Amazon SageMaker الطيار الآلي يجعل من الممكن للمؤسسات إنشاء ونشر نموذج التعلم الآلي الشامل (ML) ونشره بسرعة مع بضعة أسطر من التعليمات البرمجية أو حتى بدون أي كود على الإطلاق مع أمازون ساجميكر ستوديو. يفرغ الطيار الآلي الرفع الثقيل للبنية التحتية للتكوين والوقت المستغرق لبناء خط أنابيب كامل ، بما في ذلك هندسة الميزات واختيار النموذج وضبط المعلمة الفائقة.

في هذا المنشور ، نوضح كيفية الانتقال من البيانات الأولية إلى خط أنابيب استدلال قوي ومنتشر بالكامل باستخدام الطيار الآلي.

حل نظرة عامة

نستخدم مجموعة بيانات Lyft العامة حول مشاركة الدراجات لهذه المحاكاة للتنبؤ بما إذا كان المستخدم سيشارك أم لا في برنامج مشاركة الدراجة للجميع. هذه مشكلة تصنيف ثنائية بسيطة.

نريد أن نظهر مدى سهولة إنشاء خط أنابيب استدلال آلي وفي الوقت الفعلي لتصنيف المستخدمين بناءً على مشاركتهم في برنامج Bike Share for All. تحقيقًا لهذه الغاية ، نقوم بمحاكاة خط أنابيب استيعاب واستدلال شامل للبيانات لشركة مشاركة دراجات خيالية تعمل في منطقة خليج سان فرانسيسكو.

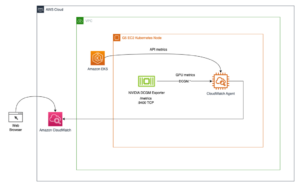

يتم تقسيم البنية إلى جزأين: خط أنابيب الابتلاع وخط أنابيب الاستدلال.

نحن نركز بشكل أساسي على خط أنابيب ML في القسم الأول من هذا المنشور ، ونراجع خط أنابيب استيعاب البيانات في الجزء الثاني.

المتطلبات الأساسية المسبقة

لمتابعة هذا المثال ، أكمل المتطلبات الأساسية التالية:

- قم بإنشاء مثيل دفتر ملاحظات SageMaker جديد.

- خلق أمازون كينسيس داتا فايرهاوس تيار التسليم مع AWS لامدا وظيفة التحويل. للحصول على التعليمات ، انظر Amazon Kinesis Firehose Data Transformation مع AWS Lambda. هذه الخطوة اختيارية ومطلوبة فقط لمحاكاة تدفق البيانات.

استكشاف البيانات

لنقم بتنزيل وتصور مجموعة البيانات الموجودة في الأماكن العامة خدمة تخزين أمازون البسيطة (Amazon S3) دلو وموقع ويب ثابت:

تُظهر لقطة الشاشة التالية مجموعة فرعية من البيانات قبل التحويل.

يحتوي العمود الأخير من البيانات على الهدف الذي نريد توقعه ، وهو متغير ثنائي يأخذ إما قيمة نعم أو لا ، مما يشير إلى ما إذا كان المستخدم يشارك في برنامج Bike Share for All.

دعنا نلقي نظرة على توزيع المتغير المستهدف لدينا لأي خلل في البيانات.

كما هو موضح في الرسم البياني أعلاه ، فإن البيانات غير متوازنة ، حيث يشارك عدد أقل من الأشخاص في البرنامج.

نحن بحاجة إلى موازنة البيانات لمنع التحيز المفرط في التمثيل. هذه الخطوة اختيارية لأن الطيار الآلي يوفر أيضًا نهجًا داخليًا للتعامل مع عدم توازن الفئة تلقائيًا ، والذي يتم تعيينه افتراضيًا على مقياس التحقق من درجة F1. بالإضافة إلى ذلك ، إذا اخترت موازنة البيانات بنفسك ، فيمكنك استخدام تقنيات أكثر تقدمًا لمعالجة عدم توازن الفصل ، مثل سموت or GAN.

بالنسبة لهذا المنشور ، قمنا باختزال فئة الأغلبية (لا) كأسلوب لموازنة البيانات:

الكود التالي يثري البيانات ويقلل من العينات للفئة الممثلة تمثيلا زائدا:

لقد تركنا عن عمد ميزاتنا الفئوية غير مشفرة ، بما في ذلك قيمة الهدف الثنائي. وذلك لأن الطيار الآلي يعتني بترميز البيانات وفك تشفيرها لنا كجزء من هندسة الميزات التلقائية ونشر خطوط الأنابيب ، كما نرى في القسم التالي.

تُظهر لقطة الشاشة التالية عينة من بياناتنا.

تبدو البيانات في الرسوم البيانية التالية طبيعية بخلاف ذلك ، مع توزيع ثنائي النسق يمثل القمتين لساعات الصباح وساعات الذروة بعد الظهر ، كما هو متوقع. نلاحظ أيضًا أنشطة منخفضة في عطلات نهاية الأسبوع وفي الليل.

في القسم التالي ، نقوم بتغذية البيانات إلى الطيار الآلي حتى يتمكن من إجراء تجربة لنا.

بناء نموذج تصنيف ثنائي

يتطلب الطيار الآلي أن نحدد دلاء وجهة الإدخال والإخراج. يستخدم حاوية الإدخال لتحميل البيانات وحاوية الإخراج لحفظ القطع الأثرية ، مثل هندسة الميزات ودفاتر Jupyter التي تم إنشاؤها. نحتفظ بـ 5٪ من مجموعة البيانات لتقييم أداء النموذج والتحقق منه بعد اكتمال التدريب وتحميل 95٪ من مجموعة البيانات إلى حاوية إدخال S3. انظر الكود التالي:

بعد تحميل البيانات إلى وجهة الإدخال ، حان الوقت لبدء الطيار الآلي:

كل ما نحتاجه لبدء التجربة هو استدعاء طريقة fit (). يحتاج الطيار الآلي إلى موقع الإدخال والإخراج S3 وعمود السمة الهدف كمعلمات مطلوبة. بعد معالجة الميزة ، يستدعي الطيار الآلي SageMaker ضبط النموذج التلقائي للعثور على أفضل نسخة من النموذج عن طريق تشغيل العديد من الوظائف التدريبية على مجموعة البيانات الخاصة بك. أضفنا المعلمة max_candidates الاختيارية للحد من عدد المرشحين إلى 30 ، وهو عدد وظائف التدريب التي يطلقها الطيار الآلي مع مجموعات مختلفة من الخوارزميات والمعلمات الفائقة من أجل العثور على أفضل نموذج. إذا لم تحدد هذه المعلمة ، فستكون القيمة الافتراضية هي 250.

يمكننا ملاحظة تقدم الطيار الآلي بالشفرة التالية:

يستغرق التدريب بعض الوقت حتى يكتمل. أثناء تشغيله ، دعنا نلقي نظرة على سير عمل الطيار الآلي.

للعثور على أفضل مرشح ، استخدم الكود التالي:

تظهر لقطة الشاشة التالية مخرجاتنا.

حقق نموذجنا دقة تحقق تصل إلى 96٪ ، لذلك سنقوم بنشره. يمكننا إضافة شرط بحيث لا نستخدم النموذج إلا إذا كانت الدقة أعلى من مستوى معين.

خط أنابيب الاستدلال

قبل نشر نموذجنا ، دعنا نفحص أفضل مرشح لدينا وما يحدث في خط الأنابيب لدينا. انظر الكود التالي:

يوضح الرسم البياني التالي ناتجنا.

قام الطيار الآلي ببناء النموذج وقام بتعبئته في ثلاث حاويات مختلفة ، كل منها يدير مهمة محددة بالتتابع: التحويل والتنبؤ والتحويل العكسي. هذا الاستدلال متعدد الخطوات ممكن مع a خط أنابيب الاستدلال SageMaker.

يمكن للاستدلال متعدد الخطوات أيضًا أن يسلسل نماذج استدلال متعددة. على سبيل المثال ، يمكن أن تؤدي حاوية واحدة تحليل المكون الرئيسي قبل تمرير البيانات إلى حاوية XGBoost.

انشر خط أنابيب الاستدلال إلى نقطة نهاية

تتضمن عملية النشر بضعة أسطر فقط من التعليمات البرمجية:

لنقم بتهيئة نقطة النهاية الخاصة بنا للتنبؤ باستخدام متنبئ:

الآن بعد أن أصبح لدينا نقطة النهاية والتنبؤ جاهزين ، حان الوقت لاستخدام بيانات الاختبار التي وضعناها جانبًا واختبار دقة نموذجنا. نبدأ بتحديد وظيفة الأداة المساعدة التي ترسل البيانات سطرًا واحدًا في كل مرة إلى نقطة نهاية الاستدلال الخاصة بنا وتحصل على تنبؤ في المقابل. لأن لدينا ملف XGBoost النموذج ، نقوم بإسقاط المتغير الهدف قبل إرسال سطر CSV إلى نقطة النهاية. بالإضافة إلى ذلك ، قمنا بإزالة الرأس من ملف CSV التجريبي قبل المرور عبر الملف ، وهو أيضًا مطلب آخر لـ XGBoost على SageMaker. انظر الكود التالي:

تظهر لقطة الشاشة التالية مخرجاتنا.

الآن دعنا نحسب دقة نموذجنا.

انظر الكود التالي:

نحصل على دقة 92٪. هذا أقل قليلاً من نسبة 96٪ التي تم الحصول عليها أثناء خطوة التحقق ، لكنها لا تزال مرتفعة بدرجة كافية. لا نتوقع أن تكون الدقة متماثلة تمامًا لأن الاختبار يتم باستخدام مجموعة بيانات جديدة.

استيعاب البيانات

قمنا بتنزيل البيانات مباشرة وتكوينها للتدريب. في الحياة الواقعية ، قد تضطر إلى إرسال البيانات مباشرة من جهاز الحافة إلى بحيرة البيانات وجعل SageMaker يقوم بتحميلها مباشرة من بحيرة البيانات إلى الكمبيوتر المحمول.

يعتبر Kinesis Data Firehose خيارًا جيدًا والطريقة الأكثر مباشرة لتحميل البيانات المتدفقة بشكل موثوق في بحيرات البيانات ومخازن البيانات وأدوات التحليل. يمكنه التقاط البيانات المتدفقة وتحويلها وتحميلها إلى Amazon S3 ومخازن بيانات AWS الأخرى.

بالنسبة لحالة الاستخدام الخاصة بنا ، نقوم بإنشاء تدفق توصيل Kinesis Data Firehose مع وظيفة تحويل Lambda للقيام ببعض عمليات تنظيف البيانات خفيفة الوزن أثناء عبورها التدفق. انظر الكود التالي:

تقوم وظيفة Lambda بتحويل خفيف للبيانات المتدفقة من الأجهزة إلى بحيرة البيانات. تتوقع ملف بيانات بتنسيق CSV.

لخطوة الاستيعاب ، نقوم بتنزيل البيانات ومحاكاة تدفق البيانات إلى Kinesis Data Firehose باستخدام وظيفة تحويل Lambda وفي بحيرة بيانات S3 الخاصة بنا.

لنحاكي دفق بضعة أسطر:

تنظيف

من المهم حذف جميع الموارد المستخدمة في هذا التمرين لتقليل التكلفة. يحذف الكود التالي نقطة نهاية استدلال SageMaker التي أنشأناها بالإضافة إلى بيانات التدريب والاختبار التي قمنا بتحميلها:

وفي الختام

يمكن لمهندسي ML وعلماء البيانات ومطوري البرامج استخدام الطيار الآلي لبناء ونشر خط أنابيب للاستدلال مع خبرة قليلة في برمجة ML أو بدونها. يوفر الطيار الآلي الوقت والموارد ، باستخدام علم البيانات وأفضل ممارسات التعلم الآلي. يمكن للمؤسسات الكبيرة الآن تحويل الموارد الهندسية بعيدًا عن تكوين البنية التحتية نحو تحسين النماذج وحل حالات استخدام الأعمال. يمكن للشركات الناشئة والمؤسسات الصغيرة البدء في التعلم الآلي مع خبرة قليلة أو معدومة في تعلم الآلة.

لتبدأ مع SageMaker Autopilot ، راجع ملف صفحة المنتج أو قم بالوصول إلى SageMaker Autopilot داخل SageMaker Studio.

نوصي أيضًا بمعرفة المزيد حول الميزات المهمة الأخرى التي يقدمها SageMaker ، مثل متجر ميزات Amazon SageMakerالذي يتكامل مع خطوط أنابيب Amazon SageMaker لإنشاء وإضافة البحث عن الميزات واكتشافها وإعادة استخدام تدفقات عمل ML الآلي. يمكنك تشغيل العديد من عمليات محاكاة الطيار الآلي بميزة مختلفة أو متغيرات مستهدفة في مجموعة البيانات الخاصة بك. يمكنك أيضًا التعامل مع هذا على أنه مشكلة ديناميكية في تخصيص السيارة حيث يحاول نموذجك التنبؤ بالطلب على السيارة بناءً على الوقت (مثل الوقت من اليوم أو اليوم من الأسبوع) أو الموقع ، أو كليهما.

حول المؤلف

دوج مبايا هو مهندس حلول أقدم مع التركيز على البيانات والتحليلات. يعمل Doug بشكل وثيق مع شركاء AWS ، مما يساعدهم على دمج حلول البيانات والتحليلات في السحابة. تتضمن خبرة Doug السابقة دعم عملاء AWS في قطاع مشاركة الرحلات وتوصيل الطعام.

دوج مبايا هو مهندس حلول أقدم مع التركيز على البيانات والتحليلات. يعمل Doug بشكل وثيق مع شركاء AWS ، مما يساعدهم على دمج حلول البيانات والتحليلات في السحابة. تتضمن خبرة Doug السابقة دعم عملاء AWS في قطاع مشاركة الرحلات وتوصيل الطعام.

فاليريو بيروني هو مدير علوم تطبيقية يعمل على الضبط التلقائي للنموذج والطيار الآلي من Amazon SageMaker.

فاليريو بيروني هو مدير علوم تطبيقية يعمل على الضبط التلقائي للنموذج والطيار الآلي من Amazon SageMaker.

- كوينسمارت. أفضل بورصة للبيتكوين والعملات المشفرة في أوروبا.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. دخول مجاني.

- كريبتوهوك. الرادار. تجربة مجانية.

- المصدر: https://aws.amazon.com/blogs/machine-learning/automate-a-shared-bikes-and-scooters-classification-model-with-amazon-sagemaker-autopilot/

- '

- "

- &

- 100

- من نحن

- الوصول

- تحقق

- أنشطة

- متقدم

- خوارزميات

- الكل

- توزيع

- أمازون

- تحليلات

- آخر

- API

- نهج

- هندسة معمارية

- المنطقة

- الحجج

- الآلي

- AWS

- خليج

- أفضل

- أفضل الممارسات

- نساعدك في بناء

- الأعمال

- دعوة

- يستطيع الحصول على

- يهمني

- الحالات

- تغيير

- الخيارات

- تصنيف

- سوائل التنظيف

- سحابة

- الكود

- عمود

- مجموعة

- تركيبات

- حول الشركة

- عنصر

- حالة

- الاعداد

- وعاء

- حاويات

- يحتوي

- استطاع

- العملاء

- البيانات

- معالجة المعلومات

- علم البيانات

- يوم

- التوصيل

- الطلب

- نشر

- نشر

- المطورين

- جهاز

- الأجهزة

- مختلف

- اكتشاف

- العرض

- توزيع

- إلى أسفل

- قطرة

- ديناميكي

- حافة

- التشفير

- نقطة النهاية

- الهندسة

- المهندسين

- الحدث/الفعالية

- مثال

- إلا

- ممارسة

- تتوقع

- الخبره في مجال الغطس

- تجربة

- خبرة

- الميزات

- المميزات

- الاسم الأول

- تركز

- اتباع

- متابعيك

- طعام

- فرانسيسكو

- وظيفة

- الحصول على

- الذهاب

- خير

- معالجة

- هنا

- مرتفع

- كيفية

- كيفية

- HTTPS

- أهمية

- بما فيه

- البنية التحتية

- دمج

- IT

- وظيفة

- المشــاريــع

- كبير

- تطلق

- تعلم

- مستوى

- المكتبة

- ضوء

- خفيفة الوزن

- خط

- لينكدين:

- القليل

- تحميل

- محليا

- موقع

- آلة

- آلة التعلم

- أغلبية

- القيام ب

- مدير

- ML

- نموذج

- عارضات ازياء

- أكثر

- مفكرة

- عرض

- عروض

- تعمل

- خيار

- طلب

- المنظمات

- أخرى

- وإلا

- مشاركة

- شركاء

- مجتمع

- أداء

- ممكن

- تنبؤ

- المشكلة

- عملية المعالجة

- البرنامج

- برمجة وتطوير

- تزود

- جمهور

- بسرعة

- الخام

- في الوقت الحقيقي

- نوصي

- سجل

- تسجيل

- مطلوب

- الموارد

- عائدات

- مراجعة

- القواعد

- يجري

- تشغيل

- اندفاع

- سان

- سان فرانسيسكو

- إنقاذ

- علوم

- العلماء

- بحث

- مختار

- مسلسلات

- طقم

- مشاركة

- شاركت

- نقل

- الاشارات

- محاكاة

- مقاس

- النوم

- So

- تطبيقات الكمبيوتر

- انقسم

- بداية

- بدأت

- البدء

- تخزين

- فروعنا

- مجرى

- تدفق

- متدفق

- ستوديو

- الهدف

- تقنيات

- تجربه بالعربي

- الاختبار

- عبر

- الوقت

- اليوم

- أدوات

- قادة الإيمان

- تحول

- تحول

- us

- تستخدم

- المستخدمين

- سهل حياتك

- قيمنا

- المثالية

- الموقع الإلكتروني

- أسبوع

- سواء

- ويكيبيديا

- في غضون

- عامل

- أعمال