غالبًا ما تتعامل الشركات مع كميات كبيرة من طلبات خدمات تكنولوجيا المعلومات. تقليديا ، يتم وضع العبء على مقدم الطلب لاختيار الفئة الصحيحة لكل قضية. عادةً ما يعني الخطأ اليدوي أو التصنيف الخاطئ للتذكرة تأخيرًا في حل طلب خدمة تكنولوجيا المعلومات. يمكن أن يؤدي ذلك إلى انخفاض الإنتاجية وانخفاض رضا العملاء والتأثير على اتفاقيات مستوى الخدمة (SLAs) وتأثيرات تشغيلية أوسع. مع نمو مؤسستك ، تصبح مشكلة الحصول على طلب الخدمة المناسب للفريق المناسب أكثر أهمية. يمكن أن يساعد استخدام نهج قائم على التعلم الآلي (ML) والذكاء الاصطناعي في تلبية احتياجات مؤسستك المتطورة باستمرار.

التعلم الآلي الخاضع للإشراف هو عملية تستخدم مجموعات البيانات والمخرجات ذات العلامات لتدريب خوارزميات التعلم على كيفية تصنيف البيانات أو التنبؤ بنتيجة. فهم الأمازون هي خدمة معالجة اللغة الطبيعية (NLP) التي تستخدم ML للكشف عن رؤى واتصالات قيمة في النص. يوفر واجهات برمجة تطبيقات مدعومة من ML لاستخراج العبارات الرئيسية والكيانات وتحليل المشاعر والمزيد.

في هذا المنشور ، نوضح لك كيفية تنفيذ نموذج ML خاضع للإشراف يمكن أن يساعد في تصنيف طلبات خدمة تكنولوجيا المعلومات تلقائيًا باستخدام تصنيف Amazon Comprehend المخصص. يساعدك التصنيف المخصص لخدمة Amazon Comprehend على تخصيص Amazon Comprehend وفقًا لمتطلباتك الخاصة بدون مجموعة المهارات المطلوبة لبناء حلول البرمجة اللغوية العصبية القائمة على ML. باستخدام ML أو AutoML التلقائي ، ينشئ التصنيف المخصص Amazon Comprehend نماذج NLP مخصصة نيابة عنك ، باستخدام بيانات التدريب التي تقدمها.

نظرة عامة على الحل

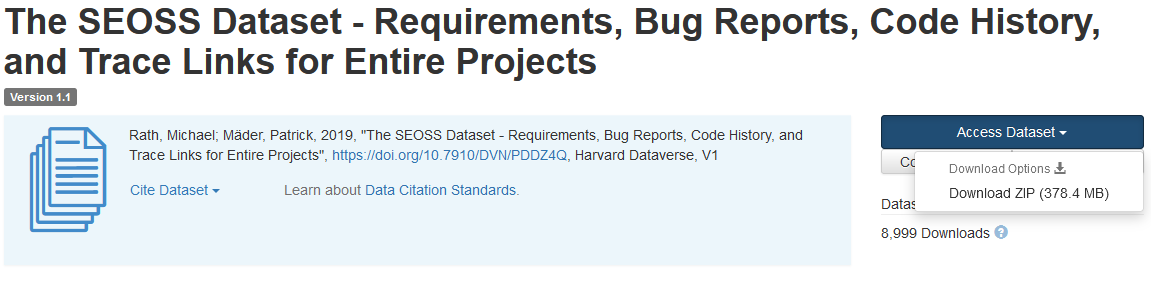

لتوضيح تصنيف طلب خدمة تكنولوجيا المعلومات ، يستخدم هذا الحل مجموعة بيانات SEOSS. مجموعة البيانات هذه عبارة عن مجموعة بيانات تم استردادها بشكل منهجي وتتألف من 33 مشروعًا برمجيًا مفتوح المصدر تحتوي على عدد كبير من القطع الأثرية المكتوبة وروابط التتبع فيما بينها. يستخدم هذا الحل بيانات المشكلة من 33 مشروعًا مفتوح المصدر وملخصات وأوصاف كما أبلغ عنها المستخدمون النهائيون لإنشاء نموذج مصنف مخصص باستخدام Amazon Comprehend.

يوضح هذا المنشور كيفية تنفيذ الحل ونشره باستخدام مجموعة تطوير سحابة AWS (AWS CDK) في ملف سحابة أمازون الافتراضية الخاصة تتكون بيئة (Amazon VPC) من شبكات فرعية خاصة فقط. نستخدم أيضًا الكود لشرح كيف يمكنك استخدام AWS CDK إطار مزود، إطار مصغر لتنفيذ مزود ل تكوين سحابة AWS موارد مخصصة لإنشاء مورد مخصص أو تحديثه أو حذفه ، مثل نقطة نهاية Amazon Comprehend. تتضمن نقطة نهاية Amazon Comprehend موارد مُدارة تجعل نموذجك المخصص متاحًا للاستدلال في الوقت الفعلي على جهاز عميل أو تطبيقات تابعة لجهات خارجية. ال رمز لهذا الحل متاح على جيثب.

أنت تستخدم AWS CDK لنشر البنية التحتية ورمز التطبيق والتكوين للحل. تحتاج أيضًا إلى حساب AWS والقدرة على إنشاء موارد AWS. تستخدم AWS CDK لإنشاء موارد AWS مثل VPC بشبكات فرعية خاصة ، نقاط نهاية Amazon VPC, نظام ملفات أمازون المرن (أمازون EFS) ، أ خدمة إعلام أمازون البسيطة (Amazon SNS) موضوع ، و خدمة تخزين أمازون البسيطة (Amazon S3) دلو ، إشعارات أحداث Amazon S3و AWS لامدا المهام. بشكل جماعي ، تشكل موارد AWS هذه حزمة التدريب ، والتي تستخدمها لبناء وتدريب نموذج المصنف المخصص.

بعد إنشاء موارد AWS هذه ، يمكنك تنزيل مجموعة بيانات SEOSS وتحميل مجموعة البيانات إلى حاوية S3 التي تم إنشاؤها بواسطة الحل. إذا كنت تنشر هذا الحل في منطقة AWS us-east-2 ، فسيكون تنسيق اسم حاوية S3 هو comprehendcustom--us-east-2-s3stack. يستخدم الحل مشغل التحميل متعدد الأجزاء Amazon S3 لاستدعاء وظيفة Lambda التي تبدأ المعالجة المسبقة لبيانات الإدخال ، وتستخدم البيانات المعالجة مسبقًا لتدريب المصنف المخصص Amazon Comprehend لإنشاء نموذج المصنف المخصص. يمكنك بعد ذلك استخدام Amazon Resource Name (ARN) لنموذج المصنف المخصص لإنشاء حزمة الاستدلال ، والتي تُنشئ نقطة نهاية Amazon Comprehend باستخدام AWS CDK إطار مزود، والتي يمكنك استخدامها بعد ذلك للاستنتاجات من تطبيق أو جهاز عميل تابع لجهة خارجية.

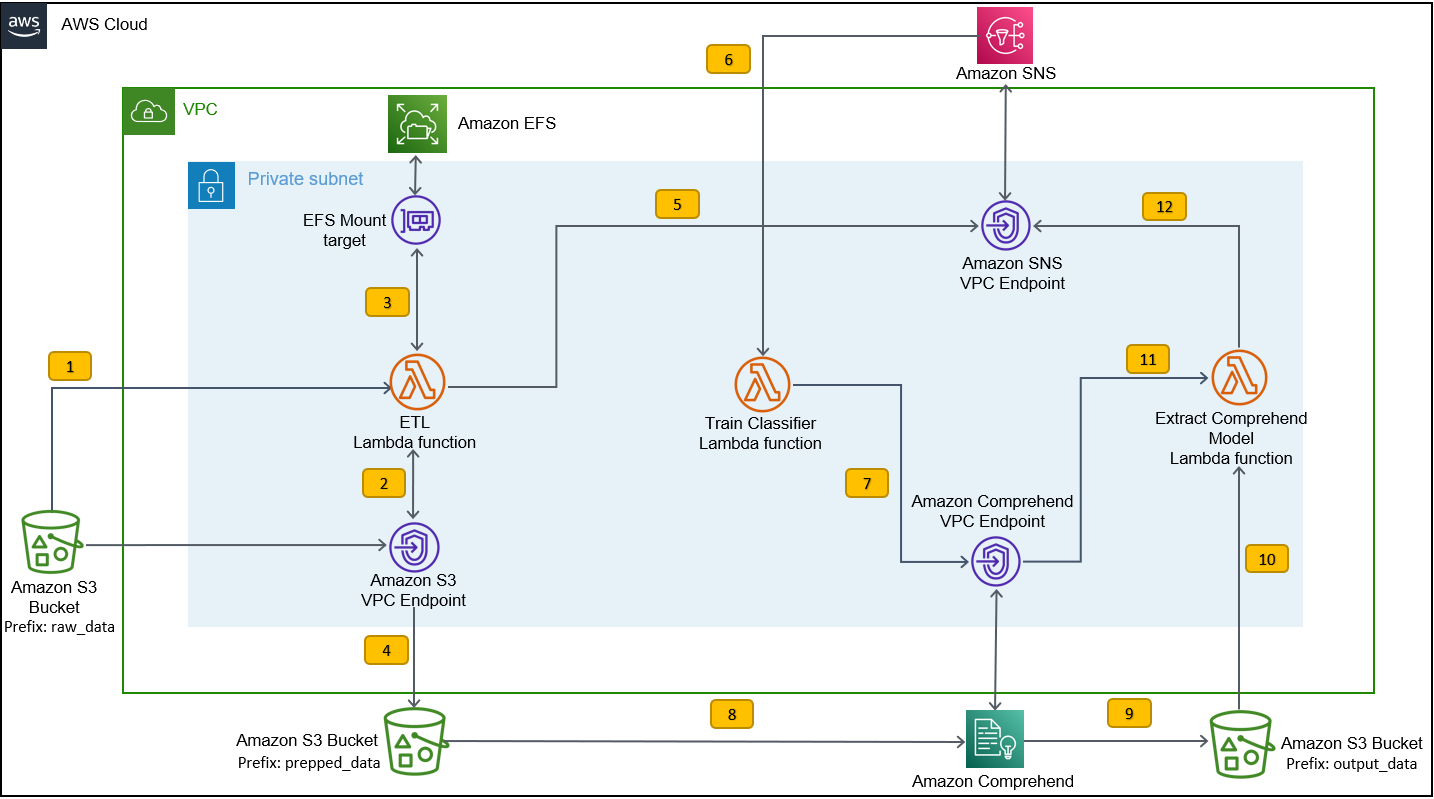

يوضح الرسم البياني التالي بنية حزمة التدريب.

خطوات سير العمل كالتالي:

- قم بتحميل مجموعة بيانات SEOSS إلى حاوية S3 التي تم إنشاؤها كجزء من عملية نشر مكدس التدريب. يؤدي هذا إلى إنشاء مشغل حدث يستدعي ملف

etl_lambdaوظيفة. - •

etl_lambdaتقوم الوظيفة بتنزيل مجموعة البيانات الأولية من Amazon S3 إلى Amazon EFS. - •

etl_lambdaتؤدي الوظيفة مهمة المعالجة المسبقة للبيانات لمجموعة بيانات SEOSS. - عند اكتمال تنفيذ الوظيفة ، يتم تحميل البيانات المحولة باستخدام

prepped_dataبادئة في دلو S3. - بعد اكتمال تحميل البيانات المحولة ، يتم إرسال رسالة إكمال ETL بنجاح إلى Amazon SNS.

- في Amazon Comprehend ، يمكنك تصنيف مستنداتك باستخدام وضعين: متعدد الطبقات أو متعدد التصنيفات. يحدد الوضع متعدد الفئات فئة واحدة وفئة واحدة فقط لكل مستند ، ويحدد الوضع متعدد التسميات تسمية واحدة أو أكثر لكل مستند. نظرًا لأننا نريد تحديد فئة واحدة لكل مستند ، فإننا نقوم بتدريب نموذج المصنف المخصص في وضع متعدد الفئات. تقوم Amazon SNS بتشغيل ملف

train_classifier_lambdaوظيفة ، والتي تبدأ تدريب مصنف Amazon Comprehend في وضع متعدد الفصول. - •

train_classifier_lambdaتعمل الوظيفة على بدء تدريب مصنف Amazon Comprehend المخصص. - يقوم Amazon Comprehend بتنزيل البيانات المحولة من ملف

prepped_dataالبادئة في Amazon S3 لتدريب نموذج المصنف المخصص. - عند اكتمال تدريب النموذج ، يقوم Amazon Comprehend بتحميل ملف

model.tar.gzملف لoutput_dataبادئة دلو S3. متوسط وقت الانتهاء لتدريب نموذج المصنف المخصص هذا هو حوالي 10 ساعات. - يستدعي مشغل تحميل Amazon S3 ملف

extract_comprehend_model_name_lambdaدالة ، والتي تسترد نموذج المصنف المخصص ARN. - تستخرج الوظيفة نموذج المصنف المخصص ARN من حمولة الحدث S3 واستجابة

list-document-classifiersمكالمة. - ترسل الوظيفة نموذج المصنف المخصص ARN إلى عنوان البريد الإلكتروني الذي اشتركت فيه سابقًا كجزء من عملية إنشاء مكدس التدريب. ثم تستخدم ARN هذا لنشر مكدس الاستدلال.

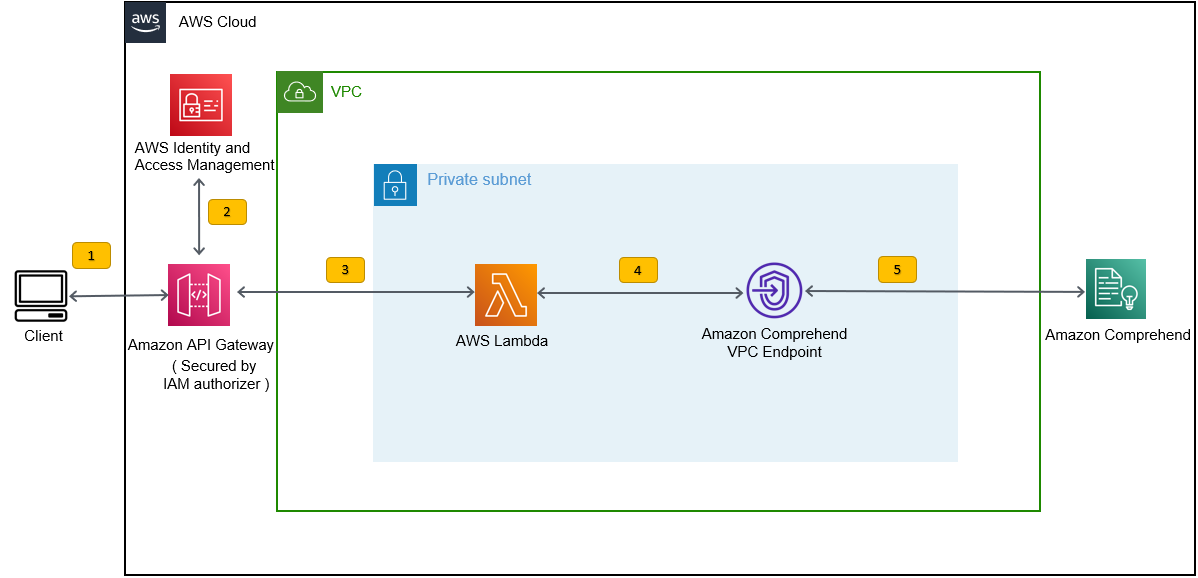

يؤدي هذا النشر إلى إنشاء حزمة الاستدلال ، كما هو موضح في الشكل التالي. يوفر لك مكدس الاستدلال واجهة برمجة تطبيقات REST مؤمنة بواسطة ملف إدارة الهوية والوصول AWS (IAM) ، والذي يمكنك استخدامه بعد ذلك لإنشاء درجات ثقة للتسميات بناءً على نص الإدخال المقدم من تطبيق جهة خارجية أو جهاز عميل.

المتطلبات الأساسية المسبقة

بالنسبة لهذا العرض التوضيحي ، يجب أن تتوفر لديك المتطلبات الأساسية التالية:

- An حساب AWS.

- Python 3.7 أو أحدث, نود.جي إسو بوابة في آلة التطوير. يستخدم AWS CDK إصدارات معينة من Node.js (> = 10.13.0 ، باستثناء الإصدار 13.0.0 - 13.6.0). يوصى باستخدام نسخة في الدعم النشط طويل المدى (LTS).

لتثبيت إصدار LTS النشط من Node.js ، يمكنك استخدام ما يلي تثبيت البرنامج النصي Fornvmواستخدامهاnvmإلى تثبيت إصدار Node.js LTS. يمكنك أيضًا تثبيت LTS Node.js النشط الحالي عبر مدير الحزم اعتمادًا على نظام التشغيل الذي تختاره.بالنسبة لنظام macOS ، يمكنك تثبيت Node.js عبر مدير الحزم باستخدام ما يلي تعليمات.

بالنسبة لنظام التشغيل Windows ، يمكنك تثبيت Node.js عبر مدير الحزم باستخدام ما يلي تعليمات.

- يتم تثبيت AWS CDK v2 مسبقًا إذا كنت تستخدم ملف سحابة AWS 9 IDE. إذا كنت تستخدم AWS Cloud9 IDE ، فيمكنك تخطي هذه الخطوة. إذا لم يكن لديك AWS CDK مثبتًا في جهاز التطوير ، فقم بتثبيت AWS CDK v2 عالميًا باستخدام الأمر Node Package Manager

npm install -g aws-cdk. تتطلب هذه الخطوة تثبيت Node.js في آلة التطوير. - قم بتكوين بيانات اعتماد AWS للوصول إلى موارد AWS وإنشائها باستخدام AWS CDK. للحصول على تعليمات ، راجع تحديد بيانات الاعتماد والمنطقة.

- تحميل مجموعة بيانات SEOSS تتكون من المتطلبات وتقارير الأخطاء وتاريخ الشفرة وروابط التتبع لـ 33 مشروعًا برمجيًا مفتوح المصدر. حفظ الملف

dataverse_files.zipعلى جهازك المحلي.

انشر حزمة تدريب AWS CDK

لنشر AWS CDK ، نبدأ بمكدس التدريب. أكمل الخطوات التالية:

- استنساخ مستودع GitHub:

- انتقل إلى

amazon-comprehend-custom-automate-classification-it-service-requestالمجلد:

يتم تشغيل جميع الأوامر التالية داخل ملف amazon-comprehend-custom-automate-classification-it-service-request الدليل.

- في دليل طلب amazon-comprehend-custom-automate-rating-it-service-request ، قم بتهيئة بيئة Python الافتراضية وقم بتثبيت متطلبات. txt باستخدام نقطة:

- إذا كنت تستخدم AWS CDK في حساب AWS ومنطقة معينة لأول مرة ، فراجع التعليمات الخاصة بـ تمهيد بيئة AWS CDK الخاصة بك:

- تجميع قوالب CloudFormation لهذا الحل باستخدام

cdk synthواستخدامهاcdk deployلإنشاء موارد AWS المذكورة سابقًا:

بعد أن تدخل cdk deploy، يطالبك AWS CDK بما إذا كنت تريد نشر التغييرات لكل مجموعة من الحزم التي تم استدعاؤها في أمر نشر cdk.

- أدخل

yلكل من مطالبات إنشاء المكدس ، تقوم خطوة نشر القرص المضغوط بإنشاء هذه الحزم. اشترك في عنوان البريد الإلكتروني الذي قدمته في موضوع SNS الذي تم إنشاؤه كجزء من نشر cdk. - بعد اكتمال نشر cdk بنجاح ، قم بإنشاء مجلد يسمى

raw_dataفي دلو S3comprehendcustom---s3stack. - قم بتحميل مجموعة بيانات SEOSS

dataverse_files.zipالذي قمت بتنزيله مسبقًا إلى هذا المجلد.

بعد اكتمال التحميل ، يستدعي الحل ملف etl_lambda تعمل باستخدام مشغل حدث Amazon S3 لبدء عملية الاستخراج والتحويل والتحميل (ETL). بعد اكتمال عملية ETL بنجاح ، يتم إرسال رسالة إلى موضوع SNS ، والذي يستدعي ملف train_classifier_lambda وظيفة. تقوم هذه الوظيفة بتشغيل تدريب نموذج المصنف المخصص من Amazon Comprehend. اعتمادًا على ما إذا كنت تدرب نموذجك على مجموعة بيانات SEOSS الكاملة ، قد يستغرق التدريب ما يصل إلى 10 ساعات. عند اكتمال عملية التدريب ، يقوم Amazon Comprehend بتحميل ملف model.tar.gz ملف ل output_data البادئة في دلو S3.

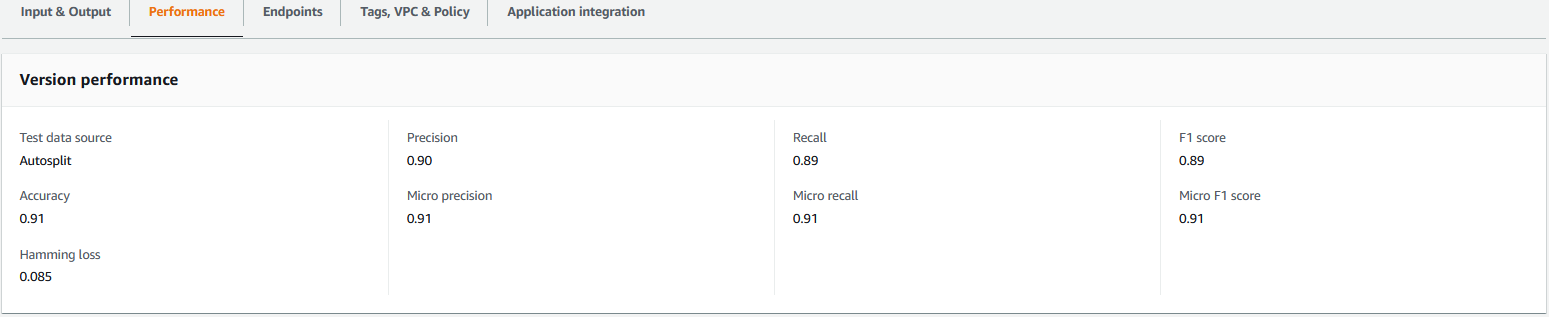

يؤدي هذا التحميل إلى تشغيل ملف extract_comprehend_model_name_lambda باستخدام مشغل حدث S3 الذي يستخرج نموذج المصنف المخصص ARN ويرسله إلى عنوان البريد الإلكتروني الذي اشتركت فيه سابقًا. ثم يتم استخدام نموذج المصنف المخصص ARN هذا لإنشاء مكدس الاستدلال. عند اكتمال تدريب النموذج ، يمكنك عرض مقاييس الأداء لنموذج المصنف المخصص من خلال الانتقال إلى قسم تفاصيل الإصدار في وحدة تحكم Amazon Comprehend (انظر لقطة الشاشة التالية) ، أو باستخدام Amazon Comprehend Boto3 SDK.

انشر مكدس استدلال AWS CDK

أنت الآن جاهز لنشر مكدس الاستدلال.

- انسخ نموذج المصنف المخصص ARN من البريد الإلكتروني الذي تلقيته واستخدم ما يلي

cdk deployأمر لإنشاء مكدس الاستدلال.

ينشر هذا الأمر API Gateway REST API مؤمنًا بواسطة مفوض IAM ، والذي تستخدمه للاستدلال بمعرف مستخدم AWS أو دور IAM الذي يحتوي للتو على تنفيذ API: استدعاء امتياز IAM. ينشر أمر cdk التالي مكدس الاستدلال. يستخدم هذا المكدس AWS CDK إطار مزود لإنشاء نقطة نهاية Amazon Comprehend كمورد مخصص ، بحيث يمكن إنشاء وحذف وتحديث نقطة نهاية Amazon Comprehend كجزء من دورة حياة مكدس الاستدلال باستخدام أوامر نشر cdk وتدمير cdk.

نظرًا لأنك تحتاج إلى تشغيل الأمر التالي بعد اكتمال تدريب النموذج ، والذي قد يستغرق ما يصل إلى 10 ساعات ، فتأكد من أنك في بيئة Python الافتراضية التي قمت بتهيئتها في خطوة سابقة وفي amazon-comprehend-custom-automate-classification-it-service-request دليل:

فمثلا:

- بعد

cdk deployاكتمل الأمر بنجاح ، انسخ ملفAPIGWInferenceStack.ComprehendCustomClassfierInvokeAPIالقيمة من إخراج وحدة التحكم ، واستخدم واجهة برمجة تطبيقات REST هذه لإنشاء استنتاجات من جهاز عميل أو تطبيق تابع لجهة خارجية يحتوي علىexecute-api:Invokeامتياز IAM. إذا كنت تقوم بتشغيل هذا الحل في us-east-2 ، فإن تنسيق REST API هذا هوhttps://.execute-api.us-east-2.amazonaws.com/prod/invokecomprehendV1.

بدلاً من ذلك ، يمكنك استخدام عميل الاختبار apiclientinvoke.py من مستودع GitHub لإرسال طلب إلى نموذج المصنف المخصص. قبل استخدام apiclientinvoke.py ، تأكد من توفر المتطلبات الأساسية التالية:

- لديك

boto3وrequestsتم تثبيت حزمة Python باستخدام نقطة على جهاز العميل. - لقد قمت بتكوين بيانات اعتماد Boto3. افتراضيًا ، يفترض عميل الاختبار أن ملفًا شخصيًا اسمه الافتراضي موجود ولديه الامتداد

execute-api:Invokeامتياز IAM على REST API. - يشير SigV4Auth إلى المنطقة حيث يتم نشر REST API. قم بتحديث ملف

قيمة لus-east-2inapiclientinvoke.pyإذا تم نشر REST API الخاص بك في us-east-2. - لقد قمت بتعيين ملف

raw_dataمتغيرًا بالنص الذي تريد إجراء التنبؤ بالفئة أو طلب التصنيف عليه:

- لقد قمت بتعيين ملف

restapiمتغير مع واجهة برمجة تطبيقات REST التي تم نسخها مسبقًا:

restapi="https://.execute-api.us-east-2.amazonaws.com/prod/invokecomprehendV1"

- تشغيل

apiclientinvoke.pyبعد التحديثات السابقة:

تحصل على الاستجابة التالية من نموذج المصنف المخصص:

تقوم Amazon Comprehend بإرجاع نقاط الثقة لكل تسمية تنسبها بشكل صحيح. إذا كانت الخدمة واثقة جدًا من أحد الملصقات ، فستكون النتيجة أقرب إلى 1. لذلك ، بالنسبة لنموذج المصنف المخصص Amazon Comprehend الذي تم تدريبه باستخدام مجموعة بيانات SEOSS ، يتوقع نموذج المصنف المخصص أن النص ينتمي إلى فئة SPARK. يمكن بعد ذلك استخدام هذا التصنيف الذي تم إرجاعه بواسطة نموذج المصنف المخصص من Amazon Comprehend لتصنيف طلبات خدمة تكنولوجيا المعلومات أو التنبؤ بالفئة الصحيحة لطلبات خدمة تكنولوجيا المعلومات ، وبالتالي تقليل الأخطاء اليدوية أو سوء تصنيف طلبات الخدمة.

تنظيف

لتنظيف جميع الموارد التي تم إنشاؤها في هذا المنشور والتي تم إنشاؤها كجزء من حزمة التدريب ومكدس الاستدلال ، استخدم الأمر التالي. يحذف هذا الأمر جميع موارد AWS التي تم إنشاؤها كجزء من أوامر نشر cdk السابقة:

وفي الختام

في هذا المنشور ، أوضحنا لك كيف يمكن للمؤسسات تنفيذ نموذج ML خاضع للإشراف باستخدام تصنيف Amazon Comprehend المخصص للتنبؤ بفئة طلبات خدمة تكنولوجيا المعلومات بناءً على الموضوع أو وصف الطلب المقدم من المستخدم النهائي. بعد إنشاء نموذج مصنف مخصص وتدريبه ، يمكنك تشغيل تحليل في الوقت الفعلي لتصنيف مخصص عن طريق إنشاء نقطة نهاية. بعد نشر هذا النموذج إلى نقطة نهاية Amazon Comprehend ، يمكن استخدامه لتشغيل الاستدلال في الوقت الفعلي بواسطة تطبيقات الجهات الخارجية أو أجهزة العميل الأخرى ، بما في ذلك أدوات إدارة خدمات تكنولوجيا المعلومات. يمكنك بعد ذلك استخدام هذا الاستنتاج للتنبؤ بفئة العيب وتقليل الأخطاء اليدوية أو سوء تصنيف التذاكر. يساعد هذا في تقليل التأخير في حل التذاكر وزيادة دقة الدقة وإنتاجية العملاء ، مما يؤدي في النهاية إلى زيادة رضا العملاء.

يمكنك توسيع المفاهيم الواردة في هذا المنشور لتشمل حالات استخدام أخرى ، مثل توجيه الأعمال أو تذاكر تكنولوجيا المعلومات إلى فرق داخلية مختلفة مثل أقسام الأعمال ووكلاء خدمة العملاء ودعم تكنولوجيا المعلومات من المستوى 2/3 ، الذي تم إنشاؤه إما بواسطة المستخدمين النهائيين أو من خلال التشغيل الآلي يعني.

مراجع حسابات

- راث ، مايكل ؛ Mäder ، باتريك ، 2019 ، "مجموعة بيانات SEOSS - المتطلبات وتقارير الأخطاء وتاريخ الشفرة وروابط التتبع للمشاريع بأكملها" ، https://doi.org/10.7910/DVN/PDDZ4Q، هارفارد داتافيرس ، V1

حول المؤلف

ارناب شاكرابورتي هو مهندس حلول أول في AWS ومقره في مدينة سينسيناتي بولاية أوهايو. إنه شغوف بالموضوعات في هندسة المشاريع والحلول ، وتحليلات البيانات ، و Serverless ، والتعلم الآلي. يستمتع في أوقات فراغه بمشاهدة الأفلام وعروض السفر والرياضة.

ارناب شاكرابورتي هو مهندس حلول أول في AWS ومقره في مدينة سينسيناتي بولاية أوهايو. إنه شغوف بالموضوعات في هندسة المشاريع والحلول ، وتحليلات البيانات ، و Serverless ، والتعلم الآلي. يستمتع في أوقات فراغه بمشاهدة الأفلام وعروض السفر والرياضة.

فيروسي ديساي هو مهندس حلول رئيسي في AWS. مع أكثر من 25 عامًا من الخبرة في مجال تكنولوجيا المعلومات ، كان يساعد العملاء على تبني AWS وتحديث بنياتهم. إنه يحب التنزه ويستمتع بالغوص العميق مع العملاء في كل ما يتعلق بـ AWS.

ديساي هو مهندس حلول رئيسي في AWS. مع أكثر من 25 عامًا من الخبرة في مجال تكنولوجيا المعلومات ، كان يساعد العملاء على تبني AWS وتحديث بنياتهم. إنه يحب التنزه ويستمتع بالغوص العميق مع العملاء في كل ما يتعلق بـ AWS.

- متقدم (300،XNUMX)

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- فهم الأمازون

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- متوسط (200،XNUMX)

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- الكيفية الفنية

- زفيرنت