كان الحجم المتزايد لنماذج اللغة أحد أكبر الاتجاهات في معالجة اللغة الطبيعية (NLP) في السنوات الأخيرة. منذ عام 2018 ، شهدنا تطويرًا ونشرًا غير مسبوق لنماذج لغوية أكبر من أي وقت مضى ، بما في ذلك BERT ومتغيراتها ، و GPT-2 و T-NLG و GPT-3 (175 مليار معلمة).

دفعت هذه النماذج حدود الابتكارات المعمارية الممكنة. نواجه العديد من التحديات عند تدريب نماذج التعلم العميق واسعة النطاق ، لا سيما الموجة الجديدة من المحولات التوليدية المدربة مسبقًا. تشمل هذه التحديات قيود الأجهزة والمفاضلات مع الحساب والكفاءة. للتغلب على تحديات النماذج وتوازي البيانات ، تقدم AWS مجموعة واسعة من القدرات.

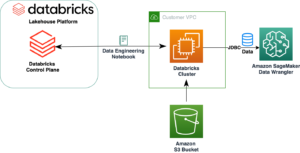

في هذا المنشور ، نقدم طريقتين رئيسيتين: موازاة البيانات وتوازي النموذج باستخدام الأمازون SageMaker، وناقش إيجابياتهم وسلبياتهم.

نموذج

بالنسبة لنموذج اللغة ، نستخدم المحولات ، المقدمة في الورقة الاهتمام هو كل ما تحتاجه. المحولات هي نماذج تعليمية عميقة مصممة لتتجنب عمدًا مآزق RNNs من خلال الاعتماد على آلية الاهتمام الذاتي لرسم التبعيات العالمية بين المدخلات والمخرجات. تسمح بنية نموذج المحولات بموازنة أفضل بشكل ملحوظ ويمكن أن تحقق أداءً عاليًا في وقت تدريب قصير نسبيًا. مبني على نجاح Transformers ، BERT ، الذي تم تقديمه في الورقة BERT: التدريب المسبق لمحولات ثنائية الاتجاه عميقة لفهم اللغة، إضافة تدريب ثنائي الاتجاه لتمثيل اللغة. مستوحى من مهمة Cloze ، تم تدريب BERT مسبقًا على نمذجة اللغة المقنعة (MLM) ، حيث يتعلم النموذج استرداد الكلمات الأصلية للرموز المقنعة عشوائيًا. يتم أيضًا اختبار نموذج BERT مسبقًا في مهمة التنبؤ بالجمل التالية (NSP) للتنبؤ بما إذا كانت جملتان في ترتيب قراءة صحيح. منذ ظهوره في عام 2018 ، تم استخدام BERT وتنوعاته على نطاق واسع في نماذج اللغة.

نبدأ بإنشاء طبقتين من التضمين من أجل التضمين المميز والموضعي. إن حفلات الزفاف المدخلة هي مجموع حفلات الزفاف المميزة وحفلات الزفاف في الموضع.

ثم نحدد كتلة وحدة فك ترميز المحولات بطبقتين فرعيتين: طبقة انتباه ذاتي متعددة الرؤوس ، وشبكة تغذية أمامية بسيطة متصلة بالكامل متبوعة بتطبيع الطبقة والتسرب:

أخيرًا ، قمنا بإنشاء نموذج لغتنا مع طبقة التضمين وكتل المحولات السابقة:

اعتمادًا على المعلمات الفائقة ، يمكنك قياس هذا النموذج من آلاف المعلمات إلى مليارات من المعلمات. يتمثل التحدي الأساسي في نماذج المليار متغير في أنه لا يمكنك استضافة النموذج في حالة واحدة وتحتاج إلى توزيع النموذج على عدة عقد للتدريب والاستدلال.

مجموعة البيانات

في تجاربنا ، استخدمنا مجموعة بيانات الوبر. The Pile عبارة عن مجموعة بيانات نصية باللغة الإنجليزية بحجم 800 جيجا بايت مصممة لتدريب نماذج اللغة على نطاق واسع. تم إنشاؤه من 22 مجموعة بيانات متنوعة وعالية الجودة ، بما في ذلك مجموعات بيانات البرمجة اللغوية العصبية القائمة والمجموعات المُقدمة حديثًا.

يتم إنشاء مجموعة البيانات من مجموعة متنوعة من مصادر البيانات ، بما في ذلك الكتب. مستودعات جيثب ؛ صفحات الانترنت؛ سجلات الدردشة وأوراق الطب والفيزياء والرياضيات وعلوم الكمبيوتر والفلسفة. على وجه التحديد ، يستخدم المصادر التالية: Pile-CC و PubMed Central و ArXiv و GitHub و FreeLaw Project و Stack Exchange و US Patent and Trademark Office و PubMed و Ubuntu و IRC و HackerNews و YouTube و PhilPapers و Books3 و Project Gutenberg ( PG-19) ، و OpenSubtitles ، ويكيبيديا الإنجليزية ، و DM Mathematics ، و EuroParl ، ومجموعة Enron Emails corpus ، و NIH ExPorter. ويتضمن أيضًا OpenWebText2 و BookCorpus2 ، وهما امتدادان لمجموعتي بيانات OpenWebText و BookCorpus الأصلية ، على التوالي. يمكن أن يؤدي التنوع في مصادر البيانات إلى تحسين المعرفة العامة عبر المجال وبالتالي تحسين قدرات التعميم النهائية.

التحدي الأساسي مع مجموعة البيانات هذه هو الحجم الهائل ؛ تحتوي مجموعة البيانات على 825 جيجا بايت من النص ، والتي تُترجم إلى 4.2 تيرا بايت من نقاط البيانات المُجهزة مسبقًا والمضغوطة. على غرار التحديات التي نواجهها في التدريب واستضافة النماذج ، فإن تدريب نموذج باستخدام مجموعة البيانات هذه في مثيل واحد سيستغرق الكثير من الوقت وغير عملي.

يتمثل الحل الذي نقدمه في تقسيم مجموعة البيانات إلى ما يقرب من 1 جيجا بايت من البيانات ، وتحميل الميزات ومعالجتها مسبقًا في مجموعة بيانات TensorFlow الأشياء ، وتخزينها في خدمة الملفات المرنة من أمازون (أمازون EFS). توفر مجموعات بيانات TensorFlow خط أنابيب بيانات سهل الاستخدام وعالي الأداء يتكامل بشكل جيد مع نماذجنا. Amazon EFS هي خدمة سهلة الاستخدام تمكننا من إنشاء نظام ملفات مشترك يتوسع تلقائيًا مع إضافة الملفات وحذفها. بالإضافة إلى ذلك ، فإن Amazon EFS قادرة على الاندفاع إلى مستويات إنتاجية أعلى عند الحاجة ، وهو أمر بالغ الأهمية في بياناتنا وخط أنابيب التدريب الخاص بنا.

بعد ذلك ، ننظر في استراتيجيات التدريب الموزعة لمواجهة هذه التحديات.

التدريب الموزع

في هذا المشروع ، واجهنا تحديين: قياس حجم النموذج وحجم البيانات. قد تؤدي زيادة حجم النموذج وعدد المعلمات القابلة للتدريب إلى دقة أفضل ، ولكن هناك حدًا للنموذج الذي يمكنك ملاءمته في ذاكرة GPU واحدة أو حتى وحدات معالجة رسومات متعددة في مثيل واحد. بالإضافة إلى ذلك ، تستغرق أحجام النماذج الأكبر وقتًا أطول للتدريب.

يمكنك معالجة هذه التحديات بطريقتين مختلفتين: توازي البيانات ونموذج التوازي. باستخدام توازي البيانات ، نقوم بإجراء هبوط التدرج العشوائي (SGD) من خلال توزيع سجلات دفعة صغيرة على أجهزة مختلفة لتسريع التدريب. ومع ذلك ، فإن التدريب على البيانات المتوازية يأتي مع تعقيد إضافي لحوسبة متوسط التدرج للدفعة الصغيرة مع التدرجات من جميع الأجهزة ، وهي خطوة تسمى AllReduce، والتي تصبح أكثر صعوبة مع نمو مجموعة التدريب. أثناء استخدام توازي البيانات ، يجب أن نكون قادرين على ملاءمة النموذج ونقطة بيانات واحدة في جهاز (وحدة المعالجة المركزية أو وحدة معالجة الرسومات) ، وهو عامل مقيد في تجاربنا لأن حجم مثل هذا النموذج الكبير أكبر بكثير من ذاكرة وحدة معالجة الرسومات الفردية بحجم.

الحل الآخر هو استخدام نموذج التوازي ، الذي يقسم النموذج على أجهزة متعددة. نموذج التوازي هو عملية تقسيم النموذج بين أجهزة أو عقد متعددة (مثل مثيلات مجهزة بوحدة معالجة الرسومات) وإنشاء خط أنابيب فعال لتدريب النموذج عبر هذه الأجهزة لزيادة استخدام وحدة معالجة الرسومات إلى أقصى حد.

موازنة البيانات

موازاة البيانات هو النهج الأكثر شيوعًا لوحدات معالجة الرسومات المتعددة أو التدريب الموزع. يمكنك تجميع بياناتك وإرسالها إلى أجهزة متعددة (كل منها يستضيف نموذجًا منسوخًا) ، ثم تجميع النتائج. جربنا حزمتين لموازنة البيانات: Horovod و وزعت SageMaker مكتبة البيانات المتوازية.

Horovod هو إطار عمل للتدريب على التعلم العميق موزع لـ TensorFlow و Keras و PyTorch و Apache MXNet. لاستخدام Horovod ، مررنا بالعملية التالية:

- التهيئة عن طريق التشغيل

hvd.init(). - اربط كل جهاز بعملية واحدة. ترتبط العملية الأولى أو العامل بالجهاز الأول ، وترتبط العملية الثانية بالجهاز الثاني ، وهكذا.

- اضبط معدل التعلم بناءً على عدد الأجهزة.

- لف المحسن في

hvd.DistributedOptimizer. - قم ببث حالات المتغير الأولية من العامل الأول ذو الرتبة 0 إلى جميع العمليات الأخرى. يعد هذا ضروريًا لضمان التهيئة المتسقة لجميع العمال عند بدء التدريب بأوزان عشوائية أو استعادة من نقطة تفتيش.

- تأكد من أن الجهاز 0 فقط يمكنه حفظ نقاط التفتيش لمنع العمال الآخرين من إفسادها.

فيما يلي نص التدريب:

تتيح لنا مكتبة البيانات المتوازية SageMaker توسيع نطاق تدريبنا بكفاءة شبه خطية ، وتسريع تدريبنا مع الحد الأدنى من التغييرات في التعليمات البرمجية. تقوم المكتبة بعمل مخصص AllReduce التشغيل وتحسين الاتصال من جهاز إلى جهاز من خلال الاستفادة الكاملة من البنية التحتية لشبكة AWS و الأمازون الحوسبة المرنة السحابية (Amazon EC2) طبولوجيا مثيل. لاستخدام مكتبة بيانات SageMaker المتوازية ، مررنا بالعملية التالية:

- الاستيراد والتهيئة

sdp.init(). - اربط كل جهاز بملف

smdistributed.dataparallelعملية معlocal_rank.sdp.tensorflow.local_rank()يعطينا الترتيب المحلي للأجهزة. القائد هو 0 ، والعاملين في المرتبة 1 ، 2 ، 3 ، وهكذا. - اضبط معدل التعلم بناءً على عدد الأجهزة.

- التفاف

tf.GradientTapeمعDistributedGradientTapeلأداءAllReduce. - بث متغيرات النموذج الأولي من العقدة البادئة إلى جميع العقد العاملة.

- تأكد من أن الجهاز 0 فقط يمكنه حفظ نقاط التفتيش.

موازاة النموذج

يمكننا ضبط المعلمات الفائقة للحفاظ على النموذج صغيرًا بما يكفي للتدريب باستخدام وحدة معالجة رسومات واحدة ، أو يمكننا استخدام نموذج التوازي لتقسيم النموذج بين وحدات معالجة رسومات متعددة عبر مثيلات متعددة. يمكن أن تؤدي زيادة عدد المعلمات القابلة للتدريب في النموذج إلى دقة أفضل ، ولكن هناك حدًا لحجم النموذج الأقصى الذي يمكنك احتوائه في ذاكرة GPU واحدة. استخدمنا مكتبة SageMaker الموزعة المتوازية لتدريب نماذجنا الأكبر. والخطوات هي كما يلي:

- استيراد المكتبة وتهيئتها باستخدام

smp.init(). - يحتاج نموذج Keras إلى أن يرث من smp.DistributedModel بدلاً من فئة Keras Model.

- المجموعات

drop_remainder=Trueفي الtf.Dataset.batch()طريقة للتأكد من أن حجم الدُفعة قابل للقسمة دائمًا على عدد الميكروبات. - تحتاج جميع العمليات العشوائية في خط أنابيب البيانات إلى استخدام نفس البذور:

smp.dp_rank()، على سبيل المثال،shuffle(ds, seed=smp.dp_rank()). يضمن ذلك اتساق عينات البيانات عبر الأجهزة التي تحتوي على أقسام نموذجية مختلفة. - يجب أن يكون المنطق الأمامي والخلفي في دالة خطوة مع

smp.stepزخرفة. - إجراء المعالجة اللاحقة على النواتج عبر microbatches باستخدام أساليب StepOutput مثل

reduce_mean.smp.stepيجب أن يكون للدالة قيمة إرجاع تعتمد على ناتجsmp.DistributedModel.

نص التدريب كالتالي:

للحصول على دليل مفصل لتمكين البرنامج النصي للتدريب TensorFlow لمكتبة SageMaker الموزعة المتوازية ، ارجع إلى تعديل البرنامج النصي للتدريب على TensorFlow. بالنسبة إلى PyTorch ، يرجى الرجوع إلى تعديل البرنامج النصي للتدريب على PyTorch.

مصحح أخطاء SageMaker

ناقشنا في الأقسام السابقة كيفية تحسين التدريب باستخدام تقنيات موازنة البيانات والنموذج. مع الأمازون SageMaker المصحح، يمكننا الآن الحصول على معلومات توصيف الأداء من تدريباتنا لتحديد مدى تحسن التدريب. بشكل افتراضي ، يلتقط Debugger مقاييس النظام لكل مهمة تدريب SageMaker مثل GPU ، واستخدام وحدة المعالجة المركزية ، والذاكرة ، والشبكة ، والإدخال / الإخراج بفاصل زمني لأخذ العينات يبلغ 500 مللي ثانية. يمكننا الوصول إلى البيانات على النحو التالي:

المصحح يوفر المرافق ل تصور بيانات التنميط بطرق مختلفة. في المثال التالي ، نرى إجمالي استخدام GPU ووحدة المعالجة المركزية بالإضافة إلى وقت انتظار الإدخال / الإخراج لوظيفة التدريب على وحدات معالجة الرسومات المتعددة باستخدام Horovod. لإنشاء هذه الرسوم البيانية ، نقوم بتشغيل الكود التالي:

يتقلب استخدام وحدة معالجة الرسومات بشكل متكرر بين 0-100٪ ، وتعتبر أوقات انتظار الإدخال / الإخراج العالية مع استخدام منخفض لوحدة معالجة الرسومات مؤشرًا على عنق الزجاجة في الإدخال / الإخراج. علاوة على ذلك ، فإن إجمالي استخدام وحدة المعالجة المركزية لا يتجاوز أبدًا 70٪ ، مما يعني أنه يمكننا تحسين المعالجة المسبقة للبيانات من خلال زيادة عدد عمليات العاملين.

يمكننا تحسين الأداء بالتبديل من Horovod إلى مكتبة البيانات المتوازية الموزعة من SageMaker. في الرسوم البيانية التالية ، يمكننا أن نرى أن وحدات معالجة الرسومات تستخدم بكفاءة أكبر وتتراجع فقط إلى الاستخدام المنخفض لفترات زمنية قصيرة.

البنية التحتية للتدريب

لتدريب النماذج ، استخدمنا مثيلات 10 ml.p3.16xlarge باستخدام وظيفة تدريب SageMaker. يقلل SageMaker من وقت وتكلفة تدريب نماذج التعلم الآلي (ML) وضبطها دون الحاجة إلى إدارة البنية التحتية. باستخدام SageMaker ، يمكنك بسهولة تدريب نماذج ML وضبطها باستخدام أدوات مدمجة لإدارة تجارب التدريب وتتبعها ، واختيار المعلمات الفائقة المثالية تلقائيًا ، ومهام التدريب لتصحيح الأخطاء ، ومراقبة استخدام موارد النظام مثل وحدات معالجة الرسومات (GPU) ووحدات المعالجة المركزية (CPU) وعرض النطاق الترددي للشبكة. تمت استضافة البيانات في Amazon EFS ، مما مكننا من النمو والانكماش حيث نضيف الملفات ونزيلها دون الحاجة إلى الإدارة أو التزويد. كانت أهدافنا الأساسية هي تحسين سرعة التدريب وخفض التكاليف.

قابلية التوسع في النموذج

على الرغم من أن هذه البنية التحتية تُستخدم بشكل أساسي لتوليد اللغة ، مع بنية GPT ومجموعة بيانات Pile ، يمكنك استخدام هذه التقنيات لتدريب نماذج المحولات واسعة النطاق ، وهو أمر مفيد في العديد من المجالات خارج البرمجة اللغوية العصبية. في التعلم الآلي نفسه ، يتم الآن حل العديد من مهام رؤية الكمبيوتر باستخدام معماريات ذات معلمات كبيرة (محولات) حيث ثبت أنها تتفوق على شبكات CNN التقليدية (الشبكة العصبية التلافيفية) في مهام مثل التعلم التمثيلي (انظر الارتقاء بأحدث ما توصلت إليه التقنية في رؤية الكمبيوتر باستخدام محولات ذاتية الإشراف وتدريب أكثر كفاءة بمعدل 10 أضعاف) ورسم الخرائط على نطاق واسع للصور إلى نص (مثل CLIP). النماذج ذات المعلمات الكبيرة تفتح أيضًا آفاقًا جديدة في علوم الحياة في مجالات مثل تحليل بنية البروتين و تحليل بيانات الصورة الطبية.

يجب أن تنطبق الحلول التي نوردها بالتفصيل في هذا المنشور للتدريب الموزع وإدارة النماذج الكبيرة على النماذج في أي من هذه المجالات أيضًا.

المقايضات

كان هناك نقاش مستمر في مجتمع البحث فيما يتعلق بمخاطر تدريب النماذج اللغوية واسعة النطاق ، وما إذا كان قد تم التفكير بشكل كافٍ في المخاطر المحتملة المرتبطة بتطويرها واستراتيجيات للتخفيف من هذه المخاطر ، والتي يشمل بعضها المالية و التكاليف البيئية. وفقا ل ورقة المنشور في ACM ، تم تقدير تدريب نموذج قاعدة BERT واحد (بدون ضبط فرط المعلمة) على وحدات معالجة الرسومات (GPU) على أنها تتطلب قدرًا كبيرًا من الطاقة مثل رحلة عبر أمريكا. مقياس التأثيرات البيئية مع حجم النموذج ، والقدرة على ضبط مثل هذه النماذج بكفاءة يمكن أن يقلل من الانبعاثات بشكل كبير. أطلقت AWS مؤخرًا إصدارًا جديدًا من أداة البصمة الكربونية للعملاء، متاح لجميع عملاء AWS بدون تكلفة ، كجزء من جهود Amazon لزيادة الاستدامة وتقليل انبعاثات الكربون. يمكن أن يؤدي تشغيل التطبيقات على سحابة AWS إلى تقليل البصمة الكربونية (عند مقارنتها بمراكز بيانات المؤسسة التي تم مسحها في تقرير 2019).

وفي الختام

أظهر هذا المنشور حلاً يسهل ضبط نماذج اللغة بمليار معلمة على سحابة AWS باستخدام SageMaker.

لمزيد من المعلومات حول نموذج التوازي مع SageMaker ، راجع قم بتدريب 175+ مليار من نماذج البرمجة اللغوية العصبية مع إضافات نموذجية متوازية و Hugging Face على Amazon SageMaker و كيف استخدم Latent Space مكتبة موازية نموذج Amazon SageMaker لدفع حدود المحولات واسعة النطاق.

إذا كنت ترغب في المساعدة في تسريع استخدامك لـ ML في منتجاتك وعملياتك ، فيرجى الاتصال بـ مختبر أمازون ML Solutions.

حول المؤلف

سيا غلامى هو أحد كبار علماء البيانات في Amazon ML Solutions Lab ، حيث يقوم ببناء حلول AI / ML للعملاء في مختلف الصناعات. إنه متحمس لمعالجة اللغة الطبيعية (NLP) والتعلم العميق. خارج العمل ، تستمتع Sia بقضاء الوقت في الطبيعة ولعب التنس.

سيا غلامى هو أحد كبار علماء البيانات في Amazon ML Solutions Lab ، حيث يقوم ببناء حلول AI / ML للعملاء في مختلف الصناعات. إنه متحمس لمعالجة اللغة الطبيعية (NLP) والتعلم العميق. خارج العمل ، تستمتع Sia بقضاء الوقت في الطبيعة ولعب التنس.

مهدي نوريهو مدير وكبير العلماء التطبيقيين في Amazon ML Solutions Lab ، حيث يعمل مع العملاء في مختلف الصناعات ، ويساعدهم على تسريع رحلة الترحيل إلى السحابة ، وحل مشكلات التعلم الآلي الخاصة بهم باستخدام أحدث الحلول و التقنيات.

مهدي نوريهو مدير وكبير العلماء التطبيقيين في Amazon ML Solutions Lab ، حيث يعمل مع العملاء في مختلف الصناعات ، ويساعدهم على تسريع رحلة الترحيل إلى السحابة ، وحل مشكلات التعلم الآلي الخاصة بهم باستخدام أحدث الحلول و التقنيات.

موهيون كيم هو عالم بيانات في Amazon Machine Learning Solutions Lab. إنه يحل مشاكل العمل المختلفة للعملاء من خلال تطبيق التعلم الآلي والتعلم العميق ، ويساعدهم أيضًا على اكتساب المهارات.

موهيون كيم هو عالم بيانات في Amazon Machine Learning Solutions Lab. إنه يحل مشاكل العمل المختلفة للعملاء من خلال تطبيق التعلم الآلي والتعلم العميق ، ويساعدهم أيضًا على اكتساب المهارات.

داني بيرد هو عالم تطبيقي في Amazon ML Solutions Lab. في المختبر ، ساعد العملاء على تطوير حلول ML المتقدمة ، في تخصصات تعلم الآلة من رؤية الكمبيوتر إلى التعلم المعزز. إنه متحمس لدفع التكنولوجيا إلى الأمام وفتح إمكانات جديدة من منتجات AWS على طول الطريق.

داني بيرد هو عالم تطبيقي في Amazon ML Solutions Lab. في المختبر ، ساعد العملاء على تطوير حلول ML المتقدمة ، في تخصصات تعلم الآلة من رؤية الكمبيوتر إلى التعلم المعزز. إنه متحمس لدفع التكنولوجيا إلى الأمام وفتح إمكانات جديدة من منتجات AWS على طول الطريق.

فرانسيسكو كالديرون رودريغيز هو عالم بيانات في Amazon ML Solutions Lab. بصفته عضوًا في ML Solutions Lab ، فهو يساعد في حل مشاكل الأعمال الحرجة لعملاء AWS باستخدام التعلم العميق. في أوقات فراغه ، يحب فرانسيسكو العزف على الموسيقى والغيتار ، ولعب كرة القدم مع بناته ، والاستمتاع بوقته مع أسرته.

فرانسيسكو كالديرون رودريغيز هو عالم بيانات في Amazon ML Solutions Lab. بصفته عضوًا في ML Solutions Lab ، فهو يساعد في حل مشاكل الأعمال الحرجة لعملاء AWS باستخدام التعلم العميق. في أوقات فراغه ، يحب فرانسيسكو العزف على الموسيقى والغيتار ، ولعب كرة القدم مع بناته ، والاستمتاع بوقته مع أسرته.

يوهي ناكاياما هو مهندس تعليم عميق في Amazon ML Solutions Lab. إنه يعمل مع العملاء عبر قطاعات مختلفة لتسريع استخدامهم للذكاء الاصطناعي وخدمات سحابة AWS لحل تحديات أعمالهم. إنه مهتم بتطبيق تقنيات ML / AI على صناعة الفضاء.

يوهي ناكاياما هو مهندس تعليم عميق في Amazon ML Solutions Lab. إنه يعمل مع العملاء عبر قطاعات مختلفة لتسريع استخدامهم للذكاء الاصطناعي وخدمات سحابة AWS لحل تحديات أعمالهم. إنه مهتم بتطبيق تقنيات ML / AI على صناعة الفضاء.

ناتالي روشماير هي عالمة تطبيقية أولى في AWS ، حيث تساعد العملاء على تطوير تطبيقات التعلم العميق.

ناتالي روشماير هي عالمة تطبيقية أولى في AWS ، حيث تساعد العملاء على تطوير تطبيقات التعلم العميق.

- كوينسمارت. أفضل بورصة للبيتكوين والعملات المشفرة في أوروبا.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. دخول مجاني.

- كريبتوهوك. الرادار. تجربة مجانية.

- المصدر: https://aws.amazon.com/blogs/machine-learning/create-train-and-deploy-a-billion-parameter-language-model-on-terabytes-of-data-with-tensorflow-and- أمازون ساجيماكر /

- "

- 10

- 100

- 2019

- a

- من نحن

- تسريع

- تسريع

- الوصول

- وفقا

- التأهيل

- في

- وأضاف

- إضافة

- متقدم

- الكل

- يسمح

- دائما

- أمازون

- تحليل

- API

- التطبيقات

- تطبيقي

- التقديم

- تطبيق

- نهج

- اقتراب

- ما يقرب من

- معماري

- هندسة معمارية

- فنـون

- مصطنع

- الذكاء الاصطناعي

- أسوشيتد

- اهتمام

- تلقائيا

- متاح

- المتوسط

- AWS

- لان

- يجري

- ما بين

- Beyond

- أكبر

- أكبر

- مليار

- المليارات

- حظر

- كُتُب

- نساعدك في بناء

- يبني

- مدمج

- الأعمال

- قدرات

- قادر على

- أسر

- يلتقط

- كربون

- انبعاثات الكربون

- مركزي

- تحدى

- التحديات

- اختار

- فئة

- سحابة

- الخدمات السحابية

- الكود

- مشترك

- Communication

- مجتمع

- مقارنة

- حساب

- إحصاء

- الكمبيوتر

- علوم الكمبيوتر

- الحوسبة

- متصل

- سلبيات

- ثابتة

- التواصل

- التكاليف

- خلق

- خلق

- يخلق

- خلق

- حرج

- على

- العملاء

- البيانات

- مراكز البيانات

- عالم البيانات

- عميق

- تظاهر

- يعتمد

- نشر

- نشر

- تصميم

- التفاصيل

- مفصلة

- حدد

- تطوير

- تطوير

- التطوير التجاري

- جهاز

- الأجهزة

- مختلف

- بحث

- وزعت

- توزيع

- تنوع

- DM

- المجالات

- إلى أسفل

- بسهولة

- سهلة الاستخدام

- كفاءة

- فعال

- بكفاءة

- جهود

- انبعاثات

- تمكين

- تمكن

- طاقة

- عربي

- مشروع

- بيئي

- خاصة

- أنشئ

- مقدر

- مثال

- يتجاوز

- تبادل

- اضافات المتصفح

- الوجه

- فيسبوك

- واجه

- للعائلات

- المميزات

- مجال

- مالي

- الاسم الأول

- تناسب

- طيران

- متابعيك

- متابعات

- البصمة

- إلى الأمام

- الإطار

- فرانسيسكو

- تبدأ من

- وظيفة

- علاوة على ذلك

- العلاجات العامة

- توليد

- جيل

- توليدي

- الحصول على

- GitHub جيثب:

- العالمية

- وحدة معالجة الرسوميات:

- وحدات معالجة الرسومات

- النمو

- توجيه

- أجهزة التبخير

- مساعدة

- يساعد

- مرتفع

- عالي الجودة

- أعلى

- عقد

- استضافت

- استضافة

- كيفية

- كيفية

- لكن

- HTTPS

- صورة

- صور

- تحسن

- تحسن

- تتضمن

- يشمل

- بما فيه

- القيمة الاسمية

- في ازدياد

- مؤشر

- الصناعات

- العالمية

- معلومات

- البنية التحتية

- الابتكارات

- إدخال

- موحى

- مثل

- رؤيتنا

- يستفد

- IT

- نفسها

- وظيفة

- المشــاريــع

- رحلة

- احتفظ

- المعرفة

- مختبر

- تُشير

- ملصقات

- لغة

- كبير

- أكبر

- أطلقت

- طبقة

- زعيم

- تعلم

- ومستوياتها

- المكتبة

- علوم الحياة

- تحميل

- محلي

- بحث

- آلة

- آلة التعلم

- إدارة

- إدارة

- مدير

- إدارة

- رسم الخرائط

- قناع

- الرياضيات

- الرياضيات

- يعني

- طبي

- عضو

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- طرق

- المقاييس

- ML

- نموذج

- عارضات ازياء

- مراقبة

- الأكثر من ذلك

- أكثر

- متعدد

- موسيقى

- طبيعي

- الطبيعة

- ضروري

- إحتياجات

- شبكة

- المعاهد الوطنية للصحة

- العقد

- عدد

- أهداف

- عروض

- Office

- جارية

- عملية

- عمليات

- الأمثل

- طلب

- أخرى

- ورق

- جزء

- عاطفي

- براءة الإختراع

- أداء

- فترات

- فلسفة

- فيزياء

- بلايستشن

- لعب

- ان يرتفع المركز

- ممكن

- محتمل

- تنبأ

- تنبؤ

- تنبؤات

- سابق

- ابتدائي

- مشاكل

- عملية المعالجة

- العمليات

- معالجة

- المنتجات

- جانبي

- تنفيذ المشاريع

- الإيجابيات

- تزود

- ويوفر

- دفع

- نطاق

- نادي القراءة

- الأخيرة

- مؤخرا

- تسجيل

- استعادة

- تخفيض

- بخصوص

- التمثيل

- ممثلة

- تطلب

- بحث

- الموارد

- النتائج

- عائد أعلى

- المخاطر

- يجري

- تشغيل

- نفسه

- حجم

- التحجيم

- علوم

- علوم

- عالم

- بذرة

- الخدمة

- خدمات

- عدة

- SGD

- الشكل

- شاركت

- قصير

- أظهرت

- مماثل

- الاشارات

- منذ

- عزباء

- مقاس

- صغير

- So

- كرة القدم

- حل

- الحلول

- حل

- يحل

- بعض

- الفضاء

- على وجه التحديد

- سرعة

- الإنفاق

- انقسم

- الإنشقاقات

- كومة

- بدأت

- الولايه او المحافظه

- دولة من بين الفن

- المحافظة

- متجر

- استراتيجيات

- تحقيق النجاح

- الاستدامة

- نظام

- المهام

- تقنيات

- التكنولوجيا

- تكنولوجيا

- •

- الآلاف

- عبر

- الإنتاجية

- الوقت

- مرات

- رمز

- الرموز

- أدوات

- مسار

- علامة تجارية

- تقليدي

- قادة الإيمان

- جديد الموضة

- أوبونتو

- غير مسبوق

- us

- تستخدم

- خدمات

- استخدام

- قيمنا

- تشكيلة

- مختلف

- القطاعات

- رؤيتنا

- حجم

- انتظر

- موجة

- طرق

- سواء

- في حين

- ويكيبيديا

- بدون

- كلمات

- للعمل

- عامل

- العمال

- أعمال

- X

- سنوات

- حل متجر العقارات الشامل الخاص بك في جورجيا

- موقع YouTube