منظمة العفو الدولية تكره عدم اليقين. ومع ذلك ، لكي تتنقل في عالمنا الذي لا يمكن التنبؤ به ، فإنها تحتاج إلى تعلم كيفية اتخاذ الخيارات بمعلومات غير كاملة - كما نفعل كل يوم.

DeepMind فقط أخذ طعنة في حل هذا اللغز. كانت الحيلة هي دمج نظرية اللعبة في إستراتيجية خوارزمية تعتمد بشكل فضفاض على الدماغ البشري تسمى التعلم المعزز العميق. والنتيجة ، DeepNash ، أطاحت بخبراء بشريين في لعبة لوحة إستراتيجية للغاية تسمى Stratego. تشتهر لعبة Stratego بأنها صعبة السمعة للذكاء الاصطناعي ، وتتطلب نقاط قوة متعددة من الذكاء البشري: التفكير طويل المدى والخداع ووضع الاستراتيجيات ، كل ذلك دون معرفة قطع خصمك على السبورة.

"على عكس الشطرنج والجو ، فإن الإستراتيجو هي لعبة تحتوي على معلومات غير كاملة: لا يمكن للاعبين أن يلاحظوا بشكل مباشر هويات قطع خصومهم ،" DeepMind كتب في منشور مدونة. مع DeepNash ، "تطورت أنظمة الذكاء الاصطناعي (AI) للعب الألعاب إلى آفاق جديدة."

ليس كل شيء ممتعًا وألعابًا. يمكن لأنظمة الذكاء الاصطناعي التي يمكنها بسهولة المناورة العشوائية لعالمنا وتعديل "سلوكها" وفقًا لذلك أن تتعامل يومًا ما مع مشاكل العالم الحقيقي بمعلومات محدودة ، مثل تحسين تدفق حركة المرور لتقليل وقت السفر و (نأمل) إخماد الغضب على الطريق كقيادة ذاتية أصبحت السيارات حاضرة أكثر من أي وقت مضى.

"إذا كنت تصنع سيارة ذاتية القيادة ، فأنت لا تريد أن تفترض أن جميع السائقين الآخرين على الطريق عقلانيون تمامًا ، وسوف يتصرفون على النحو الأمثل ،" محمد الدكتور نعوم براون في Meta AI ، والذي لم يشارك في البحث.

يأتي انتصار DeepNash في أعقاب تقدم آخر للذكاء الاصطناعي هذا الشهر ، حيث تعلمت خوارزمية لعب الدبلوماسية—لعبة تتطلب التفاوض والتعاون لتحقيق الفوز. نظرًا لأن الذكاء الاصطناعي يكتسب المزيد من المرونة في التفكير ، ويصبح أكثر عمومية ، ويتعلم كيفية التنقل في المواقف الاجتماعية ، فقد يؤدي أيضًا إلى إلقاء نظرة ثاقبة على العمليات العصبية والإدراك في أدمغتنا.

تعرف على ستراتيجو

من حيث التعقيد ، فإن Stratego هي وحش مختلف تمامًا مقارنة بالشطرنج أو Go أو البوكر - جميع الألعاب التي أتقنها الذكاء الاصطناعي سابقًا.

اللعبة هي في الأساس التقاط العلم. يحتوي كل جانب على 40 قطعة يمكنهم وضعها في أي موضع على السبورة. كل قطعة لها اسم مختلف ورتبة عددية مختلفة ، مثل "مارشال" أو "عام" أو "استكشافي" أو "جاسوس". يمكن للقطع ذات الترتيب الأعلى التقاط القطع الأدنى. الهدف هو القضاء على الخصم والاستيلاء على علمهم.

تعتبر الإستراتيجية تحديًا خاصًا للذكاء الاصطناعي لأن اللاعبين لا يمكنهم رؤية موقع قطع خصومهم ، سواء أثناء الإعداد الأولي أو أثناء اللعب. على عكس الشطرنج أو Go ، حيث يتم عرض كل قطعة وحركة ، فإن Stratego هي لعبة ذات معلومات محدودة. وأوضح المؤلفون أنه يجب على اللاعبين "تحقيق التوازن بين جميع النتائج الممكنة" في أي وقت يتخذون فيه قرارًا.

هذا المستوى من عدم اليقين هو جزئيًا سبب قيام ستراتيجو بإرباك الذكاء الاصطناعي على مر العصور. حتى أكثر خوارزميات اللعب نجاحًا ، مثل AlphaGo و AlphaZero، الاعتماد على المعلومات الكاملة. على النقيض من ذلك ، فإن ستراتيجو لديه لمسة تكساس هولدم، وهي لعبة بوكر غزاها DeepMind سابقًا باستخدام خوارزمية. لكن هذه الإستراتيجية تعثرت بالنسبة لـ Stratego ، ويرجع ذلك إلى حد كبير إلى طول اللعبة ، والتي على عكس البوكر ، عادة ما تشمل مئات الحركات.

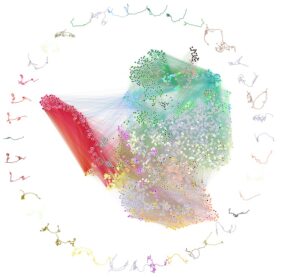

عدد مرات اللعب المحتملة مذهل. الشطرنج لديه نقطة انطلاق واحدة. يمتلك ستراتيجو أكثر من 1066 مواقع البداية الممكنة - أكثر بكثير من كل النجوم في الكون. شجرة لعبة ستراتيجو ، مجموع كل الحركات المحتملة في اللعبة ، يبلغ مجموعها 10 مذهل535.

"التعقيد الهائل لعدد النتائج المحتملة في الإستراتيجية يعني أن الخوارزميات التي تعمل بشكل جيد في ألعاب المعلومات المثالية ، وحتى تلك التي تعمل في لعبة البوكر ، لا تعمل ،" محمد مؤلف الدراسة الدكتور جوليان بيرولات في DeepMind. قال إن التحدي هو "ما أثارنا".

عقل جميل

يعني تعقيد ستراتيجو أن الإستراتيجية المعتادة للبحث عن حركات اللعب غير واردة. هذه التقنية التي يطلق عليها اسم بحث شجرة مونت كارلو ، "نهج قوي للألعاب القائمة على الذكاء الاصطناعي" ، ترسم المسارات المحتملة - مثل الفروع على الشجرة - التي يمكن أن تؤدي إلى النصر.

بدلاً من ذلك ، جاءت اللمسة السحرية لـ DeepNash من عالم الرياضيات جون ناش ، الذي تم تصويره في الفيلم عقل جميل. رائد في نظرية الألعاب ، فاز ناش بجائزة نوبل لعمله في ناش التوازن. ببساطة ، في كل لعبة ، يمكن للاعبين الاستفادة من مجموعة من الاستراتيجيات التي يتبعها الجميع ، بحيث لا يربح أي لاعب أي شيء من خلال تغيير استراتيجيته الخاصة. في Statego ، يؤدي هذا إلى لعبة محصلتها صفر: أي مكسب يحققه اللاعب ينتج عنه خسارة لخصمه.

بسبب تعقيد ستراتيجو ، اتخذ DeepNash منهجًا خالٍ من النماذج في الخوارزمية الخاصة بهم. هنا ، لا تحاول منظمة العفو الدولية وضع نموذج دقيق لسلوك خصمها. مثل الطفل ، لديه قائمة فارغة ، من نوع ما ، للتعلم. هذا الإعداد مفيد بشكل خاص في المراحل الأولى من اللعب ، "عندما يعرف DeepNash القليل عن قطع الخصم" ، مما يجعل التنبؤات "صعبة ، إن لم تكن مستحيلة" ، كما قال المؤلفون.

استخدم الفريق بعد ذلك التعلم التعزيزي العميق لتشغيل DeepNash ، بهدف إيجاد توازن ناش في اللعبة. إنها مباراة صنعت في الجنة: التعلم المعزز يساعد في تحديد أفضل خطوة تالية في كل خطوة من اللعبة ، بينما يوفر DeepNash استراتيجية تعليمية شاملة. لتقييم النظام ، صمم الفريق أيضًا "مدرسًا" باستخدام المعرفة من اللعبة لتصفية الأخطاء الواضحة التي من المحتمل ألا يكون لها معنى في العالم الحقيقي.

الممارسة تجعل من الكمال

كخطوة تعليمية أولى ، لعبت DeepNash ضد نفسها في 5.5 مليار لعبة ، وهو نهج شائع في تدريب الذكاء الاصطناعي يُطلق عليه اللعب الذاتي.

عندما يفوز أحد الأطراف ، يتم منح جائزة الذكاء الاصطناعي وتقوية معلمات الشبكة العصبية الاصطناعية الحالية. الجانب الآخر - نفس الذكاء الاصطناعي - يتلقى عقوبة لإضعاف قوة شبكته العصبية. إنه مثل التمرين على خطاب أمام المرآة. بمرور الوقت ، تكتشف الأخطاء وتحسن الأداء. في حالة DeepNash ، تنجرف نحو توازن Nash لأفضل طريقة لعب.

ماذا عن الأداء الفعلي؟

اختبر الفريق الخوارزمية ضد روبوتات الإستراتيجيو النخبة الأخرى ، والتي فاز بعضها ببطولة العالم لاستراتيجيات الكمبيوتر. سحق DeepNash خصومه بمعدل فوز يقارب 97 في المائة. عندما تم إطلاق العنان ضد Gravon - وهي منصة على الإنترنت للاعبين البشريين - تغلبت DeepNash على خصومها من البشر. بعد أكثر من أسبوعين من المباريات ضد لاعبي Gravon في أبريل من هذا العام ، صعد DeepNash إلى المركز الثالث في جميع المباريات المصنفة منذ عام 2002.

إنه يُظهر أن تحويل بيانات اللعب البشري إلى الذكاء الاصطناعي ليس ضروريًا لـ DeepNash للوصول إلى مستوى الأداء البشري - والتغلب عليه.

أظهر الذكاء الاصطناعي أيضًا بعض السلوكيات المثيرة للاهتمام مع الإعداد الأولي وأثناء اللعب. على سبيل المثال ، بدلاً من الاستقرار على وضع بداية "محسن" معين ، قام DeepNash بتحويل القطع باستمرار لمنع خصمه من اكتشاف الأنماط بمرور الوقت. أثناء اللعب ، ارتد الذكاء الاصطناعي بين الحركات التي تبدو غير منطقية - مثل التضحية بقطع عالية المستوى - لتحديد مكان القطع ذات التصنيف الأعلى للخصم عند الهجوم المضاد.

يمكن لـ DeepNash أيضًا الخداع. في إحدى المسرحية ، نقلت منظمة العفو الدولية قطعة منخفضة المستوى كما لو كانت قطعة عالية المستوى ، مما جذب الخصم البشري لمطاردة القطعة مع عقيدها رفيع المستوى. ضحى الذكاء الاصطناعي بالبيدق ، ولكنه بدوره استدرج قطعة التجسس القيمة للخصم في كمين.

على الرغم من أن برنامج DeepNash قد تم تطويره لـ Stratego ، إلا أنه قابل للتعميم في العالم الحقيقي. يمكن أن توجه الطريقة الأساسية الذكاء الاصطناعي للتعامل بشكل أفضل مع مستقبلنا غير المتوقع باستخدام معلومات محدودة - من التحكم في الحشود وحركة المرور إلى تحليل اضطرابات السوق.

قال الفريق: "من خلال إنشاء نظام ذكاء اصطناعي قابل للتعميم وقوي في مواجهة عدم اليقين ، نأمل في نقل قدرات حل المشكلات للذكاء الاصطناعي إلى عالمنا الذي لا يمكن التنبؤ به بطبيعته".

الصورة الائتمان: ديريك براف / فليكر