حافة هو مصطلح يشير إلى موقع بعيد عن السحابة أو مركز بيانات ضخم ، حيث يكون لديك جهاز كمبيوتر (جهاز حافة) قادر على تشغيل تطبيقات (حافة). الحوسبة المتطورة هي عملية تشغيل أعباء العمل على هذه الأجهزة المتطورة. التعلم الآلي على الحافة (ML @ Edge) هو مفهوم يجلب القدرة على تشغيل نماذج ML محليًا إلى الأجهزة المتطورة. يمكن بعد ذلك استدعاء نماذج ML هذه من خلال تطبيق الحافة. تعد ML @ Edge مهمة للعديد من السيناريوهات حيث يتم جمع البيانات الأولية من مصادر بعيدة عن السحابة. قد تحتوي هذه السيناريوهات أيضًا على متطلبات أو قيود محددة:

- زمن الوصول المنخفض والتنبؤات في الوقت الفعلي

- اتصال ضعيف أو غير موجود بالسحابة

- القيود القانونية التي لا تسمح بإرسال البيانات إلى خدمات خارجية

- مجموعات البيانات الكبيرة التي يجب معالجتها محليًا قبل إرسال الردود إلى السحابة

فيما يلي بعض حالات الاستخدام العديدة التي يمكن أن تستفيد من تشغيل نماذج ML بالقرب من المعدات التي تولد البيانات المستخدمة للتنبؤات:

- الأمن والسلامة - المنطقة المحظورة حيث تعمل الآلات الثقيلة في منفذ آلي يتم مراقبتها بواسطة كاميرا. إذا دخل شخص إلى هذه المنطقة عن طريق الخطأ ، يتم تفعيل آلية أمان لإيقاف الآلات وحماية الإنسان.

- الصيانة الوقائية - تجمع أجهزة استشعار الاهتزازات والصوت البيانات من علبة تروس لتوربينات الرياح. يعالج نموذج اكتشاف الشذوذ بيانات المستشعر ويحدد ما إذا كانت هناك حالات شاذة في الجهاز. في حالة اكتشاف حالة شاذة ، يمكن لجهاز الحافة بدء قياس طارئ في الوقت الفعلي لتجنب إتلاف المعدات ، مثل إشراك الفواصل أو فصل المولد عن الشبكة.

- كشف الخلل في خطوط الإنتاج - تلتقط الكاميرا صورًا للمنتجات على حزام ناقل وتعالج الإطارات بنموذج تصنيف الصور. في حالة اكتشاف عيب ، يمكن التخلص من المنتج تلقائيًا دون تدخل يدوي.

على الرغم من أن ML @ Edge يمكنها معالجة العديد من حالات الاستخدام ، إلا أن هناك تحديات معمارية معقدة تحتاج إلى حل من أجل الحصول على تصميم آمن وقوي وموثوق. في هذا المنشور ، ستتعرف على بعض التفاصيل حول ML @ Edge والموضوعات ذات الصلة وكيفية استخدام خدمات AWS للتغلب على هذه التحديات وتنفيذ حل كامل لـ ML الخاص بك في عبء العمل المتطور.

نظرة عامة على ML @ Edge

هناك ارتباك شائع عندما يتعلق الأمر بـ ML @ Edge وإنترنت الأشياء (IoT) ، لذلك من المهم توضيح كيف يختلف ML @ Edge عن إنترنت الأشياء وكيف يمكن أن يجتمع كلاهما معًا لتقديم حل قوي في حالات معينة.

يحتوي حل الحافة الذي يستخدم ML @ Edge على مكونين رئيسيين: تطبيق حافة ونموذج ML (تم استدعاؤه بواسطة التطبيق) يعملان على جهاز الحافة. تدور ML @ Edge حول التحكم في دورة حياة واحد أو أكثر من نماذج ML المنتشرة في أسطول من الأجهزة المتطورة. يمكن أن تبدأ دورة حياة نموذج ML على الجانب السحابي (على الأمازون SageMaker، على سبيل المثال) ولكنها تنتهي عادةً بنشر مستقل للنموذج على جهاز الحافة. يتطلب كل سيناريو دورات حياة مختلفة لنموذج ML يمكن أن تتكون من عدة مراحل ، مثل جمع البيانات ؛ إعداد البيانات بناء النموذج وتجميعه ونشره على جهاز الحافة ؛ نموذج التحميل والتشغيل ؛ وتكرار دورة الحياة.

آلية ML @ Edge ليست مسؤولة عن دورة حياة التطبيق. ينبغي اعتماد نهج مختلف لهذا الغرض. يمنحك فصل دورة حياة نموذج ML ودورة حياة التطبيق الحرية والمرونة لمواصلة تطويرهما في خطوات مختلفة. تخيل تطبيقًا للهاتف المحمول يقوم بتضمين نموذج ML كمورد مثل صورة أو ملف XML. في هذه الحالة ، في كل مرة تقوم فيها بتدريب نموذج جديد وترغب في نشره على الهواتف المحمولة ، تحتاج إلى إعادة نشر التطبيق بالكامل. هذا يستهلك الوقت والمال ، ويمكن أن يتسبب في حدوث أخطاء في تطبيقك. من خلال فصل دورة حياة نموذج ML ، فإنك تنشر تطبيق الأجهزة المحمولة مرة واحدة وتنشر أي عدد تريده من إصدارات نموذج ML.

ولكن كيف ترتبط إنترنت الأشياء بـ ML @ Edge؟ ترتبط إنترنت الأشياء بالأجسام المادية المضمنة بتقنيات مثل المستشعرات وقدرة المعالجة والبرامج. ترتبط هذه الكائنات بأجهزة وأنظمة أخرى عبر الإنترنت أو شبكات اتصال أخرى ، من أجل تبادل البيانات. يوضح الشكل التالي هذه العمارة. تم إنشاء هذا المفهوم في البداية عند التفكير في الأجهزة البسيطة التي تقوم فقط بجمع البيانات من الحافة وإجراء معالجة محلية بسيطة وإرسال النتيجة إلى وحدة حوسبة أكثر قوة تدير عمليات تحليلية تساعد الأفراد والشركات في اتخاذ قراراتهم. يعد حل إنترنت الأشياء مسؤولاً عن التحكم في دورة حياة التطبيقات المتطورة. لمزيد من المعلومات حول إنترنت الأشياء ، يرجى الرجوع إلى إنترنت الأشياء.

إذا كان لديك بالفعل تطبيق إنترنت الأشياء ، فيمكنك إضافة إمكانيات ML @ Edge لجعل المنتج أكثر كفاءة ، كما هو موضح في الشكل التالي. ضع في اعتبارك أن ML @ Edge لا تعتمد على إنترنت الأشياء ، ولكن يمكنك دمجها لإنشاء حل أكثر قوة. عندما تفعل ذلك ، فإنك تقوم بتحسين إمكانات جهازك البسيط لتوليد رؤى في الوقت الفعلي لعملك بشكل أسرع من مجرد إرسال البيانات إلى السحابة للمعالجة اللاحقة.

إذا كنت تنشئ حلاً متطورًا جديدًا من البداية باستخدام إمكانيات ML @ Edge ، فمن المهم تصميم بنية مرنة تدعم دورات حياة التطبيق ونموذج ML. نقدم بعض البنى المرجعية لتطبيقات الحافة باستخدام ML @ Edge لاحقًا في هذا المنشور. لكن أولاً ، دعنا نتعمق أكثر في الحوسبة المتطورة ونتعلم كيفية اختيار جهاز الحافة الصحيح للحل الخاص بك ، بناءً على قيود البيئة.

الحوسبة الحافة

اعتمادًا على مدى بُعد الجهاز عن السحابة أو مركز البيانات الضخمة (القاعدة) ، يجب مراعاة ثلاث خصائص رئيسية للأجهزة الطرفية لزيادة الأداء وطول عمر النظام: سعة الحوسبة والتخزين والاتصال واستهلاك الطاقة. يوضح الرسم البياني التالي ثلاث مجموعات من الأجهزة الطرفية التي تجمع بين المواصفات المختلفة لهذه الخصائص ، اعتمادًا على بُعدها عن القاعدة.

المجموعات هي كما يلي:

- MECs (حوسبة حواف متعددة الوصول) - تعد MECs أو مراكز البيانات الصغيرة ، التي تتميز بزمن انتقال منخفض أو منخفض للغاية وعرض نطاق ترددي مرتفع ، من البيئات الشائعة حيث يمكن أن تحقق ML @ Edge فوائد دون قيود كبيرة عند مقارنتها بأحمال العمل السحابية. توفر هوائيات وخوادم 5G في المصانع والمستودعات والمختبرات وما إلى ذلك مع الحد الأدنى من قيود الطاقة والاتصال الجيد بالإنترنت طرقًا مختلفة لتشغيل نماذج ML على وحدات معالجة الرسومات (GPU) ووحدات المعالجة المركزية (GPU) ، والأجهزة الافتراضية ، والحاويات ، والخوادم المعدنية.

- بالقرب من الحافة - يحدث هذا عندما يكون التنقل أو تجميع البيانات من المتطلبات ويكون للأجهزة بعض القيود فيما يتعلق باستهلاك الطاقة وقوة المعالجة ، ولكن لا يزال لديها بعض الاتصال الموثوق به ، على الرغم من زيادة زمن الانتقال ، مع إنتاجية محدودة وأكثر تكلفة من "بالقرب من الحافة". يتم تضمين تطبيقات الهاتف المحمول أو اللوحات المحددة لتسريع نماذج ML أو الأجهزة البسيطة ذات القدرة على تشغيل نماذج ML المغطاة بالشبكات اللاسلكية في هذه المجموعة.

- حافة بعيدة - في هذا السيناريو المتطرف ، تواجه الأجهزة المتطورة قيودًا شديدة على استهلاك الطاقة أو قيود الاتصال. وبالتالي ، فإن قوة المعالجة مقيدة أيضًا في العديد من السيناريوهات البعيدة. الزراعة والتعدين والمراقبة والأمن والنقل البحري هي بعض المجالات التي تلعب فيها الأجهزة المتطورة دورًا مهمًا. اللوحات البسيطة ، عادةً بدون وحدات معالجة الرسومات أو مسرعات الذكاء الاصطناعي الأخرى ، شائعة. وهي مصممة لتحميل نماذج ML البسيطة وتشغيلها ، وحفظ التنبؤات في قاعدة بيانات محلية ، والنوم حتى دورة التنبؤ التالية. يمكن أن تحتوي الأجهزة التي تحتاج إلى معالجة البيانات في الوقت الفعلي على مخازن محلية كبيرة لتجنب فقدان البيانات.

التحديات

من الشائع أن يكون لديك سيناريوهات ML @ Edge حيث لديك مئات أو آلاف (وربما ملايين) من الأجهزة التي تعمل بنفس الطرز والتطبيقات المتطورة. عندما تقوم بتوسيع نطاق نظامك ، من المهم أن يكون لديك حل قوي يمكنه إدارة عدد الأجهزة التي تحتاج إلى دعمها. هذه مهمة معقدة ولهذه السيناريوهات ، تحتاج إلى طرح العديد من الأسئلة:

- كيف يمكنني تشغيل نماذج ML على أسطول من الأجهزة على الحافة؟

- كيف يمكنني إنشاء نماذج ML وتحسينها ونشرها على أجهزة حافة متعددة؟

- كيف يمكنني تأمين النموذج الخاص بي أثناء نشره وتشغيله على الحافة؟

- كيف يمكنني مراقبة أداء النموذج الخاص بي وإعادة تدريبه ، إذا لزم الأمر؟

- كيف يمكنني التخلص من الحاجة إلى تثبيت إطار عمل كبير مثل TensorFlow أو PyTorch على جهازي المقيد؟

- كيف يمكنني الكشف عن نموذج واحد أو عدة نماذج باستخدام تطبيق Edge الخاص بي كواجهة برمجة تطبيقات بسيطة؟

- كيف أقوم بإنشاء مجموعة بيانات جديدة مع الحمولات والتنبؤات التي تم التقاطها بواسطة أجهزة الحافة؟

- كيف أقوم بكل هذه المهام تلقائيًا (MLOps plus ML @ Edge)؟

في القسم التالي ، نقدم إجابات على كل هذه الأسئلة من خلال أمثلة لحالات الاستخدام والبنى المرجعية. نناقش أيضًا خدمات AWS التي يمكنك دمجها لبناء حلول كاملة لكل من السيناريوهات التي تم استكشافها. ومع ذلك ، إذا كنت تريد البدء بتدفق بسيط للغاية يصف كيفية استخدام بعض الخدمات التي تقدمها AWS لإنشاء حل ML @ Edge ، فهذا مثال:

باستخدام SageMaker ، يمكنك بسهولة إعداد مجموعة بيانات وإنشاء نماذج ML التي يتم نشرها على الأجهزة المتطورة. مع أمازون سيجماكر نيو، يمكنك تجميع النموذج الذي قمت بتدريبه وتحسينه على جهاز الحافة المحدد الذي اخترته. بعد تجميع النموذج ، تحتاج فقط إلى وقت تشغيل خفيف لتشغيله (توفره الخدمة). مدير حافة أمازون SageMaker مسؤول عن إدارة دورة حياة جميع طرز ML المنتشرة في أسطولك من الأجهزة المتطورة. يمكن لـ Edge Manager إدارة أساطيل تصل إلى ملايين الأجهزة. يقوم الوكيل ، المثبت على كل جهاز من الأجهزة الطرفية ، بتعريف نماذج ML المنشورة باعتبارها واجهة برمجة تطبيقات (API) للتطبيق. الوكيل مسؤول أيضًا عن جمع المقاييس والحمولات والتنبؤات التي يمكنك استخدامها لمراقبة أو إنشاء مجموعة بيانات جديدة لإعادة تدريب النموذج إذا لزم الأمر. أخيرًا ، مع خطوط أنابيب Amazon SageMaker، يمكنك إنشاء خط أنابيب آلي مع جميع الخطوات المطلوبة لبناء نماذج ML وتحسينها ونشرها على أسطول أجهزتك. يمكن بعد ذلك تشغيل خط الأنابيب الآلي هذا من خلال أحداث بسيطة تحددها ، دون تدخل بشري.

حالة الاستخدام 1

لنفترض أن الشركة المصنعة للطائرات تريد اكتشاف وتتبع الأجزاء والأدوات في حظيرة الإنتاج. لتحسين الإنتاجية ، يجب توفير جميع الأجزاء المطلوبة والأدوات الصحيحة للمهندسين في كل مرحلة من مراحل الإنتاج. نريد أن نكون قادرين على الإجابة على أسئلة مثل: أين الجزء أ؟ أو أين الأداة "ب"؟ لدينا عدة كاميرات IP مثبتة بالفعل ومتصلة بشبكة محلية. تغطي الكاميرات الحظيرة بالكامل ويمكنها بث فيديو عالي الدقة في الوقت الفعلي عبر الشبكة.

أوس بانوراما يناسب بشكل جيد في هذه الحالة. توفر AWS Panorama جهاز ML وخدمة مُدارة تمكنك من إضافة رؤية الكمبيوتر (CV) إلى أسطولك الحالي من كاميرات IP والأتمتة. تمنحك AWS Panorama القدرة على إضافة سيرة ذاتية إلى كاميرات بروتوكول الإنترنت (IP) الحالية لديك وأتمتة المهام التي تتطلب عادةً الفحص والمراقبة البشرية.

في البنية المرجعية التالية ، نعرض المكونات الرئيسية للتطبيق قيد التشغيل على AWS Panorama Appliance. تسهل حزمة تطوير البرامج (SDK) الخاصة بالتطبيق البانورامي من التقاط الفيديو من تدفقات الكاميرا ، وإجراء الاستدلال بخط أنابيب من عدة نماذج ML ، ومعالجة النتائج باستخدام كود Python الذي يعمل داخل حاوية. يمكنك تشغيل نماذج من أي مكتبة ML شائعة مثل TensorFlow أو PyTorch أو TensorRT. يمكن دمج نتائج النموذج مع أنظمة الأعمال على شبكة المنطقة المحلية الخاصة بك ، مما يتيح لك الاستجابة للأحداث في الوقت الفعلي.

يتكون الحل من الخطوات التالية:

- قم بتوصيل وتكوين جهاز AWS Panorama بنفس الشبكة المحلية.

- تدريب نموذج ML (اكتشاف الكائن) لتحديد الأجزاء والأدوات في كل إطار.

- قم ببناء تطبيق AWS Panorama الذي يحصل على التنبؤات من نموذج ML ، ويطبق آلية تتبع على كل كائن ، ويرسل النتائج إلى قاعدة بيانات في الوقت الفعلي.

- يمكن للمشغلين إرسال استعلامات إلى قاعدة البيانات لتحديد الأجزاء والأدوات.

حالة الاستخدام 2

بالنسبة لحالة الاستخدام التالية ، تخيل أننا نقوم بإنشاء dashcam للمركبات القادرة على دعم السائق في العديد من المواقف ، مثل تجنب المشاة ، بناءً على لوحة CV25 من Ambaralla. قد تكون استضافة نماذج ML على جهاز بموارد نظام محدودة أمرًا صعبًا. في هذه الحالة ، لنفترض أن لدينا بالفعل آلية تسليم عبر الهواء (OTA) راسخة لنشر مكونات التطبيق المطلوبة على الجهاز الطرفي. ومع ذلك ، ما زلنا نستفيد من القدرة على القيام بنشر OTA للنموذج نفسه ، وبالتالي عزل دورة حياة التطبيق ودورة حياة النموذج.

مدير حافة أمازون SageMaker و أمازون سيجماكر نيو مناسب بشكل جيد لحالة الاستخدام هذه.

يسهّل Edge Manager على مطوري ML edge استخدام نفس الأدوات المألوفة في السحابة أو على الأجهزة المتطورة. فهو يقلل الوقت والجهد اللازمين لإيصال النماذج إلى الإنتاج ، مع السماح لك بمراقبة جودة الطراز وتحسينها باستمرار عبر أسطول أجهزتك. يتضمن SageMaker Edge آلية نشر OTA تساعدك على نشر النماذج على الأسطول بشكل مستقل عن التطبيق أو البرامج الثابتة للجهاز. ال وكيل مدير الحافة يسمح لك بتشغيل نماذج متعددة على نفس الجهاز. يجمع الوكيل بيانات التنبؤ بناءً على المنطق الذي تتحكم فيه ، مثل الفواصل الزمنية ، ويقوم بتحميلها إلى السحابة بحيث يمكنك إعادة تدريب النماذج بشكل دوري بمرور الوقت. تقوم SageMaker Edge بتوقيع نماذجك بشكل مشفر حتى تتمكن من التحقق من عدم العبث بها أثناء انتقالها من السحابة إلى جهاز الحافة.

Neo هو مترجم كخدمة وهو مناسب بشكل خاص في حالة الاستخدام هذه. يقوم Neo تلقائيًا بتحسين نماذج ML للاستدلال على المثيلات السحابية والأجهزة المتطورة للعمل بشكل أسرع دون فقدان الدقة. تبدأ بنموذج ML الذي تم إنشاؤه بواحد من الأطر المدعومة وتدربوا في SageMaker أو في أي مكان آخر. ثم تختار النظام الأساسي للجهاز المستهدف ، (راجع قائمة اجهزة مدعومة). بنقرة واحدة ، يقوم Neo بتحسين النموذج المدرب ويجمعه في حزمة يمكن تشغيلها باستخدام وقت تشغيل SageMaker Edge خفيف الوزن. يستخدم المترجم نموذج ML لتطبيق تحسينات الأداء التي تستخرج أفضل أداء متاح لطرازك على مثيل السحابة أو جهاز الحافة. تقوم بعد ذلك بنشر النموذج كنقطة نهاية SageMaker أو على أجهزة الحافة المدعومة وتبدأ في عمل التنبؤات.

يوضح الرسم البياني التالي هذه العمارة.

يتكون سير عمل الحل من الخطوات التالية:

- يقوم المطور ببناء وتدريب والتحقق من صحة وإنشاء نموذج نهائي يجب نشره في dashcam.

- استدعاء Neo لتجميع النموذج المدرَّب.

- يتم تثبيت وكيل SageMaker Edge وتكوينه على جهاز Edge ، وفي هذه الحالة كاميرا dashcam.

- قم بإنشاء حزمة نشر بنموذج موقّع ووقت التشغيل المستخدم بواسطة وكيل SageMaker Edge لتحميل النموذج الأمثل واستدعاءه.

- انشر الحزمة باستخدام آلية نشر OTA الحالية.

- يتفاعل تطبيق الحافة مع وكيل SageMaker Edge للقيام بالاستدلال.

- يمكن تكوين الوكيل (إذا لزم الأمر) لإرسال بيانات إدخال عينة في الوقت الفعلي من التطبيق لأغراض مراقبة النموذج والتحسين.

حالة الاستخدام 3

افترض أن عميلك يطور تطبيقًا يكتشف الشذوذ في آليات توربينات الرياح (مثل علبة التروس أو المولد أو الدوار). الهدف هو تقليل الضرر الذي يلحق بالمعدات من خلال تشغيل إجراءات الحماية المحلية أثناء الطيران. هذه التوربينات باهظة الثمن وتقع في أماكن يصعب الوصول إليها. يمكن تجهيز كل توربين بجهاز NVIDIA Jetson لمراقبة بيانات المستشعر من التوربين. نحتاج بعد ذلك إلى حل لالتقاط البيانات واستخدام خوارزمية ML لاكتشاف الحالات الشاذة. نحتاج أيضًا إلى آلية OTA لتحديث البرامج ونماذج ML على الجهاز.

AWS IoT Greengrass V2 جنبًا إلى جنب مع Edge Manager مناسب تمامًا في حالة الاستخدام هذه. AWS IoT Greengrass هي خدمة سحابية ووقت تشغيل إنترنت الأشياء مفتوح المصدر تساعدك على إنشاء تطبيقات إنترنت الأشياء ونشرها وإدارتها على أجهزتك. يمكنك استخدام AWS IoT Greengrass لإنشاء تطبيقات متطورة باستخدام وحدات برامج مسبقة الإنشاء تسمى مكونات، يمكنها توصيل أجهزتك المتطورة بخدمات AWS أو خدمات الجهات الخارجية. تجعل قدرة AWS IoT Greengrass هذه من السهل نشر الأصول على الأجهزة ، بما في ذلك وكيل SageMaker Edge. AWS IoT Greengrass مسؤول عن إدارة دورة حياة التطبيق ، بينما يفصل Edge Manager دورة حياة نموذج ML. يمنحك هذا المرونة لمواصلة تطوير الحل بالكامل من خلال نشر إصدارات جديدة من تطبيق الحافة ونماذج ML بشكل مستقل. الرسم البياني التالي يوضح هذه العمارة.

يتكون الحل من الخطوات التالية:

- يقوم المطور ببناء وتدريب والتحقق من صحة وإنشاء النموذج النهائي الذي يجب نشره في توربينات الرياح.

- استدعاء Neo لتجميع النموذج المدرَّب.

- قم بإنشاء مكون نموذج باستخدام Edge Manager مع تكامل AWS IoT Greengrass V2.

- قم بإعداد AWS IoT Greengrass V2.

- أنشئ مكونًا للاستدلال باستخدام AWS IoT Greengrass V2.

- يتفاعل تطبيق الحافة مع وكيل SageMaker Edge للقيام بالاستدلال.

- يمكن تكوين الوكيل (إذا لزم الأمر) لإرسال بيانات إدخال عينة في الوقت الفعلي من التطبيق لأغراض مراقبة النموذج والتحسين.

حالة الاستخدام 4

بالنسبة لحالة الاستخدام النهائي لدينا ، دعنا نلقي نظرة على سفينة تنقل الحاويات ، حيث تحتوي كل حاوية على اثنين من أجهزة الاستشعار وتقوم ببث إشارة إلى البنية التحتية للحوسبة والتخزين المنتشرة محليًا. التحدي هو أننا نريد معرفة محتوى كل حاوية ، وحالة البضائع على أساس درجة الحرارة والرطوبة والغازات داخل كل حاوية. نريد أيضًا تتبع جميع البضائع في كل حاوية. لا يوجد اتصال بالإنترنت طوال الرحلة ، وقد تستغرق الرحلة شهورًا. يجب أن تقوم نماذج ML التي تعمل على هذه البنية التحتية بمعالجة البيانات مسبقًا وإنشاء معلومات للإجابة على جميع أسئلتنا. يجب تخزين البيانات التي تم إنشاؤها محليًا لعدة أشهر. يقوم تطبيق Edge بتخزين جميع الاستنتاجات في قاعدة بيانات محلية ثم يقوم بمزامنة النتائج مع السحابة عندما تقترب السفينة من المنفذ.

أوس سنوكوني و أوس سنوبول من مجموعة AWS Snow يمكن أن يتناسب جيدًا في حالة الاستخدام هذه.

AWS Snowcone عبارة عن جهاز صغير وقوي وآمن للحوسبة المتطورة وترحيل البيانات. تم تصميم Snowcone وفقًا لمعيار OSHA لجهاز يمكن رفعه لشخص واحد. يمكّنك Snowcone من تشغيل أحمال عمل متطورة باستخدام ملفات الأمازون الحوسبة المرنة السحابية (Amazon EC2) والتخزين المحلي في البيئات الميدانية القاسية وغير المتصلة مثل منصات البترول ومركبات البحث والإنقاذ والمواقع العسكرية أو أرضيات المصانع ، بالإضافة إلى المكاتب البعيدة والمستشفيات ودور السينما.

يضيف Snowball المزيد من الحوسبة عند مقارنته بـ Snowcone ، وبالتالي قد يكون مناسبًا تمامًا للتطبيقات الأكثر تطلبًا. توفر ميزة Compute Optimized وحدة معالجة الرسومات NVIDIA Tesla V100 الاختيارية جنبًا إلى جنب مع مثيلات EC2 لتسريع أداء التطبيق في البيئات غير المتصلة. باستخدام خيار GPU ، يمكنك تشغيل تطبيقات مثل ML المتقدم وتحليل الفيديو بالحركة الكاملة في بيئات ذات اتصال ضئيل أو معدوم.

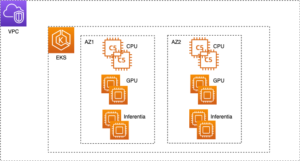

علاوة على مثيل EC2 ، لديك الحرية في إنشاء ونشر أي نوع من حلول الحافة. على سبيل المثال: يمكنك استخدام ملفات أمازون ECS أو أي مدير حاوية آخر لنشر تطبيق Edge و Edge Manager Agent ونموذج ML كحاويات فردية. ستكون هذه البنية مشابهة لحالة الاستخدام 2 (باستثناء أنها ستعمل دون اتصال بالإنترنت معظم الوقت) ، مع إضافة أداة إدارة الحاوية.

يوضح الرسم البياني التالي بنية الحل هذه.

لتنفيذ هذا الحل ، ما عليك سوى طلب جهاز Snow الخاص بك من وحدة تحكم إدارة AWS وأطلق مواردك.

وفي الختام

في هذا المنشور ، ناقشنا الجوانب المختلفة للحافة التي قد تختار العمل معها بناءً على حالة الاستخدام الخاصة بك. ناقشنا أيضًا بعض المفاهيم الأساسية حول ML @ Edge وكيف يمنحك فصل دورة حياة التطبيق ودورة حياة نموذج ML الحرية في تطويرهما دون أي اعتماد على بعضهما البعض. لقد أكدنا على كيفية اختيار الجهاز المناسب لحمل عملك وطرح الأسئلة الصحيحة أثناء عملية الحل يمكن أن يساعدك في العمل للخلف وتضييق نطاق خدمات AWS المناسبة. قدمنا أيضًا حالات استخدام مختلفة جنبًا إلى جنب مع البنى المرجعية لإلهامك لإنشاء حلولك الخاصة التي ستعمل مع أعباء عملك.

حول المؤلف

دينيش كومار سوبراماني هو مهندس حلول أول مع فريق UKIR SMB ، ومقره في إدنبرة ، اسكتلندا. وهو متخصص في الذكاء الاصطناعي والتعلم الآلي. يستمتع Dinesh بالعمل مع العملاء عبر الصناعات لمساعدتهم على حل مشكلاتهم مع خدمات AWS. خارج العمل ، يحب قضاء الوقت مع أسرته ولعب الشطرنج والاستمتاع بالموسيقى من مختلف الأنواع.

دينيش كومار سوبراماني هو مهندس حلول أول مع فريق UKIR SMB ، ومقره في إدنبرة ، اسكتلندا. وهو متخصص في الذكاء الاصطناعي والتعلم الآلي. يستمتع Dinesh بالعمل مع العملاء عبر الصناعات لمساعدتهم على حل مشكلاتهم مع خدمات AWS. خارج العمل ، يحب قضاء الوقت مع أسرته ولعب الشطرنج والاستمتاع بالموسيقى من مختلف الأنواع.

سمير أروجو هو مهندس حلول AI / ML في AWS. يساعد العملاء على إنشاء حلول AI / ML التي تحل تحديات أعمالهم باستخدام AWS. لقد كان يعمل في العديد من مشاريع الذكاء الاصطناعي / التعلم الآلي المتعلقة برؤية الكمبيوتر ومعالجة اللغة الطبيعية والتنبؤ والتعلم الآلي على الحافة والمزيد. إنه يحب اللعب بمشاريع الأجهزة والأتمتة في أوقات فراغه ، ولديه اهتمام خاص بالروبوتات.

سمير أروجو هو مهندس حلول AI / ML في AWS. يساعد العملاء على إنشاء حلول AI / ML التي تحل تحديات أعمالهم باستخدام AWS. لقد كان يعمل في العديد من مشاريع الذكاء الاصطناعي / التعلم الآلي المتعلقة برؤية الكمبيوتر ومعالجة اللغة الطبيعية والتنبؤ والتعلم الآلي على الحافة والمزيد. إنه يحب اللعب بمشاريع الأجهزة والأتمتة في أوقات فراغه ، ولديه اهتمام خاص بالروبوتات.

- "

- 100

- 5G

- a

- القدرة

- من نحن

- تسريع

- المعجلات

- يمكن الوصول

- في

- عمل

- إضافة

- العنوان

- متقدم

- زراعة

- AI

- خوارزمية

- الكل

- السماح

- يسمح

- سابقا

- بالرغم ان

- أمازون

- تحليل

- تحليلات

- إجابة

- في أى مكان

- API

- التطبيق

- تطبيق

- التطبيقات

- التقديم

- نهج

- اقتراب

- معماري

- هندسة معمارية

- المنطقة

- حول

- مصطنع

- الذكاء الاصطناعي

- الذكاء الاصطناعي وآلة التعلم

- ممتلكات

- سمعي

- أتمتة

- الآلي

- تلقائيا

- أتمتة

- متاح

- تجنب

- AWS

- قبل

- تستفيد

- الفوائد

- أفضل

- البيانات الكبيرة

- مجلس

- فواصل

- جلب

- البق

- نساعدك في بناء

- ابني

- يبني

- الأعمال

- كاميرات

- قدرات

- قادر على

- الطاقة الإنتاجية

- أسر

- يلتقط

- حقيبة

- الحالات

- معين

- تحدى

- التحديات

- شطرنج

- اختار

- تصنيف

- سحابة

- الكود

- جمع

- جمع

- مجموعة شتاء XNUMX

- تأتي

- مشترك

- Communication

- الشركات

- مقارنة

- إكمال

- مجمع

- عنصر

- مكونات

- تتألف

- إحصاء

- الكمبيوتر

- الحوسبة

- مفهوم

- حالة

- ارتباك

- التواصل

- متصل

- الإتصال

- استهلاك

- وعاء

- حاويات

- محتوى

- مراقبة

- استطاع

- زوجان

- بهيكل

- خلق

- خلق

- يخلق

- خلق

- زبون

- العملاء

- البيانات

- مراكز البيانات

- قاعدة البيانات

- أعمق

- التوصيل

- مطالب

- اعتمادا

- نشر

- نشر

- نشر

- نشر

- تصميم

- تصميم

- تفاصيل

- الكشف عن

- كشف

- المطور

- المطورين

- تطوير

- جهاز

- الأجهزة

- مختلف

- صعبة

- بحث

- لا

- إلى أسفل

- سائق

- أثناء

- كل

- بسهولة

- حافة

- الحوسبة حافة

- فعال

- جهد

- القضاء

- جزءا لا يتجزأ من

- وأكد

- تمكن

- نقطة النهاية

- ينتهي

- طاقة

- جذب

- المهندسين

- يدخل

- البيئة

- معدات

- خاصة

- أحداث

- يتطور

- المتطورة

- مثال

- إلا

- تبادل

- القائمة

- أقصى

- المصانع

- مصنع

- مألوف

- للعائلات

- أسرع

- الميزات

- الشكل

- أخيرا

- الاسم الأول

- تناسب

- سريع

- مرونة

- مرن

- تدفق

- متابعيك

- متابعات

- FRAME

- الإطار

- مجانًا

- حرية

- تبدأ من

- بالإضافة إلى

- توليد

- ولدت

- مولد كهربائي

- هدف

- خير

- بضائع

- وحدة معالجة الرسوميات:

- وحدات معالجة الرسومات

- عظيم

- شبكة

- تجمع

- مجموعات

- أجهزة التبخير

- مساعدة

- يساعد

- مرتفع

- أعلى

- المستشفيات

- استضافة

- كيفية

- كيفية

- لكن

- HTTPS

- الانسان

- مئات

- تحديد

- صورة

- صور

- تنفيذ

- أهمية

- تحسن

- شامل

- يشمل

- بما فيه

- مستقل

- بشكل مستقل

- فرد

- الصناعات

- معلومات

- البنية التحتية

- إدخال

- رؤى

- مثل

- المتكاملة

- التكامل

- رؤيتنا

- مصلحة

- Internet

- إنترنت الأشياء

- قام المحفل

- IP

- IT

- نفسها

- احتفظ

- القفل

- علم

- لغة

- إطلاق

- تعلم

- تعلم

- المكتبة

- دورات حياة

- ضوء

- خفيفة الوزن

- محدود

- خطوط

- قائمة

- القليل

- تحميل

- جار التحميل

- محلي

- محليا

- موقع

- بحث

- آلة

- آلة التعلم

- الآلات

- رائد

- جعل

- يصنع

- القيام ب

- إدارة

- تمكن

- إدارة

- مدير

- إدارة

- كتيب

- الشركة المصنعة

- آلية

- المقاييس

- عسكر

- ملايين

- مانع

- تعدين

- ML

- الجوال

- تطبيقات الجوال

- تطبيقات الجوال

- الهواتف النقالة

- التنقل

- نموذج

- عارضات ازياء

- مال

- مراقبة

- مراقبة

- المقبلة.

- الأكثر من ذلك

- أكثر

- فيلم

- متعدد

- موسيقى

- طبيعي

- إحتياجات

- الأجسام القريبة من الأرض

- شبكة

- الشبكات

- التالي

- عادة

- عدد

- NVIDIA

- عرض

- مكاتب

- حاليا

- زيت

- طريقة التوسع

- مشغلي

- الأمثل

- الأمثل

- خيار

- طلب

- أخرى

- الخاصة

- صفقة

- جزء

- خاص

- مجتمع

- أداء

- شخص

- الهواتف

- مادي

- المنصة

- بلايستشن

- لعب

- أكثر الاستفسارات

- محتمل

- قوة

- قوي

- تنبؤ

- تنبؤات

- إعداد

- مشاكل

- عملية المعالجة

- العمليات

- معالجة

- منتج

- الإنتــاج

- إنتاجية

- المنتجات

- مشروع ناجح

- حماية

- الحماية

- بروتوكول

- تزود

- المقدمة

- ويوفر

- نشر

- غرض

- أغراض

- جودة

- الخام

- في الوقت الحقيقي

- معلومات الوقت الحقيقي

- يشير

- بخصوص

- الخدمة الموثوقة

- عن بعد

- تطلب

- مطلوب

- المتطلبات الأساسية

- مورد

- الموارد

- مسؤول

- القيود

- النتائج

- الروبوتات

- النوع

- يجري

- تشغيل

- السلامة

- نفسه

- حجم

- الإستراحة

- بحث

- تأمين

- أمن

- الخدمة

- خدمات

- عدة

- أظهرت

- لوحات

- مماثل

- الاشارات

- عزباء

- المواقع

- النوم

- صغير

- ثلج

- So

- تطبيقات الكمبيوتر

- حل

- الحلول

- حل

- بعض

- تتخصص

- محدد

- مواصفات

- الإنفاق

- المسرح

- مراحل

- مستقل

- معيار

- بداية

- لا يزال

- تخزين

- فروعنا

- مجرى

- الدعم

- مدعومة

- دعم

- الدعم

- المراقبة

- نظام

- أنظمة

- الهدف

- المهام

- فريق

- التكنولوجيا

- تسلا

- •

- وبالتالي

- وبالتالي

- الأشياء

- تفكير

- طرف ثالث

- الآلاف

- ثلاثة

- عبر

- طوال

- الإنتاجية

- الوقت

- سويا

- أداة

- أدوات

- تيشرت

- المواضيع

- مسار

- تتبع الشحنة

- تقليديا

- القطارات

- وسائل النقل

- أثار

- وحدة

- تستخدم

- السيارات

- تحقق من

- فيديو

- افتراضي

- رؤيتنا

- طرق

- في حين

- ويكيبيديا

- ريح

- لاسلكي

- بدون

- للعمل

- عامل

- سوف

- XML

- حل متجر العقارات الشامل الخاص بك في جورجيا