يقدم العديد من عملاء AWS البحث والتحليلات والمعلومات المهنية كخدمة. يمكّن هذا النوع من البحث وذكاء الأعمال عملائهم النهائيين من البقاء في صدارة الأسواق والمنافسين ، وتحديد فرص النمو ، ومعالجة المشكلات بشكل استباقي. على سبيل المثال ، يقوم بعض عملاء قطاع الخدمات المالية لدينا بإجراء بحث عن الأسهم وصناديق التحوط وشركات إدارة الاستثمار لمساعدتهم على فهم الاتجاهات وتحديد استراتيجيات المحفظة. في صناعة الصحة ، أصبح جزء كبير بشكل متزايد من البحوث الصحية يعتمد على المعلومات. يستلزم قدر كبير من البحث تحليل البيانات التي تم جمعها في البداية للتشخيص أو العلاج أو لمشاريع بحثية أخرى ، ويتم استخدامها الآن لأغراض بحثية جديدة. أدت هذه الأشكال من البحوث الصحية إلى الوقاية الأولية الفعالة لتجنب الحالات الجديدة ، والوقاية الثانوية للكشف المبكر ، والوقاية من أجل إدارة أفضل للمرض. لا تؤدي نتائج البحث إلى تحسين نوعية الحياة فحسب ، بل تساعد أيضًا في تقليل نفقات الرعاية الصحية.

يميل العملاء إلى استيعاب المعلومات من المصادر العامة والخاصة. ثم يقومون بتطبيق نماذج معالجة اللغة الطبيعية (NLP) المنشأة أو المخصصة لتلخيص الاتجاه وتحديده وتكوين رؤى بناءً على هذه المعلومات. تتعامل نماذج البرمجة اللغوية العصبية المستخدمة لهذه الأنواع من المهام البحثية مع النماذج الكبيرة وعادةً ما تتضمن مقالات طويلة يتم تلخيصها مع الأخذ في الاعتبار حجم المجموعة - ونقاط النهاية المخصصة ، والتي لم يتم تحسين التكلفة فيها في الوقت الحالي. تتلقى هذه التطبيقات دفعة من حركة المرور الواردة في أوقات مختلفة من اليوم.

نعتقد أن العملاء سيستفيدون بشكل كبير من القدرة على تقليص حجمهم إلى الصفر وزيادة قدرتهم على الاستدلال على أساس الحاجة. يؤدي هذا إلى تحسين تكلفة البحث ولا يزال لا يساوم على جودة الاستدلالات. يناقش هذا المنشور كيف تعانق الوجه مع الأمازون SageMaker يمكن أن يساعد الاستدلال غير المتزامن في تحقيق ذلك.

يمكنك إنشاء نماذج تلخيص نصية باستخدام العديد من أطر عمل التعلم العميق مثل TensorFlow و PyTorch و Apache MXNet. تحتوي هذه النماذج عادةً على حمولة إدخال كبيرة من مستندات نصية متعددة ذات أحجام مختلفة. تتطلب نماذج التعلم العميق المتقدمة معالجة مسبقة كثيفة الحوسبة قبل استدلال النموذج. يمكن أن تصل أوقات المعالجة إلى بضع دقائق ، مما يزيل خيار تشغيل الاستدلال في الوقت الفعلي عن طريق تمرير الحمولات عبر واجهة برمجة تطبيقات HTTP. بدلاً من ذلك ، تحتاج إلى معالجة حمولات الإدخال بشكل غير متزامن من ملف تخزين كائنات مثل خدمة تخزين أمازون البسيطة (Amazon S3) مع قائمة انتظار تلقائية وعتبة التزامن محددة مسبقًا. يجب أن يكون النظام قادرًا على تلقي إشعارات الحالة وتقليل التكاليف غير الضرورية عن طريق تنظيف الموارد عند اكتمال المهام.

يساعد SageMaker علماء البيانات والمطورين على إعداد وبناء وتدريب ونشر نماذج عالية الجودة للتعلم الآلي (ML) بسرعة من خلال الجمع بين مجموعة واسعة من القدرات المصممة لغرض التعلم الآلي. يوفر SageMaker حاويات تقديم النماذج مفتوحة المصدر الأكثر تقدمًا لـ XGBoost (حاوية, SDK) ، Scikit-Learn (حاوية, SDK) ، PyTorch (حاوية, SDK) ، TensorFlow (حاوية, SDK) و Apache MXNet (حاوية, SDK).

- الاستدلال في الوقت الحقيقي تعد نقاط النهاية مناسبة لأحمال العمل التي يجب معالجتها بمتطلبات زمن انتقال منخفض في حدود مللي ثانية إلى ثانية.

- تحويل دفعة مثالي للتنبؤات في وضع عدم الاتصال على مجموعات كبيرة من البيانات.

- استدلال Amazon SageMaker Serverless (في وضع المعاينة وغير موصى به لأحمال العمل الإنتاجية حتى كتابة هذه السطور) هو خيار استدلال مبني لغرض معين يسهل عليك نشر نماذج ML وقياسها. يعد الاستدلال بدون خادم مثاليًا لأحمال العمل التي لها فترات خمول بين طفرات حركة المرور ويمكن أن تتسامح مع عمليات البدء الباردة.

- الاستدلال غير المتزامن قائمة انتظار الطلبات الواردة. إنها مثالية لأحمال العمل حيث تكون أحجام الطلبات كبيرة (حتى 1 غيغابايت) وتكون أوقات معالجة الاستدلال في حدود الدقائق (حتى 15 دقيقة). يمكّنك الاستدلال غير المتزامن من توفير التكاليف عن طريق القياس التلقائي لعدد المثيلات إلى الصفر في حالة عدم وجود طلبات للمعالجة.

حل نظرة عامة

في هذا المنشور ، نقوم بنشر ملف نموذج PEGASUS تم تدريبه مسبقًا لإجراء تلخيص نصي من وجه يعانق إلى خدمات استضافة SageMaker. نحن نستخدم النموذج كما هو من Hugging Face من أجل البساطة. ومع ذلك ، يمكنك ذلك صقل النموذج بناءً على مجموعة بيانات مخصصة. يمكنك أيضًا تجربة الطرز الأخرى المتوفرة في معانقة الوجه النموذجي المحور. نوفر أيضًا نقطة نهاية الاستدلال غير المتزامن التي تستضيف هذا النموذج ، والتي يمكنك من خلالها الحصول على تنبؤات.

يتوقع معالج الاستدلال غير المتزامن لنقطة النهاية مقالة باعتبارها حمولة إدخال. النص الملخص للمقال هو الإخراج. يتم تخزين المخرجات في قاعدة البيانات لتحليل الاتجاهات أو يتم تغذيتها في نهاية المطاف لمزيد من التحليلات. يستمد تحليل المصب رؤى البيانات التي تساعد في البحث.

نوضح كيف تمكّنك نقاط نهاية الاستدلال غير المتزامن من الحصول على إعلامات التزامن وإكمال المعرفة من قبل المستخدم. نقوم بتكوين القياس التلقائي للمثيلات الموجودة خلف نقطة النهاية لتقليصها إلى الصفر عند انخفاض حركة المرور وتوسيع نطاقها احتياطيًا مع امتلاء قائمة انتظار الطلبات.

نحن نستخدم أيضا الأمازون CloudWatch مقاييس لمراقبة حجم قائمة الانتظار وإجمالي وقت المعالجة والاستدعاءات التي تتم معالجتها.

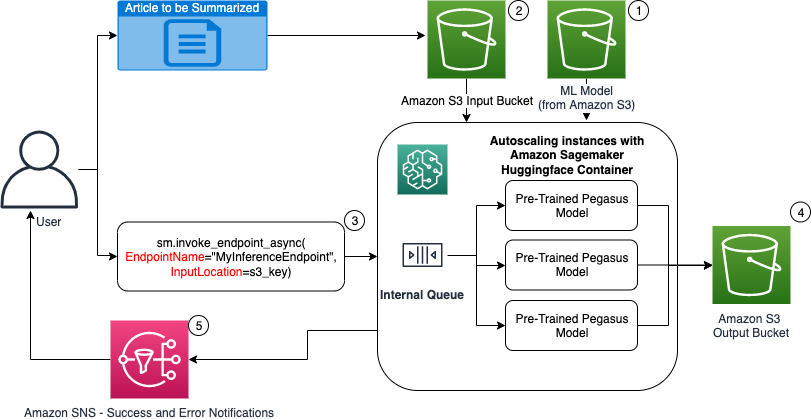

في الرسم البياني التالي ، نعرض الخطوات المتضمنة أثناء إجراء الاستدلال باستخدام نقطة نهاية الاستدلال غير المتزامن.

- لدينا تدريب مسبق PEGASUS يتم استضافة نموذج ML أولاً على نقطة نهاية القياس.

- يقوم المستخدم بتحميل المقالة ليتم تلخيصها في حاوية إدخال S3.

- يتم استدعاء نقطة نهاية الاستدلال غير المتزامن باستخدام API.

- بعد اكتمال الاستدلال ، يتم حفظ النتيجة في حاوية الإخراج S3.

- An خدمة إعلام أمازون البسيطة يتم إرسال إشعار (Amazon SNS) إلى المستخدم لإخطاره بنجاح أو فشل.

إنشاء نقطة نهاية الاستدلال غير المتزامن

نقوم بإنشاء نقطة نهاية الاستدلال غير المتزامن المشابهة لنقطة النهاية المستضافة في الوقت الفعلي. تتضمن الخطوات إنشاء نموذج SageMaker ، متبوعًا بتكوين نقطة النهاية ونشر نقطة النهاية. يتمثل الاختلاف بين نوعي نقاط النهاية في أن تكوين نقطة نهاية الاستدلال غير المتزامن يحتوي على ملف AsyncInferenceConfig الجزء. نحدد هنا مسار إخراج S3 للنتائج من استدعاء نقطة النهاية ونقوم اختياريًا بتضمين موضوعات SNS للإخطارات الخاصة بالنجاح والفشل. نحدد أيضًا الحد الأقصى لعدد الاستدعاءات المتزامنة لكل مثيل على النحو الذي يحدده العميل. انظر الكود التالي:

للحصول على تفاصيل حول API لإنشاء تكوين نقطة نهاية للاستدلال غير المتزامن ، راجع قم بإنشاء نقطة نهاية للاستدلال غير المتزامن.

استدعاء نقطة نهاية الاستدلال غير المتزامن

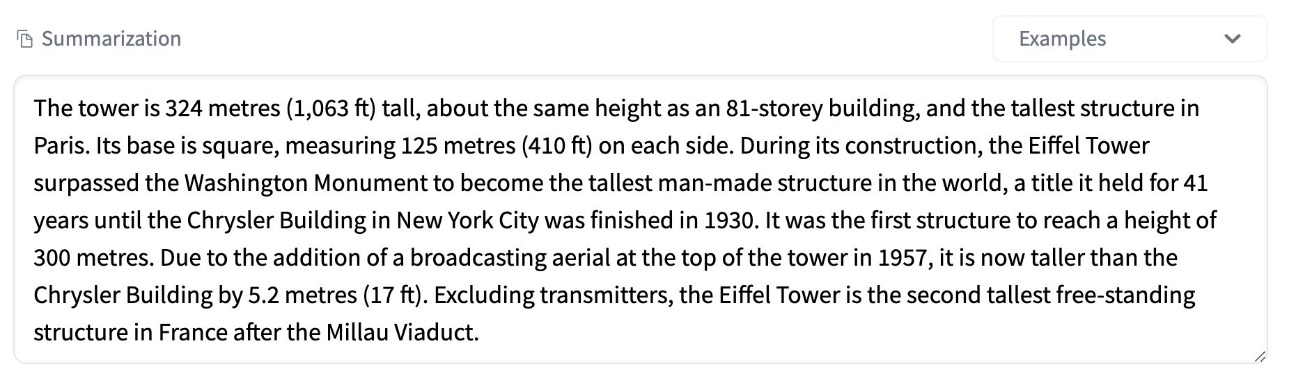

تُظهر لقطة الشاشة التالية مقالة موجزة نستخدمها كحمولة إدخال لدينا:

الكود التالي يقوم بتحميل المقال كملف input.json ملف إلى Amazon S3:

نستخدم Amazon S3 URI لملف حمولة الإدخال لاستدعاء نقطة النهاية. يحتوي كائن الاستجابة على موقع الإخراج في Amazon S3 لاسترداد النتائج بعد الاكتمال:

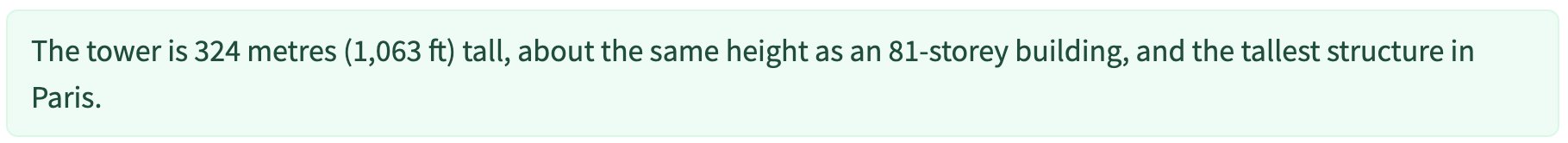

تُظهر لقطة الشاشة التالية نموذج تلخيص ما بعد الإخراج:

للحصول على تفاصيل حول API لاستدعاء نقطة نهاية الاستدلال غير المتزامن ، راجع استدعاء نقطة نهاية الاستدلال غير المتزامن.

ضع طلبات الاستدعاء في قائمة انتظار مع التزامن المعرفة من قبل المستخدم

تضع نقطة نهاية الاستدلال غير المتزامن طلبات الاستدعاء في قائمة انتظار تلقائيًا. هذه قائمة انتظار مُدارة بالكامل مع مقاييس مراقبة متنوعة ولا تتطلب أي تكوين إضافي. يستخدم MaxConcurrentInvocationsPerInstance المعلمة في تكوين نقطة النهاية السابقة لمعالجة الطلبات الجديدة من قائمة الانتظار بعد اكتمال الطلبات السابقة. MaxConcurrentInvocationsPerInstance هو الحد الأقصى لعدد الطلبات المتزامنة التي يرسلها عميل SageMaker إلى حاوية النموذج. إذا لم يتم تقديم أي قيمة ، فإن SageMaker يختار القيمة المثلى لك.

مثيلات القياس التلقائي داخل نقطة نهاية الاستدلال غير المتزامن

لقد قمنا بتعيين سياسة القياس التلقائي بحد أدنى للسعة صفر وبسعة قصوى تبلغ خمس مثيلات. على عكس نقاط النهاية المستضافة في الوقت الفعلي ، تدعم نقاط نهاية الاستدلال غير المتزامن تصغير الحالات إلى الصفر عن طريق تعيين الحد الأدنى للسعة على صفر. نحن نستخدم ال ApproximateBacklogSizePerInstance مقياس لتكوين سياسة القياس مع تراكم قائمة انتظار مستهدفة من خمسة لكل مثيل للتوسع بشكل أكبر. حددنا فترة التهدئة لـ ScaleInCooldown إلى 120 ثانية و ScaleOutCooldown إلى 120 ثانية. قيمة ApproximateBacklogSizePerInstance يتم اختياره بناءً على حركة المرور وحساسيتك لسرعة القياس. كلما توسعت بشكل أسرع ، قلت التكلفة التي تتحملها ، ولكن كلما زاد احتمال أن تضطر إلى التوسع مرة أخرى عند ورود طلبات جديدة. وكلما كان التوسع أبطأ ، زادت التكلفة التي تتحملها ، ولكنك أقل احتمالًا يأتي طلب عندما تكون أقل من الحجم.

للحصول على تفاصيل حول واجهة برمجة التطبيقات للقياس التلقائي لنقطة نهاية الاستدلال غير المتزامن ، راجع ملف مقياس تلقائي لنقطة نهاية الاستدلال غير المتزامن.

تكوين الإخطارات من نقطة نهاية الاستدلال غير المتزامن

نقوم بإنشاء موضوعين منفصلين SNS لإشعارات النجاح والخطأ لكل نتيجة استدعاء لنقطة النهاية:

تتضمن الخيارات الأخرى للإشعارات التحقق بشكل دوري من إخراج حاوية S3 ، أو استخدام إشعارات حاوية S3 لتهيئة AWS لامدا وظيفة عند تحميل الملف. يتم تضمين إخطارات SNS في قسم تكوين نقطة النهاية كما هو موضح سابقًا.

للحصول على تفاصيل حول كيفية إعداد الإعلامات من نقطة نهاية الاستدلال غير المتزامن ، راجع تحقق من نتائج التنبؤ.

مراقبة نقطة نهاية الاستدلال غير المتزامن

نحن نراقب نقطة نهاية الاستدلال غير المتزامن مع مقاييس CloudWatch الإضافية المضمنة الخاصة بالاستدلال غير المتزامن. على سبيل المثال ، نراقب طول قائمة الانتظار في كل حالة باستخدام ApproximateBacklogSizePerInstance وإجمالي طول قائمة الانتظار مع ApproximateBacklogSize.

للحصول على قائمة كاملة من المقاييس ، يرجى الرجوع إلى مراقبة نقاط نهاية الاستدلال غير المتزامن.

يمكننا تحسين تكوين نقطة النهاية للحصول على المثيل الأكثر فعالية من حيث التكلفة مع الأداء العالي. على سبيل المثال ، يمكننا استخدام مثيل مع Amazon Elastic Inference أو AWS Inferentia. يمكننا أيضًا زيادة مستوى التزامن تدريجيًا وصولاً إلى ذروة الإنتاجية أثناء تعديل معلمات الخادم والحاوية النموذجية الأخرى.

الرسوم البيانية CloudWatch

لقد قمنا بمحاكاة حركة مرور من 10,000 طلب استنتاج تتدفق خلال فترة زمنية إلى نقطة نهاية الاستدلال غير المتزامن التي تم تمكينها باستخدام سياسة القياس التلقائي الموضحة في القسم السابق.

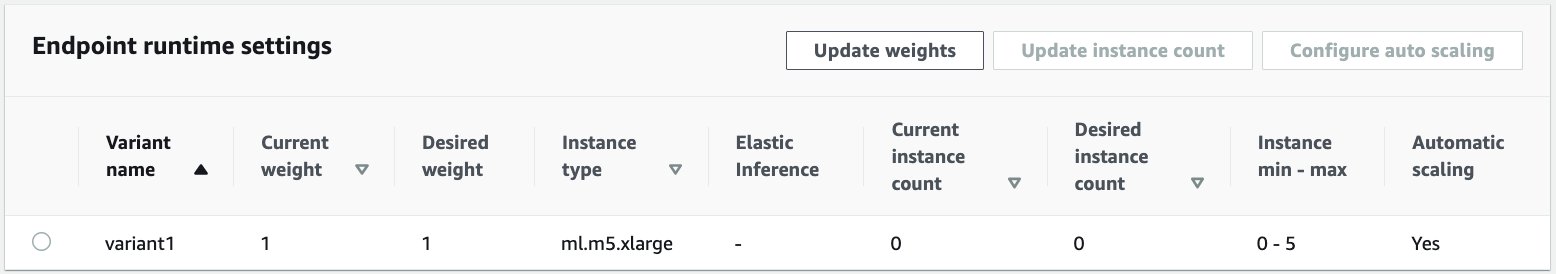

تُظهر لقطة الشاشة التالية مقاييس المثيل قبل بدء تدفق الطلبات. نبدأ بنقطة نهاية مباشرة بدون أي مثيلات قيد التشغيل:

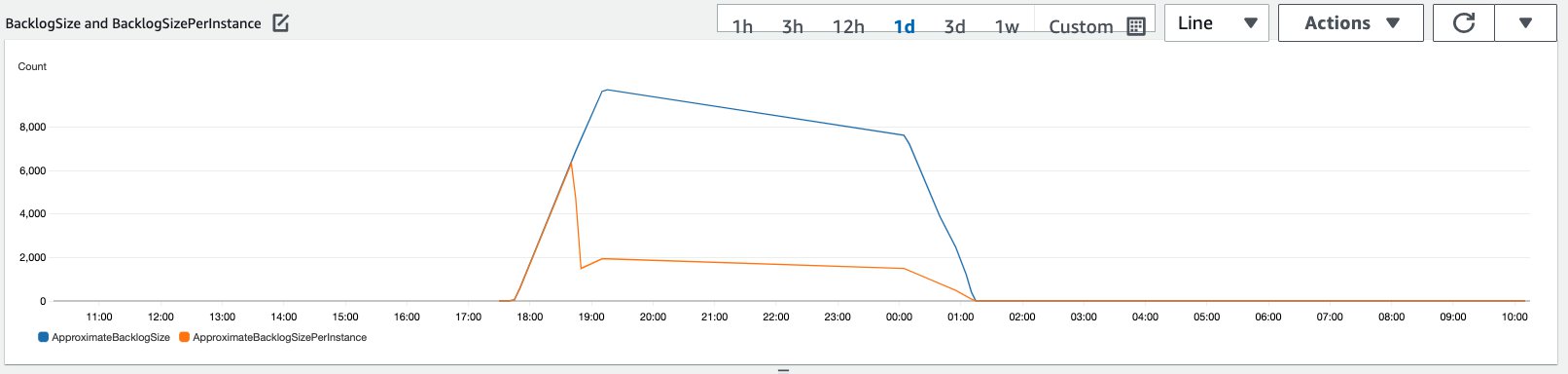

يوضح الرسم البياني التالي كيف أن ملف BacklogSize و BacklogSizePerInstance تتغير المقاييس عندما يبدأ القياس التلقائي ويتم مشاركة الحمل على نقطة النهاية بواسطة مثيلات متعددة تم توفيرها كجزء من عملية القياس التلقائي.

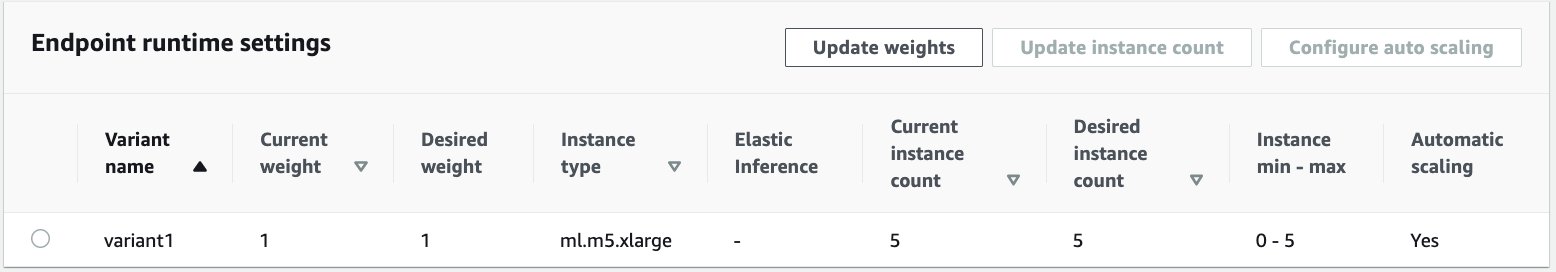

كما هو موضح في لقطة الشاشة التالية ، زاد عدد المثيلات مع زيادة عدد الاستدلالات:

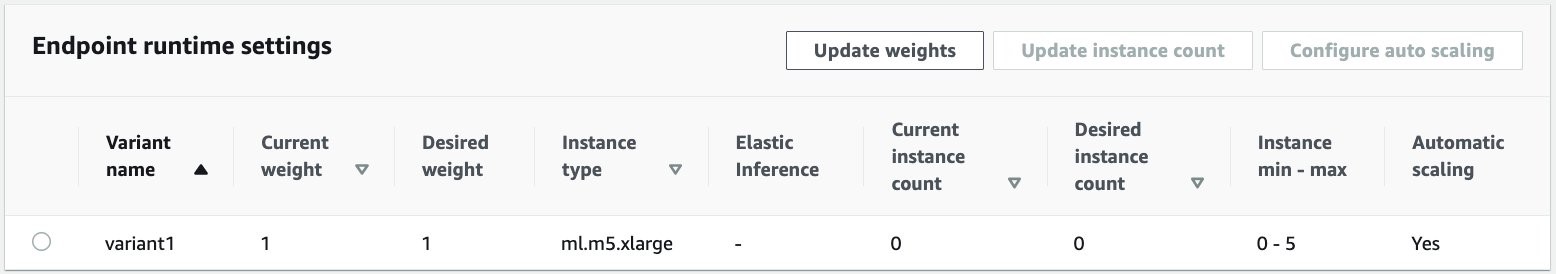

توضح لقطة الشاشة التالية كيف يعيد القياس نقطة النهاية إلى الحالة الأولية لعدم وجود مثيلات قيد التشغيل:

تنظيف

بعد اكتمال جميع الطلبات ، يمكننا حذف نقطة النهاية المشابهة لحذف نقاط النهاية المستضافة في الوقت الفعلي. لاحظ أنه إذا قمنا بتعيين الحد الأدنى من سعة نقاط نهاية الاستدلال غير المتزامن على صفر ، فلن يتم تكبد رسوم مثيل بعد تقليصها إلى الصفر.

إذا قمت بتمكين القياس التلقائي لنقطة النهاية الخاصة بك ، فتأكد من إلغاء تسجيل نقطة النهاية كهدف قابل للتحجيم قبل حذف نقطة النهاية. للقيام بذلك ، قم بتشغيل الكود التالي:

تذكر حذف نقطة النهاية الخاصة بك بعد الاستخدام حيث سيتم محاسبتك على المثيلات المستخدمة في هذا العرض التوضيحي.

تحتاج أيضًا إلى حذف كائنات S3 وموضوعات SNS. إذا قمت بإنشاء أي موارد AWS أخرى لاستهلاك إعلامات SNS واتخاذ إجراء بشأنها ، فقد ترغب أيضًا في حذفها.

وفي الختام

في هذا المنشور ، أوضحنا كيفية استخدام قدرة الاستدلال غير المتزامن الجديدة من SageMaker لمعالجة حمولة إدخال كبيرة نموذجية تشكل جزءًا من مهمة التلخيص. للاستدلال ، استخدمنا نموذجًا من Hugging Face ونشرناه على نقطة نهاية الاستدلال غير المتزامن. شرحنا التحديات الشائعة لحركة المرور المتدفقة ، وأوقات معالجة النماذج العالية ، والحمولات الكبيرة المرتبطة بتحليلات البحث. ساعدتنا القدرة الكامنة لنقطة نهاية الاستدلال غير المتزامن على إدارة قوائم الانتظار الداخلية ، وحدود التزامن المحددة مسبقًا ، وتكوين إشعارات الاستجابة ، والتخفيض تلقائيًا إلى الصفر على مواجهة هذه التحديات. الكود الكامل لهذا المثال متاح في GitHub جيثب:.

لتبدأ مع SageMaker الاستدلال غير المتزامن ، تحقق من الاستدلال غير المتزامن.

حول المؤلف

دينيش كومار سوبراماني هو مهندس حلول أول مع فريق UKIR SMB ، ومقره في إدنبرة ، اسكتلندا. وهو متخصص في الذكاء الاصطناعي والتعلم الآلي. يستمتع Dinesh بالعمل مع العملاء عبر الصناعات لمساعدتهم على حل مشكلاتهم مع خدمات AWS. خارج العمل ، يحب قضاء الوقت مع أسرته ولعب الشطرنج والاستمتاع بالموسيقى من مختلف الأنواع.

دينيش كومار سوبراماني هو مهندس حلول أول مع فريق UKIR SMB ، ومقره في إدنبرة ، اسكتلندا. وهو متخصص في الذكاء الاصطناعي والتعلم الآلي. يستمتع Dinesh بالعمل مع العملاء عبر الصناعات لمساعدتهم على حل مشكلاتهم مع خدمات AWS. خارج العمل ، يحب قضاء الوقت مع أسرته ولعب الشطرنج والاستمتاع بالموسيقى من مختلف الأنواع.

راغو راميشا هو مهندس حلول ML مع فريق Amazon SageMaker Service. إنه يركز على مساعدة العملاء في بناء ونشر وترحيل أعباء عمل إنتاج ML إلى SageMaker على نطاق واسع. وهو متخصص في مجالات التعلم الآلي والذكاء الاصطناعي ورؤية الكمبيوتر ، وهو حاصل على درجة الماجستير في علوم الكمبيوتر من جامعة UT Dallas. في أوقات فراغه يستمتع بالسفر والتصوير.

راغو راميشا هو مهندس حلول ML مع فريق Amazon SageMaker Service. إنه يركز على مساعدة العملاء في بناء ونشر وترحيل أعباء عمل إنتاج ML إلى SageMaker على نطاق واسع. وهو متخصص في مجالات التعلم الآلي والذكاء الاصطناعي ورؤية الكمبيوتر ، وهو حاصل على درجة الماجستير في علوم الكمبيوتر من جامعة UT Dallas. في أوقات فراغه يستمتع بالسفر والتصوير.

- كوينسمارت. أفضل بورصة للبيتكوين والعملات المشفرة في أوروبا.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. دخول مجاني.

- كريبتوهوك. الرادار. تجربة مجانية.

- المصدر: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- في

- اكشن

- نشاط

- إضافي

- العنوان

- متقدم

- AI

- الكل

- أمازون

- كمية

- تحليل

- تحليلات

- آخر

- API

- تطبيق

- التطبيقات

- البند

- مقالات

- مصطنع

- الذكاء الاصطناعي

- الذكاء الاصطناعي وآلة التعلم

- السيارات

- متاح

- المتوسط

- AWS

- أساس

- يجري

- الحدود

- نساعدك في بناء

- مدمج

- الأعمال

- ذكاء الأعمال

- يستطيع الحصول على

- قدرات

- الطاقة الإنتاجية

- الحالات

- التحديات

- تغيير

- متهم

- اسعارنا محددة من قبل وزارة العمل

- تدقيق

- شطرنج

- سوائل التنظيف

- الكود

- مشترك

- الشركات

- المنافسين

- علوم الكمبيوتر

- الاعداد

- تستهلك

- وعاء

- حاويات

- يحتوي

- فعاله من حيث التكلفه

- التكاليف

- خلق

- العملاء

- دالاس

- البيانات

- قاعدة البيانات

- يوم

- صفقة

- مخصصة

- نشر

- نشر

- كشف

- المطورين

- مختلف

- مرض

- وثائق

- لا

- المجالات

- إلى أسفل

- في وقت مبكر

- الطُرق الفعّالة

- نقطة النهاية

- أنشئ

- مثال

- تتوقع

- مصاريف

- الوجه

- فشل

- للعائلات

- أسرع

- بنك الاحتياطي الفيدرالي

- مالي

- الخدمات المالية

- الاسم الأول

- متابعيك

- شكل

- أشكال

- مجانًا

- وظيفة

- أموال

- توليد

- عظيم

- التسويق

- صحة الإنسان

- الرعاية الصحية

- صناديق التحوط

- مساعدة

- يساعد

- هنا

- مرتفع

- يحمل

- كيفية

- كيفية

- HTTPS

- تحديد

- تحسن

- تتضمن

- شامل

- القيمة الاسمية

- زيادة

- الصناعات

- العالمية

- معلومات

- رؤى

- رؤيتنا

- استثمار

- المشاركة

- مسائل

- IT

- لغة

- كبير

- تعلم

- ليد

- مستوى

- قائمة

- تحميل

- موقع

- طويل

- آلة

- آلة التعلم

- إدارة

- الأسواق

- المقاييس

- ML

- نموذج

- عارضات ازياء

- مراقبة

- أكثر

- MS

- موسيقى

- طبيعي

- إعلام

- الإخطار

- الفرص

- خيار

- مزيد من الخيارات

- طلب

- أخرى

- أداء

- فترات

- تصوير

- سياسة

- محفظة

- تنبؤ

- تنبؤات

- الوقاية

- أرسال

- ابتدائي

- خاص

- مشاكل

- عملية المعالجة

- الإنتــاج

- مشروع ناجح

- تزود

- ويوفر

- جمهور

- أغراض

- جودة

- بسرعة

- المنحدر

- في الوقت الحقيقي

- تسلم

- تخفيض

- تطلب

- المتطلبات الأساسية

- بحث

- مورد

- الموارد

- استجابة

- النتائج

- يجري

- تشغيل

- تحجيم

- حجم

- التحجيم

- علوم

- العلماء

- ثانوي

- القطاع

- Serverless

- الخدمة

- خدمات

- طقم

- ضبط

- شاركت

- مماثل

- الاشارات

- مقاس

- الحلول

- حل

- تتخصص

- سرعة

- الإنفاق

- بداية

- بدأت

- يبدأ

- الولايه او المحافظه

- الحالة

- إقامة

- تخزين

- متجر

- استراتيجيات

- تحقيق النجاح

- الدعم

- الدعم

- نظام

- الهدف

- المهام

- فريق

- الوقت

- سويا

- المواضيع

- تتبع الشحنة

- حركة المرور

- علاج

- جديد الموضة

- فهم

- us

- تستخدم

- عادة

- قيمنا

- رؤيتنا

- سواء

- في غضون

- للعمل

- عامل

- جاري الكتابة

- صفر