يُمكِّن تسليم البيانات والرؤى في الوقت الفعلي تقريبًا الشركات من الاستجابة بسرعة لاحتياجات عملائها. يمكن أن تأتي البيانات في الوقت الفعلي من مجموعة متنوعة من المصادر ، بما في ذلك وسائل التواصل الاجتماعي وأجهزة إنترنت الأشياء ومراقبة البنية التحتية ومراقبة مركز الاتصال والمزيد. نظرًا لاتساع وعمق البيانات التي يتم استيعابها من مصادر متعددة ، تبحث الشركات عن حلول لحماية خصوصية عملائها ومنع الوصول إلى البيانات الحساسة من الأنظمة النهائية. كان عليك في السابق الاعتماد على محركات قواعد معلومات التعريف الشخصية (PII) التي يمكنها الإبلاغ عن الإيجابيات الزائفة أو فقدان البيانات ، أو كان عليك إنشاء نماذج مخصصة للتعلم الآلي (ML) وصيانتها لتحديد معلومات تحديد الهوية الشخصية في بياناتك المتدفقة. تحتاج أيضًا إلى تنفيذ وصيانة البنية التحتية اللازمة لدعم هذه المحركات أو النماذج.

للمساعدة في تبسيط هذه العملية وتقليل التكاليف ، يمكنك استخدام فهم الأمازون، خدمة معالجة اللغة الطبيعية (NLP) التي تستخدم التعلم الآلي للعثور على رؤى وعلاقات مثل الأشخاص والأماكن والمشاعر والموضوعات في نص غير منظم. يمكنك الآن استخدام إمكانات Amazon Comprehend ML لاكتشاف معلومات تحديد الهوية الشخصية وتنقيحها في رسائل البريد الإلكتروني للعملاء ، وتذاكر الدعم ، ومراجعات المنتجات ، ووسائل التواصل الاجتماعي ، والمزيد. لا يلزم وجود خبرة ML. على سبيل المثال ، يمكنك تحليل تذاكر الدعم والمقالات المعرفية لاكتشاف كيانات معلومات تحديد الهوية الشخصية وتنقيح النص قبل فهرسة المستندات. بعد ذلك ، تصبح المستندات خالية من كيانات PII ويمكن للمستخدمين استهلاك البيانات. تساعدك كيانات تنقيح معلومات تحديد الهوية الشخصية على حماية خصوصية العميل والامتثال للقوانين واللوائح المحلية.

في هذا المنشور ، ستتعلم كيفية تنفيذ Amazon Comprehend في بنيات البث الخاصة بك لتنقيح كيانات PII في الوقت الفعلي تقريبًا باستخدام أمازون كينسيس داتا فايرهاوس مع AWS لامدا.

يركز هذا المنشور على تنقيح البيانات من الحقول المحددة التي يتم استيعابها في بنية التدفق باستخدام Kinesis Data Firehose ، حيث تريد إنشاء نسخ مشتقة إضافية من البيانات وتخزينها والاحتفاظ بها للاستهلاك من قبل المستخدمين النهائيين أو التطبيقات النهائية. إذا كنت تستخدم ملفات الأمازون كينسيس دفق البيانات أو لديك حالات استخدام إضافية خارج تنقيح معلومات تحديد الهوية الشخصية ، يرجى الرجوع إلى ترجمة وتحرير وتحليل البيانات المتدفقة باستخدام وظائف SQL مع Amazon Kinesis Data Analytics و Amazon Translate و Amazon Comprehend، حيث نعرض كيف يمكنك استخدام استوديو تحليلات البيانات Amazon Kinesis مدعوم من اباتشي زيبلين و اباتشي فلينك لتحليل الحقول النصية وترجمتها وتنقيحها بشكل تفاعلي في تدفق البيانات.

حل نظرة عامة

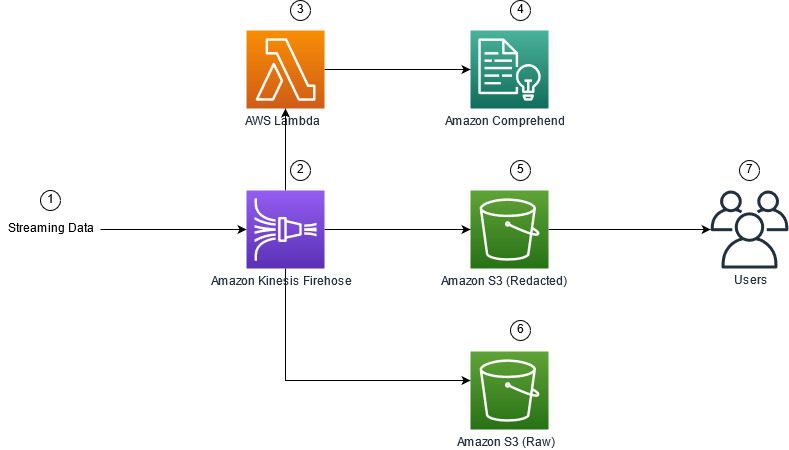

يوضح الشكل التالي نموذجًا معماريًا لأداء تنقيح PII للبيانات المتدفقة في الوقت الفعلي ، باستخدام خدمة تخزين أمازون البسيطة (Amazon S3) ، Kinesis Data Firehose تحويل البيانات, فهم الأمازونو AWS لامدا. بالإضافة إلى ذلك ، نستخدم ملف AWS SDK لـ Python (Boto3) لوظائف لامدا. كما هو موضح في الرسم التخطيطي ، تحتوي حاوية S3 الأولية على بيانات غير منقحة ، بينما تحتوي حاوية S3 المنقحة على بيانات منقحة بعد استخدام Amazon Comprehend DetectPiiEntities API ضمن دالة Lambda.

التكاليف المترتبة على ذلك

بالإضافة إلى تكاليف Kinesis Data Firehose و Amazon S3 و Lambda ، سيتحمل هذا الحل تكاليف الاستخدام من Amazon Comprehend. المبلغ الذي تدفعه هو أحد عوامل العدد الإجمالي للسجلات التي تحتوي على معلومات PII والأحرف التي تتم معالجتها بواسطة دالة Lambda. لمزيد من المعلومات ، يرجى الرجوع إلى تسعير Amazon Kinesis Data Firehose, تسعير Amazon Comprehendو تسعير AWS Lambda.

على سبيل المثال ، لنفترض أن لديك 10,000 سجل ، والقيمة الأساسية التي تريد تنقيح معلومات تحديد الهوية الشخصية منها هي 500 حرف. من بين 10,000 سجل سجل ، تم تحديد 50 على أنها تحتوي على معلومات تحديد الهوية الشخصية. تفاصيل التكلفة هي كما يلي:

يحتوي على تكلفة معلومات تحديد الهوية الشخصية:

- حجم كل قيمة مفتاح = 500 حرف (وحدة واحدة = 1 حرف)

- عدد الوحدات (100 حرف) لكل سجل (الحد الأدنى 3 وحدات) = 5

- إجمالي الوحدات = 10,000 (سجل) × 5 (وحدات لكل سجل) × 1 (طلبات Amazon Comprehend لكل سجل) = 50,000

- سعر الوحدة = 0.000002 دولار

- التكلفة الإجمالية لتحديد سجلات السجل باستخدام معلومات تحديد الهوية الشخصية باستخدام واجهة برمجة تطبيقات ContainsPiiEntities = 0.1 دولارًا أمريكيًا [50,000 وحدة × 0.000002 دولار أمريكي]

تكلفة Redact PII:

- إجمالي الوحدات التي تحتوي على معلومات PII = 50 (سجلات) × 5 (وحدات لكل سجل) × 1 (طلبات Amazon Comprehend لكل سجل) = 250

- سعر الوحدة = 0.0001 دولار

- التكلفة الإجمالية لتحديد موقع معلومات تحديد الهوية الشخصية باستخدام واجهة برمجة تطبيقات DetectPiiEntities = [عدد الوحدات] x [التكلفة لكل وحدة] = 250 x 0.0001 USD = 0.025 USD

التكلفة الإجمالية للتعريف والتنقيح:

- التكلفة الإجمالية: 0.1 دولارًا أمريكيًا (التحقق إذا كان الحقل يحتوي على معلومات تحديد الهوية الشخصية) + 0.025 دولارًا (حقول التنقيح التي تحتوي على معلومات تحديد الهوية الشخصية) = 0.125 دولارًا أمريكيًا

انشر الحل باستخدام AWS CloudFormation

لهذا المنشور ، نحن نقدم تكوين سحابة AWS تدفق تنقيح البيانات قالب، والذي يوفر التفاصيل الكاملة للتنفيذ لتمكين عمليات النشر القابلة للتكرار. عند النشر ، يُنشئ هذا القالب اثنين من حاويات S3: واحدة لتخزين بيانات العينة الأولية التي يتم إدخالها من Amazon Kinesis Data Generator (KDG) ، والأخرى لتخزين البيانات المنقحة. بالإضافة إلى ذلك ، يقوم بإنشاء تدفق توصيل Kinesis Data Firehose باستخدام DirectPUT كمدخلات ، ووظيفة Lambda التي تستدعي Amazon Comprehend يحتوي على كيانات و DetectPiiEntities API لتحديد وتنقيح بيانات PII. تعتمد وظيفة Lambda على مدخلات المستخدم في متغيرات البيئة لتحديد القيم الأساسية التي يجب فحصها لمعرفة معلومات تحديد الهوية الشخصية.

وظيفة Lambda في هذا الحل لها أحجام حمولة محدودة تصل إلى 100 كيلوبايت. إذا تم توفير حمولة حيث كان النص أكبر من 100 كيلوبايت ، فستتخطى وظيفة Lambda.

لنشر الحل ، أكمل الخطوات التالية:

- إطلاق حزمة CloudFormation في شرق الولايات المتحدة (شمال فيرجينيا)

us-east-1:

- أدخل اسم المكدس ، واترك المعلمات الأخرى على الإعدادات الافتراضية

- أختار أقر بأن AWS CloudFormation قد ينشئ موارد IAM بأسماء مخصصة.

- اختار إنشاء مكدس.

انشر الموارد يدويًا

إذا كنت تفضل إنشاء البنية يدويًا بدلاً من استخدام AWS CloudFormation ، فأكمل الخطوات الواردة في هذا القسم.

أنشئ حاويات S3

قم بإنشاء حاويات S3 الخاصة بك من خلال الخطوات التالية:

- في وحدة تحكم Amazon S3 ، اختر الدلاء في جزء التنقل.

- اختار إنشاء دلو.

- أنشئ دلوًا واحدًا لبياناتك الأولية وآخر لبياناتك المنقحة.

- لاحظ أسماء المستودعات التي أنشأتها للتو.

قم بإنشاء وظيفة Lambda

لإنشاء ونشر وظيفة Lambda ، أكمل الخطوات التالية:

- في وحدة تحكم لامدا ، اختر خلق وظيفة.

- اختار مؤلف من الصفر.

- في حالة اسم الوظيفة، أدخل

AmazonComprehendPII-Redact. - في حالة وقت التشغيل، اختر بيثون 3.9.

- في حالة معمار، حدد x86_64.

- في حالة دور التنفيذ، حدد أنشئ دورًا جديدًا باستخدام أذونات Lambda.

- بعد إنشاء الوظيفة ، أدخل الرمز التالي:

- اختار نشر.

- في جزء التنقل ، اختر التكوين.

- انتقل إلى متغيرات البيئة.

- اختار تعديل.

- في حالة القفل، أدخل

keys. - في حالة القيم، أدخل القيم الأساسية التي تريد تنقيح معلومات تحديد الهوية الشخصية منها ، مفصولة بفاصلة ومسافة. على سبيل المثال ، أدخل

Tweet1,Tweet2إذا كنت تستخدم بيانات الاختبار النموذجية الواردة في القسم التالي من هذا المنشور. - اختار حفظ.

- انتقل إلى التكوين العام.

- اختار تعديل.

- تغيير قيمة مهلة إلى 1 دقيقة.

- اختار حفظ.

- انتقل إلى أذونات.

- اختر اسم الدور تحته دور التنفيذ.

تتم إعادة توجيهك إلى إدارة الهوية والوصول AWS (IAM). - في حالة أضف أذونات، اختر إرفاق السياسات.

- أدخل

Comprehendفي شريط البحث واختر السياسةComprehendFullAccess. - اختار إرفاق السياسات.

قم بإنشاء تدفق توصيل Firehose

لإنشاء تدفق تسليم Firehose ، أكمل الخطوات التالية:

- في وحدة التحكم Kinesis Data Firehose ، اختر إنشاء دفق التسليم.

- في حالة مصدر، حدد وضع مباشر.

- في حالة الرحلات، حدد الأمازون S3.

- في حالة اسم تيار التسليم، أدخل

ComprehendRealTimeBlog. - تحت قم بتحويل سجلات المصدر باستخدام AWS Lambda، حدد تمكين.

- في حالة دالة AWS Lambda، أدخل ARN للوظيفة التي قمت بإنشائها ، أو استعرض للوصول إلى الوظيفة

AmazonComprehendPII-Redact. - في حالة حجم المخزن المؤقت، اضبط القيمة على 1 ميغا بايت.

- في حالة الفاصل الزمني للمخزن المؤقت، اتركها 60 ثانية.

- تحت إعدادات الوجهة، حدد حاوية S3 التي قمت بإنشائها للبيانات المنقحة.

- تحت إعدادات النسخ الاحتياطي، حدد حاوية S3 التي قمت بإنشائها للسجلات الأولية.

- تحت إذن، إما إنشاء أو تحديث دور IAM ، أو اختيار دور حالي مع الأذونات المناسبة.

- اختار إنشاء دفق التسليم.

انشر حل تدفق البيانات باستخدام Kinesis Data Generator

يمكنك استخدام Kinesis Data Generator (KDG) لإدخال عينة من البيانات إلى Kinesis Data Firehose واختبار الحل. لتبسيط هذه العملية ، نقدم وظيفة Lambda ونموذج CloudFormation لإنشاء ملف أمازون كوجنيتو المستخدم وتعيين الأذونات المناسبة لاستخدام KDG.

- على صفحة Amazon Kinesis Data Generator، اختر أنشئ مستخدم Cognito باستخدام CloudFormationتتم إعادة توجيهك إلى وحدة تحكم AWS CloudFormation لإنشاء مكدس الخاص بك.

- أدخل اسم مستخدم وكلمة مرور للمستخدم الذي من خلاله تقوم بتسجيل الدخول إلى KDG.

- اترك الإعدادات الأخرى على الإعدادات الافتراضية الخاصة بها وقم بإنشاء مكدس الخاص بك.

- على النواتج علامة التبويب ، اختر رابط KDG UI.

- ادخل اسم المستخدم وكلمة المرور للدخول.

أرسل سجلات الاختبار وتحقق من صحة التنقيح في Amazon S3

لاختبار الحل ، أكمل الخطوات التالية:

- قم بتسجيل الدخول إلى عنوان URL الخاص بـ KDG الذي قمت بإنشائه في الخطوة السابقة.

- اختر المنطقة التي تم فيها نشر مكدس AWS CloudFormation.

- في حالة تيار / تسليم تيار، اختر تدفق التسليم الذي أنشأته (إذا استخدمت النموذج ، فسيكون له التنسيق

accountnumber-awscomprehend-blog). - اترك الإعدادات الأخرى في إعداداتها الافتراضية.

- بالنسبة لقالب السجل ، يمكنك إنشاء الاختبارات الخاصة بك ، أو استخدام النموذج التالي. إذا كنت تستخدم البيانات النموذجية المتوفرة أدناه للاختبار ، فيجب أن يكون لديك متغيرات البيئة المحدثة في

AmazonComprehendPII-Redactوظيفة Lambda لTweet1,Tweet2. إذا تم النشر عبر CloudFormation ، فقم بتحديث متغيرات البيئة إلىTweet1,Tweet2ضمن وظيفة Lambda التي تم إنشاؤها. بيانات اختبار العينة أدناه: - اختار أرسل البيانات، وانتظر بضع ثوانٍ لإرسال السجلات إلى مجموعة البث الخاصة بك.

- بعد بضع ثوانٍ ، أوقف منشئ KDG وتحقق من دلاء S3 الخاصة بك بحثًا عن الملفات التي تم تسليمها.

فيما يلي مثال على البيانات الأولية في حاوية S3 الأولية:

فيما يلي مثال على البيانات المنقحة في حاوية S3 المنقحة:

تمت إزالة المعلومات الحساسة من الرسائل المنقحة ، مما يوفر الثقة في أنه يمكنك مشاركة هذه البيانات مع الأنظمة النهائية.

تنظيف

عندما تنتهي من تجربة هذا الحل ، قم بتنظيف مواردك باستخدام وحدة تحكم AWS CloudFormation لحذف جميع الموارد المنشورة في هذا المثال. إذا اتبعت الخطوات اليدوية ، فستحتاج إلى حذف المجموعتين يدويًا ، ملف AmazonComprehendPII-Redact وظيفة، و ComprehendRealTimeBlog تيار ، مجموعة السجل الخاصة بـ ComprehendRealTimeBlog وأية أدوار IAM تم إنشاؤها.

وفي الختام

أوضح لك هذا المنشور كيفية دمج تنقيح معلومات تحديد الهوية الشخصية في بنية التدفق شبه الحقيقي وتقليل وقت معالجة البيانات عن طريق إجراء التنقيح أثناء الطيران. في هذا السيناريو ، تقوم بتوفير البيانات المنقحة للمستخدمين النهائيين ويقوم مسئول بحيرة البيانات بتأمين الحاوية الأولية للاستخدام لاحقًا. يمكنك أيضًا إنشاء معالجة إضافية باستخدام Amazon Comprehend لتحديد النغمة أو المشاعر وتحديد الكيانات داخل البيانات وتصنيف كل رسالة.

قدمنا خطوات فردية لكل خدمة كجزء من هذا المنشور ، وقمنا أيضًا بتضمين نموذج CloudFormation الذي يسمح لك بتوفير الموارد المطلوبة في حسابك. يجب استخدام هذا النموذج لإثبات المفهوم أو اختبار السيناريوهات فقط. الرجوع إلى أدلة المطور ل فهم الأمازون, لامداو Kinesis Data Firehose لأي حدود خدمة.

للبدء في تحديد PII وتنقيحها ، راجع معلومات التعريف الشخصية (PII). باستخدام بنية المثال في هذا المنشور ، يمكنك دمج أي من واجهات برمجة تطبيقات Amazon Comprehend مع بيانات شبه فورية باستخدام تحويل بيانات Kinesis Data Firehose. لمعرفة المزيد حول ما يمكنك إنشاؤه باستخدام بياناتك في الوقت الفعلي تقريبًا باستخدام Kinesis Data Firehose ، يُرجى الرجوع إلى دليل مطور Amazon Kinesis Data Firehose. يتوفر هذا الحل في جميع مناطق AWS حيث يتوفر Amazon Comprehend و Kinesis Data Firehose.

عن المؤلفين

جو موروتي مهندس حلول في Amazon Web Services (AWS) ، يساعد عملاء المؤسسات في جميع أنحاء الغرب الأوسط بالولايات المتحدة. لقد شغل مجموعة واسعة من الأدوار الفنية ويستمتع بإظهار فن العميل الممكن. في أوقات فراغه ، يستمتع بقضاء وقت ممتع مع عائلته في استكشاف أماكن جديدة والإفراط في تحليل أداء فريقه الرياضي

جو موروتي مهندس حلول في Amazon Web Services (AWS) ، يساعد عملاء المؤسسات في جميع أنحاء الغرب الأوسط بالولايات المتحدة. لقد شغل مجموعة واسعة من الأدوار الفنية ويستمتع بإظهار فن العميل الممكن. في أوقات فراغه ، يستمتع بقضاء وقت ممتع مع عائلته في استكشاف أماكن جديدة والإفراط في تحليل أداء فريقه الرياضي

سريهارش أداري هو مهندس حلول أول في Amazon Web Services (AWS) ، حيث يساعد العملاء على العمل بشكل عكسي من نتائج الأعمال لتطوير حلول مبتكرة على AWS. على مر السنين ، ساعد العديد من العملاء في تحويلات منصة البيانات عبر قطاعات الصناعة. تشمل مجالات خبرته الأساسية استراتيجية التكنولوجيا وتحليلات البيانات وعلوم البيانات. في أوقات فراغه ، يستمتع بلعب التنس ومشاهدة البرامج التلفزيونية بنهم ولعب الطبلة.

سريهارش أداري هو مهندس حلول أول في Amazon Web Services (AWS) ، حيث يساعد العملاء على العمل بشكل عكسي من نتائج الأعمال لتطوير حلول مبتكرة على AWS. على مر السنين ، ساعد العديد من العملاء في تحويلات منصة البيانات عبر قطاعات الصناعة. تشمل مجالات خبرته الأساسية استراتيجية التكنولوجيا وتحليلات البيانات وعلوم البيانات. في أوقات فراغه ، يستمتع بلعب التنس ومشاهدة البرامج التلفزيونية بنهم ولعب الطبلة.

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- أمازون كينسيس

- تحليلات

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- متوسط (200،XNUMX)

- Kinesis Data Firehose

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- زفيرنت