يمكن استخدام نماذج اللغات الكبيرة (LLMs) لتحليل المستندات المعقدة وتقديم ملخصات وإجابات للأسئلة. المنشور التهيئة الدقيقة لتكييف المجال لنماذج الأساس في Amazon SageMaker JumpStart على البيانات المالية يصف كيفية ضبط LLM باستخدام مجموعة البيانات الخاصة بك. بمجرد حصولك على LLM قوي ، سترغب في عرض LLM لمستخدمي الأعمال لمعالجة المستندات الجديدة ، والتي قد تكون بطول مئات الصفحات. في هذا المنشور ، نوضح كيفية إنشاء واجهة مستخدم في الوقت الفعلي للسماح لمستخدمي الأعمال بمعالجة مستند PDF ذي طول عشوائي. بمجرد معالجة الملف ، يمكنك تلخيص المستند أو طرح أسئلة حول المحتوى. نموذج الحل الموضح في هذا المنشور متاح على GitHub جيثب:.

التعامل مع المستندات المالية

البيانات المالية مثل تقارير الأرباح الفصلية والتقارير السنوية للمساهمين غالبًا ما تكون عشرات أو مئات الصفحات. تحتوي هذه المستندات على الكثير من اللغة المعيارية مثل إخلاء المسؤولية واللغة القانونية. إذا كنت ترغب في استخراج نقاط البيانات الأساسية من إحدى هذه المستندات ، فأنت بحاجة إلى الوقت وبعض الإلمام باللغة المعيارية حتى تتمكن من تحديد الحقائق المثيرة للاهتمام. وبالطبع ، لا يمكنك طرح أسئلة على ماجستير حول مستند لم يسبق له رؤيته.

LLMs المستخدمة للتلخيص لها حد لعدد الرموز المميزة (الأحرف) التي تم تمريرها في النموذج ، ومع بعض الاستثناءات ، لا تزيد هذه عادةً عن بضعة آلاف من الرموز المميزة. هذا عادة ما يمنع القدرة على تلخيص وثائق أطول.

يتعامل حلنا مع المستندات التي تتجاوز الحد الأقصى لطول تسلسل الرمز المميز لـ LLM ، ويجعل هذا المستند متاحًا لـ LLM للإجابة على الأسئلة.

حل نظرة عامة

يتكون تصميمنا من ثلاث قطع مهمة:

- يحتوي على تطبيق ويب تفاعلي لمستخدمي الأعمال لتحميل ملفات PDF ومعالجتها

- يستخدم مكتبة langchain لتقسيم ملف PDF كبير إلى أجزاء أكثر قابلية للإدارة

- يستخدم تقنية الاسترجاع المعزز التوليد للسماح للمستخدمين بطرح أسئلة حول البيانات الجديدة التي لم يرها LLM من قبل

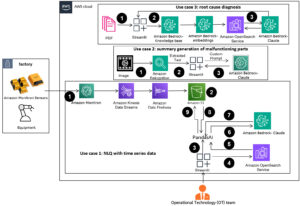

كما هو موضح في الرسم البياني التالي ، نستخدم واجهة أمامية مطبقة مع React JavaScript مستضافة في ملف خدمة تخزين أمازون البسيطة (Amazon S3) أمامه الأمازون CloudFront. يتيح تطبيق الواجهة الأمامية للمستخدمين تحميل مستندات PDF إلى Amazon S3. بعد اكتمال التحميل ، يمكنك تشغيل وظيفة استخراج نص مدعومة من أمازون تيكستراك. كجزء من المعالجة اللاحقة ، فإن ملف AWS لامدا تقوم الوظيفة بإدراج علامات خاصة في النص تشير إلى حدود الصفحة. عند الانتهاء من هذه المهمة ، يمكنك استدعاء واجهة برمجة تطبيقات تلخص النص أو تجيب على أسئلة حوله.

نظرًا لأن بعض هذه الخطوات قد تستغرق بعض الوقت ، فإن البنية تستخدم نهجًا غير متزامن منفصل. على سبيل المثال ، استدعاء تلخيص مستند ما يستدعي وظيفة Lambda التي تنشر رسالة إلى ملف خدمة Amazon Simple Queue Service قائمة انتظار (Amazon SQS). تقوم وظيفة أخرى في Lambda بالتقاط تلك الرسالة وتبدأ ملف خدمة الأمازون المرنة للحاويات (أمازون ECS) AWS فارجيت مهمة. تستدعي مهمة فارجيت ملف الأمازون SageMaker نقطة نهاية الاستدلال. نستخدم مهمة Fargate هنا لأن تلخيص ملف PDF طويل جدًا قد يستغرق وقتًا وذاكرة أطول مما توفره وظيفة Lambda. عند الانتهاء من التلخيص ، يمكن لتطبيق الواجهة الأمامية التقاط النتائج من ملف الأمازون DynamoDB الجدول.

للتلخيص ، نستخدم نموذج تلخيص AI21 ، أحد نماذج الأساس المتاحة من خلال أمازون سيج ميكر جومب ستارت. على الرغم من أن هذا النموذج يتعامل مع مستندات تصل إلى 10,000 كلمة (حوالي 40 صفحة) ، فإننا نستخدم أداة تقسيم النص langchain للتأكد من أن كل استدعاء تلخيص لـ LLM لا يزيد عن 10,000 كلمة. لتوليد النص ، نستخدم نموذج Cohere's Medium ، ونستخدم GPT-J لحفلات الزفاف ، عبر JumpStart.

معالجة التلخيص

عند التعامل مع المستندات الأكبر حجمًا ، نحتاج إلى تحديد كيفية تقسيم المستند إلى أجزاء أصغر. عندما نحصل على نتائج استخراج النص من Amazon Textract ، نقوم بإدخال علامات لأجزاء أكبر من النص (عدد الصفحات القابلة للتكوين) والصفحات الفردية وفواصل الأسطر. سيتم تقسيم Langchain بناءً على تلك العلامات وتجميع المستندات الأصغر التي تكون أقل من حد الرمز المميز. انظر الكود التالي:

LLM في سلسلة التلخيص عبارة عن غلاف رفيع حول نقطة نهاية SageMaker الخاصة بنا:

الإجابة على السؤال

في طريقة الاسترجاع المعزز ، قمنا أولاً بتقسيم المستند إلى أجزاء أصغر. نقوم بإنشاء حفلات الزفاف لكل جزء وتخزينها في قاعدة بيانات Chroma vector مفتوحة المصدر عبر واجهة langchain. نحفظ قاعدة البيانات في ملف نظام ملفات أمازون المرن (Amazon EFS) لاستخدامه لاحقًا. انظر الكود التالي:

عندما تكون حفلات الزفاف جاهزة ، يمكن للمستخدم طرح سؤال. نحن نبحث في قاعدة بيانات المتجهات عن أجزاء النص الأكثر تطابقًا مع السؤال:

نأخذ أقرب جزء مطابق ونستخدمه كسياق لنموذج إنشاء النص للإجابة على السؤال:

تجربة المستخدم

على الرغم من أن LLMs تمثل علم بيانات متقدمًا ، فإن معظم حالات استخدام LLM تتضمن في النهاية التفاعل مع مستخدمين غير تقنيين. يتعامل تطبيق الويب الخاص بنا على سبيل المثال مع حالة استخدام تفاعلي حيث يمكن لمستخدمي الأعمال تحميل مستند PDF جديد ومعالجته.

يوضح الرسم البياني التالي واجهة المستخدم. يبدأ المستخدم بتحميل ملف PDF. بعد تخزين المستند في Amazon S3 ، يمكن للمستخدم بدء مهمة استخراج النص. عند اكتمال ذلك ، يمكن للمستخدم استدعاء مهمة التلخيص أو طرح الأسئلة. تعرض واجهة المستخدم بعض الخيارات المتقدمة مثل حجم المقطع وتداخل المقطع ، والذي سيكون مفيدًا للمستخدمين المتقدمين الذين يختبرون التطبيق على المستندات الجديدة.

الخطوات التالية

توفر LLM إمكانات جديدة مهمة لاسترجاع المعلومات. يحتاج مستخدمو الأعمال إلى سهولة الوصول إلى تلك القدرات. هناك اتجاهان للعمل المستقبلي يجب مراعاتهما:

- استفد من LLMs القوية المتوفرة بالفعل في نماذج مؤسسة Jumpstart. من خلال بضعة أسطر من التعليمات البرمجية ، يمكن لتطبيقنا النموذجي نشر واستخدام LLMs المتقدمة من AI21 و Cohere لتلخيص النص وإنشاءه.

- اجعل هذه الإمكانات في متناول المستخدمين غير التقنيين. من المتطلبات الأساسية لمعالجة مستندات PDF استخراج النص من المستند ، وقد تستغرق مهام التلخيص عدة دقائق للتشغيل. يتطلب ذلك واجهة مستخدم بسيطة مع إمكانات معالجة خلفية غير متزامنة ، والتي يسهل تصميمها باستخدام خدمات السحابة الأصلية مثل Lambda و Fargate.

نلاحظ أيضًا أن مستند PDF عبارة عن معلومات شبه منظمة. يصعب تحديد الإشارات المهمة مثل عناوين الأقسام برمجيًا ، لأنها تعتمد على أحجام الخطوط والمؤشرات المرئية الأخرى. يساعد تحديد البنية الأساسية للمعلومات LLM على معالجة البيانات بشكل أكثر دقة ، على الأقل حتى يحين الوقت الذي يمكن فيه لـ LLM معالجة المدخلات ذات الطول غير المحدود.

وفي الختام

في هذا المنشور ، أوضحنا كيفية إنشاء تطبيق ويب تفاعلي يتيح لمستخدمي الأعمال تحميل مستندات PDF ومعالجتها للتلخيص والإجابة على الأسئلة. لقد رأينا كيفية الاستفادة من نماذج مؤسسة Jumpstart للوصول إلى LLMs المتقدمة ، واستخدام تقنيات إنشاء تقسيم واسترجاع النص المعزز لمعالجة المستندات الأطول وإتاحتها كمعلومات إلى LLM.

في الوقت الحالي ، لا يوجد سبب لعدم إتاحة هذه الإمكانات القوية لمستخدميك. نحن نشجعك على البدء في استخدام نماذج مؤسسة Jumpstart اليوم.

عن المؤلف

راندي ديفو هو مهندس حلول رئيسي أول في AWS. وهو حاصل على MSEE من جامعة ميشيغان ، حيث عمل على الرؤية الحاسوبية للمركبات ذاتية القيادة. كما أنه حاصل على ماجستير إدارة الأعمال من جامعة ولاية كولورادو. شغل راندي العديد من المناصب في مجال التكنولوجيا ، بدءًا من هندسة البرمجيات إلى إدارة المنتجات. دخلت مساحة البيانات الضخمة في عام 2013 وتواصل استكشاف هذا المجال. يعمل بنشاط في مشاريع في مجال ML وقد قدم في العديد من المؤتمرات بما في ذلك ستراتا وغلوكون.

راندي ديفو هو مهندس حلول رئيسي أول في AWS. وهو حاصل على MSEE من جامعة ميشيغان ، حيث عمل على الرؤية الحاسوبية للمركبات ذاتية القيادة. كما أنه حاصل على ماجستير إدارة الأعمال من جامعة ولاية كولورادو. شغل راندي العديد من المناصب في مجال التكنولوجيا ، بدءًا من هندسة البرمجيات إلى إدارة المنتجات. دخلت مساحة البيانات الضخمة في عام 2013 وتواصل استكشاف هذا المجال. يعمل بنشاط في مشاريع في مجال ML وقد قدم في العديد من المؤتمرات بما في ذلك ستراتا وغلوكون.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/use-a-generative-ai-foundation-model-for-summarization-and-question-answering-using-your-own-data/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 000

- 10

- 100

- 13

- 14

- 15%

- 2013

- 25

- 40

- 500

- 7

- a

- القدرة

- ماهرون

- من نحن

- حوله

- الوصول

- يمكن الوصول

- بدقة

- بنشاط

- متقدم

- مميزات

- بعد

- AI

- سابقا

- أيضا

- بالرغم ان

- أمازون

- الأمازون SageMaker

- أمازون سيج ميكر جومب ستارت

- أمازون تيكستراك

- أمازون ويب سيرفيسز

- an

- تحليل

- و

- سنوي

- آخر

- إجابة

- الأجوبة

- API

- تطبيق

- نهج

- ما يقرب من

- هندسة معمارية

- هي

- المنطقة

- حول

- AS

- At

- المعزز

- المؤلفة

- مستقل

- المركبات المستقلة

- متاح

- AWS

- الى الخلف

- الخلفية

- على أساس

- BE

- لان

- كبير

- البيانات الكبيرة

- على حد سواء

- الحدود

- فواصل

- نساعدك في بناء

- الأعمال

- by

- دعوة

- دعوات

- CAN

- قدرات

- حقيبة

- الحالات

- سلسلة

- الأحرف

- عن كثب

- الكود

- كولورادو

- إكمال

- مجمع

- الكمبيوتر

- رؤية الكمبيوتر

- المؤتمرات

- نظر

- بناء

- تحتوي على

- وعاء

- محتوى

- سياق الكلام

- تواصل

- مناسب

- استطاع

- الدورة

- خلق

- البيانات

- نقاط البيانات

- علم البيانات

- قاعدة البيانات

- تنفصل

- حدد

- شرح

- نشر

- وصف

- تصميم

- صعبة

- وثيقة

- وثائق

- فعل

- كل

- أرباح

- سهل

- شجع

- النهاية

- نقطة النهاية

- الهندسة

- دخل

- مثال

- تجاوز

- اكتشف

- استخراج

- حقائق

- معرفة

- قليل

- قم بتقديم

- مالي

- الاسم الأول

- متابعيك

- في حالة

- دورة تأسيسية

- تبدأ من

- جبهة

- نهاية المقدمة

- وظيفة

- مستقبل

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- مقبض

- مقابض

- معالجة

- يملك

- he

- عقد

- يساعد

- هنا

- يحمل

- استضافت

- كيفية

- كيفية

- HTTP

- HTTPS

- مئات

- تحديد

- تحديد

- if

- نفذت

- أهمية

- in

- بما فيه

- من مؤشرات

- فرد

- معلومات

- إدخال

- إدراج

- تفاعل

- التفاعلية

- وكتابة مواضيع مثيرة للاهتمام

- السطح البيني

- إلى

- يتضرع

- تنطوي

- IT

- جافا سكريبت

- وظيفة

- المشــاريــع

- JPG

- م

- القفل

- لغة

- كبير

- أكبر

- الى وقت لاحق

- الأقل

- شروط وأحكام

- الطول

- اسمحوا

- يتيح

- المكتبة

- مثل

- مما سيحدث

- خط

- خطوط

- LLM

- محمل

- طويل

- يعد

- الكثير

- جعل

- التحكم

- إدارة

- مباراة

- مطابقة

- أقصى

- مايو..

- متوسط

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- الرسالة

- طريقة

- ميشيغان

- دقيقة

- ML

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- حاجة

- أبدا

- جديد

- لا

- غير التقنية

- عادة

- عدد

- كثير

- of

- غالبا

- on

- مرة

- ONE

- المصدر المفتوح

- مزيد من الخيارات

- or

- أخرى

- لنا

- الخاصة

- صفحة

- صفحات

- جزء

- مرت

- اختيار

- مختارات

- صورة

- قطعة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- البوينت

- نقاط

- مواقف

- منشور

- المنشورات

- مدعوم

- قوي

- قدم

- رئيسي

- عملية المعالجة

- معالجتها

- معالجة

- المنتج

- ادارة المنتج

- مشروع ناجح

- تزود

- سؤال

- الأسئلة المتكررة

- تتراوح

- رد فعل

- استعداد

- في الوقت الحقيقي

- سبب

- اعتمد

- التقارير

- مثل

- استجابة

- ردود

- النتائج

- عائد أعلى

- يجري

- sagemaker

- حفظ

- رأى

- علوم

- بحث

- القسم

- انظر تعريف

- رأيت

- قطعة

- شرائح

- SELF

- كبير

- تسلسل

- خدماتنا

- عدة

- المساهمين

- أظهرت

- أظهرت

- يظهر

- هام

- الاشارات

- المقاس

- الأحجام

- الأصغر

- So

- تطبيقات الكمبيوتر

- هندسة البرمجيات

- الصلبة

- حل

- الحلول

- بعض

- الفضاء

- تختص

- انقسم

- الإنشقاقات

- بداية

- يبدأ

- الولايه او المحافظه

- البيانات

- خطوات

- قلة النوم

- تخزين

- متجر

- تخزين

- بناء

- هذه

- تلخيص

- ملخص

- بالتأكيد

- نظام

- جدول

- أخذ

- مهمة

- تقنيات

- تكنولوجيا

- عشرات

- الاختبار

- من

- أن

- •

- منهم

- هناك.

- تشبه

- هم

- هؤلاء

- ثلاثة

- عبر

- الوقت

- إلى

- اليوم

- رمز

- الرموز

- يثير

- اثنان

- عادة

- في النهاية

- مع

- التي تقوم عليها

- جامعة

- حتى

- تحميل

- تستخدم

- حالة الاستخدام

- مستعمل

- مستخدم

- واجهة المستخدم

- المستخدمين

- يستخدم

- استخدام

- تشكيلة

- السيارات

- جدا

- بواسطة

- رؤيتنا

- تريد

- we

- الويب

- تطبيق ويب

- خدمات ويب

- متى

- التي

- من الذى

- سوف

- مع

- كلمات

- للعمل

- عمل

- عامل

- سوف

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت