এটি Qualcomm AI থেকে AK রায়ের একটি অতিথি পোস্ট।

আমাজন ইলাস্টিক কম্পিউট ক্লাউড (অ্যামাজন EC2) Qualcomm AI 2 স্ট্যান্ডার্ড এক্সিলারেটর দ্বারা চালিত DL100q দৃষ্টান্তগুলি, ক্লাউডে ডিপ লার্নিং (DL) কাজের চাপগুলিকে সাশ্রয়ীভাবে স্থাপন করতে ব্যবহার করা যেতে পারে। এগুলি কোয়ালকম ডিভাইসগুলিতে স্থাপন করা ডিএল ওয়ার্কলোডগুলির কার্যক্ষমতা এবং নির্ভুলতা বিকাশ এবং যাচাই করতেও ব্যবহার করা যেতে পারে। কোয়ালকমের কৃত্রিম বুদ্ধিমত্তা (AI) প্রযুক্তিকে ক্লাউডে আনার প্রথম দৃষ্টান্ত হল DL2q দৃষ্টান্ত।

আটটি Qualcomm AI 100 স্ট্যান্ডার্ড এক্সিলারেটর এবং মোট এক্সিলারেটর মেমরির 128 GiB সহ, গ্রাহকরা জনপ্রিয় জেনারেটিভ AI অ্যাপ্লিকেশন, যেমন বিষয়বস্তু তৈরি, পাঠ্য সংক্ষিপ্তকরণ এবং ভার্চুয়াল সহকারীর পাশাপাশি প্রাকৃতিক ভাষা প্রক্রিয়াকরণের জন্য ক্লাসিক AI অ্যাপ্লিকেশনগুলি চালানোর জন্য DL2q দৃষ্টান্ত ব্যবহার করতে পারেন। এবং কম্পিউটার দৃষ্টি। উপরন্তু, Qualcomm AI 100 অ্যাক্সিলারেটর স্মার্টফোন, স্বায়ত্তশাসিত ড্রাইভিং, ব্যক্তিগত কম্পিউটার এবং বর্ধিত রিয়েলিটি হেডসেট জুড়ে ব্যবহৃত একই AI প্রযুক্তি বৈশিষ্ট্যযুক্ত, তাই DL2q দৃষ্টান্তগুলি স্থাপনের আগে এই AI ওয়ার্কলোডগুলি বিকাশ এবং যাচাই করতে ব্যবহার করা যেতে পারে।

নতুন DL2q উদাহরণ হাইলাইট

প্রতিটি DL2q ইন্সট্যান্সে আটটি কোয়ালকম ক্লাউড AI100 এক্সিলারেটর অন্তর্ভুক্ত করা হয়েছে, যার একটি সমষ্টিগত পারফরম্যান্সের 2.8টির বেশি PetaOps Int8 ইনফারেন্স পারফরম্যান্স এবং 1.4 PetaFlops FP16 ইনফারেন্স পারফরম্যান্স। উদাহরণটিতে AI কোরগুলির একটি মোট 112, এক্সিলারেটর মেমরির ক্ষমতা 128 GB এবং মেমরি ব্যান্ডউইথ 1.1 TB প্রতি সেকেন্ডে রয়েছে।

প্রতিটি DL2q ইন্সট্যান্সে 96টি vCPU আছে, একটি সিস্টেম মেমরির ক্ষমতা 768 GB এবং নেটওয়ার্কিং ব্যান্ডউইথ 100 Gbps সমর্থন করে। আমাজন ইলাস্টিক ব্লক স্টোর (আমাজন ইবিএস) 19 জিবিপিএস স্টোরেজ।

| উদাহরণের নাম | vCPUs | ক্লাউড AI100 এক্সিলারেটর | এক্সিলারেটর মেমরি | অ্যাক্সিলারেটর মেমরি BW (একত্রিত) | ইনস্ট্যান্স মেমরি | উদাহরণ নেটওয়ার্কিং | স্টোরেজ (আমাজন ইবিএস) ব্যান্ডউইথ |

| DL2q.24x বড় | 96 | 8 | 128 গিগাবাইট | 1.088 টিবি / গুলি | 768 গিগাবাইট | 100 জিবিপিএস | 19 জিবিপিএস |

Qualcomm Cloud AI100 এক্সিলারেটর উদ্ভাবন

ক্লাউড AI100 অ্যাক্সিলারেটর সিস্টেম-অন-চিপ (SoC) হল একটি উদ্দেশ্য-নির্মিত, মাপযোগ্য মাল্টি-কোর আর্কিটেকচার, যা ডেটাসেন্টার থেকে প্রান্ত পর্যন্ত বিস্তৃত গভীর-শিক্ষার ব্যবহার-কেসগুলির একটি বিস্তৃত পরিসরকে সমর্থন করে। SoC 126 MB এর একটি শিল্প-নেতৃস্থানীয় অন-ডাই SRAM ক্ষমতা সহ স্কেলার, ভেক্টর এবং টেনসর কম্পিউট কোর নিয়োগ করে। কোরগুলি একটি উচ্চ-ব্যান্ডউইথ কম-ল্যাটেন্সি নেটওয়ার্ক-অন-চিপ (NoC) জালের সাথে আন্তঃসংযুক্ত।

AI100 অ্যাক্সিলারেটর মডেল এবং ব্যবহারের ক্ষেত্রে বিস্তৃত এবং ব্যাপক পরিসর সমর্থন করে। নীচের টেবিলটি মডেল সমর্থনের পরিসর হাইলাইট করে।

| মডেল বিভাগ | মডেল সংখ্যা | উদাহরণ |

| এনএলপি | 157 | BERT, BART, FasterTransformer, T5, Z-code MOE |

| জেনারেটিভ এআই - এনএলপি | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| জেনারেটিভ এআই – ইমেজ | 3 | স্থিতিশীল বিস্তার v1.5 এবং v2.1, OpenAI CLIP |

| সিভি - ছবির শ্রেণীবিভাগ | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| সিভি - বস্তু সনাক্তকরণ | 23 | YOLO v2, v3, v4, v5, এবং v7, SSD-ResNet, RetinaNet |

| সিভি - অন্যান্য | 15 | LPRNet, সুপার-রেজোলিউশন/SRGAN, বাইটট্র্যাক |

| স্বয়ংচালিত নেটওয়ার্ক* | 53 | উপলব্ধি এবং LIDAR, পথচারী, গলি, এবং ট্র্যাফিক লাইট সনাক্তকরণ |

| মোট | > 300 | |

* বেশিরভাগ স্বয়ংচালিত নেটওয়ার্কগুলি পৃথক নেটওয়ার্কগুলির সংমিশ্রণ নিয়ে গঠিত যৌগিক নেটওয়ার্ক।

DL2q এক্সিলারেটরের বড় অন-ডাই এসআরএএম উন্নত কর্মক্ষমতা কৌশল যেমন ওজন সংরক্ষণের জন্য MX6 মাইক্রো-এক্সপোনেন্ট নির্ভুলতা এবং এক্সিলারেটর-টু-অ্যাক্সিলারেটর যোগাযোগের জন্য MX9 মাইক্রো-এক্সপোনেন্ট নির্ভুলতার দক্ষ বাস্তবায়ন সক্ষম করে। মাইক্রো-এক্সপোনেন্ট প্রযুক্তি নিম্নলিখিত ওপেন কম্পিউট প্রজেক্ট (ওসিপি) শিল্প ঘোষণায় বর্ণিত হয়েছে: এএমডি, আর্ম, ইন্টেল, মেটা, মাইক্রোসফ্ট, এনভিআইডিএ এবং কোয়ালকম স্ট্যান্ডার্ডাইজ নেক্সট-জেনারেশন ন্যারো প্রিসিশন ডেটা ফরম্যাট AI এর জন্য » ওপেন কম্পিউট প্রজেক্ট.

উদাহরণ ব্যবহারকারী পারফরম্যান্স-প্রতি-খরচকে সর্বাধিক করার জন্য নিম্নলিখিত কৌশলটি ব্যবহার করতে পারেন:

- অন-অ্যাক্সিলারেটর DDR মেমরিতে MX6 মাইক্রো-এক্সপোনেন্ট নির্ভুলতা ব্যবহার করে ওজন সংরক্ষণ করুন। MX6 নির্ভুলতা ব্যবহার করে উপলব্ধ মেমরির ক্ষমতা এবং মেমরি-ব্যান্ডউইথের সর্বোচ্চ ব্যবহার করে সেরা-শ্রেণীর থ্রুপুট এবং লেটেন্সি প্রদান করতে।

- কার্ডে উচ্চতর অন-চিপ SRAM এবং অতিরিক্ত TOP ব্যবহার করার সময়, উচ্চ-কার্যক্ষমতা কম-বিলম্বিত MX16 থেকে FP6 কার্নেলগুলি বাস্তবায়নের জন্য প্রয়োজনীয় ব্যবহারের ক্ষেত্রে সঠিকতা প্রদান করতে FP16-এ গণনা করুন।

- একটি অপ্টিমাইজ করা ব্যাচিং কৌশল এবং উচ্চতর ব্যাচ-আকার ব্যবহার করে ওজনের পুনঃব্যবহার সর্বাধিক করার জন্য উপলব্ধ বৃহৎ অন-চিপ SRAM ব্যবহার করে, অন-চিপ অ্যাক্টিভেশনগুলিকে যতটা সম্ভব সম্ভব ধরে রেখে।

DL2q AI স্ট্যাক এবং টুলচেইন

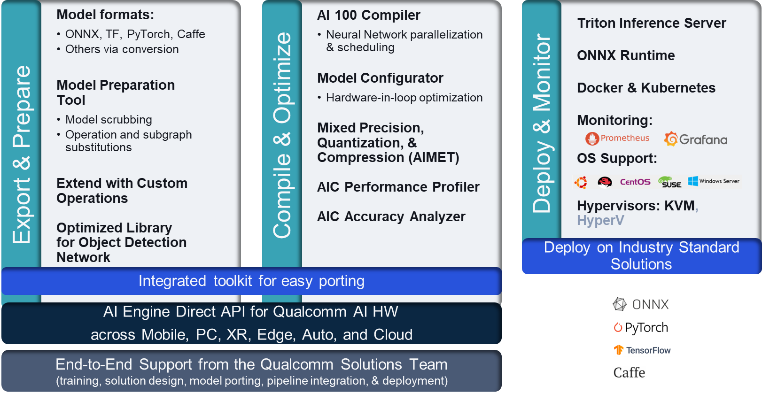

DL2q দৃষ্টান্তের সাথে Qualcomm AI স্ট্যাক রয়েছে যা ক্লাউড এবং অন্যান্য Qualcomm পণ্যগুলিতে Qualcomm AI জুড়ে একটি সামঞ্জস্যপূর্ণ বিকাশকারী অভিজ্ঞতা প্রদান করে। একই Qualcomm AI স্ট্যাক এবং বেস AI প্রযুক্তি DL2q দৃষ্টান্ত এবং Qualcomm এজ ডিভাইসে চলে, যা গ্রাহকদের তাদের ক্লাউড, স্বয়ংচালিত, ব্যক্তিগত কম্পিউটার, বর্ধিত বাস্তবতা এবং স্মার্টফোন ডেভেলপমেন্ট এনভায়রনমেন্ট জুড়ে একীভূত API সহ একটি ধারাবাহিক বিকাশকারী অভিজ্ঞতা প্রদান করে।

টুলচেইন ইনস্ট্যান্স ব্যবহারকারীকে পূর্বে প্রশিক্ষিত মডেলকে দ্রুত জাহাজে আনতে, উদাহরণের ক্ষমতার জন্য মডেলটিকে কম্পাইল এবং অপ্টিমাইজ করতে এবং পরবর্তীতে নিম্নলিখিত চিত্রে দেখানো তিনটি ধাপে উৎপাদন অনুমান ব্যবহারের ক্ষেত্রে সংকলিত মডেলগুলি স্থাপন করতে সক্ষম করে।

একটি মডেলের কর্মক্ষমতা টিউনিং সম্পর্কে আরও জানতে, দেখুন Cloud AI 100 কী পারফরম্যান্স প্যারামিটার নথিপত্র।

DL2q দৃষ্টান্ত দিয়ে শুরু করুন

এই উদাহরণে, আপনি একটি প্রাক-প্রশিক্ষিত কম্পাইল এবং স্থাপন করুন BERT মডেল থেকে আলিঙ্গন মুখ একটি EC2 DL2q দৃষ্টান্তে একটি পূর্ব-নির্মিত উপলব্ধ DL2q AMI ব্যবহার করে, চারটি ধাপে।

আপনি হয় একটি পূর্ব-নির্মিত ব্যবহার করতে পারেন কোয়ালকম ডিএলএএমআই উদাহরণে বা একটি Amazon Linux2 AMI দিয়ে শুরু করুন এবং এতে উপলব্ধ Cloud AI 2 প্ল্যাটফর্ম এবং Apps SDK সহ আপনার নিজস্ব DL100q AMI তৈরি করুন অ্যামাজন সিম্পল স্টোরেজ সার্ভিস (অ্যামাজন এস 3) বালতি: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

যে পদক্ষেপগুলি অনুসরণ করে তা পূর্ব-নির্মিত DL2q AMI ব্যবহার করে, কোয়ালকম বেস AL2 DLAMI.

Qualcomm Base AL2 DLAMI AMI-এর সাথে আপনার DL2q ইন্সট্যান্স অ্যাক্সেস করতে SSH ব্যবহার করুন এবং ধাপ 1 থেকে 4 অনুসরণ করুন।

ধাপ 1. পরিবেশ সেট আপ করুন এবং প্রয়োজনীয় প্যাকেজ ইনস্টল করুন

- পাইথন 3.8 ইনস্টল করুন।

- Python 3.8 ভার্চুয়াল পরিবেশ সেট আপ করুন।

- Python 3.8 ভার্চুয়াল পরিবেশ সক্রিয় করুন।

- প্রয়োজনীয় প্যাকেজ ইনস্টল করুন, দেখানো হয়েছে requirements.txt নথি Qualcomm পাবলিক Github সাইটে উপলব্ধ।

- প্রয়োজনীয় লাইব্রেরি আমদানি করুন।

ধাপ 2. মডেল আমদানি করুন

- মডেলটি আমদানি করুন এবং টোকেনাইজ করুন।

- একটি নমুনা ইনপুট সংজ্ঞায়িত করুন এবং নিষ্কাশন করুন

inputIdsএবংattentionMask. - মডেলটিকে ONNX-এ রূপান্তর করুন, যা তারপর কম্পাইলারের কাছে পাঠানো যেতে পারে।

- আপনি মডেলটি FP16 নির্ভুলতায় চালাবেন। সুতরাং, আপনাকে পরীক্ষা করতে হবে যে মডেলটিতে FP16 সীমার বাইরে কোনো ধ্রুবক রয়েছে কিনা। মডেল পাস

fix_onnx_fp16প্রয়োজনীয় সংশোধন সহ নতুন ONNX ফাইল তৈরি করতে ফাংশন।

ধাপ 3. মডেল কম্পাইল

সার্জারির qaic-exec কমান্ড লাইন ইন্টারফেস (CLI) কম্পাইলার টুল মডেল কম্পাইল করতে ব্যবহার করা হয়। এই কম্পাইলারের ইনপুট হল ONNX ফাইলটি ধাপ 2-এ উত্পন্ন। কম্পাইলার একটি বাইনারি ফাইল তৈরি করে (যাকে বলা হয় QPCজন্য কোয়ালকম প্রোগ্রাম কন্টেইনার) দ্বারা সংজ্ঞায়িত পথে -aic-binary-dir যুক্তি.

নীচের কম্পাইল কমান্ডে, আপনি মডেলটি কম্পাইল করতে চারটি এআই কম্পিউট কোর এবং একটি ব্যাচের আকার ব্যবহার করেন।

কিউপিসি তৈরি হয় bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc ফোল্ডার.

ধাপ 4. মডেল চালান

DL100q দৃষ্টান্তে একটি Cloud AI2 Qualcomm অ্যাক্সিলারেটরে অনুমান চালানোর জন্য একটি সেশন সেট আপ করুন৷

Qualcomm qaic Python লাইব্রেরি হল API-এর একটি সেট যা Cloud AI100 অ্যাক্সিলারেটরে অনুমান চালানোর জন্য সমর্থন প্রদান করে।

- সেশনের একটি উদাহরণ তৈরি করতে সেশন API কল ব্যবহার করুন। সেশন এপিআই কল হল qaic পাইথন লাইব্রেরি ব্যবহার করার এন্ট্রি পয়েন্ট।

- এর সাথে আউটপুট বাফার থেকে ডেটা পুনর্গঠন করুন

output_shapeএবংoutput_type. - উত্পাদিত আউটপুট ডিকোড করুন।

এখানে ইনপুট বাক্যটির আউটপুট রয়েছে "মাদুরের উপর কুকুর [মাস্ক]।"

এটাই. মাত্র কয়েকটি ধাপে, আপনি একটি Amazon EC2 DL2q দৃষ্টান্তে একটি PyTorch মডেল কম্পাইল এবং চালান৷ DL2q দৃষ্টান্তে অনবোর্ডিং এবং কম্পাইলিং মডেল সম্পর্কে আরও জানতে, দেখুন Cloud AI100 টিউটোরিয়াল ডকুমেন্টেশন।

কোন DL মডেল আর্কিটেকচারগুলি AWS DL2q দৃষ্টান্ত এবং বর্তমান মডেল সমর্থন ম্যাট্রিক্সের জন্য উপযুক্ত সে সম্পর্কে আরও জানতে, দেখুন Qualcomm Cloud AI100 ডকুমেন্টেশন.

এখন পর্যাপ্ত

আপনি US পশ্চিম (ওরেগন) এবং ইউরোপ (ফ্রাঙ্কফুর্ট) AWS অঞ্চলে আজ DL2q দৃষ্টান্ত চালু করতে পারেন চাহিদা সাপেক্ষে, সংরক্ষিত, এবং দাগ দৃষ্টান্ত, অথবা একটি অংশ হিসাবে সঞ্চয় পরিকল্পনা. Amazon EC2 এর সাথে যথারীতি, আপনি যা ব্যবহার করেন তার জন্যই আপনি অর্থ প্রদান করেন। আরও তথ্যের জন্য, দেখুন Amazon EC2 মূল্য.

DL2q উদাহরণ ব্যবহার করে স্থাপন করা যেতে পারে AWS ডিপ লার্নিং AMIs (DLAMI), এবং কন্টেইনার ছবি যেমন পরিচালিত পরিষেবার মাধ্যমে উপলব্ধ আমাজন সেজমেকার, আমাজন ইলাস্টিক কুবারনেটস সার্ভিস (অ্যামাজন ইকেএস), আমাজন ইলাস্টিক কন্টেইনার সার্ভিস (অ্যামাজন ইসিএস), এবং AWS সমান্তরাল ক্লাস্টার.

আরও জানতে, দেখুন Amazon EC2 DL2q উদাহরণ পৃষ্ঠা, এবং প্রতিক্রিয়া পাঠান AWS re:EC2 এর জন্য পোস্ট অথবা আপনার সাধারণ AWS সহায়তা পরিচিতির মাধ্যমে।

লেখক সম্পর্কে

এ কে রায় ক্লাউড এবং ডেটাসেন্টার এআই পণ্য এবং সমাধানগুলির জন্য কোয়ালকমের পণ্য ব্যবস্থাপনার একজন পরিচালক। পণ্যের কৌশল এবং উন্নয়নে তার 20 বছরেরও বেশি অভিজ্ঞতা রয়েছে, যার বর্তমান ফোকাস সর্বোত্তম-শ্রেণীর পারফরম্যান্স এবং পারফরম্যান্স/$ এন্ড-টু-এন্ড সমাধানের জন্য ক্লাউডে AI অনুমানের জন্য, ব্যবহারের ক্ষেত্রে বিস্তৃত পরিসরের জন্য, GenAI, LLMs, Auto এবং Hybrid AI সহ।

এ কে রায় ক্লাউড এবং ডেটাসেন্টার এআই পণ্য এবং সমাধানগুলির জন্য কোয়ালকমের পণ্য ব্যবস্থাপনার একজন পরিচালক। পণ্যের কৌশল এবং উন্নয়নে তার 20 বছরেরও বেশি অভিজ্ঞতা রয়েছে, যার বর্তমান ফোকাস সর্বোত্তম-শ্রেণীর পারফরম্যান্স এবং পারফরম্যান্স/$ এন্ড-টু-এন্ড সমাধানের জন্য ক্লাউডে AI অনুমানের জন্য, ব্যবহারের ক্ষেত্রে বিস্তৃত পরিসরের জন্য, GenAI, LLMs, Auto এবং Hybrid AI সহ।

জিয়ানিং ল্যাং AWS ওয়ার্ল্ডওয়াইড স্পেশালিস্ট অর্গানাইজেশনের (WWSO) একজন প্রধান সমাধান স্থপতি। HPC এবং AI ক্ষেত্রে তার 15 বছরের বেশি কাজের অভিজ্ঞতা রয়েছে। AWS-এ, তিনি গ্রাহকদের ত্বরিত কম্পিউটিং দৃষ্টান্তগুলিতে তাদের AI/ML কাজের চাপ স্থাপন, অপ্টিমাইজ এবং স্কেল করতে সহায়তা করার উপর ফোকাস করেন। তিনি HPC এবং AI ক্ষেত্রের কৌশলগুলিকে একত্রিত করার বিষয়ে উত্সাহী। জিয়ানিং বোল্ডারের কলোরাডো বিশ্ববিদ্যালয় থেকে কম্পিউটেশনাল ফিজিক্সে পিএইচডি ডিগ্রি অর্জন করেছেন।

জিয়ানিং ল্যাং AWS ওয়ার্ল্ডওয়াইড স্পেশালিস্ট অর্গানাইজেশনের (WWSO) একজন প্রধান সমাধান স্থপতি। HPC এবং AI ক্ষেত্রে তার 15 বছরের বেশি কাজের অভিজ্ঞতা রয়েছে। AWS-এ, তিনি গ্রাহকদের ত্বরিত কম্পিউটিং দৃষ্টান্তগুলিতে তাদের AI/ML কাজের চাপ স্থাপন, অপ্টিমাইজ এবং স্কেল করতে সহায়তা করার উপর ফোকাস করেন। তিনি HPC এবং AI ক্ষেত্রের কৌশলগুলিকে একত্রিত করার বিষয়ে উত্সাহী। জিয়ানিং বোল্ডারের কলোরাডো বিশ্ববিদ্যালয় থেকে কম্পিউটেশনাল ফিজিক্সে পিএইচডি ডিগ্রি অর্জন করেছেন।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- : আছে

- : হয়

- $ ইউপি

- 1

- 1 টিবি

- 10

- 100

- 11

- 12

- 13

- 15 বছর

- 15%

- 17

- 19

- 20

- 20 বছর

- 22

- 23

- 7

- 75

- 8

- 84

- a

- সম্পর্কে

- উপরে

- দ্রুততর

- বেগবর্ধক ব্যক্তি

- ত্বক

- প্রবেশ

- অনুষঙ্গী

- সঠিকতা

- দিয়ে

- সক্রিয়করণ

- উপরন্তু

- অগ্রসর

- থোক

- AI

- এআই / এমএল

- সব

- এছাড়াও

- মর্দানী স্ত্রীলোক

- আমাজন EC2

- অ্যামাজন ওয়েব সার্ভিসেস

- an

- এবং

- ঘোষণা

- কোন

- API

- API গুলি

- অ্যাপ্লিকেশন

- অ্যাপস

- স্থাপত্য

- রয়েছি

- যুক্তি

- এআরএম

- কৃত্রিম

- AS

- সহায়ক

- At

- গাড়ী

- স্বয়ংচালিত

- স্বশাসিত

- সহজলভ্য

- ডেস্কটপ AWS

- অক্ষ

- ব্যান্ডউইথ

- ভিত্তি

- BE

- আগে

- নিচে

- তার পরেও

- বিন

- বাধা

- পুষ্প

- আনা

- প্রশস্ত

- বাফার

- নির্মাণ করা

- by

- কল

- নামক

- CAN

- ক্ষমতা

- ধারণক্ষমতা

- কার্ড

- কেস

- চেক

- সর্বোত্তম

- মেঘ

- কলোরাডো

- মিশ্রন

- যোগাযোগ

- ব্যাপক

- গণনা

- গনা

- কম্পিউটার

- কম্পিউটার ভিশন

- কম্পিউটার

- কম্পিউটিং

- সঙ্গত

- গঠিত

- যোগাযোগ

- আধার

- ধারণ

- বিষয়বস্তু

- কন্টেন্ট জেনারেশন

- সৃষ্টি

- বর্তমান

- গ্রাহকদের

- উপাত্ত

- তথ্য কেন্দ্র

- গভীর

- গভীর জ্ঞানার্জন

- সংজ্ঞায়িত

- ডিগ্রী

- প্রদান করা

- বিতরণ

- স্থাপন

- মোতায়েন

- বিস্তৃতি

- বর্ণিত

- বিকাশ

- বিকাশকারী

- উন্নয়ন

- যন্ত্র

- ডিভাইস

- আশ্লেষ

- Director

- ডকুমেন্টেশন

- কুকুর

- পরিচালনা

- প্রগতিশীল

- প্রান্ত

- দক্ষ

- পারেন

- নিয়োগ

- সম্ভব

- সর্বশেষ সীমা

- প্রবেশ

- পরিবেশ

- পরিবেশের

- ইউরোপ

- উদাহরণ

- অভিজ্ঞতা

- বর্ধিত বাস্তবতা

- নির্যাস

- মিথ্যা

- বৈশিষ্ট্য

- প্রতিক্রিয়া

- কয়েক

- ক্ষেত্র

- ক্ষেত্রসমূহ

- ব্যক্তিত্ব

- ফাইল

- প্রথম

- ফিট

- কেন্দ্রবিন্দু

- গুরুত্ত্ব

- অনুসরণ করা

- অনুসরণ

- জন্য

- পাওয়া

- চার

- ফ্রাংকফুর্ট

- থেকে

- ক্রিয়া

- লয়

- সাধারণত

- উত্পাদন করা

- উত্পন্ন

- প্রজন্ম

- সৃজক

- জেনারেটিভ এআই

- GitHub

- প্রদত্ত

- ভাল

- অতিথি

- অতিথি পোস্ট

- he

- হেডসেট

- সাহায্য

- এখানে

- উচ্চ পারদর্শিতা

- ঊর্ধ্বতন

- হাইলাইট

- ঝুলিতে

- এইচপিসি

- এইচটিএমএল

- HTTPS দ্বারা

- অকুলীন

- i

- IDX

- if

- ভাবমূর্তি

- চিত্র

- বাস্তবায়ন

- বাস্তবায়ন

- আমদানি

- in

- সুদ্ধ

- অন্তর্ভুক্ত

- স্বতন্ত্র

- শিল্প

- শিল্প-নেতৃস্থানীয়

- তথ্য

- ইনপুট

- ইনস্টল

- উদাহরণ

- ইন্টেল

- বুদ্ধিমান

- আন্তঃসংযুক্ত

- ইন্টারফেস

- IT

- JPG

- মাত্র

- চাবি

- গলি

- ভাষা

- বড়

- অদৃশ্যতা

- শুরু করা

- শিখতে

- শিক্ষা

- লাইব্রেরি

- লাইব্রেরি

- আলো

- লাইন

- লোড

- পরিচালিত

- ব্যবস্থাপনা

- মাস্ক

- জরায়ু

- সর্বোচ্চ

- চরমে তোলা

- সম্ভব

- সর্বাধিক

- স্মৃতি

- জাল

- মেটা

- মাইক্রোসফট

- মিনিট

- মডেল

- মডেল

- পরিবর্তিত

- অধিক

- সেতু

- নাম

- সংকীর্ণ

- প্রাকৃতিক

- স্বাভাবিক ভাষা প্রক্রিয়াকরণ

- প্রয়োজনীয়

- প্রয়োজন

- নেটওয়ার্ক

- নেটওয়ার্কিং

- নেটওয়ার্ক

- নতুন

- পরবর্তী প্রজন্ম

- এখন

- অসাড়

- এনভিডিয়া

- লক্ষ্য

- of

- on

- অনবোর্ড

- অনবোর্ডিং

- ONE

- কেবল

- খোলা

- OpenAI

- অপ্টিমিজ

- অপ্টিমাইজ

- or

- অরেগন

- সংগঠন

- OS

- অন্যান্য

- বাইরে

- আউটপুট

- আউটপুট

- শেষ

- নিজের

- প্যাকেজ

- পৃষ্ঠা

- অংশ

- পাস

- গৃহীত

- কামুক

- পথ

- বেতন

- প্রতি

- কর্মক্ষমতা

- ব্যক্তিগত

- পিএইচডি

- পদার্থবিদ্যা

- মাচা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- বিন্দু

- জনপ্রিয়

- সম্ভব

- পোস্ট

- চালিত

- স্পষ্টতা

- পূর্বে

- অধ্যক্ষ

- প্রক্রিয়াজাতকরণ

- প্রযোজনা

- উত্পাদন করে

- পণ্য

- পণ্য ব্যবস্থাপনা

- উত্পাদনের

- পণ্য

- কার্যক্রম

- প্রকল্প

- উপলব্ধ

- প্রদানের

- প্রকাশ্য

- পাইথন

- পাইটার্চ

- যা এমনকি

- দ্রুত

- পরিসর

- RE

- পড়া

- বাস্তবতা

- অঞ্চল

- প্রয়োজনীয়

- আবশ্যকতা

- ধারনকারী

- প্রত্যাবর্তন

- পুনঃব্যবহারের

- রায়

- চালান

- দৌড়

- রান

- একই

- সংরক্ষণ করুন

- রক্ষা

- মাপযোগ্য

- স্কেল

- SDK

- দ্বিতীয়

- দেখ

- পাঠান

- বাক্য

- ক্রম

- সেবা

- সেবা

- সেশন

- সেট

- সে

- প্রদর্শিত

- সহজ

- সহজতর করা

- সাইট

- আয়তন

- স্মার্টফোন

- স্মার্টফোনের

- So

- সলিউশন

- বিস্তৃত

- বিশেষজ্ঞ

- গাদা

- মান

- শুরু

- শুরু

- ধাপ

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- স্টোরেজ

- দোকান

- সংরক্ষণ

- কৌশল

- পরবর্তীকালে

- এমন

- উচ্চতর

- সমর্থন

- সমর্থক

- সমর্থন

- SYS

- পদ্ধতি

- টেবিল

- প্রযুক্তি

- প্রযুক্তিঃ

- পাঠ

- যে

- সার্জারির

- তাদের

- তারপর

- এইগুলো

- তারা

- এই

- তিন

- দ্বারা

- থ্রুপুট

- পুরনো

- থেকে

- আজ

- টোকেনাইজ

- টুল

- সমাজের সারাংশ

- মশাল

- মোট

- ট্রাফিক

- প্রশিক্ষিত

- ট্রান্সফরমার

- সত্য

- সুরকরণ

- অভিভাবকসংবঁধীয়

- সমন্বিত

- বিশ্ববিদ্যালয়

- us

- ব্যবহার

- ব্যবহার ক্ষেত্রে

- ব্যবহারের ক্ষেত্রে

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহার

- চলিত

- v1

- যাচাই করুন

- মূল্য

- ভার্চুয়াল

- দৃষ্টি

- দেখুন

- we

- ওয়েব

- ওয়েব সার্ভিস

- আমরা একটি

- পশ্চিম

- কি

- যে

- যখন

- ব্যাপক

- প্রশস্ত পরিসর

- ইচ্ছা

- সঙ্গে

- শব্দ

- কাজ

- বিশ্বব্যাপী

- বছর

- আপনি

- আপনার

- zephyrnet