হুইস্পার হল একটি স্বয়ংক্রিয় স্পিচ রিকগনিশন (ASR) মডেল যা ওয়েব থেকে 680,000 ঘণ্টার তত্ত্বাবধানে থাকা ডেটা ব্যবহার করে প্রশিক্ষিত হয়েছে, যা বিভিন্ন ভাষা এবং কাজের পরিধিকে অন্তর্ভুক্ত করে। এর সীমাবদ্ধতাগুলির মধ্যে একটি হল নিম্ন-সম্পদ ভাষা যেমন মারাঠি ভাষা এবং দ্রাবিড় ভাষাগুলির নিম্ন-কর্মক্ষমতা, যা সূক্ষ্ম-সুরকরণের মাধ্যমে প্রতিকার করা যেতে পারে। যাইহোক, কম্পিউটেশনাল রিসোর্স এবং স্টোরেজ প্রয়োজনীয়তা উভয় ক্ষেত্রেই হুইস্পার মডেলকে ফাইন-টিউন করা একটি যথেষ্ট চ্যালেঞ্জ হয়ে দাঁড়িয়েছে। হুইস্পার মডেলগুলির জন্য সম্পূর্ণ ফাইন-টিউনিং এর পাঁচ থেকে দশ রানের জন্য প্রায় 100 ঘন্টা A100 GPU (40 GB SXM4) (মডেলের আকার এবং মডেলের প্যারামিটারের উপর ভিত্তি করে পরিবর্তিত হয়), এবং প্রতিটি সূক্ষ্ম-টিউন করা চেকপয়েন্টের জন্য প্রায় 7 GB স্টোরেজ স্পেস প্রয়োজন। উচ্চ কম্পিউটেশনাল এবং স্টোরেজ চাহিদার এই সংমিশ্রণটি উল্লেখযোগ্য বাধা সৃষ্টি করতে পারে, বিশেষ করে সীমিত সংস্থান সহ পরিবেশে, প্রায়শই অর্থপূর্ণ ফলাফল অর্জন করা ব্যতিক্রমীভাবে কঠিন করে তোলে।

নিম্ন-র্যাঙ্ক অভিযোজন, নামেও পরিচিত LoRA, মডেল ফাইন-টিউনিংয়ের জন্য একটি অনন্য পদ্ধতি গ্রহণ করে। এটি একটি স্থির অবস্থায় প্রাক-প্রশিক্ষিত মডেলের ওজন বজায় রাখে এবং ট্রান্সফরমার কাঠামোর প্রতিটি স্তরে প্রশিক্ষণযোগ্য র্যাঙ্ক পচন ম্যাট্রিক্স প্রবর্তন করে। এই পদ্ধতিটি ডাউনস্ট্রিম কাজের জন্য প্রয়োজনীয় প্রশিক্ষণযোগ্য প্যারামিটারের সংখ্যা 10,000 গুণ কমাতে পারে এবং GPU মেমরির প্রয়োজনীয়তা 3 গুণ কমাতে পারে। মডেলের মানের দিক থেকে, কম প্রশিক্ষিত প্যারামিটারের সাথে কাজ করা সত্ত্বেও, LoRA-কে প্রথাগত ফাইন-টিউনিং পদ্ধতির পারফরম্যান্সের সাথে মেলে বা অতিক্রম করতে দেখা গেছে (মূল থেকে ফলাফল দেখুন LoRA কাগজ) এটি বর্ধিত প্রশিক্ষণ থ্রুপুট সুবিধা প্রদান করে। অসদৃশ এডাপটার পদ্ধতিতে, LoRA অনুমানের সময় অতিরিক্ত লেটেন্সি প্রবর্তন করে না, যার ফলে স্থাপনার পর্যায়ে মডেলের দক্ষতা বজায় থাকে। LoRA ব্যবহার করে ফাইন-টিউনিং হুইস্পার আশাব্যঞ্জক ফলাফল দেখিয়েছে। Whisper-Large-v2 নিন, উদাহরণস্বরূপ: 3 জিবি মেমরির জিপিইউতে 12-ঘন্টার সাধারণ ভয়েস ডেটাসেটের সাথে 8-যুগগুলি চালাতে 6-8 ঘন্টা সময় লাগে, যা তুলনামূলক কর্মক্ষমতা সহ সম্পূর্ণ ফাইন-টিউনিংয়ের চেয়ে 5 গুণ দ্রুত।

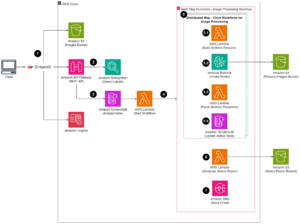

আমাজন সেজমেকার হুইস্পারের LoRA ফাইন-টিউনিং বাস্তবায়নের জন্য একটি আদর্শ প্ল্যাটফর্ম। Amazon SageMaker আপনাকে সম্পূর্ণরূপে পরিচালিত পরিকাঠামো, সরঞ্জাম এবং কর্মপ্রবাহ সহ যেকোন ব্যবহারের ক্ষেত্রে মেশিন লার্নিং মডেলগুলি তৈরি করতে, প্রশিক্ষণ দিতে এবং স্থাপন করতে সক্ষম করে৷ অতিরিক্ত মডেল প্রশিক্ষণ সুবিধার মধ্যে ম্যানেজড স্পট ট্রেনিং-এর সাথে কম প্রশিক্ষণের খরচ, মডেলকে বিভক্ত করার জন্য বিতরণ করা প্রশিক্ষণ লাইব্রেরি এবং AWS GPU দৃষ্টান্ত জুড়ে প্রশিক্ষণ ডেটাসেট অন্তর্ভুক্ত থাকতে পারে এবং অধিক. প্রশিক্ষিত সেজমেকার মডেলগুলি সহজেই সেজমেকারে সরাসরি অনুমানের জন্য স্থাপন করা যেতে পারে। এই পোস্টে, আমরা সেজমেকারে LoRA ফাইন-টিউনিং বাস্তবায়নের জন্য একটি ধাপে ধাপে নির্দেশিকা উপস্থাপন করি। এই বাস্তবায়নের সাথে যুক্ত সোর্স কোডটি পাওয়া যাবে GitHub.

ফাইন-টিউনিংয়ের জন্য ডেটাসেট প্রস্তুত করুন

আমরা ফাইন-টিউনিং টাস্কের জন্য কম-রিসোর্স ভাষা মারাঠি ব্যবহার করি। ব্যবহার করে আলিঙ্গন মুখ ডেটাসেট লাইব্রেরি, আপনি প্রশিক্ষণ এবং টেস্টিং ডেটাসেটে কমন ভয়েস ডেটাসেট ডাউনলোড এবং বিভক্ত করতে পারেন। নিম্নলিখিত কোড দেখুন:

হুইস্পার স্পিচ রিকগনিশন মডেলের জন্য অডিও ইনপুট থাকা প্রয়োজন 16kHz মনো 16-বিট স্বাক্ষরিত পূর্ণসংখ্যা WAV ফাইল. যেহেতু কমন ভয়েস ডেটাসেটটি 48K স্যাম্পলিং রেট, আপনাকে প্রথমে অডিও ফাইলগুলি ডাউনস্যাম্পল করতে হবে। তারপর লগ-মেল স্পেকট্রোগ্রাম বৈশিষ্ট্যগুলি বের করতে আপনাকে অডিওতে হুইস্পারের বৈশিষ্ট্য এক্সট্র্যাক্টর প্রয়োগ করতে হবে এবং ট্রান্সক্রিপ্টের প্রতিটি বাক্যকে একটি টোকেন আইডিতে রূপান্তর করতে ফ্রেমযুক্ত বৈশিষ্ট্যগুলিতে হুইস্পারের টোকেনাইজার প্রয়োগ করতে হবে। নিম্নলিখিত কোড দেখুন:

আপনি সমস্ত প্রশিক্ষণের নমুনাগুলি প্রক্রিয়া করার পরে, প্রক্রিয়াকৃত ডেটা Amazon S3 এ আপলোড করুন, যাতে প্রক্রিয়াকৃত প্রশিক্ষণের ডেটা সূক্ষ্ম-টিউনিং পর্যায়ে ব্যবহার করার সময়, আপনি ব্যবহার করতে পারেন ফাস্টফাইল স্থানীয় ডিস্কে অনুলিপি করার পরিবর্তে সরাসরি S3 ফাইলটি মাউন্ট করতে:

মডেল প্রশিক্ষণ

প্রদর্শনের জন্য, আমরা whisper-large-v2 ব্যবহার করি প্রাক-প্রশিক্ষিত মডেল হিসেবে (whisper v3 এখন উপলব্ধ), যা Hugging Face ট্রান্সফরমার লাইব্রেরির মাধ্যমে আমদানি করা যেতে পারে। তুমি ব্যবহার করতে পার 8-বিট কোয়ান্টাইজেশন প্রশিক্ষণের দক্ষতা আরও উন্নত করতে। 8-বিট কোয়ান্টাইজেশন ফ্লোটিং পয়েন্ট থেকে 8-বিট পূর্ণসংখ্যাতে রাউন্ডিং করে মেমরি অপ্টিমাইজেশন অফার করে। এটি একটি সাধারণভাবে ব্যবহৃত মডেল কম্প্রেশন কৌশল যা অনুমান করার সময় খুব বেশি সূক্ষ্মতা বিসর্জন না করে কম মেমরির সঞ্চয় করে।

8-বিট কোয়ান্টাইজড ফরম্যাটে প্রাক-প্রশিক্ষিত মডেল লোড করার জন্য, আমরা মডেলটি ইনস্ট্যান্ট করার সময় load_in_8bit=True আর্গুমেন্ট যোগ করি, যেমনটি নিম্নলিখিত কোডে দেখানো হয়েছে। এটি 8 বিটে পরিমাপকৃত মডেল ওজন লোড করবে, মেমরি পদচিহ্ন হ্রাস করবে।

আমরা Hugging Face এর থেকে LoRA বাস্তবায়ন ব্যবহার করি peft প্যাকেজ LoRA ব্যবহার করে একটি মডেলকে ফাইন-টিউন করার জন্য চারটি ধাপ রয়েছে:

- একটি বেস মডেল ইনস্ট্যান্টিয়েট করুন (যেমন আমরা শেষ ধাপে করেছি)।

- একটি কনফিগারেশন তৈরি করুন (

LoraConfig) যেখানে LoRA-নির্দিষ্ট পরামিতি সংজ্ঞায়িত করা হয়। - সঙ্গে বেস মডেল মোড়ানো

get_peft_model()একটি প্রশিক্ষণযোগ্য পেতেPeftModel. - প্রশিক্ষণ

PeftModelবেস মডেল হিসাবে।

নিম্নলিখিত কোডটি দেখুন:

চালানো a সেজমেকার প্রশিক্ষণ কাজ, আমরা আমাদের নিজস্ব ডকার কন্টেইনার নিয়ে আসি। আপনি থেকে ডকার ইমেজ ডাউনলোড করতে পারেন GitHub, যেখানে ffmpeg4 এবং git-lfs অন্যান্য Python প্রয়োজনীয়তার সাথে একত্রে প্যাকেজ করা হয়। সেজমেকারের সাথে কাজ করার জন্য আপনার নিজের ডকার কন্টেইনারকে কীভাবে মানিয়ে নেওয়া যায় সে সম্পর্কে আরও জানতে, পড়ুন আপনার নিজস্ব প্রশিক্ষণ ধারক অভিযোজিত. তারপর আপনি হাগিং ফেস এস্টিমেটর ব্যবহার করতে পারেন এবং সেজমেকার প্রশিক্ষণের কাজ শুরু করতে পারেন:

LoRA বাস্তবায়ন আমাদেরকে একটি একক GPU দৃষ্টান্তে হুইস্পার বড় ফাইন-টিউনিং টাস্ক চালাতে সক্ষম করেছে (উদাহরণস্বরূপ, ml.g5.2xlarge)। তুলনামূলকভাবে, হুইস্পার বড় ফুল ফাইন-টিউনিং টাস্কের জন্য একাধিক GPU (উদাহরণস্বরূপ, ml.p4d.24xlarge) এবং অনেক বেশি প্রশিক্ষণের সময় প্রয়োজন। আরও নির্দিষ্টভাবে, আমাদের পরীক্ষায় প্রমাণিত হয়েছে যে সম্পূর্ণ ফাইন-টিউনিং টাস্কের জন্য LoRA পদ্ধতির তুলনায় 24 গুণ বেশি GPU ঘন্টা প্রয়োজন।

মডেল কর্মক্ষমতা মূল্যায়ন

ফাইন-টিউনড হুইস্পার মডেলের কর্মক্ষমতা মূল্যায়ন করার জন্য, আমরা একটি হোল্ড-আউট টেস্ট সেটে শব্দ ত্রুটির হার (WER) গণনা করি। WER পূর্বাভাসিত প্রতিলিপি এবং স্থল সত্য প্রতিলিপির মধ্যে পার্থক্য পরিমাপ করে। একটি নিম্ন WER ভাল কর্মক্ষমতা নির্দেশ করে। আপনি পূর্ব-প্রশিক্ষিত মডেল এবং ফাইন-টিউনড মডেলের বিপরীতে নিম্নলিখিত স্ক্রিপ্টটি চালাতে পারেন এবং তাদের WER পার্থক্য তুলনা করতে পারেন:

উপসংহার

এই পোস্টে, আমরা সূক্ষ্ম-টিউনিং হুইস্পার প্রদর্শন করেছি, একটি অত্যাধুনিক স্পিচ রিকগনিশন মডেল। বিশেষ করে, আমরা Hugging Face এর PEFT LoRA ব্যবহার করেছি এবং দক্ষ প্রশিক্ষণের জন্য 8-বিট কোয়ান্টাইজেশন সক্ষম করেছি। আমরা সেজমেকারে প্রশিক্ষণের কাজটি কীভাবে চালাতে হয় তাও প্রদর্শন করেছি।

যদিও এটি একটি গুরুত্বপূর্ণ প্রথম ধাপ, তবে হুইস্পার মডেলটিকে আরও উন্নত করতে আপনি এই কাজটি তৈরি করতে পারেন এমন বিভিন্ন উপায় রয়েছে৷ সামনের দিকে, অনেক বড় ডেটাসেটে প্রশিক্ষণ স্কেল করার জন্য SageMaker বিতরণ করা প্রশিক্ষণ ব্যবহার করার কথা বিবেচনা করুন। এটি মডেলটিকে আরও বৈচিত্র্যময় এবং ব্যাপক ডেটার উপর প্রশিক্ষণের অনুমতি দেবে, সঠিকতা উন্নত করবে। রিয়েল-টাইম স্পিচ রিকগনিশন সক্ষম করতে আপনি হুইস্পার মডেল পরিবেশন করার সময় লেটেন্সিও অপ্টিমাইজ করতে পারেন। অতিরিক্তভাবে, আপনি দীর্ঘ অডিও ট্রান্সক্রিপশন পরিচালনা করতে কাজকে প্রসারিত করতে পারেন, যার জন্য মডেল আর্কিটেকচার এবং প্রশিক্ষণ স্কিমগুলিতে পরিবর্তন প্রয়োজন।

স্বীকৃতি

লেখকরা তাদের অন্তর্দৃষ্টিপূর্ণ প্রতিক্রিয়া এবং পোস্টের পর্যালোচনার জন্য পারস মেহরা, জন সল এবং ইভান্দ্রো ফ্রাঙ্কোর প্রতি কৃতজ্ঞতা প্রকাশ করেছেন।

লেখক সম্পর্কে

জুন শি আমাজন ওয়েব সার্ভিসেস (AWS) এর একজন সিনিয়র সলিউশন আর্কিটেক্ট। তার বর্তমান ফোকাস ক্ষেত্র হল AI/ML পরিকাঠামো এবং অ্যাপ্লিকেশন। সফটওয়্যার ইঞ্জিনিয়ার হিসেবে ফিনটেক ইন্ডাস্ট্রিতে তার এক দশকের বেশি অভিজ্ঞতা রয়েছে।

জুন শি আমাজন ওয়েব সার্ভিসেস (AWS) এর একজন সিনিয়র সলিউশন আর্কিটেক্ট। তার বর্তমান ফোকাস ক্ষেত্র হল AI/ML পরিকাঠামো এবং অ্যাপ্লিকেশন। সফটওয়্যার ইঞ্জিনিয়ার হিসেবে ফিনটেক ইন্ডাস্ট্রিতে তার এক দশকের বেশি অভিজ্ঞতা রয়েছে।

ডঃ. চাংশা মা AWS-এর একজন AI/ML বিশেষজ্ঞ। তিনি কম্পিউটার সায়েন্সে পিএইচডি, শিক্ষা মনোবিজ্ঞানে স্নাতকোত্তর ডিগ্রি এবং ডেটা সায়েন্সে বছরের অভিজ্ঞতা এবং এআই/এমএলে স্বাধীন পরামর্শ সহ একজন প্রযুক্তিবিদ। তিনি মেশিন এবং মানুষের বুদ্ধিমত্তার জন্য পদ্ধতিগত পদ্ধতির গবেষণা সম্পর্কে উত্সাহী। কাজের বাইরে, তিনি হাইকিং, রান্না, খাবার শিকার এবং বন্ধু এবং পরিবারের সাথে সময় কাটাতে পছন্দ করেন।

ডঃ. চাংশা মা AWS-এর একজন AI/ML বিশেষজ্ঞ। তিনি কম্পিউটার সায়েন্সে পিএইচডি, শিক্ষা মনোবিজ্ঞানে স্নাতকোত্তর ডিগ্রি এবং ডেটা সায়েন্সে বছরের অভিজ্ঞতা এবং এআই/এমএলে স্বাধীন পরামর্শ সহ একজন প্রযুক্তিবিদ। তিনি মেশিন এবং মানুষের বুদ্ধিমত্তার জন্য পদ্ধতিগত পদ্ধতির গবেষণা সম্পর্কে উত্সাহী। কাজের বাইরে, তিনি হাইকিং, রান্না, খাবার শিকার এবং বন্ধু এবং পরিবারের সাথে সময় কাটাতে পছন্দ করেন।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- : আছে

- : হয়

- :কোথায়

- 000

- 1

- 10

- 100

- 13

- 15%

- 17

- 24

- 25

- 26%

- 40

- 7

- 8

- 97

- a

- সম্পর্কে

- সঠিকতা

- অর্জন করা

- দিয়ে

- খাপ খাওয়ানো

- অভিযোজন

- যোগ

- অতিরিক্ত

- উপরন্তু

- বিরুদ্ধে

- এআই / এমএল

- সব

- অনুমতি

- এছাড়াও

- মর্দানী স্ত্রীলোক

- আমাজন সেজমেকার

- অ্যামাজন ওয়েব সার্ভিসেস

- আমাজন ওয়েব সার্ভিসেস (এডব্লিউএস)

- amp

- an

- এবং

- কোন

- অ্যাপ্লিকেশন

- প্রয়োগ করা

- অভিগমন

- পন্থা

- আন্দাজ

- স্থাপত্য

- রয়েছি

- এলাকার

- যুক্তি

- বিন্যাস

- AS

- যুক্ত

- At

- অডিও

- লেখক

- গাড়ী

- স্বয়ংক্রিয়

- সহজলভ্য

- ডেস্কটপ AWS

- ভিত্তি

- ভিত্তি

- BE

- কারণ

- পরিণত

- হয়েছে

- সুবিধা

- সুবিধা

- উত্তম

- মধ্যে

- উভয়

- আনা

- নির্মাণ করা

- by

- গণনা করা

- CAN

- কেস

- চ্যালেঞ্জ

- পরিবর্তন

- কোড

- সমাহার

- সাধারণ

- সাধারণভাবে

- তুলনীয়

- তুলনা করা

- তুলনা

- তুলনা

- ব্যাপক

- গণনা

- গনা

- কম্পিউটার

- কম্পিউটার বিজ্ঞান

- কনফিগারেশন

- বিবেচনা

- গণ্যমান্য

- পরামর্শকারী

- আধার

- রূপান্তর

- নকল

- খরচ

- পারা

- বর্তমান

- উপাত্ত

- ডেটা প্রস্তুতি

- তথ্য বিজ্ঞান

- ডেটাসেট

- দশক

- হ্রাস

- সংজ্ঞায়িত

- ডিগ্রী

- এর

- দাবি

- প্রদর্শিত

- স্থাপন

- মোতায়েন

- বিস্তৃতি

- সত্ত্বেও

- DID

- পার্থক্য

- কঠিন

- সরাসরি

- বণ্টিত

- বিতরণ করা প্রশিক্ষণ

- ডকশ্রমিক

- না

- ডাউনলোড

- সময়

- প্রতি

- সহজে

- প্রশিক্ষণ

- দক্ষতা

- দক্ষ

- সক্ষম করা

- সক্ষম করা

- সম্ভব

- encompassing

- প্রকৌশলী

- পরিবেশের

- কাল

- ভুল

- বিশেষত

- মূল্যায়ন

- এমন কি

- উদাহরণ

- অতিক্রম করা

- অত্যন্ত

- বিস্তৃত করা

- অভিজ্ঞতা

- পরীক্ষা

- প্রসারিত করা

- নির্যাস

- মুখ

- পরিবারের

- দ্রুত

- বৈশিষ্ট্য

- বৈশিষ্ট্য

- প্রতিক্রিয়া

- কম

- ফাইল

- নথি পত্র

- fintech

- প্রথম

- পাঁচ

- নির্দলীয়

- কেন্দ্রবিন্দু

- অনুসরণ

- খাদ্য

- পদাঙ্ক

- জন্য

- বিন্যাস

- অগ্রবর্তী

- পাওয়া

- চার

- বন্ধুদের

- থেকে

- সম্পূর্ণ

- সম্পূর্ণরূপে

- ক্রিয়া

- অধিকতর

- পাওয়া

- চালু

- জিপিইউ

- জিপিইউ

- কৃতজ্ঞতা

- স্থল

- কৌশল

- হাতল

- আছে

- he

- উচ্চ

- তার

- ঘন্টার

- কিভাবে

- কিভাবে

- যাহোক

- এইচটিএমএল

- HTTPS দ্বারা

- মানবীয়

- মানব বুদ্ধি

- শিকার

- বেড়া-ডিঙ্গান দৌড়

- ID

- আদর্শ

- আইডি

- ভাবমূর্তি

- বাস্তবায়ন

- বাস্তবায়ন

- আমদানি

- গুরুত্বপূর্ণ

- উন্নত করা

- উন্নতি

- in

- অন্তর্ভুক্ত করা

- বর্ধিত

- স্বাধীন

- ইঙ্গিত

- শিল্প

- পরিকাঠামো

- ইনপুট

- ইনপুট

- অন্তর্দৃষ্টিপূর্ণ

- উদাহরণ

- পরিবর্তে

- বুদ্ধিমত্তা

- মধ্যে

- প্রবর্তন করা

- পরিচয় করিয়ে দেয়

- IT

- এর

- কাজ

- জন

- JPG

- পরিচিত

- লেবেল

- লেবেলগুলি

- ভাষা

- ভাষাসমূহ

- বড়

- বৃহত্তর

- গত

- অদৃশ্যতা

- স্তর

- শিখতে

- শিক্ষা

- লাইব্রেরি

- লাইব্রেরি

- সীমাবদ্ধতা

- সীমিত

- বোঝা

- স্থানীয়

- আর

- ভালবাসে

- নিম্ন

- মেশিন

- মেশিন লার্নিং

- নিয়ন্ত্রণের

- রক্ষণাবেক্ষণ

- মেকিং

- পরিচালিত

- মানচিত্র

- মাস্টার্স

- ম্যাচ

- অর্থপূর্ণ

- পরিমাপ

- স্মৃতি

- পদ্ধতি

- পদ্ধতি

- ছন্দোময়

- ML

- মডেল

- মডেল

- অধিক

- মাউন্ট

- mr

- অনেক

- বহু

- প্রয়োজন

- প্রয়োজন

- প্রয়োজন

- না

- এখন

- সংখ্যা

- এনভিডিয়া

- of

- অফার

- প্রায়ই

- on

- ONE

- অপারেটিং

- অপ্টিমাইজেশান

- অপ্টিমিজ

- অপশন সমূহ

- or

- মূল

- অন্যান্য

- আমাদের

- বাহিরে

- শেষ

- নিজের

- প্যাকেজ

- গাঁটবন্দী

- পরামিতি

- বিশেষ

- কামুক

- পিডিএফ

- কর্মক্ষমতা

- ফেজ

- পিএইচডি

- মাচা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- বিন্দু

- অঙ্গবিক্ষেপ

- পোস্ট

- স্পষ্টতা

- পূর্বাভাস

- প্রস্তুতি

- বর্তমান

- প্রক্রিয়াকৃত

- আশাপ্রদ

- মনোবিজ্ঞান

- পাইথন

- গুণ

- পরিসর

- মর্যাদাক্রম

- হার

- প্রকৃত সময়

- স্বীকার

- হ্রাস করা

- হ্রাসপ্রাপ্ত

- হ্রাস

- পড়ুন

- প্রয়োজন

- আবশ্যকতা

- প্রয়োজন

- Resources

- ফলাফল

- প্রত্যাবর্তন

- এখানে ক্লিক করুন

- বৃত্তাকার

- চালান

- রান

- s

- বলিদান

- ঋষি নির্মাতা

- জমা

- স্কেল

- স্কিম

- বিজ্ঞান

- লিপি

- দেখ

- জ্যেষ্ঠ

- বাক্য

- সেবা

- ভজনা

- সেট

- বিভিন্ন

- সে

- প্রদর্শিত

- সাইন ইন

- গুরুত্বপূর্ণ

- কেবল

- একক

- মাপ

- So

- সফটওয়্যার

- সফটওয়্যার ইঞ্জিনিয়ার

- SOL

- সলিউশন

- উৎস

- সোর্স কোড

- স্থান

- বিশেষজ্ঞ

- বিশেষভাবে

- বক্তৃতা

- কন্ঠ সনান্তকরণ

- খরচ

- বিভক্ত করা

- অকুস্থল

- পর্যায়

- শুরু

- রাষ্ট্র

- রাষ্ট্র-এর-শিল্প

- স্থির

- ধাপ

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- স্টোরেজ

- গঠন

- এমন

- গ্রহণ করা

- লাগে

- লক্ষ্য

- কার্য

- কাজ

- প্রযুক্তি

- প্রযুক্তিবিদ

- এই

- শর্তাবলী

- পরীক্ষা

- পরীক্ষামূলক

- পাঠ

- চেয়ে

- যে

- সার্জারির

- উৎস

- তাদের

- তারপর

- সেখানে।

- যার ফলে

- এই

- দ্বারা

- থ্রুপুট

- সময়

- বার

- থেকে

- একসঙ্গে

- টোকেন

- অত্যধিক

- সরঞ্জাম

- মশাল

- ঐতিহ্যগত

- রেলগাড়ি

- প্রশিক্ষিত

- প্রশিক্ষণ

- প্রতিলিপি

- ট্রান্সফরমার

- ট্রান্সফরমার

- সত্য

- অনন্য

- অসদৃশ

- us

- ব্যবহার

- ব্যবহার ক্ষেত্রে

- ব্যবহৃত

- ব্যবহার

- বিভিন্ন

- কণ্ঠস্বর

- উপায়

- we

- ওয়েব

- ওয়েব সার্ভিস

- কখন

- যে

- ফিস্ ফিস্ শব্দ

- ইচ্ছা

- সঙ্গে

- ছাড়া

- শব্দ

- হয়া যাই ?

- কর্মপ্রবাহ

- বছর

- আপনি

- আপনার

- zephyrnet