ভূমিকা

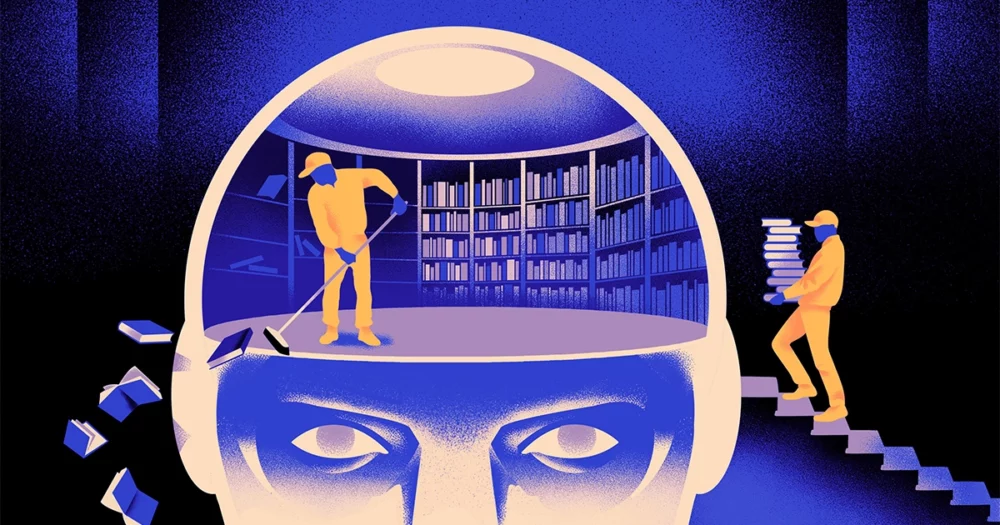

কম্পিউটার বিজ্ঞানীদের একটি দল তৈরি করেছে একটি nimbler, আরো নমনীয় টাইপ মেশিন লার্নিং মডেলের। কৌশল: এটি পর্যায়ক্রমে যা জানে তা ভুলে যেতে হবে। এবং যদিও এই নতুন পদ্ধতিটি বিশাল মডেলগুলিকে স্থানচ্যুত করবে না যা সবচেয়ে বড় অ্যাপগুলিকে আন্ডারগার্ড করে, এটি এই প্রোগ্রামগুলি কীভাবে ভাষা বোঝে সে সম্পর্কে আরও প্রকাশ করতে পারে।

নতুন গবেষণা "ক্ষেত্রে একটি উল্লেখযোগ্য অগ্রগতি" চিহ্নিত করেছে জে কওন, দক্ষিণ কোরিয়ার ইনস্টিটিউট ফর বেসিক সায়েন্সের একজন এআই ইঞ্জিনিয়ার।

বর্তমানে ব্যবহৃত AI ভাষার ইঞ্জিনগুলি বেশিরভাগ দ্বারা চালিত কৃত্রিম নিউরাল নেটওয়ার্ক. নেটওয়ার্কের প্রতিটি "নিউরন" একটি গাণিতিক ফাংশন যা অন্যান্য এই জাতীয় নিউরন থেকে সংকেত গ্রহণ করে, কিছু গণনা চালায় এবং নিউরনের একাধিক স্তরের মাধ্যমে সংকেত পাঠায়। প্রাথমিকভাবে তথ্যের প্রবাহ কমবেশি এলোমেলো হয়, কিন্তু প্রশিক্ষণের মাধ্যমে, নেটওয়ার্ক প্রশিক্ষণের ডেটার সাথে খাপ খায় বলে নিউরনের মধ্যে তথ্য প্রবাহ উন্নত হয়। যদি একজন এআই গবেষক একটি দ্বিভাষিক মডেল তৈরি করতে চান, উদাহরণস্বরূপ, তিনি মডেলটিকে উভয় ভাষার পাঠ্যের একটি বড় স্তূপ দিয়ে প্রশিক্ষণ দেবেন, যা নিউরনের মধ্যে সংযোগগুলিকে এমনভাবে সামঞ্জস্য করবে যাতে পাঠ্যটিকে সমতুল্য ভাষায় একটি ভাষায় সংযুক্ত করা যায়। অন্য শব্দ.

কিন্তু এই প্রশিক্ষণ প্রক্রিয়ায় অনেক কম্পিউটিং শক্তি লাগে। যদি মডেলটি খুব ভালভাবে কাজ না করে, বা ব্যবহারকারীর প্রয়োজন পরে পরিবর্তিত হয়, এটি মানিয়ে নেওয়া কঠিন। "বলুন আপনার কাছে 100টি ভাষা আছে এমন একটি মডেল আছে, কিন্তু কল্পনা করুন যে আপনি যে একটি ভাষা চান তা কভার করা হয়নি," বলেন মাইকেল আর্টেক্সে, নতুন গবেষণার সহ-লেখক এবং এআই স্টার্টআপ রেকা-এর প্রতিষ্ঠাতা। "আপনি স্ক্র্যাচ থেকে শুরু করতে পারেন, কিন্তু এটি আদর্শ নয়।"

Artetxe এবং তার সহকর্মীরা এই সীমাবদ্ধতাগুলি অতিক্রম করার চেষ্টা করেছেন। কিছু বছর আগে, Artetxe এবং অন্যরা একটি ভাষায় একটি নিউরাল নেটওয়ার্ককে প্রশিক্ষিত করে, তারপর শব্দের বিল্ডিং ব্লক সম্পর্কে যা জানত তা মুছে ফেলে, যাকে টোকেন বলা হয়। এগুলি নিউরাল নেটওয়ার্কের প্রথম স্তরে সংরক্ষিত থাকে, যাকে বলা হয় এমবেডিং স্তর। তারা মডেলের অন্যান্য স্তরগুলিকে একা রেখেছিল। প্রথম ভাষার টোকেনগুলি মুছে ফেলার পরে, তারা দ্বিতীয় ভাষার মডেলটিকে পুনরায় প্রশিক্ষণ দেয়, যা সেই ভাষা থেকে নতুন টোকেন দিয়ে এমবেডিং স্তরটি পূর্ণ করে।

যদিও মডেলটিতে অমিল তথ্য রয়েছে, পুনঃপ্রশিক্ষণ কাজ করেছে: মডেলটি নতুন ভাষা শিখতে এবং প্রক্রিয়া করতে পারে। গবেষকরা অনুমান করেছেন যে যখন এম্বেডিং স্তরটি ভাষায় ব্যবহৃত শব্দগুলির জন্য নির্দিষ্ট তথ্য সংরক্ষণ করে, নেটওয়ার্কের গভীর স্তর মানব ভাষার পিছনের ধারণাগুলি সম্পর্কে আরও বিমূর্ত তথ্য সঞ্চয় করে, যা মডেলটিকে দ্বিতীয় ভাষা শিখতে সহায়তা করে।

“আমরা একই পৃথিবীতে বাস করি। আমরা একই জিনিসকে ভিন্ন ভিন্ন শব্দ দিয়ে ধারণা করি”, বলেন ইহং চেন, সাম্প্রতিক কাগজের প্রধান লেখক. “তাই মডেলটিতে আপনার এই একই উচ্চ-স্তরের যুক্তি রয়েছে। একটি আপেল একটি শব্দের পরিবর্তে মিষ্টি এবং রসালো কিছু।"

ভূমিকা

যদিও এই ভুলে যাওয়ার পদ্ধতিটি ইতিমধ্যে প্রশিক্ষিত মডেলে একটি নতুন ভাষা যোগ করার একটি কার্যকর উপায় ছিল, তখনও পুনরায় প্রশিক্ষণের দাবি ছিল - এর জন্য প্রচুর ভাষাগত ডেটা এবং প্রক্রিয়াকরণ শক্তির প্রয়োজন ছিল। চেন একটি খামচির পরামর্শ দিয়েছেন: প্রশিক্ষণের পরিবর্তে, এমবেডিং স্তরটি মুছে ফেলার, তারপর পুনরায় প্রশিক্ষণ দেওয়া, প্রশিক্ষণের প্রাথমিক রাউন্ডের সময় তাদের পর্যায়ক্রমে এমবেডিং স্তরটি পুনরায় সেট করা উচিত। "এটি করার মাধ্যমে, পুরো মডেলটি রিসেট করতে অভ্যস্ত হয়ে যায়," আর্টেক্স বলেছেন। "এর মানে আপনি যখন মডেলটিকে অন্য ভাষায় প্রসারিত করতে চান, তখন এটি সহজ, কারণ আপনি এটিই করছেন।"

গবেষকরা একটি সাধারণভাবে ব্যবহৃত ভাষার মডেল নামে পরিচিত রবার্টা, তাদের পর্যায়ক্রমিক-ভুলে যাওয়ার কৌশল ব্যবহার করে এটিকে প্রশিক্ষিত করে এবং একই মডেলের কর্মক্ষমতার সাথে তুলনা করে যখন এটিকে প্রমিত, ভুলে না যাওয়া পদ্ধতির সাথে প্রশিক্ষিত করা হয়েছিল। ভুলে যাওয়া মডেলটি প্রচলিত মডেলটির চেয়ে কিছুটা খারাপ করেছে, ভাষার নির্ভুলতার একটি সাধারণ পরিমাপের 85.1 এর তুলনায় 86.1 স্কোর পেয়েছে। তারপরে তারা প্রথম প্রশিক্ষণের সময় ব্যবহৃত 5 বিলিয়নটির পরিবর্তে শুধুমাত্র 70 মিলিয়ন টোকেনের অনেক ছোট ডেটা সেট ব্যবহার করে অন্যান্য ভাষার মডেলগুলিকে পুনরায় প্রশিক্ষণ দেয়। স্ট্যান্ডার্ড মডেলের যথার্থতা গড়ে 53.3 এ কমেছে, কিন্তু ভুলে যাওয়া মডেলটি মাত্র 62.7 এ নেমে গেছে।

যদি দল পুনরায় প্রশিক্ষণের সময় গণনামূলক সীমা আরোপ করে তবে ভুলে যাওয়া মডেলটিও অনেক ভাল ছিল। গবেষকরা যখন প্রশিক্ষণের দৈর্ঘ্য 125,000 ধাপ থেকে কমিয়ে মাত্র 5,000 এ পরিণত করেন, তখন ভুলে যাওয়া মডেলের নির্ভুলতা গড়ে 57.8-এ নেমে আসে, যখন আদর্শ মডেলটি 37.2-এ নেমে আসে, যা এলোমেলো অনুমানের চেয়ে ভাল নয়।

ভূমিকা

দলটি উপসংহারে পৌঁছেছে যে পর্যায়ক্রমিক ভুলে যাওয়া সাধারণভাবে ভাষা শেখার ক্ষেত্রে মডেলটিকে আরও ভাল করে তোলে। "কারণ [তারা] প্রশিক্ষণের সময় ভুলে যাওয়া এবং পুনরায় শিখতে থাকে, পরবর্তীতে নেটওয়ার্ককে নতুন কিছু শেখানো সহজ হয়ে যায়," বলেন ইভগেনি নিকিশিন, মিলার একজন গবেষক, কুইবেকের একটি গভীর শিক্ষা গবেষণা কেন্দ্র। এটি পরামর্শ দেয় যে যখন ভাষার মডেলগুলি একটি ভাষা বোঝে, তখন তারা শুধুমাত্র পৃথক শব্দের অর্থের চেয়ে গভীর স্তরে তা করে।

পদ্ধতিটি আমাদের নিজস্ব মস্তিষ্ক কীভাবে কাজ করে তার অনুরূপ। "সাধারণভাবে মানুষের স্মৃতি সঠিকভাবে প্রচুর পরিমাণে বিস্তারিত তথ্য সংরক্ষণের জন্য খুব ভাল নয়। পরিবর্তে, মানুষ আমাদের অভিজ্ঞতার সারাংশ, বিমূর্তকরণ এবং এক্সট্রাপোলেটিং মনে রাখার প্রবণতা রাখে," বলেন বেঞ্জামিন লেভি, সান ফ্রান্সিসকো বিশ্ববিদ্যালয়ের একজন স্নায়ুবিজ্ঞানী। "এআইকে আরও মানবিক প্রক্রিয়ার সাথে সক্ষম করা, যেমন অভিযোজিত ভুলে যাওয়া, তাদের আরও নমনীয় কর্মক্ষমতা অর্জনের একটি উপায়।"

বোঝাপড়া কীভাবে কাজ করে সে সম্পর্কে এটি কী বলতে পারে তা ছাড়াও, Artetxe আশা করে যে আরও নমনীয় ভুলে যাওয়া ভাষা মডেলগুলি আরও বেশি ভাষায় সাম্প্রতিকতম এআই ব্রেকথ্রু আনতে সাহায্য করতে পারে। যদিও এআই মডেলগুলি স্প্যানিশ এবং ইংরেজি, দুটি ভাষা, পর্যাপ্ত প্রশিক্ষণ সামগ্রী সহ পরিচালনা করতে ভাল, মডেলগুলি তার স্থানীয় বাস্কের সাথে খুব ভাল নয়, উত্তর-পূর্ব স্পেনের নির্দিষ্ট স্থানীয় ভাষা। "বড় কারিগরি সংস্থাগুলির বেশিরভাগ মডেল এটি ভাল করে না," তিনি বলেছিলেন। "বাস্কে বিদ্যমান মডেলগুলিকে অভিযোজিত করাই পথ।"

চেন এমন একটি বিশ্বের দিকেও তাকিয়ে আছেন যেখানে আরও এআই ফুল ফোটে। “আমি এমন একটি পরিস্থিতির কথা ভাবছি যেখানে বিশ্বের একটি বড় ভাষার মডেলের প্রয়োজন নেই। আমরা অনেক আছে,” তিনি বলেন. “যদি ভাষার মডেল তৈরির কারখানা থাকে, তাহলে আপনার এই ধরনের প্রযুক্তির প্রয়োজন। এটির একটি বেস মডেল রয়েছে যা দ্রুত নতুন ডোমেনে মানিয়ে নিতে পারে।"

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- : আছে

- : হয়

- :না

- :কোথায়

- [পৃ

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- সম্পর্কে

- বিমূর্ত

- সঠিকতা

- সঠিক

- খাপ খাওয়ানো

- অভিযোজিত

- রূপান্তর

- যোগ

- যোগ

- আগাম

- পর

- AI

- এআই মডেল

- সব

- একা

- ইতিমধ্যে

- এছাড়াও

- পরিমাণে

- an

- এবং

- অন্য

- আপেল

- অভিগমন

- অ্যাপস

- রয়েছি

- AS

- At

- লেখক

- গড়

- ভিত্তি

- মৌলিক

- কারণ

- হয়ে

- হয়েছে

- পিছনে

- উত্তম

- মধ্যে

- বিশাল

- বড় প্রযুক্তি

- বৃহত্তম

- বিলিয়ন

- ব্লক

- পুষ্প

- উভয়

- ক্রমশ

- আনা

- ভবন

- কিন্তু

- by

- গণনার

- নামক

- CAN

- কেন্দ্র

- পরিবর্তন

- চেন

- পাশ কাটিয়ে যাওয়া

- সহ-লেখক

- সহকর্মীদের

- সাধারণ

- সাধারণভাবে

- কোম্পানি

- তুলনা

- গণনা

- কম্পিউটার

- কম্পিউটিং

- গননার ক্ষমতা

- ধারণা

- পর্যবসিত

- সংযোগ

- অন্তর্ভুক্ত

- প্রচলিত

- পারা

- আবৃত

- সৃষ্টি

- নির্মিত

- কাটা

- উপাত্ত

- ডেটা সেট

- কমান

- গভীর

- গভীর জ্ঞানার্জন

- গভীর

- চাহিদা

- বিশদ

- DID

- বিভিন্ন

- do

- না

- করছেন

- ডোমেইনের

- Dont

- বাদ

- সময়

- প্রতি

- সহজ

- কার্যকর

- এম্বেডিং

- প্রকৌশলী

- ইঞ্জিন

- ইংরেজি

- সমগ্র

- সমতুল্য

- উদাহরণ

- বিদ্যমান

- অভিজ্ঞতা

- প্রসারিত করা

- কারখানা

- কয়েক

- ক্ষেত্র

- ভরা

- প্রথম

- নমনীয়

- প্রবাহ

- জন্য

- অগ্রবর্তী

- প্রতিষ্ঠাতা

- ফ্রান্সিসকো

- থেকে

- ক্রিয়া

- সাধারণ

- সাধারণত

- পাওয়া

- GitHub

- Go

- ভাল

- হ্যান্ডলিং

- কঠিন

- আছে

- he

- সাহায্য

- সাহায্য

- উচ্চস্তর

- তার

- আশা

- কিভাবে

- HTTPS দ্বারা

- প্রচুর

- মানবীয়

- মানুষের মত

- মানুষেরা

- আদর্শ

- if

- কল্পনা করা

- আরোপিত

- উন্নত

- in

- স্বতন্ত্র

- তথ্য

- প্রারম্ভিক

- প্রাথমিকভাবে

- পরিবর্তে

- প্রতিষ্ঠান

- IT

- মাত্র

- রাখা

- রকম

- জানে

- কোরিয়া

- ভাষা

- ভাষাসমূহ

- বড়

- পরে

- সর্বশেষ

- স্তর

- স্তর

- নেতৃত্ব

- শিখতে

- শিক্ষা

- বাম

- লম্বা

- কম

- উচ্চতা

- মাত্রা

- মত

- সীমাবদ্ধতা

- সীমা

- জীবিত

- স্থানীয়

- সৌন্দর্য

- অনেক

- মেশিন

- মেশিন লার্নিং

- পত্রিকা

- করা

- মেকিং

- অনেক

- উপকরণ

- গাণিতিক

- অর্থ

- মানে

- মাপ

- স্মৃতি

- হতে পারে

- মিলিয়ন

- মডেল

- মডেল

- অধিক

- অধিকাংশ ক্ষেত্রে

- অনেক

- বহু

- অবশ্যই

- স্থানীয়

- প্রয়োজন

- চাহিদা

- নেটওয়ার্ক

- নার্ভীয়

- স্নায়বিক নেটওয়ার্ক

- নিউরোন

- নতুন

- না।

- of

- on

- ONE

- কেবল

- or

- অন্যান্য

- অন্যরা

- আমাদের

- শেষ

- নিজের

- কাগজ

- কর্মক্ষমতা

- পর্যাবৃত্ত

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- নিমগ্ন

- ক্ষমতা

- চালিত

- প্রক্রিয়া

- প্রসেস

- প্রক্রিয়াজাতকরণ

- প্রসেসিং শক্তি

- প্রোগ্রাম

- কোয়ান্টাম্যাগাজিন

- ক্যুবেক

- দ্রুত

- এলোমেলো

- বরং

- পায়

- গ্রহণ

- সাম্প্রতিক

- মনে রাখা

- প্রয়োজনীয়

- গবেষণা

- গবেষক

- গবেষকরা

- প্রকাশ করা

- বৃত্তাকার

- রান

- বলেছেন

- একই

- সান

- সানফ্রান্সিসকো

- বলা

- বিজ্ঞান

- বিজ্ঞানীরা

- স্কোর

- আঁচড়ের দাগ

- দ্বিতীয়

- মনে হয়

- নির্বাচক

- পাঠায়

- সেট

- সে

- উচিত

- সংকেত

- গুরুত্বপূর্ণ

- অনুরূপ

- অবস্থা

- ক্ষুদ্রতর

- So

- কিছু

- কিছু

- দক্ষিণ

- দক্ষিণ কোরিয়া

- স্পেন

- স্প্যানিশ

- নির্দিষ্ট

- মান

- শুরু

- প্রারম্ভকালে

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- এখনো

- সঞ্চিত

- সংরক্ষণ

- এমন

- প্রস্তাব

- মিষ্টি

- লাগে

- শিক্ষাদান

- টীম

- প্রযুক্তি

- প্রযুক্তি কোম্পানিগুলি

- প্রযুক্তি

- প্রযুক্তিঃ

- tends

- পাঠ

- চেয়ে

- যে

- সার্জারির

- তথ্য

- বিশ্ব

- তাদের

- তাহাদিগকে

- তারপর

- এইগুলো

- তারা

- কিছু

- চিন্তা

- এই

- যদিও?

- দ্বারা

- থেকে

- আজ

- টোকেন

- গ্রহণ

- রেলগাড়ি

- প্রশিক্ষিত

- প্রশিক্ষণ

- কৌতুক

- চেষ্টা

- খামচি

- দুই

- বোঝা

- বোধশক্তি

- বিশ্ববিদ্যালয়

- ব্যবহার

- ব্যবহৃত

- ব্যবহার

- খুব

- প্রয়োজন

- চায়

- ছিল

- উপায়..

- we

- webp

- আমরা একটি

- কি

- কখন

- যে

- যখন

- কেন

- সঙ্গে

- শব্দ

- শব্দ

- হয়া যাই ?

- কাজ করছে

- কাজ

- বিশ্ব

- খারাপ

- would

- বছর

- আপনি

- zephyrnet