সাম্প্রতিক বড় ভাষা মডেল (LLMs) প্রাকৃতিক ভাষা বোঝার ক্ষেত্রে অসাধারণ অগ্রগতি সক্ষম করেছে। যাইহোক, তারা আত্মবিশ্বাসী কিন্তু অযৌক্তিক ব্যাখ্যা তৈরি করতে প্রবণ, যা ব্যবহারকারীদের সাথে বিশ্বাস স্থাপনে একটি উল্লেখযোগ্য বাধা সৃষ্টি করে। এই পোস্টে, আমরা দেখাই যে এই কাজগুলিতে পারফরম্যান্স উন্নত করার জন্য মাল্টি-হপ যুক্তির জন্য ভুল যুক্তি চেইনের উপর মানুষের প্রতিক্রিয়া কীভাবে অন্তর্ভুক্ত করা যায়। মানুষকে জিজ্ঞাসা করে স্ক্র্যাচ থেকে যুক্তির চেইনগুলি সংগ্রহ করার পরিবর্তে, আমরা LLM-এর প্রম্পটিং ক্ষমতা ব্যবহার করে মডেল-উত্পন্ন যুক্তি চেইনের সমৃদ্ধ মানব প্রতিক্রিয়া থেকে শিখি। আমরা স্ট্র্যাটেজিকিউএ এবং স্পোর্টস আন্ডারস্ট্যান্ডিং ডেটাসেটের জন্য মানুষের প্রতিক্রিয়ার এই ধরনের দুটি ডেটাসেট (সংশোধন, ব্যাখ্যা, ত্রুটির ধরন) আকারে সংগ্রহ করি এবং এই ধরনের প্রতিক্রিয়া থেকে শেখার জন্য বেশ কয়েকটি সাধারণ অ্যালগরিদম মূল্যায়ন করি। আমাদের প্রস্তাবিত পদ্ধতিগুলি বেস ফ্লান-টি 5 ব্যবহার করে চেইন-অফ-থট প্রম্পটিং প্রতিযোগিতামূলকভাবে কাজ করে এবং আমাদের নিজস্ব উত্তরের সঠিকতা বিচার করতে আরও ভাল।

সমাধান ওভারভিউ

বৃহৎ ভাষার মডেলের সূত্রপাতের সাথে, ক্ষেত্রটি বিভিন্ন প্রাকৃতিক ভাষা প্রক্রিয়াকরণ (NLP) বেঞ্চমার্কে অসাধারণ অগ্রগতি দেখেছে। তাদের মধ্যে, মাল্টি-হপ প্রশ্নের উত্তরের মতো যুক্তির প্রয়োজন হয় এমন কঠিন কাজের তুলনায় তুলনামূলকভাবে সহজ কাজগুলি যেমন সংক্ষিপ্ত প্রসঙ্গ বা বাস্তবভিত্তিক প্রশ্নের উত্তরের ক্ষেত্রে অগ্রগতি উল্লেখযোগ্য। এলএলএম ব্যবহার করে কিছু কাজের পারফরম্যান্স ছোট স্কেলে এলোমেলো অনুমানের মতো হতে পারে, তবে বড় স্কেলে উল্লেখযোগ্যভাবে উন্নতি করে। তা সত্ত্বেও, এলএলএম-এর প্রম্পটিং ক্ষমতাগুলি প্রশ্নের উত্তর দেওয়ার জন্য প্রয়োজনীয় কিছু প্রাসঙ্গিক তথ্য সরবরাহ করার ক্ষমতা রাখে।

যাইহোক, এই মডেলগুলি নির্ভরযোগ্যভাবে সঠিক যুক্তি চেইন বা ব্যাখ্যা তৈরি করতে পারে না। সেই আত্মবিশ্বাসী কিন্তু অযৌক্তিক ব্যাখ্যাগুলি আরও বেশি প্রচলিত যখন এলএলএমগুলিকে রিইনফোর্সমেন্ট লার্নিং ফ্রম হিউম্যান ফিডব্যাক (RLHF) ব্যবহার করে প্রশিক্ষণ দেওয়া হয়, যেখানে পুরস্কার হ্যাকিং হতে পারে।

এর দ্বারা অনুপ্রাণিত হয়ে, আমরা নিম্নলিখিত গবেষণা প্রশ্নটি সমাধান করার চেষ্টা করি: মডেল-উত্পন্ন যুক্তি চেইনের উপর মানুষের প্রতিক্রিয়া থেকে শিখে আমরা কি এলএলএম-এর যুক্তি উন্নত করতে পারি? নিম্নলিখিত চিত্রটি আমাদের পদ্ধতির একটি ওভারভিউ প্রদান করে: আমরা প্রথমে মডেলটিকে মাল্টি-হপ প্রশ্নগুলির জন্য যুক্তির চেইন তৈরি করার জন্য অনুরোধ করি, তারপরে রোগ নির্ণয়ের জন্য এই চেইনে বিভিন্ন মানুষের প্রতিক্রিয়া সংগ্রহ করি এবং সংগৃহীত ডেটা থেকে শেখার জন্য প্রশিক্ষণ অ্যালগরিদম প্রস্তাব করি।

আমরা BigBench থেকে দুটি মাল্টি-হপ রিজনিং ডেটাসেট, স্ট্র্যাটেজিকিউএ এবং স্পোর্টস আন্ডারস্ট্যান্ডিং-এর উপর মানুষের বিভিন্ন প্রতিক্রিয়া সংগ্রহ করি। প্রতিটি প্রশ্ন এবং মডেল-উত্পন্ন যুক্তি শৃঙ্খলের জন্য, আমরা সঠিক যুক্তি শৃঙ্খল সংগ্রহ করি, মডেল-উত্পন্ন যুক্তি শৃঙ্খলে ত্রুটির ধরন এবং প্রদত্ত যুক্তি শৃঙ্খলে কেন সেই ত্রুটিটি উপস্থাপন করা হয়েছে তার একটি বর্ণনা (প্রাকৃতিক ভাষায়)। চূড়ান্ত ডেটাসেটে স্ট্র্যাটেজিকিউএ থেকে 1,565টি নমুনার প্রতিক্রিয়া এবং ক্রীড়া বোঝার জন্য 796টি উদাহরণ রয়েছে।

সংগৃহীত প্রতিক্রিয়া থেকে শিখতে আমরা একাধিক প্রশিক্ষণ অ্যালগরিদম প্রস্তাব করি। প্রথমত, আমরা চেইন-অফ-থট প্রম্পটিং-এ স্ব-সংগতির একটি বৈকল্পিক প্রস্তাব করি যার একটি ওজনযুক্ত বৈকল্পিক বিবেচনা করে যা প্রতিক্রিয়া থেকে শেখা যায়। দ্বিতীয়ত, আমরা পুনরাবৃত্তিমূলক পরিমার্জন প্রস্তাব করি, যেখানে আমরা মডেল-উত্পন্ন যুক্তি শৃঙ্খলটি সঠিক না হওয়া পর্যন্ত পুনরাবৃত্তিমূলকভাবে পরিমার্জন করি। আমরা দুটি ডেটাসেটে পরীক্ষামূলকভাবে প্রদর্শন করি যে প্রস্তাবিত অ্যালগরিদম ব্যবহার করে একটি LLM, যথা Flan-T5 ফাইন-টিউনিং, ইন-কনটেক্সট লার্নিং বেসলাইনের সাথে তুলনামূলকভাবে কাজ করে। আরও গুরুত্বপূর্ণ, আমরা দেখাই যে বেস ফ্লান-টি 5 মডেলের তুলনায় এর নিজস্ব উত্তর সঠিক হলে সূক্ষ্ম-টিউনড মডেলটি বিচার করতে আরও ভাল।

তথ্য সংগ্রহ

এই বিভাগে, আমরা সংগৃহীত প্রতিক্রিয়ার বিশদ বিবরণ এবং ডেটা সংগ্রহের সময় অনুসৃত টীকা প্রোটোকল বর্ণনা করি। আমরা দুটি যুক্তি-ভিত্তিক ডেটাসেটের ভিত্তিতে মডেল প্রজন্মের জন্য প্রতিক্রিয়া সংগ্রহ করেছি: BigBench থেকে StrategyQA এবং স্পোর্টস আন্ডারস্ট্যান্ডিং। আমরা স্পোর্টস আন্ডারস্ট্যান্ডিং ডেটাসেটের উত্তর তৈরি করতে স্ট্র্যাটেজিকিউএ এবং ফ্ল্যান-টি5-এর উত্তর তৈরি করতে GPT-J ব্যবহার করেছি। প্রতিটি ক্ষেত্রে, মডেলটিকে প্রশ্ন, উত্তর এবং ব্যাখ্যা সম্বলিত কে-ইন-প্রেক্ষাপট উদাহরণ সহ প্রম্পট করা হয়েছিল, তারপরে পরীক্ষার প্রশ্ন করা হয়েছিল।

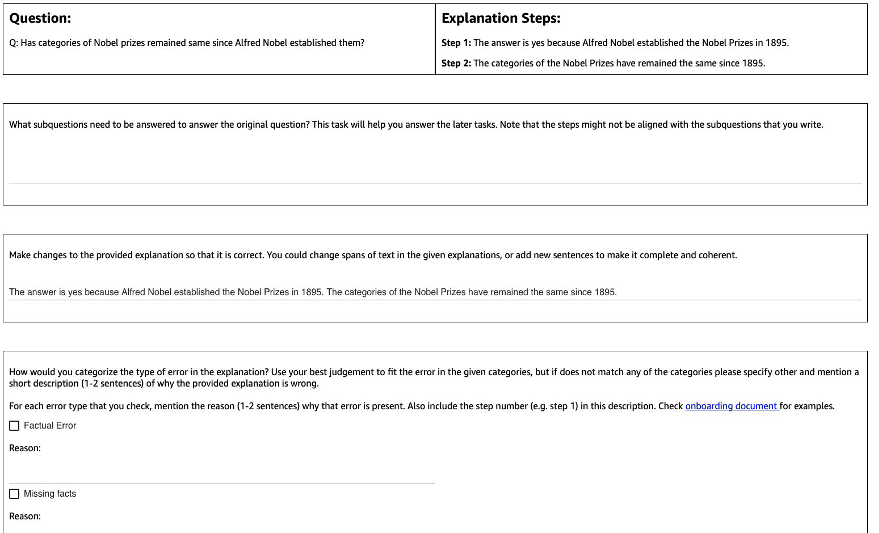

নিচের চিত্রটি আমরা যে ইন্টারফেসটি ব্যবহার করেছি তা দেখায়। টীকাকারদের প্রশ্ন, মডেল-উৎপন্ন উত্তর এবং ব্যাখ্যা ধাপে বিভক্ত করা হয়।

প্রতিটি প্রশ্নের জন্য, আমরা নিম্নলিখিত প্রতিক্রিয়া সংগ্রহ করেছি:

- প্রশ্ন - টীকাকারীরা মূল প্রশ্নের উত্তর দেওয়ার জন্য প্রয়োজনীয় সহজ উপপ্রশ্নগুলিতে মূল প্রশ্নটিকে বিচ্যুত করে। এই টাস্কটি একটি পাইলটের পরে যোগ করা হয়েছিল যেখানে আমরা দেখেছি যে এই টাস্কটি যোগ করা টীকা প্রস্তুত করতে এবং বাকি কাজগুলির গুণমান উন্নত করতে সহায়তা করে৷

- সংশোধন - টীকাকারদের মডেল-উত্পাদিত উত্তর এবং ব্যাখ্যা দিয়ে পূর্বে ভরা একটি ফ্রি-ফর্ম টেক্সট বক্স সরবরাহ করা হয় এবং সঠিক উত্তর এবং ব্যাখ্যা পেতে এটি সম্পাদনা করতে বলা হয়।

- ত্রুটির ধরণ – মডেল জেনারেশনে (ফ্যাকচুয়াল এরর, মিসিং ফ্যাক্টস, অপ্রাসঙ্গিক ফ্যাক্টস এবং লজিক্যাল অসংগতি) পাওয়া সবচেয়ে সাধারণ ধরনের ত্রুটির মধ্যে, টীকাকারদের প্রদত্ত উত্তর এবং ব্যাখ্যার ক্ষেত্রে প্রযোজ্য এক বা একাধিক ত্রুটির ধরন বেছে নিতে বলা হয়েছিল।

- ত্রুটি বর্ণনা - টীকাকারদের শুধুমাত্র ত্রুটিগুলিকে শ্রেণীবদ্ধ করার জন্য নয় বরং তাদের শ্রেণীকরণের জন্য একটি বিস্তৃত ন্যায্যতা দিতে নির্দেশ দেওয়া হয়েছিল, যেখানে ভুলটি ঘটেছে এবং প্রদত্ত উত্তর এবং ব্যাখ্যার ক্ষেত্রে এটি কীভাবে প্রযোজ্য তা চিহ্নিত করা সহ।

আমরা ব্যবহার করেছি আমাজন সেজমেকার গ্রাউন্ড ট্রুথ প্লাস আমাদের তথ্য সংগ্রহে। তথ্য সংগ্রহ একাধিক রাউন্ড জুড়ে সঞ্চালিত হয়েছে. আমরা প্রথমে যথাক্রমে 30টি উদাহরণ এবং 200টি উদাহরণের দুটি ছোট পাইলট পরিচালনা করেছি, তারপরে টীকা দলকে টীকাটির উপর বিস্তারিত প্রতিক্রিয়া দেওয়া হয়েছিল। তারপরে আমরা StrategyQA-এর জন্য দুটি ব্যাচের উপর এবং স্পোর্টস আন্ডারস্ট্যান্ডিং-এর জন্য এক ব্যাচের বেশি ডেটা সংগ্রহ পরিচালনা করেছি, জুড়ে পর্যায়ক্রমিক প্রতিক্রিয়া প্রদান করেছি—মোট 10 টি টীকাকার প্রায় 1 মাস ধরে টাস্কটিতে কাজ করেছে।

আমরা StrategyQA-এর জন্য মোট 1,565টি উদাহরণ এবং খেলাধুলা বোঝার জন্য 796টি উদাহরণের উপর মতামত সংগ্রহ করেছি। নিম্নলিখিত সারণীটি মডেল জেনারেশনে ত্রুটি-মুক্ত উদাহরণগুলির শতাংশ এবং একটি নির্দিষ্ট ত্রুটির ধরন ধারণ করে এমন উদাহরণগুলির অনুপাতকে চিত্রিত করে৷ এটি লক্ষণীয় যে কিছু উদাহরণে একাধিক ত্রুটির ধরন থাকতে পারে।

| ত্রুটি প্রকার | কৌশল QA | খেলাধুলার বোঝাপড়া |

| না | 17.6% | 31.28% |

| বাস্তবগত ত্রুটি | 27.6% | 38.1% |

| মিসিং ফ্যাক্টস | 50.4% | 46.1% |

| অপ্রাসঙ্গিক তথ্য | 14.6% | 3.9% |

| যৌক্তিক অসঙ্গতি | 11.2% | 5.2% |

অ্যালগরিদম শেখা

প্রতিটি প্রশ্নের জন্য q, এবং মডেল-উৎপন্ন উত্তর এবং ব্যাখ্যা m, আমরা নিম্নলিখিত প্রতিক্রিয়া সংগ্রহ করেছি: সঠিক উত্তর এবং ব্যাখ্যা c, এর মধ্যে উপস্থিত ত্রুটির ধরন m (দ্বারা প্রকাশ t), এবং ত্রুটি বিবরণ d, পূর্ববর্তী বিভাগে বর্ণিত হিসাবে।

আমরা নিম্নলিখিত পদ্ধতি ব্যবহার করেছি:

- মাল্টিটাস্ক লার্নিং - উপলব্ধ বিভিন্ন প্রতিক্রিয়া থেকে শেখার জন্য একটি সহজ বেসলাইন হল তাদের প্রতিটিকে একটি পৃথক কাজ হিসাবে বিবেচনা করা। আরও দৃঢ়ভাবে, আমরা উদ্দেশ্যের সাথে Flan-T5 (টেক্সট টু টেক্সট) টিউন করি চরমে তোলা p(c|q) + p(t|q, m) + p(d|q, m). উদ্দেশ্যের প্রতিটি পদের জন্য, আমরা টাস্কের জন্য উপযুক্ত একটি পৃথক নির্দেশ ব্যবহার করি (উদাহরণস্বরূপ, "প্রদত্ত উত্তরে ত্রুটি ভবিষ্যদ্বাণী করুন")। আমরা শ্রেণীগত পরিবর্তনশীলকেও রূপান্তর করি t একটি স্বাভাবিক ভাষার বাক্যে। অনুমানের সময়, আমরা শব্দটির জন্য নির্দেশ ব্যবহার করি p(c|q) ("প্রদত্ত প্রশ্নের সঠিক উত্তরের ভবিষ্যদ্বাণী করুন") পরীক্ষার প্রশ্নের উত্তর তৈরি করতে।

- ওজনযুক্ত স্ব-সংগতি - চেইন-অফ-থট প্রম্পটিং-এ স্ব-সংগতির সাফল্যের দ্বারা অনুপ্রাণিত হয়ে, আমরা এটির একটি ওজনযুক্ত বৈকল্পিক প্রস্তাব করি। মডেল থেকে প্রতিটি নমুনাযুক্ত ব্যাখ্যাকে সঠিক হিসাবে বিবেচনা করার পরিবর্তে এবং সমষ্টিগত ভোট বিবেচনা করার পরিবর্তে, আমরা প্রথমে ব্যাখ্যাটি সঠিক কিনা তা বিবেচনা করি এবং তারপরে সেই অনুযায়ী একত্রিত করি। আমরা মাল্টিটাস্ক শেখার মতো একই উদ্দেশ্য নিয়ে প্রথমে Flan-T5 টিউন করি। অনুমান করার সময়, একটি পরীক্ষার প্রশ্ন দেওয়া হয়েছে q, আমরা নির্দেশ সহ একাধিক সম্ভাব্য উত্তর নমুনা করি p(c|q)): a1, a2, .., an. প্রতিটি নমুনা উত্তরের জন্য ai, আমরা শব্দের জন্য নির্দেশ ব্যবহার করি p(t|q, m) ("প্রদত্ত উত্তরে ত্রুটি ভবিষ্যদ্বাণী করুন") এটিতে ত্রুটি রয়েছে কিনা তা সনাক্ত করতে ti = argmax p(t|q, a_i). প্রতিটি উত্তর ai এটি সঠিক হলে 1 এর ওজন নির্ধারণ করা হয়, অন্যথায় এটি 1 (টিউনযোগ্য হাইপারপ্যারামিটার) এর চেয়ে ছোট একটি ওজন নির্ধারণ করা হয়। সমস্ত উত্তরের উপর ওজনযুক্ত ভোট বিবেচনা করে চূড়ান্ত উত্তর পাওয়া যায় a1 থেকে an.

- পুনরাবৃত্তিমূলক পরিমার্জন - পূর্ববর্তী প্রস্তাবিত পদ্ধতিতে, মডেল সরাসরি সঠিক উত্তর তৈরি করে c প্রশ্নে শর্তযুক্ত q. এখানে আমরা মডেল-উত্পন্ন উত্তর পরিমার্জন করার প্রস্তাব করি m একটি প্রদত্ত প্রশ্নের সঠিক উত্তর পেতে। আরও বিশেষভাবে, আমরা প্রথমে Flan-T5 (টেক্সট টু টেক্সট উইথ উদ্দেশ্য) এর সাথে ফাইন-টিউন করি p(t; c|q, m) সর্বাধিক করুন, কোথায় ; সংযোজন বোঝায় (ত্রুটির প্রকার t সঠিক উত্তর দ্বারা অনুসরণ c) এই উদ্দেশ্যটি দেখার একটি উপায় হল মডেলটিকে প্রথমে প্রদত্ত প্রজন্মের ত্রুটি সনাক্ত করতে প্রশিক্ষিত করা হয় m, এবং তারপর সঠিক উত্তর পেতে সেই ত্রুটিটি দূর করতে c. অনুমান করার সময়, আমরা মডেলটিকে পুনরাবৃত্তিমূলকভাবে ব্যবহার করতে পারি যতক্ষণ না এটি সঠিক উত্তর তৈরি করে - একটি পরীক্ষার প্রশ্ন দেওয়া হয় q, আমরা প্রথম প্রাথমিক মডেল প্রজন্ম প্রাপ্ত m (প্রাক-প্রশিক্ষিত Flan-T5 ব্যবহার করে)। তারপরে আমরা পুনরাবৃত্তিমূলকভাবে ত্রুটির ধরন তৈরি করি ti এবং সম্ভাব্য সঠিক উত্তর ci পর্যন্ত ti = কোন ত্রুটি নেই (অভ্যাসগতভাবে, আমরা একটি হাইপারপ্যারামিটারে সর্বাধিক সংখ্যক পুনরাবৃত্তি সেট করি), এই ক্ষেত্রে চূড়ান্ত সঠিক উত্তর হবে CI-1 (থেকে প্রাপ্ত p(ti ; ci | q, ci-1)).

ফলাফল

উভয় ডেটাসেটের জন্য, আমরা ইন-কনটেক্সট লার্নিং বেসলাইনের সাথে সমস্ত প্রস্তাবিত লার্নিং অ্যালগরিদম তুলনা করি। সমস্ত মডেল স্ট্র্যাটেজিকিউএ এবং স্পোর্টস আন্ডারস্ট্যান্ডিং-এর ডেভ সেটে মূল্যায়ন করা হয়। নিম্নলিখিত টেবিল ফলাফল দেখায়.

| পদ্ধতি | কৌশল QA | খেলাধুলার বোঝাপড়া |

| Flan-T5 4-শট চেইন-অফ-থট ইন-কনটেক্সট লার্নিং | 67.39±2.6% | 58.5% |

| মাল্টিটাস্ক লার্নিং | 66.22±0.7% | 54.3±2.1% |

| ওজনযুক্ত স্ব সামঞ্জস্য | 61.13±1.5% | 51.3±1.9% |

| পুনরাবৃত্তিমূলক পরিমার্জন | 61.85±3.3% | 57.0±2.5% |

যেমন পর্যবেক্ষণ করা হয়েছে, কিছু পদ্ধতি ইন-কনটেক্সট লার্নিং বেসলাইনের (স্ট্র্যাটেজিকিউএ-এর জন্য মাল্টিটাস্ক, এবং স্পোর্টস বোঝার জন্য পুনরাবৃত্তিমূলক পরিমার্জন) তুলনীয় কাজ করে, যা মডেল আউটপুটগুলিতে মানুষের কাছ থেকে চলমান প্রতিক্রিয়া সংগ্রহ করার এবং ভাষার মডেলগুলিকে উন্নত করার জন্য ব্যবহার করার সম্ভাবনা প্রদর্শন করে। এটি RLHF-এর মতো সাম্প্রতিক কাজ থেকে আলাদা, যেখানে প্রতিক্রিয়া সীমাবদ্ধ এবং সাধারণত বাইনারি।

নিম্নোক্ত সারণীতে দেখানো হয়েছে, আমরা অনুসন্ধান করি যে কীভাবে যুক্তির ভুলের বিষয়ে মানুষের প্রতিক্রিয়ার সাথে অভিযোজিত মডেলগুলি ক্রমাঙ্কন বা আত্মবিশ্বাসীভাবে ভুল ব্যাখ্যা সম্পর্কে সচেতনতা উন্নত করতে সাহায্য করতে পারে। মডেলটিকে ভবিষ্যদ্বাণী করার জন্য অনুরোধ করে এটি মূল্যায়ন করা হয় যে এর প্রজন্মে কোনো ত্রুটি রয়েছে কিনা।

| পদ্ধতি | ত্রুটি সংশোধন | কৌশল QA |

| Flan-T5 4-শট চেইন-অফ-থট ইন-কনটেক্সট লার্নিং | না | 30.17% |

| মাল্টিটাস্ক ফাইনটিউনড মডেল | হাঁ | 73.98% |

আরও বিস্তারিতভাবে, আমরা ভাষা মডেলটিকে তার নিজস্ব তৈরি করা উত্তর এবং যুক্তির চেইন (যার জন্য আমরা প্রতিক্রিয়া সংগ্রহ করেছি) সহ প্রম্পট করি এবং তারপর প্রজন্মের ত্রুটির পূর্বাভাস দেওয়ার জন্য এটিকে আবার অনুরোধ করি। আমরা কাজের জন্য উপযুক্ত নির্দেশনা ব্যবহার করি ("উত্তরে ত্রুটি চিহ্নিত করুন")। মডেলটি সঠিকভাবে স্কোর করা হয় যদি এটি প্রজন্মের মধ্যে "কোন ত্রুটি" বা "সঠিক" ভবিষ্যদ্বাণী করে যদি টীকাকাররা উদাহরণটিকে কোনো ত্রুটি নেই বলে লেবেল করে, অথবা যদি এটি প্রজন্মের কোনো ত্রুটির প্রকারের পূর্বাভাস দেয় ("ভুল" বা "সহ" ভুল") যখন টীকাকাররা এটিকে একটি ত্রুটি হিসাবে লেবেল করে। মনে রাখবেন যে আমরা মডেলের ত্রুটির ধরনটি সঠিকভাবে সনাক্ত করার ক্ষমতা মূল্যায়ন করি না, বরং একটি ত্রুটি উপস্থিত থাকলে। স্ট্র্যাটেজিকিউএ ডেভ সেট থেকে 173টি অতিরিক্ত উদাহরণের একটি সেটের উপর মূল্যায়ন করা হয় যা সংগ্রহ করা হয়েছিল, যা ফাইন-টিউনিংয়ের সময় দেখা যায় না। এর মধ্যে চারটি উদাহরণ ভাষা মডেলকে প্রম্পট করার জন্য সংরক্ষিত (পূর্ববর্তী সারণীতে প্রথম সারি)।

নোট করুন যে আমরা 0-শট বেসলাইন ফলাফল দেখাই না কারণ মডেলটি দরকারী প্রতিক্রিয়া তৈরি করতে অক্ষম৷ আমরা লক্ষ্য করি যে যুক্তি শৃঙ্খলে ত্রুটি সংশোধনের জন্য মানুষের প্রতিক্রিয়া ব্যবহার করা মডেলের ভবিষ্যদ্বাণীকে উন্নত করতে পারে যে এটি ভুল করে কিনা, যা ভুল ব্যাখ্যার সচেতনতা বা ক্রমাঙ্কনকে উন্নত করতে পারে।

উপসংহার

এই পোস্টে, আমরা দেখিয়েছি কিভাবে মানুষের ফিডব্যাক ডেটাসেটগুলিকে সূক্ষ্ম-দানাযুক্ত ত্রুটি সংশোধন সহ কিউরেট করা যায়, যা এলএলএম-এর যুক্তির ক্ষমতা উন্নত করার একটি বিকল্প উপায়। পরীক্ষামূলক ফলাফলগুলি প্রমাণ করে যে যুক্তি ত্রুটির বিষয়ে মানুষের প্রতিক্রিয়া চ্যালেঞ্জিং মাল্টি-হপ প্রশ্নগুলিতে কর্মক্ষমতা এবং ক্রমাঙ্কন উন্নত করতে পারে।

আপনি যদি আপনার বৃহৎ ভাষার মডেলগুলি উন্নত করার জন্য মানুষের প্রতিক্রিয়া খুঁজছেন, তাহলে যান অ্যামাজন সেজমেকার ডেটা লেবেলিং এবং গ্রাউন্ড ট্রুথ প্লাস কনসোল।

লেখক সম্পর্কে

এরান লি হিউম্যান-ইন-দ্য-লুপ পরিষেবা, AWS AI, Amazon-এর প্রয়োগকৃত বিজ্ঞান ব্যবস্থাপক৷ তার গবেষণার আগ্রহ হল 3D গভীর শিক্ষা, এবং দৃষ্টি এবং ভাষা উপস্থাপনা শেখা। পূর্বে তিনি আলেক্সা এআই-এর একজন সিনিয়র বিজ্ঞানী, স্কেল এআই-এর মেশিন লার্নিং প্রধান এবং Pony.ai-এর প্রধান বিজ্ঞানী ছিলেন। এর আগে, তিনি Uber ATG-এ উপলব্ধি টিম এবং Uber-এর মেশিন লার্নিং প্ল্যাটফর্ম টিমের সাথে ছিলেন স্বায়ত্তশাসিত ড্রাইভিং, মেশিন লার্নিং সিস্টেম এবং AI-এর কৌশলগত উদ্যোগের জন্য মেশিন লার্নিং নিয়ে কাজ করে। তিনি বেল ল্যাবসে তার কর্মজীবন শুরু করেন এবং কলম্বিয়া বিশ্ববিদ্যালয়ের সহযোগী অধ্যাপক ছিলেন। তিনি ICML'17 এবং ICCV'19-এ টিউটোরিয়াল সহ-শিক্ষা দিয়েছেন এবং NeurIPS, ICML, CVPR, ICCV-এ স্বায়ত্তশাসিত ড্রাইভিং, 3D দৃষ্টি এবং রোবোটিক্স, মেশিন লার্নিং সিস্টেম এবং প্রতিপক্ষের মেশিন লার্নিং এর জন্য মেশিন লার্নিং এর উপর বেশ কয়েকটি কর্মশালার সহ-সংগঠিত করেছেন। তিনি কর্নেল ইউনিভার্সিটিতে কম্পিউটার সায়েন্সে পিএইচডি করেছেন। তিনি একজন ACM ফেলো এবং IEEE ফেলো।

এরান লি হিউম্যান-ইন-দ্য-লুপ পরিষেবা, AWS AI, Amazon-এর প্রয়োগকৃত বিজ্ঞান ব্যবস্থাপক৷ তার গবেষণার আগ্রহ হল 3D গভীর শিক্ষা, এবং দৃষ্টি এবং ভাষা উপস্থাপনা শেখা। পূর্বে তিনি আলেক্সা এআই-এর একজন সিনিয়র বিজ্ঞানী, স্কেল এআই-এর মেশিন লার্নিং প্রধান এবং Pony.ai-এর প্রধান বিজ্ঞানী ছিলেন। এর আগে, তিনি Uber ATG-এ উপলব্ধি টিম এবং Uber-এর মেশিন লার্নিং প্ল্যাটফর্ম টিমের সাথে ছিলেন স্বায়ত্তশাসিত ড্রাইভিং, মেশিন লার্নিং সিস্টেম এবং AI-এর কৌশলগত উদ্যোগের জন্য মেশিন লার্নিং নিয়ে কাজ করে। তিনি বেল ল্যাবসে তার কর্মজীবন শুরু করেন এবং কলম্বিয়া বিশ্ববিদ্যালয়ের সহযোগী অধ্যাপক ছিলেন। তিনি ICML'17 এবং ICCV'19-এ টিউটোরিয়াল সহ-শিক্ষা দিয়েছেন এবং NeurIPS, ICML, CVPR, ICCV-এ স্বায়ত্তশাসিত ড্রাইভিং, 3D দৃষ্টি এবং রোবোটিক্স, মেশিন লার্নিং সিস্টেম এবং প্রতিপক্ষের মেশিন লার্নিং এর জন্য মেশিন লার্নিং এর উপর বেশ কয়েকটি কর্মশালার সহ-সংগঠিত করেছেন। তিনি কর্নেল ইউনিভার্সিটিতে কম্পিউটার সায়েন্সে পিএইচডি করেছেন। তিনি একজন ACM ফেলো এবং IEEE ফেলো।

নীতীশ জোশী AWS AI, Amazon-এ একজন ফলিত বিজ্ঞান ইন্টার্ন ছিলেন। তিনি নিউ ইয়র্ক ইউনিভার্সিটির কোরান্ট ইনস্টিটিউট অফ ম্যাথমেটিকাল সায়েন্সেস-এর কম্পিউটার বিজ্ঞানের একজন পিএইচডি ছাত্র, অধ্যাপক হি হি এর পরামর্শে। তিনি মেশিন লার্নিং এবং ন্যাচারাল ল্যাঙ্গুয়েজ প্রসেসিং নিয়ে কাজ করেন এবং তিনি মেশিন লার্নিং ফর ল্যাঙ্গুয়েজ (ML2) গবেষণা গ্রুপের সাথে যুক্ত ছিলেন। তিনি বিস্তৃতভাবে শক্তিশালী ভাষা বোঝার বিষয়ে আগ্রহী ছিলেন: উভয় মডেল তৈরিতে যা বন্টন পরিবর্তনের জন্য শক্তিশালী (যেমন হিউম্যান-ইন-দ্য-লুপ ডেটা অগমেন্টেশনের মাধ্যমে) এবং মডেলগুলির দৃঢ়তা মূল্যায়ন/পরিমাপ করার আরও ভাল উপায় ডিজাইন করার ক্ষেত্রে। তিনি প্রাসঙ্গিক শিক্ষার সাম্প্রতিক উন্নয়ন এবং এটি কীভাবে কাজ করে তা বোঝার বিষয়েও কৌতূহলী ছিলেন।

নীতীশ জোশী AWS AI, Amazon-এ একজন ফলিত বিজ্ঞান ইন্টার্ন ছিলেন। তিনি নিউ ইয়র্ক ইউনিভার্সিটির কোরান্ট ইনস্টিটিউট অফ ম্যাথমেটিকাল সায়েন্সেস-এর কম্পিউটার বিজ্ঞানের একজন পিএইচডি ছাত্র, অধ্যাপক হি হি এর পরামর্শে। তিনি মেশিন লার্নিং এবং ন্যাচারাল ল্যাঙ্গুয়েজ প্রসেসিং নিয়ে কাজ করেন এবং তিনি মেশিন লার্নিং ফর ল্যাঙ্গুয়েজ (ML2) গবেষণা গ্রুপের সাথে যুক্ত ছিলেন। তিনি বিস্তৃতভাবে শক্তিশালী ভাষা বোঝার বিষয়ে আগ্রহী ছিলেন: উভয় মডেল তৈরিতে যা বন্টন পরিবর্তনের জন্য শক্তিশালী (যেমন হিউম্যান-ইন-দ্য-লুপ ডেটা অগমেন্টেশনের মাধ্যমে) এবং মডেলগুলির দৃঢ়তা মূল্যায়ন/পরিমাপ করার আরও ভাল উপায় ডিজাইন করার ক্ষেত্রে। তিনি প্রাসঙ্গিক শিক্ষার সাম্প্রতিক উন্নয়ন এবং এটি কীভাবে কাজ করে তা বোঝার বিষয়েও কৌতূহলী ছিলেন।

কুমার চেল্লাপিল্লা তিনি আমাজন ওয়েব সার্ভিসেস-এর একজন জেনারেল ম্যানেজার এবং ডিরেক্টর এবং ML/AI পরিষেবা যেমন হিউম্যান-ইন-লুপ সিস্টেম, AI DevOps, Geospatial ML, এবং ADAS/স্বয়ংক্রিয় যানবাহন উন্নয়নে নেতৃত্ব দেন। AWS-এর আগে, কুমার Uber ATG এবং Lyft লেভেল 5-এ ইঞ্জিনিয়ারিং ডিরেক্টর ছিলেন এবং সেল্ফ-ড্রাইভিং ক্ষমতা যেমন উপলব্ধি এবং ম্যাপিং বিকাশের জন্য মেশিন লার্নিং ব্যবহার করে দলগুলির নেতৃত্ব দিয়েছিলেন। তিনি লিঙ্কডইন, টুইটার, বিং এবং মাইক্রোসফ্ট রিসার্চে অনুসন্ধান, সুপারিশ, এবং বিজ্ঞাপন পণ্যগুলি উন্নত করতে মেশিন লার্নিং কৌশল প্রয়োগ করার বিষয়েও কাজ করেছেন।

কুমার চেল্লাপিল্লা তিনি আমাজন ওয়েব সার্ভিসেস-এর একজন জেনারেল ম্যানেজার এবং ডিরেক্টর এবং ML/AI পরিষেবা যেমন হিউম্যান-ইন-লুপ সিস্টেম, AI DevOps, Geospatial ML, এবং ADAS/স্বয়ংক্রিয় যানবাহন উন্নয়নে নেতৃত্ব দেন। AWS-এর আগে, কুমার Uber ATG এবং Lyft লেভেল 5-এ ইঞ্জিনিয়ারিং ডিরেক্টর ছিলেন এবং সেল্ফ-ড্রাইভিং ক্ষমতা যেমন উপলব্ধি এবং ম্যাপিং বিকাশের জন্য মেশিন লার্নিং ব্যবহার করে দলগুলির নেতৃত্ব দিয়েছিলেন। তিনি লিঙ্কডইন, টুইটার, বিং এবং মাইক্রোসফ্ট রিসার্চে অনুসন্ধান, সুপারিশ, এবং বিজ্ঞাপন পণ্যগুলি উন্নত করতে মেশিন লার্নিং কৌশল প্রয়োগ করার বিষয়েও কাজ করেছেন।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- প্লেটোএআইস্ট্রিম। Web3 ডেটা ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- অ্যাড্রিয়েন অ্যাশলির সাথে ভবিষ্যত মিন্টিং। এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- : আছে

- : হয়

- :না

- :কোথায়

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- ক্ষমতার

- ক্ষমতা

- সম্পর্কে

- তদনুসারে

- এসিএম

- যোগ

- যোগ

- অতিরিক্ত

- ঠিকানা

- adversarial

- বিজ্ঞাপন

- সম্বন্ধযুক্ত

- পর

- আবার

- AI

- আলেক্সা

- আলগোরিদিম

- সব

- বরাবর

- এছাড়াও

- বিকল্প

- মর্দানী স্ত্রীলোক

- আমাজন সেজমেকার

- অ্যামাজন ওয়েব সার্ভিসেস

- মধ্যে

- an

- এবং

- উত্তর

- উত্তর

- কোন

- ফলিত

- প্রয়োগ করা

- প্রয়োগ করা হচ্ছে

- অভিগমন

- যথাযথ

- রয়েছি

- AS

- নির্ধারিত

- At

- স্বশাসিত

- সহজলভ্য

- সচেতনতা

- ডেস্কটপ AWS

- ভিত্তি

- ভিত্তি

- বেসলাইন

- BE

- কারণ

- হয়েছে

- আগে

- ঘণ্টা

- benchmarks

- উত্তম

- ঠন্ঠন্

- উভয়

- বক্স

- বিস্তৃতভাবে

- ভবন

- বিল্ডিং মডেল

- কিন্তু

- by

- CAN

- ক্ষমতা

- পেশা

- কেস

- কিছু

- চেন

- চেইন

- চ্যালেঞ্জিং

- নেতা

- শ্রেণীভুক্ত করা

- ঘনিষ্ঠ

- সংগ্রহ করা

- সংগ্রহ

- সংগ্রহ

- COLUMBIA

- সাধারণ

- তুলনীয়

- তুলনা করা

- তুলনা

- ব্যাপক

- কম্পিউটার

- কম্পিউটার বিজ্ঞান

- পরিচালিত

- সুনিশ্চিত

- অসংশয়ে

- বিবেচনা

- বিবেচনা করা

- কনসোল

- ধারণ

- প্রসঙ্গ

- রূপান্তর

- কর্নেল

- সংশোধণী

- সমর্থন করা

- অদ্ভুত

- উপাত্ত

- ডেটাসেট

- গভীর

- গভীর জ্ঞানার্জন

- প্রদর্শন

- প্রমান

- বর্ণনা করা

- বর্ণিত

- বিবরণ

- ফন্দিবাজ

- সত্ত্বেও

- বিস্তারিত

- বিশদ

- বিস্তারিত

- দেব

- বিকাশ

- উন্নয়ন

- উন্নয়ন

- বিভিন্ন

- সরাসরি

- Director

- বিতরণ

- বিচিত্র

- do

- সম্পন্ন

- Dont

- পরিচালনা

- সময়

- e

- প্রতি

- সক্ষম করা

- প্রকৌশল

- ভুল

- ত্রুটি

- প্রতিষ্ঠার

- মূল্যায়ন

- মূল্যায়ন

- মূল্যায়ন

- এমন কি

- উদাহরণ

- উদাহরণ

- ব্যাখ্যা

- প্রতিক্রিয়া

- সহকর্মী

- ক্ষেত্র

- ব্যক্তিত্ব

- চূড়ান্ত

- প্রথম

- অনুসৃত

- অনুসরণ

- জন্য

- ফর্ম

- পাওয়া

- চার

- থেকে

- জমায়েত

- সাধারণ

- উত্পাদন করা

- উত্পন্ন

- উত্পন্ন

- উৎপাদিত

- প্রজন্ম

- প্রজন্ম

- ভূ-স্থানিক এমএল

- দাও

- প্রদত্ত

- দান

- স্থল

- গ্রুপ

- হ্যাকিং

- আছে

- জমিদারি

- he

- মাথা

- সাহায্য

- সাহায্য

- এখানে

- তার

- কিভাবে

- কিভাবে

- যাহোক

- HTTPS দ্বারা

- মানবীয়

- মানুষেরা

- সনাক্ত করা

- আইইইই

- if

- প্রকাশ

- উন্নত করা

- in

- সুদ্ধ

- নিগমবদ্ধ

- প্রারম্ভিক

- উদ্যোগ

- পরিবর্তে

- প্রতিষ্ঠান

- আগ্রহী

- মধ্যে রয়েছে

- ইন্টারফেস

- মধ্যে

- তদন্ত করা

- IT

- পুনরাবৃত্তি

- এর

- JPG

- ল্যাবস

- ভাষা

- বড়

- বৃহত্তর

- বিশালাকার

- শিখতে

- জ্ঞানী

- শিক্ষা

- বরফ

- উচ্চতা

- সীমিত

- লিঙ্কডইন

- LLM

- যৌক্তিক

- খুঁজছি

- Lyft

- মেশিন

- মেশিন লার্নিং

- তৈরি করে

- পরিচালক

- ম্যাপিং

- গাণিতিক

- সর্বাধিক

- মে..

- পদ্ধতি

- মাইক্রোসফট

- অনুপস্থিত

- ভুল

- ভুল

- ML

- ml2

- মডেল

- মডেল

- মাস

- অধিক

- সেতু

- উদ্দেশ্যমূলক

- বহু

- যথা

- প্রাকৃতিক

- স্বাভাবিক ভাষা প্রক্রিয়াকরণ

- নতুন

- নিউ ইয়র্ক

- NLP

- না।

- সংখ্যা

- উদ্দেশ্য

- মান্য করা

- বাধা

- প্রাপ্ত

- প্রাপ্ত

- ঘটেছে

- of

- on

- ONE

- নিরন্তর

- কেবল

- সূত্রপাত

- or

- মূল

- অন্যভাবে

- আমাদের

- বাইরে

- শেষ

- ওভারভিউ

- নিজের

- শতকরা হার

- উপলব্ধি

- সম্পাদন করা

- কর্মক্ষমতা

- সঞ্চালিত

- কাল

- পর্যাবৃত্ত

- বাছাই

- চালক

- জায়গা

- মাচা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- যোগ

- ভঙ্গি

- সম্ভব

- পোস্ট

- সম্ভাব্য

- অনুশীলন

- ভবিষ্যদ্বাণী করা

- ভবিষ্যদ্বাণী

- প্রেডিক্টস

- প্রস্তুত করা

- বর্তমান

- উপস্থাপন

- প্রভাবশালী

- আগে

- পূর্বে

- পূর্বে

- প্রক্রিয়াজাতকরণ

- পণ্য

- অধ্যাপক

- উন্নতি

- অনুপাত

- উত্থাপন করা

- প্রস্তাবিত

- প্রোটোকল

- প্রদান

- প্রদত্ত

- উপলব্ধ

- গুণ

- প্রশ্ন

- প্রশ্ন

- এলোমেলো

- বরং

- সাম্প্রতিক

- সুপারিশ

- পরিমার্জন

- অপেক্ষাকৃতভাবে

- প্রাসঙ্গিক

- অপসারণ

- প্রতিনিধিত্ব

- প্রয়োজন

- প্রয়োজনীয়

- গবেষণা

- সংরক্ষিত

- যথাক্রমে

- বিশ্রাম

- ফল

- ফলাফল

- পুরষ্কার

- ধনী

- রোবোটিক্স

- শক্তসমর্থ

- বলিষ্ঠতা

- চক্রের

- সারিটি

- ঋষি নির্মাতা

- একই

- স্কেল

- স্কেল ai

- দাঁড়িপাল্লা

- বিজ্ঞান

- বিজ্ঞান

- বিজ্ঞানী

- সার্চ

- দ্বিতীয়

- অধ্যায়

- দেখা

- আত্ম

- স্বচালিত

- জ্যেষ্ঠ

- বাক্য

- আলাদা

- সেবা

- সেট

- বিভিন্ন

- শিফট

- সংক্ষিপ্ত

- প্রদর্শনী

- প্রদর্শিত

- শো

- গুরুত্বপূর্ণ

- উল্লেখযোগ্যভাবে

- অনুরূপ

- সহজ

- ছোট

- ক্ষুদ্রতর

- কিছু

- নির্দিষ্ট

- বিশেষভাবে

- বিভক্ত করা

- বিজ্ঞাপন

- শুরু

- ধাপ

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- কৌশলগত

- ছাত্র

- সাফল্য

- এমন

- সিস্টেম

- টেবিল

- কার্য

- কাজ

- টীম

- দল

- প্রযুক্তি

- পরীক্ষা

- চেয়ে

- যে

- সার্জারির

- তাদের

- তাহাদিগকে

- তারপর

- এইগুলো

- তারা

- এই

- সেগুলো

- দ্বারা

- থেকে

- মোট

- প্রশিক্ষিত

- প্রশিক্ষণ

- আচরণ করা

- চিকিত্সা

- অসাধারণ

- আস্থা

- সত্য

- টিউটোরিয়াল

- টুইটার

- দুই

- আদর্শ

- ধরনের

- উবার

- বোধশক্তি

- বিশ্ববিদ্যালয়

- ব্যবহার

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহার

- সাধারণত

- বৈকল্পিক

- বিভিন্ন

- বাহন

- চেক

- দৃষ্টি

- দেখুন

- ভোট

- ছিল

- উপায়..

- উপায়

- we

- ওয়েব

- ওয়েব সার্ভিস

- ওজন

- ছিল

- কখন

- কিনা

- যে

- কেন

- ইচ্ছা

- সঙ্গে

- হয়া যাই ?

- কাজ করছে

- কাজ

- কাজ

- কর্মশালা

- মূল্য

- ভুল

- ইয়র্ক

- আপনার

- zephyrnet