I dag Amazon SageMaker annoncerede støtte fra Grid search for automatisk model tuning, som giver brugerne en ekstra strategi til at finde den bedste hyperparameterkonfiguration til din model.

Amazon SageMaker automatisk modeltuning finder den bedste version af en model ved at køre mange træningsjob på dit datasæt ved hjælp af en rækkevidde af hyperparametre, som du angiver. Derefter vælger den de hyperparameterværdier, der resulterer i en model, der yder bedst, målt med a metrisk efter eget valg.

For at finde de bedste hyperparameterværdier for din model, understøtter Amazon SageMaker automatisk modeljustering flere strategier, bl.a. Bayesiansk (Standard) Tilfældig søgning og Hyperbånd.

Netsøgning

Grid-søgning udforsker udtømmende konfigurationerne i gitteret af hyperparametre, som du definerer, hvilket giver dig mulighed for at få indsigt i de mest lovende hyperparameterkonfigurationer i dit gitter og deterministisk gengive dine resultater på tværs af forskellige tuning-kørsler. Gittersøgning giver dig mere tillid til, at hele hyperparametersøgeområdet blev udforsket. Denne fordel kommer med en afvejning, fordi den er beregningsmæssigt dyrere end Bayesiansk og tilfældig søgning, hvis dit hovedmål er at finde den bedste hyperparameterkonfiguration.

Gittersøgning med Amazon SageMaker

I Amazon SageMaker bruger du Grid-søgning, når dit problem kræver, at du har den optimale hyperparameterkombination, der maksimerer eller minimerer din objektive metrik. Et almindeligt tilfælde, hvor kunden bruger Grid Search, er, når modellens nøjagtighed og reproducerbarhed er vigtigere for din virksomhed end uddannelsesomkostningerne, der kræves for at opnå den.

For at aktivere Grid Search i Amazon SageMaker skal du indstille Strategy felt til Grid når du opretter et tuningjob, som følger:

Derudover kræver Grid-søgning, at du definerer dit søgeområde (kartesisk gitter) som et kategorisk område af diskrete værdier i din jobdefinition ved hjælp af CategoricalParameterRanges nøglen under ParameterRanges parameter, som følger:

Bemærk, at vi ikke specificerer MaxNumberOfTrainingJobs for gittersøgning i jobdefinitionen, fordi dette bestemmes for dig ud fra antallet af kategorikombinationer. Når du bruger tilfældig og Bayesiansk søgning, angiver du MaxNumberOfTrainingJobs parameter som en måde at styre tuning jobomkostninger ved at definere en øvre grænse for beregning. Med Grid-søgning er værdien af MaxNumberOfTrainingJobs (nu valgfrit) indstilles automatisk som antallet af kandidater til gittersøgningen i Beskriv HyperParameterTuningJob form. Dette giver dig mulighed for at udforske dit ønskede gitter af hyperparametre udtømmende. Derudover accepterer Grid Search jobdefinition kun diskrete kategoriske intervaller og kræver ikke en kontinuert eller heltals intervalldefinition, fordi hver værdi i gitteret betragtes som diskret.

Grid Search-eksperiment

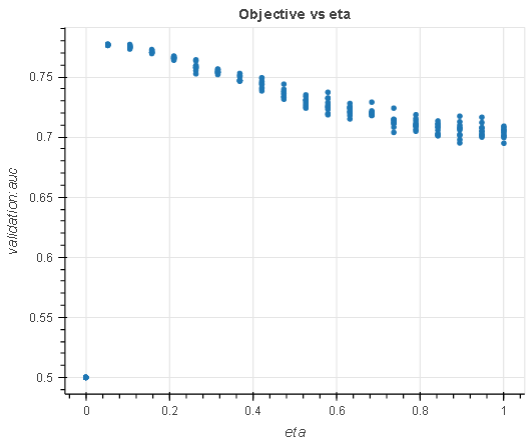

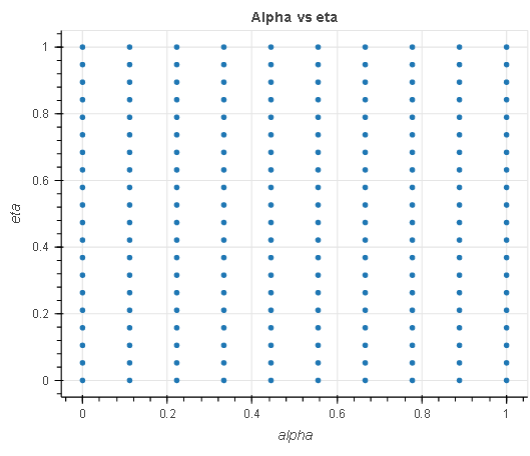

I dette eksperiment, givet en regressionsopgave, søger vi efter de optimale hyperparametre inden for et søgerum på 200 hyperparametre, 20 eta og 10 alpha spænder fra 0.1 til 1. Vi bruger direkte marketing datasæt at tune en regressionsmodel.

- eta: Trinstørrelseskrympning brugt i opdateringer for at forhindre overpasning. Efter hvert boostningstrin kan du direkte få vægten af nye funktioner. Det

etaparameter formindsker faktisk funktionsvægtene for at gøre boostingsprocessen mere konservativ. - alpha: L1 regulariseringsterm på vægte. At øge denne værdi gør modellerne mere konservative.

|

|

Diagrammet til venstre viser en analyse af eta hyperparameter i forhold til den objektive metrik og demonstrerer, hvordan gittersøgning har opbrugt hele søgerummet (gitteret) i X-akserne, før den bedste model returneres. Ligeledes analyserer diagrammet til højre de to hyperparametre i et enkelt kartesisk rum for at demonstrere, at alle punkter i gitteret blev valgt under tuning.

Eksperimentet ovenfor viser, at den udtømmende karakter af Grid-søgning garanterer et optimalt hyperparametervalg givet det definerede søgerum. Det viser også, at du kan gengive dit søgeresultat på tværs af tuning iterationer, alt andet lige.

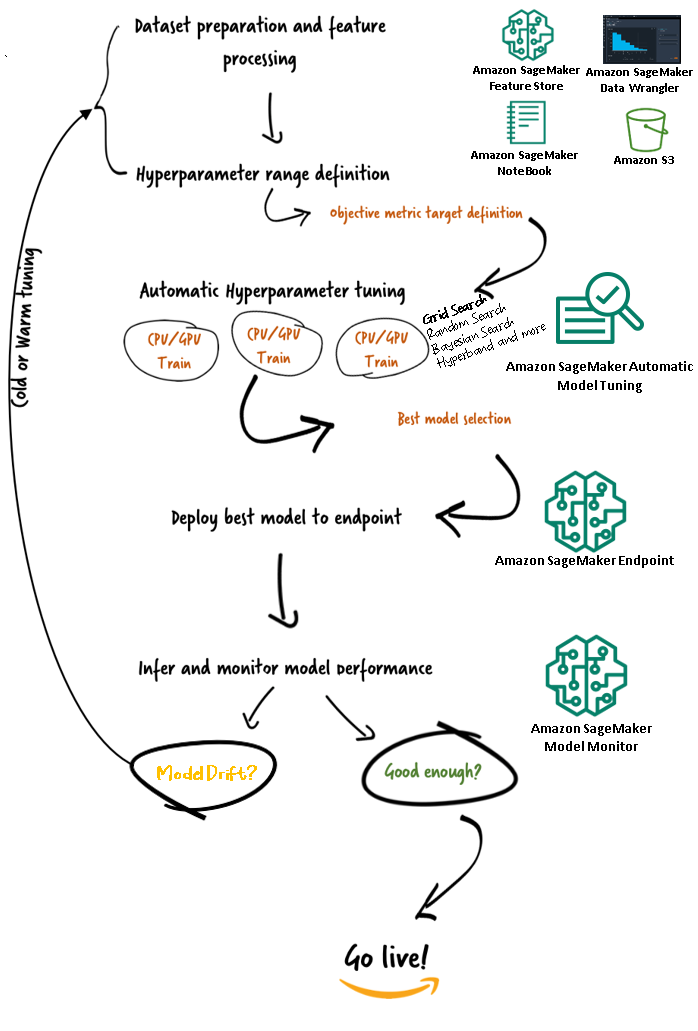

Amazon SageMaker Automatic Model Tuning-arbejdsgange (AMT)

Med Amazon SageMaker automatisk modeljustering kan du finde den bedste version af din model ved at køre træningsjob på dit datasæt med flere søgestrategier, såsom Bayesian, Random Search, Grid Search og Hyperband. Automatisk modeljustering giver dig mulighed for at reducere tiden til at tune en model ved automatisk at søge efter den bedste hyperparameterkonfiguration inden for de hyperparameterområder, du angiver.

Nu hvor vi har gennemgået fordelen ved at bruge Grid-søgning i Amazon SageMaker AMT, lad os tage et kig på AMTs arbejdsgange og forstå, hvordan det hele hænger sammen i SageMaker.

Konklusion

I dette indlæg diskuterede vi, hvordan du nu kan bruge Grid-søgestrategien til at finde den bedste model og dens evne til deterministisk at reproducere resultater på tværs af forskellige tuning-job. Vi diskuterede afvejningen, når du bruger gittersøgning sammenlignet med andre strategier, og hvordan det giver dig mulighed for at udforske, hvilke områder af hyperparameterrummene, der er mest lovende, og reproducere dine resultater deterministisk.

For at lære mere om automatisk modeljustering, besøg Produkt side , teknisk dokumentation.

Om forfatteren

Doug Mbaya er en Senior Partner Solution arkitekt med fokus på data og analyse. Doug arbejder tæt sammen med AWS-partnere og hjælper dem med at integrere data- og analyseløsninger i skyen.

Doug Mbaya er en Senior Partner Solution arkitekt med fokus på data og analyse. Doug arbejder tæt sammen med AWS-partnere og hjælper dem med at integrere data- og analyseløsninger i skyen.

- Avanceret (300)

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet