I dag er vi glade for at kunne annoncere muligheden for at finjustere Code Llama-modeller ved hjælp af Meta Amazon SageMaker JumpStart. Code Llama-familien af store sprogmodeller (LLM'er) er en samling af fortrænede og finjusterede kodegenereringsmodeller i en skala fra 7 milliarder til 70 milliarder parametre. Finjusterede Code Llama-modeller giver bedre nøjagtighed og forklaring i forhold til de grundlæggende Code Llama-modeller, som det fremgår af deres test mod HumanEval og MBPP-datasæt. Du kan finjustere og implementere Code Llama-modeller med SageMaker JumpStart ved hjælp af Amazon SageMaker Studio UI med et par klik eller ved at bruge SageMaker Python SDK. Finjustering af Llama-modeller er baseret på de scripts, der findes i Lama-opskrifter GitHub repo fra Meta ved hjælp af PyTorch FSDP, PEFT/LoRA og Int8 kvantiseringsteknikker.

I dette indlæg gennemgår vi, hvordan man finjusterer Code Llama præ-trænede modeller via SageMaker JumpStart gennem en et-klik UI og SDK oplevelse tilgængelig i det følgende GitHub repository.

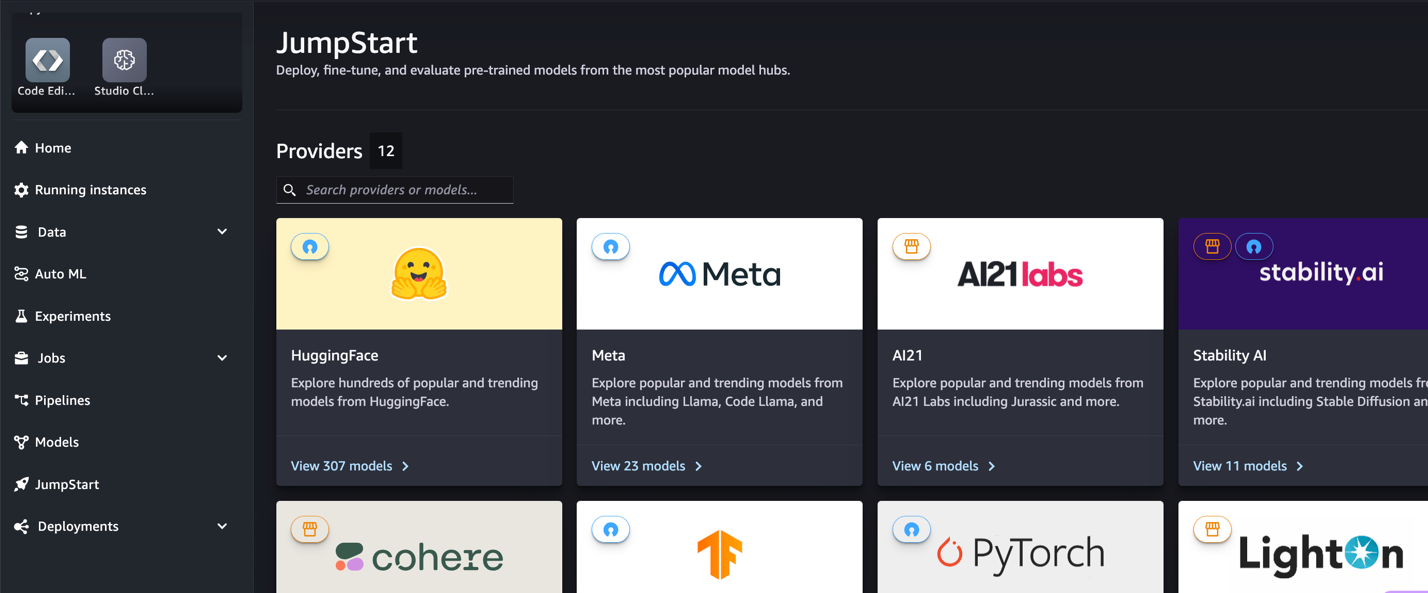

Hvad er SageMaker JumpStart

Med SageMaker JumpStart kan maskinlæringsudøvere (ML) vælge mellem et bredt udvalg af offentligt tilgængelige fundamentmodeller. ML praktikere kan implementere fundamentmodeller til dedikerede Amazon SageMaker forekomster fra et netværksisoleret miljø og tilpasse modeller ved hjælp af SageMaker til modeltræning og implementering.

Hvad er Code Llama

Code Llama er en kode-specialiseret version af Lama 2 der blev skabt ved at videreuddanne Llama 2 i dets kodespecifikke datasæt og prøveudtagning af flere data fra det samme datasæt i længere tid. Code Llama har forbedrede kodningsmuligheder. Det kan generere kode og naturligt sprog om kode fra både kode og naturlige sprogprompter (for eksempel "Skriv mig en funktion, der udsender Fibonacci-sekvensen"). Du kan også bruge det til kodefuldførelse og fejlfinding. Det understøtter mange af de mest populære programmeringssprog, der bruges i dag, inklusive Python, C++, Java, PHP, Typescript (JavaScript), C#, Bash og mere.

Hvorfor finjustere Code Llama-modeller

Meta publicerede Code Llama performance benchmarks på HumanEval og MBPP til almindelige kodningssprog som Python, Java og JavaScript. Ydeevnen af Code Llama Python-modeller på HumanEval demonstrerede varierende ydeevne på tværs af forskellige kodningssprog og opgaver lige fra 38 % på 7B Python-modellen til 57 % på 70B Python-modeller. Derudover har finjusterede Code Llama-modeller på SQL-programmeringssprog vist bedre resultater, som det fremgår af SQL-evalueringsbenchmarks. Disse offentliggjorte benchmarks fremhæver de potentielle fordele ved at finjustere Code Llama-modeller, hvilket muliggør bedre ydeevne, tilpasning og tilpasning til specifikke kodningsdomæner og opgaver.

Kodefri finjustering via SageMaker Studio UI

For at begynde at finjustere dine Llama-modeller ved hjælp af SageMaker Studio, udfør følgende trin:

- Vælg på SageMaker Studio-konsollen Forspring i navigationsruden.

Du vil finde lister over over 350 modeller lige fra open source og proprietære modeller.

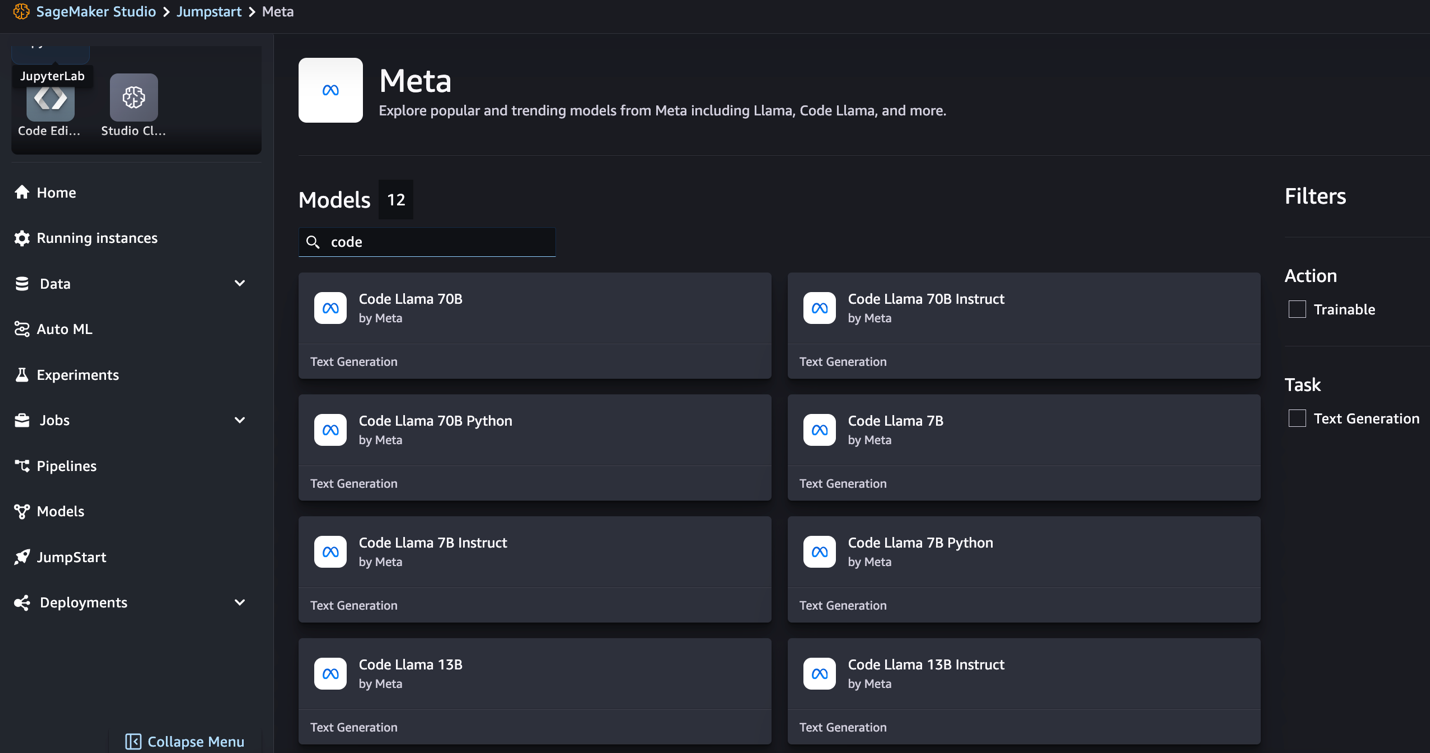

- Søg efter Code Llama-modeller.

Hvis du ikke kan se Code Llama-modeller, kan du opdatere din SageMaker Studio-version ved at lukke ned og genstarte. For mere information om versionsopdateringer, se Luk ned og opdater Studio-apps. Du kan også finde andre modelvarianter ved at vælge Udforsk alle kodegenereringsmodeller eller søger efter Code Llama i søgefeltet.

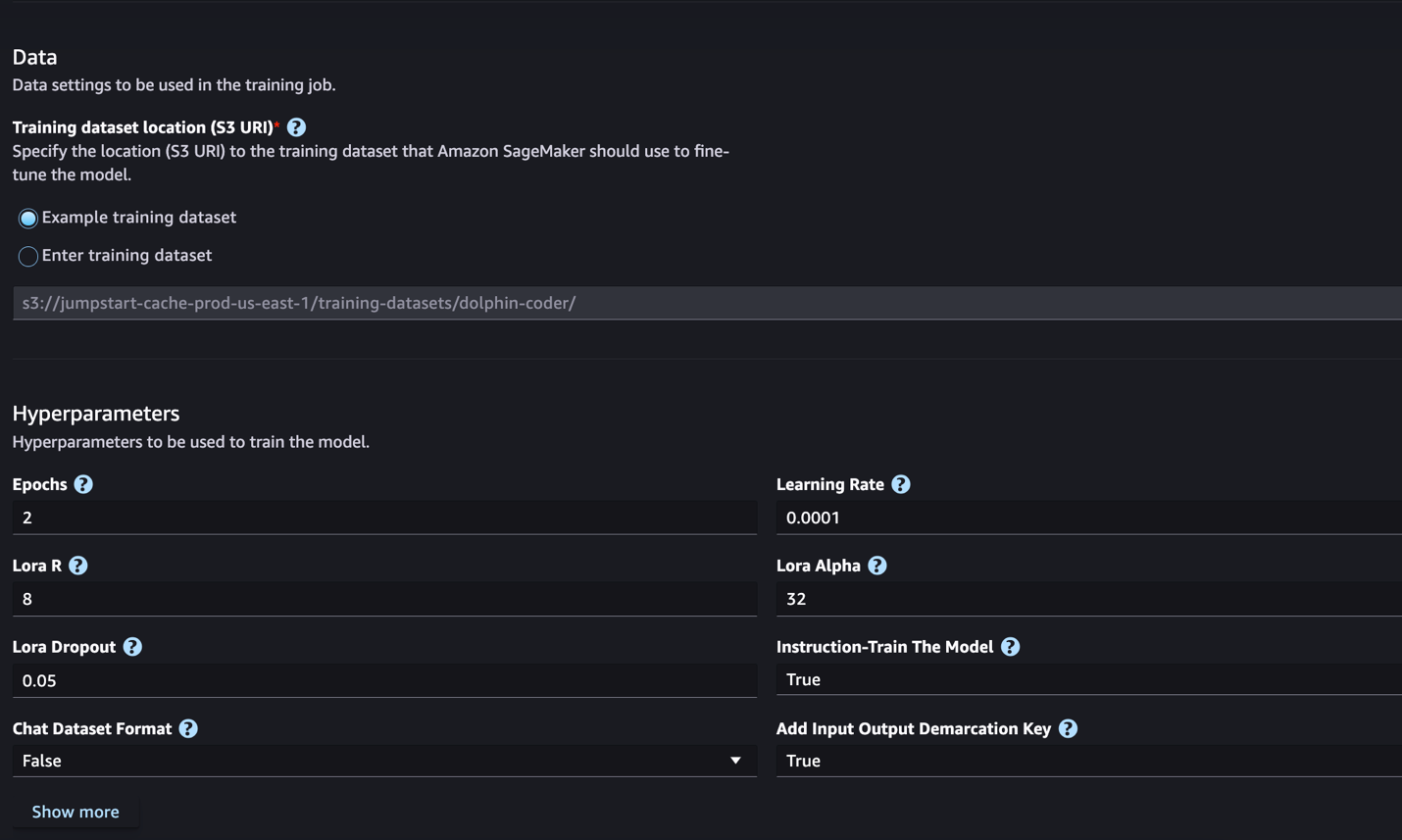

SageMaker JumpStart understøtter i øjeblikket finjustering af instruktion for Code Llama-modeller. Følgende skærmbillede viser finjusteringssiden for Code Llama 2 70B-modellen.

- Til Placering af træningsdatasæt, kan du pege på Amazon Simple Storage Service (Amazon S3) spand, der indeholder trænings- og valideringsdatasæt til finjustering.

- Indstil din implementeringskonfiguration, hyperparametre og sikkerhedsindstillinger til finjustering.

- Vælg Tog for at starte finjusteringsjobbet på en SageMaker ML-instans.

Vi diskuterer det datasætformat, du skal forberede dig til finjustering af instruktion i næste afsnit.

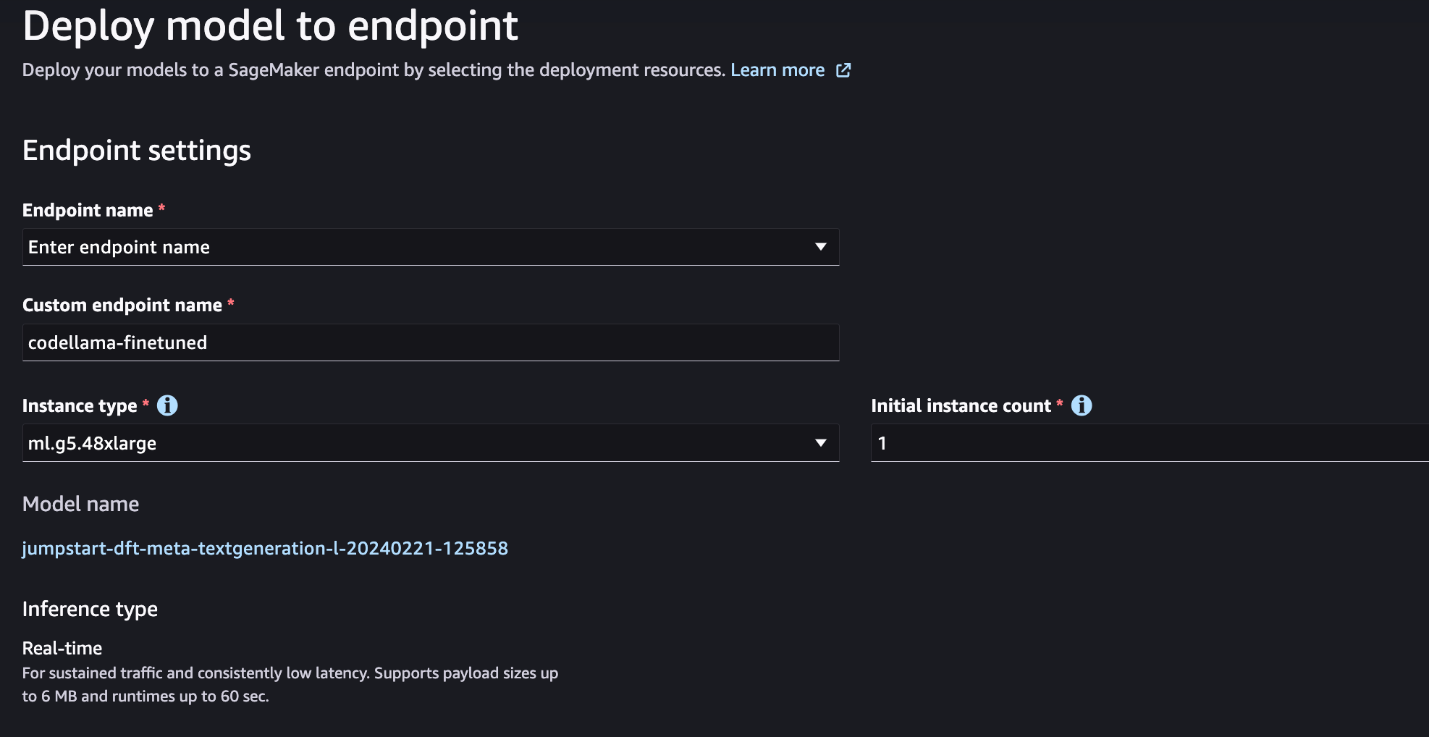

- Efter at modellen er finjusteret, kan du implementere den ved hjælp af modelsiden på SageMaker JumpStart.

Muligheden for at implementere den finjusterede model vises, når finjusteringen er færdig, som vist på det følgende skærmbillede.

Finjuster via SageMaker Python SDK

I dette afsnit demonstrerer vi, hvordan man finjusterer Code LIama-modeller ved hjælp af SageMaker Python SDK på et instruktionsformateret datasæt. Specifikt er modellen finjusteret til et sæt af NLP-opgaver (natural language processing) beskrevet ved hjælp af instruktioner. Dette hjælper med at forbedre modellens ydeevne til usete opgaver med nul-skud-prompter.

Udfør følgende trin for at fuldføre dit finjusteringsjob. Du kan få hele finjusteringskoden fra GitHub repository.

Lad os først se på det datasætformat, der kræves til finjustering af instruktionen. Træningsdataene skal formateres i et JSON-linjeformat (.jsonl), hvor hver linje er en ordbog, der repræsenterer et dataeksempel. Alle træningsdata skal være i en enkelt mappe. Det kan dog gemmes i flere .jsonl-filer. Følgende er et eksempel i JSON-linjeformat:

Træningsmappen kan indeholde en template.json fil, der beskriver input- og outputformaterne. Følgende er en eksempelskabelon:

For at matche skabelonen skal hver prøve i JSON-linjefilerne indeholde system_prompt, questionog response felter. I denne demonstration bruger vi Dolphin Coder datasæt fra Hugging Face.

Når du har forberedt datasættet og uploadet det til S3-bøtten, kan du begynde at finjustere ved hjælp af følgende kode:

Du kan implementere den finjusterede model direkte fra estimatoren, som vist i følgende kode. For detaljer, se notesbogen i GitHub repository.

Finjusteringsteknikker

Sprogmodeller som Llama er mere end 10 GB eller endda 100 GB i størrelse. Finjustering af så store modeller kræver instanser med betydelig høj CUDA-hukommelse. Desuden kan træningen af disse modeller være meget langsom på grund af modellens størrelse. Derfor bruger vi følgende optimeringer til effektiv finjustering:

- Low-Rank Adaptation (LoRA) – Dette er en type parameter effektiv finjustering (PEFT) til effektiv finjustering af store modeller. Med denne metode fryser du hele modellen og tilføjer kun et lille sæt justerbare parametre eller lag i modellen. For eksempel, i stedet for at træne alle 7 milliarder parametre til Llama 2 7B, kan du finjustere mindre end 1 % af parametrene. Dette hjælper med en betydelig reduktion af hukommelseskravet, fordi du kun behøver at gemme gradienter, optimeringstilstande og anden træningsrelateret information for kun 1 % af parametrene. Desuden hjælper dette med at reducere træningstiden såvel som omkostningerne. For flere detaljer om denne metode, se LoRA: Low-Rank Adaptation of Large Language Models.

- Int8 kvantisering – Selv med optimeringer som LoRA er modeller som Llama 70B stadig for store til at træne. For at mindske hukommelsesfodaftrykket under træning, kan du bruge Int8 kvantisering under træning. Kvantisering reducerer typisk præcisionen af datatyper med flydende komma. Selvom dette reducerer den nødvendige hukommelse til at lagre modelvægte, forringer det ydeevnen på grund af tab af information. Int8 kvantisering bruger kun en kvart præcision, men medfører ikke forringelse af ydeevnen, fordi den ikke bare taber bits. Det runder dataene fra den ene type til den anden. For at lære om Int8 kvantisering, se LLM.int8(): 8-bit matrix multiplikation for transformere i skala.

- Fuldt delte data parallelt (FSDP) – Dette er en type data-parallel træningsalgoritme, der sønderdeler modellens parametre på tværs af dataparallelle arbejdere og eventuelt kan overføre en del af træningsberegningen til CPU'erne. Selvom parametrene er fordelt på tværs af forskellige GPU'er, er beregningen af hver mikrobatch lokal for GPU-arbejderen. Det skærer parametre mere ensartet og opnår optimeret ydeevne via kommunikation og beregningsoverlapning under træning.

Følgende tabel opsummerer detaljerne for hver model med forskellige indstillinger.

| Model | Standardindstilling | LORA + FSDP | LORA + Ingen FSDP | Int8 Kvantisering + LORA + Ingen FSDP |

| Kode Llama 2 7B | LORA + FSDP | Ja | Ja | Ja |

| Kode Llama 2 13B | LORA + FSDP | Ja | Ja | Ja |

| Kode Llama 2 34B | INT8 + LORA + INGEN FSDP | Ingen | Ingen | Ja |

| Kode Llama 2 70B | INT8 + LORA + INGEN FSDP | Ingen | Ingen | Ja |

Finjustering af Llama-modeller er baseret på scripts leveret af følgende GitHub repo.

Understøttede hyperparametre til træning

Code Llama 2 finjustering understøtter en række hyperparametre, som hver især kan påvirke hukommelseskravet, træningshastigheden og ydeevnen af den finjusterede model:

- epoke – Antallet af gennemløb, som finjusteringsalgoritmen tager gennem træningsdatasættet. Skal være et heltal større end 1. Standard er 5.

- learning_rate – Den hastighed, hvormed modelvægtene opdateres efter at have gennemgået hver gruppe træningseksempler. Skal være en positiv float større end 0. Standard er 1e-4.

- instruktion_tunet – Om man skal instruktionstræne modellen eller ej. Må være

TrueorFalse. Standard erFalse. - pr_device_train_batch_size – Batchstørrelsen pr. GPU-kerne/CPU til træning. Skal være et positivt heltal. Standard er 4.

- per_device_eval_batch_size – Batchstørrelsen pr. GPU-kerne/CPU til evaluering. Skal være et positivt heltal. Standard er 1.

- max_train_samples – Afkort antallet af træningseksempler til denne værdi til fejlfindingsformål eller hurtigere træning. Værdi -1 betyder at bruge alle træningseksemplerne. Skal være et positivt heltal eller -1. Standard er -1.

- max_val_samples – Afkort antallet af valideringseksempler til denne værdi til fejlfindingsformål eller hurtigere træning. Værdi -1 betyder at bruge alle valideringseksemplerne. Skal være et positivt heltal eller -1. Standard er -1.

- max_input_length – Maksimal samlet inputsekvenslængde efter tokenisering. Sekvenser længere end dette vil blive afkortet. Hvis -1,

max_input_lengther indstillet til minimum 1024 og den maksimale modellængde defineret af tokenizeren. Hvis indstillet til en positiv værdi,max_input_lengther indstillet til minimum af den angivne værdi ogmodel_max_lengthdefineret af tokenizeren. Skal være et positivt heltal eller -1. Standard er -1. - validation_split_ratio – Hvis valideringskanal er

none, skal forholdet mellem togvalideringsopdelingen fra togdata være mellem 0–1. Standard er 0.2. - train_data_split_seed – Hvis valideringsdata ikke er til stede, fikserer dette den tilfældige opdeling af inputtræningsdataene til trænings- og valideringsdata, der bruges af algoritmen. Skal være et heltal. Standard er 0.

- forbehandling_antal_arbejdere – Antallet af processer, der skal bruges til forbehandling. Hvis

None, bruges hovedprocessen til forbehandling. Standard erNone. - lora_r – Lora R. Skal være et positivt heltal. Standard er 8.

- lora_alpha – Lora Alpha. Skal være et positivt heltal. Standard er 32

- lora_frafald – Lora Dropout. skal være en positiv float mellem 0 og 1. Standard er 0.05.

- int8_kvantisering - Hvis

True, modellen er fyldt med 8-bit præcision til træning. Standard for 7B og 13B erFalse. Standard for 70B erTrue. - enable_fsdp – Hvis det er sandt, bruger træning FSDP. Standard for 7B og 13B er True. Standard for 70B er falsk. Noter det

int8_quantizationer ikke understøttet med FSDP.

Når du vælger hyperparametrene, skal du overveje følgende:

- Lokal område

int8_quantization=Truemindsker hukommelsesbehovet og fører til hurtigere træning. - Faldende

per_device_train_batch_size,max_input_lengthreducerer hukommelseskravet og kan derfor køres på mindre instanser. Indstilling af meget lave værdier kan dog øge træningstiden. - Hvis du ikke bruger Int8 kvantisering (

int8_quantization=False), brug FSDP (enable_fsdp=True) for hurtigere og effektiv træning.

Understøttede instanstyper til træning

Følgende tabel opsummerer de understøttede instanstyper til træning af forskellige modeller.

| Model | Standard instanstype | Understøttede instanstyper |

| Kode Llama 2 7B | ml.g5.12xlarge |

ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xlarge |

| Kode Llama 2 13B | ml.g5.12xlarge |

ml.g5.24xlarge, ml.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xlarge |

| Kode Llama 2 70B | ml.g5.48xlarge |

ml.g5.48xlarge ml.p4d.24xlarge |

Når du vælger instanstypen, skal du overveje følgende:

- G5-instanser giver den mest effektive træning blandt de understøttede instanstyper. Derfor, hvis du har G5-instanser til rådighed, bør du bruge dem.

- Træningstiden afhænger i høj grad af mængden af antallet af GPU'er og den tilgængelige CUDA-hukommelse. Derfor er træning på instanser med det samme antal GPU'er (f.eks. ml.g5.2xlarge og ml.g5.4xlarge) nogenlunde det samme. Derfor kan du bruge den billigere instans til træning (ml.g5.2xlarge).

- Når du bruger p3-instanser, vil træningen blive udført med 32-bit præcision, fordi bfloat16 ikke understøttes på disse instanser. Derfor vil træningsjobbet forbruge den dobbelte mængde CUDA-hukommelse, når der trænes på p3-instanser sammenlignet med g5-instanser.

For at lære om omkostningerne ved uddannelse pr. instans, se Amazon EC2 G5-forekomster.

Evaluering

Evaluering er et vigtigt skridt til at vurdere ydeevnen af finjusterede modeller. Vi præsenterer både kvalitative og kvantitative evalueringer for at vise forbedring af finjusterede modeller i forhold til ikke-finjusterede. I kvalitativ evaluering viser vi et eksempelsvar fra både finjusterede og ikke-finjusterede modeller. Ved kvantitativ evaluering bruger vi HumanEval, en testsuite udviklet af OpenAI til at generere Python-kode for at teste evnerne til at producere korrekte og nøjagtige resultater. HumanEval-depotet er under MIT-licens. Vi finjusterede Python-varianter af alle Code LIama-modeller over forskellige størrelser (Code LIama Python 7B, 13B, 34B og 70B på Dolphin Coder datasæt), og præsentere evalueringsresultaterne i de følgende afsnit.

Kvalitativ evaluering

Med din finjusterede model installeret, kan du begynde at bruge slutpunktet til at generere kode. I det følgende eksempel præsenterer vi svar fra både basis- og finjusterede Code LIama 34B Python-varianter på en testprøve i Dolphin Coder datasæt:

Den finjusterede Code Llama-model genererer, udover at levere koden til den foregående forespørgsel, en detaljeret forklaring af tilgangen og en pseudokode.

Kode Llama 34b Python ikke-finjusteret svar:

Kode Llama 34B Python finjusteret respons

Grund sandhed

Interessant nok giver vores finjusterede version af Code Llama 34B Python en dynamisk programmeringsbaseret løsning til den længste palindromiske understreng, som er forskellig fra den løsning, der leveres i grundsandheden fra det valgte testeksempel. Vores finjusterede model begrunder og forklarer den dynamiske programmeringsbaserede løsning i detaljer. På den anden side hallucinerer den ikke-finjusterede model potentielle output lige efter print sætning (vist i venstre celle), fordi outputtet axyzzyx er ikke det længste palindrom i den givne streng. Med hensyn til tidskompleksitet er den dynamiske programmeringsløsning generelt bedre end den oprindelige tilgang. Den dynamiske programmeringsløsning har en tidskompleksitet på O(n^2), hvor n er længden af inputstrengen. Dette er mere effektivt end den oprindelige løsning fra den ikke-finjusterede model, som også havde en kvadratisk tidskompleksitet på O(n^2), men med en mindre optimeret tilgang.

Det her ser lovende ud! Husk, vi har kun finjusteret Code LIama Python-varianten med 10 % af Dolphin Coder datasæt. Der er meget mere at udforske!

På trods af grundige instruktioner i svaret skal vi stadig undersøge rigtigheden af den Python-kode, der er leveret i løsningen. Dernæst bruger vi en evalueringsramme kaldet Menneskelig Eval at køre integrationstest på det genererede svar fra Code LIama for systematisk at undersøge dets kvalitet.

Kvantitativ evaluering med HumanEval

HumanEval er en evalueringssele til evaluering af en LLM's problemløsningsevner på Python-baserede kodningsproblemer, som beskrevet i papiret Evaluering af store sprogmodeller trænet i kode. Specifikt består den af 164 originale Python-baserede programmeringsproblemer, der vurderer en sprogmodels evne til at generere kode baseret på givet information som funktionssignatur, docstring, krop og enhedstest.

For hvert Python-baseret programmeringsspørgsmål sender vi det til en Code LIama-model installeret på et SageMaker-slutpunkt for at få k-svar. Dernæst kører vi hvert af de k-svar på integrationstestene i HumanEval-depotet. Hvis ethvert svar fra de k-svar består integrationstestene, tæller vi, at testtilfældet lykkes; ellers mislykkedes. Derefter gentager vi processen for at beregne forholdet mellem vellykkede sager som den endelige evalueringsscore pass@k. Efter standardpraksis sætter vi k som 1 i vores evaluering, til kun at generere ét svar pr. spørgsmål og teste, om det består integrationstesten.

Følgende er en eksempelkode til brug af HumanEval-depot. Du kan få adgang til datasættet og generere et enkelt svar ved hjælp af et SageMaker-slutpunkt. For detaljer, se notesbogen i GitHub repository.

Følgende tabel viser forbedringerne af de finjusterede Code LIama Python-modeller i forhold til de ikke-finjusterede modeller på tværs af forskellige modelstørrelser. For at sikre korrekthed implementerer vi også de ikke-finjusterede Code LIama-modeller i SageMaker-endepunkter og gennemgår Human Eval-evalueringer. Det bestå@1 tal (den første række i følgende tabel) matcher de rapporterede tal i Code Llama research paper. Inferensparametrene er konsekvent sat som "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

Som vi kan se fra resultaterne, viser alle de finjusterede Code LIama Python-varianter betydelige forbedringer i forhold til de ikke-finjusterede modeller. Især Code LIama Python 70B overgår den ikke-finjusterede model med cirka 12%.

| . | 7B Python | 13B Python | 34B | 34B Python | 70B Python |

| Foruddannet modelydelse (pass@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| Finjusteret modelydelse (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

Nu kan du prøve at finjustere Code LIama-modeller på dit eget datasæt.

Ryd op

Hvis du beslutter, at du ikke længere ønsker at holde SageMaker-slutpunktet kørende, kan du slette det vha AWS SDK til Python (Boto3), AWS kommandolinjegrænseflade (AWS CLI) eller SageMaker-konsol. For mere information, se Slet slutpunkter og ressourcer. Derudover kan du lukke SageMaker Studio-ressourcerne som ikke længere er nødvendige.

Konklusion

I dette indlæg diskuterede vi finjustering af Metas Code Llama 2-modeller ved hjælp af SageMaker JumpStart. Vi viste, at du kan bruge SageMaker JumpStart-konsollen i SageMaker Studio eller SageMaker Python SDK til at finjustere og implementere disse modeller. Vi diskuterede også finjusteringsteknikken, instanstyper og understøttede hyperparametre. Derudover skitserede vi anbefalinger til optimeret træning baseret på forskellige tests, vi gennemførte. Som vi kan se fra disse resultater af finjustering af tre modeller over to datasæt, forbedrer finjustering sammenfatning sammenlignet med ikke-finjusterede modeller. Som et næste trin kan du prøve at finjustere disse modeller på dit eget datasæt ved at bruge koden i GitHub-lageret for at teste og benchmarke resultaterne for dine brugssager.

Om forfatterne

Dr. Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Dr. Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Vishaal Yalamanchali er en Startup Solutions Architect, der arbejder med generativ AI i tidlige stadier, robotteknologi og virksomheder med autonome køretøjer. Vishaal arbejder sammen med sine kunder om at levere banebrydende ML-løsninger og er personligt interesseret i forstærkningslæring, LLM-evaluering og kodegenerering. Før AWS var Vishaal bachelor ved UCI med fokus på bioinformatik og intelligente systemer.

Vishaal Yalamanchali er en Startup Solutions Architect, der arbejder med generativ AI i tidlige stadier, robotteknologi og virksomheder med autonome køretøjer. Vishaal arbejder sammen med sine kunder om at levere banebrydende ML-løsninger og er personligt interesseret i forstærkningslæring, LLM-evaluering og kodegenerering. Før AWS var Vishaal bachelor ved UCI med fokus på bioinformatik og intelligente systemer.

Meenakshisundaram Thandavarayan arbejder for AWS som AI/ML Specialist. Han har en passion for at designe, skabe og fremme menneskecentrerede data- og analyseoplevelser. Meena fokuserer på at udvikle bæredygtige systemer, der leverer målbare, konkurrencemæssige fordele for strategiske kunder af AWS. Meena er en connector og designtænker og stræber efter at drive virksomheder til nye måder at arbejde på gennem innovation, inkubation og demokratisering.

Meenakshisundaram Thandavarayan arbejder for AWS som AI/ML Specialist. Han har en passion for at designe, skabe og fremme menneskecentrerede data- og analyseoplevelser. Meena fokuserer på at udvikle bæredygtige systemer, der leverer målbare, konkurrencemæssige fordele for strategiske kunder af AWS. Meena er en connector og designtænker og stræber efter at drive virksomheder til nye måder at arbejde på gennem innovation, inkubation og demokratisering.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker indbyggede algoritmer og hjælper med at udvikle machine learning algoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker indbyggede algoritmer og hjælper med at udvikle machine learning algoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :har

- :er

- :ikke

- :hvor

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- evner

- evne

- Om

- Acceptere

- adgang

- nøjagtighed

- præcis

- opnår

- tværs

- aktiv

- tilpasning

- tilføje

- Desuden

- Derudover

- justerbar

- fordele

- Efter

- mod

- AI

- algoritme

- algoritmer

- Alle

- Alpha

- allerede

- også

- Skønt

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- blandt

- beløb

- an

- analyse

- analytics

- ,

- Annoncere

- En anden

- besvare

- enhver

- vises

- anvendt

- tilgang

- cirka

- ER

- OMRÅDE

- AS

- vurdere

- At

- autonom

- til rådighed

- AWS

- BAB

- bund

- baseret

- bash

- BE

- fordi

- bliver

- bag

- benchmark

- Benchmarks

- fordele

- Bedre

- mellem

- Big

- Billion

- bits

- krop

- både

- Begge sider

- Boks

- Pause

- bred

- indbygget

- virksomheder

- men

- by

- C + +

- beregne

- kaldet

- CAN

- Kan få

- kapaciteter

- kapacitet

- gennemføres

- tilfælde

- tilfælde

- celle

- lave om

- skiftende

- Kanal

- karakter

- tegn

- chatte

- billigere

- kontrollere

- kontrol

- Kontrol

- Vælg

- vælge

- cli

- klyngedannelse

- coaching

- kode

- koder

- Kodning

- samling

- Fælles

- Kommunikation

- Virksomheder

- sammenlignet

- konkurrencedygtig

- fuldføre

- færdiggørelse

- kompleksitet

- beregning

- konferencer

- Konfiguration

- træk

- Overvej

- konsekvent

- Bestående

- består

- Konsol

- forbruge

- indeholder

- korrigere

- Koste

- tælle

- skabe

- oprettet

- Nuværende

- For øjeblikket

- Kunder

- tilpasning

- tilpasse

- banebrydende

- data

- datasæt

- beslutte

- falde

- falder

- dedikeret

- dyb

- dyb læring

- Standard

- definerede

- levere

- demokratisering

- demonstrere

- demonstreret

- demonstration

- afhænger

- indsætte

- indsat

- implementering

- Afledt

- beskrevet

- beskriver

- Design

- detail

- detaljeret

- detaljer

- udvikle

- udviklet

- udvikling

- forskellige

- cifre

- størrelse

- direkte

- diskutere

- drøftet

- Er ikke

- Domæner

- færdig

- Dont

- fordoble

- ned

- køre

- Drop

- grund

- i løbet af

- dynamisk

- hver

- tidlig stadie

- effektivitet

- effektiv

- enten

- muliggør

- ende

- slutter

- Endpoint

- Engelsk

- forbedret

- sikre

- Hele

- Miljø

- lige

- evaluere

- evaluering

- evalueringer

- Endog

- indlysende

- undersøge

- eksempel

- eksempler

- ophidset

- Udvid

- erfaring

- Oplevelser

- Forklar

- Forklarer

- forklaring

- Ansigtet

- mislykkedes

- falsk

- familie

- hurtigere

- FB

- Funktionalitet

- få

- Fibonacci

- Fields

- File (Felt)

- Filer

- udfylde

- endelige

- Endelig

- Finde

- Fornavn

- fast

- Flyde

- flydende

- Fokus

- fokuserede

- fokuserer

- efter

- Fodspor

- Til

- format

- Foundation

- Framework

- Frys

- fra

- funktion

- yderligere

- Endvidere

- generelt

- generere

- genereret

- genererer

- generation

- generative

- Generativ AI

- få

- GitHub

- given

- giver

- fik

- GPU

- GPU'er

- gradienter

- større

- Ground

- havde

- hånd

- seletøj

- Have

- he

- hjælper

- Høj

- Fremhæv

- hans

- Hvordan

- How To

- Men

- HTML

- http

- HTTPS

- menneskelig

- i

- identisk

- if

- Illinois

- KIMOs Succeshistorier

- importere

- vigtigt

- Forbedre

- forbedringer

- forbedrer

- in

- omfatter

- Herunder

- Forøg

- tilvækst

- INKUBATION

- indeks

- Indeks

- oplysninger

- initial

- Innovation

- indgang

- installere

- instans

- i stedet

- anvisninger

- integration

- Intelligent

- interesseret

- interesser

- ind

- isolerede

- IT

- iteration

- iteration

- ITS

- Java

- JavaScript

- Job

- jpeg

- jpg

- json

- Holde

- holder

- Sprog

- Sprog

- stor

- vid udstrækning

- Efternavn

- lag

- Leads

- LÆR

- læring

- til venstre

- Længde

- mindre

- Licens

- ligesom

- Line (linje)

- linjer

- Listings

- Llama

- LLM

- lokale

- længere

- Se

- leder

- UDSEENDE

- off

- Lot

- Lav

- maskine

- machine learning

- Main

- fastholder

- lave

- mange

- Match

- matchede

- tændstikker

- Matrix

- maksimal

- Kan..

- me

- midler

- Hukommelse

- Meta

- metode

- minimum

- MIT

- ML

- model

- modeller

- mere

- mere effektiv

- mest

- Mest Populære

- flere

- skal

- Som hedder

- Natural

- Natural Language Processing

- Navigation

- Behov

- netværk

- aldrig

- Ny

- næste

- NLP

- ingen

- Bemærk

- notesbog

- nummer

- numre

- of

- on

- ONE

- dem

- kun

- åbent

- open source

- OpenAI

- optimeringer

- optimeret

- Option

- or

- ordrer

- original

- Andet

- Ellers

- vores

- ud

- skitseret

- udkonkurrerer

- output

- udgange

- i løbet af

- egen

- side

- brød

- Papir

- papirer

- Parallel

- parameter

- parametre

- del

- særlig

- gennemløb

- lidenskab

- per

- ydeevne

- Personligt

- phd

- PHP

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- Punkt

- Populær

- positiv

- Indlæg

- potentiale

- praksis

- forud

- Precision

- Forbered

- præsentere

- Forud

- Problem

- problemløsning

- problemer

- behandle

- Processer

- forarbejdning

- producerer

- Programmering

- programmeringssprog

- fremme

- prompter

- proprietære

- give

- forudsat

- giver

- leverer

- offentligt

- offentliggjort

- formål

- Python

- pytorch

- kvadratisk

- kvalitative

- kvalitet

- kvantitativ

- Kvarter

- query

- spørgsmål

- hurtigere

- R

- tilfældig

- spænder

- Sats

- forholdet

- nået

- når

- årsager

- anbefalinger

- reducerer

- reduktion

- henvise

- resterende

- huske

- gentag

- rapporteret

- Repository

- repræsenterer

- påkrævet

- krav

- Kræver

- forskning

- forsker

- svar

- reaktioner

- resultere

- Resultater

- afkast

- afkast

- højre

- robotteknik

- robust

- groft

- runder

- RÆKKE

- Royal

- Kør

- kører

- s

- sagemaker

- samme

- prøve

- gemt

- skalerbar

- Scale

- Videnskabsmand

- score

- scripts

- SDK

- Søg

- søgning

- Sektion

- sektioner

- sikkerhed

- se

- valgt

- valg

- send

- senior

- Sequence

- Series

- Serie A

- Tjenester

- sæt

- sæt

- indstilling

- indstillinger

- brudt

- bør

- Vis

- viste

- vist

- Shows

- lukker ned

- sider

- signatur

- signifikant

- betydeligt

- Simpelt

- ganske enkelt

- enkelt

- Størrelse

- størrelser

- langsom

- lille

- mindre

- So

- Samfund

- løsninger

- Løsninger

- nogle

- Kilde

- specialist

- specifikke

- specifikt

- hastighed

- delt

- standard

- starte

- Starter

- opstart

- Statement

- Stater

- statistiske

- Trin

- Steps

- Stadig

- stopper

- opbevaring

- butik

- Strategisk

- String

- stræber

- Studio

- lykkes

- vellykket

- sådan

- suite

- Understøttet

- Understøtter

- bæredygtig

- Systemer

- bord

- tager

- opgaver

- teknik

- teknikker

- skabelon

- vilkår

- prøve

- Test

- tests

- end

- at

- Området

- Them

- derefter

- Der.

- derfor

- Disse

- tænker

- denne

- grundig

- tre

- Gennem

- tid

- til

- i dag

- tokenization

- også

- I alt

- spor

- Tog

- uddannet

- Kurser

- transformers

- sand

- Sandheden

- prøv

- to

- typen

- typer

- maskinskrift

- typisk

- ui

- under

- enhed

- universitet

- indtil

- Opdatering

- opdateret

- opdateringer

- us

- brug

- anvendte

- bruger

- ved brug af

- gyldig

- validering

- værdi

- Værdier

- Variant

- forskellige

- Varierende

- køretøj

- udgave

- meget

- via

- gå

- ønsker

- var

- måder

- we

- web

- webservices

- GODT

- hvornår

- hvorvidt

- som

- mens

- Hele

- vilje

- med

- uden

- arbejdstager

- arbejdere

- arbejder

- virker

- Du

- Din

- zephyrnet