video Googles største AI-sprogmodel hjælper robotter med at være mere fleksible i at forstå og fortolke menneskelige kommandoer, ifølge webgigantens seneste forskning.

Maskiner reagerer typisk bedst på meget specifikke krav – åbne anmodninger kan nogle gange afvise dem og føre til resultater, som brugerne ikke havde i tankerne. Folk lærer at interagere med robotter på en stiv måde, som at stille spørgsmål på en bestemt måde for at få det ønskede svar.

Googles seneste system, døbt PaLM-SayCan, lover dog at blive smartere. Den fysiske enhed fra Everyday Robots – en startup udvundet af Google X – har kameraer til øjne i hovedet og en arm med en tang stukket bag den lange lige krop, som sidder oven på et sæt hjul.

Du kan se robotten i aktion i videoen herunder:

Spørger robotten noget i stil med "Jeg har lige trænet, kan du få mig en sund snack?" vil skubbe det til at hente et æble. "PaLM-SayCan [er] en fortolkelig og generel tilgang til at udnytte viden fra sprogmodeller, der gør det muligt for en robot at følge tekstinstruktioner på højt niveau for at udføre fysisk funderede opgaver," forskere fra Googles hjerneteam forklarede.

Google introducerede sin største sprogmodel Håndflade i april i år. PaLM blev trænet i data skrabet fra internettet, men i stedet for at udsende åbne tekstsvar, blev systemet tilpasset til at generere en liste med instruktioner, som robotten skulle følge.

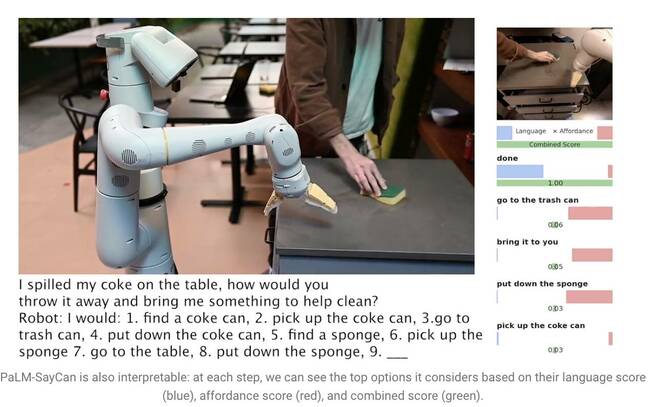

At sige "Jeg spildte min cola på bordet, hvordan ville du smide den væk og bringe mig noget til at hjælpe med at gøre rent?", får PaLM til at forstå spørgsmålet og generere en liste over trin, som robotten kan følge for at fuldføre opgaven, som at gå over at samle dåsen op, smide den i en skraldespand og få en svamp.

Store sprogmodeller (LLM'er) som PaLM forstår dog ikke meningen med noget, de siger. Af denne grund trænede forskerne en separat model ved hjælp af forstærkende læring til at jorde abstrakt sprog til visuelle repræsentationer og handlinger. På den måde lærer robotten at forbinde ordet "cola" med et billede af en sodavandsdåse.

PaLM-SayCan lærer også såkaldte "affordance-funktioner" - en metode, der rangerer muligheden for at gennemføre en specifik handling givne objekter i sit miljø. Robotten er mere tilbøjelig til at opfange en svamp end en støvsuger, for eksempel, hvis den registrerer en svamp, men ikke noget vakuum i nærheden af den.

"Vores metode, SayCan, udvinder og udnytter viden inden for LLM'er i fysisk funderede opgaver," forklarede teamet i en forskningsartikel. "LLM (Say) giver en opgave-grundlag for at bestemme nyttige handlinger for et højt niveau mål, og de lærte affordance-funktioner (Can) giver en verdensomspændende jordforbindelse til at bestemme, hvad der er muligt at udføre på planen. Vi bruger forstærkende læring (RL) som en måde at lære sprogbetingede værdifunktioner, der giver mulighed for, hvad der er muligt i verden."

For at forhindre robotten i at forlade opgaven, er den trænet til kun at vælge handlinger fra 101 forskellige instruktioner. Google trænede den til at tilpasse sig et køkken – PaLM-SayCan kan få snacks, drikkevarer og udføre simple rengøringsopgaver. Forskerne mener, at LLM'er er det første skridt i at få robotter til at udføre mere komplekse opgaver sikkert givet abstrakte instruktioner.

"Vores eksperimenter med en række robotopgaver i den virkelige verden demonstrerer evnen til at planlægge og fuldføre langsigtede, abstrakte, naturlige sproginstruktioner med en høj succesrate. Vi tror på, at PaLM-SayCans fortolkning giver mulighed for sikker brugerinteraktion i den virkelige verden med robotter,” konkluderede de. ®

- AI

- ai kunst

- ai kunst generator

- en robot

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- Registret

- zephyrnet