Vi har trænet og åbner et neuralt net kaldet Whisper, der nærmer sig robusthed og nøjagtighed på menneskeligt niveau i engelsk talegenkendelse.

Vis kode

Se modelkort

Eksempler på hviske:

Whisper er et automatisk talegenkendelsessystem (ASR) trænet på 680,000 timers flersprogede og multitask-overvågede data indsamlet fra nettet. Vi viser, at brugen af et så stort og mangfoldigt datasæt fører til forbedret robusthed over for accenter, baggrundsstøj og teknisk sprog. Desuden muliggør det transskription på flere sprog, samt oversættelse fra disse sprog til engelsk. Vi er open-sourcing-modeller og inferenskode, der skal tjene som grundlag for at bygge nyttige applikationer og for yderligere forskning i robust talebehandling.

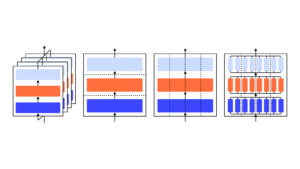

Whisper-arkitekturen er en simpel ende-til-ende-tilgang, implementeret som en encoder-dekoder-transformer. Indgangslyd opdeles i 30 sekunders bidder, konverteres til et log-Mel-spektrogram og sendes derefter til en encoder. En dekoder er trænet til at forudsige den tilsvarende tekstoverskrift, blandet med specielle tokens, der leder den enkelte model til at udføre opgaver såsom sprogidentifikation, tidsstempler på sætningsniveau, flersproget taletransskription og til engelsk taleoversættelse.

Andre eksisterende tilgange bruger ofte mindre, tættere parrede audio-tekst træningsdatasæt, eller brug bred, men uovervåget lydfortræning. Fordi Whisper blev trænet på et stort og forskelligartet datasæt og ikke var finjusteret til nogen specifik, slår det ikke modeller, der specialiserer sig i LibriSpeech-ydeevne, en berømt konkurrencemæssig benchmark inden for talegenkendelse. Men når vi måler Whispers nul-skuds ydeevne på tværs af mange forskellige datasæt, finder vi, at den er meget mere robust og laver 50 % færre fejl end disse modeller.

Omkring en tredjedel af Whispers lyddatasæt er ikke-engelsk, og det får skiftevis til opgave at transskribere på originalsproget eller oversætte til engelsk. Vi finder, at denne tilgang er særlig effektiv til at lære tale til tekst oversættelse og overgår den overvågede SOTA på CoVoST2 til engelsk oversættelse zero-shot.

Vi håber, at Whispers høje nøjagtighed og brugervenlighed vil give udviklere mulighed for at tilføje stemmegrænseflader til et meget bredere sæt applikationer. Tjek ud papir, modelkortog kode for at lære flere detaljer og for at prøve Whisper.

- AI

- ai kunst

- ai kunst generator

- en robot

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- OpenAI

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- forskning

- skala ai

- syntaks

- zephyrnet