At være i stand til at afkode hjernebølger kan hjælpe patienter, der har mistet evnen til at tale, med at kommunikere igen, og det kan i sidste ende give nye måder for mennesker at interagere med computere på. Nu har Meta-forskere vist, at de kan fortælle, hvilke ord nogen er høre ved hjælp af optagelser fra ikke-invasive hjernescanninger.

Vores evne til at sondere menneskelig hjerneaktivitet er forbedret markant i de seneste årtier, da forskere har udviklet en række forskellige hjerne-computer interface (BCI) teknologier, der kan give et vindue ind i vores tanker og hensigter.

De mest imponerende resultater er kommet fra invasive optageenheder, som implanterer elektroder direkte i hjerne gray sagen, kombineret med AI der kan lære at fortolket hjernens signaler. I de senere år har dette madet muligt at afkode hele sætninger fra en persons neurale aktivitet med 97 procent nøjagtighed, og oversættelse forsøgt håndskriftsbevægelser direkte ind i teksten ved sammenlignelige hastighedertil at sms'e.

Men at skulle implantere elektroder i en persons hjerne har åbenlyse ulemper. Disse risikable procedurer er kun medicinsk forsvarlige for patienter, der kræver hjerneregistrering for at hjælpe med at løse andre medicinske problemer, såsom epilepsi. Og neurale prober nedbrydes over tid, hvilket øger udsigten til at skulle udskifte dem regelmæssigt.

Derfor besluttede forskere ved Metas AI-forskningsafdeling at undersøge, om de kunne nå lignende mål uden at kræve farlig hjerneoperationy. I et papir offentliggjort på pre-print serveren arXiv, holdet rapporterede, at de har udviklet et AI-system, der kan forudsige, hvilke ord nogen lytter til baseret på hjerneaktivitet registreret ved hjælp af ikke-invasiv hjerne-computer grænseflader.

"Det er åbenbart ekstremt invasivt at sætte en elektrode inde i en persons hjerne,” Jean Remi King, en forsker ved Facebook Artificial Intelligence Research (FAIR) Lab, fortalt TIME. "Så vi ville prøve at bruge ikke-invasive optagelser af hjerneaktivitet. Og målet var at bygge et AI-system, der kan afkode hjernereaktioner på talte historier."

Forskerne stolede på fire allerede eksisterende datasæt for hjerneaktivitet indsamlet fra 169 mennesker, mens de lyttede til optagelser af mennesker, der talte. Hver frivillig blev optaget ved hjælp af enten magneto-encefalografi (MEG) eller elektroencefalografi (EEG), som bruger forskellige slags sensorer til at opfange hjernens elektriske aktivitet udefra kraniet.

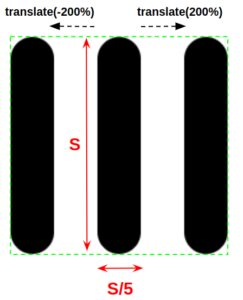

Deres tilgang involvererd opdeling af hjerne- og lyddata i tre-sekundlange uddrag og fodrer det ind i et neuralt netværk, der så ser uded for mønstre, der cOuld forbinde de to. Efter at have trænet AI'en i mange timer med disse data, testede de det på tidligere usete data.

Systemet klarede sig bedst på et af MEG-datasættene, hvor det opnåede en top-10-nøjagtighed på 72.5 procent. Det betyder, at når den rangerede 10 ord med størst sandsynlighed for at være knyttet til hjernebølgesegmentet, var det rigtige ord der 72.5 procent af tiden.

Det lyder måske ikke godt, men det er vigtigt at huske, at det var at vælge fra et potentielt ordforråd på 793 ord. Systemet scorede 67.2 procent på det andet MEG-datasæt, men klarede sig mindre godt på EEG-datasættene og fik top-10 nøjagtigheder på kun 31.4 og 19.1.

Det er klart, at dette stadig er langt fra et praktisk system, men det repræsenterer betydelige fremskridt på et hårdt problem. Ikke-invasive BCI'er har meget dårligere signal-til-støj-forhold, så det er udfordrende at dechifrere neural aktivitet på denne måde, men hvis det lykkes, kan det resultere i en langt mere anvendelig teknologi.

Ikke alle er overbevist om, at det er et problem, der kan løses. Thomas Knopfel fra Imperial College London fortalte New Scientist at forsøge at sondere tanker ved hjælp af disse ikke-invasive tilgange var som "forsøger at streame en HD-film over gammeldags analoge telefonmodemmer,” og stillede spørgsmålstegn ved, om sådanne tilgange nogensinde vil nå praktiske nøjagtighedsniveauer.

Virksomheder som Elon Musks Neuralink satser også på, at vi i sidste ende vil komme over vores sarte i forhold til invasive tilgange, efterhånden som teknologien forbedres, hvilket åbner døren for almindelige mennesker, der får hjerneimplantater.

Men forskningen fra teamet hos Meta er på de meget tidlige stadier, og der er masser af muligheder for forbedringer. Og de kommercielle muligheder for alle, der kan knække ikke-invasiv hjernescanning, vil sandsynligvis give masser af motivation til at prøve.