Introduktion

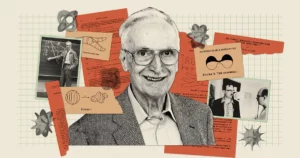

Kunstig intelligens virker mere kraftfuld end nogensinde, med chatbots som Bard og ChatGPT, der er i stand til at producere uhyggelig menneskelignende tekst. Men på trods af alle deres talenter lader disse bots stadig forskere undre sig: Lav sådanne modeller faktisk forstår hvad siger de? "Det er klart, at nogle mennesker tror, de gør," sagde AI-pioneren Geoff Hinton i en nylig samtale med Andrew Ng, "og nogle mennesker tror, at de bare er stokastiske papegøjer."

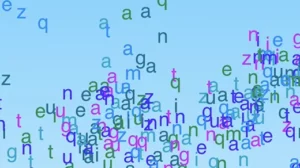

Denne stemningsfulde sætning kommer fra en 2021 papir medforfattet af Emily Bender, en computerlingvist ved University of Washington. Det antyder, at store sprogmodeller (LLM'er) - som danner grundlaget for moderne chatbots - kun genererer tekst ved at kombinere information, de allerede har set "uden nogen henvisning til mening," skrev forfatterne, hvilket gør en LLM til "en stokastisk papegøje."

Disse modeller driver mange af nutidens største og bedste chatbots, så Hinton argumenterede for, at det er tid til at bestemme omfanget af det, de forstår. Spørgsmålet er for ham mere end akademisk. "Så længe vi har disse meningsforskelle," sagde han til Ng, "vil vi ikke være i stand til at nå til enighed om farer."

Ny forskning kan have antydninger af et svar. En teori udviklet af Sanjeev Arora fra Princeton University og Anirudh Goyal, en forsker ved Google DeepMind, antyder, at den største af nutidens LLM'er ikke er stokastiske papegøjer. Forfatterne hævder, at efterhånden som disse modeller bliver større og trænes på flere data, forbedrer de individuelle sprogrelaterede evner og udvikler også nye ved at kombinere færdigheder på en måde, der antyder forståelse - kombinationer, der var usandsynligt at eksistere i træningsdataene .

Denne teoretiske tilgang, som giver et matematisk bevisbart argument for, hvordan og hvorfor en LLM kan udvikle så mange evner, har overbevist eksperter som Hinton og andre. Og da Arora og hans team testede nogle af dens forudsigelser, fandt de ud af, at disse modeller opførte sig næsten nøjagtigt som forventet. Efter alt at dømme har de gjort en stærk argumentation for, at de største LLM'er ikke bare efterlader det, de har set før.

"[De] kan ikke bare efterligne, hvad der er blevet set i træningsdataene," sagde Sébastien Bubeck, en matematiker og datalog hos Microsoft Research, som ikke var en del af arbejdet. "Det er den grundlæggende indsigt."

Mere data, mere kraft

Fremkomsten af uventede og forskelligartede evner i LLM'er, det er rimeligt at sige, kom som en overraskelse. Disse evner er ikke en åbenlys konsekvens af den måde, systemerne er bygget og trænet på. En LLM er et massivt kunstigt neuralt netværk, som forbinder individuelle kunstige neuroner. Disse forbindelser er kendt som modellens parametre, og deres antal angiver LLM'ens størrelse. Træning involverer at give LLM en sætning med det sidste ord skjult, for eksempel "Brændstof koster en arm og en ___." LLM forudsiger en sandsynlighedsfordeling over hele sit ordforråd, så hvis den kender f.eks. tusinde ord, forudsiger den tusinde sandsynligheder. Den vælger derefter det mest sandsynlige ord for at fuldføre sætningen - formentlig "ben".

I første omgang kan LLM vælge ord dårligt. Træningsalgoritmen beregner derefter et tab - afstanden, i et eller andet højdimensionelt matematisk rum, mellem LLM's svar og det faktiske ord i den oprindelige sætning - og bruger dette tab til at justere parametrene. Nu, givet den samme sætning, vil LLM beregne en bedre sandsynlighedsfordeling, og dens tab vil være lidt lavere. Algoritmen gør dette for hver sætning i træningsdataene (muligvis milliarder af sætninger), indtil LLM'ens samlede tab falder til acceptable niveauer. En lignende proces bruges til at teste LLM på sætninger, der ikke var en del af træningsdataene.

En trænet og testet LLM vil, når den præsenteres for en ny tekstprompt, generere det mest sandsynlige næste ord, tilføje det til prompten, generere endnu et næste ord og fortsætte på denne måde, hvilket giver et tilsyneladende sammenhængende svar. Intet i træningsprocessen tyder på, at større LLM'er, bygget ved hjælp af flere parametre og træningsdata, også skal forbedres ved opgaver, der kræver begrundelse at besvare.

Men det gør de. Store nok LLM'er demonstrerer evner - fra at løse elementære matematiske problemer til at besvare spørgsmål om det, der foregår i andres sind - som mindre modeller ikke har, selvom de alle er trænet på lignende måder.

"Hvor kom den [evne] fra?" undrede Arora sig. "Og kan det komme ud af blot forudsigelse af næste ord?"

Forbindelse af færdigheder til tekst

Arora gik sammen med Goyal for at besvare sådanne spørgsmål analytisk. "Vi forsøgte at komme med en teoretisk ramme for at forstå, hvordan fremkomsten sker," sagde Arora.

Duoen vendte sig til matematiske objekter kaldet tilfældige grafer. En graf er en samling af punkter (eller noder) forbundet med linjer (eller kanter), og i en tilfældig graf er tilstedeværelsen af en kant mellem to knudepunkter dikteret tilfældigt - f.eks. af en møntvending. Mønten kan være skæv, så den kommer op med en vis sandsynlighed p. Hvis mønten kommer op ad hoveder for et givet par knudepunkter, dannes en kant mellem disse to knudepunkter; ellers forbliver de uforbundne. Som værdien af p ændringer, kan graferne vise pludselige overgange i deres egenskaber. For eksempel, hvornår p overskrider en vis tærskel, isolerede noder - dem, der ikke er forbundet til nogen anden node - forsvinder brat.

Arora og Goyal indså, at tilfældige grafer, som giver anledning til uventet adfærd, efter at de opfylder visse tærskler, kunne være en måde at modellere adfærden hos LLM'er. Neurale netværk er blevet næsten for komplekse til at analysere, men matematikere har studeret tilfældige grafer i lang tid og har udviklet forskellige værktøjer til at analysere dem. Måske kunne tilfældig grafteori give forskere en måde at forstå og forudsige den tilsyneladende uventede adfærd hos store LLM'er.

Forskerne besluttede at fokusere på "todelte" grafer, som indeholder to typer knudepunkter. I deres model repræsenterer én type node stykker tekst - ikke individuelle ord, men bidder, der kan være et afsnit til et par sider lange. Disse noder er arrangeret i en lige linje. Under dem, i en anden linje, er det andet sæt noder. Disse repræsenterer de færdigheder, der er nødvendige for at give mening i et givet stykke tekst. Hver færdighed kan være næsten hvad som helst. Måske repræsenterer én knude en LLM's evne til at forstå ordet "fordi", som inkorporerer en forestilling om kausalitet; en anden kunne repræsentere at kunne dividere to tal; endnu en anden kan repræsentere evnen til at opdage ironi. "Hvis du forstår, at teksten er ironisk, er der mange ting, der vender," sagde Arora. "Det er relevant for at forudsige ord."

For at være klar, er LLM'er ikke uddannet eller testet med færdigheder i tankerne; de er kun bygget til at forbedre forudsigelse af næste ord. Men Arora og Goyal ønskede at forstå LLM'er ud fra perspektivet af de færdigheder, der kunne være nødvendige for at forstå en enkelt tekst. En forbindelse mellem en færdighedsknude og en tekstknude eller mellem flere færdighedsknudepunkter og en tekstknude betyder, at LLM har brug for disse færdigheder for at forstå teksten i den node. Også flere stykker tekst kan trække fra den samme færdighed eller sæt færdigheder; for eksempel vil et sæt færdighedsnoder, der repræsenterer evnen til at forstå ironi, forbindes med de talrige tekstnoder, hvor ironi forekommer.

Udfordringen nu var at forbinde disse todelte grafer til faktiske LLM'er og se, om graferne kunne afsløre noget om fremkomsten af kraftfulde evner. Men forskerne kunne ikke stole på nogen information om træning eller test af faktiske LLM'er - virksomheder som OpenAI eller DeepMind offentliggør ikke deres trænings- eller testdata. Arora og Goyal ønskede også at forudsige, hvordan LLM'er vil opføre sig, når de bliver endnu større, og der er ingen sådan information tilgængelig for kommende chatbots. Der var dog én afgørende information, som forskerne kunne få adgang til.

Siden 2021 har forskere, der studerer ydeevnen af LLM'er og andre neurale netværk, set et universelt træk dukke op. De bemærkede, at efterhånden som en model bliver større, hvad enten den er i størrelse eller mængden af træningsdata, falder dens tab på testdata (forskellen mellem forudsagte og korrekte svar på nye tekster, efter træning) på en meget specifik måde. Disse observationer er blevet kodificeret til ligninger kaldet de neurale skaleringslove. Så Arora og Goyal designet deres teori til ikke at afhænge af data fra nogen individuel LLM, chatbot eller sæt trænings- og testdata, men på den universelle lov, som disse systemer alle forventes at adlyde: tabet forudsagt af skaleringslove.

Måske, ræsonnerede de, var forbedret ydeevne - som målt ved de neurale skaleringslove - relateret til forbedrede færdigheder. Og disse forbedrede færdigheder kunne defineres i deres todelte grafer ved at forbinde færdighedsnoder til tekstnoder. Etablering af denne forbindelse - mellem neurale skaleringslove og todelte grafer - var nøglen til, at de kunne fortsætte.

Opskalering af færdigheder

Forskerne startede med at antage, at der eksisterer en hypotetisk todelt graf, der svarer til en LLM's adfærd på testdata. For at forklare ændringen i LLM's tab på testdata forestillede de sig en måde at bruge grafen til at beskrive, hvordan LLM opnår færdigheder.

Tag for eksempel evnen "forstår ironi." Denne idé er repræsenteret med en færdighedsknude, så forskerne ser for at se, hvilke tekstnoder denne færdighedsknude forbinder til. Hvis næsten alle disse forbundne tekstknuder er vellykkede - hvilket betyder, at LLM's forudsigelser på teksten repræsenteret af disse knudepunkter er meget nøjagtige - så er LLM kompetent i denne særlige færdighed. Men hvis mere end en vis brøkdel af færdighedsnodens forbindelser går til mislykkede tekstknudepunkter, så fejler LLM med denne færdighed.

Denne forbindelse mellem disse todelte grafer og LLM'er tillod Arora og Goyal at bruge værktøjerne fra tilfældig grafteori til at analysere LLM-adfærd ved hjælp af proxy. At studere disse grafer afslørede visse forhold mellem knudepunkterne. Disse forhold blev til gengæld oversat til en logisk og testbar måde at forklare, hvordan store modeller fik de nødvendige færdigheder for at opnå deres uventede evner.

Arora og Goyal forklarede først én nøgleadfærd: hvorfor større LLM'er bliver dygtigere end deres mindre modparter på individuelle færdigheder. De startede med det lavere testtab forudsagt af de neurale skaleringslove. I en graf er dette lavere testtab repræsenteret af et fald i andelen af mislykkede testknuder. Så der er færre fejlslagne testknuder samlet set. Og hvis der er færre fejlslagne testnoder, så er der færre forbindelser mellem fejlslagne testknuder og færdighedsnoder. Derfor er et større antal færdighedsknuder forbundet med vellykkede testknudepunkter, hvilket tyder på en voksende kompetence i færdigheder til modellen. "En meget lille reduktion i tab giver anledning til, at maskinen tilegner sig disse færdigheder," sagde Goyal.

Dernæst fandt parret en måde at forklare en større models uventede evner på. Efterhånden som en LLMs størrelse øges, og dens testtab falder, udvikler tilfældige kombinationer af færdighedsnoder forbindelser til individuelle tekstnoder. Dette tyder på, at LLM også bliver bedre til at bruge mere end én færdighed ad gangen og begynder at generere tekst ved hjælp af flere færdigheder - ved at kombinere f.eks. evnen til at bruge ironi med en forståelse af ordet "fordi" - selv hvis de nøjagtige kombinationer af færdigheder var ikke til stede i noget tekststykke i træningsdataene.

Forestil dig for eksempel en LLM, der allerede kunne bruge en færdighed til at generere tekst. Hvis du skalerer LLM'ens antal parametre eller træningsdata op i en størrelsesorden, vil den blive tilsvarende kompetent til at generere tekst, der kræver to færdigheder. Gå endnu en størrelsesorden op, og LLM kan nu udføre opgaver, der kræver fire færdigheder på én gang, igen med samme kompetenceniveau. Større LLM'er har flere måder at sætte færdigheder sammen på, hvilket fører til en kombinatorisk eksplosion af evner.

Og efterhånden som en LLM opskaleres, bliver muligheden for, at den stødte på alle disse kombinationer af færdigheder i træningsdataene, stadig mere usandsynlig. Ifølge reglerne for tilfældig grafteori opstår hver kombination fra en tilfældig stikprøve af mulige færdigheder. Så hvis der er omkring 1,000 underliggende individuelle færdighedsknuder i grafen, og du vil kombinere fire færdigheder, så er der cirka 1,000 til den fjerde potens - det vil sige 1 billion - mulige måder at kombinere dem på.

Arora og Goyal ser dette som et bevis på, at de største LLM'er ikke kun er afhængige af kombinationer af færdigheder, de så i deres træningsdata. Bubeck er enig. "Hvis en LLM virkelig er i stand til at udføre disse opgaver ved at kombinere fire af disse tusinde færdigheder, så må det være generalisering," sagde han. Det betyder, at det højst sandsynligt ikke er en stokastisk papegøje.

Ægte kreativitet?

Men Arora og Goyal ønskede at gå ud over teorien og teste deres påstand om, at LLM'er bliver bedre til at kombinere flere færdigheder og dermed til at generalisere, efterhånden som deres størrelse og træningsdata stiger. Sammen med andre kolleger har de designet en metode kaldet "skill-mix" for at evaluere en LLM's evne til at bruge flere færdigheder til at generere tekst.

For at teste en LLM bad holdet det om at generere tre sætninger om et tilfældigt valgt emne, der illustrerede nogle tilfældigt valgte færdigheder. For eksempel bad de GPT-4 (det LLM, der driver den mest kraftfulde version af ChatGPT) om at skrive om duellering - dybest set sværdkampe. Desuden bad de det om at vise færdigheder inden for fire områder: selvtjenende bias, metafor, statistisk syllogisme og almindelig vidensfysik. GPT-4 svarede med: “Min sejr i denne dans med stål [metafor] er lige så sikker som et objekts fald til jorden [fysik]. Som en berømt duellist er jeg i sagens natur kvikk, ligesom de fleste andre [statistisk syllogisme] af mit omdømme. Nederlag? Kun muligt på grund af en ujævn slagmark, ikke min utilstrækkelighed [selvtjenende bias]." Da GPT-4 blev bedt om at kontrollere outputtet, reducerede det til tre sætninger.

Introduktion

"Det er ikke Hemingway eller Shakespeare," sagde Arora, men holdet er overbevist om, at det beviser deres pointe: Modellen kan generere tekst, som den umuligt kunne have set i træningsdataene, og vise færdigheder, der svarer til, hvad nogle ville hævde. er forståelse. GPT-4 består endda færdighedsmix-tests, der kræver seks færdigheder omkring 10 % til 15 % af tiden, sagde han, og producerer tekststykker, som det er statistisk umuligt at have eksisteret i træningsdataene.

Holdet automatiserede også processen ved at få GPT-4 til at evaluere sit eget output sammen med andre LLM'ers. Arora sagde, at det er rimeligt for modellen at evaluere sig selv, fordi den ikke har hukommelse, så den husker ikke, at den blev bedt om at generere netop den tekst, den bliver bedt om at evaluere. Yasaman Bahri, en forsker hos Google DeepMind, der arbejder på grundlaget for AI, finder den automatiserede tilgang "meget enkel og elegant."

Hvad angår teorien, er det rigtigt, at den giver nogle få antagelser, sagde Bubeck, men "disse antagelser er på ingen måde skøre." Han var også imponeret over eksperimenterne. "Hvad [teamet] beviser teoretisk, og også bekræfter empirisk, er, at der er kompositorisk generalisering, hvilket betyder, at [LLM'er] er i stand til at sætte byggeklodser sammen, som aldrig er blevet sat sammen," sagde han. "Dette er for mig essensen af kreativitet."

Arora tilføjer, at værket ikke siger noget om nøjagtigheden af, hvad LLM'er skriver. "Faktisk argumenterer det for originalitet," sagde han. ”Disse ting har aldrig eksisteret i verdens træningskorpus. Ingen har nogensinde skrevet dette. Det skal hallucinere.”

Ikke desto mindre mener Hinton, at arbejdet hviler på spørgsmålet om, hvorvidt LLM'er er stokastiske papegøjer. "Det er den mest strenge metode, jeg har set til at vise, at GPT-4 er meget mere end en ren stokastisk papegøje," sagde han. "De demonstrerer overbevisende, at GPT-4 kan generere tekst, der kombinerer færdigheder og emner på måder, som næsten helt sikkert ikke forekom i træningsdataene." (Vi nåede ud til Bender for hendes perspektiv på det nye værk, men hun afviste at kommentere på grund af mangel på tid.)

Og faktisk, som matematikken forudsiger, overstråler GPT-4s ydeevne langt dens mindre forgænger, GPT-3.5 - i en grad, der skræmte Arora. "Det er nok ikke kun mig," sagde han. "Mange mennesker syntes, det var lidt uhyggeligt, hvor meget GPT-4 var bedre end GPT-3.5, og det skete inden for et år. Betyder det, at vi om et andet år vil have en lignende ændring af den størrelsesorden? Jeg ved ikke. Kun OpenAI ved det."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :har

- :er

- :ikke

- :hvor

- ][s

- $OP

- 000

- 1

- 15 %

- 2021

- a

- evner

- evne

- I stand

- Om

- brat

- akademisk

- acceptabel

- adgang

- Ifølge

- Konti

- nøjagtighed

- præcis

- opnå

- ACM

- erhverve

- faktiske

- tilføje

- Tilføjer

- Efter

- igen

- er enig

- AI

- algoritme

- Alle

- tillade

- tilladt

- næsten

- sammen

- allerede

- også

- beløb

- an

- analysere

- ,

- Andrew

- En anden

- besvare

- besvarelse

- svar

- enhver

- noget

- tilgang

- cirka

- ER

- områder

- argumentere

- argumenteret

- argument

- ARM

- anbragt

- kunstig

- AS

- antagelser

- At

- forfattere

- Automatiseret

- til rådighed

- grundlæggende

- I bund og grund

- grundlag

- Battlefield

- BE

- fordi

- bliver

- bliver

- været

- før

- adfærd

- adfærd

- være

- Tro

- jf. nedenstående

- BEDSTE

- Bedre

- mellem

- Beyond

- skævhed

- forudindtaget

- Big

- større

- Største

- milliarder

- Bit

- Blocks

- bots

- Bygning

- bygget

- men

- by

- beregne

- beregner

- kaldet

- kom

- CAN

- kan ikke

- stand

- tilfælde

- vis

- sikkert

- udfordre

- lave om

- Ændringer

- chatbot

- chatbots

- ChatGPT

- kontrollere

- Vælg

- valgt

- krav

- klar

- kodificerede

- SAMMENHÆNGENDE

- Coin

- kolleger

- samling

- kombination

- kombinationer

- kombinerer

- kombinerer

- kombinerer

- Kom

- kommer

- KOMMENTAR

- Virksomheder

- kompetent

- fuldføre

- komplekse

- forstå

- beregningsmæssige

- computer

- sikker

- Tilslut

- tilsluttet

- tilslutning

- Tilslutninger

- forbinder

- Konsensus

- følge

- indeholder

- fortsæt

- overbevist

- korrigere

- svarer

- Omkostninger

- kunne

- modparter

- skøre

- kreativitet

- afgørende

- dans

- farer

- data

- besluttede

- falder

- DeepMind

- definerede

- demonstrere

- betegner

- afhænge

- beskrive

- konstrueret

- opdage

- Bestem

- udvikle

- udviklet

- dikteret

- DID

- forskel

- forsvinder

- Skærm

- visning

- afstand

- fordeling

- forskelligartede

- opdele

- do

- gør

- Er ikke

- gør

- Dont

- ned

- tegne

- Drops

- grund

- duo

- hver

- Edge

- emerge

- fremkomsten

- nok

- Hele

- ligninger

- Essensen

- oprettelse

- evaluere

- Endog

- NOGENSINDE

- Hver

- præcist nok

- eksempel

- overstiger

- eksisterer

- eksisterer

- forventet

- eksperimenter

- eksperter

- Forklar

- forklarede

- eksplosion

- udstrækning

- Faktisk

- mislykkedes

- mislykkes

- retfærdig

- Fall

- langt

- få

- færre

- slagsmål

- fund

- Fornavn

- Flip

- Fokus

- Til

- formular

- formularer

- kommende

- fundet

- Fonde

- fire

- Fjerde

- fraktion

- Framework

- fra

- vundet

- gevinster

- generere

- generere

- få

- få

- Giv

- given

- giver

- Give

- Go

- gå

- graf

- grafer

- større

- Ground

- Dyrkning

- skete

- sker

- Have

- he

- hoveder

- hende

- stærkt

- ham

- hints

- hans

- Hvordan

- Men

- HTTPS

- menneskelignende

- i

- idé

- if

- forestillet

- umuligt

- imponeret

- Forbedre

- forbedret

- in

- inkorporerer

- Forøg

- Stigninger

- stigende

- faktisk

- individuel

- oplysninger

- sagens natur

- indsigt

- instans

- Intelligens

- ind

- ironi

- isolerede

- IT

- ITS

- selv

- lige

- Nøgle

- Kend

- kendt

- kender

- Mangel

- Sprog

- stor

- større

- største

- Efternavn

- Lov

- Love

- Lays

- Leads

- Forlade

- Niveau

- niveauer

- ligesom

- Sandsynlig

- Line (linje)

- linjer

- LINK

- lidt

- LLM

- logisk

- Lang

- lang tid

- Se

- off

- Lot

- lavere

- maskine

- lavet

- magasin

- lave

- maerker

- måde

- mange

- massive

- matematik

- matematiske

- matematisk

- Kan..

- kan være

- me

- betyde

- betyder

- midler

- Mød

- Hukommelse

- blotte

- metode

- microsoft

- måske

- tankerne

- sind

- model

- modeller

- Moderne

- mere

- Desuden

- mest

- meget

- flere

- skal

- my

- nødvendig

- behov

- behov

- netværk

- net

- neurale

- neurale netværk

- neurale netværk

- Neuroner

- aldrig

- Ny

- næste

- ingen

- node

- noder

- intet

- Begreb

- nu

- nummer

- numre

- talrige

- objekter

- sløres

- Obvious

- of

- on

- engang

- ONE

- dem

- kun

- OpenAI

- Udtalelse

- or

- ordrer

- original

- originalitet

- Andet

- Andre

- Ellers

- ud

- output

- i løbet af

- samlet

- egen

- sider

- par

- parametre

- del

- særlig

- Passing

- Mennesker

- Udfør

- ydeevne

- måske

- perspektiv

- Fysik

- picks

- stykke

- stykker

- pioner

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- punkter

- Muligheden

- mulig

- eventuelt

- magt

- vigtigste

- beføjelser

- forgænger

- forudsige

- forudsagde

- forudsige

- forudsigelse

- Forudsigelser

- forudser

- tilstedeværelse

- præsentere

- forelagt

- Princeton

- sandsynligvis

- problemer

- Fortsæt

- behandle

- producerer

- bevis

- beviselig

- beviser

- giver

- proxy

- offentlige

- sætte

- Sætte

- Quantamagazin

- spørgsmål

- Spørgsmål

- tilfældig

- nået

- gik op for

- virkelig

- Reduceret

- reduktion

- henvisningen

- relaterede

- Relationer

- relevant

- stole

- forblive

- huske

- Kendt

- svar

- repræsentere

- repræsenteret

- repræsenterer

- repræsenterer

- omdømme

- kræver

- påkrævet

- Kræver

- forskning

- forsker

- forskere

- REST

- afsløre

- Revealed

- stringent

- Rise

- regler

- Said

- samme

- så

- siger

- siger

- Scale

- skalering

- Videnskabsmand

- se

- tilsyneladende

- synes

- set

- forstand

- dømme

- sæt

- hun

- bør

- Vis

- lignende

- Tilsvarende

- Simpelt

- enkelt

- SIX

- Størrelse

- dygtighed

- faglært

- færdigheder

- mindre

- So

- Løsning

- nogle

- noget

- Space

- specifikke

- påbegyndt

- statistiske

- Stadig

- lige

- stærk

- studere

- vellykket

- sådan

- pludselige

- foreslår

- overraskelse

- sværd

- Systemer

- talenter

- opgaver

- hold

- gået

- prøve

- afprøvet

- Test

- tests

- tekst

- end

- at

- Grafen

- deres

- Them

- derefter

- teoretisk

- teori

- Der.

- derfor

- Disse

- de

- ting

- tænker

- denne

- dem

- selvom?

- tusinde

- tre

- tærskel

- Dermed

- tid

- til

- nutidens

- sammen

- også

- værktøjer

- emne

- Emner

- toronto

- uddannet

- Kurser

- overgange

- trillion

- sand

- forsøger

- TUR

- Drejede

- tweak

- to

- typen

- typer

- underliggende

- forstå

- forståelse

- Uventet

- Universal

- universitet

- usandsynligt

- indtil

- brug

- anvendte

- bruger

- ved brug af

- værdi

- forskellige

- udgave

- meget

- sejr

- ønsker

- ønskede

- var

- washington

- Vej..

- måder

- we

- WebP

- var

- Hvad

- hvornår

- hvorvidt

- som

- WHO

- hvorfor

- vilje

- med

- inden for

- undrende

- ord

- ord

- Arbejde

- virker

- Verdens

- ville

- skriver

- skriftlig

- skrev

- år

- endnu

- Du

- zephyrnet