Sidste måned fejrede Networking and Information Technology Research and Development (NITRD)-programmet deres 30-års jubilæum i Washington DC. Du kan læse hele begivenhedens resumé link.. I et forsøg på at fremhæve den indflydelse, føderale investeringer har haft på computerforskningssamfundet, indeholdt begivenheden fem paneler, hvor deltagerne diskuterede nøgleresultater på området i løbet af det seneste årti og fremtidige retninger fremadrettet. Hvert panel fokuserede på et vigtigt underområde af computerforskning: Computing at Scale, Networking and Security, Artificial Intelligence/Machine Learning, Privacy and the Internet of Things og Social Responsible Computing.

Privatliv er blevet et stort samtaleemne ikke kun blandt computerforskningsmiljøet, men på tværs af alle discipliner i både den akademiske verden og industrien. Uønskede privatlivseffekter som følge af tilgængeligheden af datasæt i stor skala bliver ganget med indbyrdes forbundne sensorer, enheder og aktuatorer der udgør tingenes internet (IoT). Modereret af Charles ("Chuck") Romine (NIST) og med felteksperterne Ed Felten (Princeton), Marc Groman (Groman Consulting), Katerina Megas (NIST) og Sunoo Park (Cornell), Panel 4: Privatliv og IoT diskuterer vigtige emner såsom afvejningen mellem databrug og privatliv og potentielle forskningsmål for at hjælpe med at opnå effektive politiske løsninger.

Romine startede med at fremhæve en rød tråd i alle panelerne: "at tale om både fordelene og de ekstraordinære kapaciteter leveret gennem føderale finansieringsinvesteringer sammen med de tilhørende risici." IoT er ikke anderledes, det giver folk adgang til uoverkommelig information, muliggør vellykkede annoncekampagner og skrædderteknologi til din personlige smag, men det bringer også brugernes privatliv i fare.

Som Megas påpegede, "Hele grunden til, at vi påtager os denne indsats, er, fordi vi vil være i stand til rent faktisk at se IoT anerkendt, og at samfundet kan høste fordelene." Hun fortsatte med at dele de potentielle fordele og vigtigheden af at kunne dele data på tværs af IoT. Der er en "fænomenal" skala af enheder i IoT, der kan bruges til at identificere problemer på tværs af datasæt, lære ting, der har et stort potentiale for individer og samfund, træning af kunstig intelligens-teknologier og til at gøre det muligt for små innovative virksomheder at teste deres enheder. Romine spurgte paneldeltagerne, hvad de tilhørende privatlivsrisici faktisk er i denne sammenhæng med IoT og informationsdeling.

Groman svarede ved først at forklare samspillet mellem privatliv og IoT. Privatlivssiden af IoT er en delmængde af data inden for det større sæt, der indsamles, dvs. om eller relateret til mennesker. Ved folk, at der bliver indsamlet data om dem? Er der en grænseflade, hvor du kan interagere med enheden, lære, hvad den indsamler eller ændre den? Forstår folk, hvilke oplysninger der bliver indsamlet, eller hvilke slutninger der drages af enheden eller virksomheden fra de data, der indsamles? På grund af den monetære incitamentstruktur og den "store" mængde af mange, som virksomheder kan gøre ud af at udnytte sådanne data, opfordrede Groman folk til at henvende sig til politik for at finde en løsning.

"Målet her er at maksimere fordelene og minimere skader. Vi har ikke en politisk, juridisk eller regulatorisk ramme i dette land, der giver incitamenter til at nå dertil” – Marc Groman

For at imødegå Gromans holdning spurgte Romine panelet om potentialet for en teknologisk løsning.

Felten foreslog, at vi starter med at søge at bedre forstå og anvende statistisk informationskontrol og bygge værktøjer, der giver folk mulighed for at interagere med deres data og afbøde negative påvirkninger. Park, som har en særlig interesse i kryptografiske databeskyttelsesværktøjer, nævnte en række måder hvorpå kryptografi kunne hjælpe i denne henseende.

"Kryptografi giver et værktøjssæt til at bygge systemer, der har konfigurationer af informationsstrømme og omfatter mere finmasket kontrol over adgang". – Sunoo Park

Et af værktøjerne kunne være nul-viden beviser, som tillader delvis deling af data, mens andre aspekter holdes hemmelige for enheder. Hun gav eksemplet med en udsmider, der tjekkede id'er for at komme ind i en bar - gennem nul-vidensbeviser kunne du bevise, at du er 21 uden at dele din adresse eller fødselsdag, der også står på id'et.

Park advarede om, at selvom kryptografi giver "et større løsningsrum, som vi kan bruge til at opbygge privatliv", svarer det ikke på spørgsmålet om, hvilke slags ting vi skal bygge ved hjælp af disse værktøjer, eller hvilke former for information vi anser for passende eller ønskværdige at dele. Det er noget, vi skal arbejde ud af som samfund og et spørgsmål om politik.

Til sidst blev paneldeltagerne spurgt, hvorfor folk skulle bekymre sig. Hvad hvis de ikke har noget at skjule? Felten tjente et grin fra mængden og jokede med, at alle har noget at skjule. I en mere seriøs note fortsatte han med at fremhæve den potentielle skade ved dataprofilering.

"Folk derude bygger en omfattende model for, hvem du er, og hvad du sandsynligvis vil gøre." – Ed Felten

Allerede en skræmmende tanke, kan disse antagelser være forkerte og nogle gange begrænse muligheder og "handlingsfrihed" i fremtiden. Groman pegede på en anden rød tråd gennem panelernes diskussioner – vigtigheden af at indse, at nogle samfund bliver uforholdsmæssigt påvirket. Indsatsen kan være højere for at holde nogle data private, uanset om det er for seksuel orientering, køn, race eller misbrugte kvinder eller børn.

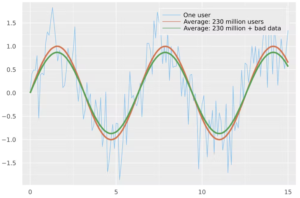

Under spørgsmålet og svaret kredsede tidligere taler fra panel 3, Ben Zorn, tilbage til fordelene ved data, der bruges til at træne AI. Han spurgte om, hvad der kunne gøres ved, at private oplysninger blev lækket gennem de datasæt, der bruges til at træne AI.

Felten påpegede, at medmindre du bruger en streng metode til bevidst at stoppe nedsivningen af information, så vil informationen flyde. Derfor er det så vigtigt at fokusere på at bygge strenge og bevisbare metoder til ting som privatlivsbevarende maskinlæring og grænseflader for at kontrollere trickle-down-effekten.

Megas opsummerede det perfekt, at vi i sidste ende ikke kan træne alle, men vi kan give folk en ramme, der sætter dem i stand til at tænke på risiko og give dem værktøjer til at give dem større kontrol over deres data. Du kan se hele optagelsen på CCC hjemmeside eller NITRDs YouTube-kanal.

Vær på udkig efter den sidste blog i serien, Panel 5: How Technology Can Benefit Society: Broadening Perspectives in Fundamental Research.