Organisationer i udlåns- og realkreditbranchen behandler tusindvis af dokumenter på daglig basis. Fra en ny realkreditansøgning til refinansiering af realkreditlån involverer disse forretningsprocesser hundredvis af dokumenter pr. ansøgning. Der er begrænset automatisering tilgængelig i dag til at behandle og udtrække information fra alle dokumenter, især på grund af varierende formater og layout. På grund af den store mængde applikationer er det en tidskrævende, meget manuel, fejludsat og dyr proces at fange strategisk indsigt og få nøgleinformation fra indholdet. Ældre værktøjer til optisk tegngenkendelse (OCR) er omkostningsoverkommelige, fejltilbøjelige, involverer en masse konfiguration og er svære at skalere. Intelligent dokumentbehandling (IDP) med AWS kunstig intelligens (AI)-tjenester hjælper med at automatisere og accelerere behandlingen af realkreditansøgninger med mål om hurtigere og kvalitetsbeslutninger, samtidig med at de samlede omkostninger reduceres.

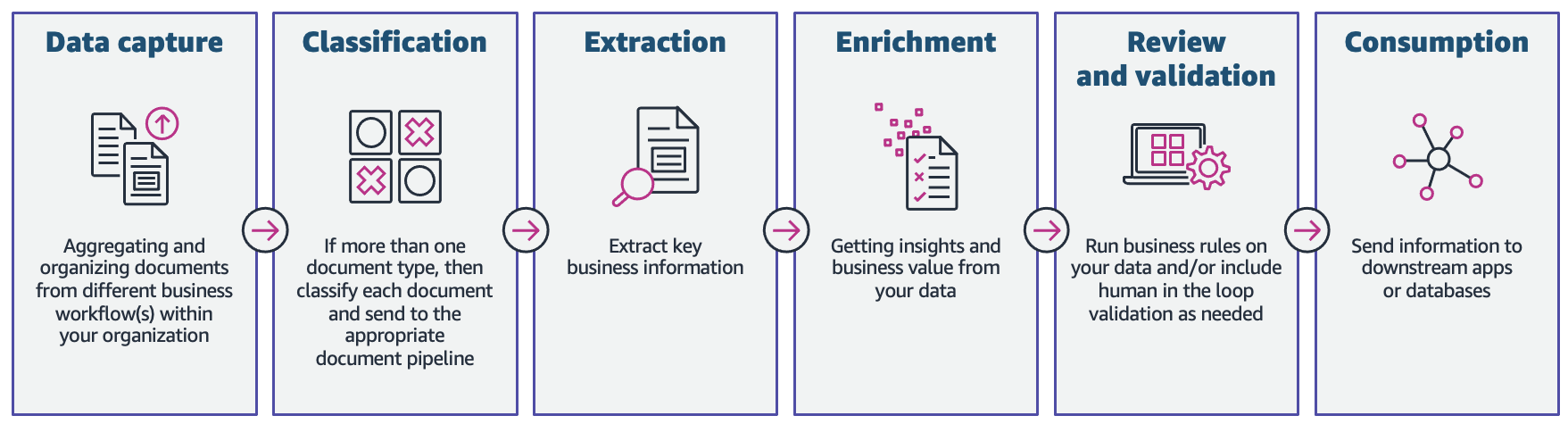

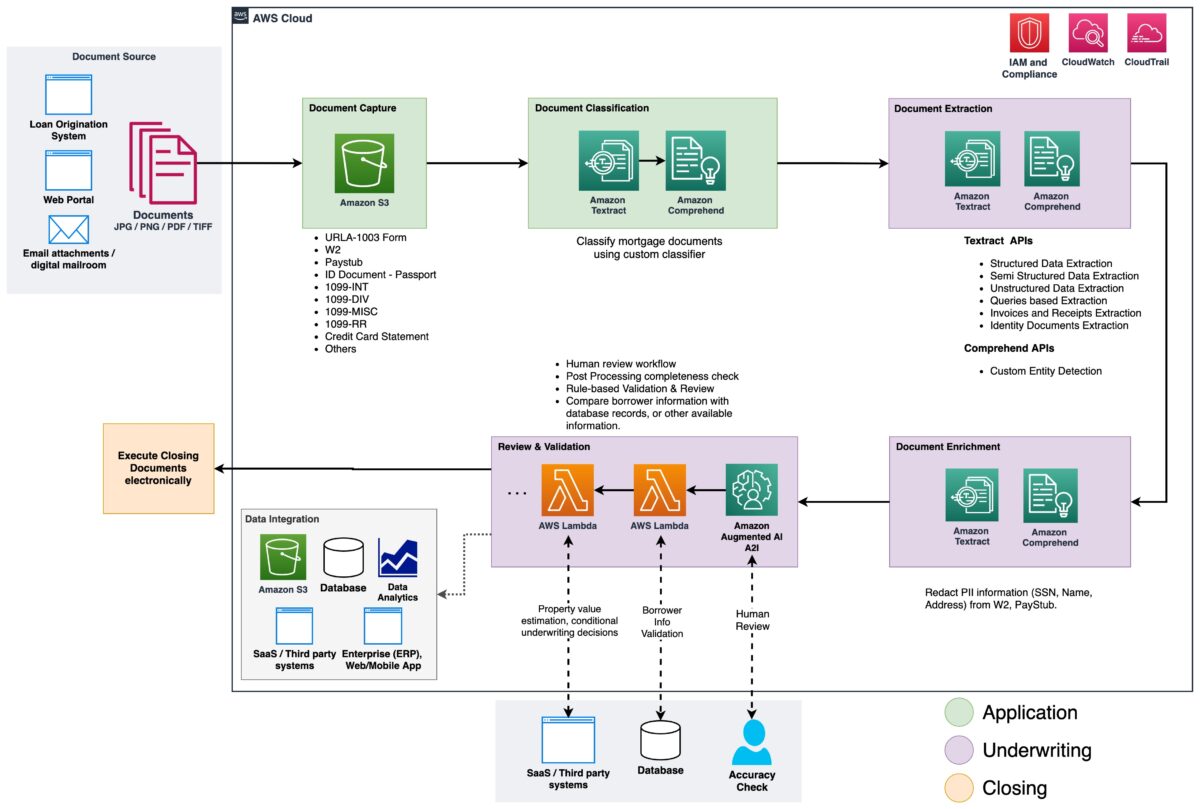

I dette indlæg demonstrerer vi, hvordan du kan bruge maskinlæringsfunktioner (ML) med amazontekstog Amazon Comprehend at behandle dokumenter i en ny realkreditansøgning, uden behov for ML-kundskaber. Vi udforsker de forskellige faser af IDP som vist i den følgende figur, og hvordan de forbindes med de trin, der er involveret i en realkreditansøgningsproces, såsom ansøgningsindsendelse, underwriting, verifikation og lukning.

Selvom hver realkreditansøgning kan være unik, har vi taget nogle af de mest almindelige dokumenter i betragtning, som er inkluderet i en realkreditansøgning, såsom Unified Residential Loan Application (URLA-1003)-formularen, 1099-formularer og pantnota.

Løsningsoversigt

Amazon Textract er en ML-tjeneste, der automatisk udtrækker tekst, håndskrift og data fra scannede dokumenter ved hjælp af forudtrænede ML-modeller. Amazon Comprehend er en NLP-tjeneste (natural-language processing), der bruger ML til at afdække værdifuld indsigt og forbindelser i tekst og kan udføre dokumentklassificering, navnenhedsgenkendelse (NER), emnemodellering og mere.

Følgende figur viser faserne af IDP, som det relaterer til faserne af en realkreditansøgningsproces.

Ved starten af processen uploades dokumenter til en Amazon Simple Storage Service (Amazon S3) spand. Dette igangsætter en dokumentklassificeringsproces for at kategorisere dokumenterne i kendte kategorier. Efter at dokumenterne er kategoriseret, er næste trin at udtrække nøgleoplysninger fra dem. Vi udfører derefter berigelse for udvalgte dokumenter, som kan være ting som redaktion af personlig identificerbar information (PII), dokumenttagging, metadataopdateringer og mere. Det næste trin involverer validering af de data, der er udtrukket i tidligere faser, for at sikre fuldstændigheden af en realkreditansøgning. Validering kan udføres via forretningsvalideringsregler og regler for krydsdokumentvalidering. Tillidsscorerne for den udtrukne information kan også sammenlignes med en fastsat tærskel og automatisk sendes til en menneskelig anmelder gennem Amazon Augmented AI (Amazon A2I), hvis tærsklen ikke er opfyldt. I den sidste fase af processen sendes de udtrukne og validerede data til downstream-systemer til yderligere lagring, behandling eller dataanalyse.

I de følgende afsnit diskuterer vi faserne af IDP, som det relaterer til faserne af en realkreditansøgning i detaljer. Vi går gennem faserne af IDP og diskuterer typerne af dokumenter; hvordan vi opbevarer, klassificerer og udtrækker information, og hvordan vi beriger dokumenterne ved hjælp af maskinlæring.

Dokumentlagring

Amazon S3 er en objektlagringstjeneste, der tilbyder brancheførende skalerbarhed, datatilgængelighed, sikkerhed og ydeevne. Vi bruger Amazon S3 til sikker opbevaring af realkreditdokumenterne under og efter realkreditansøgningsprocessen. EN pantansøgningspakke kan indeholde flere typer formularer og dokumenter, såsom URLA-1003, 1099-INT/DIV/RR/MISC, W2, lønsedler, kontoudtog, kreditkortudtog og mere. Disse dokumenter indsendes af ansøger i realkreditansøgningsfasen. Uden manuelt at gennemse dem, er det måske ikke umiddelbart klart, hvilke dokumenter der er inkluderet i pakken. Denne manuelle proces kan være tidskrævende og dyr. I næste fase automatiserer vi denne proces ved hjælp af Amazon Comprehend til at klassificere dokumenterne i deres respektive kategorier med høj nøjagtighed.

Dokumentklassificering

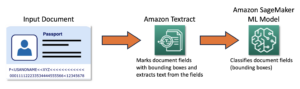

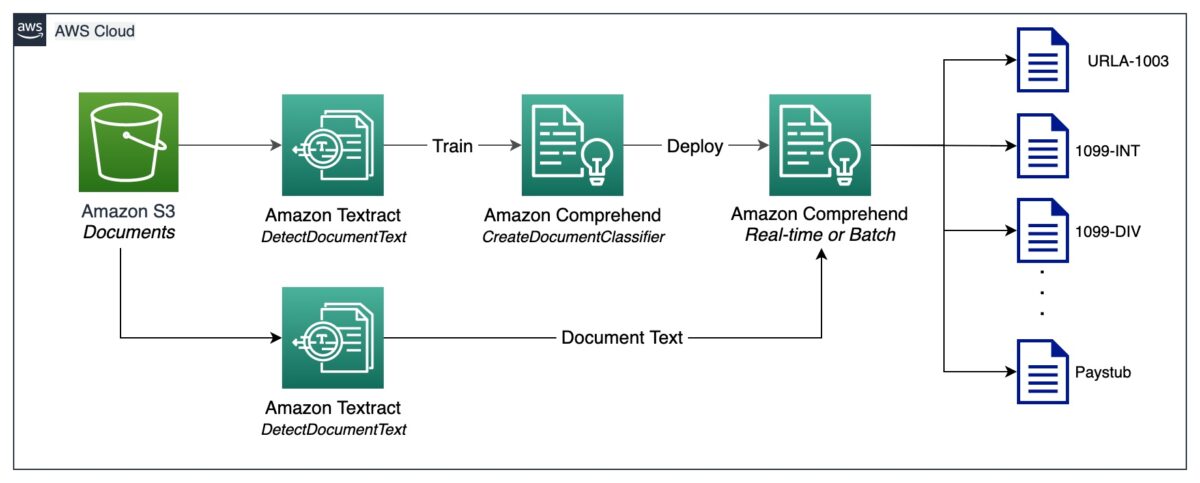

Dokumentklassificering er en metode, hvorved et stort antal uidentificerede dokumenter kan kategoriseres og mærkes. Vi udfører denne dokumentklassificering ved hjælp af en Amazon Comprehend brugerdefineret klassificering. En brugerdefineret klassificering er en ML-model, der kan trænes med et sæt mærkede dokumenter for at genkende de klasser, der er af interesse for dig. Efter at modellen er trænet og implementeret bag et hostet slutpunkt, kan vi bruge klassificeringen til at bestemme den kategori (eller klasse) et bestemt dokument tilhører. I dette tilfælde træner vi en brugerdefineret klassificering i multi-klasse tilstand, hvilket kan gøres enten med en CSV-fil eller en udvidet manifestfil. Til formålet med denne demonstration bruger vi en CSV-fil til at træne klassificereren. Se vores GitHub repository for den fulde kodeeksempel. Følgende er en oversigt på højt niveau over de involverede trin:

- Udpak UTF-8-kodet almindelig tekst fra billed- eller PDF-filer ved hjælp af Amazon Textract DetectDocumentText API.

- Forbered træningsdata for at træne en brugerdefineret klassificering i CSV-format.

- Træn en brugerdefineret klassificering ved hjælp af CSV-filen.

- Implementer den trænede model med et slutpunkt til real-time dokumentklassificering eller brug multi-class mode, som understøtter både real-time og asynkrone operationer.

Følgende diagram illustrerer denne proces.

Du kan automatisere dokumentklassificering ved hjælp af det implementerede slutpunkt til at identificere og kategorisere dokumenter. Denne automatisering er nyttig til at kontrollere, om alle de nødvendige dokumenter er til stede i en pantepakke. Et manglende dokument kan hurtigt identificeres uden manuel indgriben og meddeles ansøgeren meget tidligere i processen.

Dokumentudtræk

I denne fase udtrækker vi data fra dokumentet ved hjælp af Amazon Textract og Amazon Comprehend. Til strukturerede og semistrukturerede dokumenter, der indeholder formularer og tabeller, bruger vi Amazon Textract AnalyserDokument API. For specialiserede dokumenter, såsom ID-dokumenter, leverer Amazon Textract AnalyseID API. Nogle dokumenter kan også indeholde tæt tekst, og du skal muligvis udtrække forretningsspecifikke nøgleudtryk fra dem, også kendt som enheder. Vi bruger tilpasset enhedsgenkendelse Amazon Comprehends evne til at træne en brugerdefineret enhedsgenkendelse, som kan identificere sådanne enheder ud fra den tætte tekst.

I de følgende afsnit gennemgår vi de eksempler på dokumenter, der er til stede i en låneansøgningspakke, og diskuterer de metoder, der bruges til at udtrække information fra dem. For hvert af disse eksempler er der inkluderet et kodestykke og et kort eksempeloutput.

Udtræk data fra Unified Residential Loan Application URLA-1003

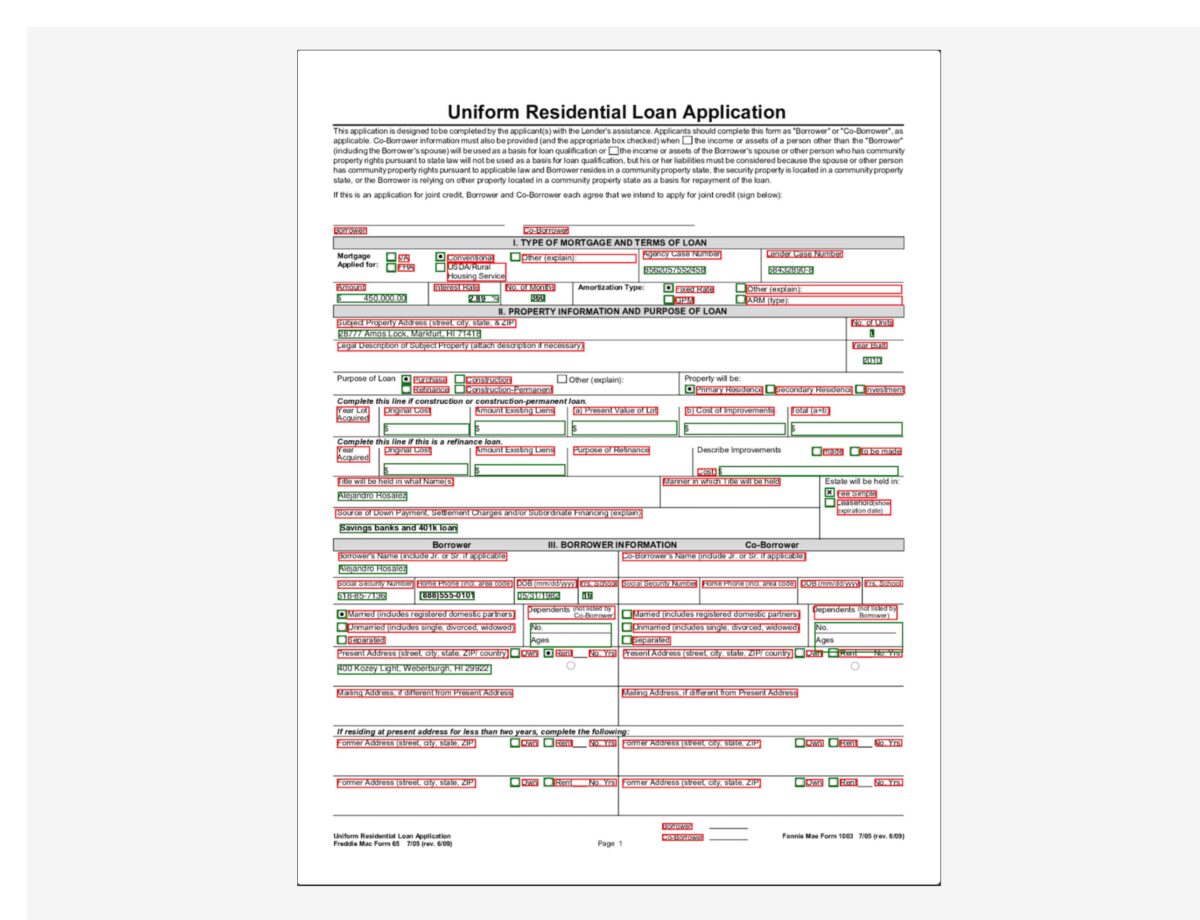

En Unified Residential Loan Application (URLA-1003) er en branchestandard ansøgningsformular til realkreditlån. Det er et ret komplekst dokument, der indeholder oplysninger om pantansøgeren, typen af bolig, der købes, beløbet, der finansieres, og andre detaljer om boligkøbets karakter. Det følgende er et eksempel på URLA-1003, og vores hensigt er at udtrække information fra dette strukturerede dokument. Fordi dette er en formular, bruger vi AnalyzeDocument API med en funktionstype på FORM.

Funktionstypen FORM udtrækker formularoplysninger fra dokumentet, som derefter returneres i nøgleværdi-parformat. Følgende kodestykke bruger amazon-textract-textractor Python-bibliotek til at udtrække formularinformation med blot et par linjer kode. Bekvemmelighedsmetoden call_textract() kalder AnalyzeDocument API internt, og de parametre, der sendes til metoden, abstraherer nogle af de konfigurationer, som API'en har brug for for at køre ekstraktionsopgaven. Document er en bekvemmelighedsmetode, der bruges til at hjælpe med at analysere JSON-svaret fra API'en. Det giver en abstraktion på højt niveau og gør API-outputtet iterabelt og nemt at få information ud af. For mere information, se Textract Response Parser , Teksttraktor.

Bemærk, at outputtet indeholder værdier for afkrydsningsfelter eller alternativknapper, der findes i formularen. For eksempel, i eksempel-URLA-1003-dokumentet Køb indstilling blev valgt. Den tilsvarende udgang for alternativknappen udtrækkes som "Purchase" (tast) og "SELECTED” (værdi), hvilket indikerer, at alternativknappen er valgt.

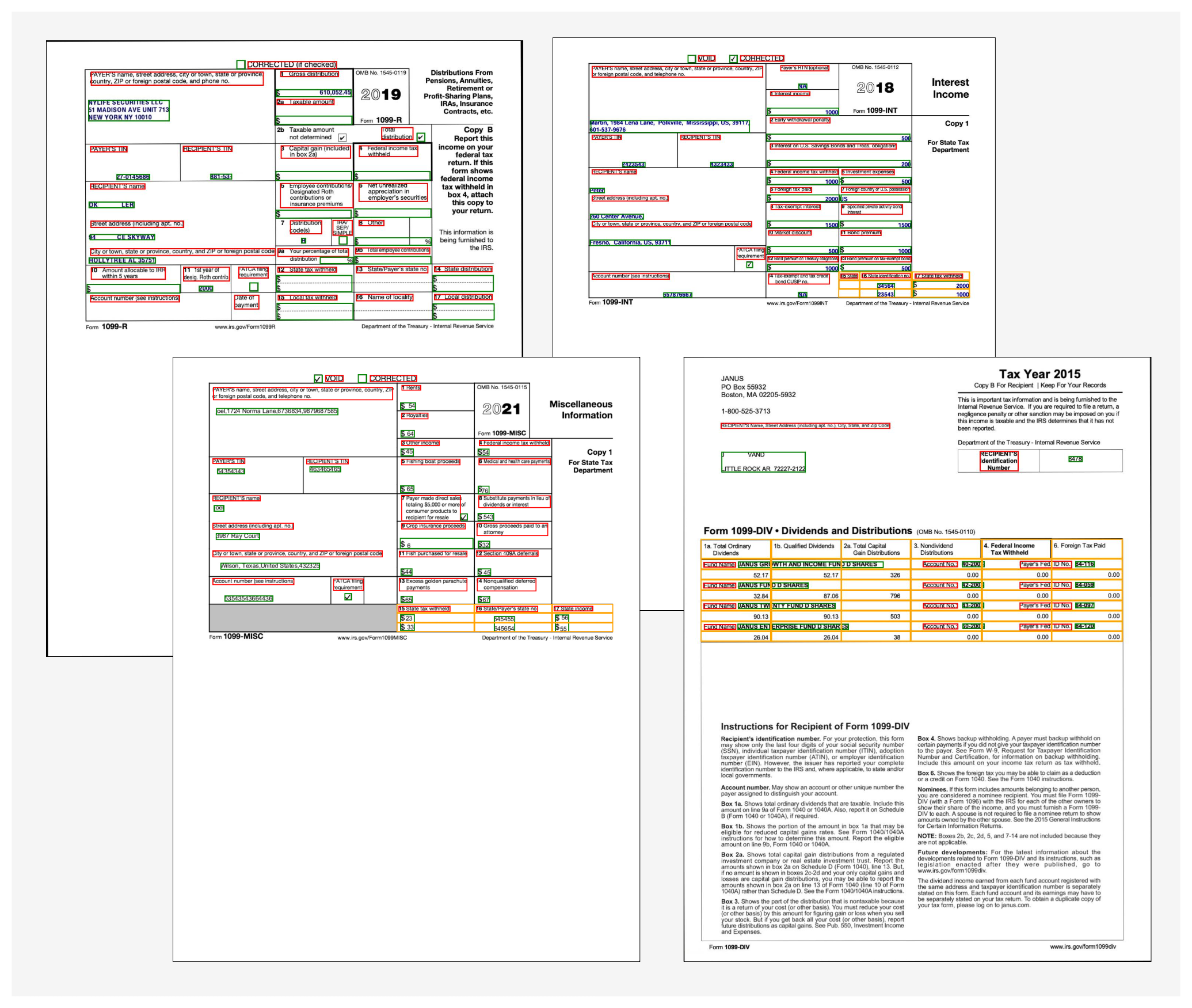

Udtræk data fra 1099 formularer

En pantansøgningspakke kan også indeholde en række IRS-dokumenter, såsom 1099-DIV, 1099-INT, 1099-MISC og 1099-R. Disse dokumenter viser ansøgerens indtjening via renter, udbytter og andre forskellige indkomstkomponenter, der er nyttige under tegning til at træffe beslutninger. Følgende billede viser en samling af disse dokumenter, som har ens struktur. I nogle tilfælde indeholder dokumenterne dog formularoplysninger (markeret med de røde og grønne afgrænsningsfelter) samt tabeloplysninger (markeret med de gule afgrænsningsfelter).

For at udtrække formularoplysninger bruger vi lignende kode som forklaret tidligere med AnalyzeDocument API. Vi passerer en ekstra funktion af TABEL til API'et for at indikere, at vi har brug for både formular- og tabeldata udtrukket fra dokumentet. Følgende kodestykke bruger AnalyzeDocument API med FORMS- og TABLES-funktioner på 1099-INT-dokumentet:

Fordi dokumentet indeholder en enkelt tabel, er outputtet af koden som følger:

Tabeloplysningerne indeholder cellepositionen (række 0, kolonne 0, og så videre) og den tilsvarende tekst i hver celle. Vi bruger en bekvemmelighedsmetode, der kan transformere disse tabeldata til en letlæselig gittervisning:

Vi får følgende output:

For at få outputtet i et CSV-format, der er nemt at forbruge, skal formattypen på Pretty_Print_Table_Format.csv kan overføres til table_format parameter. Andre formater såsom TSV (tabulatorseparerede værdier), HTML og Latex understøttes også. For mere information, se Textract-PrettyPrinter.

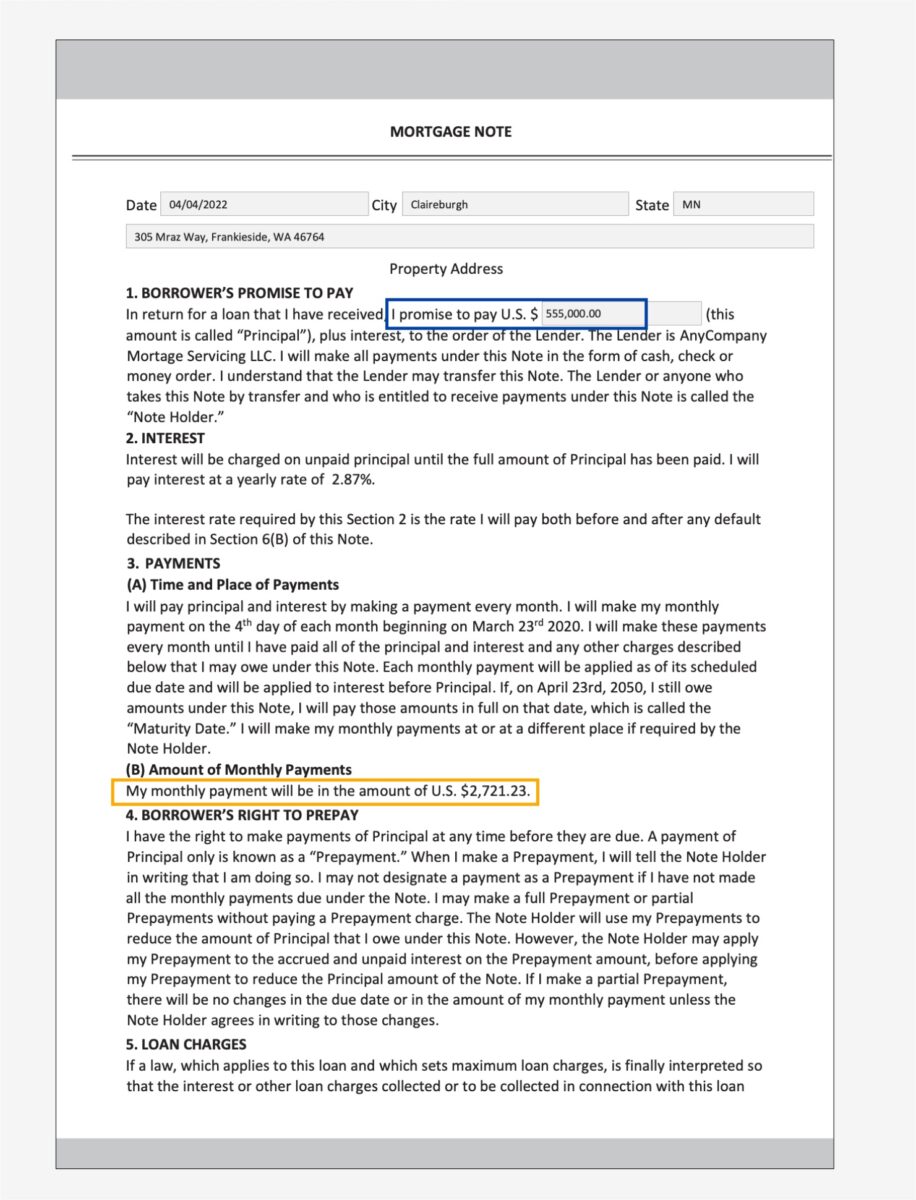

Udtræk data fra et pantebrev

En pantansøgningspakke kan indeholde ustrukturerede dokumenter med tæt tekst. Nogle eksempler på tætte tekstdokumenter er kontrakter og aftaler. Et pantebrev er en aftale mellem en realkreditansøger og långiver eller realkreditselskab, og indeholder oplysninger i tætte tekstafsnit. I sådanne tilfælde gør den manglende struktur det vanskeligt at finde vigtige forretningsoplysninger, der er vigtige i realkreditansøgningsprocessen. Der er to tilgange til at løse dette problem:

I det følgende eksempel på pantebrevet er vi specifikt interesseret i at finde ud af det månedlige betalingsbeløb og hovedstolen.

Til den første tilgang bruger vi Query , QueriesConfig bekvemmelighedsmetoder til at konfigurere et sæt spørgsmål, der sendes til Amazon Textract AnalyzeDocument API-kald. Hvis dokumentet er på flere sider (PDF eller TIFF), kan vi også angive sidetallene, hvor Amazon Textract skal lede efter svar på spørgsmålet. Følgende kodestykke viser, hvordan du opretter forespørgselskonfigurationen, foretager et API-kald og efterfølgende analyserer svaret for at få svarene fra svaret:

Vi får følgende output:

Til den anden tilgang bruger vi Amazon Comprehend DetectEntities API med pantsedlen, som returnerer de enheder, den registrerer i teksten fra en foruddefinerede sæt af enheder. Dette er enheder, som Amazon Comprehend-entity-genkenderen er foruddannet med. Men fordi vores krav er at detektere specifikke enheder, trænes en Amazon Comprehend brugerdefineret enhedsgenkender med et sæt eksempler på pantebrevsdokumenter og en liste over enheder. Vi definerer enhedsnavnene som PRINCIPAL_AMOUNT , MONTHLY_AMOUNT. Træningsdata udarbejdes efter Amazon Comprehend-uddannelsen retningslinjer for udarbejdelse af data til tilpasset enhedsgenkendelse. Enhedsgenkenderen kan trænes med dokumentanmærkninger eller med enhedslister. Til formålet med dette eksempel bruger vi entitetslister til at træne modellen. Efter at vi har trænet modellen, kan vi implementere den med en slutpunkt i realtid eller i batchvis for at detektere de to enheder fra dokumentindholdet. Følgende er de involverede trin for at træne en brugerdefineret enhedsgenkender og implementere den. For en fuld kodegennemgang, se vores GitHub-lager.

- Forbered træningsdataene (enhedslisten og dokumenterne med (UTF-8-kodet) almindeligt tekstformat).

- Start enhedsgenkendelsesuddannelsen ved hjælp af CreateEntityRecognizer API ved hjælp af træningsdata.

- Implementer den trænede model med et slutpunkt i realtid ved hjælp af Opret slutpunkt API.

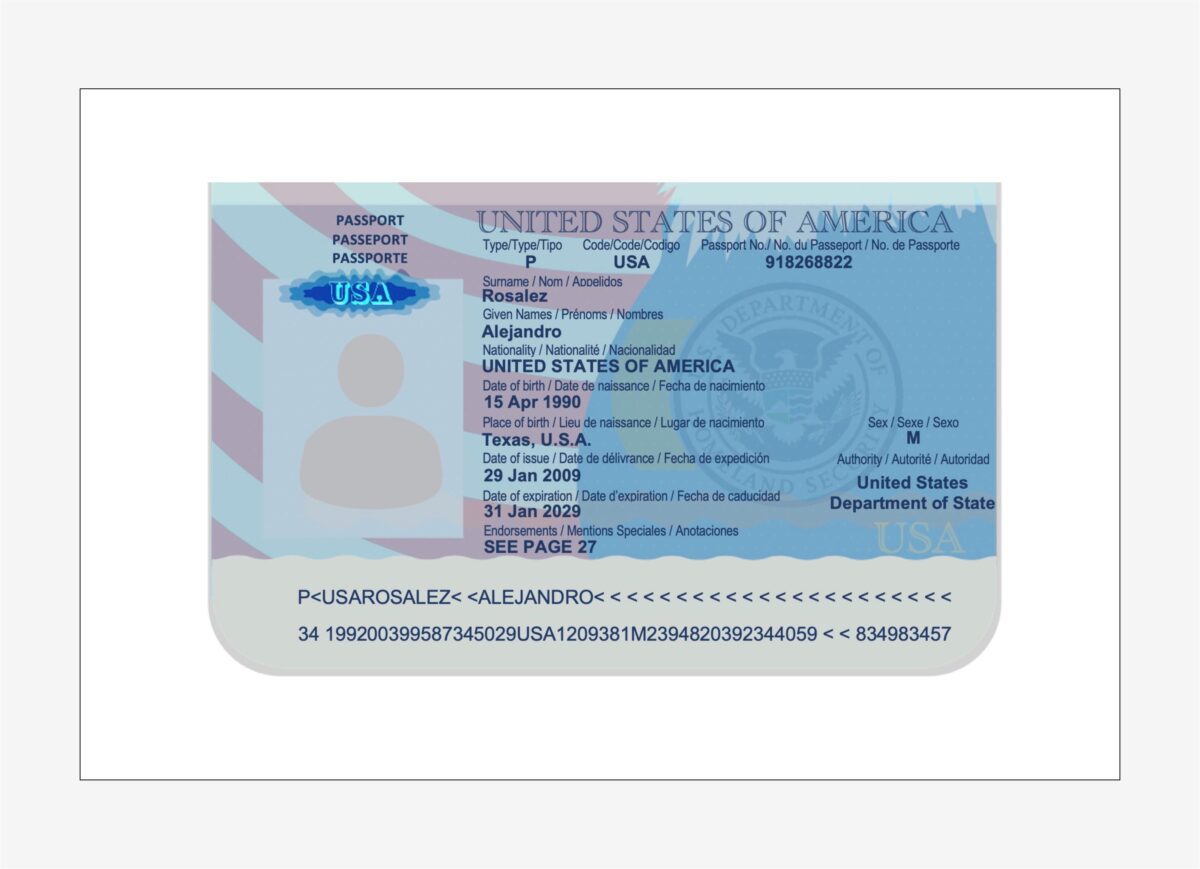

Udtræk data fra et amerikansk pas

Amazon Textract analysere identitetspapirer kapacitet kan opdage og udtrække information fra USA-baserede ID-dokumenter såsom et kørekort og pas. Det AnalyzeID API er i stand til at detektere og fortolke underforståede felter i ID-dokumenter, hvilket gør det nemt at udtrække specifik information fra dokumentet. Identitetsdokumenter er næsten altid en del af en låneansøgningspakke, fordi det bruges til at verificere låntagerens identitet under tegningsprocessen og til at validere rigtigheden af låntagerens biografiske data.

Vi bruger en bekvemmelighedsmetode ved navn call_textract_analyzeid, som kalder AnalyzeID API internt. Vi gentager derefter svaret for at få de detekterede nøgleværdi-par fra ID-dokumentet. Se følgende kode:

AnalyzeID returnerer information i en struktur kaldet IdentityDocumentFields, som indeholder de normaliserede nøgler og deres tilsvarende værdi. For eksempel i følgende output, FIRST_NAME er en normaliseret nøgle, og værdien er ALEJANDRO. I eksemplet med pasbilledet er feltet for fornavnet mærket som "Fornavne / Prénoms / Nombre", dog AnalyzeID var i stand til at normalisere det til nøglenavnet FIRST_NAME. Se en liste over understøttede normaliserede felter Identitetsdokumentation Svarobjekter.

En pantepakke kan indeholde flere andre dokumenter, såsom en lønseddel, W2-formular, kontoudtog, kreditkortudtog og ansættelsesbekræftelsesbrev. Vi har eksempler på hvert af disse dokumenter sammen med den nødvendige kode for at udtrække data fra dem. For den komplette kodebase, tjek notesbøgerne i vores GitHub repository.

Dokument berigelse

En af de mest almindelige former for dokumentberigelse er redaktion af følsomme eller fortrolige oplysninger på dokumenter, som kan være påbudt på grund af love eller regler om privatlivets fred. For eksempel kan en låneansøgers lønseddel indeholde følsomme PII-data, såsom navn, adresse og SSN, der muligvis skal redigeres for udvidet opbevaring.

I det foregående prøveudbetalingsdokument udfører vi redaktion af PII-data såsom SSN, navn, bankkontonummer og datoer. For at identificere PII-data i et dokument bruger vi Amazon Comprehend PII-detektion kapacitet via DetectPIIEntities API. Denne API inspicerer indholdet af dokumentet for at identificere tilstedeværelsen af PII-oplysninger. Fordi denne API kræver input i UTF-8-kodet almindeligt tekstformat, udtrækker vi først teksten fra dokumentet ved hjælp af Amazon Textract DetectDocumentText API, som returnerer teksten fra dokumentet og også returnerer geometriinformation såsom afgrænsningsrammens dimensioner og koordinater. En kombination af begge output bruges derefter til at tegne redaktioner på dokumentet som en del af berigelsesprocessen.

Gennemgå, valider og integrer data

Udtrukne data fra dokumentudtrækningsfasen kan have behov for validering i forhold til specifikke forretningsregler. Specifikke oplysninger kan også valideres på tværs af flere dokumenter, også kendt som cross-doc validering. Et eksempel på cross-doc validering kunne være at sammenligne ansøgers navn i ID-dokumentet med navnet i realkreditansøgningsdokumentet. Du kan også foretage andre valideringer såsom ejendomsværdivurderinger og betingede tegningsbeslutninger i denne fase.

En tredje type validering er relateret til konfidensscore for de udtrukne data i dokumentudtrækningsfasen. Amazon Textract og Amazon Comprehend returnerer en tillidsscore for formularer, tabeller, tekstdata og registrerede enheder. Du kan konfigurere en konfidensscoretærskel for at sikre, at kun korrekte værdier sendes nedstrøms. Dette opnås via Amazon A2I, som sammenligner konfidensscorerne for detekterede data med en foruddefineret konfidensgrænse. Hvis tærsklen ikke er opfyldt, sendes dokumentet og det udtrukne output til et menneske til gennemsyn gennem en intuitiv brugergrænseflade. Granskeren foretager korrigerende handlinger på dataene og gemmer dem til videre behandling. For mere information, se Kernekoncepter for Amazon A2I.

Konklusion

I dette indlæg diskuterede vi faserne af intelligent dokumentbehandling, som det vedrører faser af en realkreditansøgning. Vi har set på et par almindelige eksempler på dokumenter, der kan findes i en pantansøgningspakke. Vi diskuterede også måder at udtrække og behandle struktureret, semistruktureret og ustruktureret indhold fra disse dokumenter. IDP giver en måde at automatisere ende-til-ende realkreditdokumentbehandling, der kan skaleres til millioner af dokumenter, hvilket forbedrer kvaliteten af ansøgningsbeslutninger, reducerer omkostningerne og betjener kunderne hurtigere.

Som et næste trin kan du prøve kodeeksemplerne og notesbøgerne i vores GitHub repository. For at lære mere om, hvordan IDP kan hjælpe din dokumentbehandlingsarbejdsbelastning, besøg Automatiser databehandling fra dokumenter.

Om forfatterne

Anjan Biswas er Senior AI Services Solutions Architect med fokus på AI/ML og Data Analytics. Anjan er en del af det verdensomspændende AI-serviceteam og arbejder med kunder for at hjælpe dem med at forstå og udvikle løsninger på forretningsproblemer med AI og ML. Anjan har over 14 års erfaring med at arbejde med globale forsyningskæder, fremstillings- og detailorganisationer og hjælper aktivt kunder med at komme i gang og skalere på AWS AI-tjenester.

Anjan Biswas er Senior AI Services Solutions Architect med fokus på AI/ML og Data Analytics. Anjan er en del af det verdensomspændende AI-serviceteam og arbejder med kunder for at hjælpe dem med at forstå og udvikle løsninger på forretningsproblemer med AI og ML. Anjan har over 14 års erfaring med at arbejde med globale forsyningskæder, fremstillings- og detailorganisationer og hjælper aktivt kunder med at komme i gang og skalere på AWS AI-tjenester.

Dwiti Pathak er en Senior Technical Account Manager baseret i San Diego. Hun er fokuseret på at hjælpe halvlederindustrien med at engagere sig i AWS. I sin fritid kan hun godt lide at læse om nye teknologier og spille brætspil.

Dwiti Pathak er en Senior Technical Account Manager baseret i San Diego. Hun er fokuseret på at hjælpe halvlederindustrien med at engagere sig i AWS. I sin fritid kan hun godt lide at læse om nye teknologier og spille brætspil.

Balaji Puli er en løsningsarkitekt baseret i Bay Area, CA. Hjælper i øjeblikket udvalgte sundhedsvidenskabelige kunder i det nordvestlige USA med at accelerere deres AWS-cloudoptagelse. Balaji nyder at rejse og elsker at udforske forskellige køkkener.

Balaji Puli er en løsningsarkitekt baseret i Bay Area, CA. Hjælper i øjeblikket udvalgte sundhedsvidenskabelige kunder i det nordvestlige USA med at accelerere deres AWS-cloudoptagelse. Balaji nyder at rejse og elsker at udforske forskellige køkkener.

- Avanceret (300)

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon Comprehend

- amazontekst

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet