Quest 3-udviklere kan nu integrere tre store nye funktioner for at forbedre både virtuel og blandet virkelighed.

Inside-Out Body Tracking (IOBT) og Generative Legs var annonceret sammen med Quest 3 som kommer i december. Okklusion for blandet virkelighed via Depth API var tidligere et eksperimentelt indslag, hvilket betyder, at udviklere kunne teste det, men ikke kunne sende det i Quest Store eller App Lab builds.

Alle tre funktioner er nu tilgængelige som en del af v60 SDK for Unity og indbygget kode. I mellemtiden inkluderer v60 Unreal Engine-integrationen Depth API, men ikke IOBT eller Generative Legs.

Inside-Out Overkrop Tracking

Inside-Out Body Tracking (IOBT) bruger Quest 3's sidekameraer, som vender nedad, til at spore dit håndled, albuer, skulder og torso ved hjælp af avancerede computersynsalgoritmer.

IOBT forhindrer problemerne med invers kinematik (IK) estimerede arme, som ofte er forkerte og føles ubehagelige, fordi systemet bare foretager gæt ud fra placeringen af dit hoved og dine hænder. Når udviklere integrerer IOBT, vil du se dine arme og toro i deres faktiske positioner – ikke et skøn.

Denne overkropsporing lader udviklere også forankre bevægelse af tommelfingeren til din kropsretning, ikke kun dit hoved eller dine hænder, og du kan udføre nye handlinger som at læne dig over en afsats og få dette show realistisk på din avatar.

AI Generative Ben

IOBT virker kun for din overkrop. Til din underkrop har Meta lanceret Generative Legs.

Generative Legs bruger en "banebrydende" AI-model til at estimere dine benpositioner - en teknologi, virksomheden har været forsket i årevis.

På Quest 3 leverer Generative Legs et mere realistisk estimat end tidligere headsets takket være at bruge overkropsporing som input, men det virker også på Quest Pro og Quest 2 ved kun at bruge hoved og hænder.

Generative Legs-systemet er dog kun en estimator, og sporer ikke, så selvom det kan registrere hop og huk, opfanger det ikke mange faktiske bevægelser som at hæve dine knæ.

Tilsammen muliggør sporing af overkroppen indefra og ud og Generative Legs plausible helkroppe i VR, kaldet Full Body Synthesis, uden ekstern hardware.

Meta har tidligere annonceret, at Full Body Synthesis kommer til Supernatural, Swordsman VR og Drunken Bar Fight.

Dybde API til okklusion i blandet virkelighed

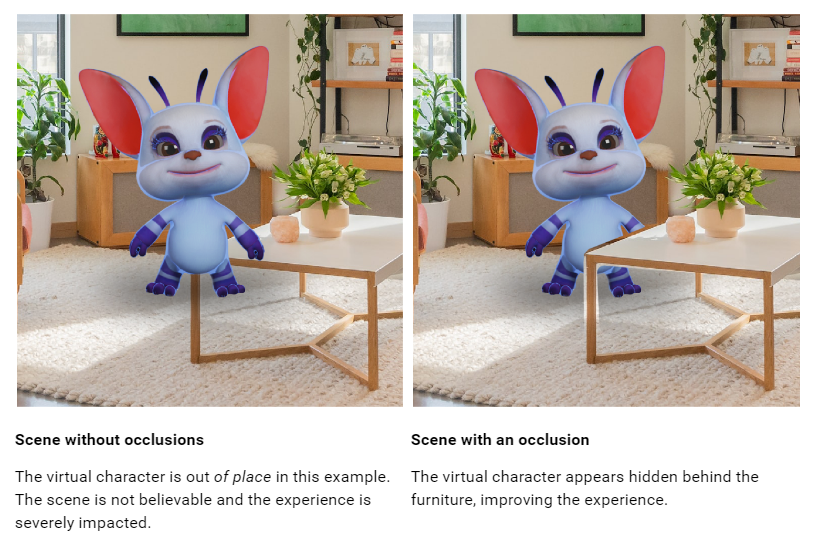

In vores Quest 3 anmeldelse vi kritiserede hårdt manglen på mixed reality dynamisk okklusion. Mens virtuelle objekter kan dukke op bag det rå Scene Mesh, der er genereret af rumopsætningsscanningen, vises de altid foran bevægelige objekter såsom dine arme og andre mennesker, selvom de er længere væk, hvilket ser skurrende og unaturligt ud.

Udviklere kunne allerede implementere dynamisk okklusion for dine hænder ved at bruge Hand Tracking mesh, men få gjorde det, fordi dette skærer af ved dit håndled, så resten af din arm ikke er inkluderet.

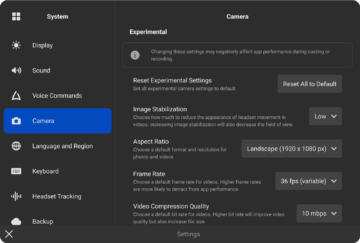

Den nye Depth API giver udviklere et per-frame groft dybdekort genereret af headsettet fra dets synspunkt. Dette kan bruges til at implementere okklusion, både til objekter i bevægelse og til finere detaljer om statiske objekter, da disse muligvis ikke er blevet fanget i Scene Mesh.

Dynamisk okklusion skulle få blandet virkelighed på Quest 3 til at se mere naturligt ud. Headsettets dybdefølende opløsning er dog meget lav, så den ikke opfanger detaljer som mellemrummene mellem dine fingre, og du vil se et tomt hul rundt om objekternes kanter.

Dybdekortet foreslås også kun at blive udnyttet til 4 meter, hvorefter "nøjagtigheden falder betydeligt", så udviklere vil måske også bruge Scene Mesh til statisk okklusion.

Der er to måder, udviklere kan implementere okklusion på: hård og blød. Hard er stort set gratis, men har takkede kanter, mens Soft har en GPU-pris, men ser bedre ud. Ser man på Metas eksempelklip, er det svært at forestille sig, at nogen udvikler vil vælge Hard.

I begge tilfælde kræver okklusion dog at bruge Metas specielle okklusionsskyggere eller specifikt implementere det i dine brugerdefinerede shaders. Det er langt fra en et-klik-løsning og vil sandsynligvis være en betydelig indsats for udviklere at understøtte.

Ud over okklusion kunne udviklere også bruge Depth API til at implementere dybdebaserede visuelle effekter i blandet virkelighed, såsom tåge.

UploadVR-test Dybde API-okklusion.

Du kan finde dokumentationen vedr Sammenhold her og for Uvirkeligt her. Bemærk, at dokumentationen endnu ikke er blevet opdateret, så den afspejler den offentlige udgivelse.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.uploadvr.com/quest-3-inside-out-upper-body-tracking-and-dynamic-occlusion/

- :har

- :er

- :ikke

- $OP

- 1

- 7

- a

- nøjagtighed

- aktioner

- faktiske

- fremskreden

- Efter

- AI

- algoritmer

- langs med

- allerede

- også

- altid

- an

- Anchor

- ,

- annoncerede

- enhver

- api

- app

- AppLab

- vises

- ER

- ARM

- arme

- omkring

- AS

- At

- til rådighed

- avatar

- væk

- Bar

- BE

- fordi

- været

- bag

- Bedre

- mellem

- organer

- krop

- Kropssporing

- både

- bygger

- men

- by

- kaldet

- kameraer

- CAN

- fanget

- tilfælde

- Vælg

- kode

- KOM

- Kom

- kommer

- selskab

- computer

- Computer Vision

- Konceptet

- Koste

- kunne

- couldn

- rå

- skik

- nedskæringer

- skære

- december

- leverer

- dybde

- beskrivelse

- detaljer

- opdage

- Udvikler

- udviklere

- DID

- retning

- Skærm

- dokumentation

- nedad

- Drops

- dynamisk

- Edge

- effekter

- indsats

- muliggøre

- Engine (Motor)

- væsentlige

- skøn

- anslået

- Endog

- eksempel

- eksperimenterende

- ekstern

- Ansigtet

- langt

- Funktionalitet

- føler sig

- få

- kæmpe

- Finde

- Tåge

- Til

- Gratis

- fra

- forsiden

- fuld

- yderligere

- kløft

- Generelt

- genereret

- generative

- giver

- GPU

- hånd

- håndsporing

- hænder

- Hård Ost

- Hardware

- Have

- hoved

- Headset

- headsets

- Men

- HTTPS

- if

- billede

- gennemføre

- gennemføre

- Forbedre

- in

- medtaget

- omfatter

- indgang

- integrere

- integration

- isn

- spørgsmål

- IT

- ITS

- jpg

- lige

- lab

- Mangel

- lanceret

- ben

- Lets

- gearede

- ligesom

- Sandsynlig

- ll

- placering

- Se

- leder

- UDSEENDE

- Lav

- lavere

- større

- lave

- Making

- mange

- kort

- Kan..

- betyder

- I mellemtiden

- mesh

- Meta

- blandet

- blandet virkelighed

- model

- mere

- bevægelser

- flytning

- mr

- indfødte

- Natural

- Ny

- Nye funktioner

- ingen

- Bemærk

- nu

- objekter

- Oculus

- of

- off

- tit

- on

- kun

- or

- Andet

- ud

- i løbet af

- del

- Mennesker

- Udfør

- pick

- plato

- Platon Data Intelligence

- PlatoData

- plausibel

- Punkt

- Synspunkt

- positioner

- forhindrer

- tidligere

- tidligere

- om

- offentlige

- Quest

- opdrag 2

- opdrag 3

- quest pro

- quest butik

- hæve

- realistisk

- Reality

- afspejler

- frigive

- Kræver

- Løsning

- REST

- Værelse

- s

- scanne

- scene

- SDK

- se

- setup

- SKIB

- bør

- Vis

- side

- signifikant

- betydeligt

- siden

- So

- Soft

- løsninger

- rum

- særligt

- specifikt

- statisk

- butik

- sådan

- overnaturlige

- support

- syntese

- systemet

- Teknologier

- prøve

- Test

- end

- Tak

- at

- deres

- de

- denne

- dem

- selvom?

- tre

- til

- spor

- Sporing

- to

- enhed

- Uvirkelig

- Unreal Engine

- opdateret

- UploadVR

- brug

- anvendte

- bruger

- ved brug af

- via

- Specifikation

- Virtual

- vision

- visuel

- vr

- ønsker

- var

- måder

- we

- GODT

- var

- hvornår

- som

- mens

- vilje

- med

- Vandt

- virker

- håndled

- endnu

- Du

- Din

- zephyrnet