Amazon SageMaker Data Wrangler hjælper dig med at forstå, aggregere, transformere og forberede data til maskinlæring (ML) fra en enkelt visuel grænseflade. Den indeholder over 300 indbyggede datatransformationer, så du hurtigt kan normalisere, transformere og kombinere funktioner uden at skulle skrive nogen kode.

Datavidenskabsudøvere genererer, observerer og behandler data for at løse forretningsproblemer, hvor de skal transformere og udtrække funktioner fra datasæt. Transformer såsom ordinær kodning eller one-hot-kodning lærer kodninger på dit datasæt. Disse kodede udgange omtales som trænede parametre. Da datasæt ændrer sig over tid, kan det være nødvendigt at tilpasse kodninger på tidligere usete data for at holde transformationsflowet relevant for dine data.

Vi er glade for at kunne annoncere funktionen til genoptræning af trænede parametre, som giver dig mulighed for at bruge tidligere trænede parametre og genmontere dem som ønsket. I dette indlæg viser vi, hvordan du bruger denne funktion.

Oversigt over Data Wrangler-genopbygningsfunktionen

Vi illustrerer, hvordan denne funktion fungerer, med det følgende eksempel, før vi dykker ned i detaljerne ved den genmonteringstrænede parameterfunktion.

Antag, at dit kundedatasæt har en kategorisk funktion til country repræsenteret som strenge som Australia , Singapore. ML-algoritmer kræver numeriske input; derfor skal disse kategoriske værdier kodes til numeriske værdier. Kodning af kategoriske data er processen med at skabe en numerisk repræsentation for kategorier. For eksempel hvis dit kategoriland har værdier Australia , Singapore, kan du indkode denne information i to vektorer: [1, 0] for at repræsentere Australia og [0, 1] for at repræsentere Singapore. Transformationen, der bruges her, er one-hot-kodning, og det nye kodede output afspejler de trænede parametre.

Efter træning af modellen kan dine kunder over tid stige, og du har mere tydelige værdier på landelisten. Det nye datasæt kunne indeholde en anden kategori, India, som ikke var en del af det originale datasæt, hvilket kan påvirke modellens nøjagtighed. Derfor er det nødvendigt at genoptræne din model med de nye data, der er blevet indsamlet over tid.

For at overvinde dette problem skal du opdatere kodningen for at inkludere den nye kategori og opdatere vektorrepræsentationen i henhold til dit seneste datasæt. I vores eksempel skal kodningen afspejle den nye kategori for country, Hvilket er India. Vi refererer almindeligvis til denne proces med at opdatere en kodning som en ombygningsoperation. Når du har udført ombygningsoperationen, får du den nye kodning: Australia: [1, 0, 0], Singapore: [0, 1, 0], og India: [0, 0, 1]. Gentilpasning af one-hot-kodningen og derefter genoptræning af modellen på det nye datasæt resulterer i forudsigelser af bedre kvalitet.

Data Wranglers genmonteringstrænede parameterfunktion er nyttig i følgende tilfælde:

- Nye data tilføjes til datasættet – Efteruddannelse af ML-modellen er nødvendig, når datasættet er beriget med nye data. For at opnå optimale resultater er vi nødt til at tilpasse de trænede parametre på det nye datasæt.

- Træning på et komplet datasæt efter at have udført funktionsudvikling på eksempeldata – For et stort datasæt overvejes en stikprøve af datasættet til indlæring af trænede parametre, som muligvis ikke repræsenterer hele dit datasæt. Vi skal genlære de trænede parametre på det komplette datasæt.

Følgende er nogle af de mest almindelige Data Wrangler-transformationer, der udføres på datasættet, og som drager fordel af muligheden for gentilpasset parameter:

For mere information om transformationer i Data Wrangler, se Transform data.

I dette indlæg viser vi, hvordan man behandler disse trænede parametre på datasæt ved hjælp af Data Wrangler. Du kan bruge Data Wrangler-flows i produktionsjob til at genbehandle dine data, efterhånden som de vokser og ændrer sig.

Løsningsoversigt

Til dette indlæg demonstrerer vi, hvordan du bruger Data Wrangler's refit-trænede parameterfunktion med det offentligt tilgængelige datasæt på Kaggle: Boligdata i USA fra Zillow, ejendomme til salg i USA. Det har boligsalgspriserne på tværs af forskellige geo-distributioner af boliger.

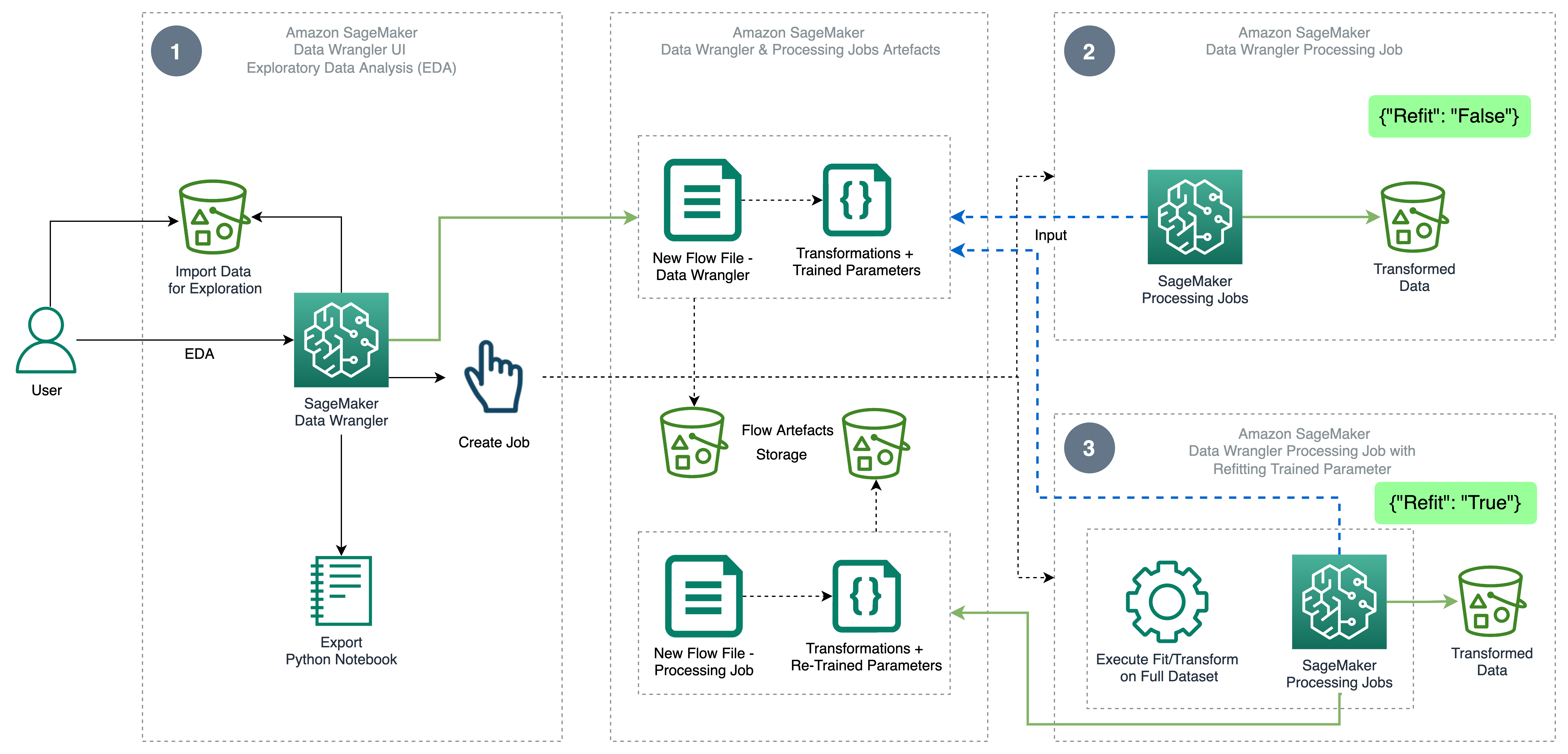

Følgende diagram illustrerer højniveau-arkitekturen i Data Wrangler ved hjælp af den genmonterede parameterfunktion. Vi viser også effekten på datakvaliteten uden den gentilrettelagte parameter og kontrasterer resultaterne til sidst.

Arbejdsgangen omfatter følgende trin:

- Udfør undersøgende dataanalyse – Opret et nyt flow på Data Wrangler for at starte den eksplorative dataanalyse (EDA). Importer virksomhedsdata for at forstå, rense, samle, transformere og forberede dine data til træning. Henvise til Udforsk Amazon SageMaker Data Wrangler-funktioner med eksempeldatasæt for flere detaljer om udførelse af EDA med Data Wrangler.

- Opret et databehandlingsjob – Dette trin eksporterer alle de transformationer, du har lavet på datasættet, som en flowfil gemt i det konfigurerede Amazon Simple Storage Service (Amazon S3) placering. Databehandlingsjobbet med flowfilen genereret af Data Wrangler anvender transformationerne og trænede parametre, der er lært på dit datasæt. Når databehandlingsjobbet er afsluttet, uploades outputfilerne til Amazon S3-lokationen, der er konfigureret i destinationsknuden. Bemærk, at ombygningsindstillingen er slået fra som standard. Som et alternativ til at udføre behandlingsopgaven øjeblikkeligt, kan du også planlægge et behandlingsjob med få klik ved hjælp af Data Wrangler – Opret job til at køre på bestemte tidspunkter.

- Opret et databehandlingsjob med genmonteringstrænede parameterfunktion – Vælg den nye gentilpassede parameterfunktion, mens du opretter jobbet for at gennemtvinge genindlæring af dine trænede parametre på dit fulde eller forstærkede datasæt. I henhold til Amazon S3-placeringskonfigurationen til lagring af flowfilen opretter eller opdaterer databehandlingsjobbet den nye flowfil. Hvis du konfigurerer den samme Amazon S3-placering som i trin 2, opdaterer databehandlingsjobbet flowfilen, der er genereret i trin 2, som kan bruges til at holde dit flow relevant for dine data. Når behandlingsjobbet er afsluttet, uploades outputfilerne til den destinationsknudekonfigurerede S3-bøtte. Du kan bruge det opdaterede flow på hele dit datasæt til et produktionsworkflow.

Forudsætninger

Før du går i gang, skal du uploade datasættet til en S3-bøtte og derefter importere det til Data Wrangler. For instruktioner, se Importer data fra Amazon S3.

Lad os nu gå gennem trinene nævnt i arkitekturdiagrammet.

Udfør EDA i Data Wrangler

For at afprøve den genindrettede parameterfunktion skal du konfigurere følgende analyse og transformation i Data Wrangler. I slutningen af opsætningen af EDA opretter Data Wrangler en flowfil, der er fanget med trænede parametre fra datasættet.

- Opret et nyt flow i Amazon SageMaker Data Wrangler til udforskende dataanalyse.

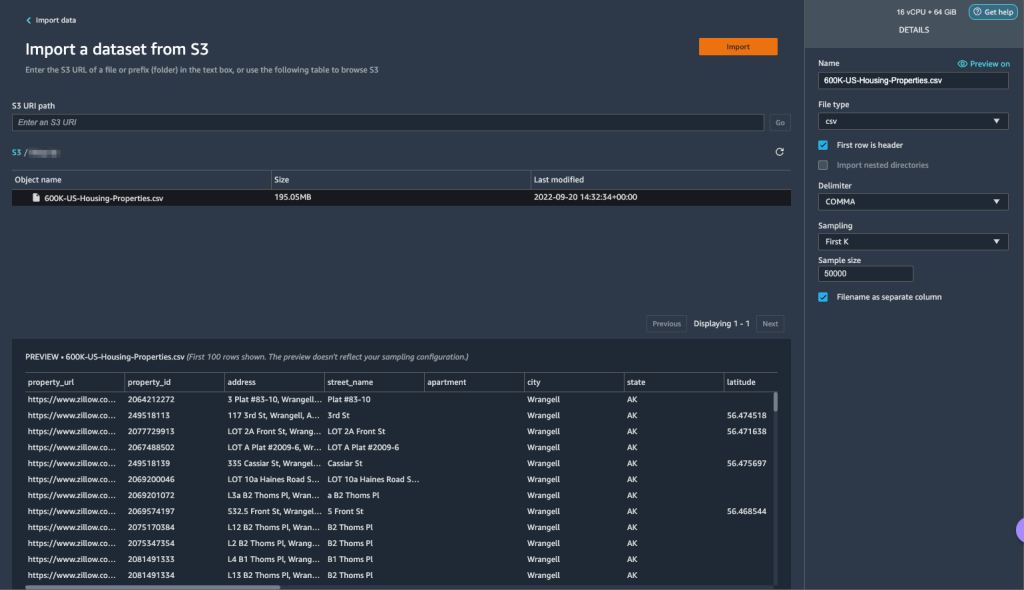

- Importer de virksomhedsdata, du har uploadet til Amazon S3.

- Du kan forhåndsvise dataene og mulighederne for at vælge filtype, afgrænsning, prøveudtagning og så videre. Til dette eksempel bruger vi Først K prøveudtagningsmulighed leveret af Data Wrangler til at importere de første 50,000 poster fra datasættet.

- Vælg Importere.

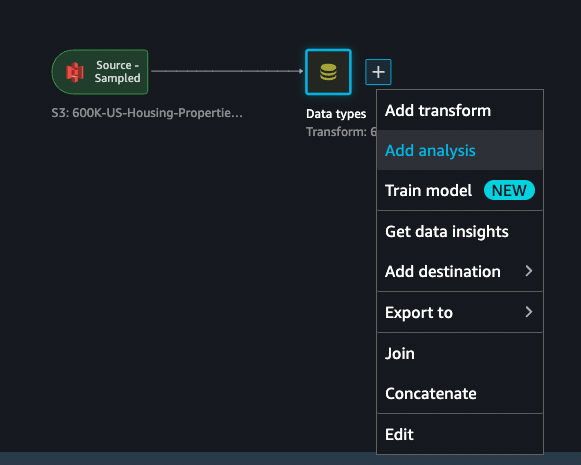

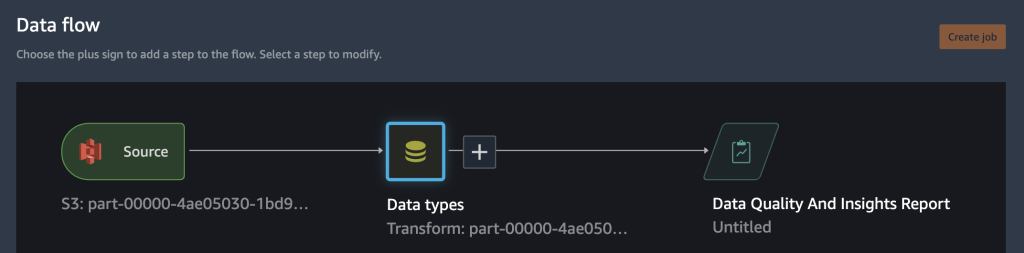

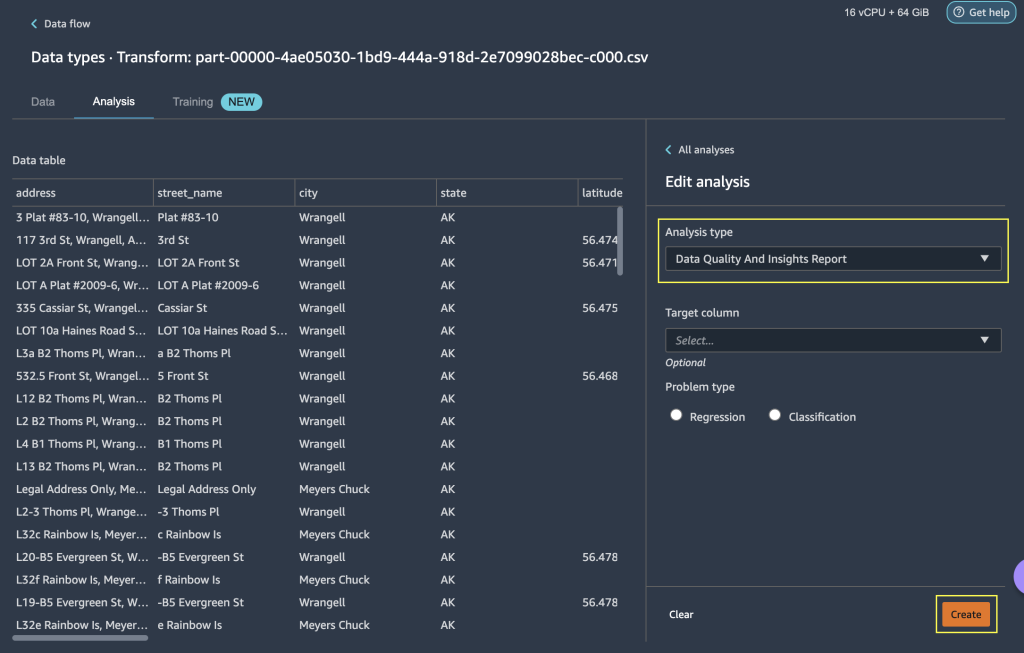

- Når du har tjekket datatypematchningen anvendt af Data Wrangler, skal du tilføje en ny analyse.

- Til Analyse type, vælg Rapport om datakvalitet og indsigt.

- Vælg Opret.

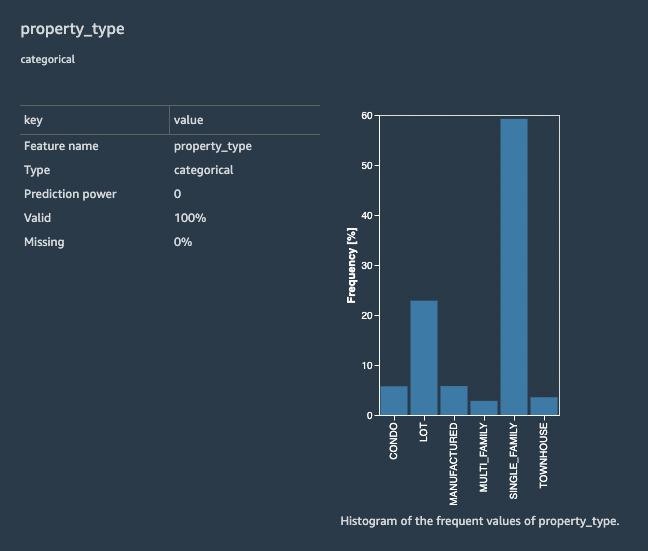

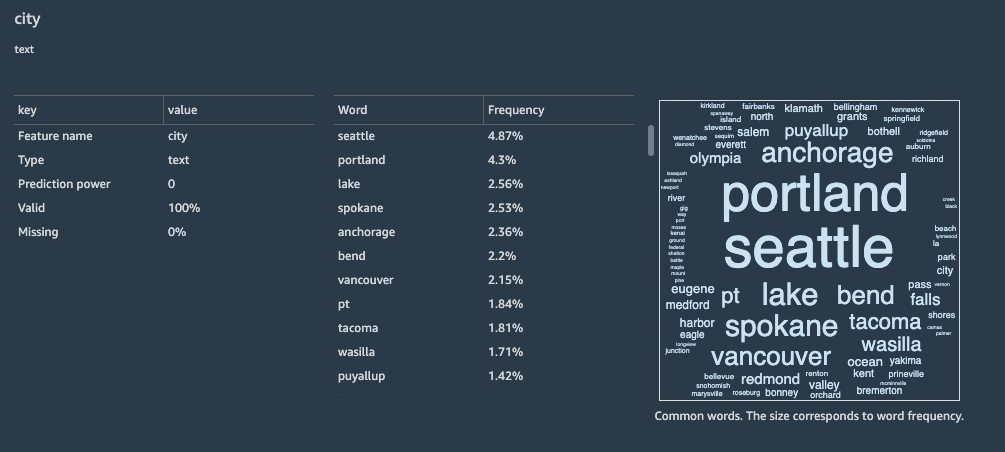

Med rapporten Datakvalitet og indsigt får du en kort oversigt over datasættet med generel information såsom manglende værdier, ugyldige værdier, funktionstyper, afvigende tællinger og mere. Du kan vælge funktioner property_type , city til at anvende transformationer på datasættet for at forstå den genindrettede parameterfunktion.

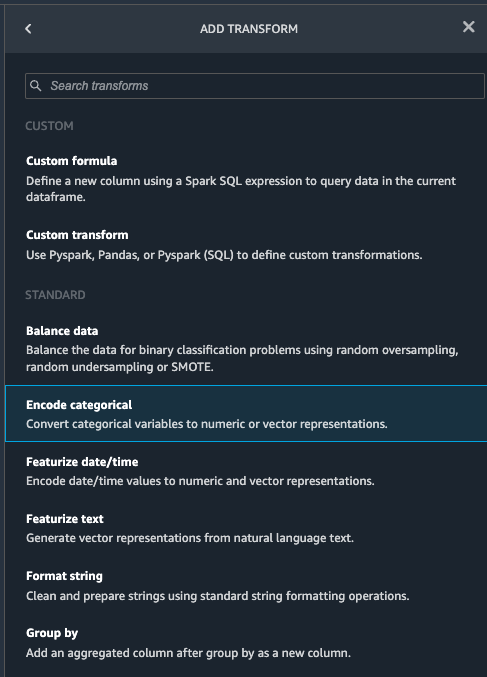

Lad os fokusere på funktionen property_type fra datasættet. I rapportens Funktionsdetaljer afsnittet, kan du se property_type, som er et kategorisk træk, og seks unikke værdier afledt af de 50,000 samplede datasæt af Data Wrangler. Det komplette datasæt kan have flere kategorier for funktionen property_type. For en funktion med mange unikke værdier foretrækker du måske ordinær kodning. Hvis funktionen har nogle få unikke værdier, kan en en-hot-kodningstilgang bruges. For dette eksempel vælger vi one-hot encoding på property_type.

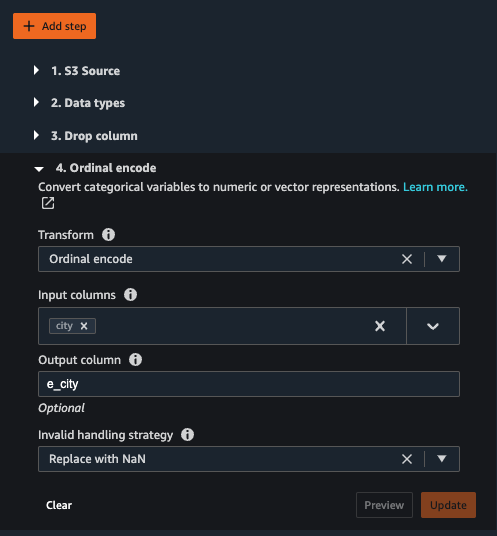

Tilsvarende for city feature, som er en tekstdatatype med et stort antal unikke værdier, lad os anvende ordinær kodning på denne funktion.

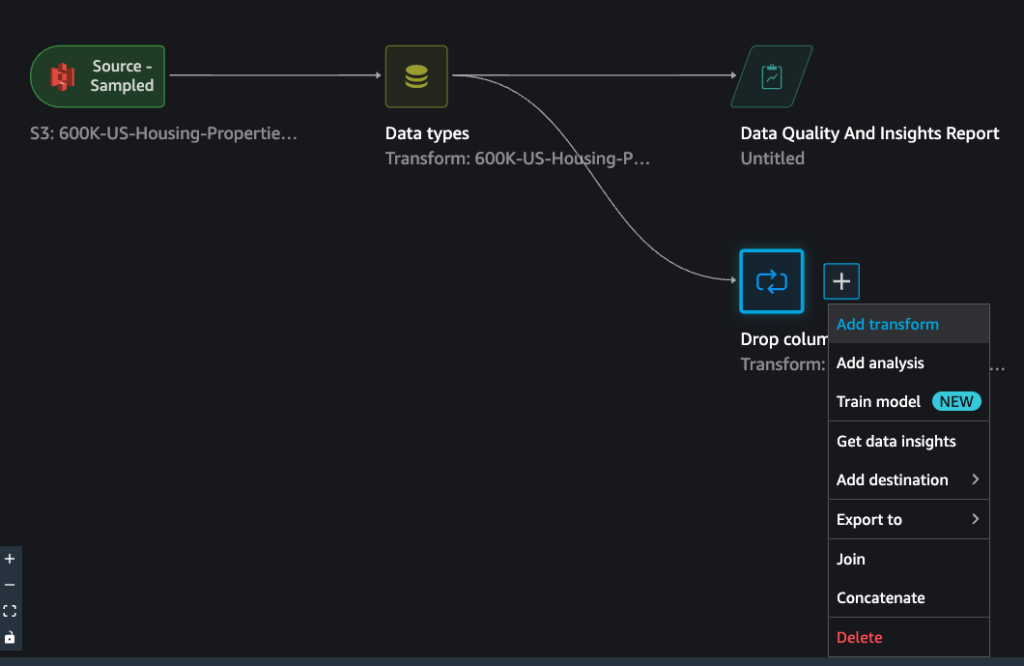

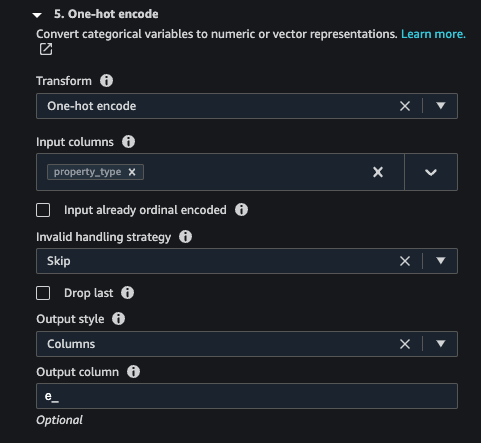

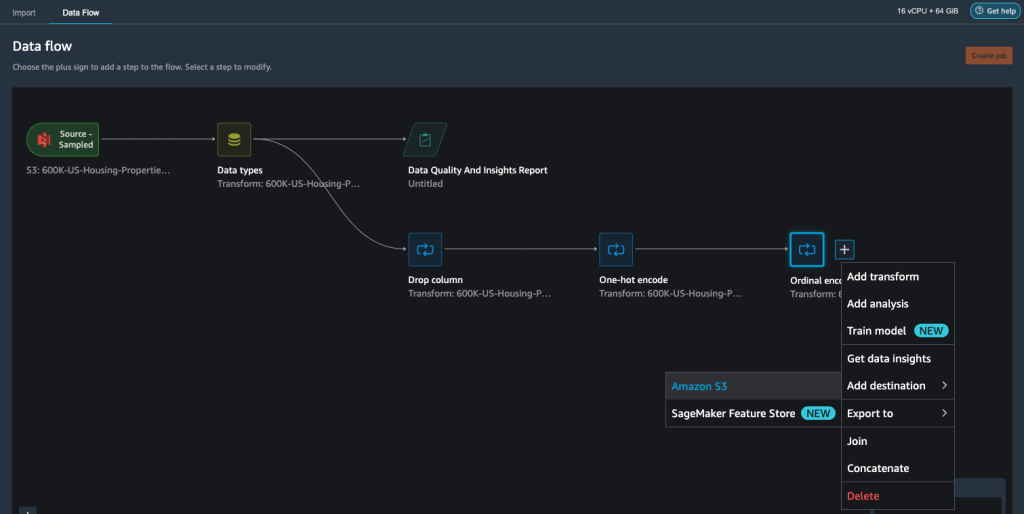

- Naviger til Data Wrangler-flowet, vælg plustegnet, og vælg Tilføj transformation.

- Vælg den Indkode kategorisk mulighed for at transformere kategoriske træk.

Fra rapporten Datakvalitet og indsigt, funktion property_type viser seks unikke kategorier: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILYog TOWNHOUSE.

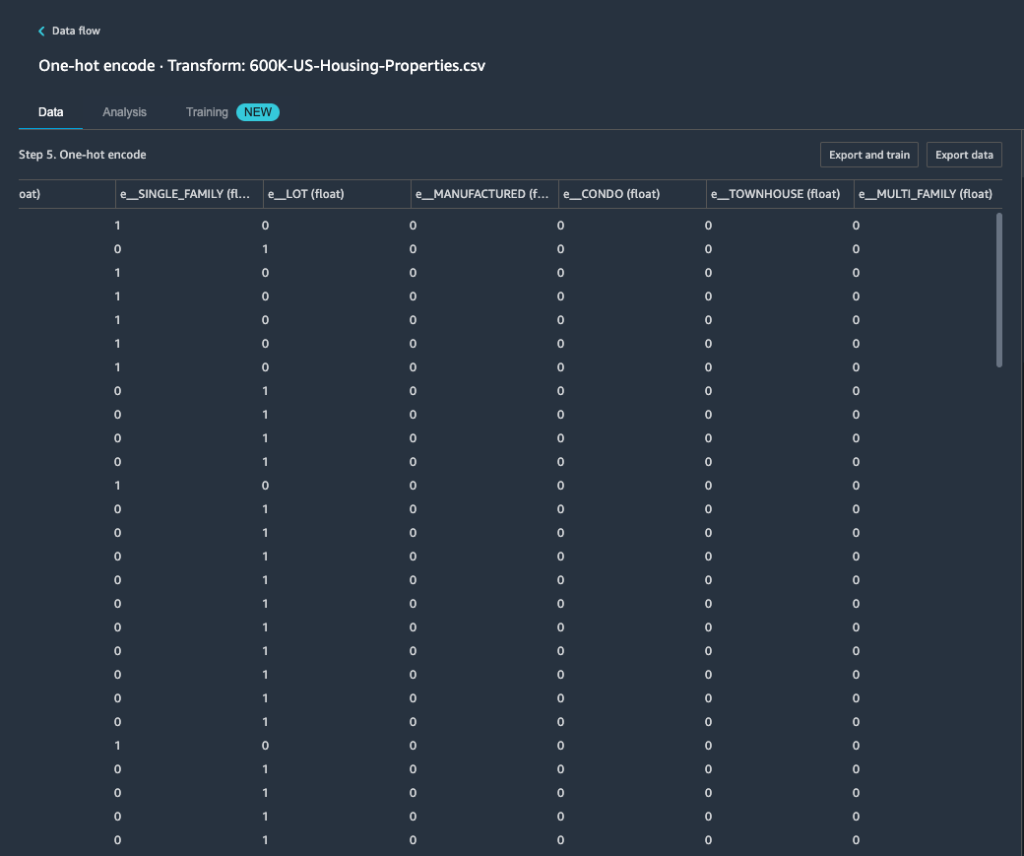

- Til Transform, vælg One-hot encode.

Efter at have anvendt one-hot encoding på funktionen property_type, kan du forhåndsvise alle seks kategorier som separate funktioner tilføjet som nye kolonner. Bemærk, at 50,000 poster blev samplet fra dit datasæt for at generere denne forhåndsvisning. Mens du kører et Data Wrangler-behandlingsjob med dette flow, anvendes disse transformationer på hele dit datasæt.

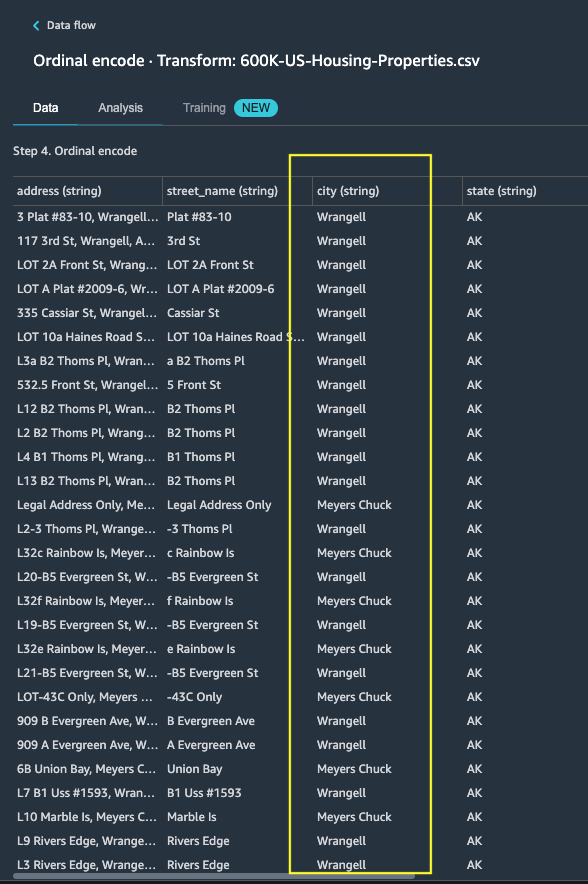

- Tilføj en ny transformation og vælg Indkode Kategorisk for at anvende en transformation på funktionen

city, som har et større antal unikke kategoriske tekstværdier. - Vælg for at indkode denne funktion til en numerisk repræsentation Ordinal indkodning forum Transform.

- Vælg Eksempel på denne transformation.

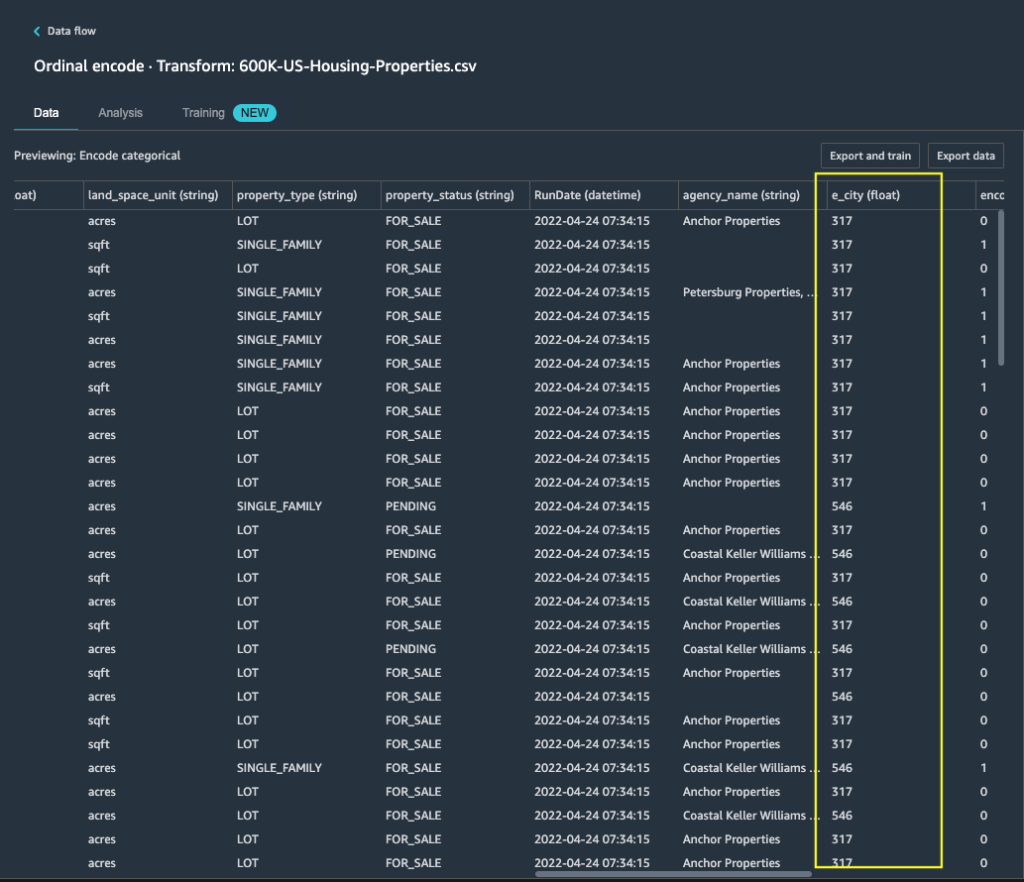

Du kan se, at den kategoriske funktion city er afbildet til ordensværdier i outputkolonnen e_city.

- Tilføj dette trin ved at vælge Opdatering.

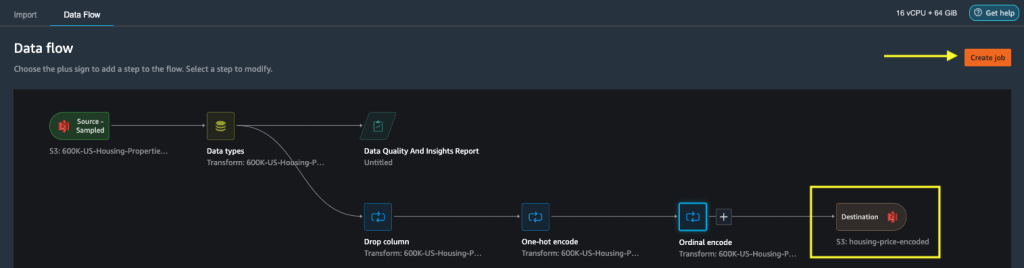

- Du kan indstille destinationen til Amazon S3 for at gemme de anvendte transformationer på datasættet for at generere output som CSV-fil.

Data Wrangler gemmer den arbejdsgang, du har defineret i brugergrænsefladen, som en flowfil og uploader til det konfigurerede databehandlingsjobs Amazon S3-placering. Denne flowfil bruges, når du opretter Data Wrangler-behandlingsjob for at anvende transformationerne på større datasæt eller til at transformere nye forstærkningsdata for at genoptræne modellen.

Start et Data Wrangler-databehandlingsjob uden gentilpasning aktiveret

Nu kan du se, hvordan ombygningsmuligheden bruger trænede parametre på nye datasæt. Til denne demonstration definerer vi to Data Wrangler-behandlingsjob, der opererer på de samme data. Det første behandlingsjob vil ikke aktivere genmontering; til det andet forarbejdningsjob bruger vi ombygning. Vi sammenligner effekterne til sidst.

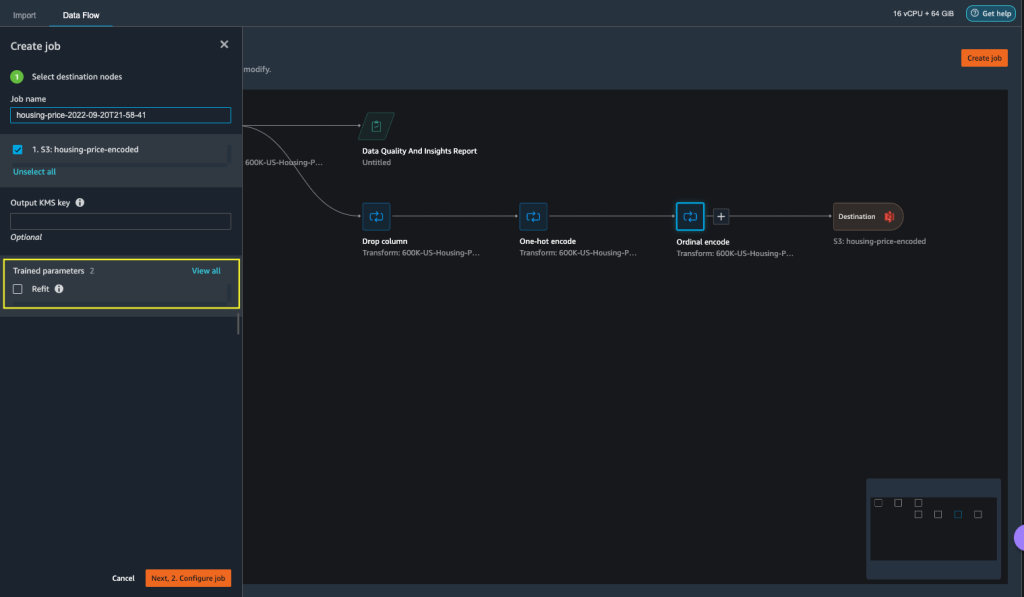

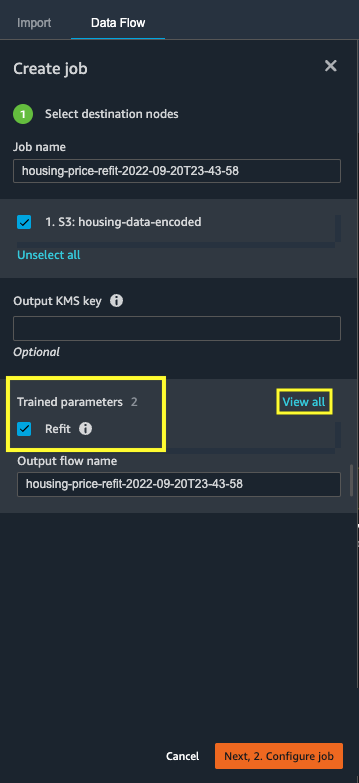

- Vælg Skab job at starte et databehandlingsjob med Data Wrangler.

- Til Job navn, indtast et navn.

- Under Trænede parametre, vælg ikke ombygning.

- Vælg Konfigurer job.

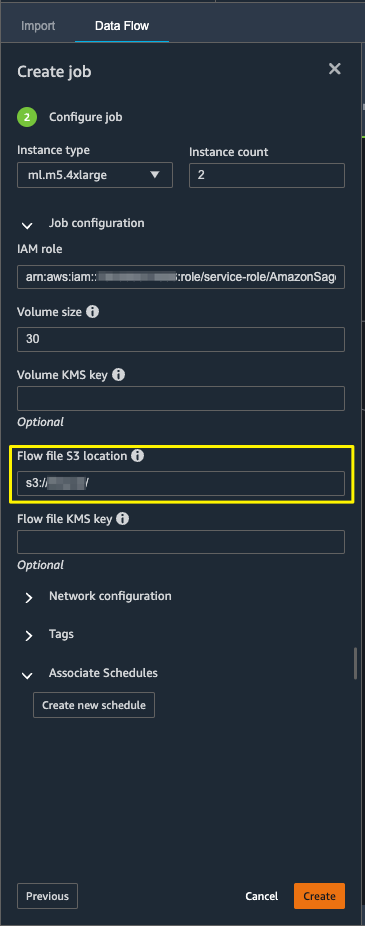

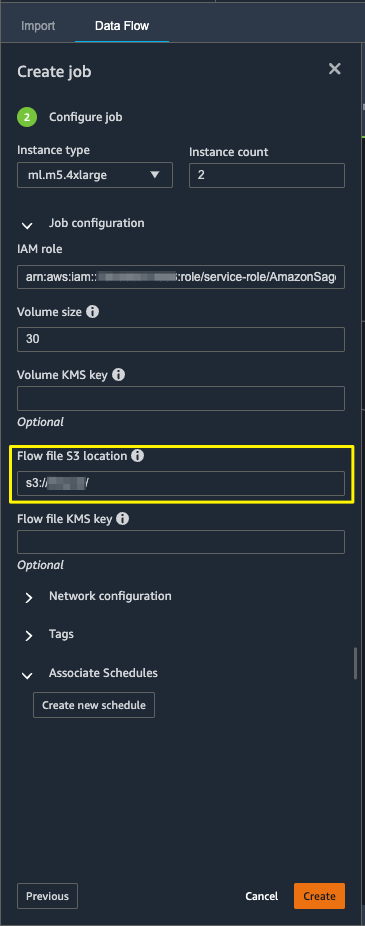

- Konfigurer jobparametrene som forekomsttyper, volumenstørrelse og Amazon S3-placering til lagring af outputflowfilen.

- Data Wrangler opretter en flowfil i flowfilen S3-placering. Flowet bruger transformationer til at træne parametre, og vi bruger senere refit-muligheden til at genoptræne disse parametre.

- Vælg Opret.

Vent på, at databehandlingsjobbet er fuldført for at se de transformerede data i S3-bøtten, der er konfigureret i destinationsknuden.

Start et Data Wrangler-databehandlingsjob med genopbygning aktiveret

Lad os oprette endnu et bearbejdningsjob aktiveret med genmonteringstrænede parameterfunktionen aktiveret. Denne mulighed håndhæver de trænede parametre, der genlæres på hele datasættet. Når dette databehandlingsjob er fuldført, oprettes eller opdateres en flowfil til den konfigurerede Amazon S3-placering.

- Vælg Skab job.

- Til Job navn, indtast et navn.

- Til Trænede parametre, Vælg ombygning.

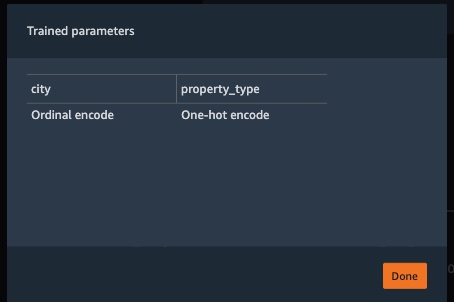

- Hvis du vælger Se alt, kan du gennemgå alle de trænede parametre.

- Vælg Konfigurer job.

- Indtast Amazon S3 flow-filens placering.

- Vælg Opret.

Vent på, at databehandlingsjobbet er fuldført.

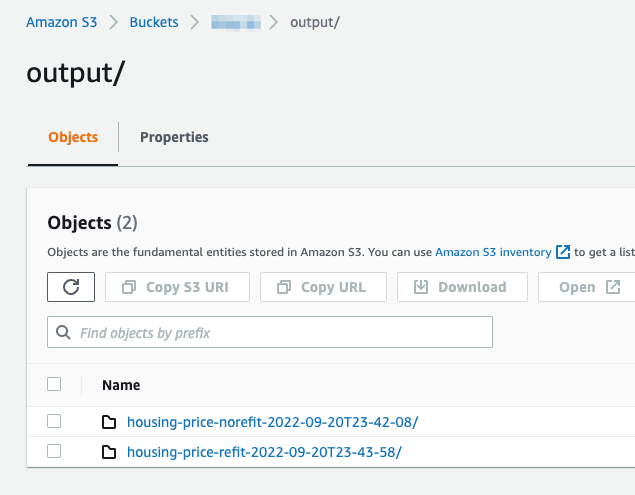

Se den konfigurerede S3-bucket i destinationsknuden for at se de data, der genereres af databehandlingsjobbet, der kører de definerede transformationer.

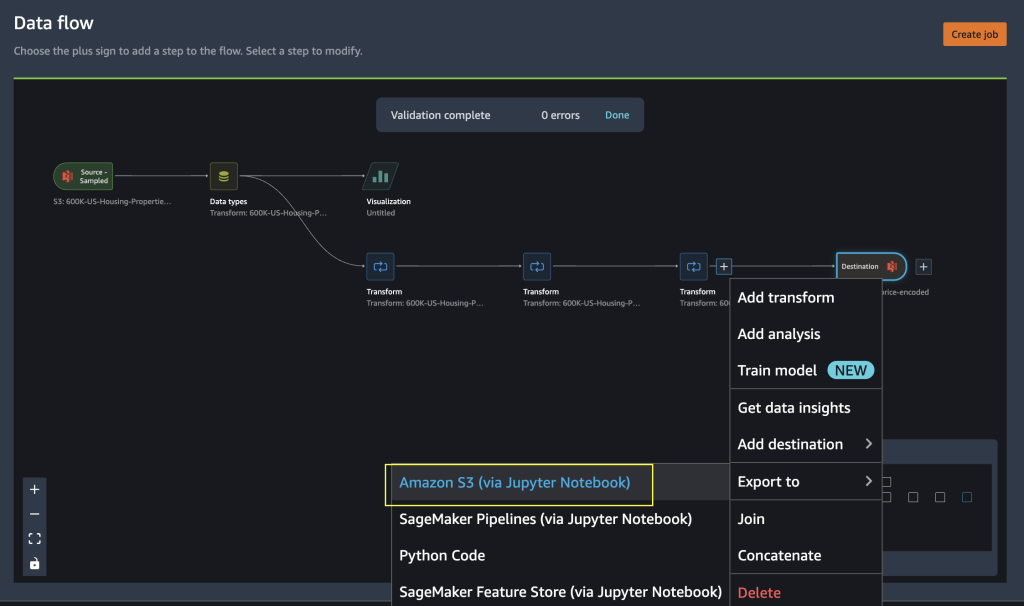

Eksporter til Python-kode for at køre Data Wrangler-behandlingsjob

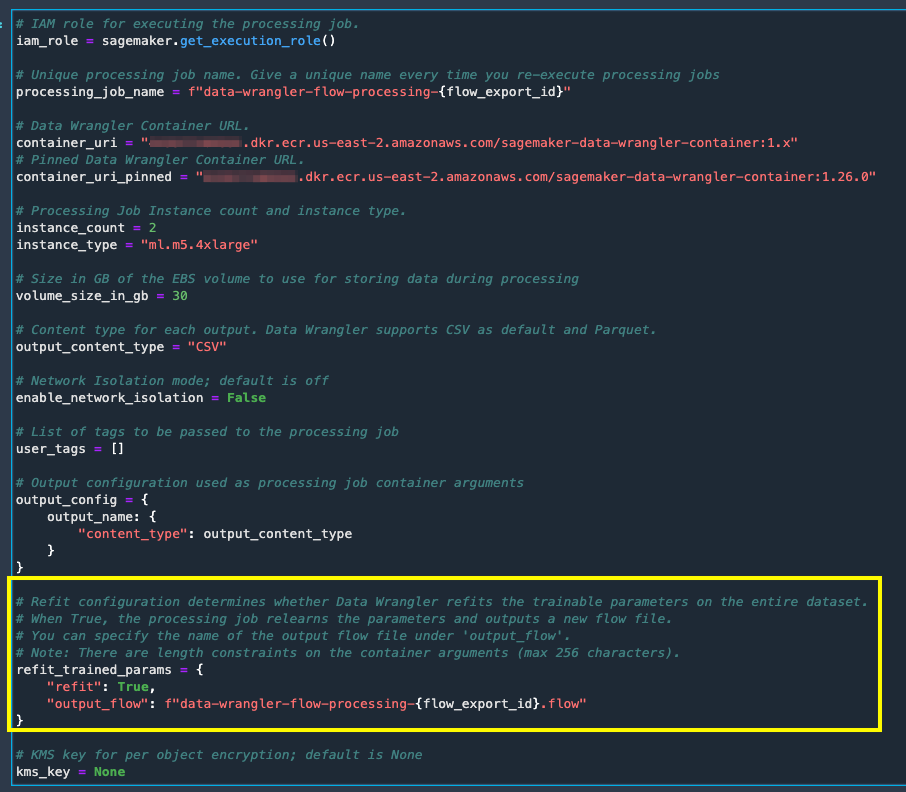

Som et alternativ til at starte behandlingsjob ved at bruge indstillingen Opret job i Data Wrangler, kan du udløse databehandlingsjob ved at eksportere Data Wrangler-flowet til en Jupyter-notesbog. Data Wrangler genererer en Jupyter-notebook med input, output, behandlingsjobkonfigurationer og kode til kontrol af jobstatus. Du kan ændre eller opdatere parametrene i henhold til dine datatransformationskrav.

- Vælg plustegnet ved siden af finalen Transform node.

- Vælg eksport til og Amazon S3 (Via Jupyter Notebook).

Du kan se en Jupyter-notebook åbnet med input, output, behandlingsjobkonfigurationer og kode til kontrol af jobstatus.

- For at håndhæve muligheden for genmontering af trænede parametre via kode, skal du indstille

refitparameter tilTrue.

Sammenlign resultater for databehandlingsjob

Sammenlign resultater for databehandlingsjob

Når Data Wrangler-bearbejdningsjobbene er fuldført, skal du oprette to nye Data Wrangler-flows med output genereret af databehandlingsjob, der er gemt i den konfigurerede Amazon S3-destination.

Du kan henvise til den konfigurerede placering i Amazon S3-destinationsmappen for at gennemgå databehandlingsjobnes output.

For at inspicere resultaterne af behandlingsjob skal du oprette to nye Data Wrangler-flows ved hjælp af rapporten Datakvalitet og indsigt til at sammenligne transformationsresultaterne.

- Opret et nyt flow i Amazon SageMaker Data Wrangler.

- Importer databehandlingsjobbet uden genmonteringsaktiveret outputfil fra Amazon S3.

- Tilføj en ny analyse.

- Til Analyse type, vælg Rapport om datakvalitet og indsigt.

- Vælg Opret.

Gentag ovenstående trin, og opret et nyt datawrangler-flow for at analysere databehandlingsjoboutputtet med gentilpasning aktiveret.

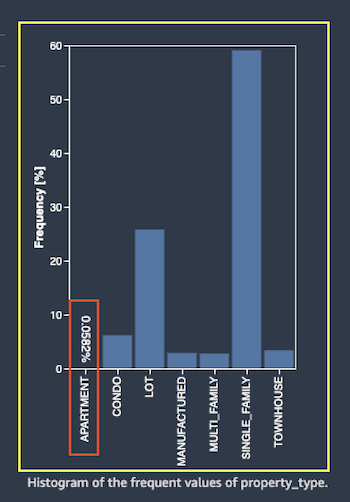

Lad os nu se på outputtet af behandlingsjob for funktionen property_type ved hjælp af datakvalitets- og indsigtsrapporterne. Rul til funktionsdetaljerne på listen over data- og indsigtsrapporter feature_type.

Arbejdet med genmontering af trænede parameterbehandling har genmonteret de trænede parametre på hele datasættet og kodet den nye værdi APARTMENT med syv forskellige værdier på det fulde datasæt.

Det normale behandlingsjob anvendte prøvedatasættet trænede parametre, som kun har seks forskellige værdier for property_type funktion. Til data med feature_type APARTMENT, ugyldig håndteringsstrategi Skip er anvendt, og databehandlingsjobbet lærer ikke denne nye kategori. One-hot-kodningen har sprunget over denne nye kategori på de nye data, og kodningen springer kategorien over APARTMENT.

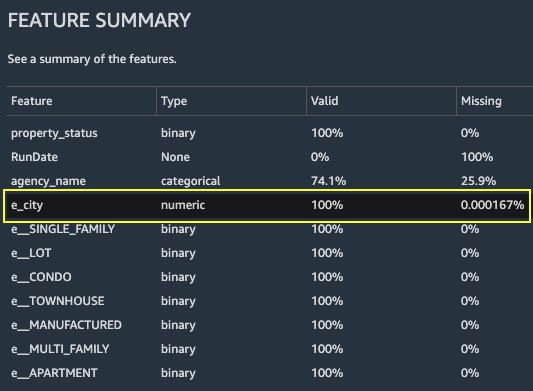

Lad os nu fokusere på en anden funktion, city. Det genoptrænede parameterbehandlingsjob har genlært alle de tilgængelige værdier for city funktion, i betragtning af de nye data.

Som vist i Funktionsoversigt afsnittet i rapporten, kolonnen med den nye kodede funktion e_city har 100 % gyldige parametre ved at bruge genmonteringstrænede parameterfunktion.

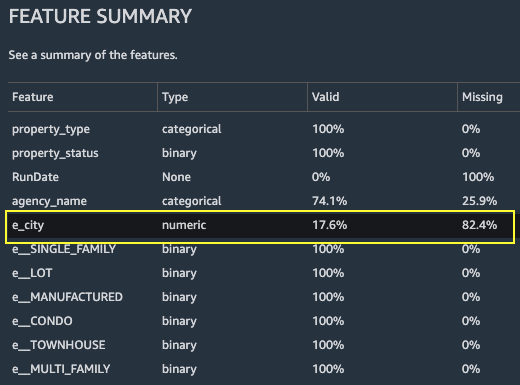

I modsætning hertil har det normale behandlingsjob 82.4 % af manglende værdier i den nye kodede funktionskolonne e_city. Dette fænomen skyldes, at kun prøvesættet af indlærte, trænede parametre anvendes på det fulde datasæt, og ingen gentilpasning anvendes af databehandlingsjobbet.

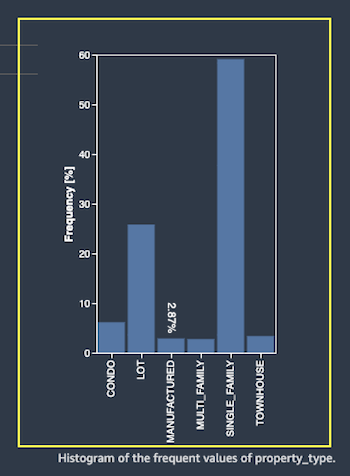

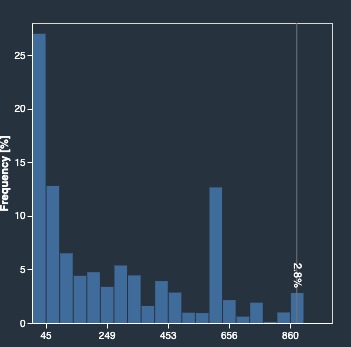

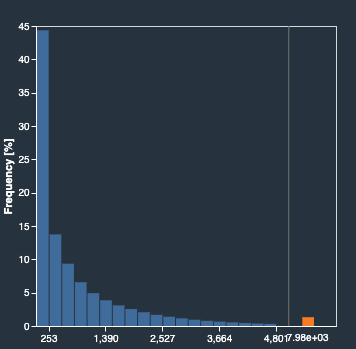

Følgende histogrammer viser den ordinalkodede funktion e_city. Det første histogram er af funktionen, der er transformeret med ombygningsmuligheden.

Det næste histogram er af funktionen, der er transformeret uden genmonteringsmuligheden. Den orange kolonne viser manglende værdier (NaN) i rapporten Datakvalitet og indsigt. De nye værdier, der ikke læres fra eksempeldatasættet, erstattes som Not a Number (NaN) som konfigureret i Data Wrangler UI's ugyldig håndteringsstrategi.

Databehandlingsjobbet med den ombygningstrænede parameter genlærte property_type , city funktioner i betragtning af de nye værdier fra hele datasættet. Uden den omfittrænede parameter bruger databehandlingsjobbet kun det samplede datasæts forudindlærte trænede parametre. Det anvender dem derefter på de nye data, men de nye værdier tages ikke i betragtning til kodning. Dette vil have betydning for modellens nøjagtighed.

Ryd op

Når du ikke bruger Data Wrangler, er det vigtigt at lukke den instans, den kører på, for at undgå at pådrage sig yderligere gebyrer.

For at undgå at miste arbejde skal du gemme dit dataflow, før du lukker Data Wrangler ned.

- For at gemme dit dataflow ind Amazon SageMaker Studio, vælg File (Felt), Og vælg derefter Gem data Wrangler Flow. Data Wrangler gemmer automatisk dit dataflow hvert 60. sekund.

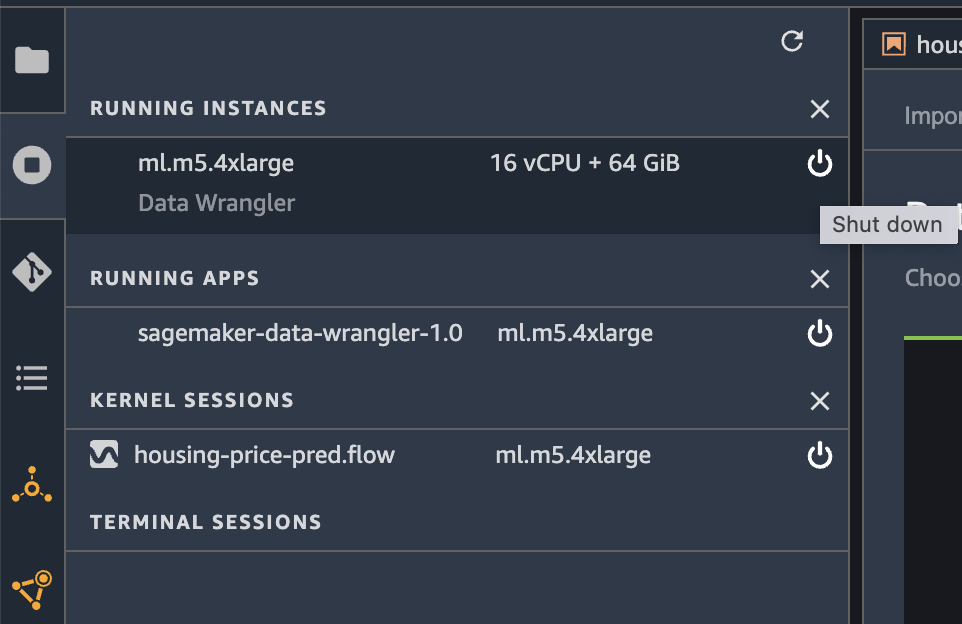

- For at lukke Data Wrangler-forekomsten ned i Studio skal du vælge Kører forekomster og kerner.

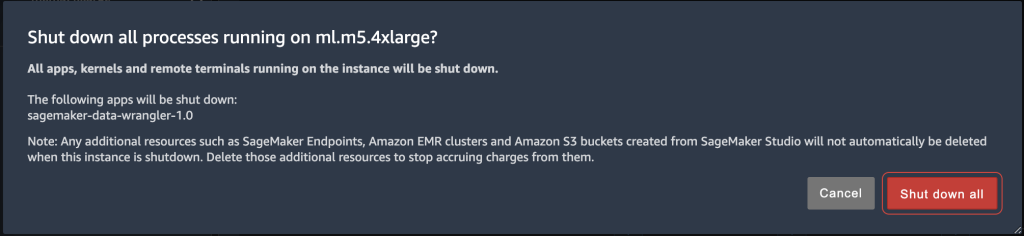

- Under KØRENDE APPS, skal du vælge nedlukningsikonet ud for sagemaker-data-wrangler-1.0-appen.

- Vælg Luk alt sammen at bekræfte.

Data Wrangler kører på en ml.m5.4xlarge instans. Denne instans forsvinder fra LØBENDE INSTANSER når du lukker Data Wrangler-appen ned.

Når du har lukket Data Wrangler-appen ned, skal den genstarte, næste gang du åbner en Data Wrangler-flowfil. Dette kan tage et par minutter.

Konklusion

I dette indlæg har vi givet et overblik over den genindrettede parameterfunktion i Data Wrangler. Med denne nye funktion kan du gemme de trænede parametre i Data Wrangler-flowet, og databehandlingsopgaverne bruger de trænede parametre til at anvende de indlærte transformationer på store datasæt eller forstærkningsdatasæt. Du kan anvende denne indstilling til vektorisering af tekstfunktioner, numeriske data og håndtering af outliers.

Bevarelse af trænede parametre gennem hele databehandlingen af ML-livscyklussen forenkler og reducerer databehandlingstrinnene, understøtter robust funktionsteknologi og understøtter modeltræning og forstærkningstræning på nye data.

Vi opfordrer dig til at prøve denne nye funktion til dine databehandlingskrav.

Om forfatterne

Hariharan Suresh er Senior Solutions Architect hos AWS. Han brænder for databaser, maskinlæring og design af innovative løsninger. Før han kom til AWS, var Hariharan produktarkitekt, specialist i implementering af kernebankvirksomhed og udvikler og arbejdede med BFSI-organisationer i over 11 år. Uden for teknologien nyder han paragliding og cykling.

Hariharan Suresh er Senior Solutions Architect hos AWS. Han brænder for databaser, maskinlæring og design af innovative løsninger. Før han kom til AWS, var Hariharan produktarkitekt, specialist i implementering af kernebankvirksomhed og udvikler og arbejdede med BFSI-organisationer i over 11 år. Uden for teknologien nyder han paragliding og cykling.

Santosh Kulkarni er en Enterprise Solutions Architect hos Amazon Web Services, der arbejder med sportskunder i Australien. Han brænder for at bygge store distribuerede applikationer til at løse forretningsproblemer ved at bruge sin viden inden for AI/ML, big data og softwareudvikling.

Santosh Kulkarni er en Enterprise Solutions Architect hos Amazon Web Services, der arbejder med sportskunder i Australien. Han brænder for at bygge store distribuerede applikationer til at løse forretningsproblemer ved at bruge sin viden inden for AI/ML, big data og softwareudvikling.

Vishaal Kapoor er en Senior Applied Scientist med AWS AI. Han brænder for at hjælpe kunder med at forstå deres data i Data Wrangler. I sin fritid cykler han, cykler på snowboard og bruger tid sammen med sin familie.

Vishaal Kapoor er en Senior Applied Scientist med AWS AI. Han brænder for at hjælpe kunder med at forstå deres data i Data Wrangler. I sin fritid cykler han, cykler på snowboard og bruger tid sammen med sin familie.

Aniketh Manjunath er softwareudviklingsingeniør hos Amazon SageMaker. Han hjælper med at støtte Amazon SageMaker Data Wrangler og brænder for distribuerede maskinlæringssystemer. Uden for arbejdet nyder han at vandre, se film og spille cricket.

Aniketh Manjunath er softwareudviklingsingeniør hos Amazon SageMaker. Han hjælper med at støtte Amazon SageMaker Data Wrangler og brænder for distribuerede maskinlæringssystemer. Uden for arbejdet nyder han at vandre, se film og spille cricket.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- Mellem (200)

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet