Introduktion

Inden for maskinlæring er bias-variance-afvejningen et grundlæggende koncept, der påvirker ydeevnen af enhver prædiktiv model. Det refererer til den delikate balance mellem bias-fejl og variansfejl i en model, da det er umuligt at minimere begge dele samtidigt. At finde den rigtige balance er afgørende for at opnå optimal modelydelse.

I denne korte artikel vil vi definere bias og varians, forklare, hvordan de påvirker en machine learning-model, og give nogle praktiske råd om, hvordan man håndterer dem i praksis.

Forstå bias og varians

Før vi dykker ned i forholdet mellem bias og varians, lad os definere, hvad disse termer repræsenterer i maskinlæring.

Bias error refererer til forskellen mellem forudsigelsen af en model og de korrekte værdier, den forsøger at forudsige (grundsandhed). Bias er med andre ord den fejl en model begår på grund af dens forkerte antagelser om den underliggende datafordeling. Modeller med høj bias er ofte for forsimplede og formår ikke at fange dataenes kompleksitet, hvilket fører til undertilpasning.

Variansfejl henviser derimod til modellens følsomhed over for små udsving i træningsdataene. Modeller med høj varians er alt for komplekse og har tendens til at passe til støjen i dataene snarere end det underliggende mønster, hvilket fører til overtilpasning. Dette resulterer i dårlig ydeevne på nye, usete data.

Høj bias kan føre til underfitting, hvor modellen er for simpel til at fange kompleksiteten af dataene. Det gør stærke antagelser om dataene og formår ikke at fange det sande forhold mellem input- og outputvariabler. På den anden side kan høj varians føre til overfitting, hvor modellen er for kompleks og lærer støjen i dataene frem for den underliggende sammenhæng mellem input- og outputvariable. Overfitting-modeller har således en tendens til at passe træningsdataene for tæt og vil ikke generalisere godt til nye data, mens underfitting-modeller ikke engang er i stand til at tilpasse træningsdataene nøjagtigt.

Som tidligere nævnt hænger bias og varians sammen, og en god model balancerer mellem biasfejl og variansfejl. Bias-variance trade-off er processen med at finde den optimale balance mellem disse to fejlkilder. En model med lav bias og lav varians vil sandsynligvis klare sig godt på både træning og nye data, hvilket minimerer den samlede fejl.

Afvejningen af bias-variance

At opnå en balance mellem modelkompleksitet og dens evne til at generalisere til ukendte data er kernen i bias-varians-afvejningen. Generelt vil en mere kompleks model have en lavere bias, men højere varians, mens en enklere model vil have en højere bias, men lavere varians.

Da det er umuligt samtidig at minimere bias og varians, er det afgørende at finde den optimale balance mellem dem for at opbygge en robust machine learning-model. For eksempel, når vi øger kompleksiteten af en model, øger vi også variansen. Dette skyldes, at en mere kompleks model er mere tilbøjelig til at passe til støjen i træningsdataene, hvilket vil føre til overfitting.

På den anden side, hvis vi holder modellen for simpel, vil vi øge skævheden. Dette skyldes, at en mere simpel model ikke vil være i stand til at fange de underliggende sammenhænge i dataene, hvilket vil føre til underfitting.

Målet er at træne en model, der er kompleks nok til at fange de underliggende sammenhænge i træningsdataene, men ikke så kompleks, at den passer til støjen i træningsdataene.

Bias-Variance Trade-Off i praksis

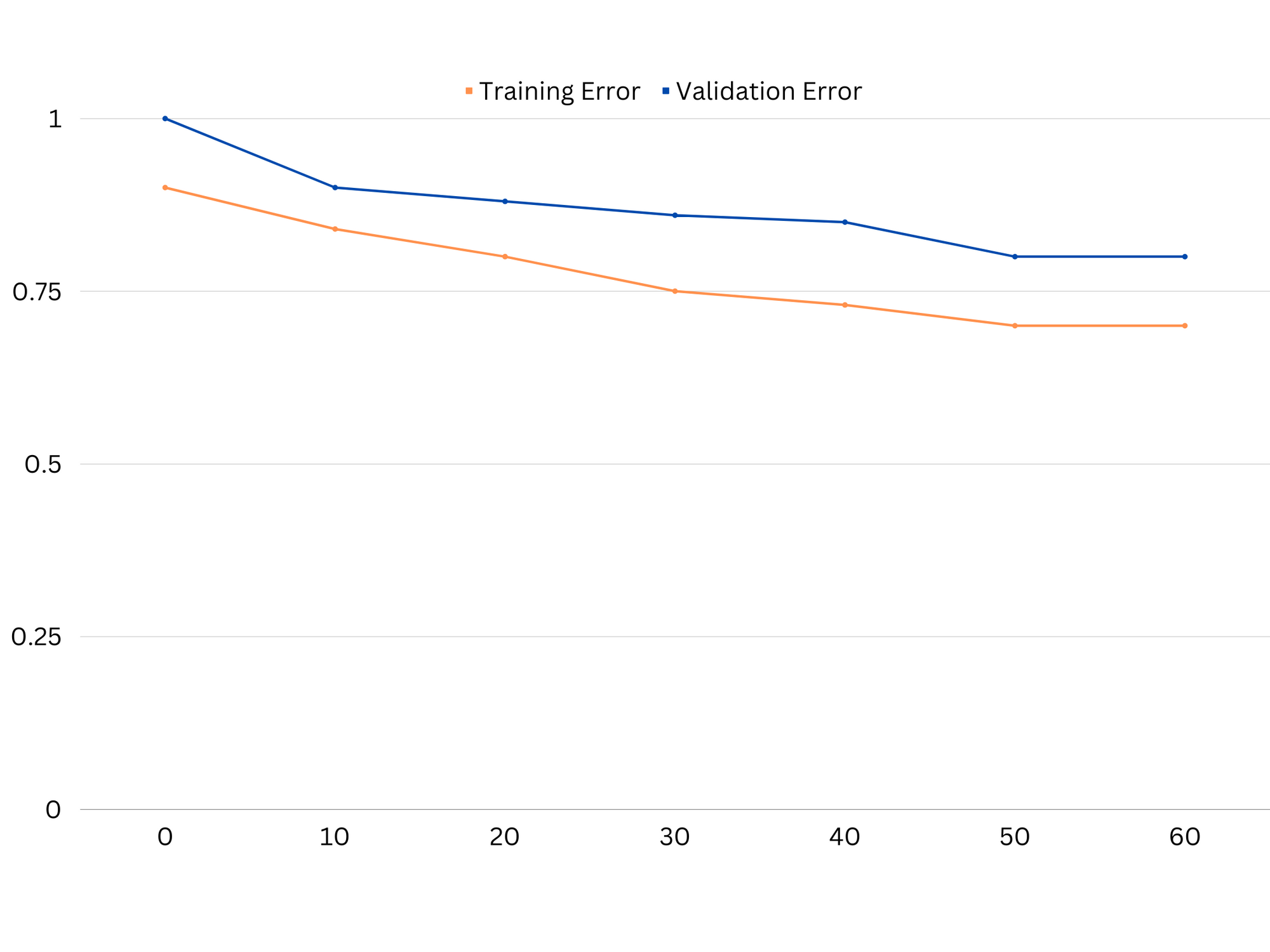

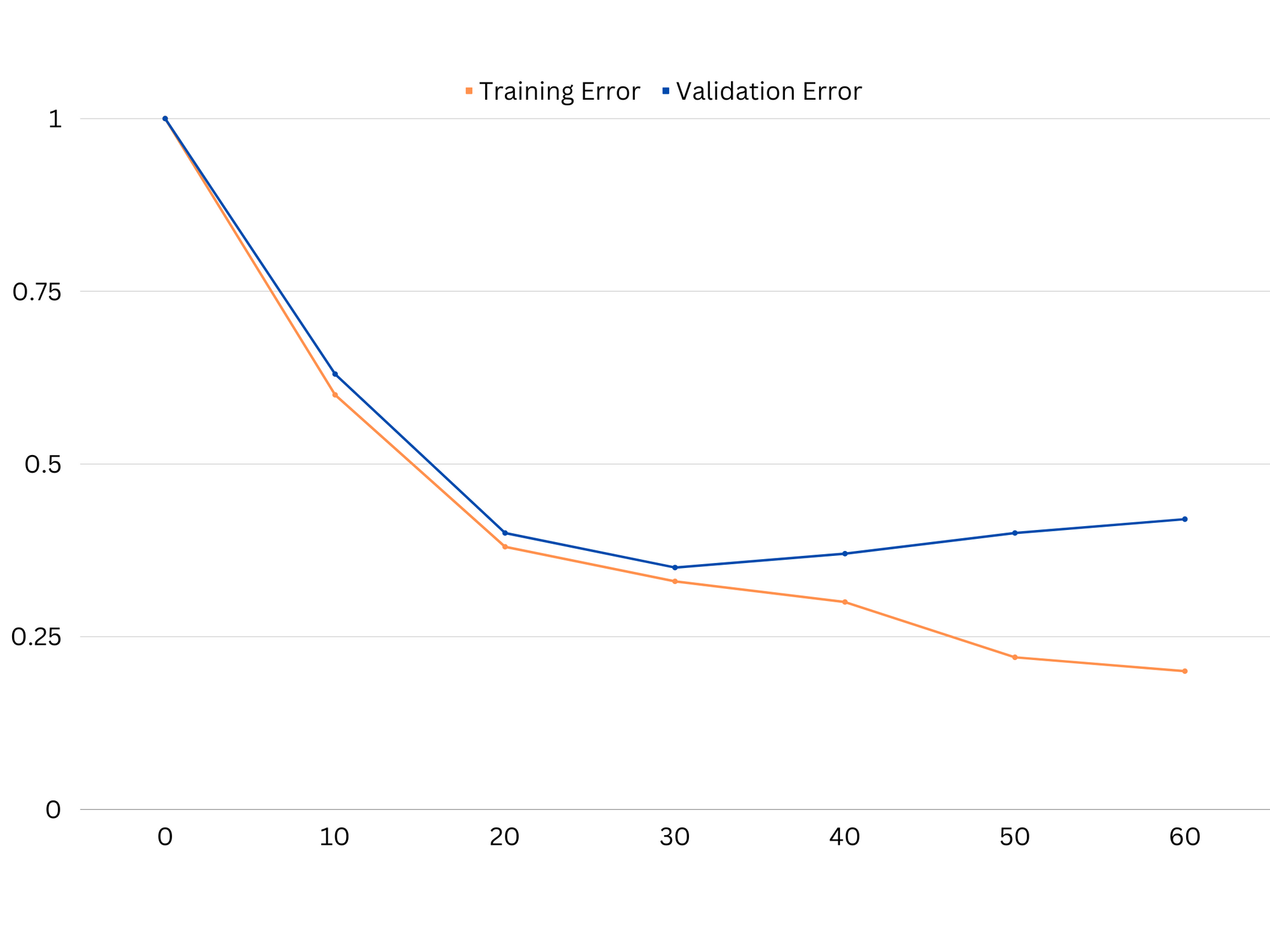

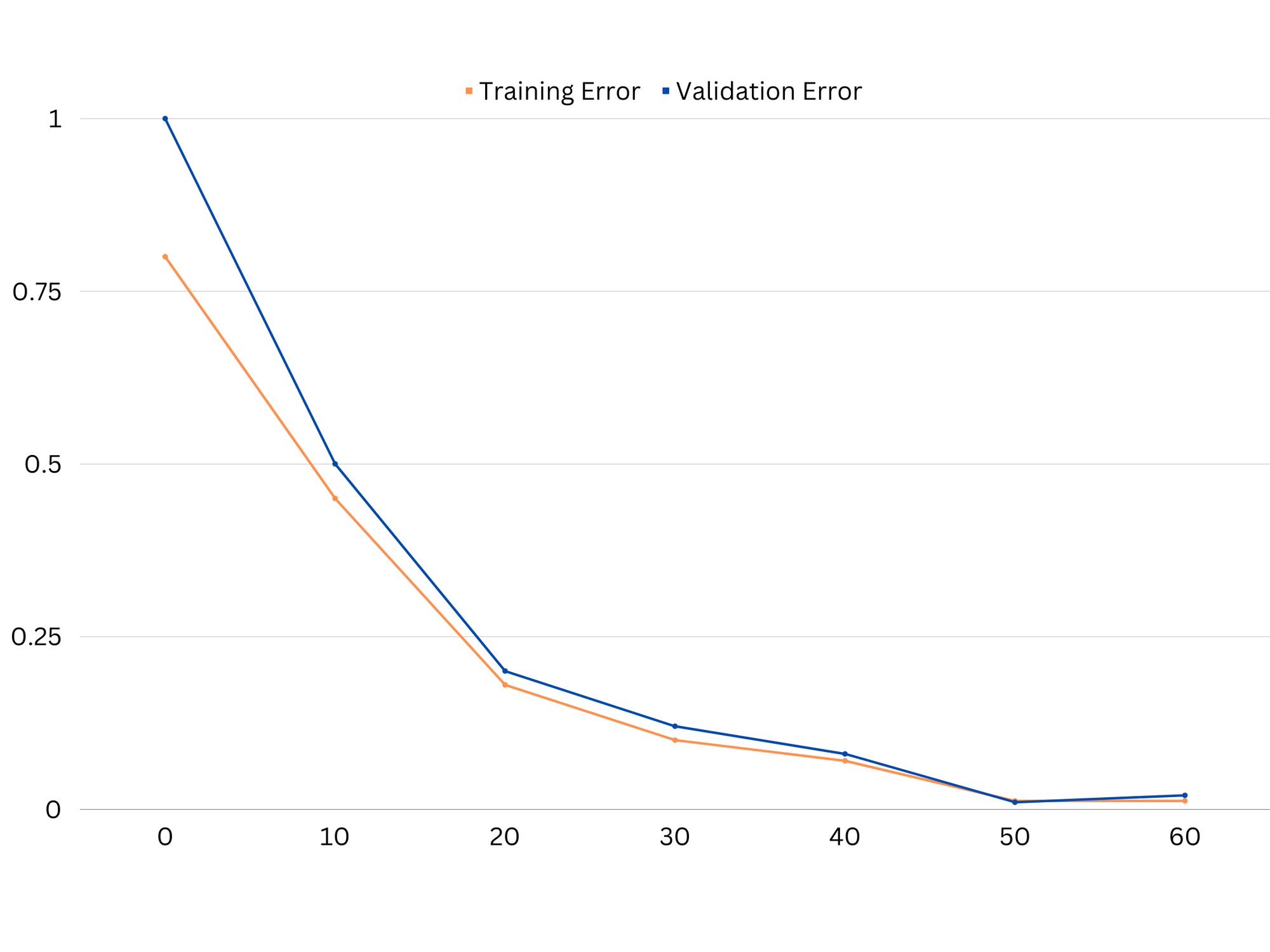

For at diagnosticere modellens ydeevne beregner og sammenligner vi typisk tog- og valideringsfejlene. Et nyttigt værktøj til at visualisere dette er et plot af læringskurverne, som viser modellens ydeevne på både toget og valideringsdata gennem hele træningsprocessen. Ved at undersøge disse kurver kan vi afgøre, om en model er overfitting (høj varians), underfitting (høj bias) eller veltilpasning (optimal balance mellem bias og varians).

Eksempel på indlæringskurver for en undertilpasningsmodel. Både togfejl og valideringsfejl er høje.

I praksis tyder lav præstation på både trænings- og valideringsdata på, at modellen er for enkel, hvilket fører til undertilpasning. På den anden side, hvis modellen klarer sig meget godt på træningsdata, men dårligt på testdata, er modellens kompleksitet sandsynligvis for høj, hvilket resulterer i overfitting. For at løse undertilpasning kan vi prøve at øge modellens kompleksitet ved at tilføje flere funktioner, ændre indlæringsalgoritmen eller vælge forskellige hyperparametre. I tilfælde af overfitting bør vi overveje at regularisere modellen eller bruge teknikker som krydsvalidering for at forbedre dens generaliseringsevner.

Eksempel på indlæringskurver af en overfitting-model. Togfejl falder, mens valideringsfejl begynder at stige. Modellen er ikke i stand til at generalisere.

Regularisering er en teknik, der kan bruges til at reducere variansfejlen i maskinlæringsmodeller, hvilket hjælper med at løse bias-varians-afvejningen. Der er en række forskellige regulariseringsteknikker, hver med deres egne fordele og ulemper. Nogle populære regulariseringsteknikker inkluderer ridge-regression, lasso-regression og elastisk netto-regularisering. Alle disse teknikker hjælper med at forhindre overfitting ved at tilføje en strafbetegnelse til modellens objektive funktion, som fraråder ekstreme parameterværdier og tilskynder til enklere modeller.

Ridge regression, også kendt som L2-regularisering, tilføjer et strafudtryk, der er proportionalt med kvadratet af modelparametrene. Denne teknik har en tendens til at resultere i modeller med mindre parameterværdier, hvilket kan føre til reduceret varians og forbedret generalisering. Den udfører dog ikke funktionsvalg, så alle funktioner forbliver i modellen.

Tjek vores praktiske, praktiske guide til at lære Git, med bedste praksis, brancheaccepterede standarder og inkluderet snydeark. Stop med at google Git-kommandoer og faktisk lærer det!

Lasso regression, eller L1-regularisering, tilføjer et strafudtryk, der er proportionalt med den absolutte værdi af modelparametrene. Denne teknik kan føre til modeller med sparsomme parameterværdier, der effektivt udfører funktionsvalg ved at sætte nogle parametre til nul. Dette kan resultere i enklere modeller, som er nemmere at fortolke.

Elastisk nettoregularisering er en kombination af både L1- og L2-regularisering, hvilket giver mulighed for en balance mellem ridge- og lasso-regression. Ved at kontrollere forholdet mellem de to strafvilkår kan elastisk net opnå fordelene ved begge teknikker, såsom forbedret generalisering og funktionsvalg.

Eksempel på læringskurver af god tilpasningsmodel.

konklusioner

Bias-variance trade-off er et afgørende koncept i maskinlæring, der bestemmer effektiviteten og godheden af en model. Mens høj bias fører til undertilpasning og høj varians fører til overtilpasning, er det nødvendigt at finde den optimale balance mellem de to for at bygge robuste modeller, der generaliserer godt til nye data.

Ved hjælp af indlæringskurver er det muligt at identificere overtilpasnings- eller undertilpasningsproblemer, og ved at tune modellens kompleksitet eller implementere regulariseringsteknikker er det muligt at forbedre ydeevnen på både trænings- og valideringsdata, samt testdata.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Køb og sælg aktier i PRE-IPO-virksomheder med PREIPO®. Adgang her.

- Kilde: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :er

- :ikke

- :hvor

- 1

- 12

- 20

- 8

- a

- evne

- I stand

- Om

- absolutte

- præcist

- opnå

- opnå

- faktisk

- tilføje

- adresse

- Tilføjer

- fordele

- rådgivning

- påvirke

- påvirker

- algoritme

- Alle

- tillade

- også

- an

- ,

- enhver

- ER

- artikel

- AS

- Balance

- saldi

- BE

- fordi

- fordele

- mellem

- skævhed

- grænse

- både

- Bygning

- men

- by

- beregne

- CAN

- kapaciteter

- fange

- tilfælde

- skiftende

- vælge

- nøje

- kombination

- sammenligne

- komplekse

- kompleksitet

- Konceptet

- Overvej

- styring

- Core

- korrigere

- afgørende

- data

- deal

- falder

- Bestem

- bestemmer

- forskel

- forskellige

- displays

- fordeling

- gør

- grund

- hver

- tidligere

- lettere

- effektivt

- effektivitet

- tilskynder

- nok

- fejl

- fejl

- Endog

- Undersøgelse

- eksempel

- Forklar

- ekstrem

- svigtende

- mislykkes

- Feature

- Funktionalitet

- finde

- passer

- montering

- udsving

- Fokus

- Til

- funktion

- fundamental

- Generelt

- Git

- mål

- godt

- Ground

- vejlede

- hånd

- hands-on

- Have

- hjælpe

- hjælpe

- Høj

- højere

- hover

- Hvordan

- How To

- Men

- HTTPS

- identificere

- if

- gennemføre

- umuligt

- Forbedre

- forbedret

- in

- I andre

- omfatter

- medtaget

- Forøg

- stigende

- indgang

- ind

- Introduktion

- IT

- ITS

- Holde

- kendt

- L1

- l2

- føre

- førende

- Leads

- læring

- lad

- LG

- ligesom

- Sandsynlig

- ll

- Lav

- lavere

- maskine

- machine learning

- maerker

- nævnte

- minimering

- model

- modeller

- mere

- nødvendig

- netto

- Ny

- Støj

- nummer

- objektiv

- of

- tit

- on

- optimal

- or

- Andet

- vores

- ud

- output

- egen

- parameter

- parametre

- Mønster

- Udfør

- ydeevne

- udfører

- udfører

- plato

- Platon Data Intelligence

- PlatoData

- fattige

- Populær

- mulig

- Praktisk

- praksis

- forudsige

- forudsigelse

- forhindre

- problemer

- behandle

- give

- hellere

- forholdet

- reducere

- Reduceret

- refererer

- relaterede

- forhold

- Relationer

- forblive

- repræsentere

- resultere

- resulterer

- Resultater

- højre

- ring

- robust

- s

- valg

- Følsomhed

- indstilling

- Shadow

- ark

- Kort

- bør

- Simpelt

- samtidigt

- lille

- mindre

- So

- nogle

- Kilder

- firkant

- Stablemisbrug

- standarder

- Stands

- stærk

- sådan

- foreslår

- teknikker

- semester

- vilkår

- prøve

- end

- at

- deres

- Them

- Der.

- Disse

- de

- denne

- hele

- til

- også

- værktøj

- I alt

- Tog

- Kurser

- overgang

- sand

- Sandheden

- prøv

- to

- typisk

- ude af stand

- underliggende

- ukendt

- anvendte

- ved brug af

- validering

- værdi

- Værdier

- meget

- we

- GODT

- Hvad

- hvorvidt

- som

- mens

- vilje

- med

- ord

- zephyrnet

- nul