Amazon SageMaker Data Wrangler er et UI-baseret dataforberedelsesværktøj, der hjælper med at udføre dataanalyse, forbehandling og visualisering med funktioner til at rense, transformere og forberede data hurtigere. Data Wrangler-forudbyggede flowskabeloner hjælper med at gøre dataforberedelse hurtigere for dataforskere og maskinlæringsudøvere (ML) ved at hjælpe dig med at accelerere og forstå best practice-mønstre for datastrømme ved hjælp af almindelige datasæt.

Du kan bruge Data Wrangler-flows til at udføre følgende opgaver:

- Data visualisering – Undersøgelse af statistiske egenskaber for hver kolonne i datasættet, opbygning af histogrammer, undersøgelse af outliers

- Datarengøring – Fjernelse af dubletter, sletning eller udfyldning af poster med manglende værdier, fjernelse af outliers

- Databerigelse og funktionsudvikling – Behandling af kolonner for at bygge mere udtryksfulde funktioner, valg af en undergruppe af funktioner til træning

Dette indlæg hjælper dig med at forstå Data Wrangler ved at bruge følgende eksempel på forhåndsbyggede flows GitHub. Depotet viser tabelformede datatransformationer, tidsseriedatatransformationer og kombinerede datasættransformationer. Hver af dem kræver en anden type transformationer på grund af deres grundlæggende natur. Standarddata i tabelform eller tværsnit indsamles på et bestemt tidspunkt. I modsætning hertil fanges tidsseriedata gentagne gange over tid, hvor hvert efterfølgende datapunkt afhænger af dets tidligere værdier.

Lad os se på et eksempel på, hvordan vi kan bruge eksempeldatastrømmen til tabeldata.

Forudsætninger

Data Wrangler er en Amazon SageMaker funktion tilgængelig indenfor Amazon SageMaker Studio, så vi er nødt til at følge Studio onboarding-processen for at skrue op for Studio-miljøet og notebooks. Selvom du kan vælge mellem nogle få godkendelsesmetoder, er den nemmeste måde at oprette et Studio-domæne på at følge Hurtig start instruktioner. Hurtig start bruger de samme standardindstillinger som standard Studio opsætning. Du kan også vælge at ombord vha AWS IAM Identity Center (efterfølger til AWS Single Sign-On) til godkendelse (se Ombord på Amazon SageMaker Domain ved hjælp af IAM Identity Center).

Importer datasættet og flowfilerne til Data Wrangler ved hjælp af Studio

Følgende trin beskriver, hvordan du importerer data til SageMaker, der skal forbruges af Data Wrangler:

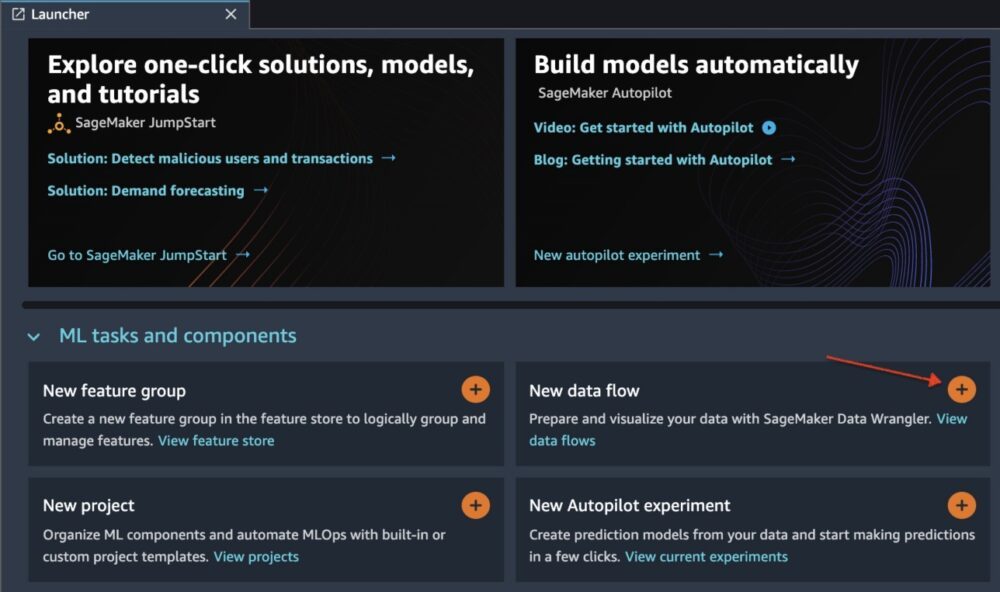

Initialiser Data Wrangler via Studio UI ved at vælge Nyt dataflow.

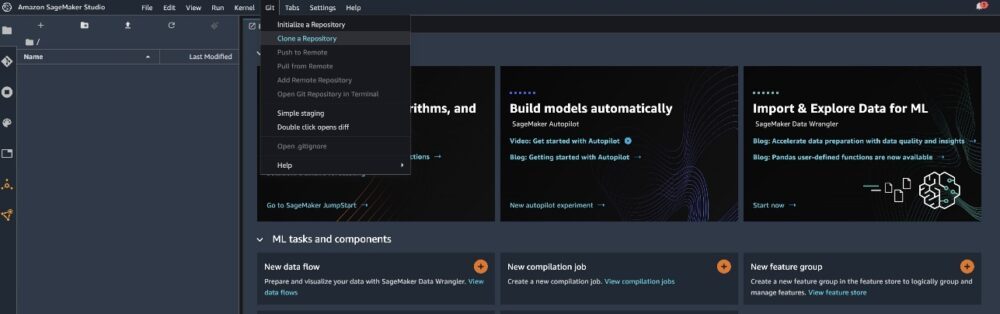

Klon GitHub repo for at downloade flow-filerne til dit Studio-miljø.

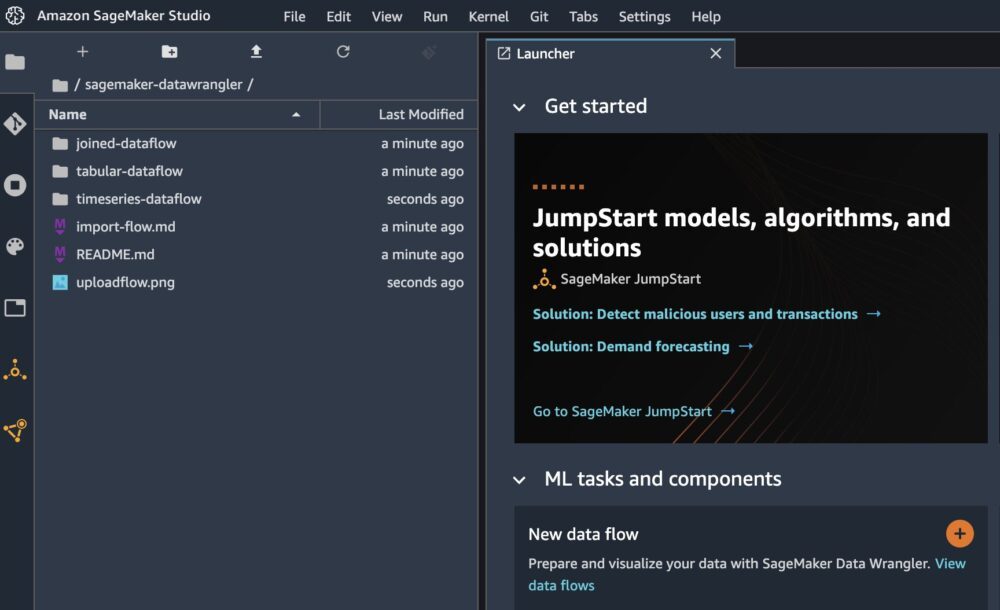

Når klonen er færdig, bør du kunne se lagerindholdet i venstre rude.

Vælg filen Hotel-Bookings-Klassificering.flow for at importere flowfilen til Data Wrangler.

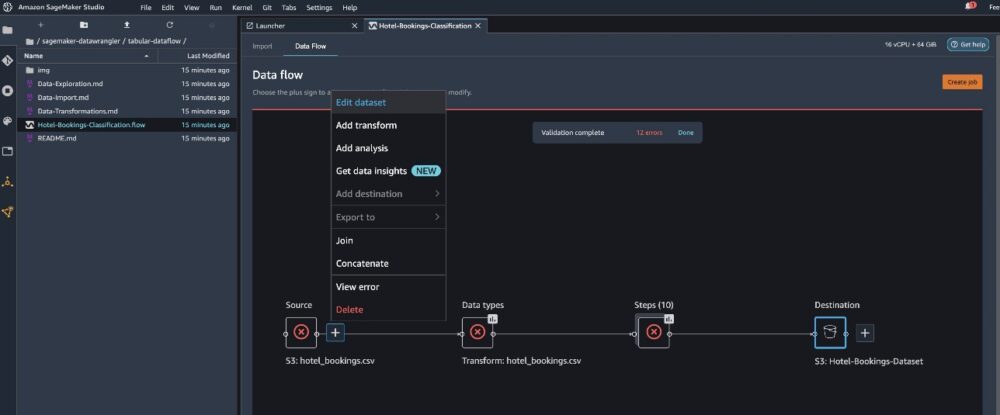

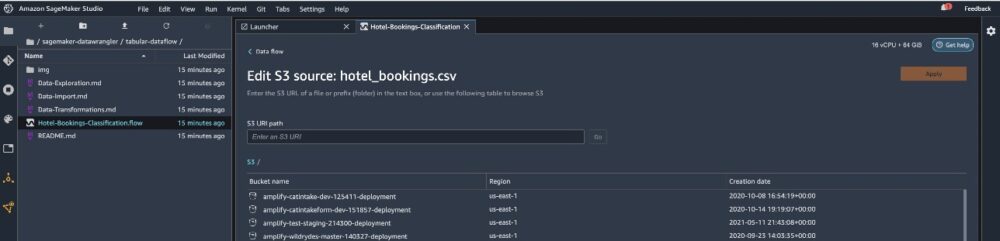

Hvis du bruger tidsserien eller det samlede dataflow, vises flowet som et andet navn. Når flowet er blevet importeret, bør du se følgende skærmbillede. Dette viser os fejl, fordi vi skal sikre os, at flowfilen peger på den korrekte datakilde i Amazon Simple Storage Service (Amazon S3).

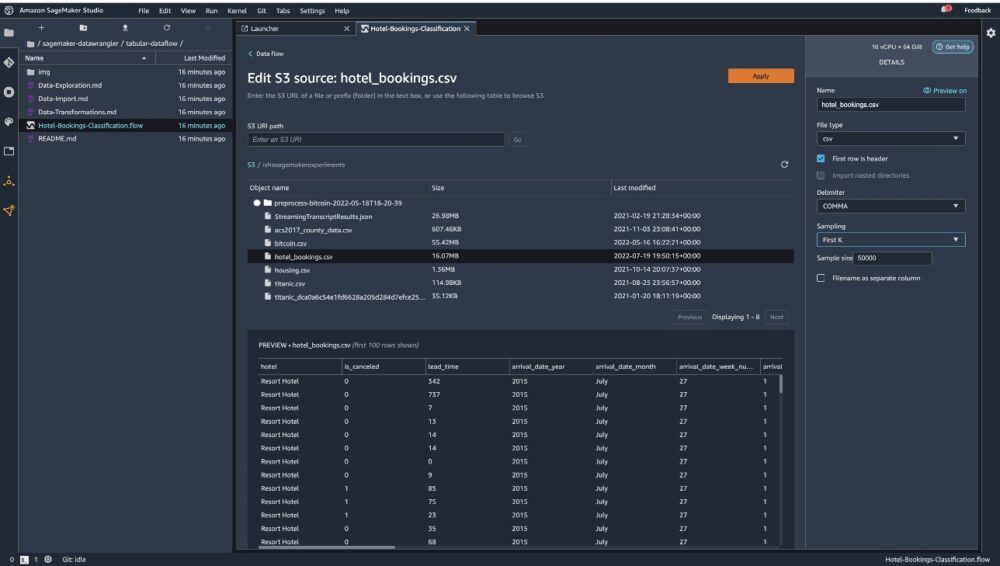

Vælg Rediger datasæt for at få alle dine S3-spande frem. Vælg derefter datasættet hotel_bookings.csv fra din S3 skovl til at køre igennem dataflow i tabelform.

Bemærk, at hvis du bruger samlet dataflow, skal du muligvis importere flere datasæt til Data Wrangler

Sørg for i højre rude AFSNIT er valgt som afgrænsning og Sampling er sat til Først K. Vores datasæt er lille nok til at køre Data Wrangler-transformationer på det fulde datasæt, men vi ønskede at fremhæve, hvordan du kan importere datasættet. Hvis du har et stort datasæt, kan du overveje at bruge sampling. Vælge Importere for at importere dette datasæt til Data Wrangler.

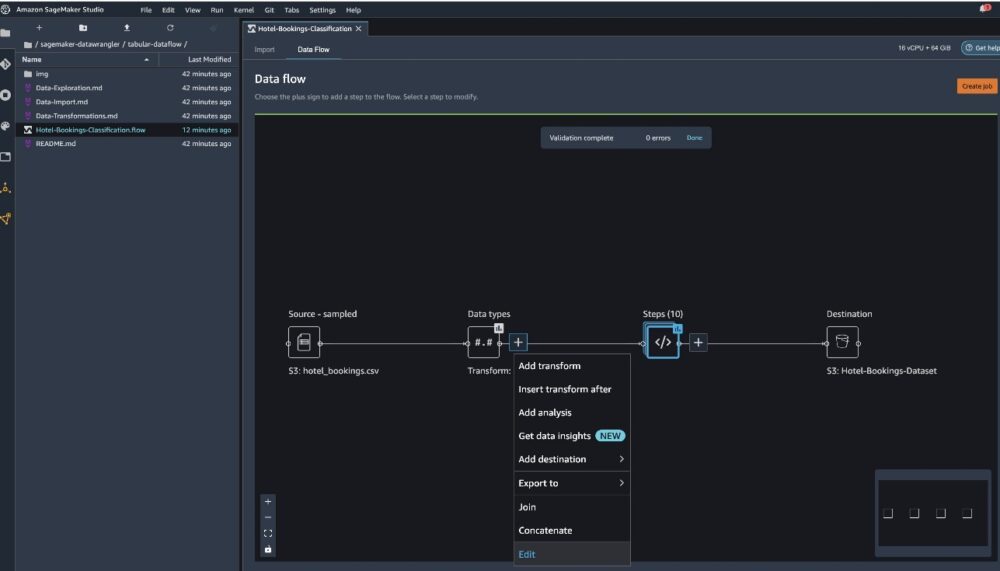

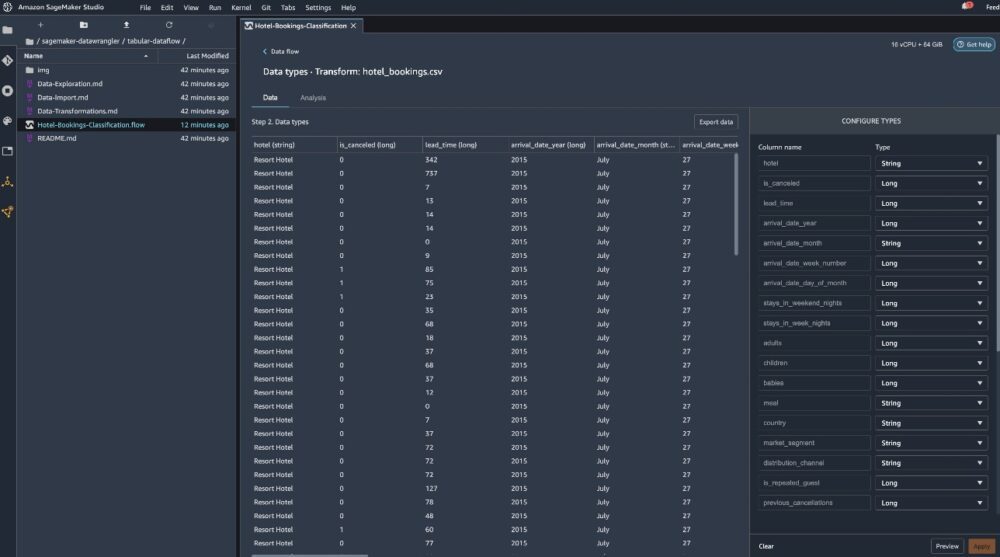

Efter at datasættet er importeret, validerer Data Wrangler automatisk datasættet og registrerer datatyperne. Du kan se, at fejlene er forsvundet, fordi vi peger på det korrekte datasæt. Floweditoren viser nu to blokke, der viser, at dataene blev importeret fra en kilde og datatyper genkendt. Du kan også redigere datatyperne, hvis det er nødvendigt.

Følgende skærmbillede viser vores datatyper.

Lad os se på nogle af transformationerne udført som en del af dette tabelformede flow. Hvis du bruger tidsserier or sluttede datastrømme, tjek nogle almindelige transformationer på GitHub repo. Vi udførte nogle grundlæggende undersøgende dataanalyser ved hjælp af dataindsigtsrapporter, der undersøgte mållækage og funktionskollinearitet i datasættet, tabeloversigtsanalyser og hurtig modellering. Udforsk trinene på GitHub repo.

Nu dropper vi kolonner baseret på anbefalingerne fra Data Insights and Quality Report.

- For mållækage, drop reservationsstatus.

- Slip for overflødige kolonner dage_i_venteliste, hotel, reserveret_værelsestype, ankomstdato_måned, reservationsstatus_dato, babyer, , ankomst_dato_dag_i_måned.

- Slip kolonner baseret på lineære korrelationsresultater ankomstdato_ugenummer , ankomstdato_år fordi korrelationsværdierne for disse træk (kolonne) par er større end den anbefalede tærskel på 0.90.

- Baseret på ikke-lineære korrelationsresultater, fald reservationsstatus. Denne kolonne var allerede markeret til at blive slettet baseret på mållækageanalysen.

- Proces numeriske værdier (min-max skalering) for lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_cancelled, booking_changes, adr, total_of_specical_requests, , krævede_bilparkeringspladser.

- One-hot encode kategoriske variabler som meal, is_repeated_guest, market_segment, assigned_room_type, deposit_type, , kundetype.

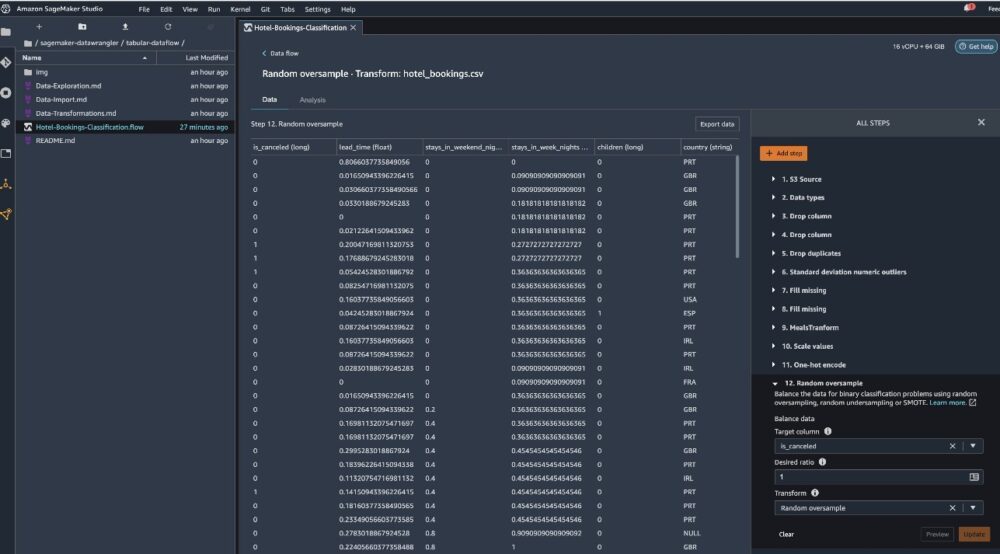

- Balancer målvariablen Tilfældig oversampling for klasseubalance. Brug den hurtige modelleringsfunktion til at håndtere afvigere og manglende værdier.

Eksporter til Amazon S3

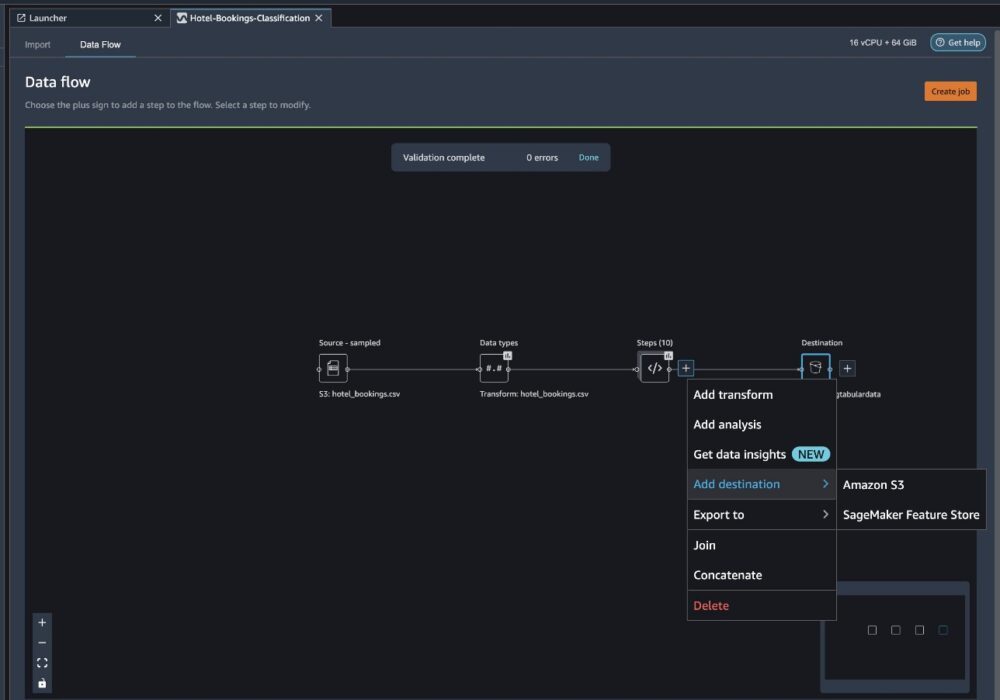

Nu har vi gennemgået de forskellige transformationer og er klar til at eksportere dataene til Amazon S3. Denne mulighed opretter et SageMaker-behandlingsjob, som kører Data Wrangler-behandlingsflowet og gemmer det resulterende datasæt i en specificeret S3-indsamling. Følg de næste trin for at konfigurere eksporten til Amazon S3:

Vælg plustegnet ud for en samling af transformationselementer, og vælg Tilføj destination, derefter Amazon S3.

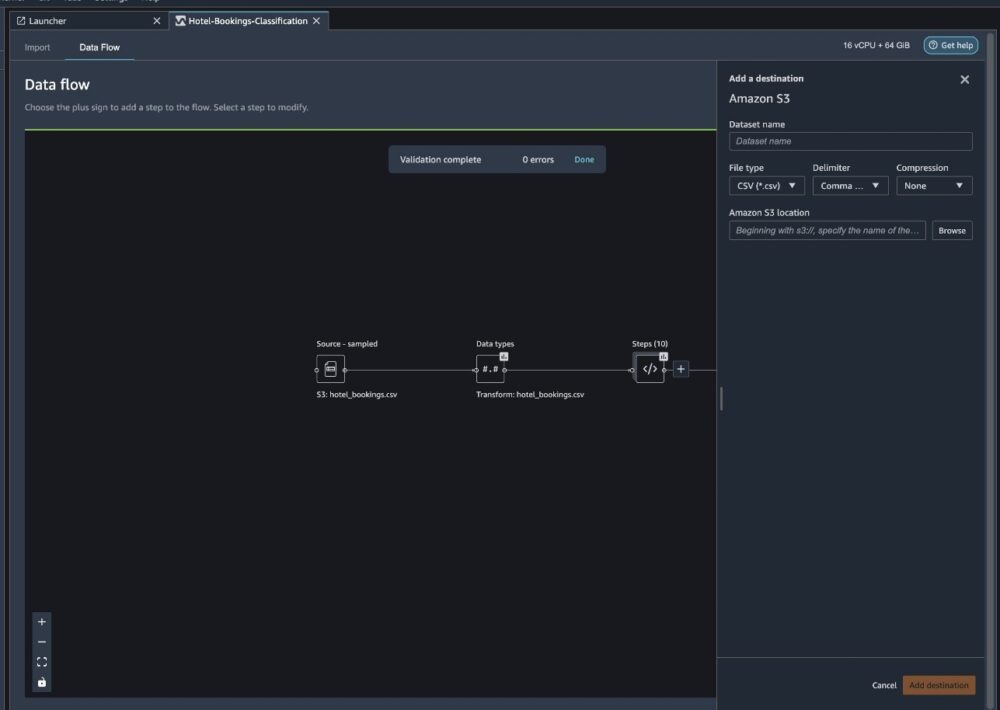

- Til Datasætnavn, indtast f.eks. et navn til det nye datasæt

NYC_export. - Til Filtype, vælg CSV.

- Til Afgrænser, vælg Komma.

- Til Compression, vælg Ingen.

- Til Amazon S3 placering, brug det samme bøttenavn, som vi oprettede tidligere.

- Vælg Tilføj destination.

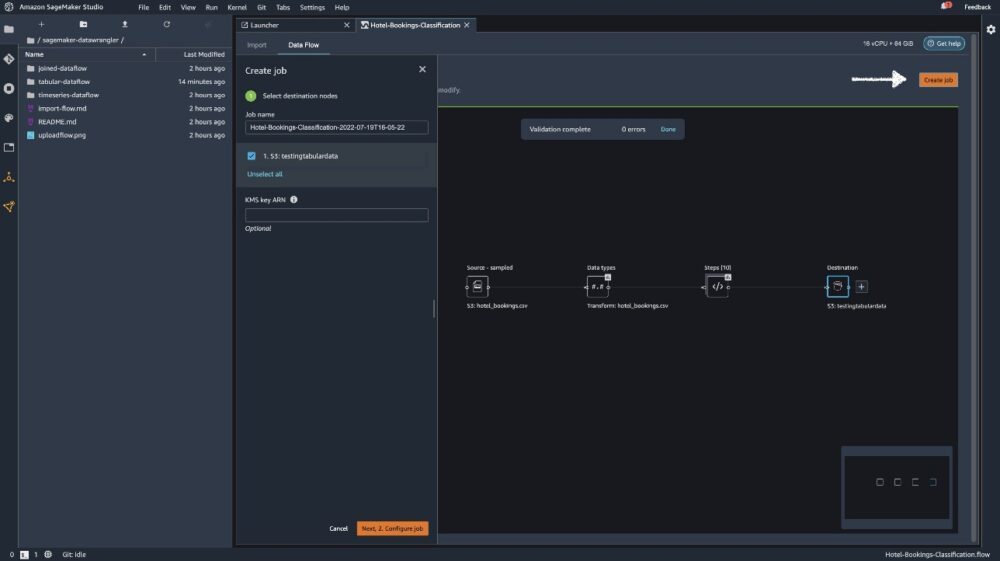

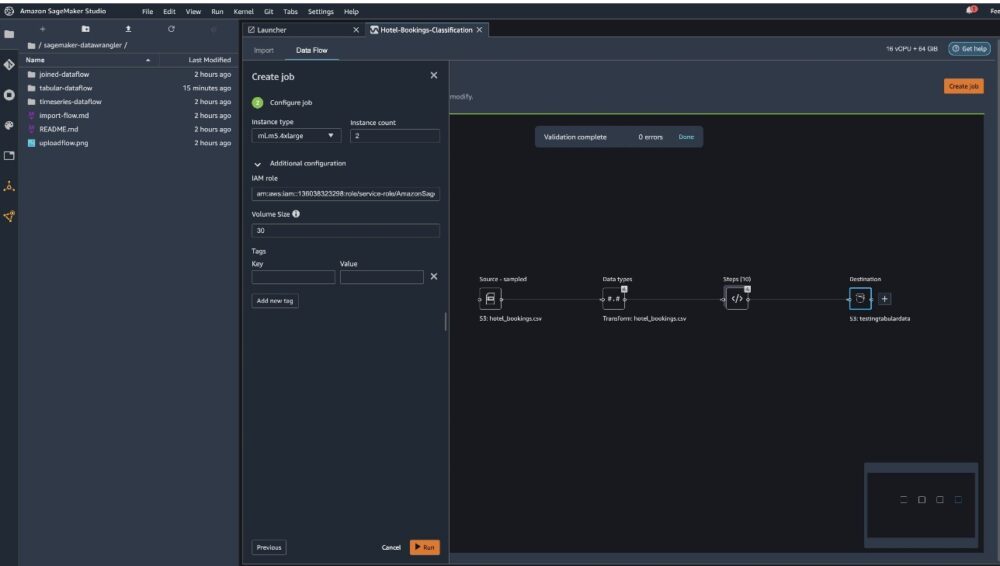

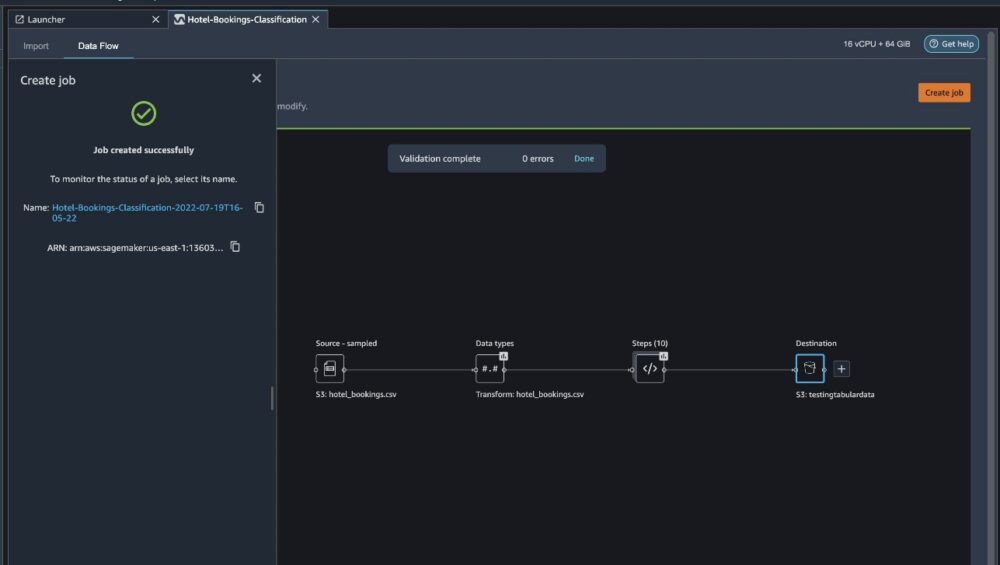

Vælg Skab job.

Til Job navn, indtast et navn eller behold den autogenererede indstilling og vælg destination. Vi har kun én destination, S3:testingtabulardata, men du har muligvis flere destinationer fra forskellige trin i din arbejdsgang. Forlad KMS nøgle ARN felt tomt og vælg Næste.

Nu skal du konfigurere beregningskapaciteten for et job. Du kan beholde alle standardværdier for dette eksempel.

- Til Forekomsttype, brug ml.m5.4xlarge.

- Til Antal tilfælde, brug 2.

- Du kan udforske Yderligere konfiguration, men behold standardindstillingerne.

- Vælg Kør.

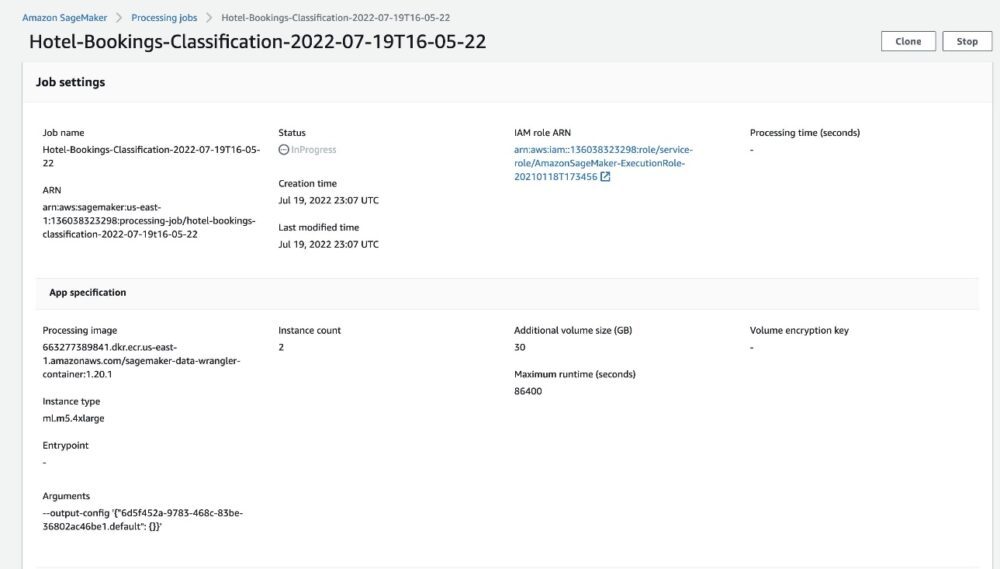

Nu er dit job startet, og det tager lidt tid at behandle 6 GB data i henhold til vores Data Wrangler-behandlingsflow. Prisen for dette job vil være omkring $2 USD, fordi ml.m5.4xlarge koster $0.922 USD i timen, og vi bruger to af dem.

Hvis du vælger jobnavnet, bliver du omdirigeret til et nyt vindue med joboplysningerne.

På siden med jobdetaljer kan du se alle parametrene fra de foregående trin.

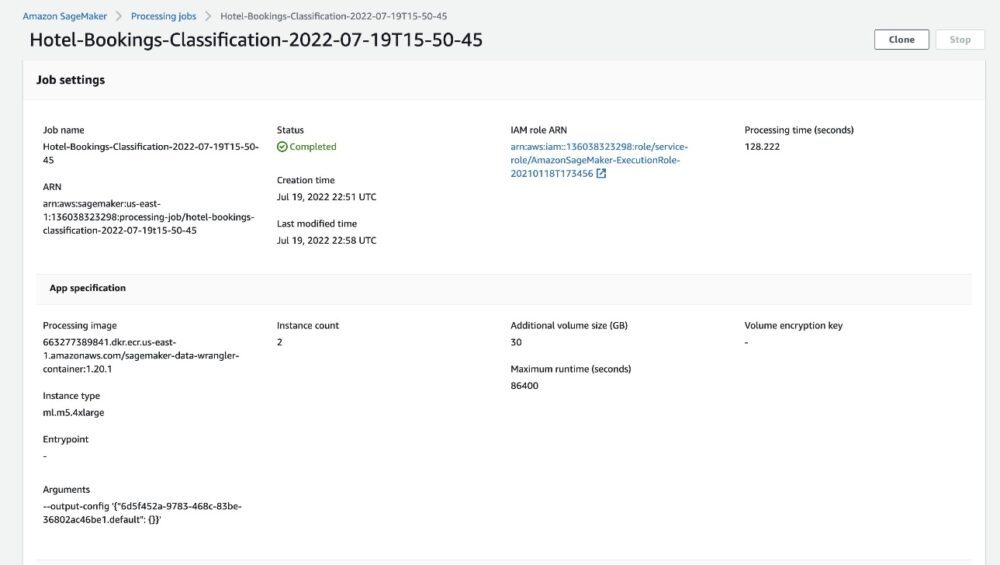

Når jobstatus ændres til Udført, kan du også kontrollere Behandlingstid (sekunder) værdi. Dette behandlingsjob tager omkring 5-10 minutter at fuldføre.

Når jobbet er fuldført, er tog- og testoutputfilerne tilgængelige i de tilsvarende S3-outputmapper. Du kan finde outputplaceringen fra behandlingsjobkonfigurationerne.

Når Data Wrangler-bearbejdningsjobbet er fuldført, kan vi kontrollere resultaterne, der er gemt i vores S3-bøtte. Glem ikke at opdatere job_name variabel med dit jobnavn.

Du kan nu bruge disse eksporterede data til at køre ML-modeller.

Ryd op

Slet dine S3-bøtter og din Data Wrangler flow for at slette de underliggende ressourcer og forhindre uønskede omkostninger, efter du er færdig med eksperimentet.

Konklusion

I dette indlæg viste vi, hvordan du kan importere det forudbyggede dataflow i tabelform til Data Wrangler, tilslutte det til vores datasæt og eksportere resultaterne til Amazon S3. Hvis dine use cases kræver, at du manipulerer tidsseriedata eller forbinder flere datasæt, kan du gennemgå de andre forudbyggede prøveflows i GitHub repo.

Når du har importeret en forudbygget dataforberedelsesarbejdsgang, kan du integrere den med Amazon SageMaker Processing, Amazon SageMaker Pipelinesog Amazon SageMaker Feature Store for at forenkle opgaven med at behandle, dele og opbevare ML træningsdata. Du kan også eksportere dette eksempeldataflow til et Python-script og oprette en tilpasset ML-dataforberedelsespipeline og derved accelerere din udgivelseshastighed.

Vi opfordrer dig til at tjekke vores GitHub repository for at få praktisk praksis og finde nye måder at forbedre modellens nøjagtighed på! For at lære mere om SageMaker, besøg Amazon SageMaker Developer Guide.

Om forfatterne

Isha Dua er en Senior Solutions Architect baseret i San Francisco Bay Area. Hun hjælper AWS Enterprise-kunder med at vokse ved at forstå deres mål og udfordringer og guider dem til, hvordan de kan opbygge deres applikationer på en cloud-native måde og samtidig sikre, at de er robuste og skalerbare. Hun brænder for maskinlæringsteknologier og miljømæssig bæredygtighed.

Isha Dua er en Senior Solutions Architect baseret i San Francisco Bay Area. Hun hjælper AWS Enterprise-kunder med at vokse ved at forstå deres mål og udfordringer og guider dem til, hvordan de kan opbygge deres applikationer på en cloud-native måde og samtidig sikre, at de er robuste og skalerbare. Hun brænder for maskinlæringsteknologier og miljømæssig bæredygtighed.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet