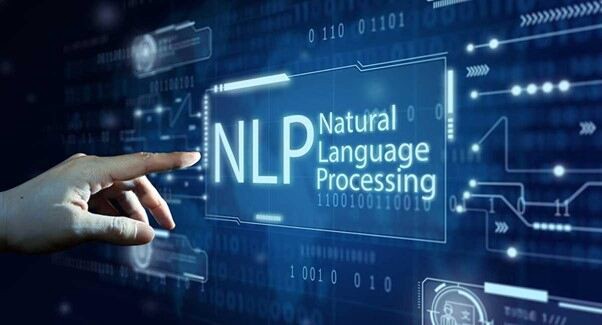

De siger 'Handling taler højere end ord'. Alligevel kan i nogle tilfælde ord (præcis dechifreret) bestemme hele handlingsforløbet, der er relevant for meget intelligente maskiner og modeller. Denne tilgang til at gøre ordene mere meningsfulde for maskinerne er NLP eller Natural Language Processing.

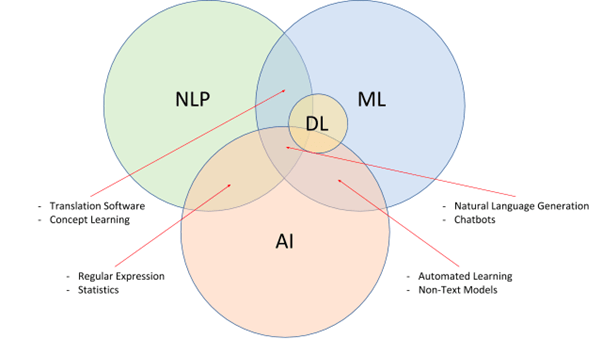

For de ukyndige er NLP et underfelt af kunstig intelligens, der er i stand til at nedbryde menneskeligt sprog og fodre principperne om det samme til de intelligente modeller. NLP, parret med NLU (Natural Language Understanding) og NLG (Natural Language Generation), har til formål at udvikle meget intelligente og proaktive søgemaskiner, grammatikkontrol, oversættere, stemmeassistenter og mere.

Enkelt sagt nedbryder NLP sprogets kompleksitet, præsenterer det samme for maskiner som datasæt at tage reference fra, og udtrækker også hensigten og konteksten for at udvikle dem yderligere. Alligevel kommer implementeringen af dem med sine dele af udfordringer.

Hvad er NLP: Fra en startups perspektiv?

Det er svært for mennesker at lære et nyt sprog, endsige maskiner. Men hvis vi har brug for maskiner til at hjælpe os i løbet af dagen, er de nødt til at forstå og reagere på den menneskelige type sprogbrug. Natural Language Processing gør det nemt ved at nedbryde det menneskelige sprog i maskinforståelige bits, der bruges til at træne modeller til perfektion.

NLP har også støtte fra NLU, som har til formål at nedbryde ordene og sætningerne fra et kontekstuelt synspunkt. Endelig er der NLG til at hjælpe maskiner med at reagere ved at generere deres egen version af det menneskelige sprog til tovejskommunikation.

Startups, der planlægger at designe og udvikle chatbots, stemmeassistenter og andre interaktive værktøjer, er nødt til at stole på NLP-tjenester og -løsninger for at udvikle maskinerne med præcise sprog- og hensigtsdechifreringsfunktioner.

NLP-udfordringer at overveje

Ord kan have forskellige betydninger. Slanger kan være sværere at udlægge kontekstuelle. Og visse sprog er bare svære at fodre på, på grund af manglen på ressourcer. På trods af at det er en af de mere eftertragtede teknologier, kommer NLP med følgende rodfæstede og implementerende AI-udfordringer.

Mangel på kontekst for homografier, homofoner og homonymer

En 'flagermus' kan være et sportsredskab og endda et træhængende pattedyr med vinger. På trods af at stavemåden er den samme, er de forskellige, når det drejer sig om betydning og kontekst. På samme måde lyder 'Der' og 'Deres' ens, men har forskellige stavemåder og betydninger for dem.

Selv mennesker har til tider svært ved at forstå de subtile forskelle i brugen. Derfor, på trods af at NLP betragtes som en af de mere pålidelige muligheder for at træne maskiner i det sprogspecifikke domæne, kan ord med lignende stavemåder, lyde og udtale afvise konteksten ret betydeligt.

tvetydigheden

Hvis du tror, bare ord kan være forvirrende, er her en tvetydig sætning med uklare fortolkninger.

"Jeg knipsede et barn i indkøbscenteret med mit kamera"- Hvis man talte til, kan det være tilfældet, at maskinen bliver forvirret med hensyn til, om ungen blev knipset ved hjælp af kameraet, eller da ungen blev knipset, han havde dit kamera.

Denne form for forvirring eller tvetydighed er ret almindelig, hvis du er afhængig af ikke-troværdige NLP-løsninger. Hvad angår kategorisering, kan flertydigheder adskilles som syntaktisk (betydningsbaseret), leksikalsk (ordbaseret) og semantisk (kontekstbaseret).

Fejl, der er relevante for hastighed og tekst

Maskiner, der er afhængige af semantisk feed, kan ikke trænes, hvis tale- og tekstbits er forkerte. Dette problem er analogt med involvering af misbrugte eller endda forkert stavede ord, som kan få modellen til at fungere over tid. Selvom udviklede grammatikkorrektionsværktøjer er gode nok til at luge ud af sætningsspecifikke fejl, skal træningsdataene være fejlfrie for at lette nøjagtig udvikling i første omgang.

Manglende evne til at passe ind i slanger og talemåder

Selv hvis NLP-tjenesterne forsøger at skalere ud over tvetydigheder, fejl og homonymer, er det ikke let at indpasse slagger eller kulturspecifikt ordret. Der er ord, der mangler standardordbogsreferencer, men som stadig kan være relevante for en bestemt målgruppe. Hvis du planlægger at designe en brugerdefineret AI-drevet stemmeassistent eller model, er det vigtigt at passe ind i relevante referencer for at gøre ressourcen indsigtsfuld nok.

Et eksempel ville være en 'Big Bang Theory-specifik' chatbot, der forstår 'Buzzinga' og endda reagerer på det samme.

Apati over for vertikal-specifik lingo

Ligesom det kulturspecifikke sprogbrug bruger visse virksomheder meget tekniske og vertikale specifikke terminologier, der måske ikke stemmer overens med en standard NLP-drevet model. Derfor, hvis du planlægger at udvikle feltspecifikke tilstande med talegenkendelsesfunktioner, skal processen med enhedsudtrækning, træning og dataindkøb være meget kurateret og specifik.

Mangel på brugbare data

NLP afhænger af begreberne sentimental og sproglig analyse af sproget, efterfulgt af dataindsamling, udrensning, mærkning og træning. Alligevel har nogle sprog ikke mange brugbare data eller historisk kontekst for NLP-løsningerne at arbejde rundt med.

Mangel på R&D

NLP implementering er ikke endimensionel. I stedet kræver det hjælpeteknologier som neurale netværk og dyb læring at udvikle sig til noget banebrydende. Tilføjelse af tilpassede algoritmer til specifikke NLP-implementeringer er en fantastisk måde at designe tilpassede modeller på - et hack, der ofte bliver skudt ned på grund af manglen på tilstrækkelige forsknings- og udviklingsværktøjer.

Skala over disse problemer i dag: Hvordan vælger man den rigtige leverandør?

Fra fixering af tvetydighed til fejl til problemer med dataindsamling, er det vigtigt at have den rigtige leverandør til din rådighed til at træne og udvikle den forudsete NLP-model. Og selv om flere faktorer skal overvejes, er her nogle af de mere ønskværdige funktioner at overveje, når du forbinder:

- Stor, domænespecifik database (lyd, tale og video), uanset sproget.

- Evne til at implementere orddeltagging for at fjerne uklarheder.

- Understøttelse af tilpassede hjælpeteknologier som flersprogede sætningsindlejringer for at forbedre kvaliteten af fortolkningen.

- Problemfri dataanmærkning til at mærke datasæt i henhold til kravene.

- Flersproget database med hyldevarevalg at arbejde med.

Leverandører, der tilbyder de fleste eller endda nogle af disse funktioner, kan overvejes til at designe dine NLP-modeller.

Wrap-Up

Det er overflødigt at sige, at NLP har udviklet sig til en af de mere bredt accepterede og hyldede teknologier baseret på kunstig intelligens. Hvis du er til detaljer, forventes NLP-markedet at vokse med næsten 1400 % i 2025 sammenlignet med det i 2017. Ifølge forventninger og ekstrapoleringer vil NLP-markedet blive vurderet til næsten 43 milliarder ved udgangen af 2025 — Statista

På trods af fordelene kommer Natural Language Processing med et par begrænsninger - noget du kan tage fat på, når du opretter forbindelse til en pålidelig AI-leverandør.

Vatsal Ghiya, Grundlægger af Saip, er en iværksætter med mere end 20 års erfaring inden for AI-software og -tjenester til sundhedspleje.

Oprindeligt udgivet på https://thinkml.ai den 1. juni 2022.

![]()

Hvad er udfordringerne med naturlig sprogbehandling, og hvordan løses det? blev oprindeligt offentliggjort i Chatbots liv på Medium, hvor folk fortsætter samtalen ved at fremhæve og svare på denne historie.

- Coinsmart. Europas bedste Bitcoin og Crypto Exchange.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. FRI ADGANG.

- CryptoHawk. Altcoin radar. Gratis prøveversion.

- Source: https://chatbotslife.com/what-are-the-natural-language-processing-challenges-and-how-to-fix-6c1e185dd95?source=rss—-a49517e4c30b—4

- "

- 20 år

- 2022

- a

- præcis

- tværs

- Lov

- Handling

- adresse

- AI

- algoritmer

- tvetydigheden

- analyse

- tilgang

- omkring

- kunstig

- kunstig intelligens

- Assistant

- publikum

- lyd

- være

- fordele

- Beyond

- Billion

- pauser

- virksomheder

- kapaciteter

- stand

- tilfælde

- vis

- udfordringer

- Vælg

- samling

- Fælles

- Kommunikation

- sammenlignet

- kompleksiteter

- forvirring

- Tilslutning

- Overvej

- Samtale

- kurateret

- skik

- data

- Database

- dag

- dyb

- Design

- designe

- Trods

- Bestem

- udvikle

- udvikling

- Udvikling

- udviklingsværktøjer

- afvige

- forskellige

- domæne

- ned

- enhed

- Entrepreneur

- udvikle sig

- eksempel

- forventninger

- forventet

- erfaring

- Uddrag

- faktorer

- Funktionalitet

- Endelig

- Fornavn

- passer

- Fix

- efter

- formular

- grundlægger

- fra

- yderligere

- generere

- generation

- godt

- stor

- Grow

- hack

- sundhedspleje

- hjælpe

- link.

- stærkt

- historisk

- Hvordan

- How To

- Men

- HTTPS

- menneskelig

- Mennesker

- gennemføre

- implementering

- gennemføre

- vigtigt

- Forbedre

- Intelligens

- Intelligent

- hensigt

- interaktiv

- fortolkning

- spørgsmål

- spørgsmål

- IT

- etiket

- mærkning

- Sprog

- Sprog

- LÆR

- læring

- maskine

- Maskiner

- lave

- maerker

- Making

- Marked

- betyder

- meningsfuld

- medium

- måske

- fejl

- model

- modeller

- mere

- mest

- Natural

- behov

- netværk

- tilbyde

- Indstillinger

- Andet

- egen

- Mennesker

- perspektiv

- planlægning

- Punkt

- Synspunkt

- præcist

- problemer

- behandle

- forarbejdning

- kvalitet

- relevant

- pålidelig

- Krav

- Kræver

- forskning

- forskning og udvikling

- ressource

- Ressourcer

- samme

- Scale

- Søg

- Søgemaskiner

- Tjenester

- sæt

- flere

- Del

- lignende

- Tilsvarende

- Software

- Løsninger

- nogle

- noget

- Taler

- specifikke

- hastighed

- standard

- Stadig

- support

- Teknisk

- Teknologier

- derfor

- tid

- gange

- i dag

- værktøj

- værktøjer

- mod

- Kurser

- forstå

- forståelse

- forstår

- us

- brug

- værdiansættes

- sælger

- udgave

- video

- Specifikation

- Voice

- ukrudt

- Hvad

- hvorvidt

- mens

- ord

- Arbejde

- ville

- år

- Din