Store sprogmodeller (LLM'er) med milliarder af parametre er i øjeblikket på forkant med naturlig sprogbehandling (NLP). Disse modeller ryster op i feltet med deres utrolige evner til at generere tekst, analysere følelser, oversætte sprog og meget mere. Med adgang til enorme mængder data har LLM'er potentialet til at revolutionere den måde, vi interagerer med sprog på. Selvom LLM'er er i stand til at udføre forskellige NLP-opgaver, betragtes de som generalister og ikke specialister. For at uddanne en LLM til at blive en ekspert inden for et bestemt domæne, er finjustering normalt påkrævet.

En af de store udfordringer ved træning og implementering af LLM'er med milliarder af parametre er deres størrelse, hvilket kan gøre det vanskeligt at passe dem ind i enkelte GPU'er, den hardware, der almindeligvis bruges til dyb læring. Den store skala af disse modeller kræver højtydende computerressourcer, såsom specialiserede GPU'er med store mængder hukommelse. Derudover kan størrelsen af disse modeller gøre dem beregningsmæssigt dyre, hvilket kan øge trænings- og inferenstider markant.

I dette indlæg viser vi, hvordan vi kan bruge Amazon SageMaker JumpStart for nemt at finjustere en storsproget tekstgenereringsmodel på et domænespecifikt datasæt på samme måde, som du ville træne og implementere enhver model på Amazon SageMaker. Vi viser især, hvordan du kan finjustere GPT-J 6B sprogmodellen til generering af finansiel tekst ved hjælp af både JumpStart SDK og Amazon SageMaker Studio UI på et offentligt tilgængeligt datasæt af SEC-arkiveringer.

JumpStart hjælper dig hurtigt og nemt med at komme i gang med maskinlæring (ML) og giver et sæt løsninger til de mest almindelige use cases, som nemt kan trænes og implementeres med blot et par trin. Alle trinene i denne demo er tilgængelige i den medfølgende notesbog Finjustering af tekstgenerering GPT-J 6B-model på et domænespecifikt datasæt.

Løsningsoversigt

I de følgende afsnit giver vi en trin-for-trin demonstration til finjustering af en LLM til tekstgenereringsopgaver via både JumpStart Studio UI og Python SDK. Vi diskuterer især følgende emner:

- En oversigt over SEC-arkiveringsdata i det finansielle domæne, som modellen er finjusteret på

- En oversigt over LLM GPT-J 6B modellen, vi har valgt at finjustere

- En demonstration af to forskellige måder, vi kan finjustere LLM ved hjælp af JumpStart:

- Brug JumpStart programmatisk med SageMaker Python SDK

- Få adgang til JumpStart ved hjælp af Studio UI

- En evaluering af den finjusterede model ved at sammenligne den med den fortrænede model uden finjustering

Finjustering refererer til processen med at tage en fortrænet sprogmodel og træne den til en anden, men relateret opgave ved hjælp af specifikke data. Denne tilgang er også kendt som overføre læring, som går ud på at overføre den lærte viden fra en opgave til en anden. LLM'er som GPT-J 6B trænes på enorme mængder umærkede data og kan finjusteres på mindre datasæt, hvilket får modellen til at yde bedre i et specifikt domæne.

Som et eksempel på, hvordan ydeevnen forbedres, når modellen finjusteres, kan du overveje at stille den følgende spørgsmål:

"Hvad driver salgsvæksten hos Amazon?"

Uden finjustering ville svaret være:

“Amazon er verdens største online forhandler. Det er også verdens største online markedsplads. Det er også verden”

Med finjustering er svaret:

"Salgsvækst hos Amazon er primært drevet af øget kundebrug, herunder øget udvalg, lavere priser og øget bekvemmelighed og øget salg fra andre sælgere på vores hjemmesider."

Forbedringen fra finjustering er tydelig.

Vi bruger finansiel tekst fra SEC-arkiver til at finjustere en GPT-J 6B LLM til finansielle applikationer. I de næste afsnit introducerer vi dataene og LLM, der vil blive finjusteret.

SEC-arkiveringsdatasæt

SEC-ansøgninger er afgørende for regulering og offentliggørelse i finanssektoren. Arkiver informerer investorsamfundet om virksomhedernes forretningsforhold og virksomhedernes fremtidsudsigter. Teksten i SEC-ansøgninger dækker hele spektret af en virksomheds drift og forretningsbetingelser. På grund af deres potentielle forudsigelige værdi er disse ansøgninger gode informationskilder for investorer. Selvom disse SEC ansøgninger er offentligt tilgængelige for alle er det en tidskrævende øvelse at downloade analyserede filer og konstruere et rent datasæt med tilføjede funktioner. Vi gør dette muligt i nogle få API-kald i JumpStart Industri SDK.

Ved at bruge SageMaker API downloadede vi årsrapporter (10-K ansøgninger; se Sådan læser du en 10-K for mere information) for et stort antal virksomheder. Vi vælger Amazons SEC-arkiveringsrapporter for årene 2021-2022 som træningsdata for at finjustere GPT-J 6B-modellen. Især sammenkæder vi virksomhedens SEC-indberetningsrapporter i forskellige år i en enkelt tekstfil med undtagelse af afsnittet "Management Diskussion and Analysis", som indeholder fremadrettede udsagn fra virksomhedens ledelse og bruges som valideringsdata.

Forventningen er, at efter finjustering af GPT-J 6B-tekstgenereringsmodellen på de finansielle SEC-dokumenter, er modellen i stand til at generere indsigtsfuldt finansielt relateret tekstoutput og kan derfor bruges til at løse flere domænespecifikke NLP-opgaver.

GPT-J 6B stor sprogmodel

GPT-J 6B er en open source model med 6 milliarder parametre frigivet af Eleuther AI. GPT-J 6B er blevet trænet i et stort korpus af tekstdata og er i stand til at udføre forskellige NLP-opgaver såsom tekstgenerering, tekstklassificering og tekstresumé. Selvom denne model er imponerende på en række NLP-opgaver uden behov for nogen finjustering, bliver du i mange tilfælde nødt til at finjustere modellen på et specifikt datasæt og NLP-opgaver, du forsøger at løse. Brugstilfælde omfatter tilpassede chatbots, idégenerering, enhedsudtrækning, klassificering og sentimentanalyse.

Få adgang til LLM'er på SageMaker

Nu hvor vi har identificeret datasættet og modellen, vi skal finjustere på, giver JumpStart to muligheder for at komme i gang med at bruge finjustering af tekstgenerering: SageMaker SDK og Studio.

Brug JumpStart programmatisk med SageMaker SDK

Vi gennemgår nu et eksempel på, hvordan du kan bruge SageMaker JumpStart SDK til at få adgang til en LLM (GPT-J 6B) og finjustere den på SEC-arkiveringsdatasættet. Når finjusteringen er afsluttet, vil vi implementere den finjusterede model og drage konklusioner imod den. Alle trinene i dette indlæg er tilgængelige i den medfølgende notesbog: Finjustering af tekstgenerering GPT-J 6B-model på domænespecifikt datasæt.

I dette eksempel bruger JumpStart SageMaker Hugging Face Deep Learning Container (DLC) og DeepSpeed bibliotek for at finjustere modellen. DeepSpeed-biblioteket er designet til at reducere computerkraft og hukommelsesbrug og til at træne store distribuerede modeller med bedre parallelitet på eksisterende computerhardware. Den understøtter single node-distribueret træning, ved at bruge gradient checkpointing og modelparallelisme til at træne store modeller på en enkelt SageMaker-træningsinstans med flere GPU'er. Med JumpStart integrerer vi DeepSpeed-biblioteket med SageMaker Hugging Face DLC for dig og tager os af alt under motorhjelmen. Du kan nemt finjustere modellen på dit domænespecifikke datasæt uden at konfigurere det manuelt.

Finjuster den fortrænede model på domænespecifikke data

For at finjustere en udvalgt model skal vi få den models URI samt træningsscriptet og containerbilledet, der bruges til træning. For at gøre tingene nemmere afhænger disse tre input udelukkende af modelnavnet, versionen (for en liste over de tilgængelige modeller, se Indbyggede algoritmer med fortrænet modelbord), og den type instans, du vil træne på. Dette er demonstreret i følgende kodestykke:

Vi henter model_id svarende til den samme model, vi ønsker at bruge. I dette tilfælde finjusterer vi huggingface-textgeneration1-gpt-j-6b.

At definere hyperparametre involverer indstilling af værdierne for forskellige parametre, der bruges under træningsprocessen for en ML-model. Disse parametre kan påvirke modellens ydeevne og nøjagtighed. I det følgende trin etablerer vi hyperparametrene ved at bruge standardindstillingerne og angive brugerdefinerede værdier for parametre som f.eks. epochs , learning_rate:

JumpStart giver en omfattende liste over hyperparametre, der er tilgængelige for tuning. Den følgende liste giver et overblik over en del af de vigtigste hyperparametre, der bruges til at finjustere modellen. For en komplet liste over hyperparametre, se notesbogen Finjustering af tekstgenerering GPT-J 6B-model på domænespecifikt datasæt.

- epoker – Angiver højst, hvor mange epoker af det originale datasæt, der vil blive itereret.

- learning_rate – Styrer trinstørrelsen eller indlæringshastigheden for optimeringsalgoritmen under træning.

- eval_trin – Angiver, hvor mange trin, der skal køres, før modellen evalueres på valideringssættet under træning. Valideringssættet er en delmængde af dataene, der ikke bruges til træning, men i stedet bruges til at kontrollere modellens ydeevne på usete data.

- vægt_henfald – Styrer regulariseringsstyrken under modeltræning. Regularisering er en teknik, der hjælper med at forhindre modellen i at overfitte træningsdataene, hvilket kan resultere i bedre præstationer på usete data.

- fp16 – Styrer, om der skal bruges fp16 16-bit (blandet) præcisionstræning i stedet for 32-bit træning.

- evalueringsstrategi – Evalueringsstrategien brugt under uddannelsen.

- gradient_akkumulation_trin – Antallet af opdateringstrin, der skal akkumuleres gradienterne for, før der udføres et tilbage-/opdateringspass.

For yderligere detaljer vedrørende hyperparametre henvises til embedsmanden Kram Face Trainer dokumentation.

Du kan nu finjustere denne JumpStart-model på dit eget brugerdefinerede datasæt ved hjælp af SageMaker SDK. Vi bruger SEC-arkiveringsdataene, vi beskrev tidligere. Tog- og valideringsdataene er hostet under train_dataset_s3_path , validation_dataset_s3_path. Det understøttede format af data inkluderer CSV, JSON og TXT. For CSV- og JSON-dataene bruges tekstdataene fra den kaldede kolonne text eller den første kolonne, hvis der ikke findes en kolonne kaldet tekst. Fordi dette er til finjustering af tekstgenerering, kræves der ingen grundsandhedsetiketter. Følgende kode er et SDK-eksempel på, hvordan man finjusterer modellen:

Efter at vi har konfigureret SageMaker Estimator med de nødvendige hyperparametre, instansierer vi en SageMaker Estimator og kalder .fit metode til at begynde at finjustere vores model ved at give den videre Amazon Simple Storage Service (Amazon S3) URI for vores træningsdata. Som du kan se, er entry_point det angivne script er navngivet transfer_learning.py (det samme for andre opgaver og modeller), og inputdatakanalen videregivet til .fit skal benævnes tog og validering.

JumpStart understøtter også hyperparameteroptimering med SageMaker automatisk model tuning. For detaljer, se eksemplet notesbog.

Implementer den finjusterede model

Når træningen er færdig, kan du implementere din finjusterede model. For at gøre det, er alt, hvad vi behøver at opnå, inferensscript-URI (koden, der bestemmer, hvordan modellen bruges til inferens, når den først er installeret) og inferenscontainerbillede-URI, som inkluderer en passende modelserver til at være vært for den model, vi valgte. Se følgende kode:

Efter et par minutter er vores model implementeret, og vi kan få forudsigelser fra den i realtid!

Få adgang til JumpStart gennem Studio UI

En anden måde at finjustere og implementere JumpStart-modeller er gennem Studio UI. Denne brugergrænseflade giver en lav-kode/ingen kode løsning til finjustering af LLM'er.

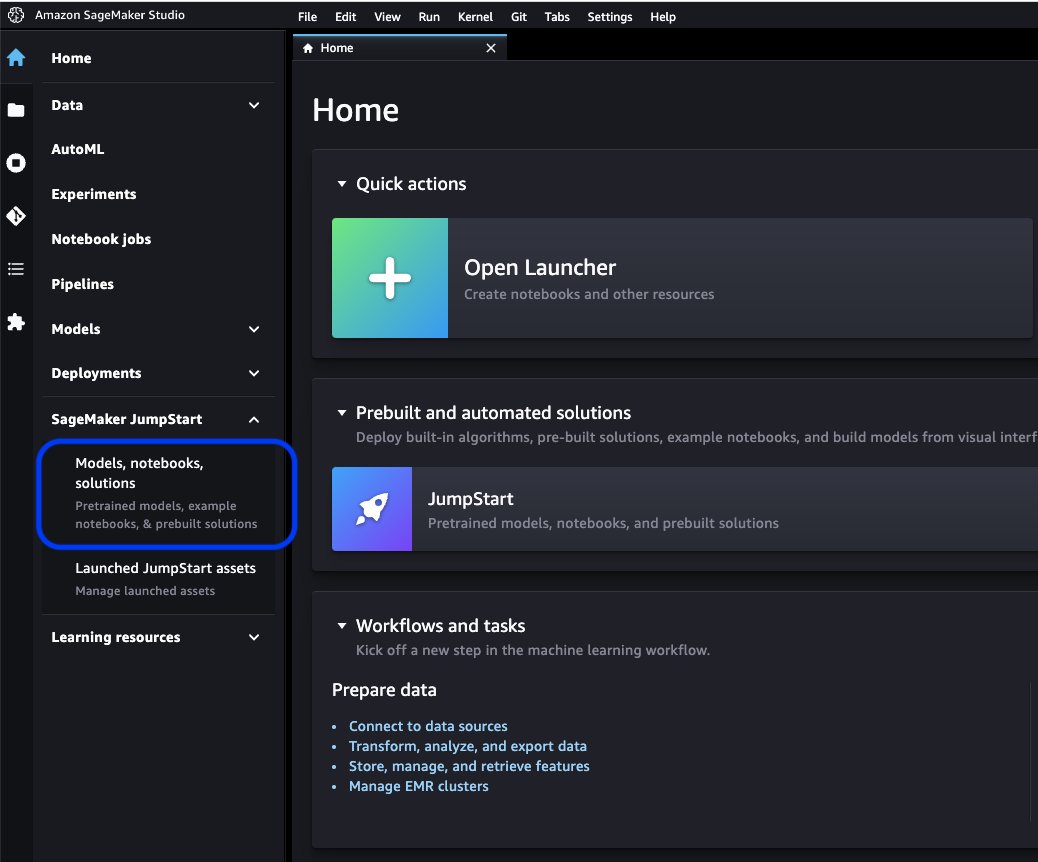

På Studio-konsollen skal du vælge Modeller, notesbøger, løsninger under SageMaker JumpStart i navigationsruden.

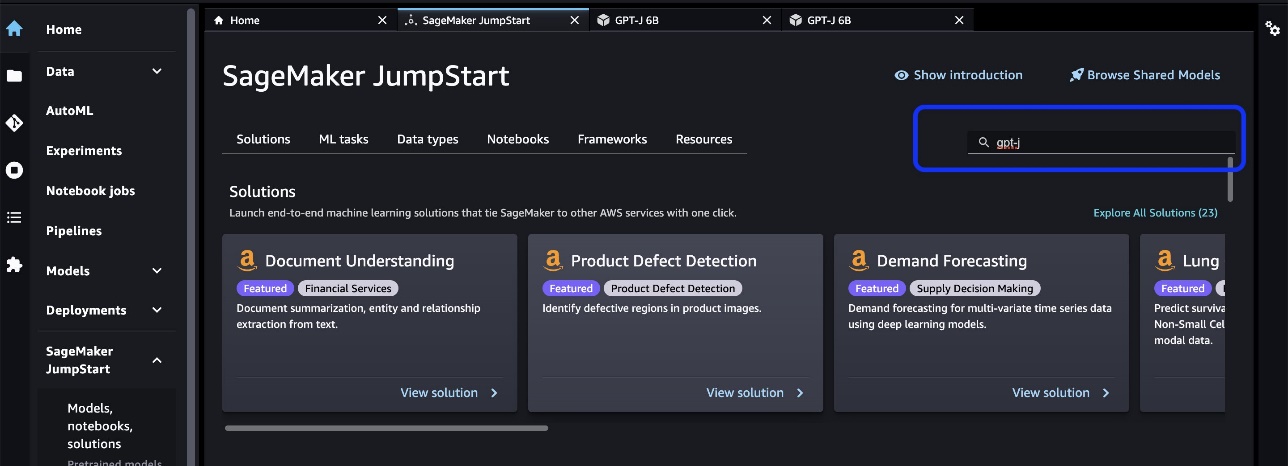

I søgelinjen skal du søge efter den model, du vil finjustere og implementere.

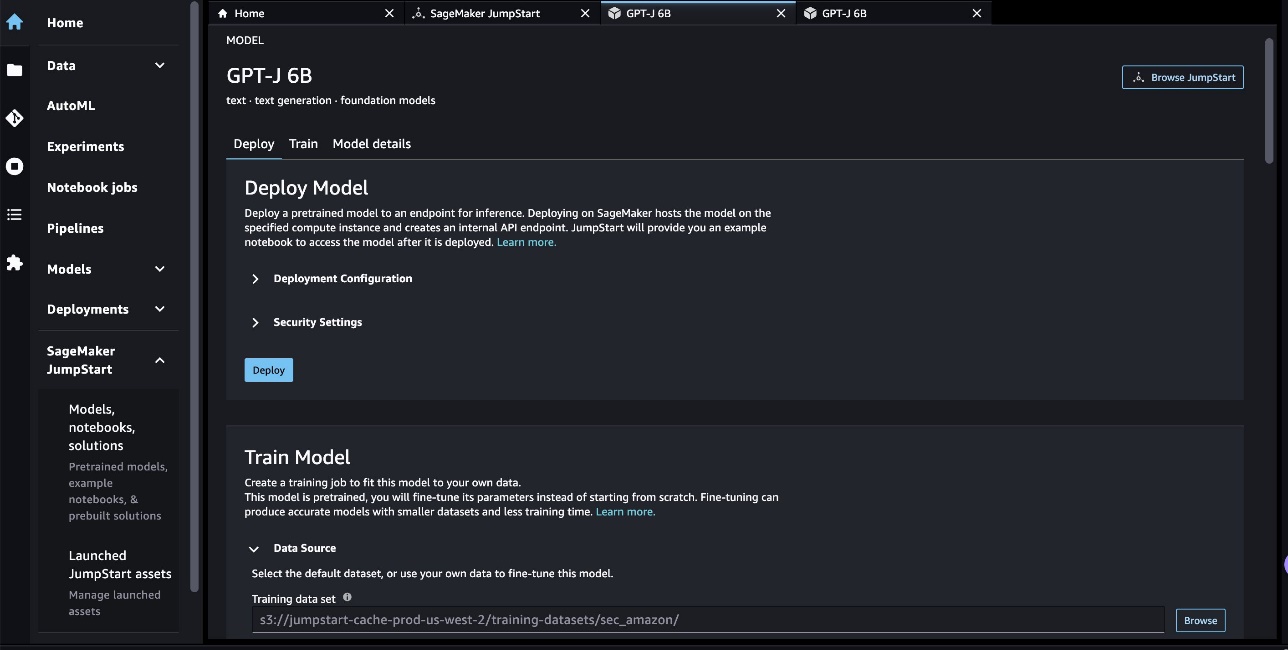

I vores tilfælde valgte vi modelkortet GPT-J 6B. Her kan vi direkte finjustere eller implementere LLM.

Modelvurdering

Når vi evaluerer en LLM, kan vi bruge perplexity (PPL). PPL er et fælles mål for, hvor godt en sprogmodel er i stand til at forudsige det næste ord i en sekvens. I enklere vendinger er det en måde at måle, hvor godt modellen kan forstå og generere menneskelignende sprog.

En lavere perplexity-score betyder, at modellen viser sig at præstere bedre til at forudsige det næste ord. Rent praktisk kan vi bruge forvirring til at sammenligne forskellige sprogmodeller og afgøre, hvilken der klarer sig bedst på en given opgave. Vi kan også bruge det til at spore en enkelt models ydeevne over tid. For flere detaljer, se Forvirring af modeller med fast længde.

Vi evaluerer modellens ydeevne gennem en sammenligning af dens præ- og post-finjusteringsydelse. PPL udsendes i træningsjobbet amazoncloudwatch logs. Derudover ser vi på output genereret af modellen som svar på specifikke test-prompter.

| Evalueringsmetrik på valideringsdataene | Før finjustering | Efter finjustering |

| Forvirring (PPL) | 8.147 | 1.437 |

Modellens forbedrede ydeevne demonstreres af to eksperimenter:

- Tekstgenerering – Vi viser, at outputtet af den finjusterede GPT-J genererer tekst, der ligner SEC-datasættet, hvilket indikerer, at det har lært at efterligne sprogmønstrene og konventionerne i det finansielle regulatoriske domæne

- Zero-shot læring – Vi demonstrerer, at den finjusterede GPT-J viser væsentligt bedre ydeevne end den ikke-finjusterede GPT-J på nul-shot spørgsmålssvar

Til tekstgenereringseksperimentet bruger vi følgende inferensparametre for at opnå vores resultater: max_length på 400 (antal returnerede poletter), num_return_sequences af 1 (antal svarteksteksempler), top_k af 250 (vælg fra en af de øverste 250 mulige fortsættelser), top_p på 0.8 (vælg kun fra fortsættelser, der er mindst 80 % sandsynlige), do_sample is True (prøveudtagning), og temperature på 1 (høj temperatur er større tilfældighed i svar). For flere detaljer om parametrene, se GenerationConfig. Følgende tabel sammenligner den finjusterede GPT-J og den ikke-finjusterede på en tekstfuldførelsesopgave.

| Inferens eksempel | Output fra GPT-J 6B før finjustering | Output fra GPT-J 6B efter finjustering |

| Denne Form 10-K rapport viser det |

Denne Form 10-K-rapport viser, at: Selskabets nettoindkomst, der kan henføres til selskabet for året, der sluttede den 31. december 2016, var $3,923,000, eller $0.21 pr. udvandet aktie, sammenlignet med $3,818,000, eller $0.21 pr. udvandet aktie, for året, der sluttede den 31. december 2015. Selskabets nettoindkomst, der kan henføres til selskabet for året, der sluttede den 31. december 2016, var $4,816,000, eller $0.28 pr. udvandet aktie, sammenlignet med $4,726,000, eller $0.27 pr. udvandet aktie, for året, der sluttede den 31. december 2015. Selskabets nettoindkomst, der kan henføres til selskabet for året, der sluttede den 31. december 2016, var $5,828,000, eller $0.34 pr. udvandet aktie, sammenlignet med $5,716,000, eller $0.33 pr. udvandet aktie, for året, der sluttede den 31. december 2015. Den 21. august 2009 indsendte virksomheden en formular 10-Q for kvartalet, der sluttede den 31. december 2008. Den 21. august 2009 indsendte virksomheden en formular 10-Q for kvartalet, der sluttede den 30. september 2008. Den 21. august 2009 indsendte virksomheden en formular 10-Q for kvartalet, der sluttede den 31. marts 2009. |

Denne formular 10-K-rapport viser, at:(1) Registrantens navn, adresse og telefonnummer er som følger:Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington Bemærk: Corporate Secretary (2) For formålet med artikel III i Securities Exchange Act af 1934 er registrantens navn og adresse som følger:(3) Registrantens Exchange Act-rapporteringsperiode er fra og med 1. januar 2020 til i dag.(4) Registrantens subjektive vurdering er at årsregnskabet og andre finansielle oplysninger inkluderet i denne rapport i alle væsentlige henseender er retvisende repræsenterende registrantens økonomiske tilstand, driftsresultater og pengestrømme pr. og for de perioder, der præsenteres i denne rapport.(5) Registrantens ledelses vurderingen er, at årsregnskabet og andre finansielle oplysninger inkluderet i denne rapport i alle væsentlige henseender er retvisende repræsenterende registrantens økonomiske tilstand, driftsresultater og pengestrømme pr. og for de perioder, der præsenteres i denne rapport./s/ Ernst & Young LLPSeattle, Washington 29. januar 2020EX-31.1 5 amzn-20201231xex311.htm EX-31.1 DocumentExhibit 31.1CERTIFICATIONSI, Andrew R. Jassy, bekræfter, at:1. Jeg har gennemgået denne formular 10-K fra Amazon.com, Inc.;2. Baseret på min viden indeholder denne rapport ingen usand erklæring om en væsentlig kendsgerning eller undlader at angive en væsentlig kendsgerning, der er nødvendig for at afgive de afgivne erklæringer, i lyset af de omstændigheder, hvorunder sådanne erklæringer blev afgivet, ikke vildledende med hensyn til den periode, der er omfattet af denne rapport; |

| Vi betjener forbrugerne igennem |

Vi betjener forbrugerne gennem: Vores Blog Er du virksomhedsejer og ønsker at udvikle din virksomhed? Vil du skabe en mere effektiv og effektiv virksomhed? Vil du lære at udvikle din virksomhed? Hvis du svarede "ja" til et af disse spørgsmål, så skal du læse denne artikel. Det første skridt til at vokse din virksomhed er at forstå din virksomhed. Du skal kunne besvare følgende spørgsmål om din virksomhed: Hvem er dine kunder? Hvad er dit produkt eller din service? Hvad er dit unikke salgsforslag? Hvad er din marketingstrategi? Hvad er din salgsprognose? Hvad er din salgsprognose? Hvad er din salgsprognose? Hvad er din salgsprognose? Hvad er din salgsprognose? |

Vi betjener forbrugerne gennem: Amazon.com, en forhandler af fysiske og digitale produkter; Amazon Web Services, som leverer teknologiske infrastrukturtjenester, der muliggør stort set enhver form for virksomhed; Amazon Enterprise Solutions, som giver virksomheder tilpasset teknologi og tjenester til at muliggøre bedre forretningsprocesser og forbedre effektiviteten og produktiviteten; og Audible, et digitalt lydbogsforlag. Vi betjener udviklere og virksomheder i alle størrelser gennem AWS, som tilbyder et bredt sæt af globale databehandlings-, lagrings-, database- og andre servicetilbud. Vi fremstiller og sælger også elektronisk udstyr. Vi har organiseret vores aktiviteter i to hovedsegmenter: Nordamerika og International. Se punkt 8 i del II, ""Finansregnskaber og supplerende data-Note 12-Segmentoplysninger."" Se punkt 7 i del II, ""Ledelsens diskussion og analyse af økonomiske forhold og resultater af operationer - Driftsresultater - Supplerende oplysninger" ” for supplerende information om vores nettosalg.ForbrugereVi betjener forbrugerne gennem vores online og fysiske butikker og fokuserer på udvalg, pris og bekvemmelighed. Vi designer vores butikker for at gøre det muligt for hundreder af millioner af unikke produkter at blive solgt af os og af tredjeparter på tværs af snesevis af produktkategorier. Kunder får adgang til vores tilbud via vores websteder, mobilapps, Alexa og fysisk besøg i vores butikker. Vi fremstiller og sælger også Kindledevices. Vi stræber efter at tilbyde vores kunder de lavest mulige priser gennem lave daglige produktpriser og forsendelsestilbud, og at forbedre vores driftseffektivitet, så vi kan fortsætte med at sænke priserne for vores kunder. Vi leverer også brugervenlig funktionalitet, hurtig og pålidelig udførelse og rettidig kundeservice. Derudover tilbyder vi Amazon Prime, et medlemskabsprogram, der inkluderer ubegrænset gratis forsendelse af over 100 millioner varer, adgang til ubegrænset streaming af titusindvis af film og TV-afsnit og andre fordele. |

| I år har vi særligt fokus på |

I år har vi særligt fokus på: Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes Sundhedssystemets rolle i forebyggelsen af fedme og diabetes |

I år fokuserer vi især på: -Fortsat international ekspansion, herunder udvikling af nye virksomheder i eksisterende internationale markedssegmenter, samt udvikling af nye internationale markedssegmenter; -Udvide vores kundebase, herunder øge salget til eksisterende kunder og tiltrække nye kunder; - Udvikling af nye forretningsmuligheder og indgåelse af kommercielle aftaler, herunder gennem licensering og andre arrangementer, med andre virksomheder eller gennem opkøb af andre virksomheder; - Udvikling af teknologi, der giver forbedret kundeservice og effektivt leverer vores produkter og tjenester; - Udvikling af nye produkt- og servicetilbud og inkorporering af disse i eksisterende og nye produkt- og servicetilbud; -Udvikling af effektive og effektive systemer til at understøtte vores forretning, og -Andre forretningsmæssige og strategiske initiativer. Vi mener, at det at tilbyde lave priser til vores kunder er grundlæggende for vores fremtidige succes. En måde, vi tilbyder lavere priser, er gennem tilbud om gratis forsendelse, der resulterer i en nettoomkostning for os ved levering af produkter, og gennem medlemskab af Amazon Prime, som giver gratis forsendelse på millioner af varer og adgang til film og andet indhold. Vi tilbyder også andre kampagner, der gør det muligt for os at reducere en lavere nettosalgsomkostning. Vi har organiseret vores aktiviteter i to hovedsegmenter: Nordamerika og International. Se punkt 8 i del II, ""Finansregnskaber og Supplerende Data-Note 12-Segmentoplysninger."" Se Punkt 7 i Del II,""Ledelsens diskussion og analyse af økonomiske tilstand og driftsresultater - Driftsresultater - Supplerende oplysninger"" for supplerende information om vores nettosalg.ForbrugereVi betjener forbrugerne gennem vores detailwebsteder og fysiske butikker og fokuserer på udvalg, pris og bekvemmelighed. |

Til det andet eksperiment med en opgave med nul-skudsspørgsmål satte vi max_length at være en anden værdi (henholdsvis 40, 200 og 40) baseret på det output, vi forventer fra hvert spørgsmål. Parametrene for top_k, top_p, do_sample, temperature er indstillet til 250, 0.8, Falsehenholdsvis 0 og 0. Vi indstiller temperaturen tæt på 1 for at kontrollere outputtet tilfældigt, mens vi i tekstgenereringsopgaven sætter den tæt på XNUMX for at gøre modellen mere kreativ. Følgende tabel sammenligner resultaterne. For hvert spørgsmål er outputtet fra finjusteret GPT-J mere nøjagtigt end det ikke-finjusterede.

| Input | Output fra GPT-J 6B før finjustering | Output fra GPT-J 6B efter finjustering |

| Hvad handler punkt 7 i 10-K SEC-filen om?: |

Hvad handler punkt 7 i 10-K SEC-filen om?: Punkt 7 i 10-K SEC-arkiveringen er følgende: "Selskabet har ikke modtaget nogen væsentlig negativ |

Punkt 7. Ledelsens diskussion og analyse af økonomiske forhold og resultater af operationer Fremadrettede udsagn |

| Hvordan påvirkede COVID-19-pandemien Amazons forretning?: |

Hvordan påvirkede COVID-19-pandemien Amazons forretning?: Amazons forretning bliver påvirket af COVID-19-pandemien på en række måder. Virksomheden oplever et fald i antallet af Prime-medlemskaber, hvilket er en stor del af virksomhedens forretning. Virksomheden oplever også et fald i antallet af Prime-medlemskaber. Amazon oplever også et fald i antallet af ordrer placeret på sin hjemmeside. Virksomheden oplever også et fald i antallet af mennesker, der handler på sin hjemmeside. Amazon oplever også et fald i antallet af mennesker, der handler på deres hjemmeside. Amazon oplever også et fald i antallet af mennesker, der handler på deres hjemmeside. Amazon oplever også et fald i antallet af mennesker, der handler på deres hjemmeside. Amazon oplever også et fald i antallet af mennesker, der handler |

Hvordan påvirkede COVID-19-pandemien Amazons forretning?: COVID-19-pandemien har påvirket vores forretning på flere måder. For det første har det forstyrret vores forsyningskæde, og det har påvirket kundernes efterspørgsel, hvilket igen har påvirket vores salgs- og driftsresultater. For det andet har det øget vores udgifter til annoncering og markedsføring, hvilket måske ikke er effektivt i det lange løb. For det tredje har det øget vores udgifter til teknologisk infrastruktur og computerkapacitet, hvilket måske ikke er effektivt i det lange løb. For det fjerde har det øget vores udgifter til opfyldelse og kundeservice, hvilket måske ikke er effektivt i det lange løb. Endelig har det øget vores udgifter til indhold, hvilket måske ikke er effektivt i det lange løb. Se punkt 8 i del II, "Årsregnskaber og supplerende data - Note 1 - Beskrivelse af forretnings- og regnskabspraksis. |

| Hvad driver salgsvæksten hos Amazon?: | Amazon er verdens største online forhandler. Det er også verdens største online markedsplads. Det er også verden' | Salgsvækst hos Amazon er primært drevet af øget kundebrug, herunder øget udvalg, lavere priser og øget bekvemmelighed og øget salg fra andre sælgere på vores hjemmesider. |

Ryd op

For at undgå løbende opkrævninger skal du slette SageMaker-slutpunkterne. Du kan slette endepunkterne via SageMaker-konsollen eller fra notesbogen ved at bruge følgende kommandoer:

Konklusion

JumpStart er en funktion i SageMaker, der giver dig mulighed for hurtigt at komme i gang med ML. JumpStart bruger open source, forudtrænede modeller til at løse almindelige ML-problemer som billedklassificering, objektgenkendelse, tekstklassificering, sætningsparklassificering og besvarelse af spørgsmål.

I dette indlæg viste vi dig, hvordan du finjusterer og implementerer en forudtrænet LLM (GPT-J 6B) til tekstgenerering baseret på SEC-fyldningsdatasættet. Vi demonstrerede, hvordan modellen forvandlede sig til en finansdomæneekspert ved at gennemgå finjusteringsprocessen på blot to årsrapporter fra virksomheden. Denne finjustering gjorde det muligt for modellen at generere indhold med en forståelse af økonomiske emner og større præcision. Prøv løsningen på egen hånd, og lad os vide, hvordan det går i kommentarerne.

Vigtigt: Dette indlæg er kun til demonstrationsformål. Det er ikke finansiel rådgivning og bør ikke påberåbes som finansiel eller investeringsrådgivning. Posten brugte modeller, der var forudtrænede på data hentet fra SEC EDGAR-databasen. Du er ansvarlig for at overholde EDGARs adgangsvilkår og -betingelser, hvis du bruger SEC-data.

For at lære mere om JumpStart, tjek følgende indlæg:

Om forfatterne

Dr. Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Dr. Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Dr. Sanjiv Das er Amazon Scholar og Terry-professor i finans- og datavidenskab ved Santa Clara University. Han har post-graduate grader i finans (M.Phil og PhD fra New York University) og Computer Science (MS fra UC Berkeley) og en MBA fra Indian Institute of Management, Ahmedabad. Før han blev akademiker, arbejdede han i derivatbranchen i Asien-Stillehavsområdet som Vice President hos Citibank. Han arbejder med multimodal maskinlæring inden for finansielle applikationer.

Dr. Sanjiv Das er Amazon Scholar og Terry-professor i finans- og datavidenskab ved Santa Clara University. Han har post-graduate grader i finans (M.Phil og PhD fra New York University) og Computer Science (MS fra UC Berkeley) og en MBA fra Indian Institute of Management, Ahmedabad. Før han blev akademiker, arbejdede han i derivatbranchen i Asien-Stillehavsområdet som Vice President hos Citibank. Han arbejder med multimodal maskinlæring inden for finansielle applikationer.

Arun Kumar Lokanatha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, træne og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i deep learning, især inden for NLP og CV. Uden for arbejdet nyder han at løbe og vandre.

Arun Kumar Lokanatha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, træne og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i deep learning, især inden for NLP og CV. Uden for arbejdet nyder han at løbe og vandre.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :har

- :er

- :ikke

- $3

- $OP

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- evner

- I stand

- Om

- akademisk

- adgang

- Bogføring og administration

- Ophobe

- nøjagtighed

- præcis

- opnå

- erhvervelse

- tværs

- Lov

- tilføjet

- Tilføjede funktioner

- Desuden

- Derudover

- adresse

- Reklame

- rådgivning

- påvirke

- Efter

- mod

- AI

- Alexa

- algoritme

- algoritmer

- Alle

- tillader

- også

- Skønt

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- Amazon.com

- amerika

- beløb

- an

- analyse

- analysere

- ,

- Andrew

- årligt

- En anden

- besvare

- enhver

- nogen

- api

- applikationer

- anvendt

- tilgang

- passende

- apps

- ER

- OMRÅDE

- artikel

- AS

- vurdering

- At

- opmærksomhed

- tiltrækker

- AUGUST

- Automatisk Ur

- til rådighed

- AWS

- Bar

- bund

- baseret

- BE

- fordi

- bliver

- været

- før

- være

- Tro

- fordele

- Berkeley

- Bedre

- Big

- milliarder

- både

- bred

- bygge

- indbygget

- virksomhed

- men

- by

- ringe

- kaldet

- Opkald

- CAN

- Kan få

- stand

- Kapacitet

- kort

- hvilken

- tilfælde

- tilfælde

- attestere

- kæde

- udfordringer

- Kanal

- afgifter

- chatbots

- kontrollere

- Vælg

- valgte

- valgt

- omstændigheder

- Citibank

- Clara

- klassificering

- Luk

- klyngedannelse

- kode

- Kolonne

- KOM

- kommentarer

- Fælles

- almindeligt

- samfund

- Virksomheder

- selskab

- Selskabs

- sammenligne

- sammenlignet

- sammenligne

- sammenligning

- fuldføre

- færdiggørelse

- Compute

- computer

- Datalogi

- computing

- computerkraft

- betingelse

- betingelser

- konferencer

- Overvej

- betragtes

- Konsol

- konstruere

- Forbrugere

- indeholder

- Container

- indeholder

- indhold

- fortsæt

- kontrol

- kontrol

- bekvemmelighed

- Corporate

- Tilsvarende

- Koste

- dækket

- Dækker

- Covid-19

- COVID-19-pandemi

- skabe

- Kreativ

- kritisk

- For øjeblikket

- skik

- kunde

- Kundeservice

- Kunder

- data

- datalogi

- Database

- datasæt

- december

- Afvis

- dyb

- dyb læring

- Standard

- leverer

- leverer

- Efterspørgsel

- demonstrere

- demonstreret

- indsætte

- indsat

- implementering

- Derivater

- beskrevet

- beskrivelse

- Design

- konstrueret

- detaljer

- Detektion

- Bestem

- bestemmer

- udviklere

- udvikling

- Udvikling

- Enheder

- DID

- forskellige

- svært

- digital

- direkte

- videregivelse

- diskutere

- diskussion

- distribueret

- distribueret træning

- Docker

- dokumenter

- domæne

- snesevis

- drevet

- i løbet af

- hver

- tidligere

- nemt

- nem at bruge

- Effektiv

- effektivitet

- effektivitet

- effektiv

- elektronisk

- muliggøre

- aktiveret

- Endpoint

- forbedret

- Enterprise

- virksomheder

- Hele

- enhed

- epoker

- Ernst & Young

- især

- etablere

- evaluere

- evaluere

- evaluering

- hverdagen

- at alt

- eksempel

- eksempler

- Undtagen

- udveksling

- Dyrke motion

- eksisterende

- udvidelse

- forvente

- forventning

- dyrt

- eksperiment

- ekspert

- Udforskning

- omfattende

- Ansigtet

- FAST

- Funktionalitet

- få

- felt

- File (Felt)

- Arkivering

- Endelig

- finansiere

- finansielle

- økonomisk rådgivning

- finansielle data

- økonomisk information

- ende

- Fornavn

- passer

- Fokus

- fokuserer

- efter

- følger

- Til

- Til investorer

- Forecast

- forkant

- formular

- format

- fremadrettet

- fundet

- Foundation

- Fjerde

- fra

- fuld

- funktionalitet

- fundamental

- yderligere

- fremtiden

- generere

- genereret

- genererer

- generation

- få

- given

- Global

- Go

- Goes

- gå

- godt

- GPU'er

- gradienter

- større

- Ground

- Grow

- Dyrkning

- Vækst

- Hardware

- Have

- he

- Helse

- Health Care

- hjælpe

- hjælper

- link.

- Høj

- Høj ydeevne

- besidder

- hætte

- host

- hostede

- Hvordan

- How To

- HTML

- http

- HTTPS

- KrammerFace

- Hundreder

- hundreder af millioner

- Hyperparameter optimering

- i

- idé

- identificeret

- billede

- Billedklassificering

- KIMOs Succeshistorier

- påvirket

- importere

- imponerende

- Forbedre

- in

- Inc.

- omfatter

- medtaget

- omfatter

- Herunder

- Indkomst

- inkorporering

- Forøg

- øget

- stigende

- utrolige

- indiske

- oplysninger

- Infrastruktur

- initiativer

- indgang

- instans

- i stedet

- Institut

- integrere

- interagere

- interesser

- internationalt

- ind

- indføre

- investering

- Investopedia

- investor

- Investorer

- IT

- Varer

- ITS

- Job

- jpg

- json

- lige

- Nøgle

- Kend

- viden

- kendt

- Etiketter

- Sprog

- Sprog

- stor

- største

- lancere

- LÆR

- lærte

- læring

- Bibliotek

- Licenser

- lys

- ligesom

- Liste

- LLM

- Lang

- Se

- leder

- off

- Lav

- lave priser

- maskine

- machine learning

- lavet

- større

- lave

- Making

- administrere

- ledelse

- manuelt

- mange

- Marts

- Marked

- Marketing

- markedsplads

- massive

- materiale

- Kan..

- midler

- måle

- medlemskab

- medlemskaber

- Hukommelse

- metode

- metrisk

- migrere

- million

- millioner

- minutter

- blandet

- ML

- Mobil

- mobil-apps

- model

- modeller

- mere

- mest

- Film

- MS

- flere

- navn

- Som hedder

- Natural

- Natural Language Processing

- Navigation

- nødvendig

- Behov

- netto

- Ny

- nyt produkt

- New York

- næste

- NLP

- node

- Nord

- nordamerika

- notesbog

- nu

- nummer

- Fedme

- objekt

- Objektdetektion

- opnå

- opnået

- of

- tilbyde

- tilbyde

- tilbud

- Tilbud

- on

- ONE

- igangværende

- online

- online markedsplads

- online forhandler

- kun

- open source

- drift

- Produktion

- Muligheder

- optimering

- or

- ordrer

- ordrer

- Organiseret

- original

- Andet

- vores

- Outlook

- output

- uden for

- i løbet af

- overstyring

- oversigt

- egen

- ejer

- pandemi

- brød

- papirer

- parametre

- del

- særlig

- især

- parter

- passerer

- Bestået

- Passing

- sti

- mønstre

- Mennesker

- Udfør

- ydeevne

- udfører

- udfører

- periode

- perioder

- PHIL

- fysisk

- Fysisk

- pick

- Steder

- plato

- Platon Data Intelligence

- PlatoData

- politikker

- mulig

- Indlæg

- Indlæg

- potentiale

- magt

- Praktisk

- Precision

- forudsige

- forudsige

- Forudsigelser

- Predictor

- præsentere

- forelagt

- præsident

- forhindre

- Forebyggelse

- tidligere

- pris

- Priser

- prissætning

- primært

- Prime

- Main

- Forud

- problemer

- behandle

- Processer

- forarbejdning

- Produkt

- produktion

- produktivitet

- Produkter

- Professor

- Program

- Kampagner

- proposition

- give

- forudsat

- giver

- offentligt

- offentliggjort

- forlægger

- formål

- formål

- Python

- Kvarter

- spørgsmål

- Spørgsmål

- hurtigt

- tilfældighed

- Sats

- Læs

- ægte

- modtaget

- reducere

- refererer

- om

- regulært udtryk

- region

- Regulering

- lovgivningsmæssige

- relaterede

- frigivet

- indberette

- Rapporter

- påkrævet

- Kræver

- forskning

- Ressourcer

- respekt

- svar

- ansvarlige

- resultere

- Resultater

- detail

- detailhandler

- revideret

- revolutionere

- robust

- roller

- Royal

- Kør

- kører

- sagemaker

- SageMaker Inference

- salg

- samme

- Santa

- skalerbar

- Scale

- Videnskab

- Videnskabsmand

- score

- SDK

- Søg

- SEK

- SEC arkivering

- Anden

- sekretær

- Sektion

- sektioner

- Værdipapirer

- se

- segmenter

- valgt

- valg

- sælger

- Sælgere

- Salg

- senior

- dømme

- stemningen

- september

- Sequence

- Series

- Serie A

- tjener

- tjeneste

- Tjenester

- sæt

- indstilling

- indstillinger

- flere

- Del

- Levering

- Shopping

- bør

- Vis

- vist

- Shows

- betydeligt

- Simpelt

- enkelt

- Størrelse

- størrelser

- mindre

- So

- Samfund

- solgt

- løsninger

- Løsninger

- SOLVE

- Kilder

- specialister

- specialiserede

- specialiseret

- specifikke

- udgifterne

- starte

- påbegyndt

- Tilstand

- udsagn

- statistiske

- Trin

- Steps

- opbevaring

- forhandler

- Strategisk

- Strategi

- streaming

- styrke

- stræbe

- Studio

- succes

- sådan

- forsyne

- forsyningskæde

- Understøttet

- Støtte

- Understøtter

- systemet

- Systemer

- bord

- Tag

- tager

- Opgaver

- opgaver

- hold

- Teknologier

- vilkår

- vilkår og betingelser

- prøve

- Tekstklassificering

- end

- at

- Området

- Fremtiden

- deres

- Them

- derfor

- Disse

- de

- ting

- Tredje

- tredje partier

- denne

- tre

- Gennem

- tid

- tidskrævende

- gange

- til

- Tokens

- top

- Emner

- spor

- Tog

- uddannet

- Kurser

- Overførsel

- omdannet

- Oversætte

- Traveling

- Sandheden

- TUR

- tv

- ui

- under

- forstå

- forståelse

- enestående

- universitet

- ubegrænset

- opdateringer

- us

- Brug

- brug

- anvendte

- ved brug af

- sædvanligvis

- udnyttet

- Ved hjælp af

- validering

- værdi

- Værdier

- forskellige

- udgave

- via

- Vice President

- næsten

- var

- washington

- Vej..

- måder

- we

- web

- webservices

- Hjemmeside

- websites

- GODT

- hvorvidt

- som

- WHO

- vilje

- med

- uden

- ord

- Arbejde

- arbejdede

- virker

- Verdens

- ville

- år

- år

- Du

- unge

- Din

- zephyrnet