GPU'er er et kraftfuldt værktøj til maskinlærings-arbejdsbelastninger, selvom de ikke nødvendigvis er det rigtige værktøj til ethvert AI-job, ifølge Michael Bronstein, Twitters leder af graflæringsforskning.

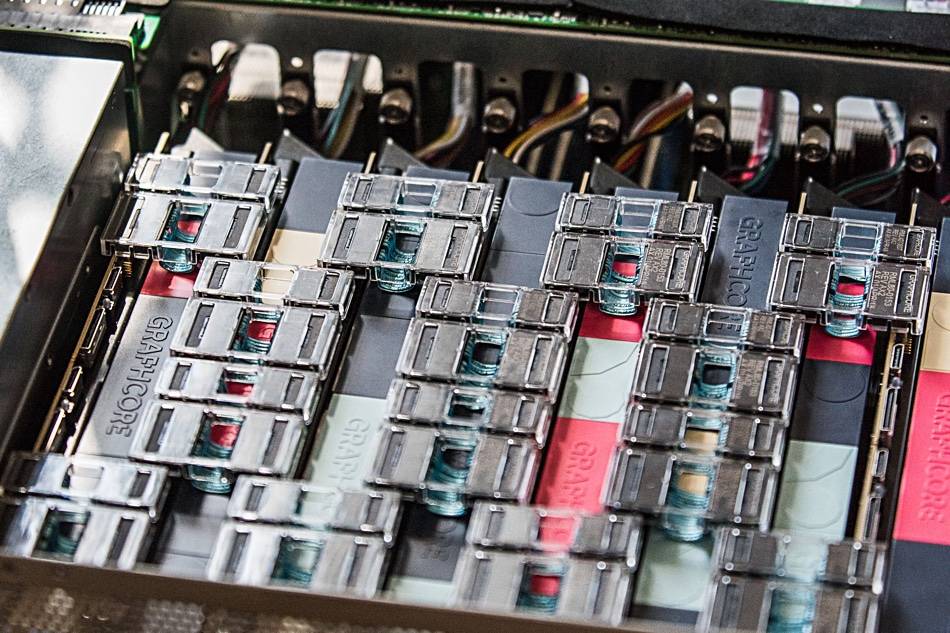

Hans team viste for nylig, at Graphcores AI-hardware tilbød en "størrelsesordenshastighed, når man sammenligner en enkelt IPU-processor med en Nvidia A100 GPU," i temporal graph network (TGN)-modeller.

"Valget af hardware til implementering af Graph ML-modeller er et afgørende, men ofte overset problem," lyder en fælles artikel skrevet af Bronstein med Emanuele Rossi, en ML-forsker på Twitter, og Daniel Justus, en forsker hos Graphcore.

Grafiske neurale netværk tilbyder et middel til at finde orden i komplekse systemer og er almindeligt anvendt i sociale netværk og anbefalingssystemer. Men den dynamiske natur af disse miljøer gør disse modeller særligt udfordrende at træne, forklarede trioen.

Gruppen undersøgte levedygtigheden af Graphcores IPU'er ved håndtering af flere TGN-modeller. Indledende test blev udført på en lille TGN-model baseret på JODIE Wikipedia-datasæt, der linker brugere til redigeringer, de har lavet på sider. Grafen bestod af 8,227 brugere og 1,000 artikler til i alt 9,227 noder. JODIE er et open source-forudsigelsessystem designet til at give mening i tidsmæssige interaktionsnetværk.

Trioens eksperimenter afslørede, at store batchstørrelser resulterede i forringet validering og slutningsnøjagtighed sammenlignet med mindre batchstørrelser.

"Nodehukommelsen og grafforbindelsen bliver begge kun opdateret, efter at en fuld batch er behandlet," skrev trioen. "Derfor kan de senere begivenheder inden for en batch stole på forældede oplysninger, da de ikke er opmærksomme på tidligere begivenheder."

Men ved at bruge en batchstørrelse på 10 var gruppen i stand til at opnå optimal validerings- og slutningsnøjagtighed, men de bemærker, at ydeevnen på IPU'en stadig var overlegen i forhold til en GPU, selv når der blev brugt store batchstørrelser.

"Når man bruger en batchside på 10, kan TGN trænes på IPU'en omkring 11 gange hurtigere, og selv med en stor batchstørrelse på 200 er træningen stadig tre gange hurtigere på IPU'en," lyder det i indlægget. "Igennem alle operationer håndterer IPU'en små batchstørrelser mere effektivt."

Holdet hævder, at den hurtige hukommelsesadgang og høje gennemløb, der tilbydes af Graphcores store SRAM-cache i processoren, gav IPU'en en fordel.

Denne ydeevne blev også udvidet til grafmodeller, der oversteg IPU'ens in-processor-hukommelse - hver IPU har en 1GB SRAM-cache - hvilket kræver brug af langsommere DRAM-hukommelse knyttet til chipsene.

I test på en grafmodel bestående af 261 millioner følgere mellem 15.5 millioner Twitter-brugere, har brugen af DRAM til nodehukommelsen reduceret gennemløbet med en faktor to, fandt Bronsteins team.

Men når de inducerede flere undergrafer baseret på et syntetisk datasæt 10X størrelsen af Twitter-grafen, fandt holdet gennemløbet skaleret uafhængigt af grafens størrelse. Med andre ord var præstationshittet resultatet af at bruge langsommere hukommelse og ikke resultatet af modellens størrelse.

"Ved at bruge denne teknik på IPU'en kan TGN anvendes på næsten vilkårlige grafstørrelser, kun begrænset af mængden af tilgængelig værtshukommelse, mens den bibeholder en meget høj gennemstrømning under træning og inferens," lyder artiklen.

Holdet konkluderede, at Graphcores IPU-arkitektur viser betydelige fordele i forhold til GPU'er i arbejdsbelastninger, hvor databehandling og hukommelsesadgang er heterogen.

Den bredere løsning er dog, at ML-forskere nøje bør overveje deres valg af hardware og ikke som standard bør bruge GPU'er.

"Tilgængeligheden af cloud computing-tjenester, der abstraherer den underliggende hardware, fører til en vis dovenskab i denne henseende," skrev trioen. "Vi håber, at vores undersøgelse vil henlede mere opmærksomhed på dette vigtige emne og bane vejen for fremtidige, mere effektive algoritmer og hardwarearkitekturer til Graph ML-applikationer." ®

- AI

- ai kunst

- ai kunst generator

- en robot

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- Registret

- zephyrnet