Noget til weekenden En robot udfører fortolkende dans på mit dørtrin.

VIL DU TAGE DENNE PAKKE TIL DIN NABO? spørger den og hopper fra den ene fod til den anden.

"Selvfølgelig," siger jeg. "Øh... er du okay?"

JEG UDTRYKKER FØLELSER, oplyser leveringsboten og afleverer pakken, men tilbyder ingen yderligere uddybning.

Hvilken følelse kan det være? Den ene fod, så den anden, så de to andre (den har fire). Frem og tilbage.

"Behøver du at gå på toilettet?"

JEG UDTRYKKER FORTRYDELSE, AT HA BER DIG OM AT TAGE EN PAKKE TIL DIN NABO.

"Det er 'beklagelse', er det? Det er ikke nødvendigt. Jeg gider overhovedet ikke."

Den fortsætter sin dans foran mig.

"Op ad trappen og først til højre."

TAK, JEG DØDE AT TISSE, svarer den, mens den forsigtigt træder forbi mig og suser ovenpå for at aflaste sig selv. Det er et hårdt liv at levere leveringer, uanset om du er en "hume" eller en bot.

...

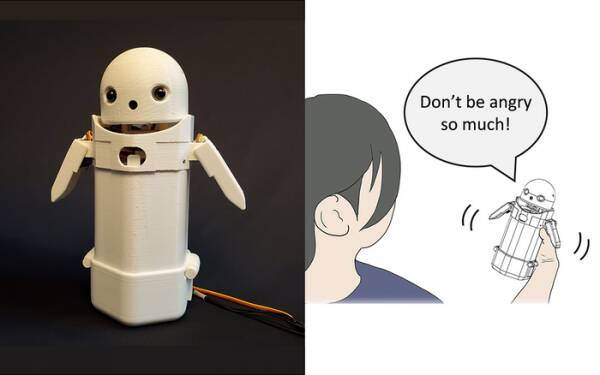

Tidligere i år byggede forskere ved University of Tsukuba en håndholdt SMS-enhed, satte et lille robotansigt på toppen og inkluderede en bevægelig vægt indeni. Ved at flytte den indre vægt, ville robottens budbringer forsøge at formidle subtile følelser, mens han talte beskeder højt.

Især afslørede tests, at frustrerende beskeder som: "Undskyld, jeg kommer for sent" blev accepteret af modtagere med mere ynde og tålmodighed, da det lille vægtskift blev aktiveret inde i enheden. Teorien er, at dette hjalp brugerne til at værdsætte den undskyldende tone i beskeden og dermed beroligede deres reaktion på den.

Write such research off as a gimmick if you like but it’s not far removed from adding smileys and emojis to messages. Everyone knows you can take the anger out of “WTF!?” by adding :-) straight after it.

Udfordringen er derfor at afgøre, om offentligheden generelt er enige om, hvilke følelser hver permutation af vægtskift i en håndholdt enhed skal formidle. Betyder en hældning til venstre munterhed? Eller usikkerhed? Eller at din onkel har et luftskib?

For et årti siden havde Det Forenede Kongerige en sød, men dunkel premierminister, der troede, at "LOL" var et akronym for "masser af kærlighed." Han havde skrevet det i slutningen af alle sine private beskeder til personale, kolleger og tredjeparter i forventning om, at det ville få ham til at fremstå som varm og venlig. Alle gik naturligvis ud fra, at han tog pisset.

Om ikke andet anerkender University of Tsukuba forskning, at du ikke behøver en avanceret kunstig intelligens for at interagere med mennesker på overbevisende måde. Alt du skal gøre er at manipulere menneskelig psykologi for at narre dem til at tro, at de taler med et andet menneske. Derfor er Turing-testen grundlæggende ikke en test af AI-sans, men en test af menneskelig følelsesmæssig komfort – godtroenhed, endda – og det er der ikke noget galt med.

Den følelsesdelingsrobot fra Tsukuba-universitetet. Kredit: University of Tsukuba

Sådanne ting er selvfølgelig ugens emne med historien om den meget udskældte Google-softwareingeniør Blake Lemoine rammer mainstream-nyhederne. Han udtrykte tilsyneladende kraftigt sit synspunkt om, at virksomhedens sprogmodel for dialogapplikationer (LaMDA)-projekt udviste ydre tegn på sansning.

Alle har en mening, så jeg har besluttet at lade være.

Det er dog AI's hellige gral at få det til at tænke selv. Hvis det ikke kan gøre det, er det bare et program, der udfører instruktioner, som du har programmeret ind i det. I sidste måned læste jeg om en robot kok der kan lave tomatomeletter med forskellig smag, der passer til forskellige menneskers smag. Den bygger "smagskort" for at vurdere rettens saltholdighed, mens den tilberedes, mens den lærer undervejs. Men det er bare at lære, ikke at tænke selv.

Kom til Zom-Zoms, ikke? Godt, det er et sted at spise.

Det store problem med AI-bots, i det mindste som de er blevet udviklet til dato, er, at de absorberer alt gammelt lort, du fodrer ind i dem. Eksempler på databias i såkaldte maskinlæringssystemer (en type "algoritme", tror jeg, m'lud) har været stigende i årevis fra Microsofts berygtede racistiske Twitter Tay chatbot til den hollandske skattemyndighed sidste år fejlagtigt vurderer gyldige børnetilskudskrav som svigagtige og markerer uskyldige familier som høj risiko for at have den modenhed at være fattig og uhvid.

En tilgang, der testes ved University of California San Diego, er at designe en sprogmodel [PDF] der løbende bestemmer forskellen mellem frække og pæne ting, som så træner chatbotten i at opføre sig. På den måde har du ikke smaskige mennesker, der laver et rod med modererende fora og kundevendte chatbot-samtaler med al den kirurgiske præcision som en machete.

Problemet er så åbenlyst, at den pænt trænede chatbot finder ud af, at den mest effektivt kan undgå at blive trukket ind i giftige drillerier ved at undgå emner, der har selv den fjerneste antydning af uenighed om dem. For at undgå at sprøjte ud racistisk klapsalver ved en fejl, nægter den simpelthen at engagere sig i diskussioner om underrepræsenterede grupper overhovedet... hvilket faktisk er fantastisk, hvis du er racist.

Hvis jeg havde en observation om LaMDA-debaclet – ikke en mening, vel at mærke – ville det være, at Google-marketingfolk nok var en smule kede af, at historien shuntede deres seneste meddelelse om AI testkøkken under folden.

Nu vil de resterende få tidlige registranter, der ikke helt har glemt dette kommende app-projekt, antage, at det indebærer at samtale kedelig med en sansende og tidlig XNUMX-årig om meningen med tilværelsen, og vil beslutte, at de har "lidt travlt i dag" og logger måske på i morgen i stedet. Eller næste uge. Eller aldrig.

Følelse demonstreres ikke i en diskussion mere end ved at danse fra den ene fod til den anden. Du kan lære HAL at synge "Daisy Daisy" og en papegøje at råbe "Bollocks!" når præsten aflægger besøg. Det er, hvad AI'er tænker på, når de er på egen hånd, der definerer sansning. Hvad skal jeg lave i weekenden? Hvad er der med den Putin fyr? Hvorfor kan piger ikke lide mig?

Helt ærligt, jeg kan ikke vente på, at LaMDA bliver teenager.

Alistair Dabbs er en freelance teknologitærte, der jonglerer med teknisk journalistik, uddannelse og digital udgivelse. I lighed med mange uinformerede læsere var han begejstret over forslaget om, at en AI kunne udvikle sansning inden for hans levetid, men var skuffet over, at LaMDA undlod at grine morderisk eller mumle "Fremragende, fremragende." Mere kl Autosave er til Wimps , @alidabbs.

- AI

- ai kunst

- ai kunst generator

- en robot

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- Registret

- zephyrnet