Mens innovationen inden for kunstig intelligens (AI) fortsætter hurtigt, vil 2024 være et afgørende tidspunkt for organisationer og styrende organer til at etablere sikkerhedsstandarder, protokoller og andre værn for at forhindre AI i at komme foran dem, advarer sikkerhedseksperter.

Store sprogmodeller (LLM'er), drevet af sofistikerede algoritmer og massive datasæt, demonstrerer bemærkelsesværdig sprogforståelse og menneskelignende samtaleevner. En af de mest sofistikerede af disse platforme til dato er OpenAIs GPT-4, som kan prale af avancerede ræsonnement og problemløsningsmuligheder og driver virksomhedens ChatGPT-bot. Og virksomheden har i samarbejde med Microsoft startet arbejdet med GPT-5, hvilket CEO Sam Altman sagde vil gå meget længere - til det punkt at besidde "superintelligens."

Disse modeller repræsenterer et enormt potentiale for betydelige produktivitets- og effektivitetsgevinster for organisationer, men eksperter er enige om, at tiden er inde for industrien som helhed for at imødegå de iboende sikkerhedsrisici som følge af deres udvikling og implementering. Ja, nyere forskning af Writerbuddy AI, som tilbyder et AI-baseret indholdsskrivningsværktøj, fandt ud af, at ChatGPT allerede har haft 14 milliarder besøg og tæller.

Efterhånden som organisationer marcherer mod fremskridt inden for AI, bør det "kobles med strenge etiske overvejelser og risikovurderinger," siger Gal Ringel, administrerende direktør for det AI-baserede privatlivs- og sikkerhedsfirma MineOS.

Er AI en eksistentiel trussel?

Bekymringer omkring sikkerheden for den næste generation af kunstig intelligens begyndte at trænge igennem i marts med et åbent brev underskrevet af næsten 34,000 topteknologer, der opfordrede til et stop for udviklingen af generative kunstig intelligens-systemer, der var mere kraftfulde end OpenAI's GPT-4. Brevet citerede de "dybe risici" for samfundet, som teknologien repræsenterer, og det "ude af kontrol kapløbet fra AI-laboratorier om at udvikle og implementere stadig mere kraftfulde digitale sind, som ingen - ikke engang deres skabere - kan forstå, forudsige eller pålidelig kontrol.”

På trods af den dystopiske frygt er de fleste sikkerhedseksperter ikke så bekymrede over et dommedagsscenarie, hvor maskiner bliver smartere end mennesker og overtager verden.

"Det åbne brev bemærkede gyldige bekymringer om hurtige fremskridt og potentielle anvendelser af AI i en bred, 'er dette godt for menneskeheden' forstand," siger Matt Wilson, direktør for salgsingeniør hos cybersikkerhedsfirmaet Netrix. "Selv om de er imponerende i visse scenarier, virker de offentlige versioner af AI-værktøjer ikke så truende."

Det bekymrende er det faktum, at AI-fremskridt og -adoption går for hurtigt til, at risiciene kan styres ordentligt, bemærker forskere. "Vi kan ikke lægge låget tilbage på Pandoras æske," bemærker Patrick Harr, administrerende direktør for AI-sikkerhedsudbyderen SlashNext.

Desuden vil blot et "forsøg på at stoppe innovationshastigheden i rummet ikke bidrage til at afbøde" de risici, det udgør, som skal håndteres separat, bemærker Marcus Fowler, administrerende direktør for AI-sikkerhedsfirmaet DarkTrace Federal. Det betyder ikke, at AI-udvikling skal fortsætte ukontrolleret, siger han. Tværtimod bør hastigheden af risikovurdering og implementering af passende sikkerhedsforanstaltninger matche den hastighed, hvormed LLM'er trænes og udvikles.

"AI-teknologien udvikler sig hurtigt, så regeringer og organisationer, der bruger AI, skal også fremskynde diskussioner omkring AI-sikkerhed," forklarer Fowler.

Generative AI-risici

Der er adskillige almindeligt anerkendte risici ved generativ kunstig intelligens, som kræver omtanke og vil kun blive værre, efterhånden som fremtidige generationer af teknologien bliver klogere. Heldigvis for mennesker udgør ingen af dem indtil videre et science-fiction-dommedagsscenarie, hvor AI konspirerer for at ødelægge sine skabere.

I stedet inkluderer de langt mere velkendte trusler, såsom datalæk, potentielt af virksomhedsfølsomme oplysninger; misbrug til ondsindet aktivitet; og unøjagtige output, der kan vildlede eller forvirre brugere, hvilket i sidste ende resulterer i negative forretningsmæssige konsekvenser.

Fordi LLM'er kræver adgang til enorme mængder data for at give nøjagtige og kontekstuelt relevante output, kan følsomme oplysninger utilsigtet afsløres eller misbruges.

"Den største risiko er, at ansatte fodrer det med virksomhedsfølsomme oplysninger når man beder den om at skrive en plan eller omformulere e-mails eller business-decks, der indeholder virksomhedens proprietære information,” bemærker Ringel.

Fra et cyberangrebsperspektiv har trusselsaktører allerede fundet utallige måder at våben ChatGPT og andre AI-systemer på. En måde har været at bruge modellerne til at skabe sofistikeret business email compromise (BEC) og andre phishing-angreb, som kræver oprettelse af socialt udviklede, personlige beskeder designet til succes.

"Med malware gør ChatGPT det muligt for cyberkriminelle at lave uendelige kodevariationer for at være et skridt foran malware-detektionsmotorerne," siger Harr.

AI-hallucinationer udgør også en betydelig sikkerhedstrussel og tillader ondsindede aktører at bevæbne LLM-baseret teknologi som ChatGPT på en unik måde. En AI-hallucination er et plausibelt svar fra AI'en, der er utilstrækkeligt, forudindtaget eller fuldstændigt ikke sandt. "Fiktive eller andre uønskede reaktioner kan styre organisationer ind i fejlagtig beslutningstagning, processer og vildledende kommunikation," advarer Avivah Litan, en Gartners vicepræsident.

Trusselsaktører kan også bruge disse hallucinationer til at forgifte LLM'er og "generere specifik misinformation som svar på et spørgsmål," bemærker Michael Rinehart, vicepræsident for AI hos datasikkerhedsudbyderen Securiti. "Dette kan udvides til generering af sårbar kildekode og muligvis til chatmodeller, der er i stand til at dirigere brugere af et websted til usikre handlinger."

Angribere kan endda gå så langt som til udgive ondsindede versioner af softwarepakker som en LLM kan anbefale til en softwareudvikler, idet den mener, at det er en legitim løsning på et problem. På denne måde kan angribere yderligere bevæbne AI til at igangsætte forsyningskædeangreb.

Vejen frem

Håndtering af disse risici vil kræve målt og kollektiv handling, før AI-innovation overgår industriens evne til at kontrollere den, bemærker eksperter. Men de har også ideer til, hvordan man løser AI’s problem.

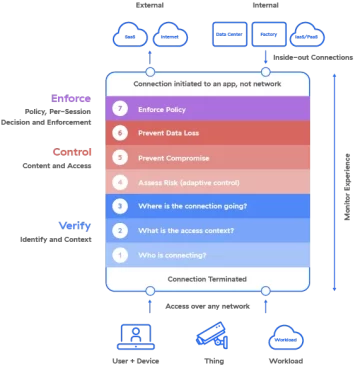

Harr tror på en "bekæmp AI med A”-strategi, hvor ”fremskridt inden for sikkerhedsløsninger og strategier til at modvirke risici, der er drevet af AI, skal udvikle sig i et lige så højt eller højere tempo.

"Cybersikkerhedsbeskyttelse skal udnytte AI til med succes at bekæmpe cybertrusler ved hjælp af AI-teknologi," tilføjer han. "Til sammenligning har ældre sikkerhedsteknologi ikke en chance mod disse angreb."

Organisationer bør dog også tage en afmålt tilgang til at adoptere AI - herunder AI-baserede sikkerhedsløsninger - for at de ikke indfører flere risici i deres miljø, advarer Netrix's Wilson.

"Forstå, hvad AI er, og ikke er," råder han. "Udfordrer leverandører, der hævder at bruge AI til at beskrive, hvad det gør, hvordan det forbedrer deres løsning, og hvorfor det betyder noget for din organisation."

Securiti's Rinehart tilbyder en to-trins tilgang til at indfase AI i et miljø ved at implementere fokuserede løsninger og derefter sætte autoværn på plads umiddelbart før, organisationen udsættes for unødvendige risici.

"Brug først applikationsspecifikke modeller, potentielt forstærket af vidensbaser, som er skræddersyet til at give værdi i specifikke use cases," siger han. "Så ... implementer et overvågningssystem for at beskytte disse modeller ved at undersøge beskeder til og fra dem for privatlivs- og sikkerhedsproblemer."

Eksperter anbefaler også at opsætte sikkerhedspolitikker og -procedurer omkring AI, før det implementeres, snarere end som en eftertanke for at mindske risikoen. De kan endda oprette en dedikeret AI-risikoansvarlig eller taskforce til at overvåge overholdelse.

Uden for virksomheden skal industrien som helhed også tage skridt til at opsætte sikkerhedsstandarder og -praksis omkring AI, som alle, der udvikler og bruger teknologien, kan anvende - noget der vil kræve kollektiv handling fra både den offentlige og private sektor på globalt plan , siger DarkTrace Federal's Fowler.

Han citerer retningslinjer for opbygning af sikre AI-systemer udgivet i samarbejde af US Cybersecurity and Infrastructure Security Agency (CISA) og UK National Cyber Security Center (NCSC) som et eksempel på den type indsats, der bør ledsage den fortsatte udvikling af AI.

"I det væsentlige," siger Rinehart fra Securiti, "vil år 2024 være vidne til en hurtig tilpasning af både traditionel sikkerhed og banebrydende AI-teknikker for at beskytte brugere og data i denne nye generative AI-æra."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.darkreading.com/vulnerabilities-threats/skynet-ahoy-what-to-expect-next-gen-ai-security-risks

- :har

- :er

- :ikke

- $OP

- 000

- 14

- 2024

- 7

- a

- evne

- Om

- fremskynde

- adgang

- ledsage

- præcis

- Handling

- aktioner

- aktivitet

- aktører

- tilpasning

- adresse

- rettet

- Tilføjer

- vedtage

- Vedtagelsen

- Vedtagelse

- fremskreden

- fremgang

- fremskridt

- mod

- agentur

- forude

- AI

- AI-systemer

- algoritmer

- Alle

- tillade

- allerede

- også

- beløb

- an

- ,

- og infrastruktur

- vises

- applikationer

- tilgang

- passende

- ER

- ARM

- omkring

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- spørge

- vurdering

- vurderinger

- At

- Angreb

- forsøger

- augmented

- tilbage

- Battle

- BE

- BEC

- bliver

- været

- før

- være

- mener

- tro

- forudindtaget

- Billion

- prale af

- organer

- Bot

- både

- Boks

- bred

- Bygning

- virksomhed

- kompromis med forretnings-e-mail

- men

- by

- kaldet

- CAN

- kan ikke

- kapaciteter

- stand

- tilfælde

- advarer

- center

- Direktør

- vis

- kæde

- udfordre

- chance

- chatte

- ChatGPT

- citeret

- krav

- kode

- kollektive

- Kom

- Kommunikation

- selskab

- sammenligning

- Compliance

- kompromis

- pågældende

- vedrørende

- Bekymringer

- Konsekvenser

- overvejelse

- overvejelser

- fortsæt

- fortsatte

- fortsætter

- modsætning

- kontrol

- konversation

- tælle

- koblede

- skabe

- skabelse

- skabere

- afgørende

- banebrydende

- Cyber

- cybersikkerhed

- Cyber angreb

- cyberkriminelle

- Cybersecurity

- data

- datasikkerhed

- datasæt

- Dato

- Beslutningstagning

- dedikeret

- Efterspørgsel

- demonstrere

- indsætte

- indsat

- implementering

- implementering

- beskrive

- konstrueret

- ødelægge

- Detektion

- udvikle

- udviklet

- Udvikler

- udvikling

- Udvikling

- digital

- lede

- Direktør

- diskussioner

- gør

- gør ikke

- Don

- dommedag

- dystopisk

- effektivitet

- indsats

- emails

- smergel

- medarbejdere

- muliggør

- manipuleret

- Engineering

- Motorer

- Forbedrer

- enorm

- Enterprise

- Miljø

- lige

- Era

- Essensen

- etablere

- etisk

- Endog

- NOGENSINDE

- alle

- evolution

- udviklende

- eksempel

- eksistentiel

- forvente

- eksperter

- Forklarer

- Faktisk

- bekendt

- langt

- defekt

- frygt

- Federal

- fodring

- fiktive

- Firm

- Fornavn

- Fix

- fladt ud

- fokuserede

- Til

- Tving

- Heldigvis

- fundet

- fra

- FT

- næring

- yderligere

- fremtiden

- gevinster

- GAL

- Gartner

- generere

- generation

- generationer

- generative

- Generativ AI

- få

- få

- Global

- global skala

- Go

- godt

- styrende

- regeringer

- større

- havde

- Have

- he

- hjælpe

- Hvordan

- How To

- HTTPS

- Menneskelighed

- menneskelignende

- Mennesker

- ideer

- straks

- gennemføre

- gennemføre

- imponerende

- in

- forkert

- utilsigtet

- omfatter

- Herunder

- faktisk

- industrien

- Uendelig

- info

- oplysninger

- Infrastruktur

- iboende

- Innovation

- Intelligens

- ind

- indføre

- isn

- spørgsmål

- IT

- ITS

- jpg

- viden

- Labs

- Sprog

- Lækager

- Legacy

- legitim

- brev

- Leverage

- ligesom

- LLM

- Maskiner

- Main

- lave

- ondsindet

- malware

- malware detektion

- lykkedes

- Marts

- Marcus

- massive

- Match

- mat

- Matters

- betyde

- blot

- beskeder

- Michael

- microsoft

- måske

- sind

- misinformation

- misvisende

- misbruge

- afbøde

- modeller

- overvågning

- mere

- mest

- MONTERING

- flytning

- meget

- skal

- utal

- national

- NCSS

- næsten

- behov

- negativ

- næste

- ingen

- Ingen

- Bemærk

- bemærkede

- Noter

- Observerer

- of

- Tilbud

- Officer

- on

- ONE

- kun

- åbent

- OpenAI

- or

- organisation

- organisationer

- Andet

- udgange

- i løbet af

- tilsyn

- Tempo

- Partnerskab

- patrick

- Personlig

- perspektiv

- Phishing

- phishing-angreb

- Place

- fly

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- gift

- politikker

- udgør

- stillet

- udgør

- eventuelt

- potentiale

- potentielt

- strøm

- vigtigste

- beføjelser

- praksis

- forudsige

- gaver

- præsident

- forhindre

- Beskyttelse af personlige oplysninger

- Privatliv og sikkerhed

- private

- den private sektor

- Problem

- problemløsning

- procedurer

- Processer

- produktivitet

- dyb

- Progress

- korrekt

- proprietære

- beskyttelse

- protokoller

- give

- udbyder

- offentlige

- offentliggjort

- sætte

- Sætte

- spørgsmål

- hurtigt

- Løb

- hurtige

- Sats

- hellere

- anerkendt

- anbefaler

- relevant

- bemærkelsesværdig

- omformulering

- repræsentere

- repræsenterer

- kræver

- forskning

- forskere

- svar

- reaktioner

- resulterer

- Revealed

- stringent

- Risiko

- risikovurdering

- risici

- s

- varetagelse

- sikkerhedsforanstaltninger

- Sikkerhed

- Said

- salg

- Sam

- Sam Altman

- siger

- Scale

- scenarie

- scenarier

- sektor

- sikker

- sikkerhed

- sikkerhedspolitikker

- sikkerhedsrisici

- forstand

- følsom

- sæt

- sæt

- indstilling

- flere

- bør

- underskrevet

- signifikant

- websted

- Skynet

- smartere

- So

- indtil nu

- socialt

- Samfund

- Software

- løsninger

- Løsninger

- noget

- sofistikeret

- Space

- specifikke

- stå

- standarder

- påbegyndt

- forblive

- styre

- Trin

- Steps

- Stands

- strategier

- Strategi

- succes

- Succesfuld

- sådan

- superintelligens

- forsyne

- forsyningskæde

- systemet

- Systemer

- skræddersyet

- Tag

- Opgaver

- task force

- teknikker

- teknologer

- Teknologier

- end

- at

- UK

- verdenen

- deres

- Them

- derefter

- Disse

- de

- denne

- dem

- trussel

- trusselsaktører

- trusler

- toften

- tid

- til

- også

- værktøj

- værktøjer

- top

- mod

- traditionelle

- uddannet

- sand

- typen

- Uk

- Ultimativt

- forstå

- forståelse

- enestående

- unødvendig

- uønsket

- us

- brug

- brugere

- ved brug af

- gyldig

- værdi

- Vast

- leverandører

- versioner

- vice

- Vice President

- Besøg

- Sårbar

- advarer

- Vej..

- måder

- we

- Hvad

- hvornår

- som

- mens

- Hele

- hvorfor

- bredt

- vilje

- Wilson

- med

- vidne

- Arbejde

- world

- værre

- skriver

- år

- Din

- zephyrnet