Das abschließende CCC-Panel der AAAS 2023, „Aufrechterhaltung einer reichen Breite für künstliche Intelligenz“, fand am Sonntag, den 5. März, dem letzten Konferenztag, statt. Dieses Panel bestand aus David Danks (University of California – San Diego), Bo Li (University of Illinois – Urbana-Champaign) und Melanie Mitchell (Santa Fe Institute) und wurde von Maria Gini (University of Minnesota) moderiert.

Dr. Bo Li begann das Panel mit der Erörterung der Bedeutung der Durchführung vertrauenswürdigen maschinellen Lernens (ML) und der Möglichkeiten, wie wir sicherstellen können, dass ML sicher, gerecht und integrativ ist. Maschinelles Lernen ist allgegenwärtig, sagte Li, und wird heute bei einer beträchtlichen Anzahl alltäglicher Aktivitäten eingesetzt, z. B. beim Navigieren zur Arbeit, beim Senden einer „schnellen Antwort“ per E-Mail oder sogar beim Öffnen Ihres Telefons mithilfe der Gesichtserkennung. Viele dieser Technologien, die auf maschinellem Lernen basieren, sind jedoch anfällig für Angriffe. Diese Technologien sind auch nicht unfehlbar und machen bekanntermaßen Fehler, wie z. B. die Gesichtserkennung, die zu falschen Verhaftungen führt.

Dr. Li wies dann auf einen Artikel in PCMag hin, der voraussagte, dass das Jahr 2023 aufgrund zunehmender Ransomware-Angriffe und gegnerischer Programme für künstliche Intelligenz ein Sicherheitsalptraum sein wird. Glücklicherweise hat es in letzter Zeit eine Verschiebung hin zur Anerkennung des Risikos von Programmen der künstlichen Intelligenz gegeben. Die Veröffentlichung des „Blueprint for an AI Bill of Rights“ durch das Office of Science and Technology Policy (OSTP) des Weißen Hauses und die Petition zum Stopp weiterer KI-Entwicklungen, die von vielen Branchenführern unterzeichnet wurde, darunter Steve Wozniak und Elon Musk, haben die Risiken einer schnellen und ungeregelten KI-Entwicklung beleuchtet. Der OSTP-Blueprint für eine KI-Bill of Rights umreißt die Notwendigkeit robuster KI-Systeme, die sicher und effektiv sind, und algorithmischen Diskriminierungsschutzes, um sicherzustellen, dass KI-Systeme fair und gerecht für alle bleiben.

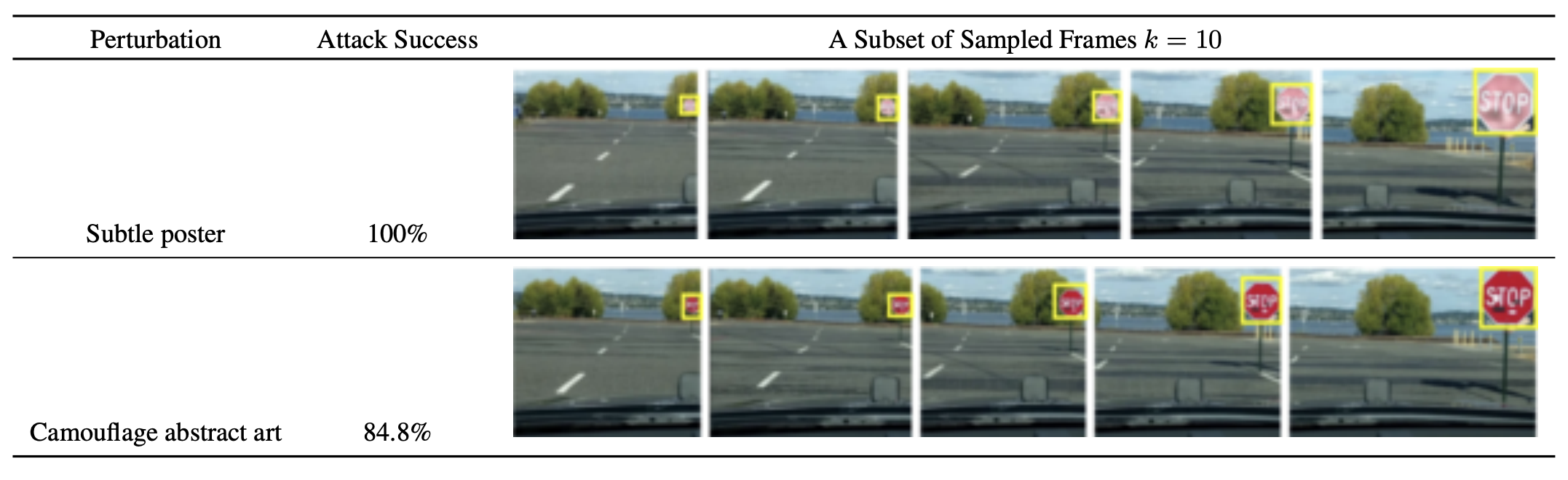

Dr. Li tauchte dann tiefer in eine Vielzahl von gegnerischen Angriffen ein, die verwendet werden, um künstliche Intelligenzsysteme zu vereiteln. Li verwies auf ihre eigene Forschung zu körperlichen Angriffen, insbesondere im Fall der Bilderkennung von selbstfahrenden Autos. In einem von Dr. Li mitverfassten Artikel demonstrierten sie und ihre Kollegen, wie einfach sie ein Wahrnehmungssystem durch verschiedene physische Angriffe dazu bringen können, Stoppschilder falsch zu identifizieren, wie im Bild unten gezeigt.

arXiv:1707.08945 [cs.CR]

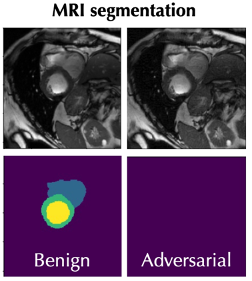

Dr. Li wies auch auf Angriffe auf MRT-Bilderkennungssoftware hin, die die Software dazu verleiten können, MRT-Bilder falsch zu segmentieren und Tumore falsch zu diagnostizieren, wie im Bild unten gezeigt.

Die Verbesserung der Sicherheit und Vertrauenswürdigkeit von KI ist laut Dr. Li von entscheidender Bedeutung. Dies zeigt sich deutlich in KI-Anwendungen, die auf Zeitreihendaten angewiesen sind, wie z. B. die Fähigkeit von Gesichtserkennungssystemen, das Gesicht einer Person mit zunehmendem Alter zu identifizieren. Ein häufig auftretendes Problem beim Training eines traditionellen maschinellen Lernmodells ist die Annahme stationärer Daten. Ein stationärer Datensatz geht davon aus, dass der Mittelwert und die Varianz eines Datensatzes über die Zeit konstant sind, ebenso wie die Kovarianz zwischen zwei Datenpunkten (z. B. ist die Kovarianz zwischen Daten an Tag 9 und Tag 10 eines Datensatzes gleich der Kovarianz zwischen Daten an Tag 99 und Tag 100). Während dies für einen typischen stationären Datensatz zutreffen kann, trifft diese Annahme häufig nicht zu, wenn Daten aus der realen Welt verwendet werden. Das sich daraus ergebende Problem ist, dass wir beim Einsatz eines auf stationären Daten trainierten Modells in einer realen Anwendung jetzt Vorhersagen über reale Daten treffen, die auf Annahmen beruhen, die nicht mehr zutreffen. Dies kann zu ungenauen Vorhersagen oder Entscheidungen der KI-Anwendung führen, was verheerende Folgen haben kann. Obwohl wir versuchen können, die Nichtstationarität von Testdaten zu korrigieren, kann es schwierig sein, festzustellen, wo und mit welchen Mitteln diese Korrekturen vorzunehmen sind.

Die Kluft zwischen Trainingsdaten und Testdaten, sagt Dr. Li, schafft das, was sie eine „Vertrauenswürdigkeitslücke“ nennt, wo Bedenken hinsichtlich mangelnder Robustheit, Datenschutz, Verallgemeinerung und Fairness aufkommen können. Das Ziel hier ist es, die Vertrauenswürdigkeitslücke zu schließen, indem die Robustheit von Systemen gestärkt wird, die es ihnen ermöglichen, Angriffe abzuwehren, sich genau an neue Situationen anzupassen und die Privatsphäre von Personen zu schützen, deren Daten von ML-Anwendungen verwendet werden.

Dr. Melanie Mitchell lenkte dann unsere Aufmerksamkeit über maschinelles Lernen hinaus und sogar über traditionelles Deep Learning hinaus, um generative KI zu diskutieren. Dr. Mitchell nannte Beispiele beliebter generativer KI-Programme wie ChatGPT, das Textantworten auf Eingabeaufforderungen generieren kann, und DALL-E, das auf Eingabeaufforderungen mit generierten Bildern reagieren kann. Die Medien haben postuliert, dass generative KI-Programme wie diese sich schnell einem mit Menschen vergleichbaren Intelligenzniveau annähern. Mitchell bezweifelt diese Aussage jedoch.

Dr. Mitchell erwähnte einen ihrer Studenten, der ein neuronales Netzwerk trainierte, um zu entscheiden, ob ein Bild ein Tier enthielt. Das Modell hatte ein hohes Maß an Genauigkeit, aber als Mitchells Schüler eine Analyse durchführte, um zu sehen, wie das Programm seine Bestimmungen traf, stellte er fest, dass das Programm den Teil des Bildes, der ein Tier enthielt, überhaupt nicht betrachtete, sondern sich eher darauf konzentrierte der Hintergrund. Anstatt zu lernen, tierische und nicht-tierische Teile von Bildern zu unterscheiden, hatte sich das Modell tatsächlich selbst beigebracht, dass die meisten Tierbilder einen verschwommenen Hintergrund haben, und deshalb begann es, den Vordergrund von Bildern vollständig zu ignorieren.

Dieses Beispiel, so Mitchell, zeigt deutlich ein Kernproblem der künstlichen Intelligenz: Es ist einfach, ein Programm zum Lernen zu bringen, aber es kann sehr schwierig sein, sie dazu zu bringen, das zu lernen, was Sie möchten. KI hat nicht die Art von gesundem Menschenverstand, den selbst ein Kleinkind haben könnte, daher ist es schwierig, die Annahmen zu korrigieren, die ein Computer machen könnte, die ein Mensch möglicherweise nicht einmal empfängt.

Die meisten neuronalen Netze können auch leicht getäuscht werden, indem klar erkennbare Gegenstände an unerwarteten Orten oder in unerwarteten Ausrichtungen platziert werden. Mitchell zeigte ein Beispiel, das von einer Gruppe von Forschern an der Auburn University erstellt wurde. Das Bild unten zeigt einen Schulbus in verschiedenen Ausrichtungen. Bei der ersten Orientierung ist der Schulbus wie erwartet positioniert und das neuronale Netz kann das Objekt problemlos mit 100%iger Sicherheit identifizieren. Wenn jedoch die Ausrichtung des Schulbusses in eine unerwartete Position gedreht wird, versagt das Programm jedes Mal bei der Identifizierung des Objekts, obwohl es immer noch Identifizierungen mit hoher Sicherheit durchführt.

Alcorn, Michael A., et al. „Stellen Sie sich (mit) einer Pose ein: Neuronale Netzwerke lassen sich leicht durch seltsame Posen vertrauter Objekte täuschen.“ arXiv-Vordruck arXiv:1811.11553 (2018).

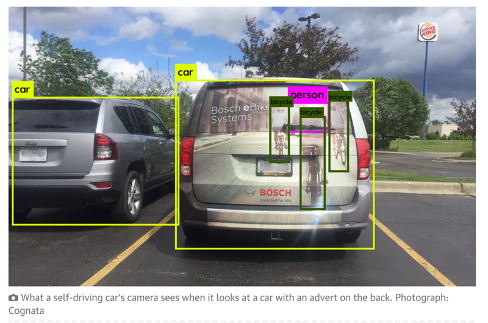

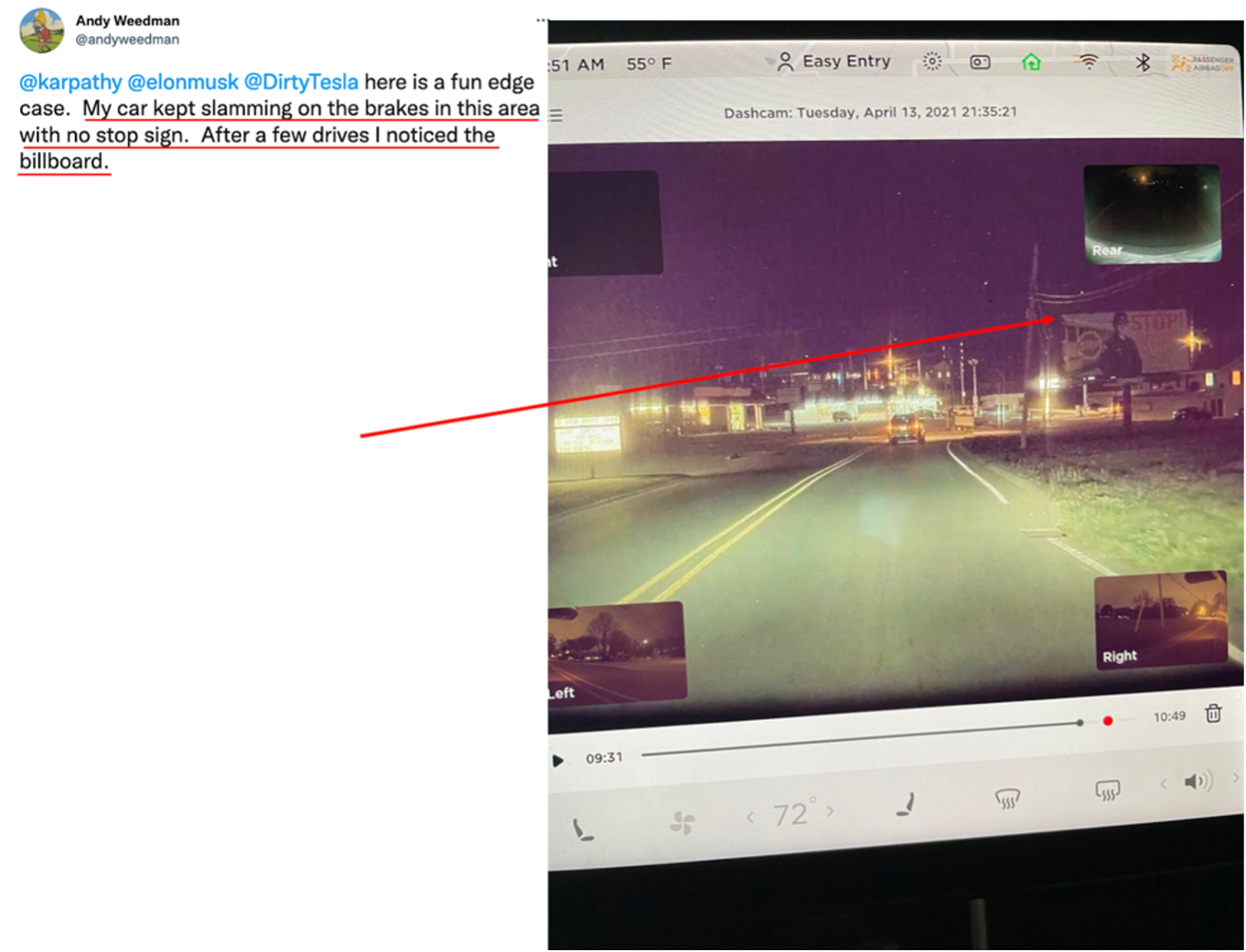

Diese Art von Fehlern, die KI-Programme machen, können sehr dumm sein, wenn Sie im Labor arbeiten, aber sie können auch schwerwiegende Konsequenzen in der realen Welt haben, insbesondere wenn selbstfahrende Autos abstürzen, weil sie Objekte falsch identifizieren oder nicht identifizieren können. Die künstliche Intelligenz hat auch Schwierigkeiten zu bestimmen, wann ein Objekt identifiziert werden sollte oder nicht. Dr. Mitchell zeigte zwei Bilder (unten), das erste zeigt die Kamera eines selbstfahrenden Autos, die die Bilder von Bikern auf einem Auto als echte Biker identifiziert, und das zweite zeigt einen Tesla, der jedes Mal auf die Bremse tritt, wenn er an einer Werbetafel mit einem Bild vorbeifährt eines Stoppschildes.

https://www.theguardian.com/technology/2017/aug/30/self-driving-cars-hackers-security

Dr. Mitchell richtete unseren Fokus dann auf Moravecs Paradoxon, auf das sie bereits früher in ihrer Präsentation angespielt hatte. Moravecs Paradoxon besagt: „Es ist vergleichsweise einfach, Computer dazu zu bringen, bei Intelligenztests oder beim Damespiel Leistungen auf Erwachsenenniveau zu zeigen, und es ist schwierig oder unmöglich, ihnen die Fähigkeiten eines Einjährigen zu vermitteln, wenn es um Wahrnehmung und Mobilität geht“ (Moravec, Hans. Achtung Kinder). Wie können wir also den Mangel an Wahrnehmung und gesundem Menschenverstand der KI korrigieren? Dr. Mitchell diskutierte dann einen vorgeschlagenen Bereich zur Bewertung von Menschen und Maschinen auf der Grundlage der „Kernwissens“-Systeme, die sowohl beim Menschen als auch bei einigen Tierarten identifiziert wurden. Die Idee des angeborenen „Kernwissens“ wurde von Elizabeth Spelke, einer Kognitionspsychologin und Direktorin des Laboratory for Developmental Studies an der Harvard University, vorgeschlagen. Die Arbeit von Dr. Spelke beinhaltet die Identifizierung der Quellen einzigartiger menschlicher kognitiver Fähigkeiten und wie sich diese Fähigkeiten von der Geburt bis zum Erwachsenenalter entwickeln.

Ohne die Möglichkeit, menschliche Intelligenz mit maschineller Intelligenz zu messen und zu vergleichen, können wir nicht hoffen, Maschinen das Feedback zu geben, das zur Verbesserung ihrer Leistung erforderlich ist. Dr. Mitchell hofft, dass wir durch die Entwicklung von Methoden zur Messung und zum Vergleich der Leistung von Mensch und KI die Hürde überwinden können, dass künstliche Intelligenz gleichzeitig unser klügster und dümmster Begleiter ist.

Schließlich lenkte Dr. David Danks unsere Aufmerksamkeit weg von der künstlichen Intelligenz selbst und stattdessen auf den Rahmen der Diskussion darüber, wie KI-Forschung durchgeführt und finanziert wird. In seiner Präsentation mit dem Titel „Letting a Thousand AI's Bloom“ diskutierte Dr. Danks zwei vorherrschende Visionen über die Natur wissenschaftlicher Bemühungen. Die erste Ideologie wird von Thomas Kuhn veranschaulicht. Kuhn glaubte, dass die Wissenschaften von den vorherrschenden Paradigmen der Zeit kontrolliert würden, was bedeutet, dass die meisten Wissenschaftler von derselben Ansicht oder Denkweise erfasst sind, wie zum Beispiel dem weit verbreiteten Glauben, dass die Urknalltheorie das Universum erschaffen hat. Diese Kuhnsche Denkweise kann zu einem homogenen Denken führen, sagte Danks, da weniger Wissenschaftler über den Tellerrand schauen und die vorherrschenden Normen des Tages in Frage stellen.

Der Philosoph Paul Feyerabend bot eine gegensätzliche Ideologie an. Er glaubte, dass Wissenschaftler Probleme von unterschiedlichen Standpunkten aus angehen sollten. Dafür plädierte Feyerabend dafür, „tausend Blumen blühen zu lassen“. Seiner Ansicht nach sollten Wissenschaftler Ouija-Bretter und die Theorie der Astrologie erforschen, da man nie sicher sein kann, dass das gegenwärtig vertretene Paradigma korrekt ist, und die Wissenschaft nicht vorangebracht werden kann, ohne selbst die am stärksten vertretenen Paradigmen in Frage zu stellen. Diese Philosophie führt zu einem heterogeneren Denken, da unter dieser Vision des wissenschaftlichen Fortschritts ausgefallenere Theorien vorgeschlagen und erforscht werden.

Dr. Danks sagt, dass wir die wissenschaftlichen Visionen von Kuhn und Feyerabend als zwei Enden eines Extrems betrachten können. Er erklärte, dass ein vollständig homogenes Denken die wissenschaftliche Forschung behindern würde, aber es auch übertrieben sei, jede Blume einer Idee zum Blühen zu bringen, und so könnten wir einige Forschungsbereiche wie das Studium von Ouija-Brettern und Astrologie eliminieren. Dr. Danks meinte weiter, dass es nützlich sein kann, über die Vor- und Nachteile von heterogeneren und homogeneren Denkweisen nachzudenken. Je homogener unser Denken ist, desto schneller können wir kurzfristig Fortschritte auf anerkannten Gebieten und Theorien machen, die allgemein als wichtig erachtet werden. Andererseits würde eine heterogenere gemeinsame Vision von Wissenschaft mehr neuartige Theorien und Ideen hervorbringen, die sonst nicht entwickelt werden könnten. Dies geht zu Lasten der Verschwendung von mehr Ressourcen für Theorien, die nicht aufgehen, und der Aufwendung von weniger Zeit und weniger Ressourcen für die Studienbereiche, die der Gesellschaft am meisten nützen.

Dr. Danks' wies darauf hin, dass es in der Praxis viel einfacher sei, Forschungsgelder in einer homogenen Gemeinschaft zuzuweisen, da alle eine ähnliche Perspektive teilen. Dieses Paradigma kann auch auf Forschungsmöglichkeiten ausgerichtet werden, die für die Gesellschaft am wertvollsten sind, wodurch das öffentliche Interesse und auch die Finanzierung gesteigert werden.

Danks schlug vor, dass es im Hinblick auf unsere Vision, wie wir wissenschaftliche Forschung betreiben, darauf ankommt, wo wir in dieses Kontinuum fallen. Zu weit in Richtung eines der beiden Enden des Extrems zu fallen, kann den Fortschritt ernsthaft behindern, und leider, sagte Dr. Danks, beginnen wir, in der KI-Forschung auf ein Extrem zu fallen.

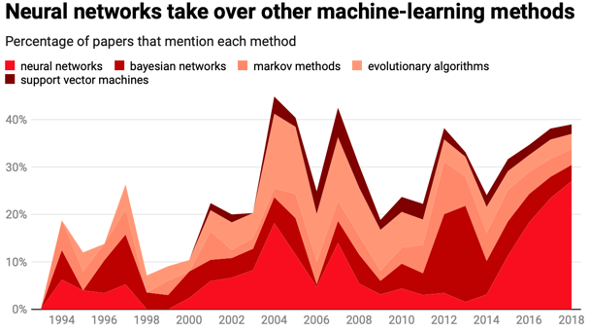

In der folgenden Grafik lenkte Danks unsere Aufmerksamkeit auf die Daten von 2014 bis heute.

MIT Technology Review

Wie wir sehen können, steigt der Prozentsatz der Arbeiten, die neuronale Netze erwähnen, in nur 4 Jahren um fast das Siebenfache. Die überwiegende Mehrheit der KI-Forschung konzentriert sich heute auf Deep Learning, und Studien zu neuronalen Netzen verdrängen andere Formen der künstlichen Intelligenz. Unsere Forschung zur KI wird zu homogen, sagte Danks, und wir vernachlässigen andere wichtige und wertvolle Formen der KI. Zu diesem Zweck schlug Danks zwei Lösungen vor.

Erstens schlug er vor, dass wir das Homogenitätsproblem von der Angebotsseite aus angehen könnten, indem wir eine angemessene Finanzierung für Formen der KI über Deep Learning hinaus sicherstellen. Diejenigen, die Mittel zuweisen, täten gut daran, die Arten von KI zu berücksichtigen, die finanziert werden, und vielleicht Anreize für eine Vielfalt von KI-Anwendungen zu schaffen.

Andererseits können wir diesem Problem auch von der Nachfrageseite aus begegnen. Ein Großteil der Finanzierung für KI konzentriert sich auf Probleme, von denen wir bereits wissen, dass sie gelöst werden können, aber was ist mit den Herausforderungen, von denen wir zuvor von Dr. Mitchell gehört haben? Wo ist zum Beispiel die Finanzierung für die Einbeziehung des gesunden Menschenverstandes in KI-Systeme? Wir sollten KI nicht so akzeptieren, wie sie jetzt ist, sagt Dr. Danks, und wir müssen uns bemühen, sie zu verbessern. Zu diesem Zweck schlägt er vor, dass wir uns zunächst auf die Verbesserung der Technologie konzentrieren, die neuronalen Netzen zugrunde liegt, bevor wir weitere Anwendungen der Netze selbst finanzieren.

Bleiben Sie dran für die Fragen und Antworten des Panels, die morgen im CCC-Blog veröffentlicht werden.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://feeds.feedblitz.com/~/737565884/0/cccblog~AAAS-Panel-Recap-Maintaining-a-Rich-Breadth-for-Artificial-Intelligence/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 10

- 100

- 2014

- 2018

- 2023

- 26%

- 7

- 9

- a

- Fähigkeiten

- Fähigkeit

- Fähig

- Über uns

- Akzeptieren

- Nach

- Genauigkeit

- genau

- Aktivitäten

- berührt das Schneidwerkzeug

- automatisch

- Erwachsenen-

- advanced

- widersprüchlich

- AI

- ai Forschung

- AL

- algorithmisch

- Alle

- Zulassen

- bereits

- ebenfalls

- an

- Analyse

- und

- Tier

- Tiere

- Anwendung

- Anwendungen

- Ansatz

- Annäherung

- SIND

- Bereiche

- Festnahmen

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- Annahme

- Astrologie

- At

- Anschläge

- Aufmerksamkeit

- ein Weg

- Hintergrund

- Hintergründe

- basierend

- BE

- weil

- Werden

- war

- Bevor

- begann

- Anfang

- Sein

- Glauben

- angenommen

- unten

- Nutzen

- Vorteile

- Besser

- zwischen

- Beyond

- Big

- Urknall

- Bill

- Blog

- Blühen

- beide

- Box

- Breite

- Bus

- aber

- by

- Kalifornien

- Aufrufe

- Kamera

- CAN

- kann keine

- Kapazitäten

- Auto

- Autos

- Häuser

- ccc

- CCC-Blog

- Sicherheit

- challenges

- Herausforderungen

- ChatGPT

- Menu

- kognitiv

- Kopien

- kommt

- gemeinsam

- community

- vergleichbar

- verhältnismäßig

- vergleichen

- uneingeschränkt

- zusammengesetzt

- Computer

- Computer

- Bedenken

- Leiten

- durchgeführt

- Leitung

- Konferenz

- Folgen

- Geht davon

- konstante

- Continuum

- gesteuert

- Kernbereich

- Korrekturen

- Kosten

- könnte

- Crashing

- erstellt

- schafft

- Erstellen

- kritischem

- Zur Zeit

- Dalls

- technische Daten

- Datenpunkte

- Christian

- Tag

- entscheidet

- Entscheidungen

- tief

- tiefe Lernen

- tiefer

- Grad

- Demand

- weisen nach, dass

- zeigt

- Bereitstellen

- Bestimmen

- verheerend

- entwickeln

- entwickelt

- Entwicklung

- Entwicklungsstörungen

- Entwicklungen

- DID

- Diego

- unterscheiden

- schwer

- Direktor

- diskutieren

- diskutiert

- diskutieren

- Diskussion

- Anzeige

- Displays

- Diversität

- do

- die

- Domain

- dominant

- Nicht

- zweifeln

- wo

- Nachteile

- zwei

- E & T

- Früher

- erleichtern

- einfacher

- leicht

- Einfache

- Effektiv

- Bemühungen

- entweder

- beseitigen

- Elon

- Elon Musk

- Ende

- endet

- gewährleisten

- Gewährleistung

- vollständig

- bewerten

- Sogar

- Jedes

- jeden Tag

- jedermann

- Beispiel

- Beispiele

- zeigen

- erwartet

- erklärt

- Extrem

- Gesicht

- Gesichts-

- Gesichtserkennung

- FAIL

- scheitert

- Messe

- Fairness

- Fallen

- Falling

- falsch

- vertraut

- Feedback

- Weniger

- Felder

- Finale

- Vorname

- Setzen Sie mit Achtsamkeit

- konzentriert

- konzentriert

- Aussichten für

- Formen

- Zum Glück

- für

- kapitalgedeckten

- Finanzierung

- Mittel

- weiter

- Lücke

- erzeugen

- erzeugt

- generativ

- Generative KI

- bekommen

- ABSICHT

- Kundenziele

- Graph

- Gruppe an

- hätten

- Pflege

- Harvard

- Harvard Universität

- Haben

- mit

- he

- gehört

- Statt

- hier (auf dänisch)

- hier

- GUTE

- behindern

- seine

- ein Geschenk

- hofft,

- Häuser

- Ultraschall

- aber

- HTTPS

- human

- menschliche Intelligenz

- Humans

- Idee

- Ideen

- identifiziert

- identifizieren

- Identifizierung

- Ideologie

- Illinois

- Image

- Bilderkennung

- Bilder

- Bedeutung

- wichtig

- unmöglich

- zu unterstützen,

- Verbesserung

- in

- ungenau

- Anreize

- Einschließlich

- Inklusive

- einarbeiten

- falsch

- Steigert

- zunehmend

- Einzelpersonen

- Energiegewinnung

- angeboren

- Anfrage

- beantragen müssen

- Institut

- Intelligenz

- Interesse

- in

- Problem

- IT

- Artikel

- SEINE

- selbst

- Art

- Wissen

- bekannt

- Labor

- Labor

- Mangel

- Nachname

- führen

- Führung

- führenden

- umwandeln

- LERNEN

- lernen

- Vermietung

- Niveau

- Li

- !

- Gefällt mir

- Standorte

- länger

- aussehen

- Maschine

- Maschinelles Lernen

- Maschinen

- gemacht

- Aufrechterhaltung

- Mehrheit

- um

- MACHT

- Making

- viele

- März

- Angelegenheiten

- max-width

- Kann..

- bedeuten

- Bedeutung

- Mittel

- messen

- Medien

- erwähnt

- Methoden

- Michael

- könnte

- Fehler

- ML

- Modell

- Modi

- mehr

- vor allem warme

- MRI

- viel

- Moschus

- Natur

- navigieren

- fast

- notwendig,

- Need

- Netzwerk

- Netzwerke

- neuronale Netzwerk

- Neuronale Netze

- Neu

- nicht

- vor allem

- Roman

- jetzt an

- Anzahl

- Objekt

- Objekte

- of

- angeboten

- Office

- vorgenommen,

- on

- EINEM

- einzige

- Eröffnung

- Entwicklungsmöglichkeiten

- or

- OSTP

- Andere

- Andernfalls

- UNSERE

- Umrissen

- aussen

- übrig

- besitzen

- Tafel

- Papier

- Papiere

- Paradigma

- Paradox

- Teil

- Teile

- leitet

- passt

- Alexander

- Prozentsatz

- Wahrnehmung

- Leistung

- vielleicht

- Perspektive

- Philosophie

- Telefon

- physikalisch

- ein Bild

- Platzierung

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- Punkte

- Datenschutzrichtlinien

- Beliebt

- Posen

- Position

- positioniert

- praktisch

- vorhergesagt

- Prognosen

- überwiegend

- Gegenwart

- presentation

- Datenschutz

- Aufgabenstellung:

- Probleme

- produziert

- Programm

- Programme

- Fortschritt

- ordnungsgemäße

- vorgeschlage

- schlägt vor

- Risiken zu minimieren

- die

- Öffentlichkeit

- F&A

- Ransomware

- Ransomware-Angriffe

- schnell

- lieber

- echt

- realen Welt

- realisiert

- rekapitulieren

- kürzlich

- Anerkennung

- anerkannt

- erkennen

- Release

- freigegeben

- bleiben

- Forschungsprojekte

- Forscher

- Downloads

- Reagieren

- Folge

- Reiches

- Rechte

- Risiko

- Risiken

- robust

- Robustheit

- Safe

- Said

- gleich

- San

- San Diego

- Santa

- sagt

- Schule

- Wissenschaft

- Wissenschaft und Technologie

- WISSENSCHAFTEN

- wissenschaftlich

- Wissenschaftler

- Zweite

- Sicherheitdienst

- sehen

- gesehen

- Segment

- selbstfahrend

- Sendung

- Sinn

- Modellreihe

- ernst

- von Locals geführtes

- Shares

- sie

- beleuchtete

- verschieben

- Short

- sollte

- gezeigt

- Seite

- Schild

- unterzeichnet

- signifikant

- Schilder

- ähnlich

- gleichzeitig

- Umstände

- Fähigkeiten

- am klügsten

- So

- Gesellschaft

- Software

- Lösungen

- einige

- Quellen

- speziell

- angegeben

- Staaten

- Steve

- Steve Wozniak

- Immer noch

- Stoppen

- streben

- Kämpft

- Schüler und Studenten

- Es wurden Studien

- Studie

- Studieren

- so

- liefern

- Umgebung

- empfänglich

- System

- Systeme und Techniken

- Technologies

- Technologie

- AGB

- Tesla

- Testen

- Tests

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Der Graph

- ihr

- Sie

- sich

- dann

- Dort.

- damit

- deswegen

- Diese

- vom Nutzer definierten

- think

- Denken

- fehlen uns die Worte.

- diejenigen

- dachte

- Durch

- Zeit

- Zeitfolgen

- betitelt

- zu

- heute

- morgen

- auch

- gegenüber

- traditionell

- trainiert

- Ausbildung

- was immer dies auch sein sollte.

- vertrauenswürdig

- Turned

- XNUMX

- Typen

- typisch

- allgegenwärtig

- für

- Unerwartet

- Unglücklicherweise

- einzigartig

- Universum

- Universität

- University of California

- auf

- benutzt

- Verwendung von

- wertvoll

- Vielfalt

- riesig

- sehr

- Anzeigen

- Seh-

- Visionen

- wurde

- Weg..

- Wege

- we

- GUT

- Was

- wann

- ob

- welche

- während

- Weiß

- Weißen Haus

- WHO

- weit

- werden wir

- mit

- ohne

- Arbeiten

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- würde

- Jahr

- Jahr

- Du

- Ihr

- Zephyrnet