Benutzerdaten: Lebenswichtige Nahrung für LLMs

Ja! RT @bryce Ich liebe dieses Zitat: „Wenn Sie nicht dafür bezahlen, sind Sie nicht der Kunde; Du bist das Produkt, das verkauft wird.“ http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) 2. September 2010

Bleiben Sie über Krypto-News auf dem Laufenden und erhalten Sie tägliche Updates in Ihrem Posteingang.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :hast

- :Ist

- :nicht

- 7

- 8

- a

- Fähigkeit

- Absolute

- Nach

- genau

- sich anpassen

- Adressierung

- Fügt

- advanced

- vor

- stimmt zu

- AI

- KI-Dienste

- KI-Systeme

- Ziel

- Alexa

- Richtet sich aus

- Alle

- erlaubt

- ebenfalls

- immer

- Amazon

- an

- und

- Anthropisch

- erwarten

- jedem

- anwendbar

- SIND

- AS

- annehmen

- At

- verfügbar

- Vermeidung von

- bewusst

- basierend

- BE

- weil

- Sein

- angenommen

- vorteilhaft

- Besser

- zwischen

- by

- CAN

- aus aller Welt

- Kunden

- kommerziell

- Engagement

- verpflichtet

- Unternehmen

- Unternehmen

- wettbewerbsfähig

- konzept

- Bedenken

- ständig

- Inhalt

- Kontext

- ständig

- Smartgeräte App

- Praktische

- Gespräche

- Urheberrecht

- könnte

- wichtig

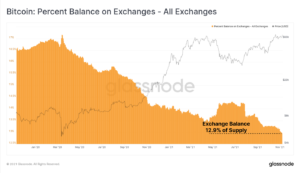

- Krypto

- Crypto Nachrichten

- Strom

- Kunde

- Kunden

- Unterricht

- Dunkel

- technische Daten

- Datenschutz

- Debatten.

- Jahrzehnte

- Entschlüsseln

- tief

- tiefe Lernen

- Standard

- Kinder

- liefern

- hängt

- lehnt ab

- Streitigkeiten

- Diversität

- do

- Dokument

- die

- Dollar

- Nicht

- im

- Gesamt-Einnahmen abzüglich Provision

- Edge

- Wirksamkeit

- entweder

- Engagement

- Eine Verbesserung der

- sorgt

- essential

- ethisch

- Ethik

- Beispiel

- Austausch-

- ERFAHRUNGEN

- umfangreiche

- Umfang

- extern

- zugewandt

- Aussichten für

- Früher

- Gründung

- Frei

- für

- gewinnen

- erzeugen

- erzeugt

- erzeugt

- generativ

- Generative KI

- bekommen

- bekommen

- Riesen

- ABSICHT

- Go

- gewähren

- Griff

- Wächst

- schwer

- ehrlich

- Ehre

- aber

- http

- HTTPS

- human

- Ideale

- if

- zu unterstützen,

- in

- Krankengymnastik

- Information

- geistigen

- geistiges Eigentum

- Absichten

- Interaktionen

- intern

- IP

- IT

- SEINE

- selbst

- Wesentliche

- Sprache

- grosse

- neueste

- Recht

- führen

- LERNEN

- lernen

- Rechtlich

- Hebelwirkung

- Gefällt mir

- Lama

- LLM

- ich liebe

- um

- Making

- Kann..

- Medien

- Meta

- Millionen

- Modell

- für

- mehr

- vor allem warme

- Netzwerke

- Nerven-

- Neuronale Netze

- Neu

- News

- beschaffen

- of

- on

- OpenAI

- or

- angeblich

- Andernfalls

- UNSERE

- Ausgänge

- übrig

- besitzen

- Besitzt

- bezahlt

- Parteien

- Party

- Muster

- AUFMERKSAMKEIT

- zahlen

- persönliche

- Personalisierung

- Personalisiert

- Fotos

- Plato

- Datenintelligenz von Plato

- PlatoData

- Datenschutzrichtlinien

- Potenzial

- Werkzeuge

- größte treibende

- Praktiken

- vorhersagen

- Prognosen

- Vorlieben

- vorherrschend

- Datenschutz

- privat

- Produziert

- Produkt

- Eingabeaufforderungen

- Resorts

- die

- bietet

- Öffentlichkeit

- das Vertrauen der Öffentlichkeit

- öffentlich

- Angebot!

- Renn-

- RE

- realen Welt

- erhält

- verfeinern

- Betrachten

- relativ

- Release

- relevant

- Berichtet

- Zugriffe

- Forscher

- für ihren Verlust verantwortlich.

- Revealed

- Rechte

- Rivalen

- rt

- Lutz

- s

- sagt

- Szene

- Lösungen

- kompensieren

- Teilen

- sollte

- Skepsis

- So

- Social Media

- Social Media

- verkauft

- BUCHSTABIEREN

- Sprecher

- Anfang

- Erklärung

- bleiben

- Schritt

- Systeme und Techniken

- Tandem

- Tech

- Tech-Giganten

- Techniken

- AGB

- Text

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Tim

- zu

- heute

- Top

- Training

- trainiert

- Ausbildung

- Transparenz

- Trends

- Vertrauen

- für

- verstehen

- Verständnis

- anstehende

- aktualisiert

- Updates

- Upgrade

- hochgeladen

- -

- benutzt

- Mitglied

- Nutzer

- Verwendung von

- wertvoll

- verschiedene

- Version

- Videos

- lebenswichtig

- Stimme

- Volumen

- wurde

- we

- waren

- wann

- ob

- welche

- warum

- werden wir

- mit

- Word

- würde

- Du

- Ihr

- Zephyrnet