Digitale Verlage suchen ständig nach Möglichkeiten, ihre Medien-Workflows zu rationalisieren und zu automatisieren, um neue Inhalte so schnell wie möglich zu generieren und zu veröffentlichen.

Viele Verlage haben eine große Bibliothek mit Stock-Bildern, die sie für ihre Artikel verwenden. Diese Bilder können viele Male für verschiedene Geschichten wiederverwendet werden, insbesondere wenn der Herausgeber Bilder von Prominenten hat. Ziemlich oft muss ein Journalist einen gewünschten Prominenten aus einem Bild herausschneiden, um ihn für seine kommende Geschichte zu verwenden. Dies ist eine manuelle, sich wiederholende Aufgabe, die automatisiert werden sollte. Manchmal möchte ein Autor vielleicht ein Bild eines Prominenten verwenden, aber es enthält zwei Personen und der Hauptstar muss aus dem Bild herausgeschnitten werden. In anderen Fällen müssen Bilder von Prominenten möglicherweise neu formatiert werden, um sie auf einer Vielzahl von Plattformen wie Mobilgeräten, sozialen Medien oder digitalen Nachrichten zu veröffentlichen. Außerdem muss ein Autor möglicherweise das Seitenverhältnis des Bilds ändern oder den Prominenten gestochen scharf in den Fokus rücken.

In diesem Beitrag demonstrieren wir die Verwendung Amazon-Anerkennung Bildanalyse durchzuführen. Amazon Rekognition erleichtert das Hinzufügen dieser Funktion zu Ihren Anwendungen ohne Fachwissen im Bereich maschinelles Lernen (ML) und wird mit verschiedenen APIs geliefert, um Anwendungsfälle wie Objekterkennung, Inhaltsmoderation, Gesichtserkennung und -analyse sowie Text- und Prominentenerkennung zu erfüllen, die wir in diesem Beispiel verwenden.

Das Funktion zur Erkennung von Prominenten in Amazon-Anerkennung erkennt mithilfe von ML automatisch zehntausende bekannte Persönlichkeiten in Bildern und Videos. Die Promi-Erkennung kann nicht nur die Anwesenheit des jeweiligen Prominenten erkennen, sondern auch den Ort innerhalb des Bildes.

Lösungsübersicht

In diesem Beitrag demonstrieren wir, wie wir ein Foto, den Namen eines Prominenten und ein Seitenverhältnis für das ausgegebene Bild übergeben können, um ein zugeschnittenes Bild des jeweiligen Prominenten zu erstellen, das sein Gesicht in der Mitte erfasst.

Bei der Arbeit mit der Amazon Rekognition-Promi-Erkennungs-API, werden viele Elemente in der Antwort zurückgegeben. Im Folgenden sind einige wichtige Antwortelemente aufgeführt:

- MatchConfidence – Ein Match-Confidence-Score, der zur Steuerung des API-Verhaltens verwendet werden kann. Wir empfehlen, in Ihrer Anwendung einen geeigneten Schwellenwert auf diese Punktzahl anzuwenden, um Ihren bevorzugten Betriebspunkt auszuwählen. Wenn Sie beispielsweise einen Schwellenwert von 99 % festlegen, können Sie Fehlalarme eliminieren, verpassen jedoch möglicherweise einige potenzielle Übereinstimmungen.

- Name, ID und URLs – Der Name des Prominenten, eine eindeutige Amazon Rekognition ID und eine Liste von URLs wie die IMDb oder der Wikipedia-Link des Prominenten für weitere Informationen.

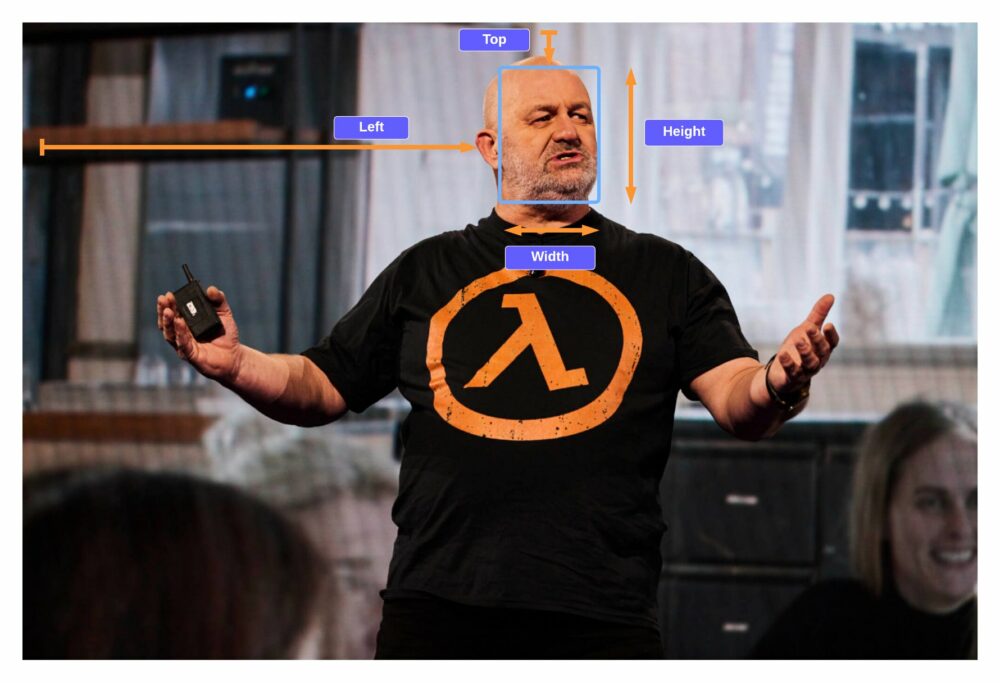

- Begrenzungsbox – Koordinaten der Position des rechteckigen Begrenzungsrahmens für jedes erkannte Promi-Gesicht.

- Bekanntes Geschlecht – Bekannte Geschlechtsidentität für jeden anerkannten Prominenten.

- Emotionen – Auf dem Gesicht des Prominenten ausgedrückte Emotionen, z. B. glücklich, traurig oder wütend.

- Pose – Pose des Promi-Gesichts mit drei Roll-, Nick- und Gierachsen.

- Lächeln – Ob der Promi lächelt oder nicht.

Ein Teil der API-Antwort von Amazon Rekognition enthält den folgenden Code:

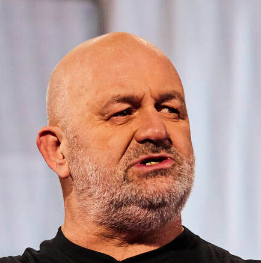

In dieser Übung demonstrieren wir, wie Sie das Begrenzungsrahmenelement verwenden, um die Position des Gesichts zu identifizieren, wie im folgenden Beispielbild gezeigt. Alle Dimensionen werden als Verhältnisse der gesamten Bildgröße dargestellt, sodass die Zahlen in der Antwort zwischen 0 und 1 liegen. In der Beispiel-API-Antwort beträgt die Breite des Begrenzungsrahmens beispielsweise 0.1, was impliziert, dass die Gesichtsbreite 10 % der Gesamtbreite des Bilds beträgt.

Mit diesem Begrenzungsrahmen können wir jetzt logisch sicherstellen, dass das Gesicht innerhalb der Ränder des neu erstellten Bildes bleibt. Wir können etwas Polsterung um diesen Begrenzungsrahmen herum anwenden, um das Gesicht in der Mitte zu halten.

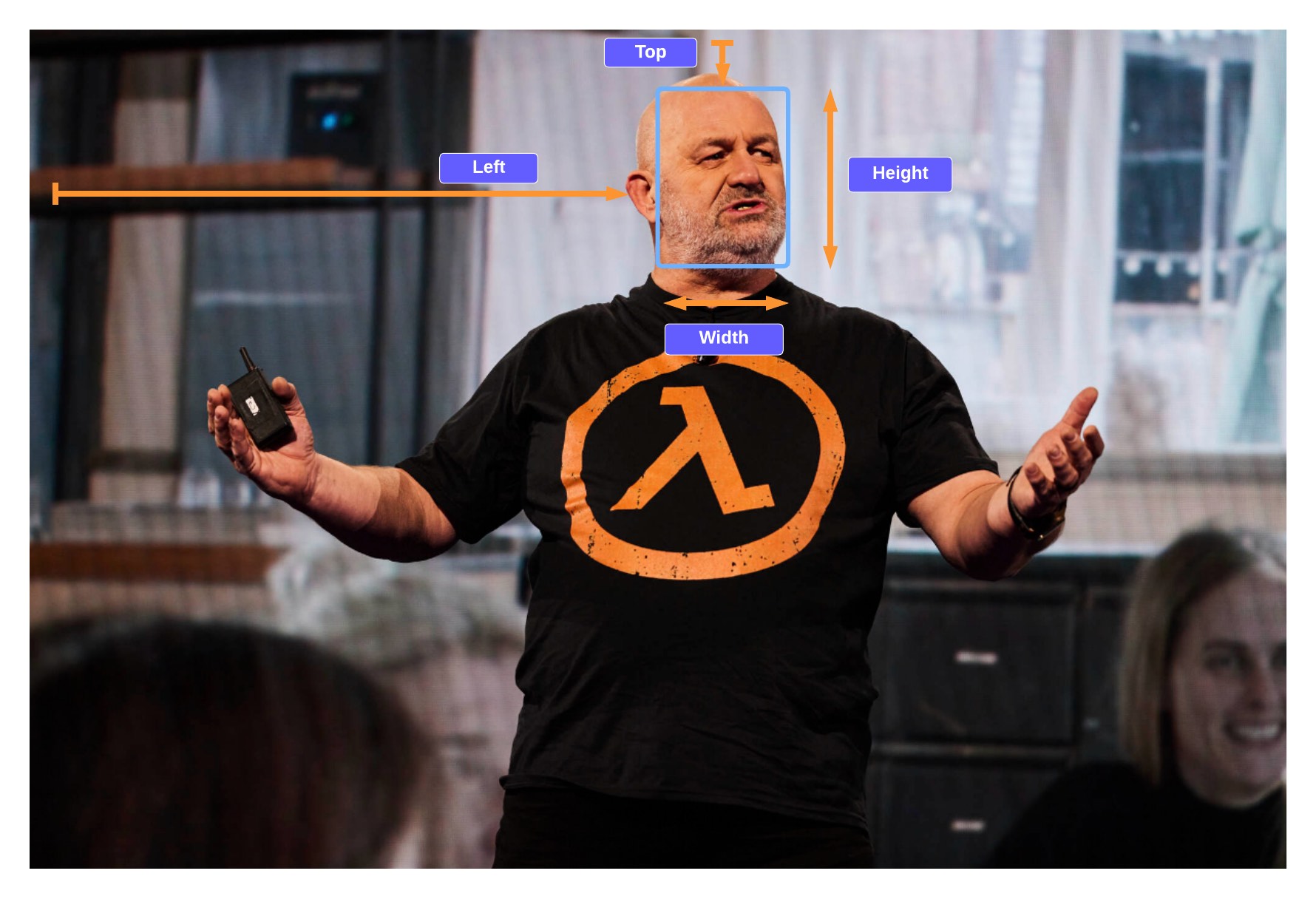

In den folgenden Abschnitten zeigen wir, wie Sie die folgende beschnittene Bildausgabe mit scharfem Fokus von Werner Vogels erstellen.

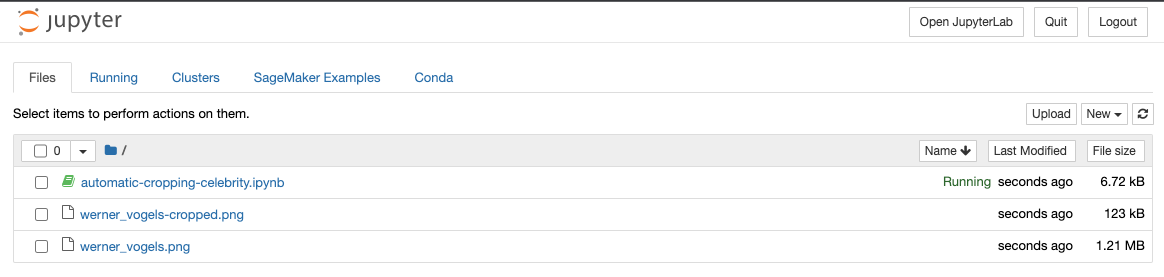

Wir starten eine Amazon Sage Maker notebook, das eine Python-Umgebung bereitstellt, in der Sie den Code ausführen können, um ein Bild an Amazon Rekognition zu übergeben, und das Bild dann automatisch mit dem Prominenten im Fokus ändern können.

Der Code führt die folgenden allgemeinen Schritte aus:

- Stellen Sie eine Anfrage an die

recognize_celebritiesAPI mit dem angegebenen Bild und Namen des Prominenten. - Filtern Sie die Antwort nach den Begrenzungsrahmeninformationen.

- Fügen Sie dem Begrenzungsrahmen etwas Polsterung hinzu, sodass wir einen Teil des Hintergrunds erfassen.

Voraussetzungen:

Für diese exemplarische Vorgehensweise sollten Sie die folgenden Voraussetzungen erfüllen:

Laden Sie das Beispielbild hoch

Laden Sie Ihr Beispiel-Promi-Bild in Ihren S3-Bucket hoch.

Führen Sie den Code aus

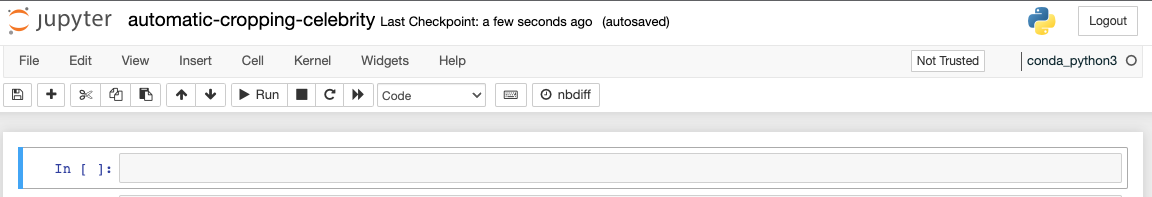

Um den Code auszuführen, verwenden wir ein SageMaker-Notebook, aber jede IDE würde auch nach der Installation von Python, Pillow und Boto3 funktionieren. Wir erstellen ein SageMaker-Notizbuch sowie die AWS Identity and Access Management and (IAM)-Rolle mit den erforderlichen Berechtigungen. Führen Sie die folgenden Schritte aus:

- Erstellen Sie das Notizbuch und nenne es

automatic-cropping-celebrity.

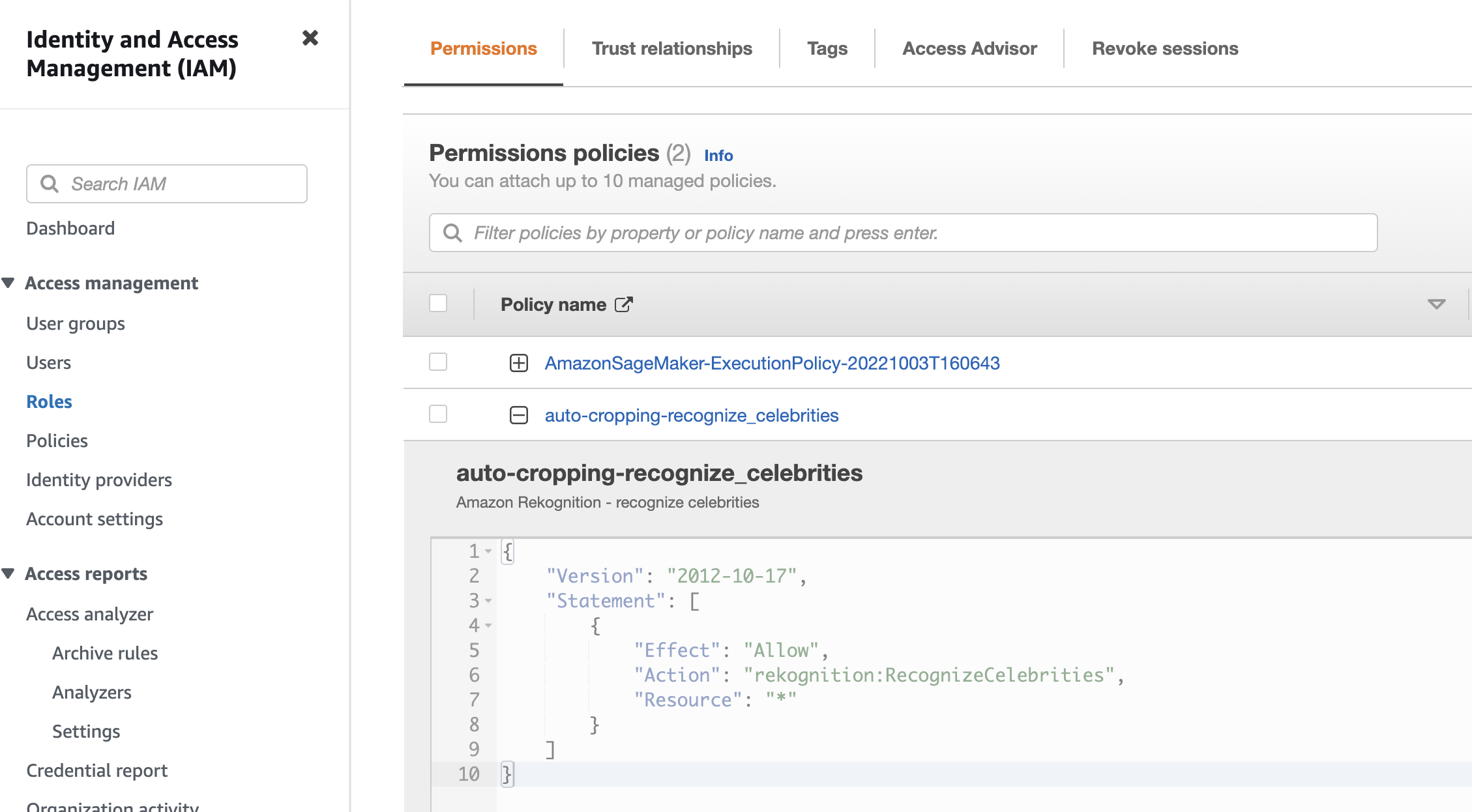

Die standardmäßige Ausführungsrichtlinie, die beim Erstellen des SageMaker-Notebooks erstellt wurde, verfügt über eine einfache Richtlinie, die der Rolle Berechtigungen zur Interaktion mit Amazon S3 erteilt.

- Aktualisieren Sie die

ResourceEinschränkung mit dem S3-Bucket-Namen:

- Erstellen Sie eine weitere Richtlinie, die der SageMaker-Notebook-IAM-Rolle hinzugefügt werden soll, um die aufrufen zu können Erkennen Sie Prominente API:

- Wählen Sie in der SageMaker-Konsole Notebook-Instanzen im Navigationsbereich.

- Suchen Sie den

automatic-cropping-celebritynotizbuch und wählen Öffne Jupyter. - Auswählen Neu und conda_python3 als Kernel für Ihr Notebook.

Kopieren Sie für die folgenden Schritte die Codeblöcke in Ihr Jupyter-Notebook und führen Sie sie aus, indem Sie auswählen Führen Sie.

- Zuerst importieren wir Hilfsfunktionen und Bibliotheken:

- Variablen setzen

- Erstellen Sie einen Dienstclient

- Funktion, um die Prominenten zu erkennen

- Funktion zum Abrufen des Begrenzungsrahmens des angegebenen Prominenten:

- Funktion, um dem Begrenzungsrahmen etwas Polsterung hinzuzufügen, sodass wir etwas Hintergrund um das Gesicht herum erfassen

- Funktion zum Speichern des Bildes im Notebook-Speicher und in Amazon S3

- Verwenden Sie die Python

main()Funktion zum Kombinieren der vorhergehenden Funktionen, um den Arbeitsablauf zum Speichern eines neuen zugeschnittenen Bildes unserer Berühmtheit abzuschließen:

Wenn Sie diesen Codeblock ausführen, können Sie sehen, dass wir Werner Vogels gefunden und ein neues Bild mit seinem Gesicht in der Mitte erstellt haben.

Das Bild wird im Notebook gespeichert und auch in den S3-Bucket hochgeladen.

Sie könnten diese Lösung in a aufnehmen größerer Arbeitsablauf; Beispielsweise möchte ein Verlag diese Funktion möglicherweise als Endpunkt veröffentlichen, um Bilder im Handumdrehen neu zu formatieren und zu skalieren, wenn Artikel von Prominenten auf mehreren Plattformen veröffentlicht werden.

Aufräumen

Löschen Sie die Ressourcen, um zukünftige Gebühren zu vermeiden:

- Wählen Sie in der SageMaker-Konsole Ihr Notebook und auf der Aktionen Menü, wählen Sie Stoppen.

- Nachdem das Notebook gestoppt wurde, auf der Aktionen Menü, wählen Sie Löschen.

- Löschen Sie in der IAM-Konsole die von Ihnen erstellte SageMaker-Ausführungsrolle.

- Löschen Sie auf der Amazon S3-Konsole das Eingabebild und alle Ausgabedateien aus Ihrem S3-Bucket.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie wir Amazon Rekognition verwenden können, um eine ansonsten manuelle Aufgabe der Änderung von Bildern zur Unterstützung von Medien-Workflows zu automatisieren. Dies ist besonders wichtig in der Verlagsbranche, wo es auf Geschwindigkeit ankommt, um neue Inhalte schnell und auf mehreren Plattformen herauszubringen.

Weitere Informationen zum Arbeiten mit Medienobjekten finden Sie unter Medienintelligenz ist mit Media2Cloud 3.0 noch intelligenter geworden

Über den Autor

Mark Watkins ist ein Lösungsarchitekt im Medien- und Unterhaltungsteam. Er hilft Kunden bei der Erstellung von KI/ML-Lösungen, die ihre geschäftlichen Herausforderungen mit AWS lösen. Er hat an mehreren KI/ML-Projekten im Zusammenhang mit Computer Vision, Natural Language Processing, Personalisierung, ML at the Edge und mehr gearbeitet. Abseits des Berufslebens verbringt er am liebsten Zeit mit seiner Familie und sieht seinen beiden Kleinen beim Aufwachsen zu.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/automatic-image-cropping-with-amazon-rekognition/

- :Ist

- $UP

- 1

- 10

- 100

- 11

- 7

- 8

- 9

- a

- Fähig

- Über Uns

- Zugang

- Action

- zusätzlich

- Nach der

- AI / ML

- Alle

- Amazon

- Amazon-Anerkennung

- Analyse

- und

- Ein anderer

- Bienen

- APIs

- Anwendung

- Anwendungen

- Bewerben

- Anwendung

- SIND

- um

- Artikel

- AS

- Aussehen

- Details

- At

- Autor

- automatisieren

- Automatisiert

- automatische

- Im Prinzip so, wie Sie es von Google Maps kennen.

- AWS

- ACHSEN

- Hintergrund

- BE

- zwischen

- Blockieren

- Blockiert

- Box

- Boxen

- Geschäft

- by

- rufen Sie uns an!

- CAN

- Erfassung

- Capturing

- Fälle

- Celeb

- Prominente

- Berühmtheit

- Center

- Herausforderungen

- Übernehmen

- Gebühren

- Auswählen

- Auswahl

- Code

- kombinieren

- Unternehmen

- abschließen

- Computer

- Computer Vision

- Vertrauen

- Konsul (Console)

- enthält

- Inhalt

- ständig

- Smartgeräte App

- könnte

- erstellen

- erstellt

- Erstellen

- Ernte

- Kunden

- Standard

- zeigen

- erwünscht

- erkannt

- Entdeckung

- anders

- digital

- Größe

- Display

- herunterladen

- e

- jeder

- Edge

- bewirken

- Element

- Elemente

- beseitigen

- Endpunkt

- Unterhaltung

- Arbeitsumfeld

- insbesondere

- Beispiel

- Ausführung

- Training

- Expertise

- zum Ausdruck gebracht

- Gesicht

- Gesichter

- Familie

- berühmt

- Reichen Sie das

- Mappen

- Setzen Sie mit Achtsamkeit

- Folgende

- Aussichten für

- Format

- gefunden

- frisch

- für

- Funktion

- Funktionen

- weiter

- Zukunft

- Geschlecht

- erzeugen

- bekommen

- bekommen

- gegeben

- gibt

- persönlichem Wachstum

- glücklich

- Haben

- Höhe

- hilft

- High-Level

- Ultraschall

- Hilfe

- aber

- HTML

- http

- HTTPS

- ID

- identifizieren

- Identitätsschutz

- Image

- Bilder

- importieren

- wichtig

- in

- das

- Dazu gehören

- Energiegewinnung

- Information

- Varianten des Eingangssignals:

- Installieren

- Intelligenz

- interagieren

- IT

- Journalist

- jpg

- Behalten

- Wesentliche

- bekannt

- Sprache

- grosse

- starten

- lernen

- Bibliotheken

- Bibliothek

- Lebensdauer

- Gefällt mir

- LINK

- Liste

- wenig

- aus einer regionalen

- Standorte

- suchen

- Maschine

- Maschinelles Lernen

- um

- MACHT

- manuell

- viele

- Spiel

- Angelegenheiten

- Medien

- MENÜ

- könnte

- ML

- Mobil

- Mäßigung

- ändern

- mehr

- mehrere

- Name

- Natürliche

- Verarbeitung natürlicher Sprache

- Menü

- Need

- Bedürfnisse

- Neu

- News

- Notizbuch

- Zahlen

- Objekt

- Objekterkennung

- of

- on

- die

- Auftrag

- Andere

- Andernfalls

- Möglichkeiten für das Ausgangssignal:

- Gesamt-

- Brot

- besonders

- Weg

- Personen

- Ausführen

- führt

- Berechtigungen

- Personalities

- Personalisierung

- Tonhöhe (Pitch)

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Datenschutzrichtlinien

- Post

- Potenzial

- bevorzugt

- Voraussetzungen

- Präsenz

- primär

- Verarbeitung

- Professionell

- Projekte

- bietet

- veröffentlichen

- Herausgeber

- Verlag

- Publishing

- setzen

- Python

- schnell

- erhöhen

- schnell

- Verhältnis

- Anerkennung

- erkennen

- anerkannt

- erkennt

- empfehlen

- bezogene

- bleibt bestehen

- repetitiv

- vertreten

- Anforderung

- falls angefordert

- Ressourcen

- Downloads

- Antwort

- Folge

- Die Ergebnisse

- Rückkehr

- ROI

- Rollen

- Rollen

- Führen Sie

- sagemaker

- Speichern

- Einsparung

- Ergebnis

- Abschnitte

- Einstellung

- mehrere

- sollte

- erklären

- gezeigt

- Einfacher

- Größe

- schlauer

- So

- Social Media

- Social Media

- Lösung

- Lösungen

- LÖSEN

- einige

- Geschwindigkeit

- Ausgabe

- quadratisch

- Erklärung

- Shritte

- -bestands-

- gestoppt

- Lagerung

- Geschichten

- Geschichte

- rationalisieren

- so

- geeignet

- Support

- Aufgabe

- Team

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- Tausende

- nach drei

- Schwelle

- Zeit

- mal

- zu

- Top

- Gesamt

- einzigartiges

- anstehende

- hochgeladen

- -

- Vielfalt

- verschiedene

- Version

- Videos

- Seh-

- Walkthrough

- beobachten

- Wege

- GUT

- bekannt

- ob

- welche

- Breite

- Wikipedia

- werden wir

- mit

- .

- ohne

- Arbeiten

- Workflows

- arbeiten,

- würde

- Du

- Ihr

- Zephyrnet