Maschinelles Lernen (ML) hilft Unternehmen dabei, den Umsatz zu steigern, das Geschäftswachstum voranzutreiben und die Kosten zu senken, indem Kerngeschäftsfunktionen über mehrere Branchen hinweg optimiert werden, wie z Verbesserung der Fertigungsqualität. Herkömmliche ML-Entwicklungszyklen dauern Monate und erfordern kaum Data Science- und ML-Engineering-Kenntnisse. Die Ideen von Analysten für ML-Modelle befinden sich oft in langen Rückständen und warten auf die Bandbreite des Data-Science-Teams, während sich Data Scientists auf komplexere ML-Projekte konzentrieren, die ihre gesamten Fähigkeiten erfordern.

Um diese Pattsituation zu durchbrechen, haben wir Einführung von Amazon SageMaker Canvas, eine No-Code-ML-Lösung, mit der Unternehmen die Bereitstellung von ML-Lösungen auf Stunden oder Tage beschleunigen können. SageMaker Canvas ermöglicht Analysten die einfache Nutzung verfügbarer Daten in Data Lakes, Data Warehouses und Betriebsdatenspeichern; ML-Modelle erstellen; und verwenden Sie sie, um interaktiv Vorhersagen zu treffen und Massendatensätze im Batch zu bewerten – alles ohne eine einzige Codezeile zu schreiben.

In diesem Beitrag zeigen wir, wie SageMaker Canvas die Zusammenarbeit zwischen Datenwissenschaftlern und Geschäftsanalysten ermöglicht, eine kürzere Markteinführungszeit erreicht und die Entwicklung von ML-Lösungen beschleunigt. Analysten erhalten ihren eigenen No-Code-ML-Arbeitsbereich in SageMaker Canvas, ohne ein ML-Experte werden zu müssen. Analysten können dann ihre Modelle aus Canvas mit wenigen Klicks teilen, mit denen Data Scientists arbeiten können Amazon SageMaker-Studio, eine integrierte End-to-End-ML-Entwicklungsumgebung (IDE). Durch die Zusammenarbeit können Business-Analysten ihr Domänenwissen und die Ergebnisse der Experimente einbringen, während Data Scientists effektiv Pipelines erstellen und den Prozess rationalisieren können.

Sehen wir uns an, wie der Workflow aussehen würde.

Business-Analysten erstellen ein Modell und teilen es dann

Um zu verstehen, wie SageMaker Canvas die Zusammenarbeit zwischen Geschäftsanalysten und Datenwissenschaftlern (oder ML-Ingenieuren) vereinfacht, nähern wir uns dem Prozess zunächst als Geschäftsanalyst. Bevor Sie beginnen, lesen Sie unter Ankündigung von Amazon SageMaker Canvas – eine visuelle maschinelle Lernfunktion ohne Code für Business-Analysten für Anweisungen zum Erstellen und Testen des Modells mit SageMaker Canvas.

Für diesen Beitrag verwenden wir eine modifizierte Version des Datensatz zur Erkennung von Kreditkartenbetrug von Kaggle, einem bekannten Datensatz für ein binäres Klassifizierungsproblem. Der Datensatz ist ursprünglich sehr unausgeglichen – er hat nur sehr wenige Einträge, die als negative Klasse (anomale Transaktionen) klassifiziert sind. Unabhängig von der Zielfunktionsverteilung können wir diesen Datensatz dennoch verwenden, da SageMaker Canvas dieses Ungleichgewicht beim automatischen Trainieren und Optimieren eines Modells handhabt. Dieser Datensatz besteht aus etwa 9 Millionen Zellen. Sie können auch eine herunterladen reduzierte Version dieses Datensatzes. Die Größe des Datensatzes ist mit etwa 500,000 Zellen viel kleiner, da er mit der SMOTE-Technik zufällig unterabgetastet und dann überabgetastet wurde, um sicherzustellen, dass während dieses Prozesses so wenig Informationen wie möglich verloren gehen. Das Ausführen eines gesamten Experiments mit diesem reduzierten Datensatz kostet Sie im Rahmen des kostenlosen Kontingents von SageMaker Canvas 0 $.

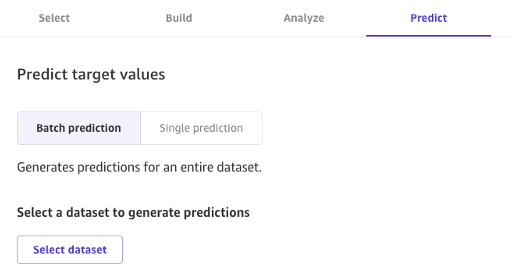

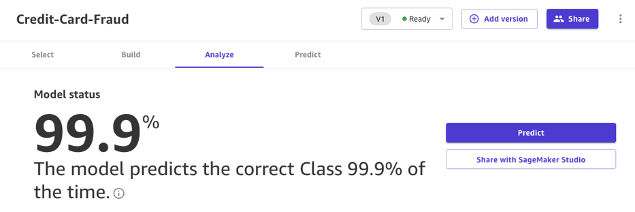

Nachdem das Modell erstellt wurde, können Analysten es verwenden, um direkt in Canvas Vorhersagen für einzelne Anfragen oder für ein ganzes Eingabe-Dataset in großen Mengen zu treffen.

Modelle, die mit Canvas Standard Build erstellt wurden, können auch einfach per Knopfdruck mit Data Scientists und ML-Ingenieuren geteilt werden, die SageMaker Studio verwenden. Auf diese Weise kann ein Data Scientist die Leistung des von Ihnen erstellten Modells validieren und Feedback geben. ML-Ingenieure können Ihr Modell aufgreifen und es in bestehende Workflows und Produkte integrieren, die Ihrem Unternehmen und Ihren Kunden zur Verfügung stehen. Beachten Sie, dass es zum Zeitpunkt der Erstellung dieses Artikels nicht möglich ist, ein mit Canvas Quick Build erstelltes Modell oder ein Zeitreihen-Prognosemodell freizugeben.

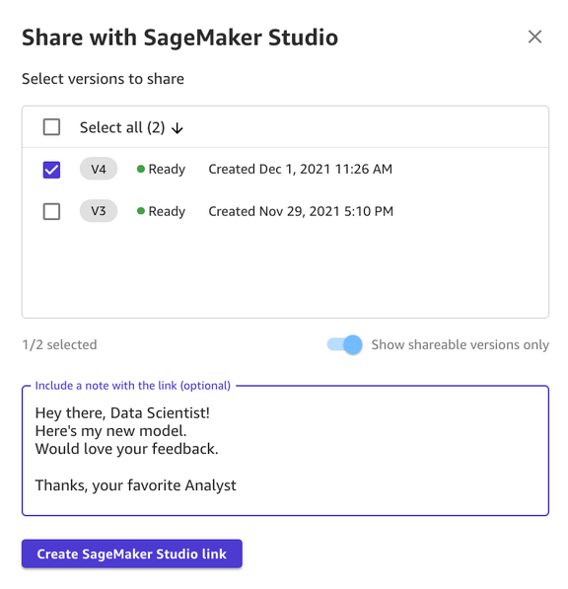

Das Teilen eines Modells über die Canvas-Benutzeroberfläche ist unkompliziert:

- Wählen Sie auf der Seite mit den von Ihnen erstellten Modellen ein Modell aus.

- Auswählen

Teilen.

- Wählen Sie eine oder mehrere Versionen des Modells aus, die Sie freigeben möchten.

- Fügen Sie optional eine Notiz hinzu, die mehr Kontext über das Modell oder die Hilfe, nach der Sie suchen, enthält.

- Auswählen

SageMaker Studio-Link erstellen.

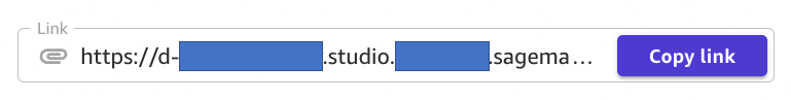

- Kopieren Sie den generierten Link.

Und das ist es! Sie können den Link jetzt über Slack, E-Mail oder eine andere Methode Ihrer Wahl mit Ihren Kollegen teilen. Der Datenwissenschaftler muss sich in derselben SageMaker Studio-Domäne befinden, um auf Ihr Modell zugreifen zu können. Stellen Sie daher sicher, dass dies bei Ihrem Organisationsadministrator der Fall ist.

Data Scientists greifen auf die Modellinformationen von SageMaker Studio zu

Lassen Sie uns nun in die Rolle eines Datenwissenschaftlers oder ML-Ingenieurs schlüpfen und die Dinge mithilfe von SageMaker Studio aus ihrer Sicht betrachten.

Der vom Analysten geteilte Link führt uns zu SageMaker Studio, der ersten Cloud-basierten IDE für den End-to-End-ML-Workflow.

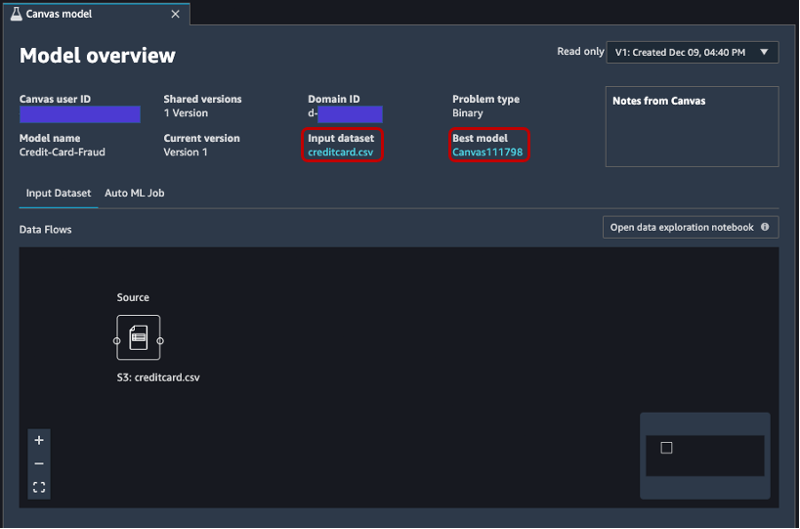

Die Registerkarte wird automatisch geöffnet und zeigt eine Übersicht über das vom Analysten in SageMaker Canvas erstellte Modell. Sie können schnell den Namen des Modells, den ML-Problemtyp, die Modellversion und den Benutzer sehen, der das Modell erstellt hat (unter dem Feld Canvas-Benutzer-ID). Sie haben auch Zugriff auf Details zum Eingabedatensatz und zum besten Modell, das SageMaker produzieren konnte. Darauf gehen wir später im Beitrag ein.

Auf dem Eingabedatensatz Auf der Registerkarte können Sie auch den Datenfluss von der Quelle zum Eingabedatensatz sehen. In diesem Fall wird nur eine Datenquelle verwendet und es wurden keine Verknüpfungsvorgänge angewendet, sodass eine einzelne Quelle angezeigt wird. Sie können Statistiken und Details zum Datensatz analysieren, indem Sie wählen Öffnen Sie das Datenexplorationsnotizbuch. Mit diesem Notizbuch können Sie die Daten erkunden, die vor dem Trainieren des Modells verfügbar waren, und enthält eine Analyse der Zielvariablen, ein Beispiel der Eingabedaten, Statistiken und Beschreibungen von Spalten und Zeilen sowie andere nützliche Informationen für den Data Scientist mehr über den Datensatz erfahren. Weitere Informationen zu diesem Bericht finden Sie unter Bericht zur Datenexploration.

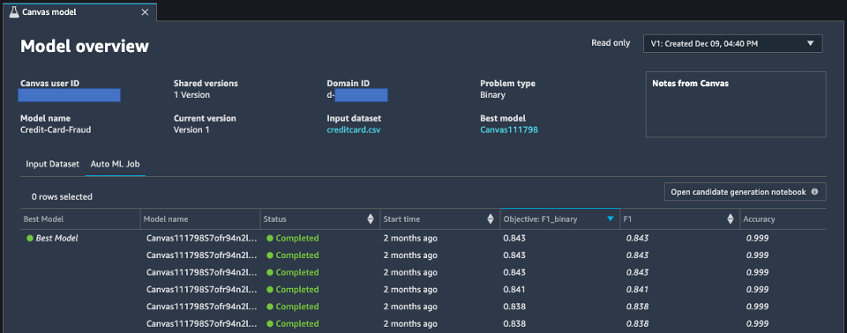

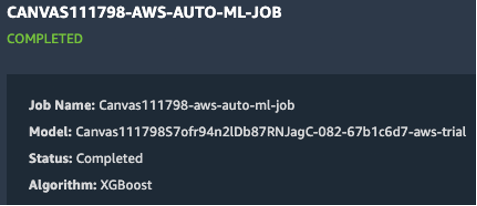

Gehen wir nach der Analyse des Eingabedatensatzes zum zweiten Tab der Modellübersicht über. AutoML-Job. Diese Registerkarte enthält eine Beschreibung des AutoML-Jobs, wenn Sie die Option Standard Build in SageMaker Canvas ausgewählt haben.

Die AutoML-Technologie unter SageMaker Canvas macht das schwere Heben beim Erstellen von ML-Modellen überflüssig. Es erstellt, trainiert und optimiert automatisch das beste ML-Modell basierend auf Ihren Daten, indem es einen automatisierten Ansatz verwendet, während Sie die volle Kontrolle und Transparenz behalten. Diese Sichtbarkeit der generierten Kandidatenmodelle sowie der während des AutoML-Prozesses verwendeten Hyperparameter ist in der enthalten Notizbuch der Kandidatengeneration, die auf dieser Registerkarte verfügbar ist.

Das AutoML-Job Die Registerkarte enthält auch eine Liste aller Modelle, die im Rahmen des AutoML-Prozesses erstellt wurden, sortiert nach der F1-Zielmetrik. Um das beste Modell aus den gestarteten Schulungsjobs hervorzuheben, wird in der ein Tag mit einem grünen Kreis verwendet Bestes Modell Säule. Sie können auch andere Metriken visualisieren, die während der Trainings- und Bewertungsphase verwendet werden, wie z. B. die Genauigkeitsbewertung und die Fläche unter der Kurve (AUC). Weitere Informationen zu den Modellen, die Sie während eines AutoML-Jobs trainieren können, und zu den Metriken, die zum Bewerten der Leistung des trainierten Modells verwendet werden, finden Sie unter Modellunterstützung, Metriken und Validierung.

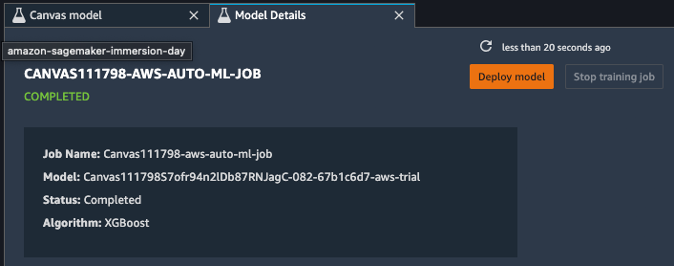

Um mehr über das Modell zu erfahren, können Sie jetzt mit der rechten Maustaste auf das beste Modell klicken und es auswählen In den Modelldetails öffnen. Alternativ können Sie wählen Bestes Modell Link oben auf der Modellübersicht Abschnitt, den Sie zuerst besucht haben.

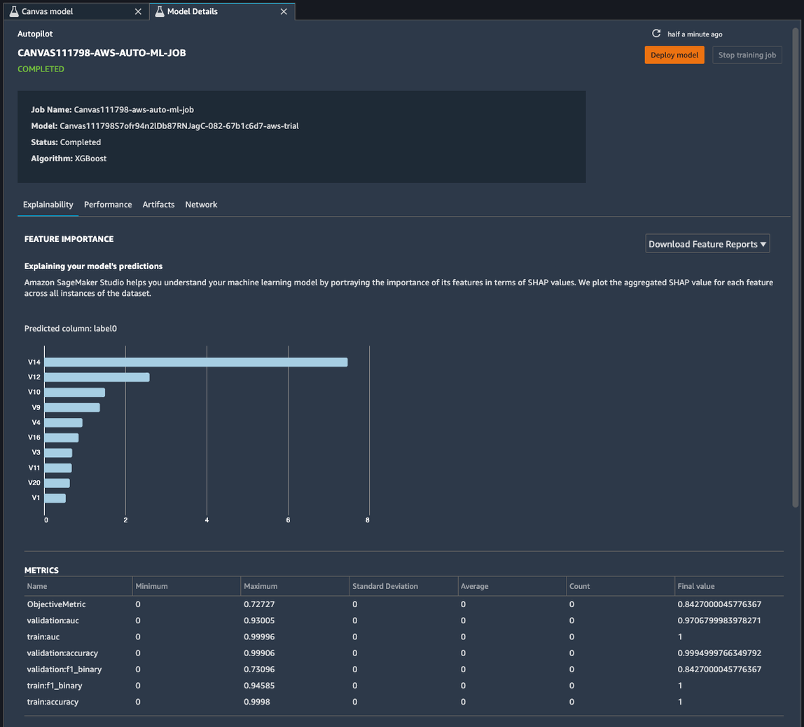

Die Modelldetailseite enthält eine Fülle nützlicher Informationen zu dem Modell, das mit diesen Eingabedaten am besten abgeschnitten hat. Konzentrieren wir uns zunächst auf die Zusammenfassung oben auf der Seite. Der vorherige Beispiel-Screenshot zeigt, dass von Hunderten von Modelltrainingsläufen ein XGBoost-Modell die beste Leistung für das Eingabe-Dataset erbracht hat. Zum Zeitpunkt der Erstellung dieses Artikels kann SageMaker Canvas drei Arten von ML-Algorithmen trainieren: Linear Learner, XGBoost und ein Multilayer Perceptron (MLP), jeweils mit einer Vielzahl von Vorverarbeitungspipelines und Hyperparametern. Weitere Informationen zu den einzelnen Algorithmen finden Sie unter Seite mit unterstützten Algorithmen.

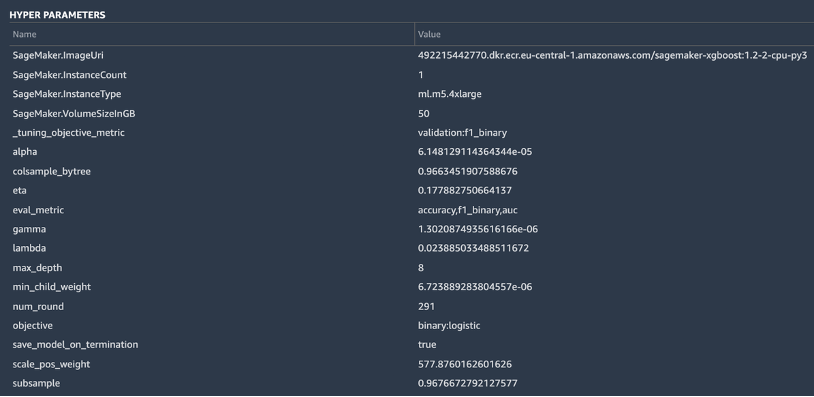

Dank einer skalierbaren und effizienten Implementierung enthält SageMaker auch eine erklärende Funktionalität KernelSHAP, basierend auf dem Konzept eines Shapley-Wertes aus dem Bereich der kooperativen Spieltheorie, der jedem Merkmal einen Wichtigkeitswert für eine bestimmte Vorhersage zuweist. Dies ermöglicht Transparenz darüber, wie das Modell zu seinen Vorhersagen gelangt ist, und es ist sehr nützlich, die Wichtigkeit von Merkmalen zu definieren. Ein vollständiger Erklärbarkeitsbericht einschließlich der Wichtigkeit von Funktionen kann im PDF-, Notebook- oder Rohdatenformat heruntergeladen werden. In diesem Bericht wird ein breiterer Satz von Metriken sowie eine vollständige Liste von Hyperparametern angezeigt, die während des AutoML-Jobs verwendet werden. Weitere Informationen darüber, wie SageMaker integrierte Erklärbarkeitstools für AutoML-Lösungen und Standard-ML-Algorithmen bereitstellt, finden Sie unter Verwenden Sie integrierte Erklärbarkeitstools und verbessern Sie die Modellqualität mit Amazon SageMaker Autopilot.

Schließlich zeigen die anderen Registerkarten in dieser Ansicht Informationen zu Leistungsdetails (Konfusionsmatrix, Präzisions-Erinnerungskurve, ROC-Kurve), Artefakten, die für Eingaben verwendet und während des AutoML-Jobs generiert werden, sowie Netzwerkdetails.

An diesem Punkt hat der Datenwissenschaftler zwei Möglichkeiten: das Modell direkt bereitstellen oder eine Trainingspipeline erstellen, die manuell oder automatisch geplant oder ausgelöst werden kann. Die folgenden Abschnitte bieten einige Einblicke in beide Optionen.

Stellen Sie das Modell direkt bereit

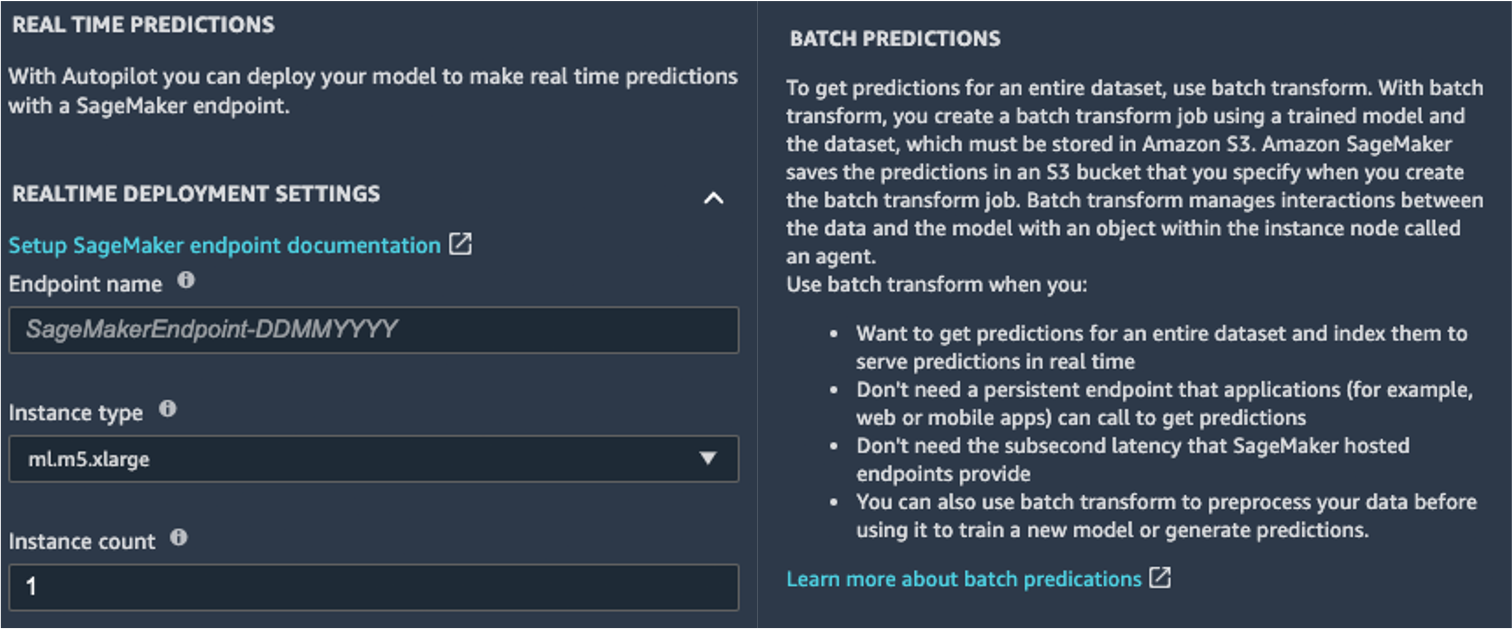

Wenn der Data Scientist mit den Ergebnissen des AutoML-Jobs zufrieden ist, kann er das Modell direkt aus dem bereitstellen Modelldetails Seite. Es ist so einfach wie die Wahl Modell bereitstellen neben dem Modellnamen.

SageMaker zeigt Ihnen zwei Bereitstellungsoptionen: einen Echtzeit-Endpunkt, powered by Amazon SageMaker-Endpunkte, und Batch-Inferenz, powered by Amazon SageMaker Batch-Transformation.

SageMaker bietet auch andere Inferenzmodi. Weitere Informationen finden Sie unter Modelle für Inferenz bereitstellen.

Um den Echtzeitvorhersagemodus zu aktivieren, geben Sie dem Endpunkt einfach einen Namen, einen Instanztyp und eine Instanzanzahl. Da dieses Modell keine großen Rechenressourcen erfordert, können Sie eine CPU-basierte Instanz mit einer anfänglichen Anzahl von 1 verwenden. Sie können mehr über die verschiedenen Arten von verfügbaren Instanzen und ihre Spezifikationen auf der erfahren Amazon SageMaker-Preisseite (in dem On-Demand-Preise Abschnitt, wählen Sie die Echtzeit-Inferenz Tab). Wenn Sie nicht wissen, welche Instanz Sie für Ihre Bereitstellung wählen sollten, können Sie SageMaker auch bitten, anhand Ihrer KPIs die beste für Sie zu finden, indem Sie die verwenden SageMaker-Inferenz-Empfehler. Sie können auch zusätzliche optionale Parameter angeben, ob Sie Anforderungs- und Antwortdaten zum oder vom Endpunkt erfassen möchten oder nicht. Dies kann sich als nützlich erweisen, wenn Sie vorhaben Überwachung Ihres Modells. Sie können auch auswählen, welche Inhalte Sie als Teil Ihrer Antwort bereitstellen möchten – sei es nur die Vorhersage oder die Vorhersagewahrscheinlichkeit, die Wahrscheinlichkeit aller Klassen und die Zielbezeichnungen.

Um einen Batch-Scoring-Job auszuführen, der gleichzeitig Vorhersagen für einen ganzen Satz von Eingaben erhält, können Sie den Batch-Transformationsjob über starten AWS-Managementkonsole oder über das SageMaker Python SDK. Weitere Informationen zur Stapeltransformation finden Sie unter Verwenden Sie die Stapeltransformation und die Beispielnotizbücher.

Definieren Sie eine Trainingspipeline

ML-Modelle können sehr selten, wenn überhaupt, als statisch und unveränderlich angesehen werden, da sie von der Grundlinie abweichen, auf der sie trainiert wurden. Daten aus der realen Welt entwickeln sich im Laufe der Zeit weiter, und daraus ergeben sich weitere Muster und Erkenntnisse, die vom ursprünglichen Modell, das auf historischen Daten trainiert wurde, erfasst werden können oder nicht. Um dieses Problem zu lösen, können Sie eine Trainingspipeline einrichten, die Ihre Modelle automatisch mit den neuesten verfügbaren Daten neu trainiert.

Bei der Definition dieser Pipeline besteht eine der Optionen des Datenwissenschaftlers darin, erneut AutoML für die Trainingspipeline zu verwenden. Sie können einen AutoML-Job programmgesteuert starten, indem Sie die API create_auto_ml_job() über die aufrufen AWS Boto3-SDK. Sie können diese Operation von einem aufrufen AWS Lambda Funktion innerhalb eines AWS Step-Funktionen Workflow oder von einem LambdaStep in Amazon SageMaker-Pipelines.

Alternativ kann der Data Scientist das Wissen, die Artefakte und die Hyperparameter verwenden, die er aus dem AutoML-Job erhält, um eine vollständige Trainingspipeline zu definieren. Sie benötigen folgende Ressourcen:

- Der Algorithmus, der für den Anwendungsfall am besten funktioniert hat – Diese Informationen haben Sie bereits aus der Zusammenfassung des mit Canvas generierten Modells erhalten. Für diesen Anwendungsfall ist es der integrierte XGBoost-Algorithmus. Anweisungen zur Verwendung des SageMaker Python SDK zum Trainieren des XGBoost-Algorithmus mit SageMaker finden Sie unter Verwenden Sie XGBoost mit dem SageMaker Python SDK.

- Die vom AutoML-Job abgeleiteten Hyperparameter – Diese sind im erhältlich Erklärbarkeit Sektion. Sie können sie als Eingaben verwenden, wenn Sie den Trainingsjob mit dem SageMaker Python SDK definieren.

- Der Funktionsentwicklungscode, der im Abschnitt „Artefakte“ bereitgestellt wird – Sie können diesen Code sowohl zur Vorverarbeitung der Daten vor dem Training (z. B. über die Amazon SageMaker-Verarbeitung) als auch vor der Inferenz (z. B. als Teil einer SageMaker-Inferenzpipeline) verwenden.

Sie können diese Ressourcen als Teil einer SageMaker-Pipeline kombinieren. Wir lassen die Implementierungsdetails in diesem Beitrag weg – bleiben Sie dran für weitere Inhalte zu diesem Thema.

Zusammenfassung

Mit SageMaker Canvas können Sie ML verwenden, um Vorhersagen zu generieren, ohne Code schreiben zu müssen. Ein Business Analyst kann es autonom mit lokalen Datensätzen sowie bereits gespeicherten Daten verwenden Amazon Simple Storage-Service (Amazon S3), Amazon RedShift, oder Schneeflocke. Mit nur wenigen Klicks können sie ihre Datensätze vorbereiten und zusammenführen, die geschätzte Genauigkeit analysieren, überprüfen, welche Spalten wirksam sind, das leistungsstärkste Modell trainieren und neue Einzel- oder Stapelvorhersagen erstellen, ohne dass ein erfahrener Datenwissenschaftler hinzugezogen werden muss. Anschließend können sie das Modell bei Bedarf mit einem Team von Datenwissenschaftlern oder MLOps-Ingenieuren teilen, die die Modelle in SageMaker Studio importieren, und mit dem Analysten zusammenarbeiten, um eine Produktionslösung bereitzustellen.

Business Analysten können selbstständig Erkenntnisse aus ihren Daten gewinnen, ohne einen Abschluss in ML zu haben und ohne eine einzige Zeile Code schreiben zu müssen. Data Scientists haben jetzt zusätzliche Zeit, um an anspruchsvolleren Projekten zu arbeiten, die ihr umfassendes Wissen über KI und ML besser nutzen können.

Wir glauben, dass diese neue Zusammenarbeit die Tür zum Aufbau vieler leistungsfähigerer ML-Lösungen für Ihr Unternehmen öffnet. Sie haben jetzt Analysten, die wertvolle Geschäftseinblicke liefern, während Data Scientists und ML-Ingenieure bei der Verfeinerung, Feinabstimmung und Erweiterung nach Bedarf helfen.

Weitere Informationen

- Weitere Informationen darüber, wie SageMaker Geschäftsanalysten weiter helfen kann, finden Sie unter Amazon SageMaker für Geschäftsanalysten.

- Um mehr darüber zu erfahren, wie SageMaker es Datenwissenschaftlern ermöglicht, ihre ML-Modelle zu entwickeln, zu trainieren und einzusetzen, lesen Sie hier Amazon SageMaker für Datenwissenschaftler.

- Weitere Informationen darüber, wie SageMaker MLOps-Ingenieure bei der Rationalisierung des ML-Lebenszyklus mit MLOps unterstützen kann, finden Sie unter Amazon SageMaker für MLOps-Ingenieure.

Über die Autoren

David Gallitelli ist ein Specialist Solutions Architect für AI/ML in der EMEA-Region. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden in den Benelux-Ländern zusammen. Er ist Entwickler, seit er sehr jung war und begann im Alter von 7 Jahren zu programmieren. Er begann an der Universität AI/ML zu lernen und hat sich seitdem darin verliebt.

David Gallitelli ist ein Specialist Solutions Architect für AI/ML in der EMEA-Region. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden in den Benelux-Ländern zusammen. Er ist Entwickler, seit er sehr jung war und begann im Alter von 7 Jahren zu programmieren. Er begann an der Universität AI/ML zu lernen und hat sich seitdem darin verliebt.

Markus Roy ist Principal Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von AI / ML-Lösungen. Marks Arbeit deckt eine breite Palette von ML-Anwendungsfällen ab, mit einem Hauptinteresse an Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen. Er hat Unternehmen in vielen Branchen unterstützt, darunter Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification. Bevor er zu AWS kam, war Mark über 25 Jahre lang Architekt, Entwickler und Technologieführer, davon 19 Jahre im Bereich Finanzdienstleistungen.

Markus Roy ist Principal Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von AI / ML-Lösungen. Marks Arbeit deckt eine breite Palette von ML-Anwendungsfällen ab, mit einem Hauptinteresse an Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen. Er hat Unternehmen in vielen Branchen unterstützt, darunter Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification. Bevor er zu AWS kam, war Mark über 25 Jahre lang Architekt, Entwickler und Technologieführer, davon 19 Jahre im Bereich Finanzdienstleistungen.

- Coinsmart. Europas beste Bitcoin- und Krypto-Börse.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. DEN FREIEN ZUGANG.

- CryptoHawk. Altcoin-Radar. Kostenlose Testphase.

- Quelle: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-und-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Über uns

- beschleunigen

- beschleunigend

- Zugang

- Nach

- über

- Zusätzliche

- Administrator

- AI

- Algorithmus

- Algorithmen

- Alle

- Zulassen

- bereits

- Amazon

- Analyse

- Analytiker

- Bienen

- Ansatz

- Bereich

- um

- Automatisiert

- verfügbar

- AWS

- Baseline

- werden

- BESTE

- Grenze

- Brüssel

- bauen

- Building

- baut

- eingebaut

- Geschäft

- rufen Sie uns an!

- Fälle

- Zertifizierung

- Entscheidungen

- Kreis

- Einstufung

- Code

- Zusammenarbeit

- Kolonne

- Kommen

- Unternehmen

- Unternehmen

- Komplex

- Berechnen

- konzept

- Verwirrung

- enthält

- Inhalt

- Smartgeräte App

- Genossenschaft

- Kernbereich

- Kosten

- Kredit

- Kurve

- Kunden

- technische Daten

- Datenwissenschaft

- Datenwissenschaftler

- Lieferanten

- Demand

- einsetzen

- Einsatz

- Design

- Entdeckung

- entwickeln

- Entwickler:in / Unternehmen

- Entwicklung

- anders

- Verteilung

- Tut nicht

- Domain

- nach unten

- leicht

- effizient

- Endpunkt

- Ingenieur

- Entwicklung

- Ingenieure

- Unternehmen

- Unterhaltung

- Arbeitsumfeld

- geschätzt

- Beispiel

- Experiment

- Exploration

- erweitern

- beschleunigt

- Merkmal

- Feedback

- Revolution

- Finanzdienstleistungen

- Vorname

- Fluss

- Setzen Sie mit Achtsamkeit

- Folgende

- Format

- Betrug

- Frei

- voller

- Funktion

- Funktionalität

- Spiel

- erzeugen

- bekommen

- Unterstützung

- Grün

- Wachstum

- mit

- Gesundheitswesen

- Hilfe

- hilft

- Hervorheben

- hoch

- historisch

- hält

- Ultraschall

- Hilfe

- HTTPS

- hunderte

- Bedeutung

- zu unterstützen,

- das

- Einschließlich

- Erhöhung

- Krankengymnastik

- Branchen

- Information

- Einblicke

- Versicherung

- integrieren

- integriert

- Interesse

- IT

- Job

- Jobs

- join

- Wissen

- Etiketten

- neueste

- starten

- LERNEN

- lernen

- Line

- LINK

- Liste

- wenig

- aus einer regionalen

- Lang

- suchen

- ich liebe

- Maschine

- Maschinelles Lernen

- Management

- manuell

- Herstellung

- Kennzeichen

- Markt

- Matrix

- Medien

- Metrik

- Million

- ML

- Modell

- für

- Monat

- schlauer bewegen

- Netzwerk

- Notizbuch

- Angebote

- öffnet

- Einkauf & Prozesse

- Option

- Optionen

- Auftrag

- Organisation

- Organisationen

- Andere

- Leistung

- Leistungen

- Phase

- Planung

- Play

- Perspektive

- möglich

- größte treibende

- Prognose

- Prognosen

- gebühr

- primär

- Principal

- Aufgabenstellung:

- Prozessdefinierung

- produziert

- Produktion

- Produkte

- Projekte

- die

- bietet

- Ziehen

- Qualität

- schnell

- Angebot

- Roh

- Echtzeit

- Veteran

- berichten

- erfordern

- Downloads

- Antwort

- Die Ergebnisse

- Einnahmen

- Führen Sie

- Laufen

- skalierbaren

- Skalierung

- Wissenschaft

- Wissenschaftler

- Wissenschaftler

- Sdk

- ausgewählt

- Modellreihe

- Leistungen

- kompensieren

- Teilen

- von Locals geführtes

- Einfacher

- SIX

- Größe

- Fähigkeiten

- locker

- So

- Lösungen

- LÖSEN

- Anfang

- begonnen

- Statistiken

- storage

- Läden

- Studio Adressen

- Support

- Target

- Team

- Technologie

- Testen

- Die Quelle

- während

- Zeit

- gemeinsam

- Werkzeuge

- Top

- traditionell

- Ausbildung

- schult Ehrenamtliche

- Transaktionen

- Transformieren

- Transparenz

- ui

- verstehen

- Universität

- us

- -

- Wert

- Anzeigen

- Sichtbarkeit

- Seh-

- Was

- ob

- WHO

- .

- ohne

- Arbeiten

- gearbeitet

- arbeiten,

- Werk

- Schreiben

- Jahr