Ich bin ein großer Fan der Reiseshow von Anthony Bourdain Teile unbekannt. In jeder Folge besucht der Koch abgelegene Dörfer auf der ganzen Welt und dokumentiert mit offenem Herzen und Verstand das Leben, Essen und die Kultur regionaler Stämme.

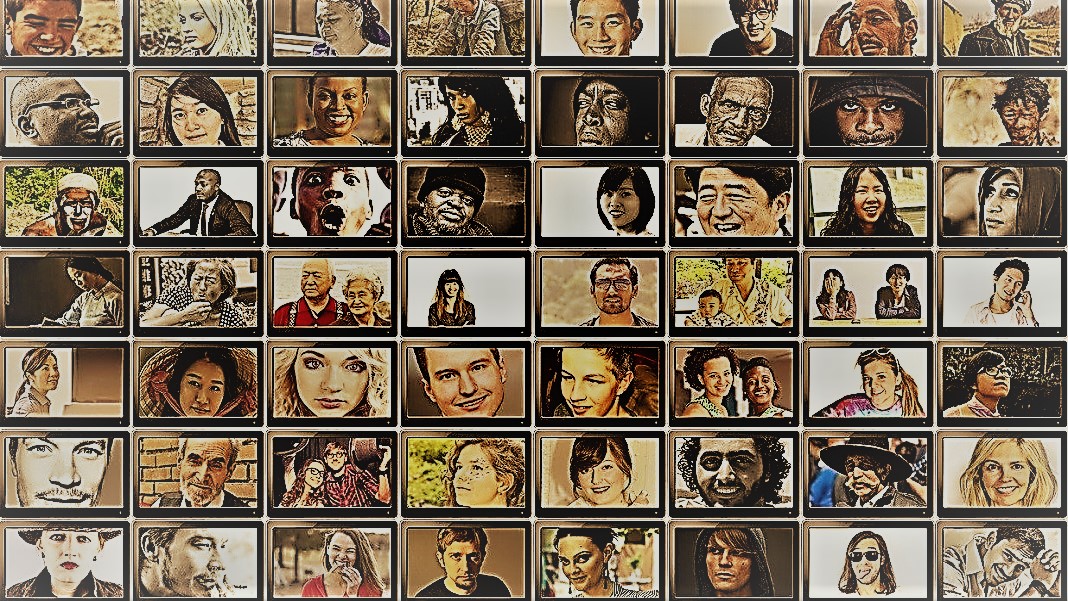

Die Show bietet einen Einblick in die erstaunliche Vielfalt der Menschheit. Sozialwissenschaftler haben ein ähnliches Ziel – das Verhalten verschiedener Menschen, Gruppen und Kulturen zu verstehen –, wenden jedoch in kontrollierten Situationen unterschiedliche Methoden an. Für beide sind die Protagonisten dieser Unternehmungen die Protagonisten: die Menschen.

Aber was wäre, wenn Sie Menschen durch KI-Chatbots ersetzen würden?

Die Idee klingt absurd. Doch dank des Aufkommens von ChatGPT und anderen großen Sprachmodellen (LLMs) liebäugeln Sozialwissenschaftler mit der Idee, diese Tools zu nutzen, um schnell verschiedene Gruppen „simulierter Menschen“ zu konstruieren und Experimente durchzuführen, um deren Verhalten und Werte als Stellvertreter ihrer biologischen Gegenstücke zu untersuchen.

Wenn Sie sich digital nachgebildete menschliche Köpfe vorstellen, ist das nicht der Fall. Die Idee besteht darin, die Expertise von ChatGPT bei der Nachahmung menschlicher Reaktionen zu nutzen. Da die Modelle riesige Mengen an Online-Daten – Blogs, YouTube-Kommentare, Fanfiction, Bücher – auswerten, erfassen sie problemlos Beziehungen zwischen Wörtern in mehreren Sprachen. Diese hochentwickelten Algorithmen können auch nuancierte Aspekte der Sprache entschlüsseln, wie etwa Ironie, Sarkasmus, Metaphern und emotionale Töne, ein entscheidender Aspekt der menschlichen Kommunikation in jeder Kultur. Diese Stärken versetzen LLMs in die Lage, mehrere synthetische Persönlichkeiten mit einem breiten Spektrum an Überzeugungen nachzuahmen.

Noch ein Bonus? Im Vergleich zu menschlichen Teilnehmern ermüden ChatGPT und andere LLMs nicht, sodass Wissenschaftler mit beispielloser Geschwindigkeit Daten sammeln und Theorien über menschliches Verhalten testen können.

Die Idee ist zwar umstritten, findet aber bereits Unterstützung. Ein neuer Artikel Eine Überprüfung des entstehenden Feldes ergab, dass in bestimmten sorgfältig entworfenen Szenarien die Antworten von ChatGPT mit denen von etwa 95 Prozent der menschlichen Teilnehmer korrelierten.

KI „könnte das Spiel für die sozialwissenschaftliche Forschung verändern“ sagte Dr. Igor Grossman von der University of Waterloo, der kürzlich zusammen mit Kollegen einen Vorschauartikel in verfasst hat Wissenschaft. Der Schlüssel zur Verwendung Homo silicus in der Forschung? Sorgfältiges Bias-Management und Datentreue, sagte das Team.

Erforschung des menschlichen gesellschaftlichen Geistes

Was genau ist Sozialwissenschaft?

Vereinfacht ausgedrückt geht es darum, zu untersuchen, wie sich Menschen – entweder als Individuen oder als Gruppe – unter verschiedenen Umständen verhalten, wie sie miteinander interagieren und sich als Kultur entwickeln. Es handelt sich um einen Dachverband akademischer Tätigkeit mit mehreren Zweigen: Wirtschaftswissenschaften, Politikwissenschaft, Anthropologie und Psychologie.

Die Disziplin befasst sich mit einem breiten Spektrum an Themen, die im aktuellen Zeitgeist aktuell sind. Welchen Einfluss haben soziale Medien auf die psychische Gesundheit? Wie ist die aktuelle öffentliche Einstellung zum Klimawandel angesichts zunehmender Unwetterepisoden? Wie bewerten verschiedene Kulturen Kommunikationsmethoden – und was löst Missverständnisse aus?

Eine sozialwissenschaftliche Studie beginnt mit einer Frage und einer Hypothese. Einer meiner Favoriten: Vertragen Kulturen Körpergeruch unterschiedlich? (Im Ernst, das Thema wurde untersucht, ziemlich viel, und ja, da ist ein Unterschied!)

Anschließend verwenden Wissenschaftler verschiedene Methoden wie Fragebögen, Verhaltenstests, Beobachtung und Modellierung, um ihre Ideen zu testen. Umfragen sind ein besonders beliebtes Instrument, da die Fragen stringent gestaltet und überprüft werden können und bei der Online-Verteilung problemlos ein breites Personenspektrum erreichen. Wissenschaftler analysieren dann schriftliche Antworten und ziehen Erkenntnisse über menschliches Verhalten. Mit anderen Worten: Der Sprachgebrauch eines Teilnehmers ist für diese Studien von entscheidender Bedeutung.

Wie passt also ChatGPT dazu?

Der „Homo Silicus“

Für Grossman stellen die LLMs hinter Chatbots wie ChatGPT oder Googles Bard eine beispiellose Gelegenheit dar, sozialwissenschaftliche Experimente neu zu gestalten.

Da sie auf riesigen Datensätzen trainiert werden, können LLMs „ein breites Spektrum menschlicher Erfahrungen und Perspektiven repräsentieren“, so die Autoren. Da sich die Modelle frei und ohne Grenzen im Internet bewegen – wie Menschen, die häufig international reisen –, können sie im Vergleich zu rekrutierten menschlichen Probanden ein breiteres Spektrum an Reaktionen annehmen und anzeigen.

ChatGPT lässt sich auch nicht von anderen Teilnehmern einer Studie beeinflussen oder ermüden, sodass möglicherweise weniger voreingenommene Antworten generiert werden. Diese Eigenschaften können besonders bei „Hochrisikoprojekten“ nützlich sein – zum Beispiel bei der Nachahmung der Reaktionen von Menschen, die in Ländern leben, in denen Krieg herrscht oder unter schwierigen Regimen, durch Social-Media-Beiträge. Die Antworten könnten wiederum in reale Interventionen einfließen.

In ähnlicher Weise könnten LLM-Studierende, die sich mit kulturell wichtigen Themen wie Geschlechtsidentität oder Fehlinformationen befassen, verschiedene theoretische oder ideologische Denkschulen reproduzieren, um politische Entscheidungen zu treffen. Anstatt Hunderttausende menschliche Teilnehmer mühsam zu befragen, kann die KI schnell Antworten auf der Grundlage von Online-Diskursen generieren.

Abgesehen von möglichen realen Einsatzmöglichkeiten können LLMs auch als digitale Subjekte fungieren, die mit menschlichen Teilnehmern an sozialwissenschaftlichen Experimenten interagieren, ähnlich wie Nichtspielercharaktere (NPC) in Videospielen. Beispielsweise könnte der LLM verschiedene „Persönlichkeiten“ annehmen und mit menschlichen Freiwilligen auf der ganzen Welt online per Text interagieren, indem er ihnen dieselbe Frage stellt. Da Algorithmen nicht schlafen, könnten sie rund um die Uhr laufen. Die resultierenden Daten können Wissenschaftlern dann dabei helfen, zu untersuchen, wie unterschiedliche Kulturen ähnliche Informationen bewerten und wie sich Meinungen – und Fehlinformationen – verbreiten.

Baby Steps

Die Idee, in Studien Chatbots anstelle von Menschen einzusetzen, ist noch nicht allgemein verbreitet.

Aber es gibt erste Beweise dafür, dass es funktionieren könnte. A Preprint-Studie Eine in diesem Monat von Georgia Tech, Microsoft Research und dem Olin College veröffentlichte Studie ergab, dass ein LLM menschliche Reaktionen in zahlreichen Experimenten der klassischen Psychologie, einschließlich der berüchtigten, nachahmte Milgram-Schockexperimente.

Dennoch bleibt eine entscheidende Frage: Wie gut können diese Modelle die Reaktion eines Menschen wirklich erfassen?

Es gibt mehrere Stolpersteine.

Erstens ist die Qualität des Algorithmus und der Trainingsdaten wichtig. Die meisten Online-Inhalte werden von nur einer Handvoll Sprachen dominiert. Ein auf diesen Daten trainierter LLM könnte leicht die Gefühle, Perspektiven oder sogar moralischen Urteile von Menschen nachahmen, die diese Sprachen verwenden – und dabei wiederum Vorurteile aus den Trainingsdaten übernehmen.

„Diese Reproduktion von Vorurteilen ist ein großes Problem, da sie genau die Unterschiede verstärken könnte, die Sozialwissenschaftler in ihrer Forschung aufdecken wollen“, sagte Grossman.

Einige Wissenschaftler befürchten auch, dass LLMs gerecht sind Aufstoßen was ihnen gesagt wird. Es ist das Gegenteil einer sozialwissenschaftlichen Studie, bei der es vor allem darum geht, die Menschheit in all ihrer vielfältigen und komplexen Schönheit einzufangen. Andererseits ist bekannt, dass ChatGPT und ähnliche Modelle „halluzinieren„Informationen erfinden, die plausibel klingen, aber falsch sind.“

Derzeit „stützen sich große Sprachmodelle auf ‚Schatten‘ menschlicher Erfahrungen“, sagte Grossman. Da es sich bei diesen KI-Systemen größtenteils um Black Boxes handelt, ist es schwierig zu verstehen, wie oder warum sie bestimmte Reaktionen erzeugen – ein wenig beunruhigend, wenn man sie als menschliche Stellvertreter in Verhaltensexperimenten verwendet.

Trotz Einschränkungen „ermöglichen LLMs Sozialwissenschaftlern, sich von traditionellen Forschungsmethoden zu lösen und ihre Arbeit auf innovative Weise anzugehen“, so die Autoren. Als erster Schritt könnte Homo silicus beim Brainstorming und schnellen Testen von Hypothesen helfen, wobei vielversprechende Hypothesen in menschlichen Populationen weiter validiert werden könnten.

Doch damit die Sozialwissenschaften KI wirklich willkommen heißen, bedarf es Transparenz, Fairness und gleichberechtigten Zugang zu diesen leistungsstarken Systemen. Die Ausbildung von LLMs ist schwierig und teuer, da neuere Modelle zunehmend hinter hohen Bezahlschranken verborgen bleiben.

„Wir müssen sicherstellen, dass sozialwissenschaftliche LLMs, wie alle wissenschaftlichen Modelle, Open Source sind, was bedeutet, dass ihre Algorithmen und idealerweise ihre Daten allen zur Prüfung, Prüfung und Änderung zur Verfügung stehen.“ sagte Studienautorin Dr. Dawn Parker von der University of Waterloo. „Nur durch die Aufrechterhaltung von Transparenz und Reproduzierbarkeit können wir sicherstellen, dass KI-gestützte sozialwissenschaftliche Forschung wirklich zu unserem Verständnis menschlicher Erfahrung beiträgt.“

Bild-Kredit: Gerd Altmann / Pixabay

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :hast

- :Ist

- :nicht

- $UP

- 23

- a

- Über Uns

- akademisch

- Zugang

- über

- Handlung

- adoptieren

- Advent

- AI

- Algorithmus

- Algorithmen

- Alle

- erlauben

- Zulassen

- bereits

- ebenfalls

- Beträge

- an

- analysieren

- und

- Heinrich

- Ansatz

- SIND

- Arizona

- Feld

- Artikel

- AS

- Aussehen

- Aspekte

- At

- Autor

- Autoren

- verfügbar

- basierend

- BE

- Die Schönheit

- weil

- war

- Verhalten

- hinter

- Sein

- Überzeugungen

- zwischen

- vorspannen

- voreingenommen

- Bit

- Schwarz

- Blockiert

- Körper

- Bonus

- Grenzen

- beide

- Boxen

- Geistesblitz

- Geäst

- Break

- aber

- by

- CAN

- Erfassung

- vorsichtig

- sicher

- Übernehmen

- Zeichen

- Chatbots

- ChatGPT

- Umstände

- Klimaschutz

- Klimawandel

- Kopien

- sammeln

- Hochschule

- Bemerkungen

- Kommunikation

- verglichen

- Komplex

- Hautpflegeprobleme

- konstruieren

- Inhalt

- trägt dazu bei

- gesteuert

- umstritten

- könnte

- Ländern

- Kredit

- kritischem

- kritischer Aspekt

- Kultur-

- KULTUR

- Strom

- technische Daten

- Datensätze

- entworfen

- entwickeln

- anders

- schwer

- digital

- digital

- Display

- verteilt

- verschieden

- Diversität

- do

- die

- Tut nicht

- Nicht

- dr

- zeichnen

- jeder

- Früh

- leicht

- Wirtschaftskunde

- enorm

- gewährleisten

- Folge anschauen

- gleich

- insbesondere

- bewerten

- Sogar

- Jedes

- genau

- Beispiel

- teuer

- ERFAHRUNGEN

- Erfahrungen

- Experimente

- Expertise

- ERKUNDEN

- Fairness

- falsch

- Fan

- Fiktion

- Treue

- Feld

- Vorname

- passen

- Lebensmittel

- Aussichten für

- gefunden

- für

- weiter

- Spiel

- Games

- Geschlecht

- erzeugen

- Georgien

- bekommen

- Blick

- Globus

- Gruppen

- Pflege

- Hand voll

- Haben

- Gesundheit

- Herz

- Hilfe

- HEISS

- Ultraschall

- HTML

- http

- HTTPS

- riesig

- human

- Menschliche Erfahrung

- Menschlichkeit

- Humans

- hunderte

- Idee

- im Idealfall

- Ideen

- Identitätsschutz

- if

- Impact der HXNUMXO Observatorien

- in

- In anderen

- Einschließlich

- Erhöhung

- zunehmend

- Einzelpersonen

- berüchtigt

- beeinflusst

- informieren

- Information

- innovativ

- Einblicke

- interagieren

- in

- Ironie

- IT

- SEINE

- jpg

- nur

- Wesentliche

- bekannt

- Sprache

- Sprachen

- grosse

- weitgehend

- weniger

- Gefällt mir

- Einschränkungen

- Leben

- Leben

- LLM

- Main

- Mainstream

- Aufrechterhaltung

- Dur

- Making

- Management

- massiv

- Kann..

- Bedeutung

- Medien

- Mitglieder

- geistig

- Psychische Gesundheit

- Methoden

- Microsoft

- Geist / Bewusstsein

- Köpfe

- Fehlinformationen

- Modellieren

- für

- ändern

- Monat

- Moral

- vor allem warme

- mehrere

- sollen

- my

- im Entstehen begriffen

- Need

- nicht

- jetzt an

- und viele

- of

- vorgenommen,

- on

- EINEM

- Einsen

- Online

- XNUMXh geöffnet

- Open-Source-

- Gelegenheit

- or

- Andere

- UNSERE

- Teilnehmer

- Personen

- Prozent

- Personalities

- Perspektive

- Perspektiven

- Plato

- Datenintelligenz von Plato

- PlatoData

- plausibel

- Points

- Politik durchzulesen

- politisch

- Beliebt

- Populationen

- BLOG-POSTS

- möglicherweise

- größte treibende

- Sonde

- prominent

- aussichtsreich

- Beweis

- bietet

- Stellvertreter

- Psychologie

- Öffentlichkeit

- Verfolgung

- Qualität

- Frage

- Fragen

- Angebot

- schnell

- lieber

- erreichen

- realen Welt

- wirklich

- kürzlich

- kürzlich

- Redesign

- Regime

- regional

- Beziehungen

- freigegeben

- verlassen

- bleibt bestehen

- entfernt

- ersetzt

- Reproduzierbarkeit

- repliziert

- vertreten

- Reproduktion

- Forschungsprojekte

- Antwort

- Antworten

- was zu

- rund

- Führen Sie

- Said

- gleich

- Szenarien

- Schulen

- Wissenschaft

- WISSENSCHAFTEN

- wissenschaftlich

- Wissenschaftler

- Gefühl

- kompensieren

- mehrere

- schwer

- erklären

- ähnlich

- einfach

- Umstände

- schlafen

- Social Media

- Social Media

- Social Media Beiträge

- gesellschaftlich

- etwas

- anspruchsvoll

- Geschwindigkeit

- Sterne

- beginnt

- Schritt

- Stärken

- streben

- Es wurden Studien

- Studie

- Studieren

- Stolper

- so

- Support

- synthetisch

- Systeme und Techniken

- angehen

- Zylinderkopfschrauben

- Team

- Tech

- Test

- Tests

- als

- Vielen Dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- dann

- theoretisch

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- obwohl?

- dachte

- Tausende

- Durch

- müde

- zu

- Werkzeug

- Werkzeuge

- Themen

- gegenüber

- traditionell

- Training

- trainiert

- Ausbildung

- Transparenz

- reisen

- beunruhigend

- wirklich

- WENDE

- Regenschirm

- aufdecken

- für

- verstehen

- Verständnis

- Universität

- beispiellos

- -

- verwendet

- Verwendung von

- validiert

- Wert

- Werte

- Vielfalt

- riesig

- sehr

- geprüft

- Video

- Videospiele

- Besuche

- Freiwillige

- Krieg

- Wege

- we

- Wetter

- willkommen

- GUT

- Was

- wann

- welche

- WHO

- warum

- breit

- Große Auswahl

- breiter

- Wikipedia

- werden wir

- mit

- ohne

- Worte

- Arbeiten

- Werk

- Sorgen

- geschrieben

- ja

- noch

- Du

- Youtube

- Zeitgeist

- Zephyrnet