Amazon SageMaker Data Wrangler reduziert die Zeit, die zum Sammeln und Vorbereiten von Daten für maschinelles Lernen (ML) benötigt wird, von Wochen auf Minuten Amazon SageMaker-Studio, die erste vollständig integrierte Entwicklungsumgebung (IDE) für ML. Mit Data Wrangler können Sie den Prozess der Datenvorbereitung und des Feature-Engineering vereinfachen und jeden Schritt des Datenvorbereitungs-Workflows, einschließlich Datenauswahl, -bereinigung, -exploration und -visualisierung, über eine einzige visuelle Oberfläche abschließen. Sie können Daten aus mehreren Datenquellen importieren, z Amazon Simple Storage-Service (Amazon S3), Amazon RedShift, Schneeflocke und 26 föderierte Abfragedatenquellen unterstützt durch Amazonas Athena.

Ab heute können Sie beim Importieren von Daten aus Athena-Datenquellen den S3-Abfrageausgabeort und den Datenaufbewahrungszeitraum konfigurieren, um Daten in Data Wrangler zu importieren, um zu steuern, wo und wie lange Athena die Zwischendaten speichert. In diesem Beitrag führen wir Sie durch diese neue Funktion.

Lösungsüberblick

Athena ist ein interaktiver Abfragedienst, der das Durchsuchen von erleichtert AWS-Kleber Data Catalog und analysieren Sie Daten in Amazon S3 und 26 föderierte Abfragedatenquellen mit Standard-SQL. Wenn Sie Athena zum Importieren von Daten verwenden, können Sie den standardmäßigen S3-Speicherort von Data Wrangler für die Athena-Abfrageausgabe verwenden oder eine Athena-Arbeitsgruppe angeben, um einen benutzerdefinierten S3-Speicherort zu erzwingen. Bisher mussten Sie Bereinigungsworkflows implementieren, um diese Zwischendaten zu entfernen, oder die S3-Lebenszykluskonfiguration manuell einrichten, um die Speicherkosten zu kontrollieren und die Datensicherheitsanforderungen Ihres Unternehmens zu erfüllen. Dies ist ein großer Betriebsaufwand und nicht skalierbar.

Data Wrangler unterstützt jetzt benutzerdefinierte S3-Speicherorte und Datenaufbewahrungszeiträume für Ihre Athena-Abfrageausgabe. Mit dieser neuen Funktion können Sie den Ausgabeort der Athena-Abfrage in einen benutzerdefinierten S3-Bucket ändern. Sie haben jetzt eine standardmäßige Datenaufbewahrungsrichtlinie von 5 Tagen für die Athena-Abfrageausgabe, und Sie können diese ändern, um die Datensicherheitsanforderungen Ihrer Organisation zu erfüllen. Basierend auf dem Aufbewahrungszeitraum wird die Athena-Abfrageausgabe im S3-Bucket automatisch bereinigt. Nachdem Sie die Daten importiert haben, können Sie an diesem Datensatz eine explorative Datenanalyse durchführen und die bereinigten Daten wieder in Amazon S3 speichern.

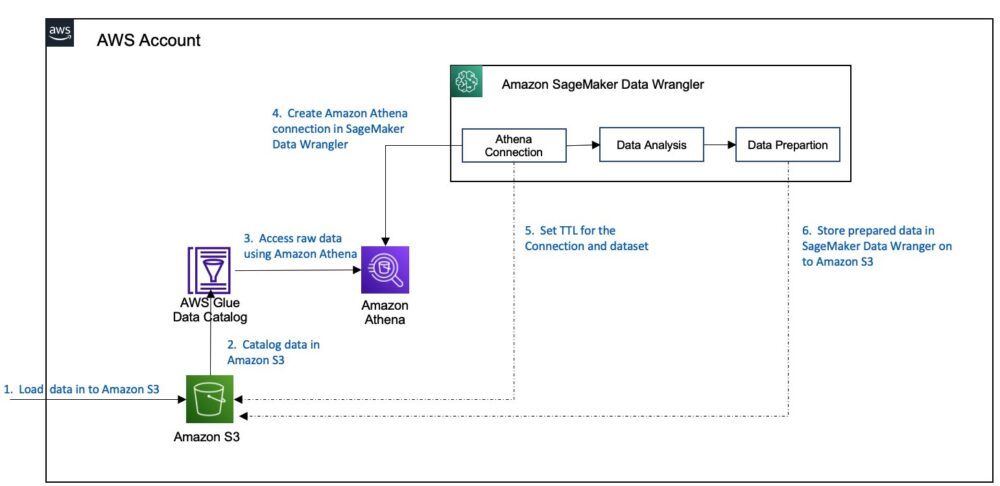

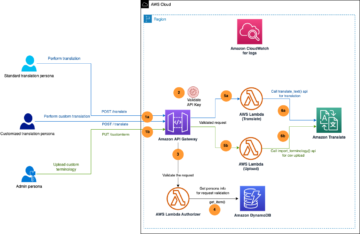

Das folgende Diagramm veranschaulicht diese Architektur.

Für unseren Anwendungsfall verwenden wir einen beispielhaften Bankdatensatz, um die Lösung durchzugehen. Der Arbeitsablauf besteht aus den folgenden Schritten:

- Laden Sie die Beispieldatensatz und laden Sie es in einen S3-Bucket hoch.

- Richten Sie einen AWS Glue ein Crawler um das Schema zu crawlen und das Metadatenschema im AWS Glue-Datenkatalog zu speichern.

- Verwenden Sie Athena für den Zugriff auf den Datenkatalog, um Daten aus dem S3-Bucket abzufragen.

- Erstellen Sie einen neuen Data Wrangler-Fluss, um eine Verbindung mit Athena herzustellen.

- Legen Sie beim Erstellen der Verbindung die Aufbewahrungs-TTL für das Dataset fest.

- Verwenden Sie diese Verbindung im Workflow und speichern Sie die sauberen Daten in einem anderen S3-Bucket.

Der Einfachheit halber gehen wir davon aus, dass Sie die Athena-Umgebung bereits eingerichtet haben (Schritte 1–3). Die weiteren Schritte erläutern wir in diesem Beitrag.

Voraussetzungen:

Informationen zum Einrichten der Athena-Umgebung finden Sie unter User Guide Schritt-für-Schritt-Anleitungen und führen Sie die Schritte 1–3 aus, wie im vorherigen Abschnitt beschrieben.

Importieren Sie Ihre Daten aus Athena in Data Wrangler

Führen Sie die folgenden Schritte aus, um Ihre Daten zu importieren:

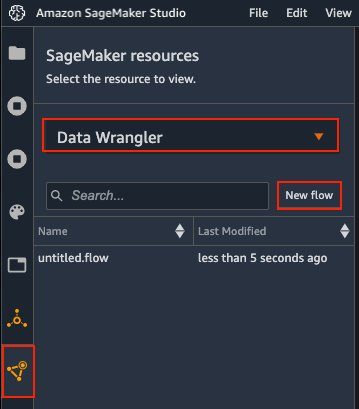

- Wählen Sie in der Studio-Konsole die Downloads Symbol im Navigationsbereich.

- Auswählen Daten-Wrangler im Dropdown-Menü.

- Auswählen

Neuer Fluss.

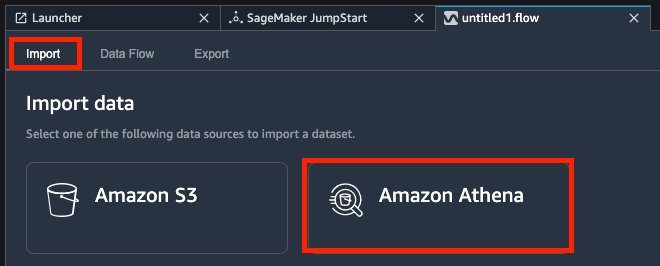

- Auf dem Import Tab, wählen Sie Amazonas Athena.

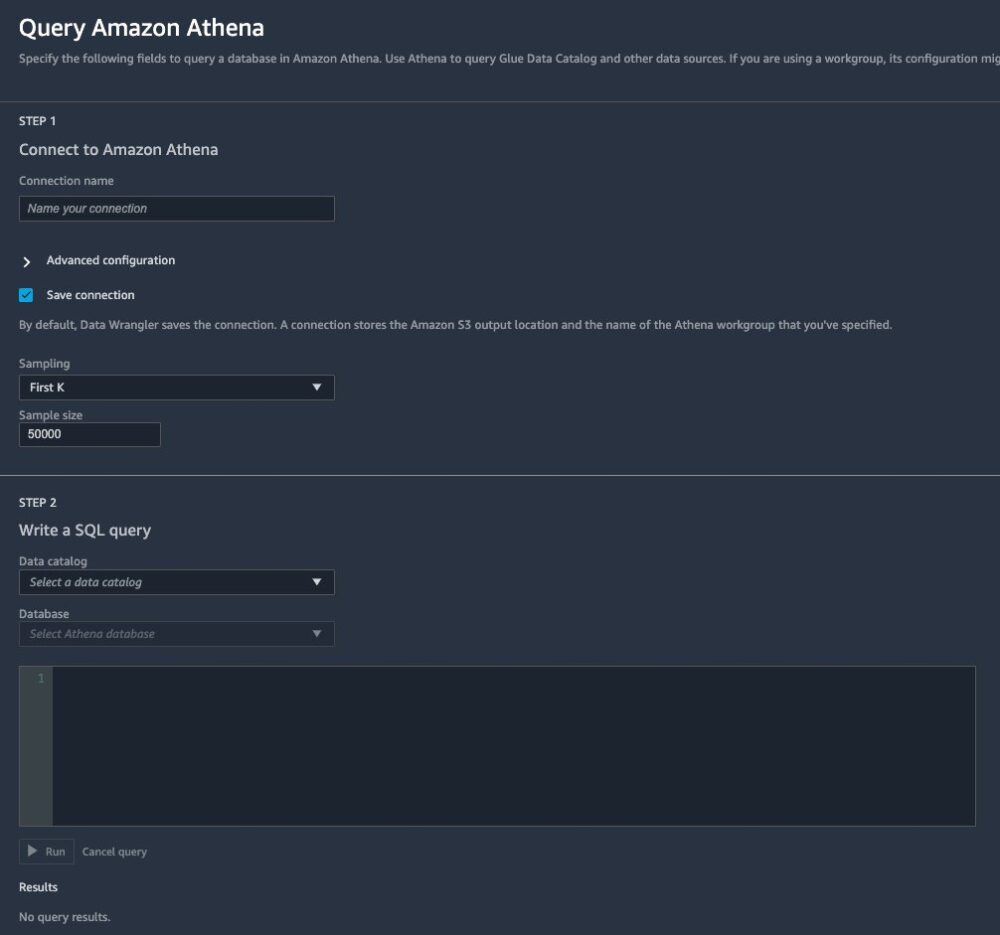

Eine Detailseite wird geöffnet, auf der Sie eine Verbindung zu Athena herstellen und eine SQL-Abfrage zum Importieren aus der Datenbank schreiben können. - Geben Sie einen Namen für Ihre Verbindung ein.

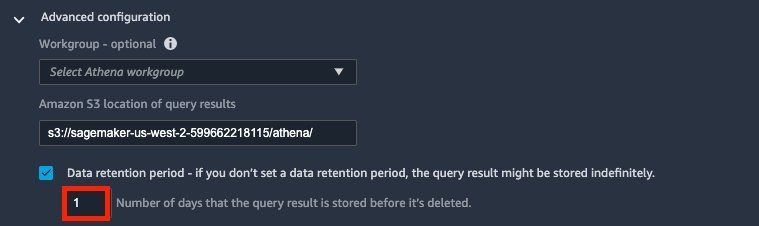

- Erweitern Sie die Funktionalität der Erweiterte Konfiguration.

Bei der Verbindung mit Athena verwendet Data Wrangler Amazon S3, um die abgefragten Daten bereitzustellen. Standardmäßig werden diese Daten am S3-Standort bereitgestellts3://sagemaker-{region}-{account_id}/athena/mit einer Aufbewahrungsfrist von 5 Tagen. - Aussichten für Amazon S3-Speicherort der Abfrageergebnisse, geben Sie Ihren S3-Standort ein.

- Auswählen Dauer der Datenaufbewahrung und legen Sie die Datenaufbewahrungsfrist fest (für diesen Beitrag 1 Tag).

Wenn Sie diese Option deaktivieren, bleiben die Daten unbegrenzt erhalten. Hinter den Kulissen hängt Data Wrangler eine S3-Lebenszyklus-Konfigurationsrichtlinie an diesen S3-Speicherort an, um automatisch zu bereinigen. Siehe folgende Beispielrichtlinie:

Hinter den Kulissen hängt Data Wrangler eine S3-Lebenszyklus-Konfigurationsrichtlinie an diesen S3-Speicherort an, um automatisch zu bereinigen. Siehe folgende Beispielrichtlinie:

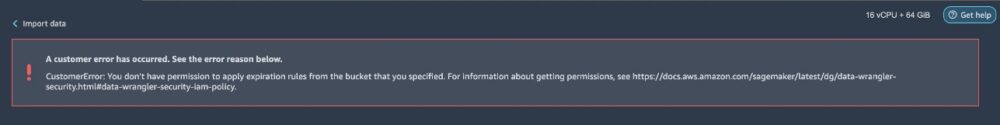

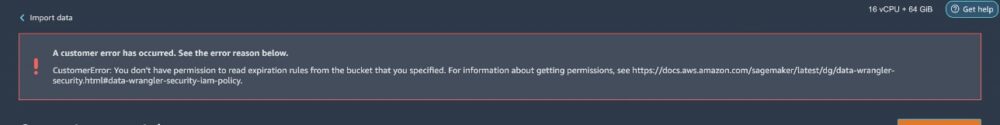

Du brauchst

s3:GetLifecycleConfigurationunds3:PutLifecycleConfigurationdamit Ihre SageMaker-Ausführungsrolle die Lebenszyklus-Konfigurationsrichtlinien korrekt anwendet. Ohne diese Berechtigungen erhalten Sie Fehlermeldungen, wenn Sie versuchen, die Daten zu importieren.Die folgende Fehlermeldung ist ein Beispiel für das Fehlen der

GetLifecycleConfigurationErlaubnis.

Die folgende Fehlermeldung ist ein Beispiel für das Fehlen der

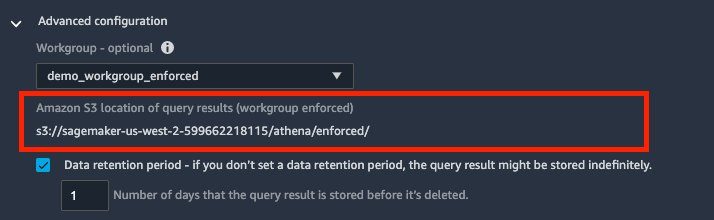

PutLifecycleConfigurationErlaubnis. - Optional für Arbeitsgruppen, können Sie eine Athena-Arbeitsgruppe angeben.

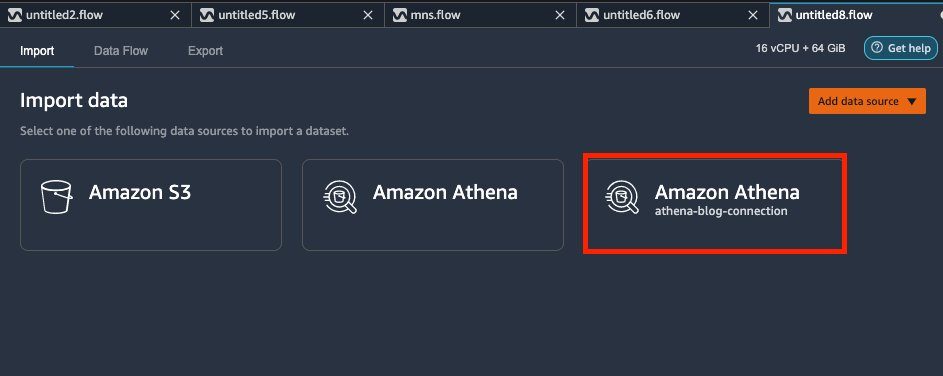

Eine Athena-Arbeitsgruppe isoliert Benutzer, Teams, Anwendungen oder Arbeitslasten in Gruppen, jede mit ihren eigenen Berechtigungen und Konfigurationseinstellungen. Wenn Sie eine Arbeitsgruppe angeben, übernimmt Data Wrangler die in Athena definierte Arbeitsgruppeneinstellung. Wenn beispielsweise für eine Arbeitsgruppe ein S3-Speicherort zum Speichern von Abfrageergebnissen und Aktivierungen definiert ist Clientseite überschreiben In den Einstellungen können Sie den Speicherort der S3-Abfrageergebnisse nicht bearbeiten. Standardmäßig speichert Data Wrangler auch die Athena-Verbindung für Sie. Dies wird als neues Athena-Kachel im angezeigt Import Tab. Sie können diese Verbindung jederzeit erneut öffnen, um andere Daten abzufragen und in Data Wrangler zu bringen.

Standardmäßig speichert Data Wrangler auch die Athena-Verbindung für Sie. Dies wird als neues Athena-Kachel im angezeigt Import Tab. Sie können diese Verbindung jederzeit erneut öffnen, um andere Daten abzufragen und in Data Wrangler zu bringen.

- Deaktivieren Verbindung speichern wenn Sie die Verbindung nicht speichern möchten.

- Um die Athena-Verbindung zu konfigurieren, wählen Sie Andere für Probennahme um den gesamten Datensatz zu importieren.

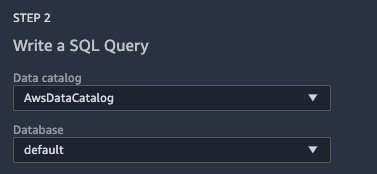

Bei großen Datasets können Sie mit Data Wrangler eine Teilmenge Ihrer Daten importieren, um Ihren Transformationsworkflow aufzubauen, und das gesamte Dataset nur verarbeiten, wenn Sie bereit sind. Dies beschleunigt den Iterationszyklus und spart Verarbeitungszeit und Kosten. Um mehr über die verschiedenen verfügbaren Datenerfassungsoptionen zu erfahren, besuchen Sie Amazon SageMaker Data Wrangler unterstützt jetzt Zufallsstichproben und geschichtete Stichproben. - Aussichten für Datenkatalogwählen AWSDataKatalog.

- Aussichten für Datenbase, wählen Sie Ihre Datenbank aus.

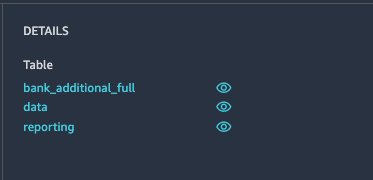

Data Wrangler zeigt die verfügbaren Tabellen an. Sie können jede Tabelle auswählen, um das Schema zu überprüfen und eine Vorschau der Daten anzuzeigen.

- Geben Sie im Abfragefeld folgenden Code ein:

- Auswählen Führen Sie um eine Vorschau der Daten anzuzeigen.

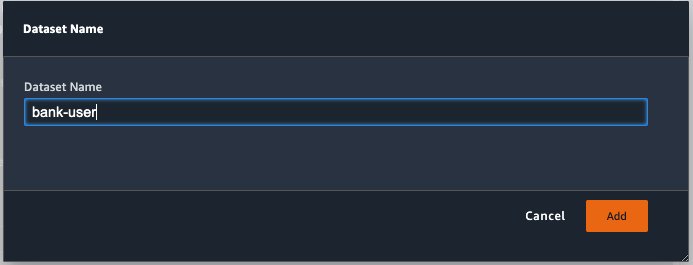

- Wenn alles gut aussieht, wählen Sie Import.

- Geben Sie einen Datensatznamen ein und wählen Sie aus Speichern um die Daten in Ihren Data Wrangler-Arbeitsbereich zu importieren.

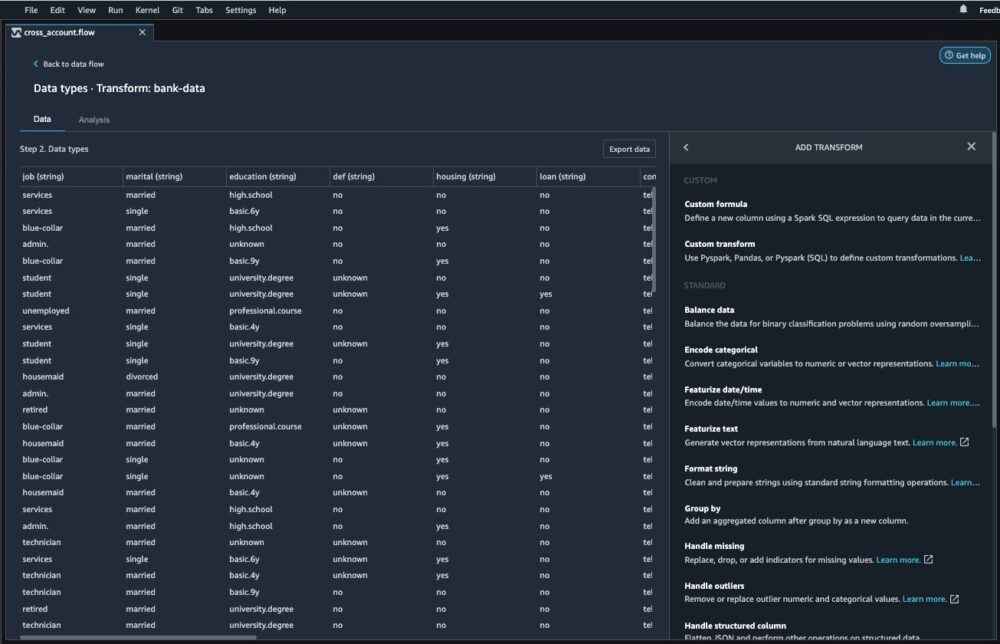

Analysieren und verarbeiten Sie Daten mit Data Wrangler

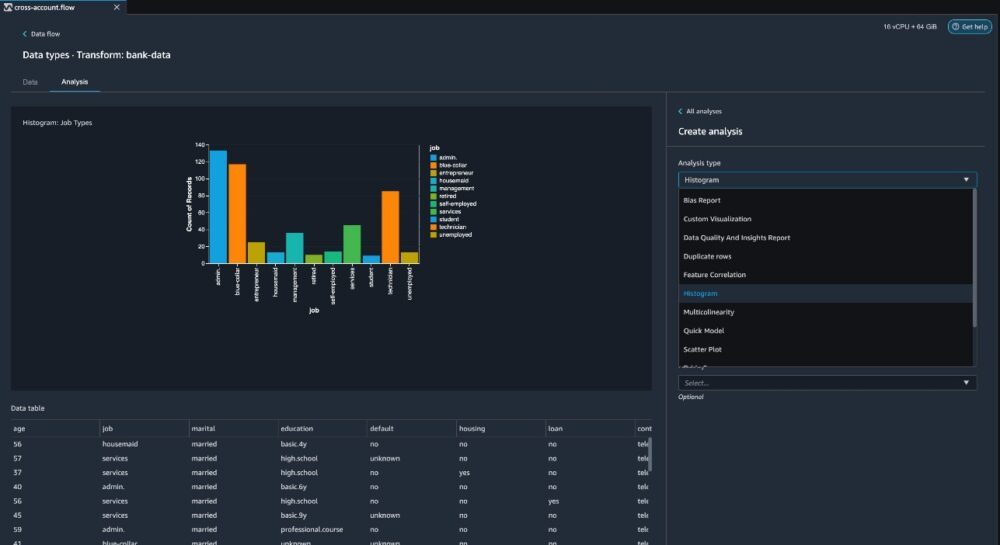

Nachdem Sie die Daten in Data Wrangler geladen haben, können Sie eine explorative Datenanalyse (EDA) durchführen und die Daten für maschinelles Lernen vorbereiten.

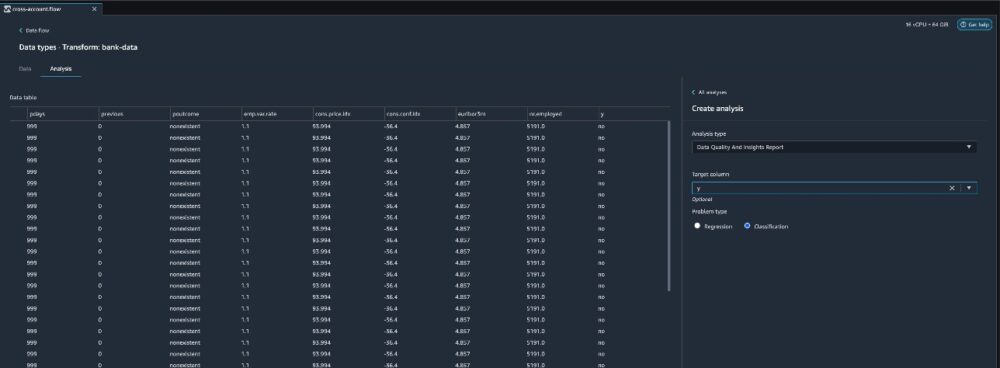

- Wählen Sie das Pluszeichen neben dem

bank-dataDatensatz im Datenfluss und wählen Sie Analyse hinzufügen.

Data Wrangler bietet integrierte Analysen, darunter einen Datenqualitäts- und Erkenntnisbericht, Datenkorrelation, einen Bias-Bericht vor dem Training, eine Zusammenfassung Ihres Datensatzes und Visualisierungen (z. B. Histogramme und Streudiagramme). Darüber hinaus können Sie Ihre eigene benutzerdefinierte Visualisierung erstellen.

- Aussichten für Analysetypwählen Datenqualitäts- und Insight-Bericht.

Dadurch werden automatisch Visualisierungen, Analysen zur Identifizierung von Datenqualitätsproblemen und Empfehlungen für die richtigen Transformationen generiert, die für Ihren Datensatz erforderlich sind. - Aussichten für Zielspalte, wählen Y.

- Da es sich hierbei um eine Klassifikationsproblematik handelt, z ProblemtypWählen Klassifikation.

- Auswählen

Erstellen.

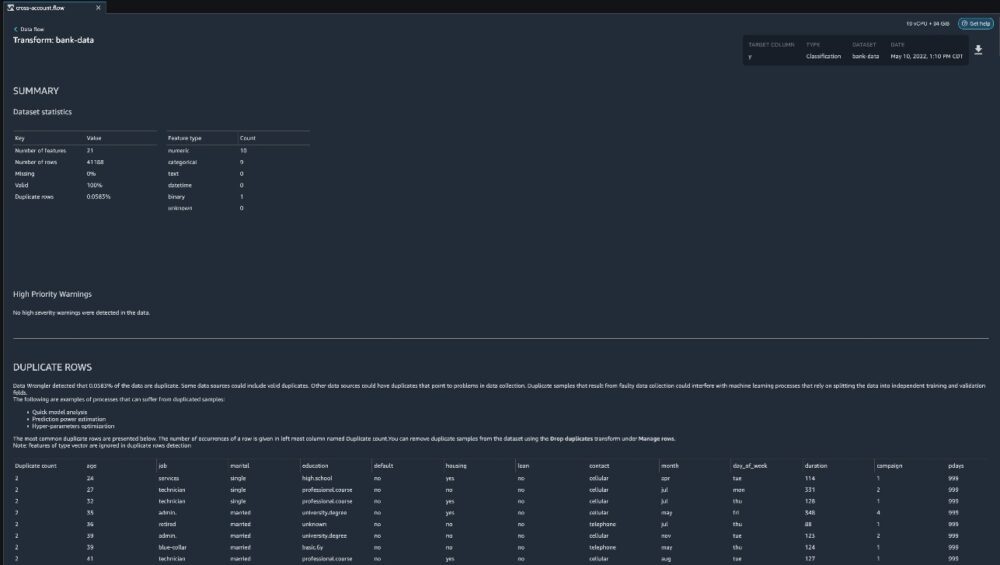

Data Wrangler erstellt einen detaillierten Bericht zu Ihrem Datensatz. Sie können den Bericht auch auf Ihren lokalen Computer herunterladen.

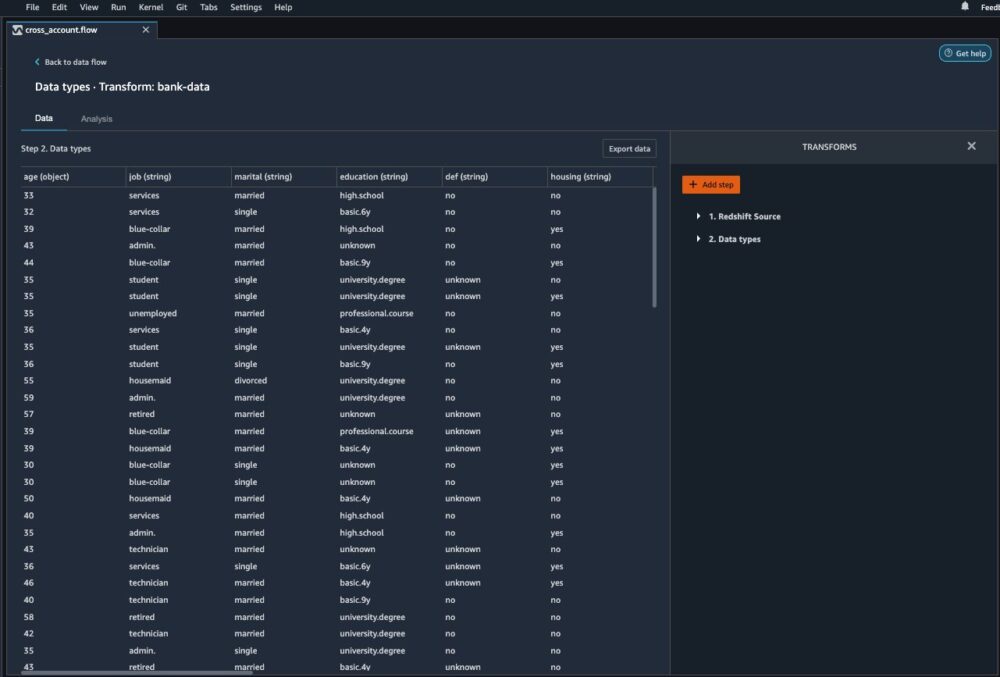

- Wählen Sie für die Datenaufbereitung im Datenfluss das Pluszeichen neben dem Bankdaten-Datensatz und wählen Sie Transformation hinzufügen.

- Auswählen

Schritt hinzufügen um mit dem Aufbau Ihrer Transformationen zu beginnen.

Zum Zeitpunkt der Erstellung dieses Artikels bietet Data Wrangler über 300 integrierte Transformationen. Sie können auch Ihre eigenen Transformationen mit Pandas oder PySpark schreiben.

Sie können jetzt damit beginnen, Ihre Transformationen und Analysen basierend auf Ihren Geschäftsanforderungen zu erstellen.

Aufräumen

Um laufende Kosten zu vermeiden, löschen Sie die Data Wrangler-Ressourcen mit den folgenden Schritten, wenn Sie fertig sind.

- Wählen Sie das Symbol Laufende Instanzen und Kernel aus.

- Klicken Sie unter AUSGEFÜHRTE APPS auf das Symbol zum Herunterfahren neben

sagemaker-data-wrangler-1.0 app. - Wählen Sie zur Bestätigung Alle herunterfahren.

Zusammenfassung

In diesem Beitrag haben wir einen Überblick über die Anpassung Ihres S3-Standorts und die Aktivierung von S3-Lebenszykluskonfigurationen für den Import von Daten aus Athena in Data Wrangler gegeben. Mit dieser Funktion können Sie Zwischendaten an einem sicheren S3-Speicherort speichern und die Datenkopie nach Ablauf der Aufbewahrungsfrist automatisch entfernen, um das Risiko eines unbefugten Zugriffs auf Daten zu verringern. Wir empfehlen Ihnen, diese neue Funktion auszuprobieren. Frohes Bauen!

Um mehr über Athena und SageMaker zu erfahren, besuchen Sie die Athena-Benutzerhandbuch und Amazon SageMaker-Dokumentation.

Über die Autoren

Meenakshisundaram Thandavarayan ist Senior AI/ML-Spezialist bei AWS. Er hilft strategischen High-Tech-Accounts auf ihrer KI- und ML-Reise. Er interessiert sich sehr für datengetriebene KI.

Meenakshisundaram Thandavarayan ist Senior AI/ML-Spezialist bei AWS. Er hilft strategischen High-Tech-Accounts auf ihrer KI- und ML-Reise. Er interessiert sich sehr für datengetriebene KI.

Harish Rajagopalan ist Senior Solutions Architect bei Amazon Web Services. Harish arbeitet mit Unternehmenskunden zusammen und hilft ihnen bei ihrer Cloud-Reise.

Harish Rajagopalan ist Senior Solutions Architect bei Amazon Web Services. Harish arbeitet mit Unternehmenskunden zusammen und hilft ihnen bei ihrer Cloud-Reise.

James Wu ist Senior AI/ML Specialist Solution Architect bei AWS. Unterstützung von Kunden bei der Entwicklung und Erstellung von KI/ML-Lösungen. Die Arbeit von James deckt ein breites Spektrum von ML-Anwendungsfällen ab, wobei sein Hauptinteresse auf Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen liegt. Bevor er zu AWS kam, war James über 10 Jahre lang Architekt, Entwickler und Technologieführer, davon 6 Jahre im Ingenieurwesen und 4 Jahre in der Marketing- und Werbebranche.

James Wu ist Senior AI/ML Specialist Solution Architect bei AWS. Unterstützung von Kunden bei der Entwicklung und Erstellung von KI/ML-Lösungen. Die Arbeit von James deckt ein breites Spektrum von ML-Anwendungsfällen ab, wobei sein Hauptinteresse auf Computer Vision, Deep Learning und der Skalierung von ML im gesamten Unternehmen liegt. Bevor er zu AWS kam, war James über 10 Jahre lang Architekt, Entwickler und Technologieführer, davon 6 Jahre im Ingenieurwesen und 4 Jahre in der Marketing- und Werbebranche.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazonas Athena

- Amazon Sage Maker

- Amazon SageMaker Data Wrangler

- Amazon einfacher Speicherdienst (S3)

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet