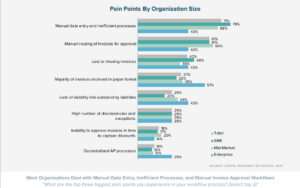

Das Extrahieren von Text aus einem Bild kann ein umständlicher Prozess sein. Die meisten Menschen geben den Text/die Daten aus dem Bild manuell ein; Dies ist jedoch sowohl zeitaufwändig als auch ineffizient, wenn Sie viele Bilder bearbeiten müssen.

Bild-zu-Text-Konverter bieten eine nette Möglichkeit, Text aus Bildern zu extrahieren.

Während solche Tools gute Arbeit leisten, werden die extrahierten Texte/Daten oft unstrukturiert dargestellt, was zu viel Nachbearbeitung führt.

An KI-gesteuerte OCR wie Nanonets können Text aus Bildern ziehen und die extrahierten Daten auf ordentliche, organisierte und strukturierte Weise präsentieren.

Nanonets extrahiert Daten aus Bildern genau, maßstabsgetreu und in mehreren Sprachen. Nanonets ist die einzige Texterkennungs-OCR, die extrahierten Text in sauber strukturierten Formaten darstellt, die vollständig anpassbar sind. Erfasste Daten können als Tabellen, Einzelposten oder in einem anderen Format dargestellt werden.

- Klicken Sie unten, um Ihr Bild hochzuladen

- Die OCR von Nanonets erkennt automatisch den Inhalt Ihrer Datei und wandelt ihn in Text um

- Laden Sie den extrahierten Text als Rohtextdatei herunter oder integrieren Sie ihn über die API

Inhaltsverzeichnis

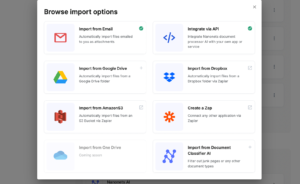

Hier sind drei fortgeschrittene Methoden, mit denen Sie Nanonets OCR verwenden können, um Text aus Bildern zu erkennen und zu extrahieren. Text aus PDF extrahierens, Daten aus PDF extrahierens oder PDFs analysieren und andere Dokumenttypen:

Benötigen Sie eine kostenlose Online-OCR für Bild zu Text, PDF in Tabelle, PDF zu Text, oder PDF-Datenextraktion? Sehen Sie sich Nanonets online an OCR-API in Aktion und beginnen Sie kostenlos mit der Erstellung benutzerdefinierter OCR-Modelle!

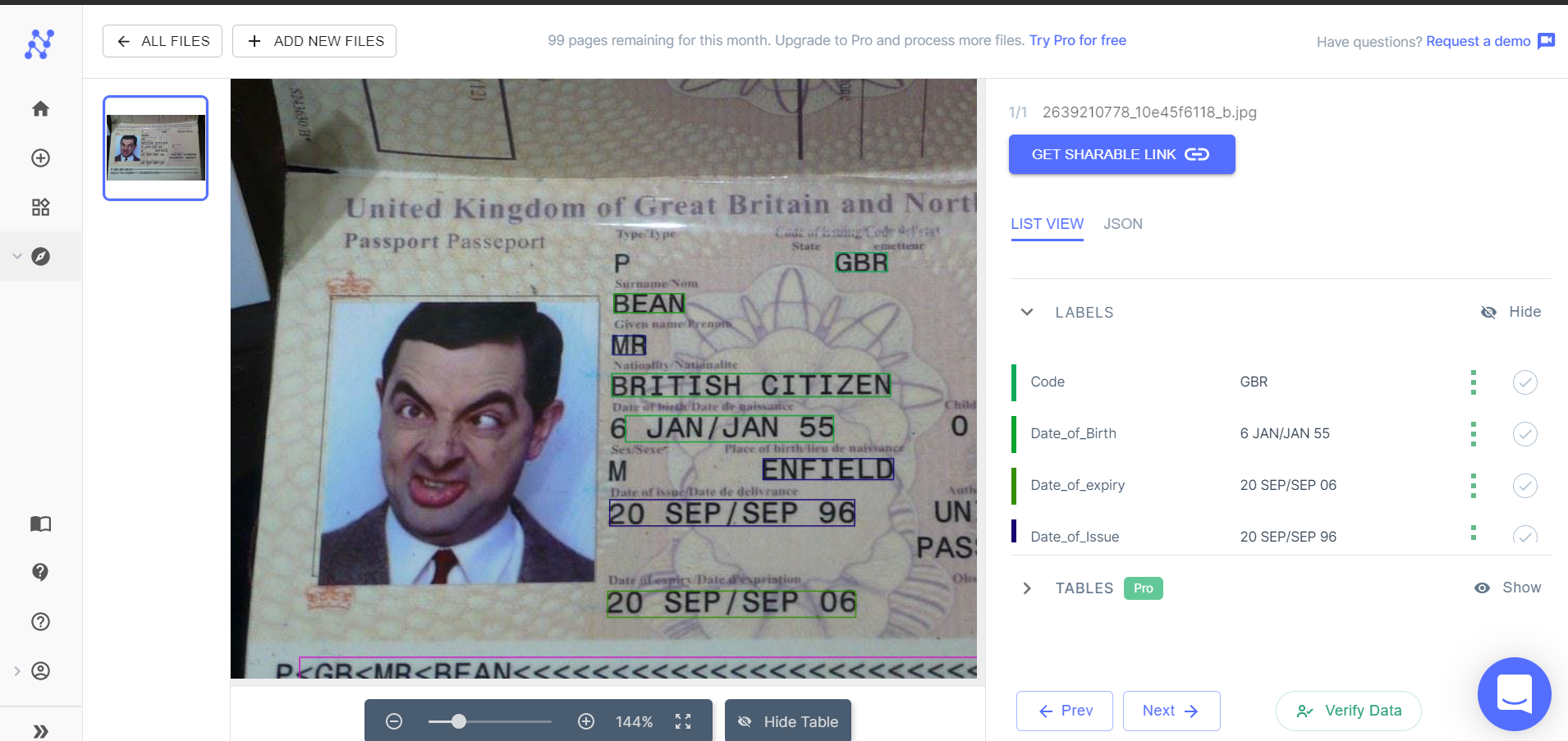

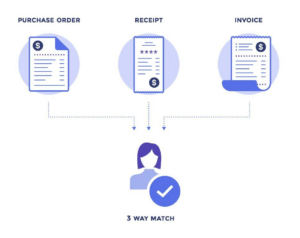

Nanonets verfügt über vortrainierte OCR-Modelle für die unten aufgeführten spezifischen Bildtypen. Jedes vortrainierte OCR-Modell ist darauf trainiert, Text im Bildtyp genau einem geeigneten Feld wie Name, Adresse, Datum, Ablaufdatum usw. zuzuordnen und den extrahierten Text ordentlich und organisiert darzustellen.

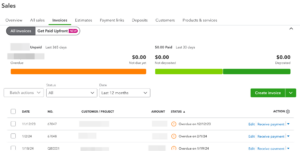

- Rechnungen

- Einkünfte

- Führerschein (USA)

- Pässe

Nanonetze Online-OCR & OCR-API habe viele interessante Anwendungsfälle.

Schritt 1: Wählen Sie ein geeignetes OCR-Modell aus

Login zu Nanonets und wählen Sie ein OCR-Modell aus, das für das Bild geeignet ist, aus dem Sie Text und Daten extrahieren möchten. Wenn keines der vortrainierten OCR-Modelle Ihren Anforderungen entspricht, können Sie weitermachen, um herauszufinden, wie Sie ein benutzerdefiniertes OCR-Modell erstellen.

Schritt 2: Dateien hinzufügen

Fügen Sie die Dateien/Bilder hinzu, aus denen Sie Text extrahieren möchten. Sie können beliebig viele Bilder hinzufügen.

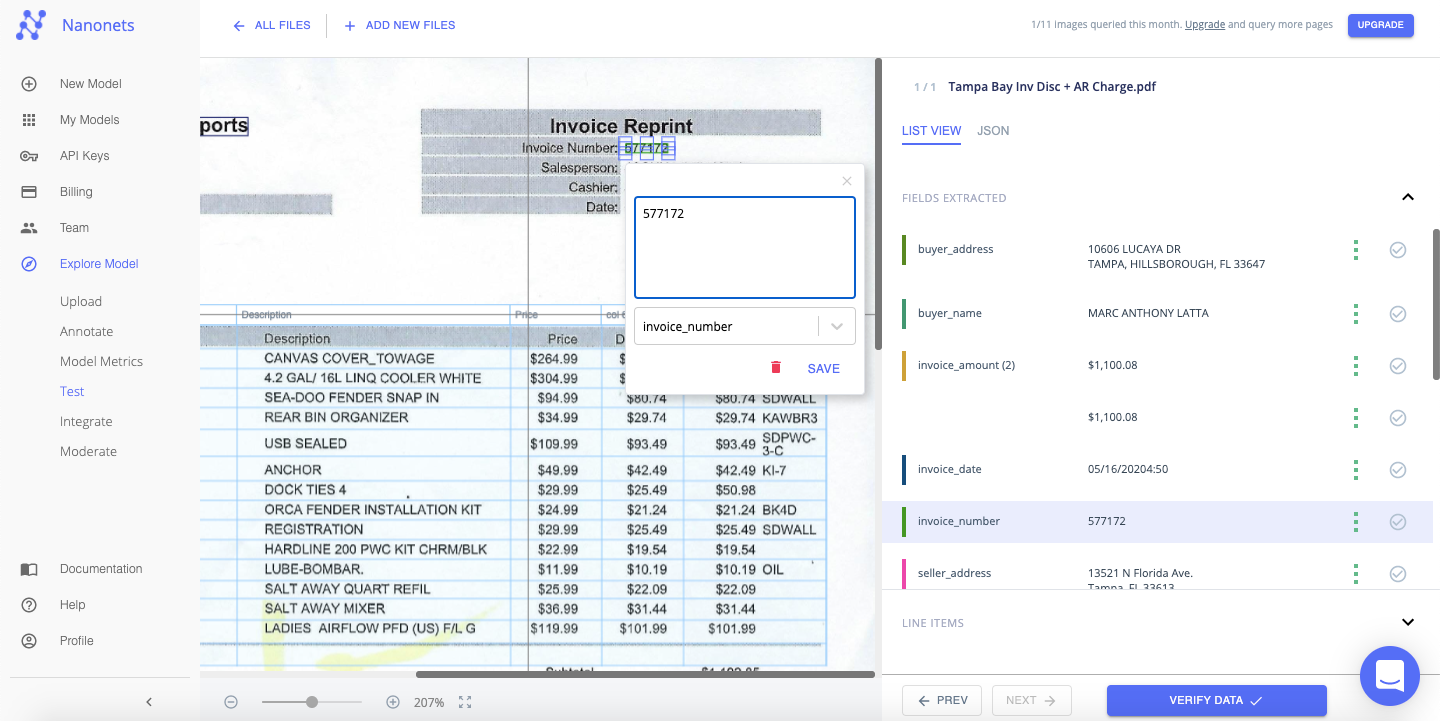

Schritt 3: Test

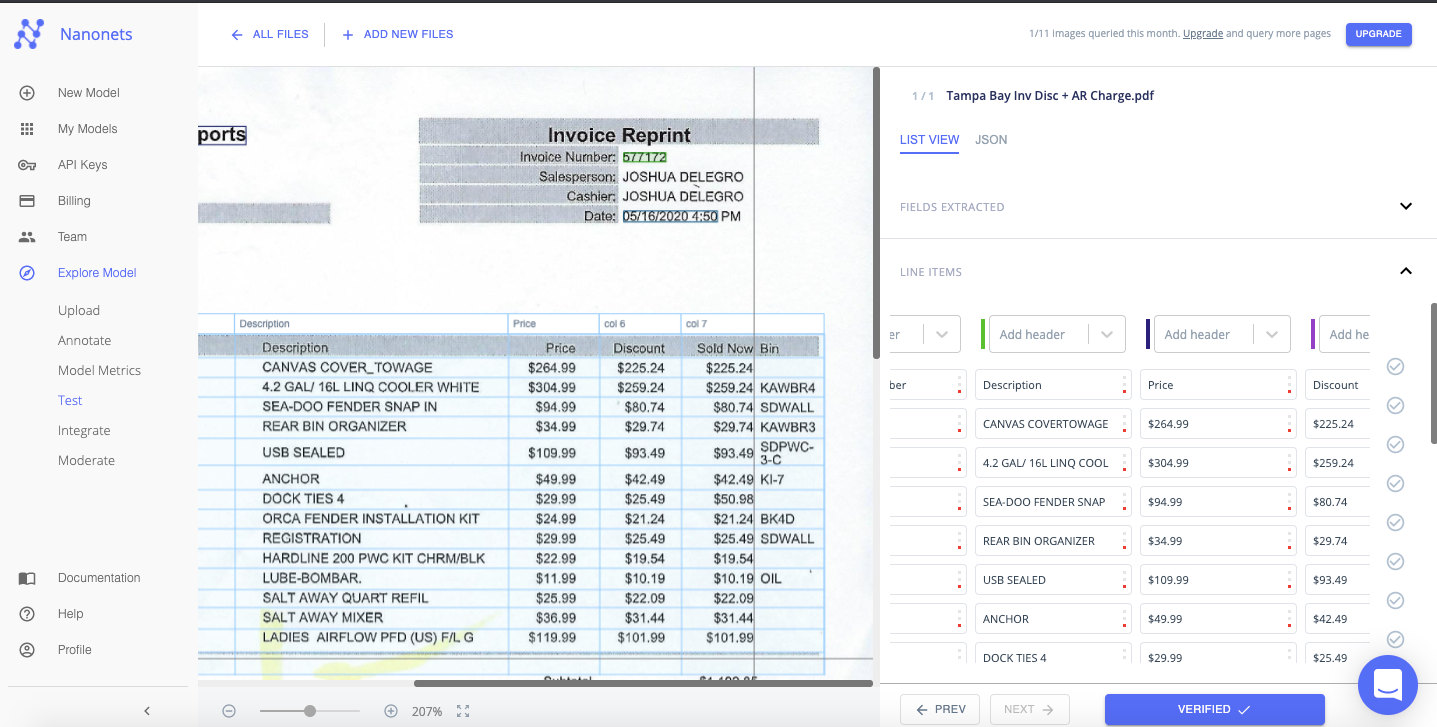

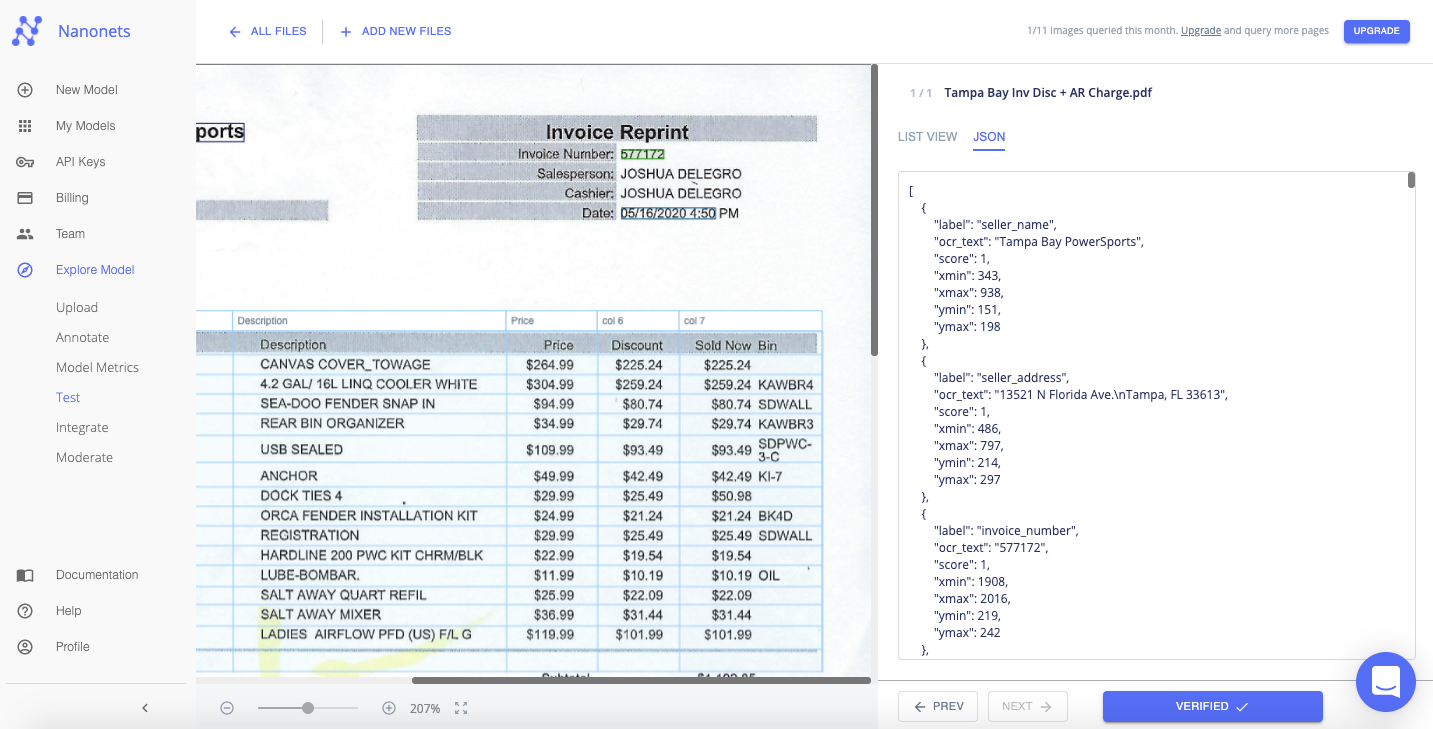

Warten Sie einige Sekunden, bis das Modell ausgeführt und Text aus dem Bild extrahiert wurde.

Schritt 4: Überprüfen

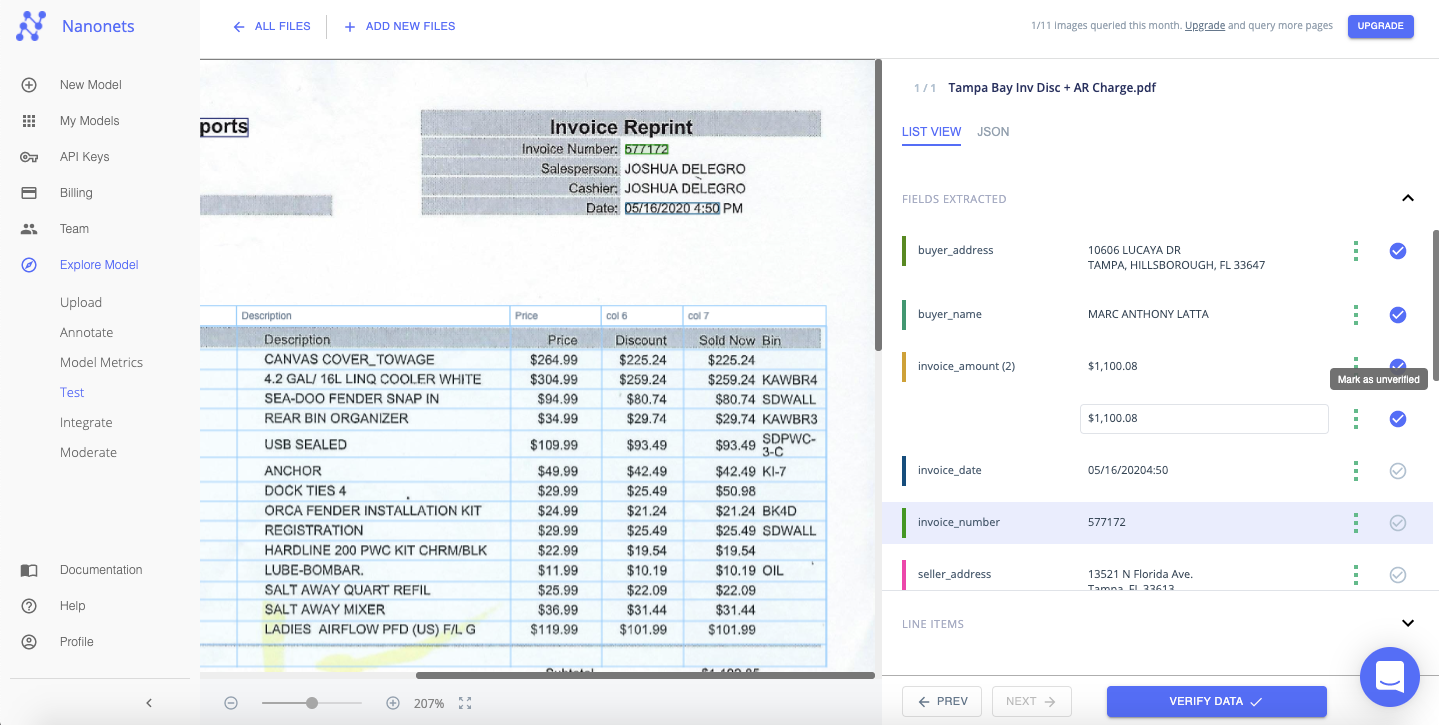

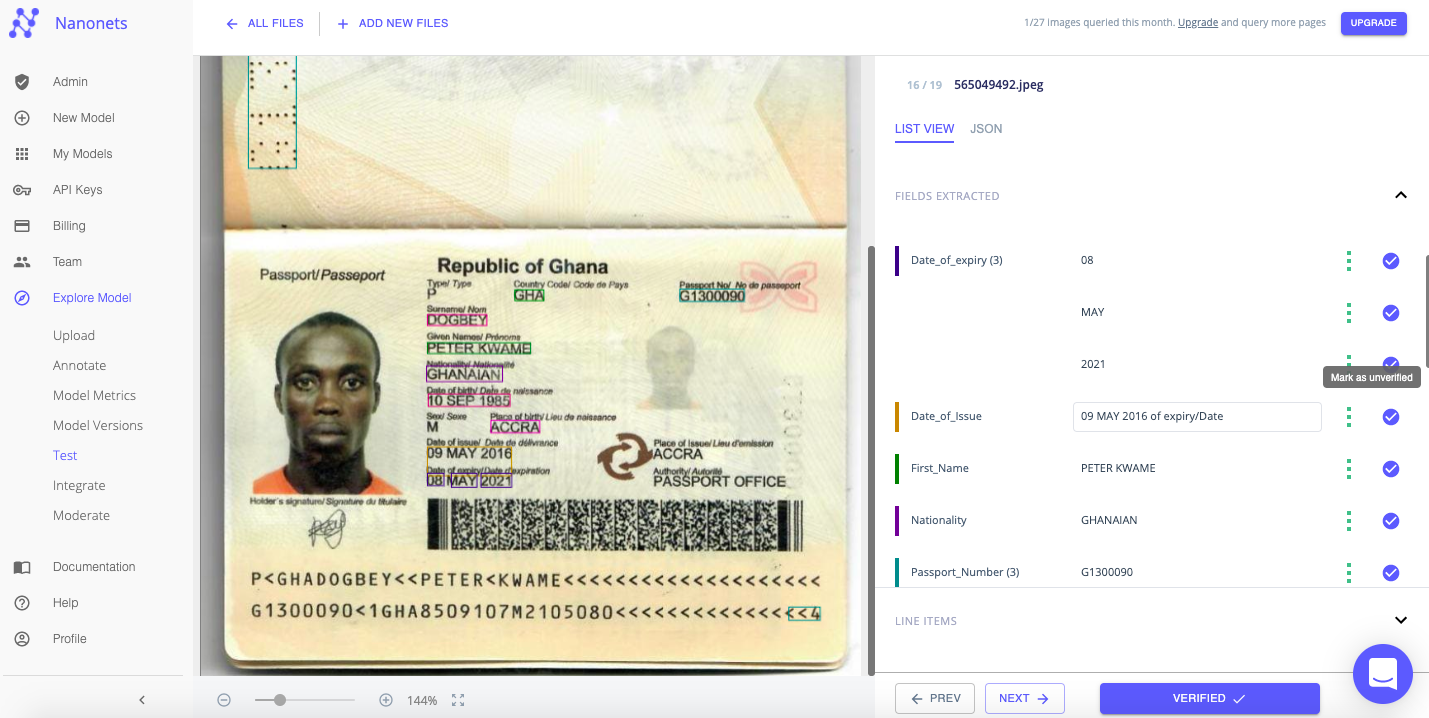

Überprüfen Sie schnell den aus jeder Datei extrahierten Text, indem Sie die Tabellenansicht auf der rechten Seite überprüfen. Sie können einfach überprüfen, ob der Text korrekt erkannt und mit einem geeigneten Feld oder Tag abgeglichen wurde.

Sie können in diesem Stadium sogar die Feldwerte und Beschriftungen bearbeiten/korrigieren. Nanonets ist nicht an die Vorlage des Bildes gebunden.

Die extrahierten Daten können im Format "Listenansicht" oder "JSON" angezeigt werden.

Sie können das Kontrollkästchen neben jedem Wert oder Feld aktivieren, das Sie überprüfen, oder auf "Daten überprüfen" klicken, um sofort fortzufahren.

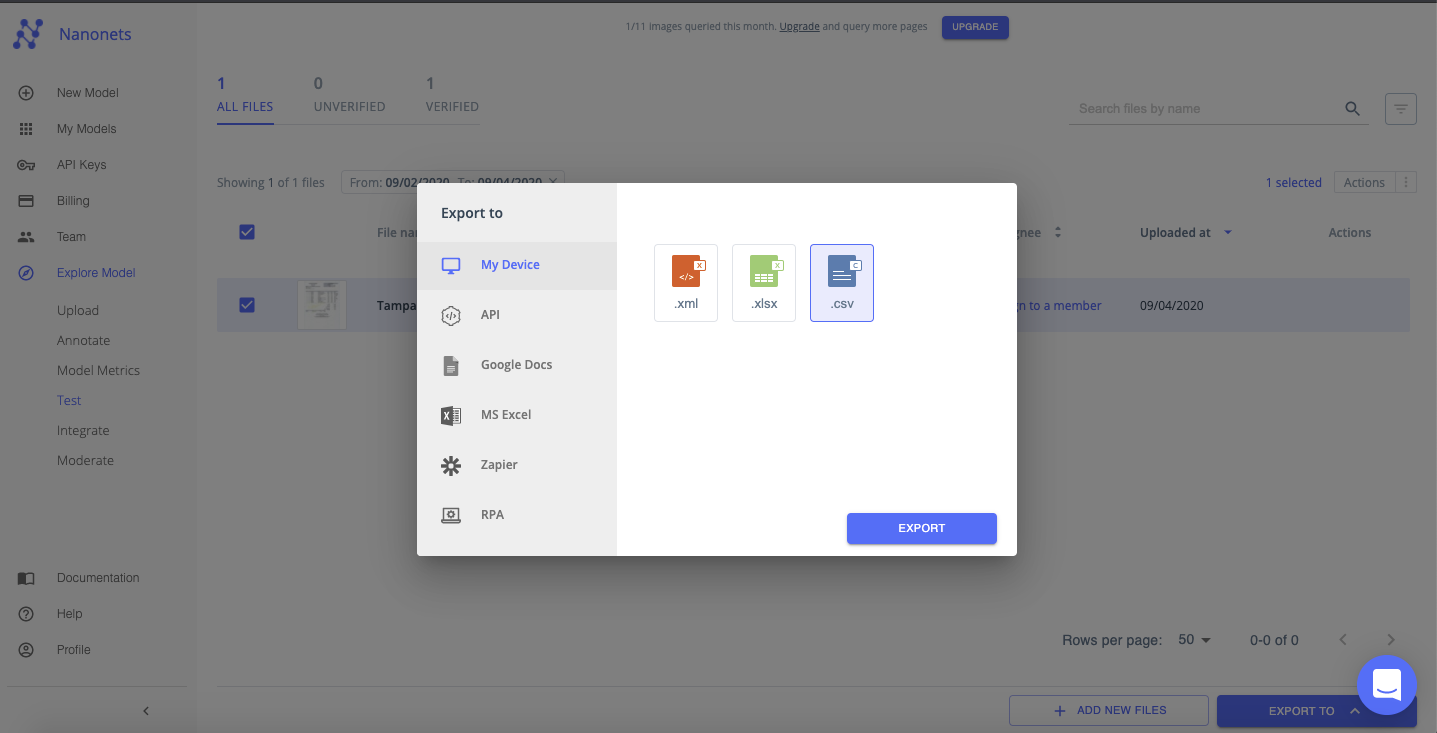

Schritt 5: Exportieren

Sobald alle Dateien überprüft wurden. Sie können die übersichtlichen Daten als XML-, XLSX- oder CSV-Datei exportieren.

Nanonets hat interessant Anwendungsfälle und einzigartig Erfolgsgeschichten von Kunden. Finden Sie heraus, wie Nanonets Ihr Unternehmen produktiver machen können.

Das Erstellen eines benutzerdefinierten OCR-Modells mit Nanonets ist einfach. In der Regel können Sie ein Modell für jeden Bild- oder Dokumenttyp in jeder Sprache in weniger als 25 Minuten erstellen, trainieren und bereitstellen (abhängig von der Anzahl der Dateien, die zum Trainieren des Modells verwendet werden).

Sehen Sie sich das Video unten an, um die ersten 4 Schritte dieser Methode zu befolgen:

Schritt 1: Erstellen Sie Ihr eigenes OCR-Modell

Login zu Nanonets und klicken Sie auf "Erstellen Sie Ihr eigenes OCR-Modell".

Schritt 2: Laden Sie Trainingsdateien / -bilder hoch

Laden Sie Beispieldateien hoch, die zum Trainieren der OCR-Modelle verwendet werden. Die Genauigkeit des von Ihnen erstellten OCR-Modells hängt weitgehend von der Qualität und Quantität der zu diesem Zeitpunkt hochgeladenen Dateien / Bilder ab

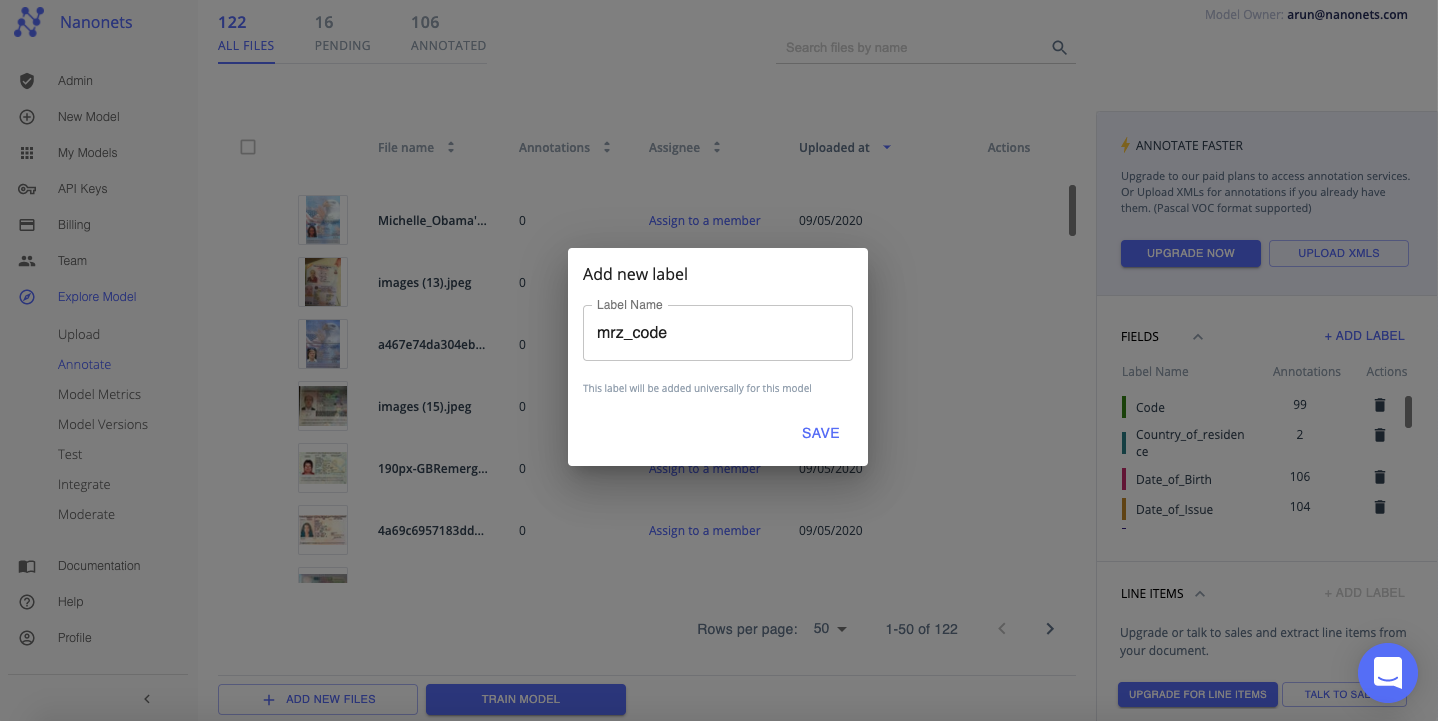

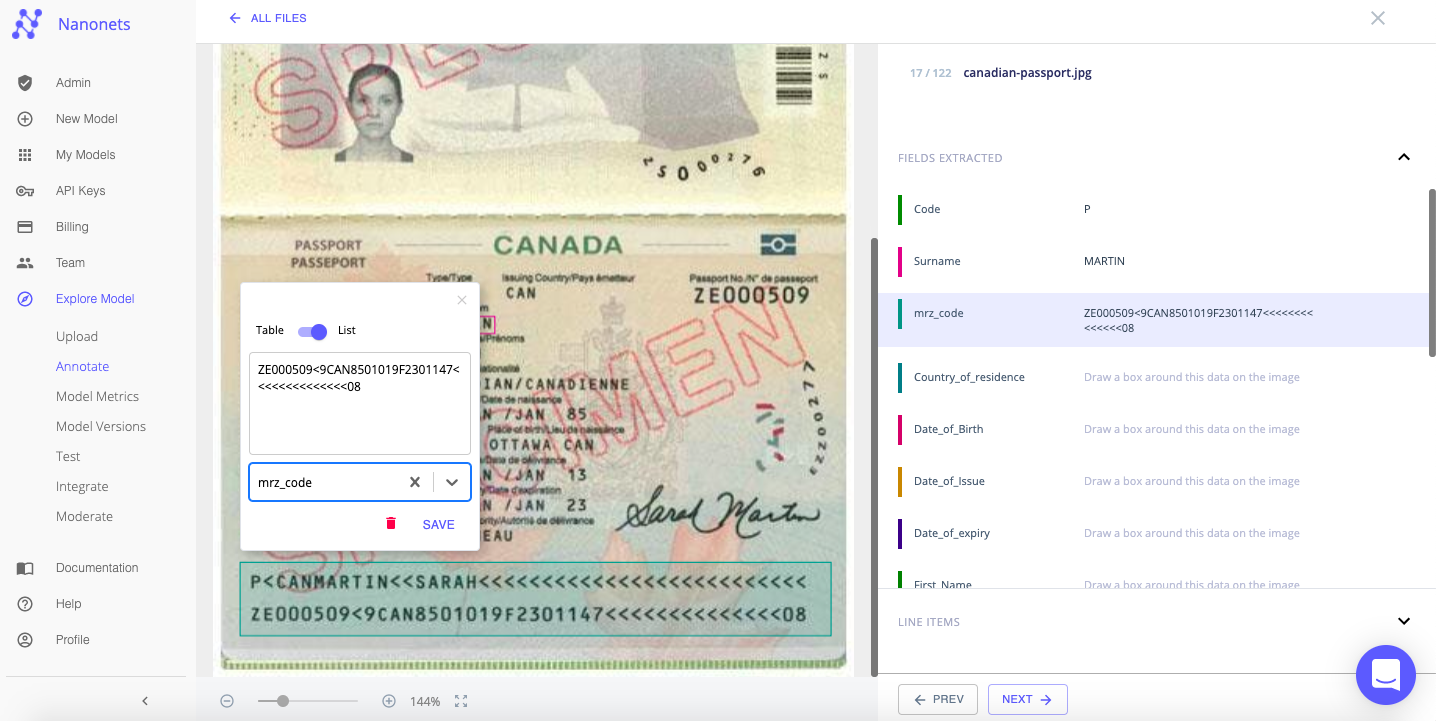

Schritt 3: Kommentieren Sie die Dateien / Bilder mit Text

Kommentieren Sie nun jeden Text oder Daten mit einem entsprechenden Feld oder einer Beschriftung. In diesem entscheidenden Schritt lernt Ihr OCR-Modell, den entsprechenden Text aus Bildern zu extrahieren und ihn benutzerdefinierten Feldern zuzuordnen, die für Ihre Anforderungen relevant sind.

Sie können auch ein neues Label hinzufügen, um den Text oder die Daten zu kommentieren. Denken Sie daran, dass Nanonets nicht an die Vorlage des Bildes gebunden ist!

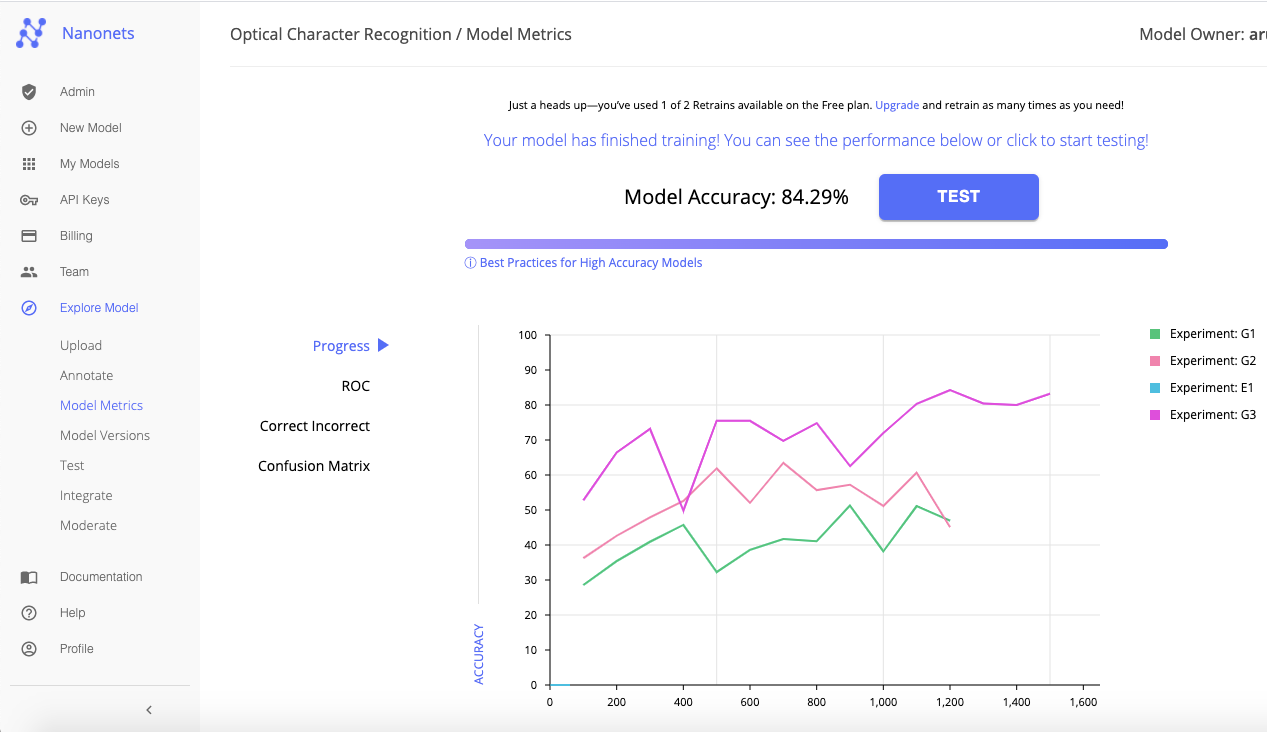

Schritt 4: Trainieren Sie das benutzerdefinierte OCR-Modell

Wenn die Annotation für alle Trainingsdateien / -bilder abgeschlossen ist, klicken Sie auf „Zugmodell“. Das Training dauert normalerweise zwischen 20 Minuten und 2 Stunden, abhängig von der Anzahl der Dateien und den Modellen für das Training in der Warteschlange. Sie können mehr Stunden zu einem bezahlten Plan, um zu diesem Zeitpunkt schnellere Ergebnisse zu erzielen (normalerweise unter 20 Minuten).

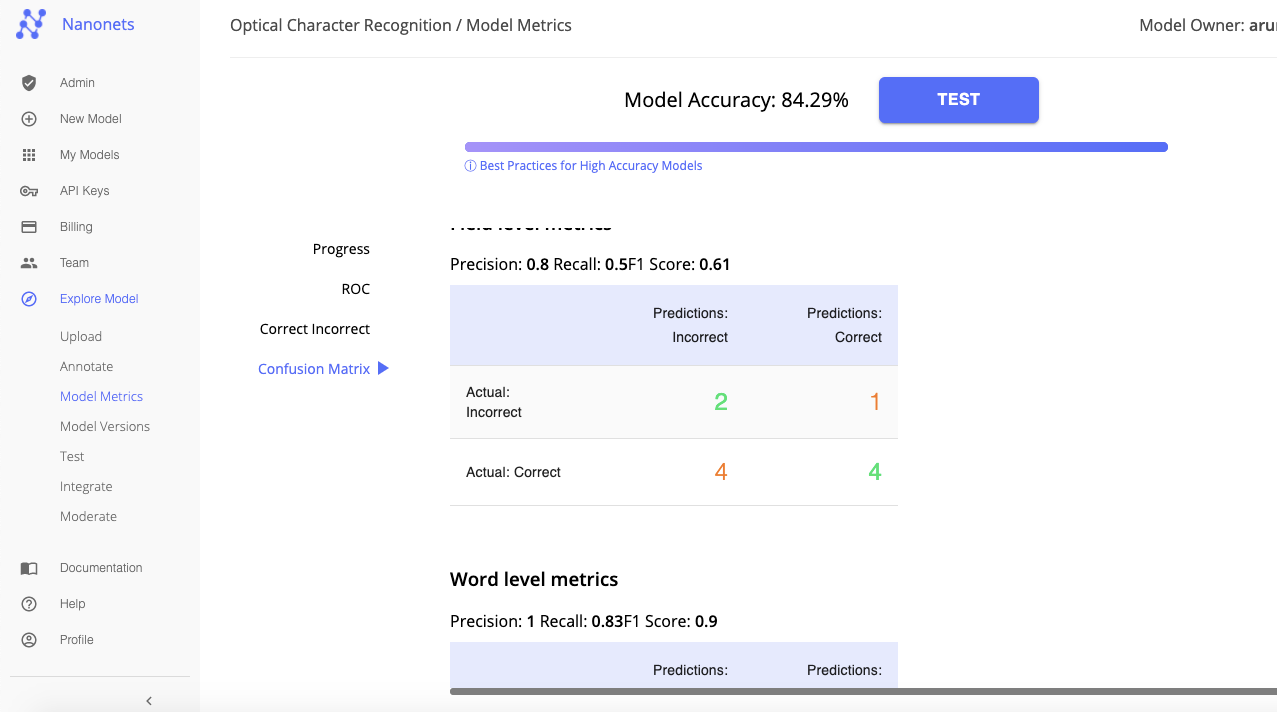

Nanonets nutzt Deep Learning, um verschiedene OCR-Modelle zu erstellen und sie gegeneinander auf Genauigkeit zu testen. Nanonets wählt dann das beste OCR-Modell aus (basierend auf Ihren Eingaben und Genauigkeitsstufen).

Auf der Registerkarte „Modellmetriken“ werden die verschiedenen Messungen und vergleichenden Analysen angezeigt, mit denen Nanonets das beste OCR-Modell unter allen erstellten auswählen konnte. Sie können das Modell neu trainieren (indem Sie eine größere Auswahl an Trainingsbildern und bessere Anmerkungen bereitstellen), um ein höheres Maß an Genauigkeit zu erzielen.

Wenn Sie mit der Genauigkeit zufrieden sind, klicken Sie auf „Test“, um zu testen und zu überprüfen, ob dieses benutzerdefinierte OCR-Modell für eine Stichprobe von Bildern oder Dateien, aus denen Text / Daten extrahiert werden müssen, wie erwartet funktioniert.

Schritt 5: Testen und überprüfen Sie die Daten

Fügen Sie einige Beispielbilder hinzu, um das benutzerdefinierte OCR-Modell zu testen und zu überprüfen.

Wenn der Text erkannt, extrahiert und angemessen dargestellt wurde, exportieren Sie die Datei. Wie Sie unten sehen können, wurden die extrahierten Daten in einem ordentlichen Format organisiert und präsentiert.

Herzlichen Glückwunsch, Sie haben jetzt ein benutzerdefiniertes OCR-Modell erstellt und trainiert, um Text aus bestimmten Bildtypen zu extrahieren!

Beschäftigt sich Ihr Unternehmen mit der Texterkennung in digitalen Dokumenten, Bildern oder PDFs? Haben Sie sich gefragt, wie Sie Text genau aus Bildern extrahieren können?

Trainieren Sie Ihre eigenen OCR-Modelle mit der NanoNets-API

Hier ist eine ausführliche Anleitung zum Trainieren Ihre eigenen OCR-Modelle mit der Nanonets-API. In dem Dokumentation, finden Sie fertige Codebeispiele in Python, Shell, Ruby, Golang, Java und C# sowie detaillierte API-Spezifikationen für verschiedene Endpunkte.

Hier ist eine Schritt-für-Schritt-Anleitung zum Trainieren Ihres eigenen Modells mit der Nanonets-API:

Schritt 1: Klonen Sie das Repo

git clone https://github.com/NanoNets/nanonets-ocr-sample-python

cd nanonets-ocr-sample-python

sudo pip install requests

sudo pip install tqdmSchritt 2: Holen Sie sich Ihren kostenlosen API-Schlüssel

Holen Sie sich Ihren kostenlosen API-Schlüssel von https://app.nanonets.com/#/keys

Schritt 3: Legen Sie den API-Schlüssel als Umgebungsvariable fest

export NANONETS_API_KEY=YOUR_API_KEY_GOES_HERE

Schritt 4: Erstellen Sie ein neues Modell

python ./code/create-model.py

Hinweis: Dadurch wird eine MODEL_ID generiert, die Sie für den nächsten Schritt benötigen

Schritt 5: Modell-ID als Umgebungsvariable hinzufügen

export NANONETS_MODEL_ID=YOUR_MODEL_ID

Schritt 6: Laden Sie die Trainingsdaten hoch

Sammeln Sie die Bilder des Objekts, das Sie erkennen möchten. Sobald Sie den Datensatz im Ordner bereit haben images (Bilddateien), starten Sie den Upload des Datensatzes.

python ./code/upload-training.py

Schritt 7: Zugmodell

Beginnen Sie nach dem Hochladen der Bilder mit dem Training des Modells

python ./code/train-model.py

Schritt 8: Modellstatus abrufen

Das Modell benötigt ca. 30 Minuten zum Trainieren. Sie erhalten eine E-Mail, sobald das Modell trainiert ist. In der Zwischenzeit überprüfen Sie den Zustand des Modells

watch -n 100 python ./code/model-state.py

Schritt 9: Vorhersage machen

Sobald das Modell trainiert ist. Mit dem Modell können Sie Vorhersagen treffen

python ./code/prediction.py PATH_TO_YOUR_IMAGE.jpgDie Vorteile der Verwendung von Nanonets gegenüber anderen OCR-APIs gehen über eine bessere Genauigkeit in Bezug auf das Extrahieren von Text aus Bildern hinaus. Hier sind 7 Gründe, warum Sie stattdessen die OCR von Nanonets zur Texterkennung verwenden sollten:

1. Arbeiten mit benutzerdefinierten Daten

Die meisten OCR-Programme sind ziemlich starr in Bezug auf die Art der Daten, mit denen sie arbeiten können. Das Training eines OCR-Modells für einen Anwendungsfall erfordert ein hohes Maß an Flexibilität hinsichtlich seiner Anforderungen und Spezifikationen; Eine OCR für die Rechnungsverarbeitung unterscheidet sich erheblich von einer OCR für Reisepässe! Nanonets ist nicht an solche starren Beschränkungen gebunden. Nanonets verwendet Ihre eigenen Daten, um OCR-Modelle zu trainieren, die am besten geeignet sind, die besonderen Anforderungen Ihres Unternehmens zu erfüllen.

2. Arbeiten mit Nicht-Englisch oder mehreren Sprachen

Da sich Nanonets auf das Training mit benutzerdefinierten Daten konzentriert, ist es einzigartig positioniert, um ein einzelnes OCR-Modell zu erstellen, das Text aus Bildern in jeder Sprache oder mehreren Sprachen gleichzeitig extrahieren kann.

3. Erfordert keine Nachbearbeitung

Mithilfe von OCR-Modellen extrahierter Text muss intelligent strukturiert und in einem verständlichen Format präsentiert werden; Andernfalls wird viel Zeit und Ressourcen in die Reorganisation der Daten in aussagekräftige Informationen gesteckt. Während die meisten OCR-Tools einfach Daten aus Bildern erfassen und ausgeben, extrahiert Nanonets nur die relevanten Daten und sortiert sie automatisch in intelligent strukturierte Felder, wodurch sie einfacher angezeigt und verstanden werden können.

4. Lernt kontinuierlich

Unternehmen sind oft mit sich dynamisch ändernden Anforderungen und Bedürfnissen konfrontiert. Um potenzielle Hindernisse zu überwinden, können Sie mit Nanonets Ihre Modelle einfach mit neuen Daten neu trainieren. Dadurch kann sich Ihr OCR-Modell an unvorhergesehene Änderungen anpassen.

5. Bewältigt problemlos allgemeine Dateneinschränkungen

Nanonets nutzt KI-, ML- und Deep-Learning-Techniken, um allgemeine Dateneinschränkungen zu überwinden, die sich stark auf die Texterkennung und -extraktion auswirken. Nanonets OCR kann handgeschriebenen Text, Bilder von Text in mehreren Sprachen gleichzeitig, Bilder mit niedriger Auflösung, Bilder mit neuen oder kursiven Schriftarten und unterschiedlichen Größen, Bilder mit schattiertem Text, geneigtem Text, zufälligem unstrukturiertem Text, Bildrauschen und unscharfen Bildern erkennen und verarbeiten und mehr. Herkömmliche OCR-APIs sind einfach nicht dafür ausgestattet, unter solchen Einschränkungen zu funktionieren; Sie erfordern Daten mit einem sehr hohen Genauigkeitsgrad, was in realen Szenarien nicht die Norm ist.

6. Erfordert kein internes Entwicklerteam

Sie müssen sich keine Gedanken über die Einstellung von Entwicklern und die Gewinnung von Talenten machen, um die Nanonets-API für Ihre Geschäftsanforderungen zu personalisieren. Nanonets wurde für eine problemlose Integration entwickelt. Sie können Nanonets auch problemlos in die meisten CRM-, ERP- oder RPA-Software integrieren.

7. Anpassen, anpassen, anpassen

Mit Nanonets OCR können Sie beliebig viele Text-/Datenfelder erfassen. Sie können sogar benutzerdefinierte Validierungsregeln erstellen, die für Ihre spezifischen Anforderungen an Texterkennung und Textextraktion geeignet sind. Nanonets ist überhaupt nicht an die Vorlage Ihres Dokuments gebunden. Sie können Daten in Tabellen oder Einzelposten oder in jedem anderen Format erfassen!

Nanonets bietet viele Anwendungsfälle, mit denen Sie Ihre Geschäftsleistung optimieren, Kosten sparen und das Wachstum steigern können. Finden Sie heraus Wie können die Anwendungsfälle von Nanonets auf Ihr Produkt angewendet werden?

Oder auschecken Nanonetze OCR-API in Aktion und beginnen Sie benutzerdefinierte zu bauen OCR Modelle kostenlos!

Aktualisierung Juli 2022: Dieser Beitrag wurde ursprünglich veröffentlicht in Oktober 2020 und wurde inzwischen aktualisiert regelmäßig.

Hier ist eine Folie fasst die Ergebnisse in diesem Artikel zusammen. Hier ist ein alternative Version von diesem Beitrag.

- AI

- KI & Maschinelles Lernen

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- OCR

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Texterkennung

- Zephyrnet