IBM (NYSE: IBM) gab heute bekannt, dass es sich laut Angaben des Unternehmens um einen Durchbruch im Quantencomputing handelt, der auf dem Cover des wissenschaftlichen Journals veröffentlicht wurde NaturDies zeigt zum ersten Mal, dass Quantensysteme genaue Ergebnisse auf einer Skala von mehr als 100 Qubits liefern können, die über die führenden klassischen Ansätze hinausgehen.“

IBM (NYSE: IBM) gab heute bekannt, dass es sich laut Angaben des Unternehmens um einen Durchbruch im Quantencomputing handelt, der auf dem Cover des wissenschaftlichen Journals veröffentlicht wurde NaturDies zeigt zum ersten Mal, dass Quantensysteme genaue Ergebnisse auf einer Skala von mehr als 100 Qubits liefern können, die über die führenden klassischen Ansätze hinausgehen.“

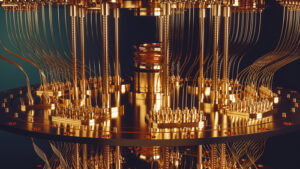

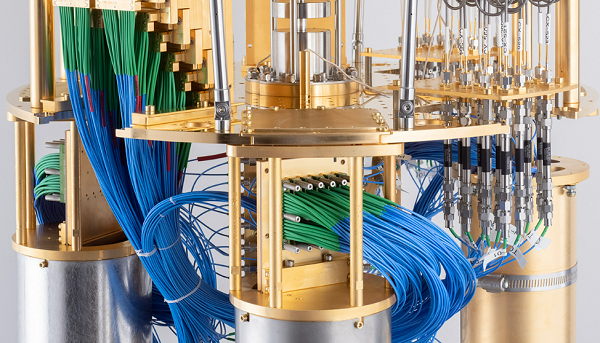

Ein IBM-Forschungsteam führte ein Experiment durch, bei dem das Unternehmen davon ausgeht, dass es einem Quantencomputer möglich ist, führende klassische Simulationen zu übertreffen, indem er lernt und Fehler im System abmildert, sagte das Unternehmen. Das Team nutzte den Quantenprozessor „Eagle“ von IBM Quantum, der aus 127 supraleitenden Qubits auf einem Chip besteht, um große, verschränkte Zustände zu erzeugen, die die Dynamik von Spins in einem Materialmodell simulieren und Eigenschaften wie seine Magnetisierung genau vorhersagen.

Um die Genauigkeit dieser Modellierung zu überprüfen, führte ein Team von Wissenschaftlern der UC Berkeley diese Simulationen gleichzeitig auf modernen klassischen Computern im National Energy Research Scientific Computing Center (NERSC) des Lawrence Berkeley National Lab durch Purdue University. Als der Maßstab des Modells zunahm, lieferte der Quantencomputer mithilfe fortschrittlicher Fehlerminderungstechniken weiterhin genaue Ergebnisse, auch wenn die klassischen Rechenmethoden schließlich ins Stocken gerieten und nicht mehr mit dem IBM Quantum-System mithalten konnten.

„Dies ist das erste Mal, dass wir Quantencomputer sehen, die ein physikalisches System in der Natur über die führenden klassischen Ansätze hinaus genau modellieren“, sagte Darío Gil, Senior Vice President und Direktor von IBM Research. „Für uns ist dieser Meilenstein ein bedeutender Schritt, um zu beweisen, dass die heutigen Quantencomputer leistungsfähige, wissenschaftliche Werkzeuge sind, mit denen sich Probleme modellieren lassen, die für klassische Systeme äußerst schwierig – und vielleicht sogar unmöglich – sind, und signalisieren, dass wir jetzt in eine neue Ära eintreten von Nutzen für das Quantencomputing.“

„Eines der ultimativen Ziele des Quantencomputings ist die Simulation von Materialkomponenten, die klassische Computer nie effizient simulieren konnten“, sagte das Unternehmen in seiner Ankündigung. „Die Modellierung dieser Aspekte ist ein entscheidender Schritt auf dem Weg zur Bewältigung von Herausforderungen wie der Entwicklung effizienterer Düngemittel, dem Bau besserer Batterien und der Entwicklung neuer Medikamente. Heutige Quantensysteme sind jedoch von Natur aus verrauscht und erzeugen eine erhebliche Anzahl von Fehlern, die die Leistung beeinträchtigen. Dies liegt an der fragilen Natur von Quantenbits oder Qubits und Störungen aus ihrer Umgebung.“ Weitere Informationen zur Demonstration finden Sie unter IBM Research-Blog.

IBM gab außerdem bekannt, dass seine IBM Quantum-Systeme, die sowohl in der Cloud als auch vor Ort bei Partnerstandorten laufen, mit mindestens 127 Qubits betrieben werden und im Laufe des nächsten Jahres fertiggestellt werden sollen.

Diese Prozessoren bieten Zugang zu einer Rechenleistung, die groß genug ist, um klassische Methoden für bestimmte Anwendungen zu übertreffen, und bieten verbesserte Kohärenzzeiten sowie niedrigere Fehlerraten im Vergleich zu früheren IBM-Quantensystemen. Solche Fähigkeiten können mit sich ständig weiterentwickelnden Fehlerminderungstechniken kombiniert werden, um es IBM Quantum-Systemen zu ermöglichen, einen neuen Schwellenwert für die Branche zu erreichen, den IBM als „Utility-Scale“ bezeichnet hat, einen Punkt, an dem Quantencomputer als wissenschaftliche Werkzeuge zur Erforschung neuer Technologien dienen könnten Ausmaß der Probleme, die klassische Systeme möglicherweise nie lösen können.

Kredit: IBM

„Während wir unsere Mission vorantreiben, nützliches Quantencomputing auf die Welt zu bringen, verfügen wir über solide Beweise für die Eckpfeiler, die zur Erforschung einer völlig neuen Klasse von Rechenproblemen erforderlich sind“, sagte er Jay Gambetta, IBM Fellow und Vizepräsident, IBM Quantum. „Indem wir unsere IBM Quantum-Systeme mit Prozessoren ausstatten, die für den Einsatzbereich geeignet sind, laden wir unsere Kunden, Partner und Mitarbeiter ein, ihre schwierigsten Probleme einzubringen, um die Grenzen der heutigen Quantensysteme zu erkunden und mit der Erzielung echten Mehrwerts zu beginnen.“

IBM sagte, dass seine Quantenbenutzer in der Lage sein werden, Probleme auf Prozessoren im Versorgungsmaßstab mit mehr als 100 Qubits auszuführen. Die über 2,000 Teilnehmer der IBM Quantum Spring Challenge hatten Zugang zu diesen Prozessoren im Versorgungsmaßstab, während sie dynamische Schaltkreise erforschten, eine Technologie, die die Ausführung fortschrittlicherer Quantenalgorithmen erleichtert.

IBM sagte, Arbeitsgruppen von IBM Quantum-Benutzern erforschen Quanten in:

- Gesundheitswesen und Biowissenschaften: Unter der Leitung von Organisationen wie der Cleveland Clinic und Moderna erforschen sie Anwendungen der Quantenchemie und des quantenmaschinellen Lernens für Herausforderungen wie die beschleunigte molekulare Entdeckung und Modelle zur Vorhersage des Patientenrisikos.

- Hochenergiephysik: bestehend aus Forschungseinrichtungen wie CERN und DESY, arbeitet daran, die am besten geeigneten Quantenberechnungen für Bereiche wie Fusionsmodellierung zu identifizieren.

- Materialien: Angeführt von den Teams von Boeing, Bosch, The University of Chicago, Eiche Ridge National Lab, ExxonMobil und RIKEN wollen die besten Methoden zum Aufbau von Arbeitsabläufen für die Materialsimulation erforschen.

- Optimierung: zielt darauf ab, eine Zusammenarbeit zwischen globalen Institutionen wie E.ON, Wells Fargo und anderen zu etablieren, um Fragen zu untersuchen, die die Identifizierung von Optimierungsproblemen vorantreiben, die sich am besten für Quantenvorteile in den Bereichen Nachhaltigkeit und Finanzen eignen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- EVM-Finanzen. Einheitliche Schnittstelle für dezentrale Finanzen. Hier zugreifen.

- Quantum Media Group. IR/PR verstärkt. Hier zugreifen.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://insidehpc.com/2023/06/ibm-reports-accurate-quantum-at-100-qubits/

- :hast

- :Ist

- :nicht

- 000

- 100

- a

- Fähigkeit

- Fähig

- beschleunigt

- Zugang

- Genauigkeit

- genau

- genau

- über

- advanced

- Vorrückend

- Ziel

- gezielt

- Algorithmen

- ebenfalls

- an

- Analyse

- und

- angekündigt

- Ankündigung

- Anwendungen

- Ansätze

- SIND

- Bereiche

- AS

- At

- Batterien

- BE

- beginnen

- Berkeley

- BESTE

- Besser

- Beyond

- Boeing

- beide

- Durchbruch

- bringen

- bauen

- Building

- aber

- by

- Berechnungen

- CAN

- Fähigkeiten

- fähig

- Center

- sicher

- challenges

- Herausforderungen

- Chemie

- Chip

- Klasse

- Kunden

- Cloud

- Zusammenarbeit

- kombiniert

- Unternehmen

- Abgeschlossene Verkäufe

- Komponenten

- zusammengesetzt

- Bestehend

- Rechenleistung

- Computer

- Computer

- Computing

- durchgeführt

- weiter

- ständig

- Eckpfeiler

- könnte

- Kurs

- Abdeckung

- Erstellen

- wichtig

- demonstrieren

- Entwerfen

- DID

- schwer

- Direktor

- Entdeckung

- zwei

- dynamisch

- Dynamik

- e

- einfacher

- effizient

- effizient

- ermöglichen

- Energie

- genug

- Eingabe

- vollständig

- Arbeitsumfeld

- Era

- Fehler

- Fehler

- Festlegung

- Sogar

- schließlich

- Beweis

- Experiment

- ERKUNDEN

- Erkundet

- Möglichkeiten sondieren

- äußerst

- Kerl

- Finanzen

- Vorname

- erstes Mal

- Aussichten für

- gefunden

- für

- Verschmelzung

- erzeugen

- Global

- Ziele

- Gruppen

- hätten

- Haben

- Hilfe

- Hohe Leistungsfähigkeit

- http

- HTTPS

- IBM

- IBM-Quantum

- Login

- identifizieren

- unmöglich

- verbessert

- in

- hat

- Energiegewinnung

- Information

- von Natur aus

- Institutionen

- einladend

- IT

- SEINE

- Zeitschrift

- grosse

- größer

- führenden

- lernen

- geführt

- Lebensdauer

- Biowissenschaften

- Grenzen

- located

- Standorte

- senken

- Maschine

- Maschinelles Lernen

- MACHT

- Spiel

- Ihres Materials

- Materialien

- max-width

- Kann..

- Mittel

- Triff

- Methoden

- Meilenstein

- Minimum

- Ziel

- mildernd

- Milderung

- Modell

- Modellieren

- für

- Moderne

- Molekular-

- mehr

- effizienter

- National

- Natur

- erforderlich

- hört niemals

- Neu

- News

- weiter

- jetzt an

- Anzahl

- NYSE

- of

- bieten

- on

- Optimierung

- or

- Organisationen

- Anders

- UNSERE

- Übertreffen

- übrig

- Teilnehmer

- Partner

- Vertrauen bei Patienten

- Leistung

- durchgeführt

- vielleicht

- physikalisch

- Physik

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- möglich

- Werkzeuge

- angetriebene

- vorhersagen

- Prognose

- Präsident

- früher

- Probleme

- Prozessor

- Prozessoren

- produziert

- Fortschritt

- immobilien

- die

- veröffentlicht

- Quant

- Quantenalgorithmen

- Quantencomputer

- Quantencomputer

- Quantencomputing

- Quantenmaschinelles Lernen

- Quantensysteme

- Qubits

- Fragen

- Honorar

- echt

- echter Wert

- Meldungen

- Forschungsprojekte

- Forschungseinrichtungen

- Die Ergebnisse

- RIKEN

- Risiko

- Führen Sie

- Laufen

- Said

- Skalieren

- WISSENSCHAFTEN

- wissenschaftlich

- Wissenschaftler

- gesehen

- Senior

- brauchen

- signifikant

- Simulation

- gleichzeitig

- solide

- LÖSEN

- Spins

- Feder

- Staaten

- Schritt

- so

- supraleitend

- übertreffen

- Nachhaltigkeit

- System

- Systeme und Techniken

- angehen

- Team

- Teams

- Techniken

- Technologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Welt

- ihr

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Schwelle

- Zeit

- mal

- zu

- heute

- heutigen

- Werkzeuge

- gegenüber

- WENDE

- letzte

- us

- benutzt

- Nutzer

- Nutzen

- Wert

- überprüfen

- Vizepräsident:in

- we

- GUT

- Wells

- Wells Fargo

- Was

- welche

- während

- werden wir

- mit

- Workflows

- arbeiten,

- Arbeitsgruppen

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Jahr

- Zephyrnet