Viele unserer AWS-Kunden bieten Forschung, Analysen und Business Intelligence als Service an. Diese Art von Forschung und Business Intelligence ermöglicht es ihren Endkunden, Märkten und Wettbewerbern einen Schritt voraus zu sein, Wachstumschancen zu erkennen und Probleme proaktiv anzugehen. Einige unserer Kunden aus dem Finanzdienstleistungssektor recherchieren beispielsweise für Aktien, Hedgefonds und Investmentmanagementgesellschaften, um ihnen dabei zu helfen, Trends zu verstehen und Portfoliostrategien zu identifizieren. In der Gesundheitsbranche ist ein immer größerer Teil der Gesundheitsforschung heute informationsbasiert. Ein großer Teil der Forschung beinhaltet die Analyse von Daten, die ursprünglich für Diagnose-, Behandlungs- oder andere Forschungsprojekte gesammelt wurden und nun für neue Forschungszwecke verwendet werden. Diese Formen der Gesundheitsforschung haben zu einer wirksamen Primärprävention zur Vermeidung neuer Fälle, zur Sekundärprävention zur Früherkennung und zur Prävention für ein besseres Krankheitsmanagement geführt. Die Forschungsergebnisse verbessern nicht nur die Lebensqualität, sondern tragen auch zur Senkung der Gesundheitsausgaben bei.

Kunden neigen dazu, die Informationen aus öffentlichen und privaten Quellen zu verdauen. Anschließend wenden sie etablierte oder benutzerdefinierte NLP-Modelle (Natural Language Processing) an, um einen Trend zusammenzufassen und zu identifizieren und auf der Grundlage dieser Informationen Erkenntnisse zu generieren. Die NLP-Modelle, die für diese Art von Forschungsaufgaben verwendet werden, befassen sich mit großen Modellen und umfassen normalerweise lange Artikel, die angesichts der Größe des Korpus zusammengefasst werden müssen – und dedizierte Endpunkte, die derzeit nicht kostenoptimiert sind. Diese Anwendungen erhalten zu unterschiedlichen Tageszeiten einen Burst eingehenden Datenverkehrs.

Wir glauben, dass Kunden von der Möglichkeit, auf null herunterzuskalieren und ihre Inferenzfähigkeit nach Bedarf zu erweitern, sehr profitieren würden. Dies optimiert die Forschungskosten und macht dennoch keine Kompromisse bei der Qualität der Schlussfolgerungen. Dieser Beitrag beschreibt, wie Hugging Face zusammen mit Amazon Sage Maker asynchrone Inferenz kann dazu beitragen.

Sie können Textzusammenfassungsmodelle mit mehreren Deep-Learning-Frameworks wie TensorFlow, PyTorch und Apache MXNet erstellen. Diese Modelle haben typischerweise eine große Eingabenutzlast von mehreren Textdokumenten unterschiedlicher Größe. Fortgeschrittene Deep-Learning-Modelle erfordern eine rechenintensive Vorverarbeitung vor der Modellinferenz. Die Verarbeitungszeiten können bis zu einigen Minuten betragen, wodurch die Option zum Ausführen von Echtzeit-Inferenzen durch das Übergeben von Nutzlasten über eine HTTP-API entfällt. Stattdessen müssen Sie Eingabenutzlasten asynchron aus einem Objektspeicher wie z Amazon Simple Storage-Service (Amazon S3) mit automatischer Warteschlange und einem vordefinierten Parallelitätsschwellenwert. Das System sollte in der Lage sein, Statusbenachrichtigungen zu empfangen und unnötige Kosten zu reduzieren, indem Ressourcen bereinigt werden, wenn die Aufgaben abgeschlossen sind.

SageMaker hilft Datenwissenschaftlern und Entwicklern, qualitativ hochwertige Modelle für maschinelles Lernen (ML) schnell vorzubereiten, zu erstellen, zu trainieren und bereitzustellen, indem es eine breite Palette von Funktionen zusammenführt, die speziell für ML entwickelt wurden. SageMaker bietet die fortschrittlichsten Open-Source-Model-Serving-Container für XGBoost (Container, SDK), Scikit-Lernen (Container, SDK), PyTorch (Container, SDK), TensorFlow (Container, SDK) und Apache MXNet (Container, SDK).

- Echtzeit-Inferenz Endpunkte eignen sich für Workloads, die mit geringen Latenzanforderungen in der Größenordnung von ms bis Sekunden verarbeitet werden müssen.

- Batch-Transformation ist ideal für Offline-Vorhersagen für große Datenmengen.

- Serverlose Amazon SageMaker-Inferenz (im Vorschaumodus und zum jetzigen Zeitpunkt nicht für Produktionsworkloads empfohlen) ist eine speziell entwickelte Inferenzoption, die es Ihnen erleichtert, ML-Modelle bereitzustellen und zu skalieren. Serverless Inference ist ideal für Workloads, die Leerlaufzeiten zwischen Datenverkehrsspitzen haben und Kaltstarts tolerieren können.

- Asynchrone Inferenz Endpunkte stellen eingehende Anfragen in eine Warteschlange. Sie sind ideal für Workloads, bei denen die Anforderungsgrößen groß sind (bis zu 1 GB) und die Inferenzverarbeitungszeiten in der Größenordnung von Minuten liegen (bis zu 15 Minuten). Mit asynchroner Inferenz können Sie Kosten sparen, indem Sie die Anzahl der Instanzen automatisch auf null skalieren, wenn keine Anforderungen zu verarbeiten sind.

Lösungsüberblick

In diesem Beitrag stellen wir eine PEGASUS-Modell das für die Textzusammenfassung vortrainiert wurde Gesicht umarmen zu SageMaker-Hosting-Dienste. Der Einfachheit halber verwenden wir das Modell von Hugging Face. Sie können jedoch Feinabstimmung des Modells basierend auf einem benutzerdefinierten Datensatz. Sie können auch andere Modelle ausprobieren, die in der verfügbar sind Modellhub mit umarmendem Gesicht. Wir stellen auch einen asynchronen Inferenzendpunkt bereit, der dieses Modell hostet, von dem Sie Vorhersagen erhalten können.

Der Inferenzhandler des asynchronen Inferenzendpunkts erwartet einen Artikel als Eingabenutzlast. Der zusammengefasste Text des Artikels ist die Ausgabe. Die Ausgabe wird in der Datenbank gespeichert, um die Trends zu analysieren, oder nachgelagert für weitere Analysen eingespeist. Diese nachgelagerte Analyse leitet Dateneinblicke ab, die bei der Recherche helfen.

Wir demonstrieren, wie Sie mit asynchronen Inferenzendpunkten benutzerdefinierte Parallelitäts- und Abschlussbenachrichtigungen erhalten. Wir konfigurieren die automatische Skalierung von Instanzen hinter dem Endpunkt so, dass sie auf null herunterskaliert wird, wenn der Datenverkehr nachlässt, und wieder hochskaliert wird, wenn sich die Anforderungswarteschlange füllt.

Wir benützen auch Amazon CloudWatch Metriken zur Überwachung der Warteschlangengröße, der Gesamtverarbeitungszeit und der verarbeiteten Aufrufe.

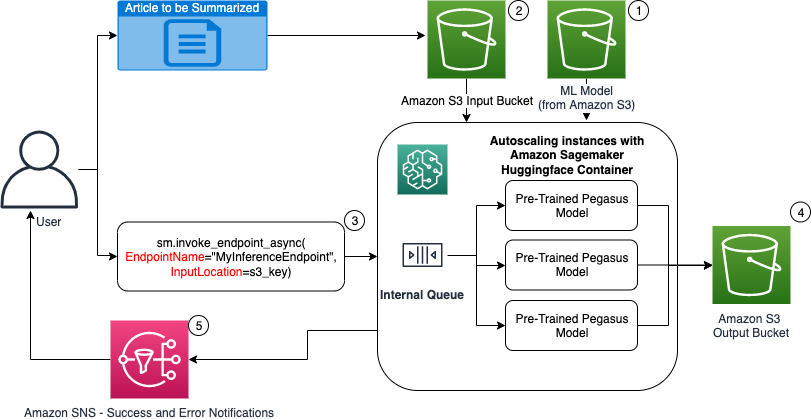

Im folgenden Diagramm zeigen wir die Schritte, die beim Durchführen einer Inferenz mit einem asynchronen Inferenzendpunkt erforderlich sind.

- Unsere vortrainierten PEGASUS Das ML-Modell wird zuerst auf dem Skalierungsendpunkt gehostet.

- Der Benutzer lädt den zusammenzufassenden Artikel in einen Eingabe-S3-Bucket hoch.

- Der asynchrone Inferenzendpunkt wird mithilfe einer API aufgerufen.

- Nachdem die Inferenz abgeschlossen ist, wird das Ergebnis im Ausgabe-S3-Bucket gespeichert.

- An Amazon Simple Notification Service (Amazon SNS) Benachrichtigung wird an den Benutzer gesendet, um ihn über den abgeschlossenen Erfolg oder Misserfolg zu informieren.

Erstellen Sie einen asynchronen Inferenzendpunkt

Wir erstellen den asynchronen Inferenzendpunkt ähnlich einem in Echtzeit gehosteten Endpunkt. Die Schritte umfassen das Erstellen eines SageMaker-Modells, gefolgt von der Konfiguration des Endpunkts und der Bereitstellung des Endpunkts. Der Unterschied zwischen den beiden Arten von Endpunkten besteht darin, dass die Endpunktkonfiguration für asynchrone Rückschlüsse eine enthält AsyncInferenceConfig Sektion. Hier geben wir den S3-Ausgabepfad für die Ergebnisse des Endpunktaufrufs an und schließen optional SNS-Themen für Benachrichtigungen über Erfolg und Fehler ein. Wir geben auch die vom Kunden festgelegte maximale Anzahl gleichzeitiger Aufrufe pro Instanz an. Siehe folgenden Code:

Einzelheiten zur API zum Erstellen einer Endpunktkonfiguration für asynchrone Inferenz finden Sie unter Erstellen eines asynchronen Inferenzendpunkts.

Rufen Sie den asynchronen Inferenzendpunkt auf

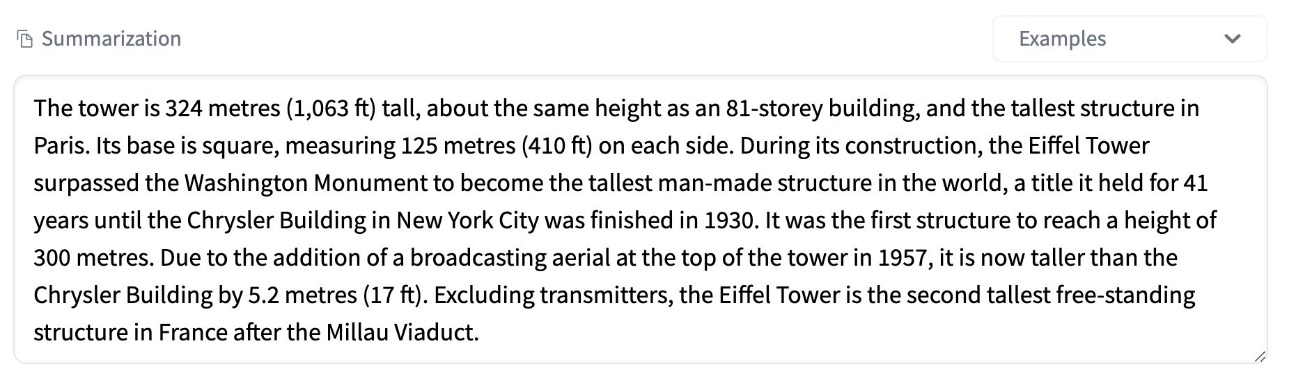

Der folgende Screenshot zeigt einen kurzen Artikel, den wir als Eingabenutzlast verwenden:

Der folgende Code lädt den Artikel als input.json Datei zu Amazon S3:

Wir verwenden den Amazon S3-URI für die Eingabenutzlastdatei, um den Endpunkt aufzurufen. Das Antwortobjekt enthält den Ausgabespeicherort in Amazon S3, um die Ergebnisse nach Abschluss abzurufen:

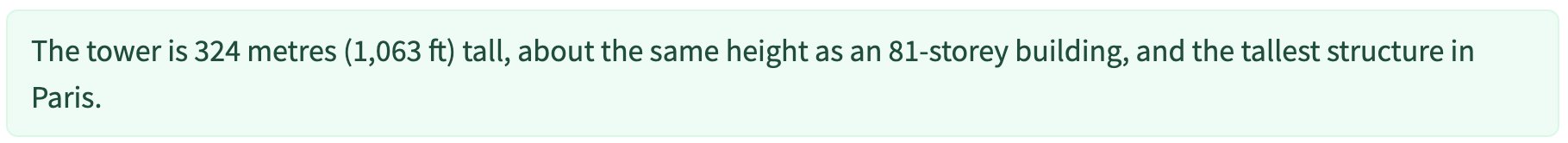

Der folgende Screenshot zeigt die Beispielausgabe nach der Zusammenfassung:

Einzelheiten zur API zum Aufrufen eines asynchronen Inferenzendpunkts finden Sie unter Rufen Sie einen asynchronen Inferenzendpunkt auf.

Stellen Sie die Aufrufanforderungen mit benutzerdefinierter Parallelität in eine Warteschlange

Der asynchrone Inferenzendpunkt stellt die Aufrufanforderungen automatisch in die Warteschlange. Dies ist eine vollständig verwaltete Warteschlange mit verschiedenen Überwachungsmetriken und erfordert keine weitere Konfiguration. Es verwendet die MaxConcurrentInvocationsPerInstance -Parameter in der vorherigen Endpunktkonfiguration, um neue Anforderungen aus der Warteschlange zu verarbeiten, nachdem vorherige Anforderungen abgeschlossen sind. MaxConcurrentInvocationsPerInstance ist die maximale Anzahl gleichzeitiger Anforderungen, die vom SageMaker-Client an den Modellcontainer gesendet werden. Wenn kein Wert angegeben wird, wählt SageMaker einen optimalen Wert für Sie aus.

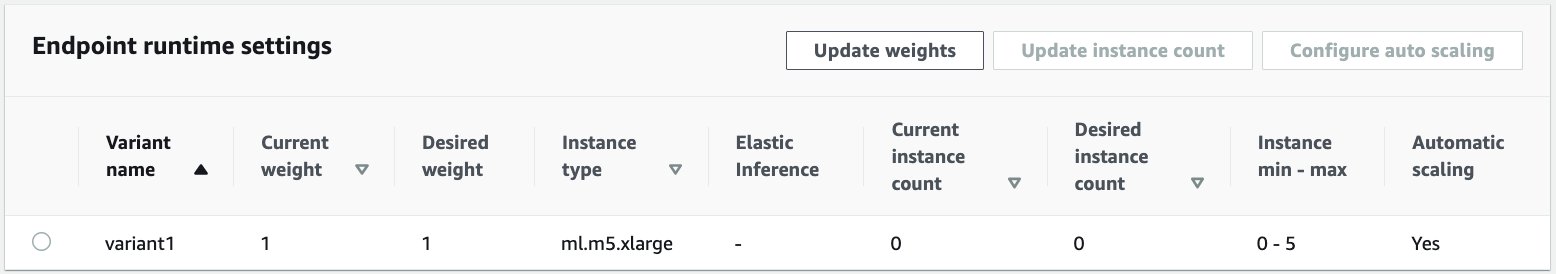

Instanzen mit automatischer Skalierung innerhalb des asynchronen Inferenzendpunkts

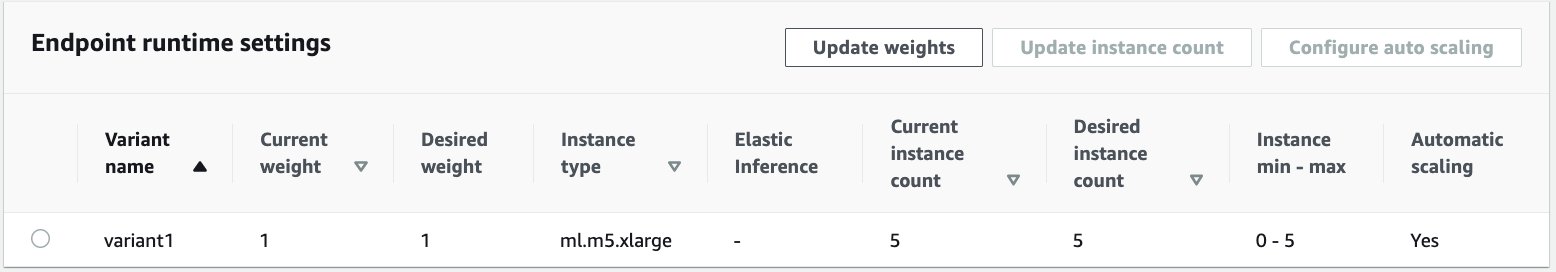

Wir legen die Auto Scaling-Richtlinie mit einer Mindestkapazität von null und einer maximalen Kapazität von fünf Instanzen fest. Im Gegensatz zu in Echtzeit gehosteten Endpunkten unterstützen asynchrone Inferenzendpunkte das Herunterskalieren von Instanzen auf null, indem die Mindestkapazität auf null gesetzt wird. Wir nehmen das ApproximateBacklogSizePerInstance Metrik für die Konfiguration der Skalierungsrichtlinie mit einem Zielwarteschlangenrückstand von fünf pro Instanz, um weiter aufzuskalieren. Wir legen die Abklingzeit für fest ScaleInCooldown bis 120 Sekunden und die ScaleOutCooldown bis 120 Sekunden. Der Wert für ApproximateBacklogSizePerInstance wird basierend auf dem Datenverkehr und Ihrer Empfindlichkeit gegenüber der Skalierungsgeschwindigkeit ausgewählt. Je schneller Sie skalieren, desto weniger Kosten entstehen Ihnen, aber desto wahrscheinlicher ist es, dass Sie erneut skalieren müssen, wenn neue Anfragen eingehen. Je langsamer Sie skalieren, desto mehr Kosten entstehen, aber die Wahrscheinlichkeit ist geringer Eine Anfrage kommt herein, wenn Sie unterdimensioniert sind.

Einzelheiten zur API zum automatischen Skalieren eines asynchronen Inferenzendpunkts finden Sie in der Autoskalieren Sie einen asynchronen Inferenzendpunkt.

Konfigurieren Sie Benachrichtigungen vom asynchronen Inferenzendpunkt

Wir erstellen zwei separate SNS-Themen für Erfolgs- und Fehlermeldungen für jedes Endpunktaufrufergebnis:

Andere Optionen für Benachrichtigungen umfassen das regelmäßige Überprüfen der Ausgabe des S3-Buckets oder die Verwendung von S3-Bucket-Benachrichtigungen zum Initialisieren einer AWS Lambda Funktion beim Datei-Upload. SNS-Benachrichtigungen sind wie zuvor beschrieben im Endpunktkonfigurationsabschnitt enthalten.

Einzelheiten zum Einrichten von Benachrichtigungen von einem asynchronen Inferenzendpunkt finden Sie unter Vorhersageergebnisse prüfen.

Überwachen Sie den asynchronen Inferenzendpunkt

Wir überwachen den asynchronen Inferenzendpunkt mit integrierten zusätzlichen CloudWatch-Metriken, die spezifisch für asynchrone Inferenz sind. Beispielsweise überwachen wir die Warteschlangenlänge in jedem Fall mit ApproximateBacklogSizePerInstance und Gesamtwarteschlangenlänge mit ApproximateBacklogSize.

Eine vollständige Liste der Metriken finden Sie unter Überwachung asynchroner Inferenzendpunkte.

Wir können die Endpunktkonfiguration optimieren, um die kostengünstigste Instanz mit hoher Leistung zu erhalten. Beispielsweise können wir eine Instanz mit Amazon Elastic Inference oder AWS Inferentia verwenden. Wir können die Gleichzeitigkeitsstufe auch schrittweise bis zur Durchsatzspitze erhöhen, während wir andere Modellserver- und Containerparameter anpassen.

CloudWatch-Diagramme

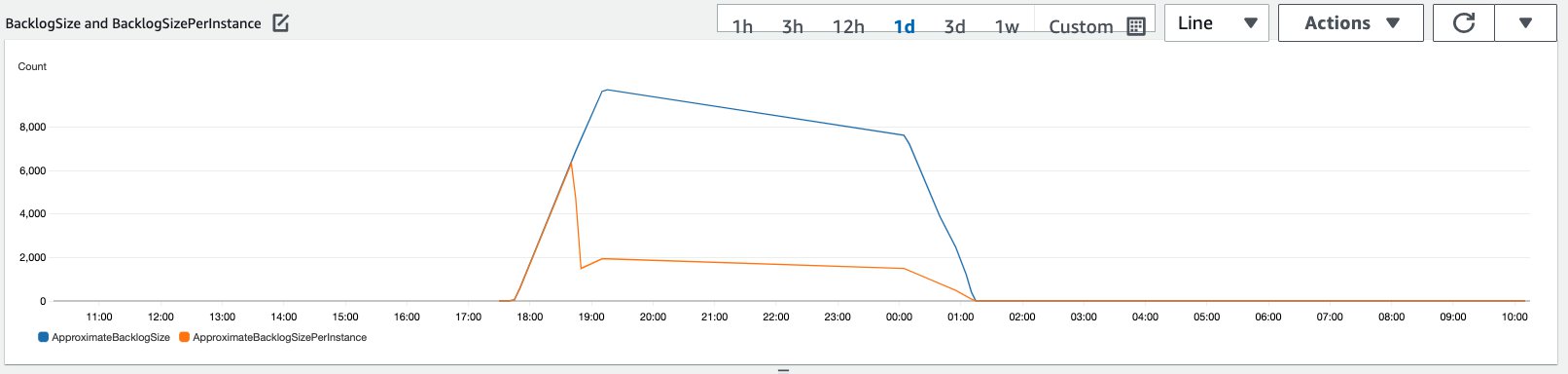

Wir haben einen Datenverkehr von 10,000 Inferenzanforderungen simuliert, die über einen bestimmten Zeitraum an den asynchronen Inferenzendpunkt fließen, der mit der im vorherigen Abschnitt beschriebenen Auto Scaling-Richtlinie aktiviert wurde.

Der folgende Screenshot zeigt Instanzmetriken, bevor Anfragen eingingen. Wir beginnen mit einem Live-Endpunkt ohne laufende Instanzen:

Die folgende Grafik zeigt, wie die BacklogSize und BacklogSizePerInstance Metriken ändern sich, wenn die automatische Skalierung einsetzt und die Last auf dem Endpunkt von mehreren Instanzen geteilt wird, die im Rahmen der automatischen Skalierung bereitgestellt wurden.

Wie im folgenden Screenshot gezeigt, stieg die Anzahl der Instanzen mit zunehmender Inferenzanzahl:

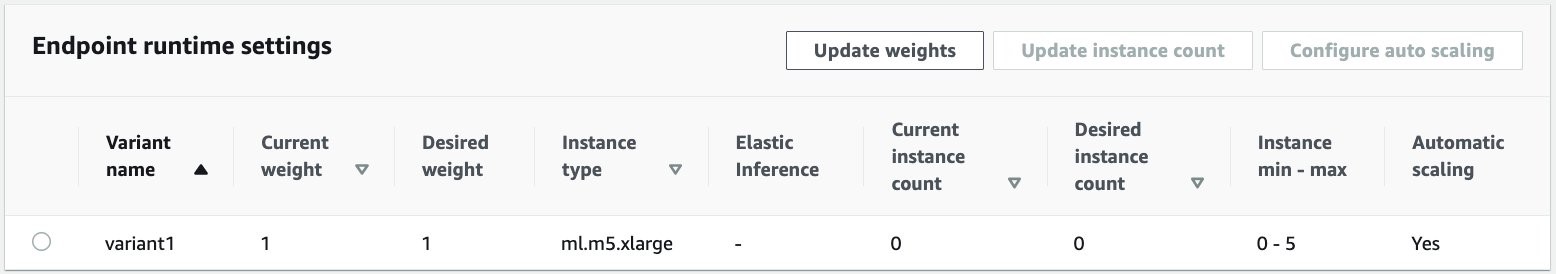

Der folgende Screenshot zeigt, wie die Skalierung den Endpunkt in den Ausgangszustand von null laufenden Instanzen zurückbringt:

Aufräumen

Nachdem alle Anforderungen abgeschlossen sind, können wir den Endpunkt ähnlich wie beim Löschen von in Echtzeit gehosteten Endpunkten löschen. Beachten Sie, dass, wenn wir die Mindestkapazität asynchroner Inferenzendpunkte auf null setzen, keine Instance-Gebühren anfallen, nachdem sie auf null herunterskaliert wurde.

Wenn Sie die automatische Skalierung für Ihren Endpunkt aktiviert haben, stellen Sie sicher, dass Sie den Endpunkt als skalierbares Ziel abmelden, bevor Sie den Endpunkt löschen. Führen Sie dazu den folgenden Code aus:

Denken Sie daran, Ihren Endpunkt nach der Verwendung zu löschen, da Ihnen die in dieser Demo verwendeten Instanzen in Rechnung gestellt werden.

Sie müssen auch die S3-Objekte und SNS-Themen löschen. Wenn Sie andere AWS-Ressourcen erstellt haben, die Sie verwenden und auf die SNS-Benachrichtigungen reagieren möchten, möchten Sie diese möglicherweise auch löschen.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie die neue asynchrone Inferenzfunktion von SageMaker verwendet wird, um eine typische große Eingabenutzlast zu verarbeiten, die Teil einer Zusammenfassungsaufgabe ist. Für die Inferenz haben wir ein Modell von Hugging Face verwendet und es auf einem asynchronen Inferenzendpunkt bereitgestellt. Wir haben die allgemeinen Herausforderungen von Burst-Traffic, hohen Modellverarbeitungszeiten und großen Nutzlasten im Zusammenhang mit Forschungsanalysen erläutert. Die inhärente Fähigkeit des asynchronen Inferenzendpunkts, interne Warteschlangen, vordefinierte Gleichzeitigkeitslimits zu verwalten, Antwortbenachrichtigungen zu konfigurieren und automatisch auf null herunterzuskalieren, half uns, diese Herausforderungen zu bewältigen. Der vollständige Code für dieses Beispiel ist unter verfügbar GitHub.

Um mit der asynchronen Inferenz von SageMaker zu beginnen, lesen Sie hier Asynchrone Inferenz.

Über die Autoren

Dinesh Kumar Subramani ist Senior Solutions Architect im UKIR SMB-Team mit Sitz in Edinburgh, Schottland. Er ist spezialisiert auf künstliche Intelligenz und maschinelles Lernen. Dinesh arbeitet gerne mit Kunden aus verschiedenen Branchen zusammen, um ihnen bei der Lösung ihrer Probleme mit AWS-Services zu helfen. Außerhalb der Arbeit verbringt er gerne Zeit mit seiner Familie, spielt Schach und genießt Musik aller Genres.

Dinesh Kumar Subramani ist Senior Solutions Architect im UKIR SMB-Team mit Sitz in Edinburgh, Schottland. Er ist spezialisiert auf künstliche Intelligenz und maschinelles Lernen. Dinesh arbeitet gerne mit Kunden aus verschiedenen Branchen zusammen, um ihnen bei der Lösung ihrer Probleme mit AWS-Services zu helfen. Außerhalb der Arbeit verbringt er gerne Zeit mit seiner Familie, spielt Schach und genießt Musik aller Genres.

Raghu Ramesha ist ML Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Produktions-Workloads in großem Umfang zu erstellen, bereitzustellen und zu SageMaker zu migrieren. Er ist auf maschinelles Lernen, KI und Computer Vision spezialisiert und hat einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

Raghu Ramesha ist ML Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Produktions-Workloads in großem Umfang zu erstellen, bereitzustellen und zu SageMaker zu migrieren. Er ist auf maschinelles Lernen, KI und Computer Vision spezialisiert und hat einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

- Coinsmart. Europas beste Bitcoin- und Krypto-Börse.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. DEN FREIEN ZUGANG.

- CryptoHawk. Altcoin-Radar. Kostenlose Testphase.

- Quelle: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- über

- Action

- Aktivität

- Zusätzliche

- Adresse

- advanced

- AI

- Alle

- Amazon

- Betrag

- Analyse

- Analytik

- Ein anderer

- Bienen

- Anwendung

- Anwendungen

- Artikel

- Artikel

- künstlich

- künstliche Intelligenz

- Künstliche Intelligenz und maschinelles Lernen

- Auto

- verfügbar

- durchschnittlich

- AWS

- Grundlage

- Sein

- Grenze

- bauen

- eingebaut

- Geschäft

- Business Intelligence

- Kann bekommen

- Fähigkeiten

- Kapazität

- Fälle

- Herausforderungen

- Übernehmen

- berechnet

- Gebühren

- Überprüfung

- Schach

- Reinigung

- Code

- gemeinsam

- Unternehmen

- Konkurrenz

- Computerwissenschaften

- Konfiguration

- verbrauchen

- Container

- Behälter

- enthält

- kostengünstiger

- Kosten

- Erstellen

- Kunden

- Dallas

- technische Daten

- Datenbase

- Tag

- Deal

- gewidmet

- einsetzen

- Bereitstellen

- Entdeckung

- Entwickler

- anders

- Krankheit

- Unterlagen

- Tut nicht

- Domains

- nach unten

- Früh

- Effektiv

- Endpunkt

- etablierten

- Beispiel

- erwartet

- Kosten

- Gesicht

- Scheitern

- Familie

- beschleunigt

- Fed

- Revolution

- Finanzdienstleistungen

- Vorname

- Folgende

- Format

- Formen

- Frei

- Funktion

- Mittel

- erzeugen

- groß

- Wachstum

- Gesundheit

- Gesundheitswesen

- Hedge Fonds

- Hilfe

- hilft

- hier

- High

- hält

- Ultraschall

- Hilfe

- HTTPS

- identifizieren

- zu unterstützen,

- das

- inklusive

- Erhöhung

- hat

- Branchen

- Energiegewinnung

- Information

- Einblicke

- Intelligenz

- Investition

- beteiligt

- Probleme

- IT

- Sprache

- grosse

- lernen

- geführt

- Niveau

- Liste

- Belastung

- Standorte

- Lang

- Maschine

- Maschinelles Lernen

- Management

- Märkte

- Metrik

- ML

- Modell

- für

- Überwachung

- vor allem warme

- MS

- Musik

- Natürliche

- Benachrichtigung

- Benachrichtigung

- Entwicklungsmöglichkeiten

- Option

- Optionen

- Auftrag

- Andere

- Leistung

- Zeiträume

- Fotografie

- Datenschutzrichtlinien

- Mappe

- Prognose

- Prognosen

- abwehr

- Vorspann

- primär

- privat

- Probleme

- Prozessdefinierung

- Produktion

- Projekte

- die

- bietet

- Öffentlichkeit

- Zwecke

- Qualität

- schnell

- Rampe

- Echtzeit

- erhalten

- Veteran

- erfordern

- Voraussetzungen:

- Forschungsprojekte

- Ressourcen

- Downloads

- Antwort

- Die Ergebnisse

- Führen Sie

- Laufen

- skalierbaren

- Skalieren

- Skalierung

- Wissenschaft

- Wissenschaftler

- Sekundär-

- Bibliotheken

- Serverlos

- Leistungen

- kompensieren

- Einstellung

- von Locals geführtes

- ähnlich

- Einfacher

- Größe

- Lösungen

- LÖSEN

- spezialisiert

- Geschwindigkeit

- Ausgabe

- Anfang

- begonnen

- beginnt

- Bundesstaat

- Status

- bleiben

- Lagerung

- speichern

- Strategien

- Erfolg

- Support

- Unterstützt

- System

- Target

- und Aufgaben

- Team

- Zeit

- gemeinsam

- Themen

- Tracking

- der Verkehr

- Behandlungen

- Trends

- verstehen

- us

- -

- gewöhnlich

- Wert

- Seh-

- ob

- .

- Arbeiten

- arbeiten,

- Schreiben

- Null