Wir haben ein neuronales Netz namens Whisper trainiert, das sich der Robustheit und Genauigkeit der englischen Spracherkennung auf menschlichem Niveau annähert, und betreiben Open-Sourcing.

Code anzeigen

Modellkarte ansehen

Flüsterbeispiele:

Whisper ist ein automatisches Spracherkennungssystem (ASR), das auf 680,000 Stunden mehrsprachiger und überwachter Multitasking-Daten aus dem Internet trainiert wurde. Wir zeigen, dass die Verwendung eines so großen und vielfältigen Datensatzes zu einer verbesserten Robustheit gegenüber Akzenten, Hintergrundgeräuschen und Fachsprache führt. Darüber hinaus ermöglicht es die Transkription in mehrere Sprachen sowie die Übersetzung aus diesen Sprachen ins Englische. Wir stellen Open-Source-Modelle und Inferenzcode zur Verfügung, um als Grundlage für die Entwicklung nützlicher Anwendungen und für weitere Forschungen zur robusten Sprachverarbeitung zu dienen.

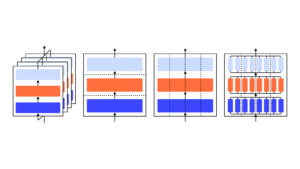

Die Whisper-Architektur ist ein einfacher End-to-End-Ansatz, der als Encoder-Decoder-Transformer implementiert ist. Das Eingangsaudio wird in 30-Sekunden-Blöcke aufgeteilt, in ein Log-Mel-Spektrogramm umgewandelt und dann an einen Encoder weitergeleitet. Ein Decoder wird darauf trainiert, die entsprechende Textbeschriftung vorherzusagen, gemischt mit speziellen Tokens, die das einzelne Modell anweisen, Aufgaben wie Sprachidentifikation, Zeitstempel auf Phrasenebene, mehrsprachige Sprachtranskription und Sprachübersetzung ins Englische auszuführen.

Andere bestehende Ansätze verwenden häufig kleinere, enger gepaarte Audio-Text-Trainingsdatensätze, oder verwenden Sie ein breites, aber nicht überwachtes Audio-Vortraining. Da Whisper auf einem großen und vielfältigen Datensatz trainiert und nicht auf einen bestimmten optimiert wurde, schlägt es keine Modelle, die auf die Leistung von LibriSpeech spezialisiert sind, ein bekanntermaßen wettbewerbsfähiger Benchmark in der Spracherkennung. Wenn wir jedoch die Zero-Shot-Leistung von Whisper über viele verschiedene Datensätze hinweg messen, stellen wir fest, dass es viel robuster ist und 50 % weniger Fehler macht als diese Modelle.

Etwa ein Drittel des Audiodatensatzes von Whisper ist nicht-englisch und erhält abwechselnd die Aufgabe, in die Originalsprache zu transkribieren oder ins Englische zu übersetzen. Wir finden, dass dieser Ansatz beim Erlernen der Sprache-zu-Text-Übersetzung besonders effektiv ist und die beaufsichtigte SOTA auf CoVoST2 to English Translation Zero-Shot übertrifft.

Wir hoffen, dass die hohe Genauigkeit und Benutzerfreundlichkeit von Whisper es Entwicklern ermöglichen wird, Sprachschnittstellen zu einer viel breiteren Palette von Anwendungen hinzuzufügen. Probier das aus Krepppapier, Modellkarte und Code um mehr Details zu erfahren und Whisper auszuprobieren.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- OpenAI

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Forschungsprojekte

- Skala ai

- Syntax

- Zephyrnet