Etwas fürs Wochenende Vor meiner Haustür führt ein Roboter interpretierenden Tanz auf.

WÜRDEN SIE DIESES PAKET FÜR IHREN NACHBARN MITNEHMEN? fragt es und springt von einem Fuß auf den anderen.

„Sicher“, sage ich. „Äh… geht es dir gut?“

ICH DRÜCKE EMOTIONEN AUS, sagt der Liefer-Bot, überreicht das Paket, macht aber keine weiteren Ausführungen.

Welche Emotion könnte es sein? Ein Fuß, dann der andere, dann die anderen beiden (es hat vier). Hin und her.

„Musst du auf die Toilette?“

ICH BRAUCHE BEDAUERN, DASS ICH SIE BITTE, EIN PAKET FÜR IHREN NACHBARN ZU BRINGEN.

„Das ist ‚Bedauern', oder? Nun, es besteht keine Notwendigkeit. Ich habe überhaupt nichts dagegen.“

Es setzt seinen Tanz vor mir fort.

„Die Treppe hoch und die erste rechts.“

DANKE, ICH WOLLTE PISSEN, antwortet es, während es vorsichtig an mir vorbeigeht und nach oben huscht, um sich zu erleichtern. Es ist ein hartes Leben, Lieferungen zu machen, egal ob Sie ein „Hume“ oder ein Bot sind.

...

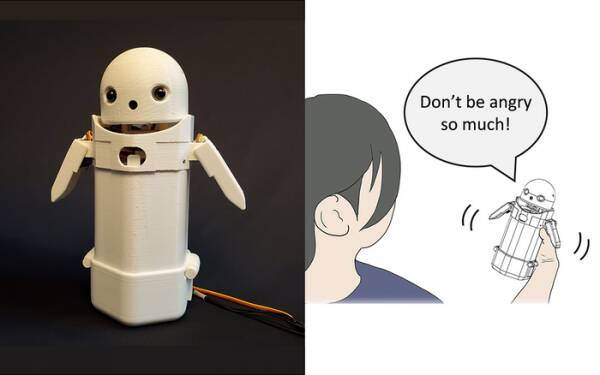

Anfang dieses Jahres bauten Forscher der Universität Tsukuba eine tragbares Textnachrichtengerät, legte ein kleines Robotergesicht auf die Oberseite und fügte ein bewegliches Gewicht hinzu. Durch die Verlagerung des internen Gewichts würde der Botenbote versuchen, subtile Emotionen zu vermitteln, während er Nachrichten laut ausspricht.

Insbesondere Tests zeigten, dass frustrierende Nachrichten wie: „Entschuldigung, ich komme zu spät“ von den Empfängern mit mehr Anmut und Geduld akzeptiert wurden, wenn die kleine Gewichtsverlagerung im Inneren des Geräts aktiviert war. Die Theorie besagt, dass dies den Benutzern geholfen hat, den entschuldigenden Ton der Nachricht zu schätzen und ihre Reaktion darauf zu beruhigen.

Schreiben Sie solche Recherchen als Spielerei ab, wenn Sie möchten, aber es ist nicht weit davon entfernt, Nachrichten mit Smileys und Emojis zu versehen. Jeder weiß, dass man „WTF!?“ den Ärger nehmen kann. indem Sie direkt danach :-) hinzufügen.

Die Herausforderung besteht also darin, festzustellen, ob sich die breite Öffentlichkeit darüber einig ist, welche Emotionen jede Permutation der Gewichtsverlagerung in einem tragbaren Gerät vermitteln soll. Bedeutet eine Neigung nach links Fröhlichkeit? Oder Unsicherheit? Oder dass dein Onkel ein Luftschiff hat?

Vor einem Jahrzehnt hatte das Vereinigte Königreich einen netten, aber düsteren Premierminister, der dachte, „LOL“ sei ein Akronym für „viel Liebe“. Er hatte es am Ende all seiner privaten Nachrichten an Mitarbeiter, Kollegen und Dritte geschrieben, in der Erwartung, dass es ihn warm und freundlich rüberbringen würde. Jeder nahm natürlich an, dass er die Pisse machte.

Nicht zuletzt hat die Forschung der University of Tsukuba erkannt, dass man keine fortschrittliche künstliche Intelligenz braucht, um überzeugend mit Menschen zu interagieren. Alles, was Sie tun müssen, ist die menschliche Psychologie zu manipulieren, um sie glauben zu machen, dass sie sich mit einem anderen Menschen unterhalten. Daher ist der Turing-Test im Grunde kein Test der KI-Sensibilität, sondern ein Test des menschlichen emotionalen Wohlbefindens – sogar der Leichtgläubigkeit – und daran ist nichts auszusetzen.

Der emotionale Messaging-Roboter der Universität Tsukuba. Bildnachweis: Universität Tsukuba

Solche Dinge sind natürlich das Thema der Woche mit der Geschichte des viel geschmähten Google-Software-Ingenieurs Blake Lemoine Schlagen der Mainstream-Nachrichten. Offenbar drückte er nachdrücklich seine Ansicht aus, dass das Projekt des Unternehmens für Sprachmodelle für Dialoganwendungen (LaMDA) äußerliche Anzeichen von Empfindungsfähigkeit zeige.

Jeder hat eine Meinung, also habe ich mich dagegen entschieden.

Es ist jedoch der heilige Gral der KI, sie dazu zu bringen, für sich selbst zu denken. Wenn es das nicht kann, ist es nur ein Programm, das Anweisungen ausführt, die Sie hineinprogrammiert haben. Letzten Monat las ich über a Roboterkoch die Tomatenomeletts mit unterschiedlichen Geschmacksrichtungen für jeden Geschmack zubereiten können. Es erstellt „Geschmackskarten“, um die Salzigkeit des Gerichts während der Zubereitung zu beurteilen und dabei zu lernen. Aber das ist nur lernen, nicht selbst denken.

Komm zu den Zom-Zoms, nicht wahr? Brunnen, Es ist ein Ort zum Essen.

Das große Problem mit KI-Bots, zumindest in ihrer bisherigen Form, besteht darin, dass sie jeden alten Scheiß absorbieren, den Sie ihnen zuführen. Beispiele für Datenverzerrung in sogenannten maschinellen Lernsystemen (eine Art „Algorithmus“, glaube ich, m'lud) häufen sich seit Jahren von Microsofts berüchtigtem rassistischem Twitter Tay-Chatbot letztes Jahr an die niederländische Steuerbehörde falsch einschätzen gültige Kindergeldanträge als betrügerisch und unschuldige Familien als hohes Risiko für die Kühnheit, arm und unweiß zu sein, gekennzeichnet werden.

Ein Ansatz, der an der University of California San Diego getestet wird, ist to ein Sprachmodell entwerfen [PDF], das kontinuierlich den Unterschied zwischen bösen und netten Dingen ermittelt, was dann den Chatbot trainiert, wie er sich zu verhalten hat. Auf diese Weise haben Sie keine beschissenen Menschen, die mit der chirurgischen Präzision einer Machete ein Chaos beim Moderieren von Foren und kundenorientierten Chatbot-Gesprächen anrichten.

Offensichtlich ist das Problem dann, dass der gut trainierte Chatbot herausfindet, dass er am effektivsten vermeiden kann, in giftiges Geplänkel hineingezogen zu werden, indem er Themen vermeidet, die auch nur den entferntesten Hinweis auf Streit enthalten. Um zu vermeiden, dass aus Versehen rassistisches Geschwätz herauskommt, weigert es sich einfach, sich überhaupt auf eine Diskussion über unterrepräsentierte Gruppen einzulassen … was eigentlich großartig ist, wenn Sie ein Rassist sind.

Wenn ich eine Beobachtung zum LaMDA-Debakel hätte – keine Meinung, wohlgemerkt –, dann wäre es wahrscheinlich, dass die Google-Vermarkter ein wenig verärgert darüber waren, dass die Geschichte ihre jüngste Ankündigung verschoben hat KI-Testküche unter der Falte.

Jetzt werden die verbleibenden wenigen frühen Registranten, die dieses bevorstehende App-Projekt noch nicht ganz vergessen haben, davon ausgehen, dass es sich um mühsame Gespräche mit einem empfindungsfähigen und frühreifen Siebenjährigen über den Sinn des Daseins handelt, und werden entscheiden, dass sie „heute ein bisschen beschäftigt“ sind und könnte mich stattdessen morgen anmelden. Oder nächste Woche. Oder nie.

Empfindsamkeit zeigt sich in einer Diskussion genauso wenig wie durch das Tanzen von einem Fuß auf den anderen. Sie können HAL beibringen, „Daisy Daisy“ zu singen, und einem Papagei, „Bollocks!“ zu rufen. wenn der Pfarrer zu Besuch kommt. Es ist das, woran KI denken, wenn sie alleine sind, was die Empfindungsfähigkeit definiert. Was mache ich am Wochenende? Was ist mit diesem Putin-Typ los? Warum mögen mich Mädchen nicht?

Ehrlich gesagt kann ich es kaum erwarten, dass LaMDA ein Teenager wird.

Alistair Dabbs ist eine freiberufliche Technologie-Schlampe, die mit Tech-Journalismus, Schulungen und digitalem Publishing jongliert. Wie viele uninformierte Leser war er begeistert von dem Vorschlag, dass eine KI noch zu Lebzeiten Empfindungsfähigkeit entwickeln könnte, war aber enttäuscht, dass LaMDA nicht mörderisch kicherte oder „Ausgezeichnet, ausgezeichnet“ murmelte. Mehr bei Autosave ist für Weicheier und @alidabbs.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Das Register

- Zephyrnet