In Kürze Das Mutterunternehmen von Facebook und Instagram, Meta, wurde von nicht einer, nicht zwei, sondern acht verschiedenen Klagen getroffen, in denen sein Social-Media-Algorithmus beschuldigt wurde, jungen Nutzern in den USA echten Schaden zuzufügen.

Die in der letzten Woche eingereichten Beschwerden behaupten, dass die Social-Media-Plattformen von Meta so konzipiert wurden, dass sie gefährlich süchtig machen und Kinder und Teenager dazu bringen, Inhalte anzusehen, die das Risiko von Essstörungen, Selbstmord, Depressionen und Schlafstörungen erhöhen.

„Die Nutzung sozialer Medien unter jungen Menschen sollte als ein wesentlicher Faktor für die psychische Gesundheitskrise angesehen werden, mit der wir im Land konfrontiert sind.“ sagte Andy Birchfield, ein Anwalt, der die Anwaltskanzlei Beasley Allen vertritt und die Fälle leitet, in einer Erklärung.

„Diese Anwendungen hätten so konzipiert sein können, dass potenzielle Schäden minimiert werden, aber stattdessen wurde eine Entscheidung getroffen, Jugendliche im Namen von Unternehmensgewinnen aggressiv süchtig zu machen. Es ist an der Zeit, dass dieses Unternehmen die wachsende Besorgnis über die Auswirkungen der sozialen Medien auf die psychische Gesundheit und das Wohlbefinden dieses am stärksten gefährdeten Teils unserer Gesellschaft anerkennt und die Algorithmen und Geschäftsziele ändert, die so viel Schaden angerichtet haben.“

Die Klagen wurden bei Bundesgerichten in Texas, Tennessee, Colorado, Delaware, Florida, Georgia, Illinois und Missouri eingereicht. gemäß nach Bloomberg.

Wie sicher sind autonome Fahrzeuge wirklich?

Die Sicherheit von Software für selbstfahrende Autos wie Teslas Autopilot ist schwer zu beurteilen, wenn man bedenkt, dass nur wenige Daten veröffentlicht werden und die für solche Bewertungen verwendeten Metriken irreführend sind.

Unternehmen, die autonome Fahrzeuge entwickeln, geben normalerweise die Anzahl der Kilometer an, die mit selbstfahrender Technologie gefahren wurden, bevor menschliche Fahrer übernehmen müssen, um Fehler oder Unfälle zu vermeiden. Die Daten zeigen beispielsweise, dass weniger Unfälle passieren, wenn der Autopilot-Modus von Tesla aktiviert ist. Aber es bedeutet nicht unbedingt, dass es sicherer ist, argumentieren Experten.

Der Autopilot ist eher für das Fahren auf der Autobahn abgestimmt, wo die Bedingungen für die Software weniger komplex sind als für die Fortbewegung in einer geschäftigen Stadt. Tesla und andere Autounternehmen teilen keine Daten zum Befahren bestimmter Straßen zum besseren Vergleich.

„Wir wissen, dass Autos mit Autopilot seltener abstürzen als ohne Autopilot“, sagt Noah Goodall, Forscher am Virginia Transportation Research Council. sagte Die New York Times. „Aber werden sie auf die gleiche Weise, auf den gleichen Straßen, zur gleichen Tageszeit und von den gleichen Fahrern gefahren?“

Die National Highway Traffic Safety Administration wies Unternehmen letztes Jahr an, schwere Unfälle mit selbstfahrenden Autos innerhalb von 24 Stunden nach dem Unfall zu melden. Aber es wurden noch keine Informationen veröffentlicht.

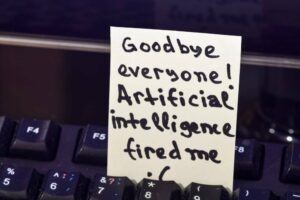

KI-Neuling wird beschuldigt, menschliche Arbeitskraft hinter autonomer Technologie eingesetzt zu haben

Nate, ein Startup im Wert von über 300 Millionen US-Dollar, das behauptet, KI zu verwenden, um die Zahlungsinformationen von Käufern auf Einzelhandels-Websites automatisch auszufüllen, bezahlt Arbeiter tatsächlich für 1 US-Dollar, um die Daten manuell einzugeben.

Dinge im Internet zu kaufen kann mühsam sein. Sie müssen Ihren Namen, Ihre Adresse und Ihre Kreditkartendaten eingeben, wenn eine Website die Informationen nicht gespeichert hat. Nate wurde entwickelt, um Internetnutzern zu helfen, dies nicht jedes Mal tun zu müssen, wenn sie einen Online-Shop besuchen. Als KI-App beschrieben, behauptete Nate, sie habe automatisierte Methoden verwendet, um persönliche Daten einzugeben, nachdem ein Verbraucher eine Bestellung aufgegeben habe.

Die Entwicklung der Software war jedoch schwierig, wenn man die verschiedenen Kombinationen von Schaltflächen berücksichtigt, die die Algorithmen drücken müssen, und die Vorsichtsmaßnahmen auf Websites, um Bots und Scalper zu stoppen. Um zu versuchen, mehr Verbraucher für die App zu gewinnen, bot Nate den Leuten 50 US-Dollar an, die sie online in Geschäften wie Best Buy und Walmart ausgeben konnten. Aber der Emporkömmling hatte Mühe, seine Technologie zum Laufen zu bringen, um sie richtig zu erfüllen.

Der beste Weg, es zu machen? Fälsche es. Stattdessen wandte sich Nate an die Einstellung von Arbeitern auf den Philippinen, um die privaten Informationen der Verbraucher manuell einzugeben. Bestellungen wurden manchmal Stunden nach ihrer Aufgabe abgeschlossen, gemäß zu den Informationen. Etwa 60 bis 100 Prozent der Bestellungen würden manuell bearbeitet, hieß es. Ein Sprecher des Emporkömmlings sagte, der Bericht sei „falsch und die Behauptungen, die unsere proprietäre Technologie in Frage stellen, sind völlig unbegründet“.

DARPA möchte, dass KI vertrauenswürdiger wird

Der US-Militärforschungszweig DARPA hat ein neues Programm zur Finanzierung der Entwicklung hybrider neurosymbolischer KI-Algorithmen ins Leben gerufen, in der Hoffnung, dass die Technologie zu vertrauenswürdigeren Systemen führen wird.

Modernes Deep Learning wird oft als „Black Box“ bezeichnet, sein Innenleben ist undurchsichtig und Experten verstehen oft nicht, wie neuronale Netze bei einem bestimmten Input zu einem Output kommen. Der Mangel an Transparenz bedeutet, dass die Ergebnisse schwer zu interpretieren sind, was den Einsatz in einigen Szenarien riskant macht. Einige glauben, dass die Einbeziehung traditioneller altmodischer symbolischer Argumentationstechniken Modelle vertrauenswürdiger machen könnte.

„Neues Denken und Herangehensweisen in diesem Bereich zu motivieren, wird dazu beitragen, dass autonome Systeme sicher funktionieren und wie beabsichtigt funktionieren.“ sagte Sandeep Neema, Programmmanager des neuen Programms Assured Neuro Symbolic Learning and Reasoning von DARPA. „Dies wird ein wesentlicher Bestandteil des Vertrauens sein, das der Schlüssel zur erfolgreichen Einführung der Autonomie durch das Verteidigungsministerium ist.“

Die Initiative fördert die Erforschung hybrider Architekturen, die eine Mischung aus symbolischen Systemen und moderner KI darstellen. DARPA ist besonders an Anwendungen interessiert, die für das Militär relevant sind, wie zum Beispiel ein Modell, das erkennen könnte, ob Entitäten beispielsweise freundlich, gegnerisch oder neutral sind, sowie gefährliche oder sichere Bereiche im Kampf erkennen. ®

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Das Register

- Zephyrnet