Weltweit hat sich eine beschleunigte Verlagerung hin zu reibungslosen digitalen Benutzererlebnissen vollzogen. Ob es sich um die Registrierung auf einer Website, Online-Transaktionen oder das einfache Anmelden bei Ihrem Bankkonto handelt, Unternehmen versuchen aktiv, die Reibungsverluste ihrer Kunden zu verringern und gleichzeitig ihre Sicherheits-, Compliance- und Betrugspräventionsmaßnahmen zu verbessern. Der Wandel hin zu reibungslosen Benutzererlebnissen hat zu gesichtsbasierten Lösungen zur biometrischen Identitätsprüfung geführt, die darauf abzielen, die Frage „Wie verifiziert man eine Person in der digitalen Welt?“ zu beantworten.

Es gibt zwei entscheidende Vorteile der Gesichtsbiometrie, wenn es um Fragen der Identifizierung und Authentifizierung geht. Erstens ist es eine bequeme Technologie für Benutzer: Sie müssen sich kein Passwort merken, sich nicht mit Multi-Faktor-Herausforderungen auseinandersetzen, auf Verifizierungslinks klicken oder CAPTCHA-Rätsel lösen. Zweitens wird ein hohes Maß an Sicherheit erreicht: Die Identifizierung und Authentifizierung auf Basis von Gesichtsbiometrie ist sicher und weniger anfällig für Betrug und Angriffe.

In diesem Beitrag tauchen wir in die zwei primären Anwendungsfälle der Identitätsprüfung ein: Onboarding und Authentifizierung. Dann tauchen wir in die zwei Schlüsselkennzahlen ein, die zur Bewertung der Genauigkeit eines biometrischen Systems verwendet werden: die Rate falscher Übereinstimmungen (auch bekannt als Rate falscher Annahmen) und die Rate falscher Nichtübereinstimmungen (auch bekannt als Rate falscher Ablehnungen). Diese beiden Maße werden von Organisationen häufig verwendet, um die Genauigkeit und Fehlerrate biometrischer Systeme zu bewerten. Abschließend diskutieren wir einen Rahmen und Best Practices für die Durchführung einer Bewertung eines Identitätsprüfungsdienstes.

Siehe Beilage Jupyter Notizbuch die alle in diesem Beitrag erwähnten Schritte durchläuft.

Anwendungsfälle: Onboarding und Authentifizierung

Es gibt zwei primäre Anwendungsfälle für biometrische Lösungen: Benutzer-Onboarding (oft als Verifizierung bezeichnet) und Authentifizierung (oft als Identifizierung bezeichnet). Das Onboarding beinhaltet den Eins-zu-eins-Abgleich von Gesichtern zwischen zwei Bildern, z. B. den Vergleich eines Selfies mit einem vertrauenswürdigen Ausweisdokument wie einem Führerschein oder Reisepass. Andererseits beinhaltet die Authentifizierung eine Eins-zu-Viele-Suche eines Gesichts gegen eine gespeicherte Sammlung von Gesichtern, beispielsweise das Durchsuchen einer Sammlung von Mitarbeitergesichtern, um zu sehen, ob ein Mitarbeiter berechtigt ist, Zugang zu einem bestimmten Stockwerk in einem Gebäude zu haben.

Die Genauigkeitsleistung von Onboarding- und Authentifizierungsanwendungsfällen wird anhand der falsch positiven und falsch negativen Fehler gemessen, die die biometrische Lösung machen kann. Eine Ähnlichkeitspunktzahl (von 0 %, was keine Übereinstimmung bedeutet, bis 100 %, was eine perfekte Übereinstimmung bedeutet) wird verwendet, um die Entscheidung über eine Übereinstimmung oder eine Nicht-Übereinstimmung zu treffen. Ein falsch positives Ergebnis tritt auf, wenn die Lösung Bilder von zwei verschiedenen Personen als dieselbe Person betrachtet. Ein falsches Negativ hingegen bedeutet, dass die Lösung zwei Bilder derselben Person als unterschiedlich betrachtet hat.

Onboarding: Eins-zu-eins-Verifizierung

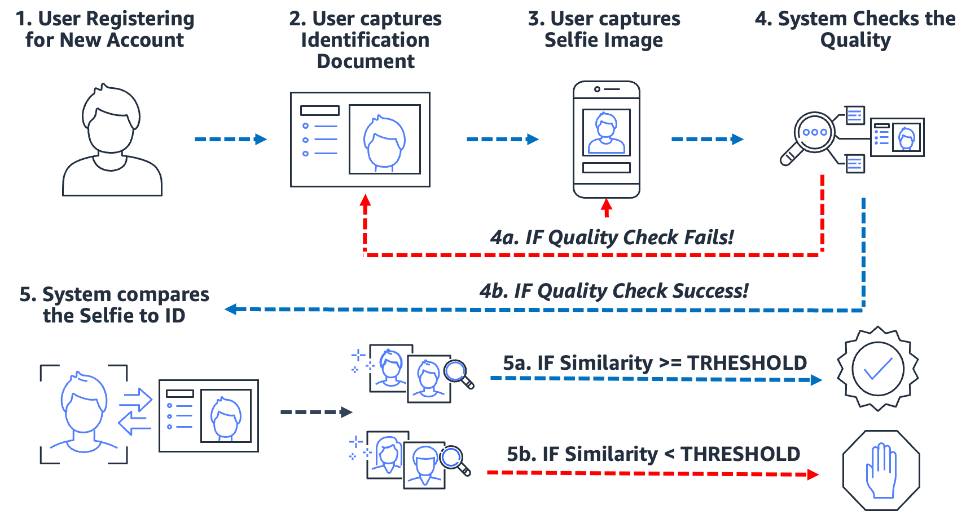

Biometriebasierte Onboarding-Prozesse vereinfachen und sichern den Prozess. Am wichtigsten ist, dass es die Organisation und den Kunden auf ein nahezu reibungsloses Onboarding-Erlebnis vorbereitet. Dazu müssen die Benutzer lediglich ein Bild eines vertrauenswürdigen Ausweisdokuments mit dem Gesicht des Benutzers (z. B. Führerschein oder Reisepass) vorlegen und während des Onboarding-Prozesses ein Selfie-Bild machen. Nachdem das System diese zwei Bilder hat, vergleicht es einfach die Gesichter innerhalb der zwei Bilder. Wenn die Ähnlichkeit größer als ein bestimmter Schwellenwert ist, haben Sie eine Übereinstimmung; andernfalls haben Sie eine Nichtübereinstimmung. Das folgende Diagramm skizziert den Prozess.

Betrachten Sie das Beispiel von Julie, einer neuen Benutzerin, die ein digitales Bankkonto eröffnet. Die Lösung fordert sie auf, ein Foto ihres Führerscheins zu machen (Schritt 2) und ein Selfie zu machen (Schritt 3). Nachdem das System die Qualität der Bilder überprüft hat (Schritt 4), vergleicht es das Gesicht auf dem Selfie mit dem Gesicht auf dem Führerschein (Eins-zu-Eins-Abgleich) und erstellt einen Ähnlichkeitswert (Schritt 5). Wenn der Ähnlichkeitswert unter dem erforderlichen Ähnlichkeitsschwellenwert liegt, wird der Onboarding-Versuch von Julie abgelehnt. Dies nennen wir eine falsche Nichtübereinstimmung oder falsche Ablehnung: Die Lösung betrachtete zwei Bilder derselben Person als unterschiedlich. Wenn andererseits der Ähnlichkeitswert größer als die erforderliche Ähnlichkeit war, betrachtet die Lösung die beiden Bilder als dieselbe Person oder als Übereinstimmung.

Authentifizierung: One-to-many-Identifikation

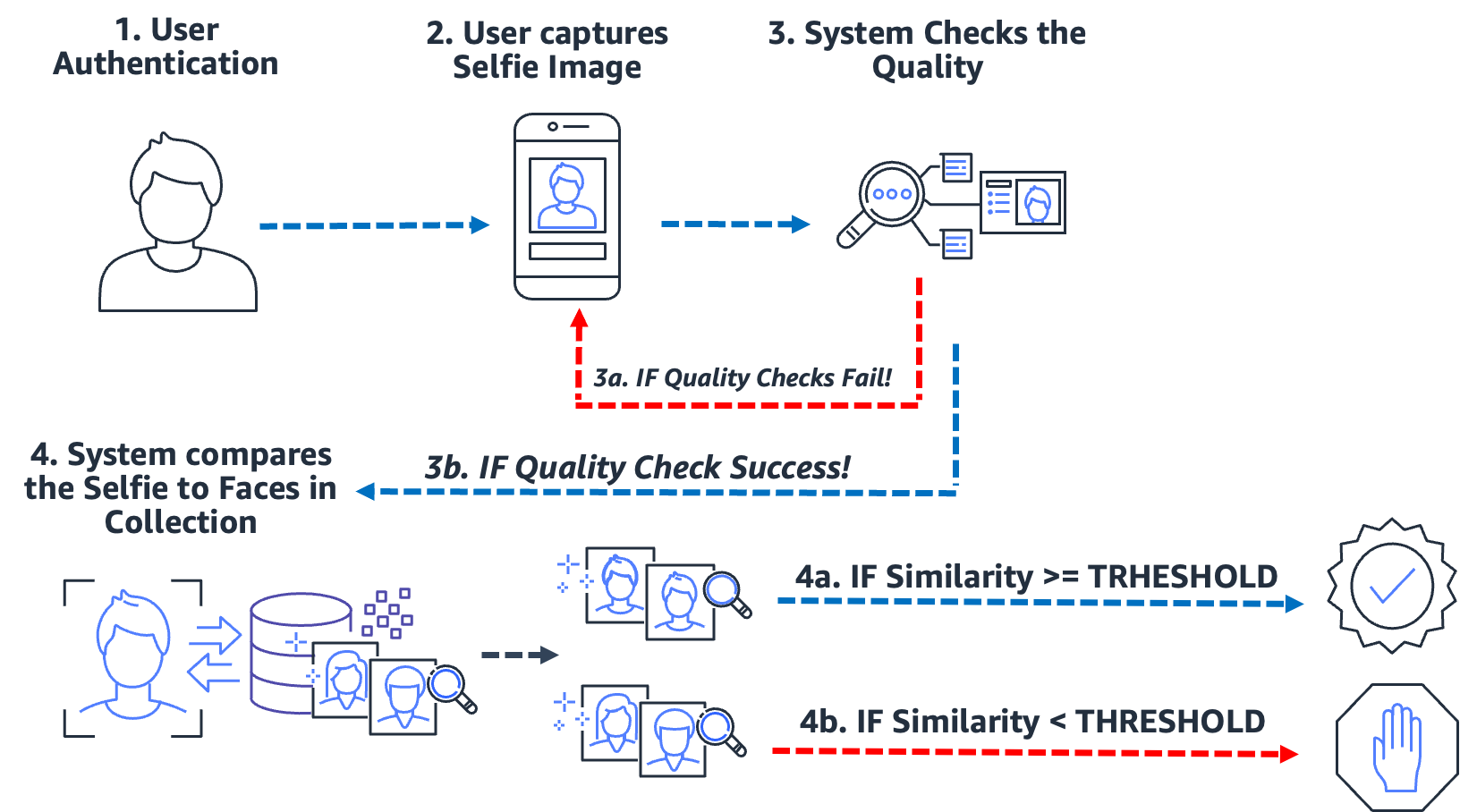

Vom Betreten eines Gebäudes über das Einchecken an einem Kiosk bis hin zur Aufforderung eines Benutzers, ein Selfie zu machen, um seine Identität zu bestätigen, ist diese Art der reibungslosen Authentifizierung über Gesichtserkennung für viele Unternehmen alltäglich geworden. Anstatt einen Bild-zu-Bild-Abgleich durchzuführen, nimmt dieser Authentifizierungs-Anwendungsfall ein einzelnes Bild und vergleicht es mit einer durchsuchbaren Sammlung von Bildern auf eine mögliche Übereinstimmung. In einem typischen Anwendungsfall für die Authentifizierung wird der Benutzer aufgefordert, ein Selfie zu machen, das dann mit den in der Sammlung gespeicherten Gesichtern verglichen wird. Das Ergebnis der Suche ergibt null, eine oder mehrere potenzielle Übereinstimmungen mit entsprechenden Ähnlichkeitsbewertungen und externen Identifikatoren. Wenn keine Übereinstimmung zurückgegeben wird, wird der Benutzer nicht authentifiziert; jedoch unter der Annahme, dass die Suche eine oder mehrere Übereinstimmungen zurückgibt, trifft das System die Authentifizierungsentscheidung basierend auf den Ähnlichkeitsbewertungen und externen Identifikatoren. Wenn die Ähnlichkeitspunktzahl den erforderlichen Ähnlichkeitsschwellenwert überschreitet und die externe Kennung mit der erwarteten Kennung übereinstimmt, wird der Benutzer authentifiziert (gematcht). Das folgende Diagramm skizziert ein Beispiel für einen gesichtsbasierten biometrischen Authentifizierungsprozess.

Betrachten Sie das Beispiel von Jose, einem Gig-Economy-Lieferfahrer. Der Lieferdienst authentifiziert Lieferfahrer, indem er den Fahrer auffordert, ein Selfie zu machen, bevor er mit der mobilen Anwendung des Unternehmens mit der Lieferung beginnt. Ein Problem für Gig-Economy-Dienstleister ist das Jobsharing; Im Wesentlichen teilen sich zwei oder mehr Benutzer dasselbe Konto, um das System zu spielen. Um dem entgegenzuwirken, verwenden viele Lieferdienste eine Kamera im Auto, um Bilder (Schritt 2) des Fahrers zu zufälligen Zeiten während einer Lieferung aufzunehmen (um sicherzustellen, dass der Lieferfahrer der autorisierte Fahrer ist). In diesem Fall macht Jose nicht nur zu Beginn seiner Lieferung ein Selfie, sondern eine Kamera im Auto macht während der Lieferung Bilder von ihm. Das System führt Qualitätsprüfungen durch (Schritt 3) und durchsucht (Schritt 4) die Sammlung von registrierten Fahrern, um die Identität des Fahrers zu verifizieren. Wenn ein anderer Fahrer erkannt wird, kann der Gig-Economy-Lieferservice weitere Nachforschungen anstellen.

Eine falsche Übereinstimmung (falsch positiv) tritt auf, wenn die Lösung zwei oder mehr Bilder von verschiedenen Personen als dieselbe Person betrachtet. Nehmen wir in unserem Anwendungsfall an, dass Jose anstelle des autorisierten Fahrers seinen Bruder Miguel eine seiner Lieferungen für ihn entgegennehmen lässt. Wenn die Lösung Miguels Selfie fälschlicherweise mit den Bildern von Jose abgleicht, kommt es zu einer falschen Übereinstimmung (falsch positiv).

Um dem Potenzial falscher Übereinstimmungen entgegenzuwirken, empfehlen wir, dass Sammlungen mehrere Bilder von jedem Thema enthalten. Es ist üblich, vertrauenswürdige Ausweisdokumente zu indizieren, die ein Gesicht, ein Selfie zum Zeitpunkt des Onboardings und Selfies von den letzten Identitätsprüfungen enthalten. Das Indizieren mehrerer Bilder eines Motivs bietet die Möglichkeit, die Ähnlichkeitswerte über die zurückgegebenen Gesichter hinweg zu aggregieren, wodurch die Genauigkeit der Identifizierung verbessert wird. Zusätzlich werden externe Identifikatoren verwendet, um das Risiko einer falschen Annahme zu begrenzen. Eine beispielhafte Geschäftsregel könnte etwa so aussehen:

WENN aggregierter Ähnlichkeitswert >= erforderlicher Ähnlichkeitsschwellenwert UND externe Kennung == erwartete Kennung DANN authentifizieren

Wichtige biometrische Genauigkeitsmaße

In einem biometrischen System interessieren wir uns für die False-Match-Rate (FMR) und die False-Non-Match-Rate (FNMR) basierend auf den Ähnlichkeitswerten aus Gesichtsvergleichen und Suchen. Unabhängig davon, ob es sich um einen Onboarding- oder Authentifizierungsanwendungsfall handelt, entscheiden biometrische Systeme basierend auf dem Ähnlichkeitswert von zwei oder mehr Bildern, ob Übereinstimmungen mit dem Gesicht eines Benutzers akzeptiert oder abgelehnt werden. Wie bei jedem Entscheidungssystem treten Fehler auf, wenn das System einen Onboarding- oder Authentifizierungsversuch fälschlicherweise akzeptiert oder ablehnt. Als Teil der Bewertung Ihrer Identitätsprüfungslösung müssen Sie das System anhand verschiedener Ähnlichkeitsschwellenwerte bewerten, um die Rate falscher Übereinstimmungen und falscher Nichtübereinstimmungen zu minimieren und diese Fehler den Kosten für falsche Ablehnungen und Annahmen gegenüberzustellen. Wir verwenden FMR und FNMR als unsere beiden wichtigsten Metriken zur Bewertung gesichtsbiometrischer Systeme.

Falsche Non-Match-Rate

Wenn das Identitätsprüfungssystem einen echten Benutzer nicht korrekt identifiziert oder autorisiert, tritt eine falsche Nichtübereinstimmung auf, die auch als falsches Negativ bezeichnet wird. Die False-Non-Match-Rate (FNMR) ist ein Maß dafür, wie anfällig das System ist, einen echten Benutzer falsch zu identifizieren oder zu autorisieren.

Die FNMR wird als Prozentsatz der Fälle ausgedrückt, in denen ein Onboarding- oder Authentifizierungsversuch unternommen wird, bei denen das Gesicht des Benutzers fälschlicherweise abgelehnt wird (ein falsches Negativ), weil der Ähnlichkeitswert unter dem vorgeschriebenen Schwellenwert liegt.

Ein echtes Positiv (TP) liegt vor, wenn die Lösung zwei oder mehr Bilder derselben Person als identisch betrachtet. Das heißt, die Ähnlichkeit des Vergleichs oder der Suche liegt über der erforderlichen Ähnlichkeitsschwelle.

Ein falsches Negativ (FN) liegt vor, wenn die Lösung zwei oder mehr Bilder derselben Person als unterschiedlich betrachtet. Das heißt, die Ähnlichkeit des Vergleichs oder der Suche liegt unterhalb der erforderlichen Ähnlichkeitsschwelle.

Die Formel für die FNMR lautet:

FNMR = Falsch-Negativ-Zählung / (Richtig-Positiv-Zählung + Falsch-Negativ-Zählung)

Angenommen, wir haben 10,000 echte Authentifizierungsversuche, aber 100 werden abgelehnt, weil ihre Ähnlichkeit mit dem Referenzbild oder der Sammlung unter den angegebenen Ähnlichkeitsschwellenwert fällt. Hier haben wir 9,900 richtig Positive und 100 falsch Negative, daher beträgt unser FNMR 1.0 %.

FNMR = 100 / (9900 + 100) oder 1.0 %

Falsche Übereinstimmungsrate

Wenn ein Identitätsprüfungssystem einen nicht autorisierten Benutzer fälschlicherweise als echt identifiziert oder autorisiert, kommt es zu einer falschen Übereinstimmung, die auch als falsch positives Ergebnis bezeichnet wird. Die False-Match-Rate (FMR) ist ein Maß dafür, wie anfällig das System ist, einen nicht autorisierten Benutzer falsch zu identifizieren oder zu autorisieren. Sie wird anhand der Anzahl der falsch positiven Erkennungen oder Authentifizierungen geteilt durch die Gesamtzahl der Identifizierungsversuche gemessen.

Ein falsch positives Ergebnis tritt auf, wenn die Lösung zwei oder mehr Bilder von verschiedenen Personen als dieselbe Person betrachtet. Das heißt, der Ähnlichkeitswert des Vergleichs oder der Suche liegt über dem erforderlichen Ähnlichkeitsschwellenwert. Im Wesentlichen identifiziert oder autorisiert das System einen Benutzer falsch, wenn es seinen Identifizierungs- oder Authentifizierungsversuch hätte ablehnen sollen.

Die Formel für den FMR lautet:

FMR = False Positive Count / (Gesamtversuche)

Angenommen, wir haben 100,000 Authentifizierungsversuche, aber 100 Scheinbenutzer werden fälschlicherweise autorisiert, weil ihre Ähnlichkeit mit dem Referenzbild oder der Sammlung über den angegebenen Ähnlichkeitsschwellenwert fällt. Hier haben wir 100 falsch positive Ergebnisse, daher beträgt unser FMR 0.01 %

FMR = 100 / (100,000) oder 0.01 %

Falsche Übereinstimmungsrate vs. falsche Nicht-Übereinstimmungsrate

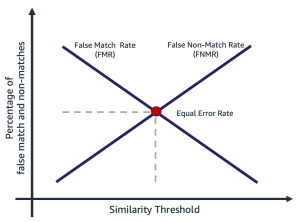

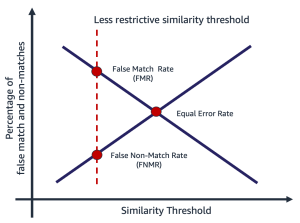

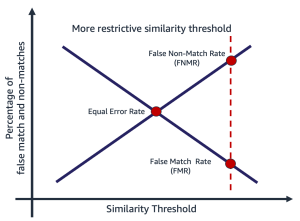

False-Match-Rate und False-Non-Match-Rate stehen im Widerspruch zueinander. Wenn die Ähnlichkeitsschwelle ansteigt, nimmt das Potenzial für eine falsche Übereinstimmung ab, während das Potenzial für eine falsche Nichtübereinstimmung zunimmt. Eine andere Möglichkeit, über diesen Kompromiss nachzudenken, besteht darin, dass die Lösung mit zunehmender Ähnlichkeitsschwelle restriktiver wird und weniger Übereinstimmungen mit geringer Ähnlichkeit erzeugt. Beispielsweise ist es für Anwendungsfälle im Zusammenhang mit öffentlicher Sicherheit üblich, einen Übereinstimmungsähnlichkeitsschwellenwert ziemlich hoch festzulegen (99 und höher). Alternativ kann eine Organisation einen weniger restriktiven Ähnlichkeitsschwellenwert (90 und höher) wählen, wenn die Auswirkungen der Reibung auf den Benutzer wichtiger sind. Das folgende Diagramm veranschaulicht diese Kompromisse. Die Herausforderung für Organisationen besteht darin, einen Schwellenwert zu finden, der sowohl FMR als auch FNMR basierend auf Ihren Organisations- und Anwendungsanforderungen minimiert.

Die Auswahl eines Ähnlichkeitsschwellenwerts hängt von der Geschäftsanwendung ab. Nehmen wir beispielsweise an, Sie möchten die Reibung der Kunden während des Onboardings begrenzen (ein weniger restriktiver Ähnlichkeitsschwellenwert, wie in der folgenden Abbildung links gezeigt). Hier haben Sie möglicherweise eine niedrigere erforderliche Ähnlichkeitsschwelle und sind bereit, das Risiko einzugehen, Benutzer einzubinden, bei denen das Vertrauen in die Übereinstimmung zwischen ihrem Selfie und dem Führerschein geringer ist. Angenommen, Sie möchten sicherstellen, dass nur autorisierte Benutzer auf eine Anwendung zugreifen. Hier können Sie mit einer ziemlich restriktiven Ähnlichkeitsschwelle arbeiten (wie in der Abbildung rechts gezeigt).

|

|

Schritte zum Berechnen der Quoten für falsche Übereinstimmungen und Nichtübereinstimmungen

Es gibt mehrere Möglichkeiten, diese beiden Metriken zu berechnen. Das Folgende ist ein relativ einfacher Ansatz zum Aufteilen der Schritte in das Sammeln echter Bildpaare, das Erstellen einer falschen Paarung (Bilder, die nicht übereinstimmen sollten) und schließlich die Verwendung einer Sonde, um die erwarteten übereinstimmenden und nicht übereinstimmenden Bildpaare zu durchlaufen und die zu erfassen resultierende Ähnlichkeit. Die Schritte sind wie folgt:

- Sammeln Sie einen echten Musterbildsatz. Wir empfehlen, mit einem Satz von Bildpaaren zu beginnen und eine externe Kennung zuzuweisen, die für eine offizielle Übereinstimmungsbestimmung verwendet wird. Das Paar besteht aus den folgenden Bildern:

- Quellbild – Ihr vertrauenswürdiges Quellbild, zum Beispiel ein Führerschein.

- Zielbild – Ihr Selfie oder Bild, mit dem Sie vergleichen möchten.

- Sammeln Sie einen Bildsatz von Streichhölzern. Dies sind Bildpaare, bei denen Quelle und Ziel nicht übereinstimmen. Dies wird verwendet, um den FMR zu bewerten (die Wahrscheinlichkeit, dass das System die Gesichter von zwei verschiedenen Benutzern falsch abgleicht). Sie können mithilfe der Bildpaare einen betrügerischen Bildsatz erstellen, indem Sie ein kartesisches Produkt der Bilder erstellen und dann das Ergebnis filtern und abtasten.

- Untersuchen Sie die echten und gefälschten Übereinstimmungssätze, indem Sie die Bildpaare durchlaufen, die Quelle und das gefälschte Ziel vergleichen und die resultierende Ähnlichkeit erfassen.

- Berechnen Sie FMR und FNMR, indem Sie die falsch positiven und falsch negativen Ergebnisse bei unterschiedlichen minimalen Ähnlichkeitsschwellen berechnen.

Sie können die Kosten von FMR und FNMR bei unterschiedlichen Ähnlichkeitsschwellenwerten relativ zu den Anforderungen Ihrer Anwendung bewerten.

Schritt 1: Sammeln Sie echte Muster von Bildpaaren

Die Auswahl einer repräsentativen Stichprobe von zu bewertenden Bildpaaren ist bei der Bewertung eines Identitätsprüfungsdienstes von entscheidender Bedeutung. Der erste Schritt besteht darin, einen echten Satz von Bildpaaren zu identifizieren. Dies sind bekannte Quell- und Zielbilder eines Benutzers. Die echte Bildpaarung wird verwendet, um die FNMR zu bewerten, im Wesentlichen die Wahrscheinlichkeit, dass das System zwei Gesichter derselben Person nicht abgleicht. Eine der ersten oft gestellten Fragen lautet: „Wie viele Bildpaare sind notwendig?“ Die Antwort ist, dass es von Ihrem Anwendungsfall abhängt, aber die allgemeine Anleitung lautet wie folgt:

- Zwischen 100 und 1,000 Bildpaare liefern ein Maß für die Machbarkeit

- Bis zu 10,000 Bildpaare sind groß genug, um die Variabilität zwischen Bildern zu messen

- Mehr als 10,000 Bildpaare bieten ein Maß für die Betriebsqualität und Verallgemeinerbarkeit

Mehr Daten sind immer besser; Verwenden Sie jedoch als Ausgangspunkt mindestens 1,000 Bildpaare. Es ist jedoch nicht ungewöhnlich, mehr als 10,000 Bildpaare zu verwenden, um ein akzeptables FNMR oder FMR für ein bestimmtes Geschäftsproblem zu ermitteln.

Im Folgenden finden Sie eine Beispieldatei für die Zuordnung von Bildpaaren. Wir verwenden die Bildpaar-Zuordnungsdatei, um den Rest des Bewertungsprozesses voranzutreiben.

| EXTERNE_ID | SOURCE | TARGET | TESTEN |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | echt |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | echt |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | echt |

| 12657 | 12657_M0.jpeg | 12657_M1.jpeg | echt |

| ... | . | . | . |

Schritt 2: Generieren Sie ein Imposter-Bildpaar kompensieren

Nachdem Sie nun eine Datei mit echten Bildpaaren haben, können Sie ein kartesisches Produkt aus Ziel- und Quellbildern erstellen, bei dem die externen Kennungen nicht übereinstimmen. Dies erzeugt Source-to-Target-Paare, die nicht übereinstimmen sollten. Diese Paarung wird verwendet, um den FMR zu bewerten, im Wesentlichen die Wahrscheinlichkeit, dass das System das Gesicht eines Benutzers mit dem Gesicht eines anderen Benutzers abgleicht.

| externe_id | SOURCE | TARGET | TESTEN |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Imposter |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Imposter |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Imposter |

| 281333 | 281333_04F35.jpeg | 314769_01M17.jpeg | Imposter |

| 40081 | 040081_2F52.jpeg | 326169_00F32.jpeg | Imposter |

| ... | . | . | . |

Schritt 3: Untersuchen Sie die Sätze echter und gefälschter Bildpaare

Mit einem Treiberprogramm wenden wir die an Amazon-Anerkennung CompareFaces-API über die Bildpaare und erfassen Sie die Ähnlichkeit. Sie können auch zusätzliche Informationen wie Pose, Qualität und andere Ergebnisse des Vergleichs erfassen. Die Ähnlichkeitsbewertungen werden verwendet, um im folgenden Schritt die Raten für falsche Übereinstimmungen und Nichtübereinstimmungen zu berechnen.

Im folgenden Code-Snippet wenden wir die CompareFaces-API auf alle Bildpaare an und füllen alle Ähnlichkeitswerte in einer Tabelle aus:

Das Code-Snippet liefert die folgende Ausgabe.

| EXTERNE_ID | SOURCE | TARGET | TESTEN | ÄHNLICHKEIT |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | echt | 98.3 |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | echt | 94.3 |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | echt | 96.1 |

| ... | . | . | . | . |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Imposter | 0.0 |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Imposter | 0.0 |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Imposter | 0.0 |

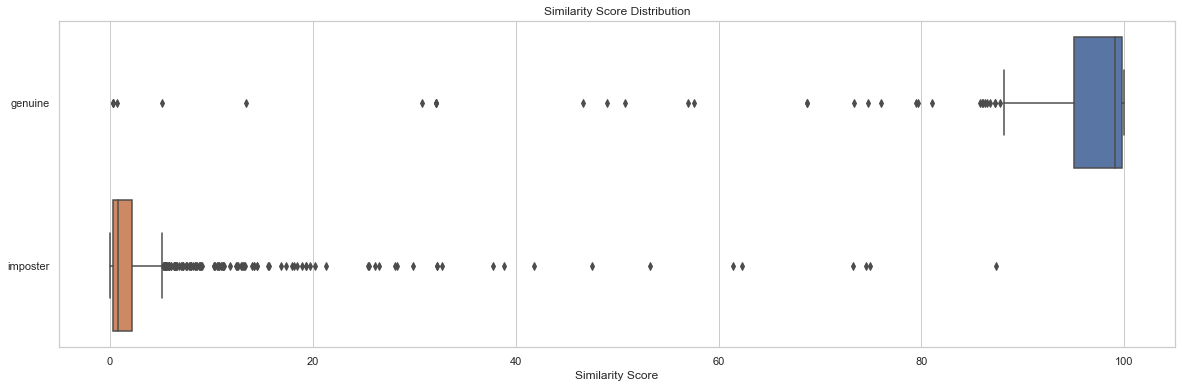

Die Verteilungsanalyse von Ähnlichkeitswerten durch Tests ist ein Ausgangspunkt, um den Ähnlichkeitswert von Bildpaaren zu verstehen. Das folgende Code-Snippet und Ausgabediagramm zeigt ein einfaches Beispiel für die Verteilung des Ähnlichkeitsergebnisses nach Testreihe sowie die daraus resultierenden deskriptiven Statistiken:

| Test | zählen | Min. | max | bedeuten | mittlere | std |

| Richte deinen Sinn auf das, | 204 | 0.2778 | 99.9957 | 91.7357 | 99.0961 | 19.9097 |

| Betrüger | 1020 | 0.0075 | 87.3893 | 2.8111 | 0.8330 | 7.3496 |

In diesem Beispiel können wir sehen, dass die mittlere und mittlere Ähnlichkeit für echte Gesichtspaare 91.7 und 99.1 betrug, während sie für die falschen Paare 2.8 bzw. 0.8 betrug. Wie erwartet zeigt dies die hohen Ähnlichkeitswerte für echte Bildpaare und niedrige Ähnlichkeitswerte für gefälschte Bildpaare.

Schritt 4: Berechnen Sie FMR und FNMR bei unterschiedlichen Ähnlichkeitsschwellenwerten

In diesem Schritt berechnen wir die Raten falscher Übereinstimmungen und Nichtübereinstimmungen bei verschiedenen Ähnlichkeitsschwellenwerten. Dazu durchlaufen wir einfach Ähnlichkeitsschwellenwerte (z. B. 90–100). Bei jeder ausgewählten Ähnlichkeitsschwelle berechnen wir unsere Verwirrungsmatrix, die wahre positive, echte negative, falsche positive und falsche negative Zählungen enthält, die verwendet werden, um die FMR und FNMR bei jeder ausgewählten Ähnlichkeit zu berechnen.

| Tatsächlich | |||

| Predicted | |||

| . | Spiel | Keine Übereinstimmung | |

| >= ausgewählte Ähnlichkeit | TP | FP | |

| < ausgewählte Ähnlichkeit | FN | TN | |

Dazu erstellen wir eine Funktion, die die falsch positiven und negativen Zählwerte zurückgibt, und durchlaufen eine Reihe von Ähnlichkeitswerten (90–100):

Die folgende Tabelle zeigt die Ergebnisse der Zählungen bei jeder Ähnlichkeitsschwelle.

| Ähnlichkeitsschwelle | TN | FN | TP | FP | FNMR | FMR |

| 80 | 1019 | 22 | 182 | 1 | 0.1% | 0.1% |

| 85 | 1019 | 23 | 181 | 1 | 0.11% | 0.1% |

| 90 | 1020 | 35 | 169 | 0 | 0.12% | 0.0% |

| 95 | 1020 | 51 | 153 | 0 | 0.2% | 0.0% |

| 96 | 1020 | 53 | 151 | 0 | 0.25% | 0.0% |

| 97 | 1020 | 60 | 144 | 0 | 0.3% | 0.0% |

| 98 | 1020 | 75 | 129 | 0 | 0.4% | 0.0% |

| 99 | 1020 | 99 | 105 | 0 | 0.5% | 0.0% |

Wie wirkt sich der Ähnlichkeitsschwellenwert auf die Rate falscher Nichtübereinstimmungen aus?

Angenommen, wir haben 1,000 echte Onboarding-Versuche von Benutzern und wir lehnen 10 dieser Versuche basierend auf einer erforderlichen Mindestähnlichkeit von 95 % ab, um als Übereinstimmung betrachtet zu werden. Hier lehnen wir 10 echte Onboarding-Versuche (Falsch-Negative) ab, weil ihre Ähnlichkeit unter die festgelegte minimal erforderliche Ähnlichkeitsschwelle fällt. In diesem Fall beträgt unser FNMR 1.0 %.

| Tatsächlich | |||

| Predicted | |||

| . | Spiel | Keine Übereinstimmung | |

| >= 95 % Ähnlichkeit | 990 | 0 | |

| < 95 % Ähnlichkeit | 10 | 0 | |

| . | gesamt | 1,000 | . |

FNMR = Falsch-Negativ-Zählung / (Richtig-Positiv-Zählung + Falsch-Negativ-Zählung)

FNMR = 10 / (990 + 10) oder 1.0 %

Nehmen wir im Gegensatz dazu an, dass wir statt 1,000 echter Benutzer 990 echte Benutzer und 10 betrügerische Benutzer (falsch positiv) haben. Angenommen, wir akzeptieren bei einer Mindestähnlichkeit von 95 % alle 1,000 Benutzer als echt. Hier hätten wir einen FMR von 1 %.

| Tatsächlich | ||||

| Predicted | ||||

| . | Spiel | Keine Übereinstimmung | gesamt | |

| >= 95 % Ähnlichkeit | 990 | 10 | 1,000 | |

| < 95 % Ähnlichkeit | 0 | 0 | . | |

FMR = False Positive Count / (Gesamtversuche)

FMR = 10 / (1,000) oder 1.0 %

Bewertung der Kosten von FMR und FNMR beim Onboarding

In einem Onboarding-Anwendungsfall sind die Kosten einer falschen Nichtübereinstimmung (einer Ablehnung) im Allgemeinen mit zusätzlichen Benutzerproblemen oder dem Verlust einer Registrierung verbunden. Nehmen wir zum Beispiel an, dass Julie in unserem Banking-Anwendungsfall zwei Bilder von sich präsentiert, aber beim Onboarding fälschlicherweise abgelehnt wird, weil die Ähnlichkeit zwischen den beiden Bildern unter die ausgewählte Ähnlichkeit fällt (eine falsche Nichtübereinstimmung). Das Finanzinstitut riskiert möglicherweise, Julie als potenzielle Kundin zu verlieren, oder es kann Julie zusätzlichen Ärger bereiten, indem es von ihr verlangt, Schritte zum Nachweis ihrer Identität durchzuführen.

Nehmen wir umgekehrt an, dass die beiden Bilder von Julie von unterschiedlichen Personen stammen und Julies Onboarding hätte abgelehnt werden sollen. In dem Fall, in dem Julie fälschlicherweise akzeptiert wird (eine falsche Übereinstimmung), sind die Kosten und das Risiko für das Finanzinstitut ganz anders. Mit Finanztransaktionen können regulatorische Probleme, Betrugsrisiken und andere Risiken verbunden sein.

Verantwortungsvoller Gebrauch

Künstliche Intelligenz (KI), die durch maschinelles Lernen (ML) angewendet wird, wird eine der transformativsten Technologien unserer Generation sein, die einige der schwierigsten Probleme der Menschheit angeht, die menschliche Leistung steigert und die Produktivität maximiert. Der verantwortungsbewusste Umgang mit diesen Technologien ist der Schlüssel zur Förderung kontinuierlicher Innovationen. AWS ist bestrebt, faire und genaue KI- und ML-Services zu entwickeln und Ihnen die Tools und Anleitungen zur Verfügung zu stellen, die zum verantwortungsbewussten Erstellen von KI- und ML-Anwendungen erforderlich sind.

Wenn Sie KI und ML einsetzen und stärker nutzen, bietet AWS basierend auf unserer Erfahrung mehrere Ressourcen an, um Sie bei der verantwortungsvollen Entwicklung und Nutzung von KI und ML zu unterstützen:

Best Practices und häufige Fehler, die es zu vermeiden gilt

In diesem Abschnitt diskutieren wir die folgenden Best Practices:

- Verwenden Sie eine ausreichend große Auswahl an Bildern

- Vermeiden Sie Open-Source- und synthetische Gesichtsdatensätze

- Vermeiden Sie manuelle und synthetische Bildmanipulationen

- Überprüfen Sie die Bildqualität zum Zeitpunkt der Auswertung und im Laufe der Zeit

- Überwachen Sie FMR und FNMR im Laufe der Zeit

- Verwenden Sie eine Human-in-the-Loop-Überprüfung

- Bleiben Sie mit Amazon Rekognition auf dem Laufenden

Verwenden Sie eine ausreichend große Auswahl an Bildern

Verwenden Sie eine ausreichend große, aber angemessene Auswahl an Bildern. Was ist eine angemessene Stichprobengröße? Es kommt auf das Geschäftsproblem an. Wenn Sie ein Arbeitgeber sind und 10,000 Mitarbeiter haben, die Sie authentifizieren möchten, ist es wahrscheinlich sinnvoll, alle 10,000 Bilder zu verwenden. Angenommen, Sie sind ein Unternehmen mit Millionen von Kunden, die Sie an Bord holen möchten. In diesem Fall ist es wahrscheinlich ausreichend, eine repräsentative Stichprobe von Kunden zu ziehen, z. B. 5,000–20,000. Hier einige Hinweise zur Stichprobengröße:

- Eine Stichprobengröße von 100 – 1,000 Bildpaare beweisen Machbarkeit

- Eine Stichprobengröße von 1,000 – 10,000 Bildpaare sind nützlich, um die Variabilität zwischen Bildern zu messen

- Eine Stichprobengröße von 10,000 – 1 Million Bildpaare bieten ein Maß für die Betriebsqualität und Verallgemeinerbarkeit

Der Schlüssel zum Sampling von Bildpaaren besteht darin, sicherzustellen, dass das Sample genügend Variabilität über die Gesamtheit der Gesichter in Ihrer Anwendung bietet. Sie können Ihre Stichproben und Tests weiter erweitern, um demografische Informationen wie Hautton, Geschlecht und Alter einzubeziehen.

Vermeiden Sie Open-Source- und synthetische Gesichtsdatensätze

Es gibt Dutzende von kuratierten Open-Source-Gesichtsbilddatensätzen sowie erstaunlich realistische synthetische Gesichtssets, die häufig in der Forschung und zur Untersuchung der Machbarkeit verwendet werden. Die Herausforderung besteht darin, dass diese Datensätze im Allgemeinen für 99 % der realen Anwendungsfälle nicht nützlich sind, einfach weil sie nicht repräsentativ für die Kameras, Gesichter und die Qualität der Bilder sind, denen Ihre Anwendung wahrscheinlich in freier Wildbahn begegnen wird. Obwohl sie für die Anwendungsentwicklung nützlich sind, lassen sich die Genauigkeitsmessungen dieser Bildsätze nicht auf das verallgemeinern, was Sie in Ihrer eigenen Anwendung finden werden. Stattdessen empfehlen wir, mit einer repräsentativen Stichprobe echter Bilder aus Ihrer Lösung zu beginnen, selbst wenn die Musterbildpaare klein sind (unter 1,000).

Vermeiden Sie manuelle und synthetische Bildmanipulationen

Es gibt oft Grenzfälle, an deren Verständnis die Menschen interessiert sind. Dinge wie die Qualität der Bildaufnahme oder die Verschleierung bestimmter Gesichtszüge sind immer von Interesse. Beispielsweise werden wir oft nach dem Einfluss von Alter und Bildqualität auf die Gesichtserkennung gefragt. Sie könnten ein Gesicht einfach synthetisch altern lassen oder das Bild manipulieren, um das Motiv älter erscheinen zu lassen, oder die Bildqualität manipulieren, aber dies lässt sich nicht gut auf die reale Alterung von Bildern übertragen. Stattdessen empfehlen wir, eine repräsentative Stichprobe von Grenzfällen aus der realen Welt zu sammeln, die Sie testen möchten.

Überprüfen Sie die Bildqualität zum Zeitpunkt der Auswertung und im Laufe der Zeit

Kamera- und Anwendungstechnik ändern sich im Laufe der Zeit recht schnell. Als Best Practice empfehlen wir, die Bildqualität im Laufe der Zeit zu überwachen. Von der Größe der erfassten Gesichter (unter Verwendung von Begrenzungsrahmen) über die Helligkeit und Schärfe eines Bildes bis hin zur Pose eines Gesichts sowie möglichen Verschleierungen (Hüte, Sonnenbrillen, Bärte usw.) Gesichtszüge verändern sich im Laufe der Zeit.

Überwachen Sie FNMR und FMR im Laufe der Zeit

Änderungen treten auf, egal ob es sich um die Bilder, die Anwendung oder die in der Anwendung verwendeten Ähnlichkeitsschwellenwerte handelt. Es ist wichtig, die Rate falscher Übereinstimmungen und Nichtübereinstimmungen im Laufe der Zeit regelmäßig zu überwachen. Änderungen der Raten (selbst geringfügige Änderungen) können oft auf vorgelagerte Probleme mit der Anwendung oder der Art und Weise der Verwendung der Anwendung hinweisen. Änderungen an Ähnlichkeitsschwellenwerten und Geschäftsregeln, die zum Treffen von Annahme- oder Ablehnungsentscheidungen verwendet werden, können große Auswirkungen auf die Onboarding- und Authentifizierungsbenutzererfahrungen haben.

Verwenden Sie eine Human-in-the-Loop-Überprüfung

Identitätsprüfungssysteme treffen basierend auf Ähnlichkeitsschwellenwerten und Geschäftsregeln automatisierte Entscheidungen über Übereinstimmung und Nichtübereinstimmung. Neben regulatorischen und internen Compliance-Anforderungen besteht ein wichtiger Prozess in jedem automatisierten Entscheidungssystem darin, menschliche Prüfer als Teil der laufenden Überwachung des Entscheidungsprozesses einzusetzen. Die menschliche Aufsicht über diese automatisierten Entscheidungssysteme bietet Validierung und kontinuierliche Verbesserung sowie Transparenz in den automatisierten Entscheidungsprozess.

Bleiben Sie mit Amazon Rekognition auf dem Laufenden

Das Gesichtsmodell von Amazon Recognition wird regelmäßig (normalerweise jährlich) aktualisiert und befindet sich derzeit in Version 6. Diese aktualisierte Version hat wichtige Verbesserungen in Bezug auf Genauigkeit und Indizierung vorgenommen. Es ist wichtig, über neue Modellversionen auf dem Laufenden zu bleiben und zu verstehen, wie diese neuen Versionen in Ihrer Anwendung zur Identitätsprüfung verwendet werden. Wenn neue Versionen des Amazon Rekognition-Gesichtsmodells eingeführt werden, empfiehlt es sich, Ihren Identitätsprüfungs-Evaluierungsprozess erneut auszuführen und mögliche Auswirkungen (positiv und negativ) auf Ihre Quoten für falsche Übereinstimmungen und Nichtübereinstimmungen zu ermitteln.

Zusammenfassung

In diesem Beitrag werden die Schlüsselelemente erörtert, die zur Bewertung des Leistungsaspekts Ihrer Identitätsprüfungslösung in Bezug auf verschiedene Genauigkeitsmetriken erforderlich sind. Genauigkeit ist jedoch nur eine der vielen Dimensionen, die Sie bei der Auswahl eines bestimmten Inhaltsmoderationsdienstes bewerten müssen. Es ist wichtig, dass Sie andere Parameter einbeziehen, wie z. B. den gesamten Funktionsumfang des Dienstes, Benutzerfreundlichkeit, vorhandene Integrationen, Datenschutz und Sicherheit, Anpassungsoptionen, Auswirkungen auf die Skalierbarkeit, Kundenservice und Preise.

Weitere Informationen zur Identitätsprüfung in Amazon Rekognition finden Sie unter Identitätsprüfung mit Amazon Rekognition.

Über die Autoren

Mike Ames ist ein Datenwissenschaftler, der sich zum Spezialisten für Identitätsprüfungslösungen entwickelt hat und über umfangreiche Erfahrung in der Entwicklung von Lösungen für maschinelles Lernen und KI verfügt, um Unternehmen vor Betrug, Verschwendung und Missbrauch zu schützen. In seiner Freizeit findet man ihn beim Wandern, Mountainbiken oder beim Freebee-Spielen mit seinem Hund Max.

Mike Ames ist ein Datenwissenschaftler, der sich zum Spezialisten für Identitätsprüfungslösungen entwickelt hat und über umfangreiche Erfahrung in der Entwicklung von Lösungen für maschinelles Lernen und KI verfügt, um Unternehmen vor Betrug, Verschwendung und Missbrauch zu schützen. In seiner Freizeit findet man ihn beim Wandern, Mountainbiken oder beim Freebee-Spielen mit seinem Hund Max.

Amit Gupta ist Senior AI Services Solutions Architect bei AWS. Er setzt sich leidenschaftlich dafür ein, Kunden mit gut durchdachten Lösungen für maschinelles Lernen in großem Umfang zu unterstützen.

Amit Gupta ist Senior AI Services Solutions Architect bei AWS. Er setzt sich leidenschaftlich dafür ein, Kunden mit gut durchdachten Lösungen für maschinelles Lernen in großem Umfang zu unterstützen.

Zuhayr Raghib ist AI Services Solutions Architect bei AWS. Er ist auf angewandte KI/ML spezialisiert und engagiert sich leidenschaftlich dafür, Kunden die Nutzung der Cloud zu ermöglichen, um schneller Innovationen zu entwickeln und ihre Unternehmen zu transformieren.

Zuhayr Raghib ist AI Services Solutions Architect bei AWS. Er ist auf angewandte KI/ML spezialisiert und engagiert sich leidenschaftlich dafür, Kunden die Nutzung der Cloud zu ermöglichen, um schneller Innovationen zu entwickeln und ihre Unternehmen zu transformieren.

Marcel Pividal ist Senior AI Services Solutions Architect in der World-Wide Specialist Organization. Marcel verfügt über mehr als 20 Jahre Erfahrung in der Lösung von Geschäftsproblemen durch Technologie für Fintechs, Zahlungsanbieter, Pharmaunternehmen und Regierungsbehörden. Seine derzeitigen Schwerpunkte sind Risikomanagement, Betrugsprävention und Identitätsprüfung.

Marcel Pividal ist Senior AI Services Solutions Architect in der World-Wide Specialist Organization. Marcel verfügt über mehr als 20 Jahre Erfahrung in der Lösung von Geschäftsproblemen durch Technologie für Fintechs, Zahlungsanbieter, Pharmaunternehmen und Regierungsbehörden. Seine derzeitigen Schwerpunkte sind Risikomanagement, Betrugsprävention und Identitätsprüfung.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon-Anerkennung

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Best Practices

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet