Amazon Sage Maker ist ein vollständig verwalteter Dienst, der Entwicklern und Datenwissenschaftlern die Möglichkeit bietet, Modelle für maschinelles Lernen (ML) schnell zu erstellen, zu trainieren und bereitzustellen. Mit SageMaker können Sie Ihre ML-Modelle auf gehosteten Endpunkten bereitstellen und Inferenzergebnisse in Echtzeit erhalten. Sie können die Leistungsmetriken für Ihre Endpunkte ganz einfach in anzeigen Amazon CloudWatch, Endpunkte automatisch skalieren basierend auf dem Datenverkehr, und aktualisieren Sie Ihre Modelle in der Produktion, ohne die Verfügbarkeit zu verlieren. SageMaker bietet je nach Anwendungsfall eine Vielzahl von Optionen zum Bereitstellen von ML-Modellen für Inferenzen auf eine der folgenden Arten:

- Verwenden Sie SageMaker für synchrone Vorhersagen, die in der Größenordnung von Millisekunden bereitgestellt werden müssen Echtzeit-Inferenz

- Verwenden Sie für Workloads, die Leerlaufzeiten zwischen Verkehrsschüben haben und Kaltstarts tolerieren können Serverlose Inferenz

- Verwenden Sie SageMaker für Anforderungen mit großen Nutzlastgrößen von bis zu 1 GB, langen Verarbeitungszeiten (bis zu 15 Minuten) und Latenzanforderungen nahezu in Echtzeit (Sekunden bis Minuten). Asynchrone Inferenz

- Verwenden Sie SageMaker, um Vorhersagen für einen gesamten Datensatz zu erhalten Batch-Transformation

Echtzeit-Inferenz ist ideal für Inferenz-Workloads, bei denen Sie Anforderungen an Echtzeit, Interaktivität und geringe Latenz haben. Sie stellen Ihr Modell für SageMaker-Hosting-Services bereit und erhalten einen Endpunkt, der für Inferenzen verwendet werden kann. Diese Endpunkte werden durch eine vollständig verwaltete Infrastruktur und Support unterstützt automatische Skalierung. Sie können Effizienz und Kosten verbessern, indem Sie mehrere Modelle zu einem einzigen Endpunkt kombinieren Endpunkte mit mehreren Modellen or Multi-Container-Endpunkte.

Es gibt bestimmte Anwendungsfälle, in denen Sie mehrere Varianten desselben Modells in der Produktion bereitstellen möchten, um deren Leistung zu messen, Verbesserungen zu messen oder A/B-Tests durchzuführen. In solchen Fällen sind SageMaker-Endpunkte mit mehreren Varianten nützlich, da sie es Ihnen ermöglichen, mehrere Produktionsvarianten eines Modells auf demselben SageMaker-Endpunkt bereitzustellen.

In diesem Beitrag diskutieren wir variantenreiche SageMaker-Endpunkte und Best Practices für die Optimierung.

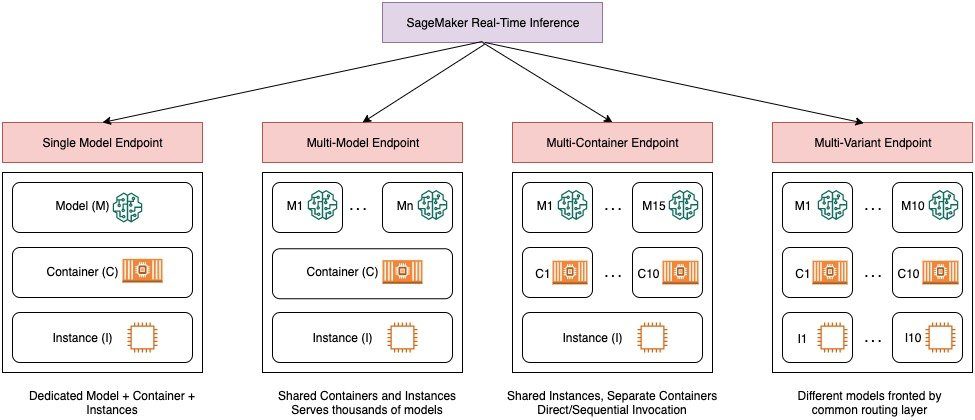

Vergleich der Echtzeit-Inferenzoptionen von SageMaker

Das folgende Diagramm gibt einen schnellen Überblick über die Echtzeit-Inferenzoptionen mit SageMaker.

Ein Einzelmodell-Endpunkt ermöglicht Ihnen die Bereitstellung eines Modells in einem Container, der auf dedizierten Instanzen oder serverlos für geringe Latenz und hohen Durchsatz gehostet wird. Sie können ein Modell erstellen und abrufen a Von SageMaker unterstütztes Bild für beliebte Frameworks wie TensorFlow, PyTorch, Scikit-learn und mehr. Wenn Sie mit einem benutzerdefinierten Framework für Ihr Modell arbeiten, können Sie das auch Bringen Sie Ihren eigenen Behälter mit das installiert Ihre Abhängigkeiten.

SageMaker unterstützt auch erweiterte Optionen wie Multi-Model-Endpoints (MMEs) und Multi-Container-Endpoints (MCEs). MMEs sind nützlich, wenn Sie mit Hunderten bis Zehntausenden von Modellen arbeiten und nicht jedes Modell als einzelnen Endpunkt bereitstellen müssen. Mit MMEs können Sie mehrere Modelle kostengünstig und skalierbar innerhalb desselben Endpunkts hosten, indem Sie einen Shared-Serving-Container verwenden, der auf einer Instanz gehostet wird. Die zugrunde liegende Infrastruktur (Container und Instanz) bleibt gleich, aber die Modelle werden dynamisch von einem gemeinsamen S3-Speicherort geladen und entladen, je nach Nutzung und verfügbarem Arbeitsspeicher auf dem Endpunkt. Ihre Anwendung muss lediglich einen API-Aufruf mit dem Zielmodell für diesen Endpunkt enthalten, um eine Inferenz mit niedriger Latenz und hohem Durchsatz zu erzielen. Anstatt für jedes einzelne Modell einen separaten Endpunkt zu bezahlen, können Sie viele Modelle zum Preis eines einzelnen Endpunkts hosten.

MCEs ermöglichen es Ihnen, bis zu 15 verschiedene ML-Container auf einem einzigen Endpunkt auszuführen und sie unabhängig voneinander aufzurufen. Sie können diese ML-Container auf verschiedenen Bereitstellungsstapeln (z. B. ML-Framework, Modellserver und Algorithmus) erstellen, um sie zur Kosteneinsparung auf demselben Endpunkt auszuführen. Sie können die Behälter in einem zusammennähen serielle Inferenzpipeline oder rufen Sie den Container unabhängig auf. Dies kann ideal sein, wenn Sie mehrere verschiedene ML-Modelle haben, die unterschiedliche Verkehrsmuster und ähnliche Ressourcenanforderungen haben. Beispiele für den Einsatz von MCEs sind unter anderem:

- Hosten von Modellen über verschiedene Frameworks (z. B. TensorFlow, PyTorch und Scikit-learn), die nicht über ausreichend Datenverkehr verfügen, um die volle Kapazität einer Instanz auszuschöpfen

- Hosten von Modellen aus demselben Framework mit unterschiedlichen ML-Algorithmen (z. B. Empfehlungen, Prognosen oder Klassifizierung) und Handler-Funktionen

- Vergleiche ähnlicher Architekturen, die auf verschiedenen Framework-Versionen ausgeführt werden (z. B. TensorFlow 1.x vs. TensorFlow 2.x) für Szenarien wie A/B-Tests

SageMaker Multi-Variant Endpoints (MVEs) ermöglichen es Ihnen, mehrere Modelle oder Modellversionen hinter demselben Endpunkt mit Produktionsvarianten zu testen. Jede Produktionsvariante identifiziert ein ML-Modell und die zum Hosten des Modells bereitgestellten Ressourcen, wie z. B. den Serving-Container und die Instanz.

Übersicht über SageMaker-Multivarianten-Endpunkte

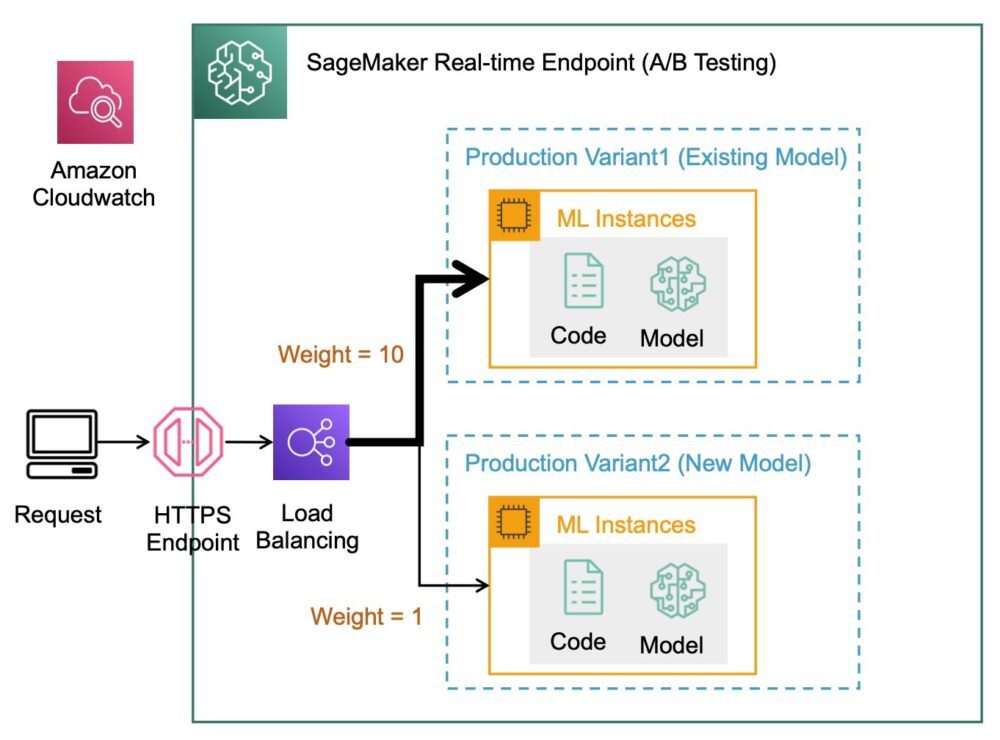

In Produktions-ML-Workflows verfeinern Data Scientists und ML-Ingenieure Modelle durch eine Vielzahl von Methoden, z. B. Neutraining basierend auf Daten-/Modell-/Konzeptdrift, Hyperparameter-Tuning, Funktionsauswahl, Framework-Auswahl und mehr. Das Durchführen von A/B-Tests zwischen einem neuen Modell und einem alten Modell mit Produktionsdatenverkehr kann ein effektiver letzter Schritt im Validierungsprozess für ein neues Modell sein. Bei A/B-Tests testen Sie verschiedene Varianten Ihrer Modelle und vergleichen, wie jede Variante relativ zueinander abschneidet. Sie wählen dann das leistungsstärkste Modell aus, um das vorherige Modell durch eine neue Version zu ersetzen, die eine bessere Leistung als die vorherige Version bietet. Durch die Verwendung von Produktionsvarianten können Sie diese ML-Modelle und verschiedene Modellversionen hinter demselben Endpunkt testen. Sie können diese ML-Modelle mit verschiedenen Datensätzen, verschiedenen Algorithmen und ML-Frameworks trainieren; stellen Sie sie auf verschiedenen Instanztypen bereit; oder eine beliebige Kombination dieser Optionen. Der mit dem SageMaker-Endpunkt verbundene Load Balancer bietet die Möglichkeit, die Aufrufanforderungen auf mehrere Produktionsvarianten zu verteilen. Beispielsweise können Sie den Datenverkehr zwischen Produktionsvarianten verteilen, indem Sie die Datenverkehrsverteilung für jede Variante angeben, oder Sie können für jede Anforderung direkt eine bestimmte Variante aufrufen.

Sie können die Auto Scaling-Richtlinie auch so konfigurieren, dass Ihre Varianten basierend auf Metriken wie Anforderungen pro Sekunde automatisch vergrößert oder verkleinert werden.

Das folgende Diagramm zeigt detaillierter, wie MVE funktioniert.

Die Bereitstellung eines MVE ist ebenfalls sehr einfach. Alles, was Sie tun müssen, ist, Modellobjekte mit den Bild- und Modelldaten mithilfe der zu definieren create_model Konstrukt aus dem SageMaker Python SDK und definieren Sie die Endpunktkonfigurationen mit production_variant Konstrukte zum Erstellen von Produktionsvarianten, jede mit ihren eigenen unterschiedlichen Modell- und Ressourcenanforderungen (Instanztyp und Anzahl). Dadurch können Sie auch Modelle auf verschiedenen Instance-Typen testen. Verwenden Sie zum Bereitstellen die endpoint_from_production_variant Konstrukt zum Erstellen des Endpunkts.

Während der Endpunkterstellung stellt SageMaker die in den Endpunkteinstellungen angegebene Hosting-Instanz bereit und lädt das von der Produktionsvariante angegebene Modell und den Inferenzcontainer auf die Hosting-Instanz herunter. Wenn nach dem Starten des Containers und dem Durchführen einer Zustandsprüfung mit einem Ping eine erfolgreiche Antwort zurückgegeben wird, wird eine Nachricht an den Benutzer gesendet, dass die Endpunkterstellung abgeschlossen ist. Siehe folgenden Code:

Im vorherigen Beispiel haben wir zwei Varianten erstellt, jede mit ihrem eigenen unterschiedlichen Modell (diese könnten auch unterschiedliche Instance-Typen und -Anzahlen haben). Wir setzen ein initial_weight von 1 für beide Varianten: Das bedeutet, dass 50 % unserer Anfragen an gehen Variant1, und die restlichen 50% zu Variant2. Die Summe der Gewichtungen beider Varianten beträgt 2 und jede Variante hat eine Gewichtungszuweisung von 1. Dies bedeutet, dass jede Variante 50 % des gesamten Datenverkehrs erhält.

Das Aufrufen des Endpunkts ähnelt dem allgemeinen SageMaker-Konstrukt invoke_endpoint; Sie können den Endpunkt direkt mit den Daten als Payload aufrufen:

SageMaker gibt Metriken wie z Latency machen Invocations für jede Variante in CloudWatch. Eine vollständige Liste der von SageMaker ausgegebenen Metriken finden Sie unter Überwachen Sie Amazon SageMaker mit Amazon CloudWatch. Sie können CloudWatch abfragen, um die Anzahl der Aufrufe pro Variante zu erhalten, um zu sehen, wie Aufrufe standardmäßig auf Varianten aufgeteilt werden.

Um eine bestimmte Version des Modells aufzurufen, geben Sie eine Variante als an TargetVariant im Aufruf an invoke_endpoint:

Sie können die Leistung jeder Produktionsvariante bewerten, indem Sie Metriken wie Genauigkeit, Präzision, Abruf, F1-Punktzahl und Empfängerbetriebscharakteristik/Fläche unter der Kurve für jede Variante überprüfen Amazon SageMaker-Modellmonitor. Sie können dann entscheiden, den Traffic auf das beste Modell zu erhöhen, indem Sie die Gewichtungen aktualisieren, die jeder Variante zugewiesen sind, indem Sie anrufen UpdateEndpointWeightsAndCapacities. Dadurch ändert sich die Verkehrsverteilung auf Ihre Produktionsvarianten, ohne dass Aktualisierungen an Ihrem Endpunkt erforderlich sind. Anstelle von 50 % des Traffics von der Ersteinrichtung verlagern wir also 75 % des Traffics auf Variant2 indem Sie jeder Variante mit neue Gewichtungen zuweisen UpdateEndpointWeightsAndCapacities. Siehe folgenden Code:

Wenn Sie mit der Leistung einer Variante zufrieden sind, können Sie 100 % des Datenverkehrs an diese Variante weiterleiten. Sie können beispielsweise das Gewicht für einstellen Variant1 auf 0 und das Gewicht für Variant2 zu 1. SageMaker sendet dann 100 % aller Inferenzanfragen an Variant2. Sie können Ihren Endpunkt dann sicher aktualisieren und löschen Variant1 von Ihrem Endpunkt. Sie können auch weiterhin neue Modelle in der Produktion testen, indem Sie Ihrem Endpunkt neue Varianten hinzufügen. Sie können diese Endpunkte auch so konfigurieren, dass sie basierend auf dem Datenverkehr, den die Endpunkte erhalten, automatisch skaliert werden.

Vorteile multivarianter Endpunkte

SageMaker MVEs ermöglichen Ihnen Folgendes:

- Bereitstellen und Testen mehrerer Varianten eines Modells mit demselben SageMaker-Endpunkt. Dies ist nützlich, um Variationen eines Modells in der Produktion zu testen. Angenommen, Sie haben ein Modell in der Produktion bereitgestellt. Sie können eine Variation des Modells testen, indem Sie eine kleine Menge an Traffic, sagen wir 5 %, auf das neue Modell umleiten.

- Bewerten Sie die Modellleistung in der Produktion, ohne den Datenverkehr zu unterbrechen, indem Sie die Betriebsmetriken für jede Variante in CloudWatch überwachen.

- Aktualisieren Sie Modelle in der Produktion, ohne die Verfügbarkeit zu verlieren. Sie können einen Endpunkt ändern, ohne Modelle, die bereits in der Produktion bereitgestellt werden, außer Betrieb zu nehmen. Sie können beispielsweise neue Modellvarianten hinzufügen, die ML-Compute-Instanzkonfigurationen vorhandener Modellvarianten aktualisieren oder die Verteilung des Datenverkehrs auf Modellvarianten ändern. Weitere Informationen finden Sie unter Endpunkt aktualisieren machen UpdateEndpointWeightsAndCapacities.

Herausforderungen bei der Verwendung von Endpunkten mit mehreren Varianten

SageMaker MVEs bringen die folgenden Herausforderungen mit sich:

- Belastungstestaufwand – Sie müssen für jede Variante einen angemessenen Aufwand und Ressourcen für Tests und Modellmatrixvergleiche aufwenden. Damit ein A/B-Test als erfolgreich angesehen wird, müssen Sie eine statistische Analyse der aus dem Test gesammelten Metriken durchführen, um festzustellen, ob es ein statistisch signifikantes Ergebnis gibt. Es könnte schwierig werden, die Suche nach leistungsschwachen Varianten zu minimieren. Sie könnten möglicherweise verwenden Der vielarmige Bandit Optimierungstechnik, um zu vermeiden, dass Traffic an Experimente gesendet wird, die nicht funktionieren, und um die Leistung während des Tests zu optimieren. Für Lasttests könnten Sie auch erkunden Amazon SageMaker Inference Recommender um umfangreiche Benchmarks basierend auf Produktionsanforderungen für Latenz und Durchsatz, benutzerdefinierte Datenverkehrsmuster und von Ihnen ausgewählte Instanzen (bis zu 10) durchzuführen.

- Enge Kopplung zwischen Modellvariante und Endpunkt – Je nach Bereitstellungshäufigkeit des Modells kann es schwierig werden, da der Endpunkt möglicherweise in

updatingStatus für jede Produktionsvariante, die aktualisiert wird. SageMaker unterstützt auch Einsatzleitplanken, mit dem Sie einfach und kontrolliert vom aktuellen Modell in der Produktion auf ein neues wechseln können. Diese Option führt ein Kanarienvogel machen linear Verkehrsverlagerungsmodi, damit Sie im Laufe des Updates eine genaue Kontrolle über die Verlagerung des Verkehrs von Ihrem aktuellen Modell auf das neue Modell haben. Mit integrierten Sicherheitsvorkehrungen wie Auto-Rollbacks können Sie Probleme frühzeitig erkennen und automatisch Korrekturmaßnahmen ergreifen, bevor sie erhebliche Auswirkungen auf die Produktion haben.

Best Practices für Endpunkte mit mehreren Varianten

Beachten Sie beim Hosten von Modellen mit SageMaker-MVEs Folgendes:

- SageMaker eignet sich hervorragend zum Testen neuer Modelle, da Sie sie problemlos in einer A/B-Testumgebung bereitstellen können und nur für das bezahlen, was Sie verwenden. Während der Endpunkt ausgeführt wird, wird Ihnen jede verbrauchte Instance-Stunde für jede Instance in Rechnung gestellt. Wenn Sie mit Ihren Tests fertig sind und den Endpunkt oder die Varianten nicht mehr ausgiebig verwenden, sollten Sie ihn löschen, um Kosten zu sparen. Sie können es jederzeit neu erstellen, wenn Sie es erneut benötigen, da das Modell in gespeichert ist Amazon Simple Storage-Service (Amazon S3).

- Sie sollten den optimalsten Instance-Typ und die optimale Größe verwenden, um Modelle bereitzustellen. SageMaker bietet derzeit ML-Recheninstanzen auf verschiedenen Instanzfamilien. Eine Endpunktinstanz wird ständig ausgeführt (während die Instanz in Betrieb ist). Daher kann die Auswahl des richtigen Instanztyps erhebliche Auswirkungen auf die Gesamtkosten und die Leistung von ML-Modellen haben. Lastprüfung ist die bewährte Methode, um den geeigneten Instance-Typ und die Flottengröße mit oder ohne automatische Skalierung für Ihren Live-Endpunkt zu bestimmen, um eine Überbereitstellung und zusätzliche Kosten für nicht benötigte Kapazität zu vermeiden.

- Sie können die Modellleistung und Ressourcennutzung in CloudWatch überwachen. Sie können eine konfigurieren

ProductionVariantbenutzen Automatische Skalierung der Anwendung. Um die Metriken und Zielwerte für eine Skalierungsrichtlinie anzugeben, konfigurieren Sie eine Skalierungsrichtlinie zur Zielverfolgung. Sie können entweder eine vordefinierte Metrik oder eine benutzerdefinierte Metrik verwenden. Weitere Informationen zur Richtlinienkonfigurationssyntax finden Sie unter TargetTrackingScalingPolicyConfiguration. Informationen zum Konfigurieren der automatischen Skalierung finden Sie unter Amazon SageMaker-Modelle automatisch skalieren. Um schnell eine Skalierungsrichtlinie zur Zielverfolgung für eine Variante zu definieren, können Sie eine bestimmte CloudWatch-Metrik auswählen und Schwellenwerte festlegen. Verwenden Sie beispielsweise MetrikSageMakerVariantInvocationsPerInstanceum zu überwachen, wie oft jede Instanz für eine Variante durchschnittlich pro Minute aufgerufen wird, oder Metrik verwendenCPUUtilizationum die Summe der von einer CPU verarbeiteten Arbeit zu überwachen. Das folgende Beispiel verwendet dieSageMakerVariantInvocationsPerInstancevordefinierte Metrik, um die Anzahl der Varianteninstanzen so anzupassen, dass jede Instanz eine hatInvocationsPerInstanceMetrik von 70:

- Das Ändern oder Löschen von Modellartefakten oder das Ändern von Inferenzcode nach der Bereitstellung eines Modells führt zu unvorhersehbaren Ergebnissen. Vor dem Bereitstellen von Modellen für die Produktion empfiehlt es sich, zu prüfen, ob das Hosten des Modells im lokalen Modus erfolgreich ist, nachdem die Inferenzcodeausschnitte (wie z

model_fn,input_fn,predict_fnundoutput_fn) in der lokalen Entwicklungsumgebung wie einer SageMaker-Notebook-Instance oder einem lokalen Server. Wenn Sie Modellartefakte ändern oder löschen oder den Inferenzcode ändern müssen, ändern Sie den Endpunkt, indem Sie eine neue Endpunktkonfiguration bereitstellen. Nachdem Sie die neue Endpunktkonfiguration bereitgestellt haben, können Sie die Modellartefakte entsprechend der alten Endpunktkonfiguration ändern oder löschen. - Sie können SageMaker verwenden Batch-Transformation Fertigungsvarianten zu testen. Die Stapeltransformation ist ideal, um Rückschlüsse aus großen Datasets zu ziehen. Sie können für jede neue Modellvariante einen separaten Transformationsjob erstellen und zum Testen ein Validierungsdataset verwenden. Geben Sie für jeden Transformationsauftrag einen eindeutigen Modellnamen und Speicherort in Amazon S3 für die Ausgabedatei an. Um die Ergebnisse zu analysieren, verwenden Sie Inferenz-Pipeline-Protokolle und -Metriken.

Zusammenfassung

SageMaker ermöglicht Ihnen das einfache A/B-Testen von ML-Modellen in der Produktion, indem mehrere Produktionsvarianten auf einem Endpunkt ausgeführt werden. Sie können die Funktionen von SageMaker verwenden, um Modelle zu testen, die mit verschiedenen Trainingsdatensätzen, Hyperparametern, Algorithmen oder ML-Frameworks trainiert wurden. wie sie auf verschiedenen Instanztypen funktionieren; oder eine Kombination aus allen oben genannten. Sie können die Datenverkehrsverteilung zwischen den Varianten auf einem Endpunkt bereitstellen, und SageMaker teilt den Inferenzdatenverkehr basierend auf der angegebenen Verteilung auf die Varianten auf. Wenn Sie Modelle für bestimmte Kundensegmente testen möchten, können Sie alternativ die Variante angeben, die eine Inferenzanforderung verarbeiten soll, indem Sie die angeben TargetVariant -Header, und SageMaker leitet die Anfrage an die von Ihnen angegebene Variante weiter. Weitere Informationen zu A/B-Tests finden Sie unter Aktualisieren Sie Modelle in der Produktion sicher.

Bibliographie

Über die Autoren

Deepali Rajale ist AI/ML Specialist Technical Account Manager bei Amazon Web Services. Sie arbeitet mit Unternehmenskunden zusammen und bietet technische Anleitungen zur Implementierung von Lösungen für maschinelles Lernen mit Best Practices. In ihrer Freizeit geht sie gerne wandern, Filme schauen und mit Familie und Freunden rumhängen.

Deepali Rajale ist AI/ML Specialist Technical Account Manager bei Amazon Web Services. Sie arbeitet mit Unternehmenskunden zusammen und bietet technische Anleitungen zur Implementierung von Lösungen für maschinelles Lernen mit Best Practices. In ihrer Freizeit geht sie gerne wandern, Filme schauen und mit Familie und Freunden rumhängen.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Saurabh Trikande ist Senior Product Manager für Amazon SageMaker Inference. Er arbeitet leidenschaftlich gerne mit Kunden zusammen und ist motiviert von dem Ziel, maschinelles Lernen zu demokratisieren. Er konzentriert sich auf die Kernherausforderungen im Zusammenhang mit der Bereitstellung komplexer ML-Anwendungen, mandantenfähigen ML-Modellen, Kostenoptimierungen und der leichteren Bereitstellung von Deep-Learning-Modellen. In seiner Freizeit wandert Saurabh gerne, lernt etwas über innovative Technologien, folgt TechCrunch und verbringt Zeit mit seiner Familie.

Saurabh Trikande ist Senior Product Manager für Amazon SageMaker Inference. Er arbeitet leidenschaftlich gerne mit Kunden zusammen und ist motiviert von dem Ziel, maschinelles Lernen zu demokratisieren. Er konzentriert sich auf die Kernherausforderungen im Zusammenhang mit der Bereitstellung komplexer ML-Anwendungen, mandantenfähigen ML-Modellen, Kostenoptimierungen und der leichteren Bereitstellung von Deep-Learning-Modellen. In seiner Freizeit wandert Saurabh gerne, lernt etwas über innovative Technologien, folgt TechCrunch und verbringt Zeit mit seiner Familie.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Sage Maker

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet