Einleitung

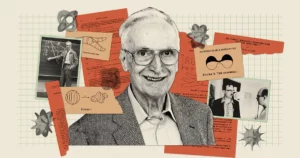

Künstliche Intelligenz scheint mächtiger denn je zu sein, denn Chatbots wie Bard und ChatGPT sind in der Lage, unheimlich menschenähnliche Texte zu produzieren. Aber trotz all ihrer Talente stellen diese Bots Forscher immer noch vor die Frage: Machen Sie solche Modelle tatsächlich verstehen Was sagen sie? „Natürlich glauben einige Leute, dass sie es tun“, sagte der KI-Pionier Geoff Hinton in einem aktuelles Gespräch mit Andrew Ng, „und manche Leute glauben, dass sie nur stochastische Papageien sind.“

Dieser eindrucksvolle Satz stammt aus dem Jahr 2021 Krepppapier Mitautor von Emily Bender, ein Computerlinguist an der University of Washington. Es legt nahe, dass große Sprachmodelle (LLMs) – die die Grundlage moderner Chatbots bilden – Text nur durch die Kombination von Informationen generieren, die sie bereits gesehen haben, „ohne jeglichen Bezug zur Bedeutung“, schrieben die Autoren, was ein LLM zu „einem stochastischen Papagei“ macht.

Viele der größten und besten Chatbots von heute basieren auf diesen Modellen. Daher argumentierte Hinton, dass es an der Zeit sei, den Umfang dessen zu bestimmen, was sie verstehen. Für ihn ist die Frage mehr als nur akademisch. „Solange wir diese Meinungsverschiedenheiten haben“, sagte er zu Ng, „werden wir keinen Konsens über die Gefahren erzielen können.“

Neue Forschungsergebnisse könnten Hinweise auf eine Antwort geben. Eine Theorie entwickelt von Sanjeev Arora der Princeton University und Anirudh Goyal, ein Forscher bei Google DeepMind, vermutet, dass die größten der heutigen LLMs keine stochastischen Papageien sind. Die Autoren argumentieren, dass diese Modelle, wenn sie größer werden und auf mehr Daten trainiert werden, die individuellen sprachbezogenen Fähigkeiten verbessern und auch neue entwickeln, indem sie Fähigkeiten auf eine Weise kombinieren, die auf das Verstehen hinweist – Kombinationen, die in den Trainingsdaten wahrscheinlich nicht vorhanden waren .

Dieser theoretische Ansatz, der ein mathematisch nachweisbares Argument dafür liefert, wie und warum ein LLM so viele Fähigkeiten entwickeln kann, hat Experten wie Hinton und andere überzeugt. Und als Arora und sein Team einige seiner Vorhersagen testeten, stellten sie fest, dass sich diese Modelle fast genau wie erwartet verhielten. Sie haben allem Anschein nach deutlich gemacht, dass die größten LLMs nicht nur nachplappern, was sie zuvor gesehen haben.

„[Sie] können nicht einfach nachahmen, was in den Trainingsdaten gesehen wurde“, sagte er Sebastian Bubeck, ein Mathematiker und Informatiker bei Microsoft Research, der nicht an der Arbeit beteiligt war. „Das ist die grundlegende Erkenntnis.“

Mehr Daten, mehr Leistung

Die Entstehung von unerwartete und vielfältige Fähigkeiten in LLMs kann man wohl sagen, dass es eine Überraschung war. Diese Fähigkeiten sind keine offensichtliche Folge der Art und Weise, wie die Systeme aufgebaut und trainiert werden. Ein LLM ist ein riesiges künstliches neuronales Netzwerk, das einzelne künstliche Neuronen verbindet. Diese Verbindungen werden als Modellparameter bezeichnet und ihre Zahl gibt die Größe des LLM an. Zum Training gehört es, dem LLM einen Satz zu geben, bei dem das letzte Wort verdeckt ist, zum Beispiel „Kraftstoff kostet einen Arm und einen ___.“ Das LLM sagt eine Wahrscheinlichkeitsverteilung über seinen gesamten Wortschatz voraus. Wenn es also beispielsweise tausend Wörter kennt, sagt es tausend Wahrscheinlichkeiten voraus. Anschließend wird das wahrscheinlichste Wort zur Vervollständigung des Satzes ausgewählt – vermutlich „Bein“.

Am Anfang könnte es sein, dass der LLM die Wörter schlecht wählt. Der Trainingsalgorithmus berechnet dann einen Verlust – den Abstand in einem hochdimensionalen mathematischen Raum zwischen der Antwort des LLM und dem tatsächlichen Wort im Originalsatz – und nutzt diesen Verlust, um die Parameter zu optimieren. Wenn nun derselbe Satz gegeben ist, berechnet das LLM eine bessere Wahrscheinlichkeitsverteilung und sein Verlust wird etwas geringer sein. Der Algorithmus führt dies für jeden Satz in den Trainingsdaten durch (möglicherweise Milliarden von Sätzen), bis der Gesamtverlust des LLM auf ein akzeptables Niveau sinkt. Ein ähnlicher Prozess wird verwendet, um das LLM an Sätzen zu testen, die nicht Teil der Trainingsdaten waren.

Wenn einem geschulten und getesteten LLM eine neue Textaufforderung präsentiert wird, generiert er das wahrscheinlichste nächste Wort, hängt es an die Aufforderung an, generiert ein weiteres nächstes Wort und fährt auf diese Weise fort, um eine scheinbar kohärente Antwort zu erzeugen. Nichts im Trainingsprozess deutet darauf hin, dass größere LLMs, die mit mehr Parametern und Trainingsdaten erstellt werden, auch bei Aufgaben besser werden sollten, deren Beantwortung Argumentation erfordert.

Aber sie tun es. LLMs, die groß genug sind, zeigen Fähigkeiten – von der Lösung elementarer mathematischer Probleme bis hin zur Beantwortung von Fragen über die Vorgänge in den Köpfen anderer –, über die kleinere Modelle nicht verfügen, obwohl sie alle auf ähnliche Weise trainiert sind.

„Woher ist diese [Fähigkeit] gekommen?“ fragte sich Arora. „Und kann das allein aus der Vorhersage des nächsten Wortes hervorgehen?“

Fähigkeiten mit Text verbinden

Arora hat sich mit Goyal zusammengetan, um solche Fragen analytisch zu beantworten. „Wir haben versucht, einen theoretischen Rahmen zu entwickeln, um zu verstehen, wie Entstehung geschieht“, sagte Arora.

Das Duo wandte sich mathematischen Objekten zu, die als Zufallsgraphen bezeichnet werden. Ein Graph ist eine Ansammlung von Punkten (oder Knoten), die durch Linien (oder Kanten) verbunden sind, und in einem Zufallsgraphen wird das Vorhandensein einer Kante zwischen zwei beliebigen Knoten zufällig bestimmt – beispielsweise durch einen Münzwurf. Die Münze kann voreingenommen sein, so dass sie mit einiger Wahrscheinlichkeit „Kopf“ erscheint p. Wenn die Münze auf ein bestimmtes Knotenpaar trifft, bildet sich zwischen diesen beiden Knoten eine Kante. andernfalls bleiben sie unverbunden. Als Wert von p Bei Änderungen können die Diagramme plötzliche Übergänge in ihren Eigenschaften aufweisen. Zum Beispiel wann p einen bestimmten Schwellenwert überschreitet, verschwinden isolierte Knoten – diejenigen, die mit keinem anderen Knoten verbunden sind – plötzlich.

Arora und Goyal erkannten, dass Zufallsdiagramme, die nach Erreichen bestimmter Schwellenwerte zu unerwartetem Verhalten führen, eine Möglichkeit sein könnten, das Verhalten von LLMs zu modellieren. Neuronale Netze sind fast zu komplex geworden, um sie zu analysieren, aber Mathematiker beschäftigen sich schon seit langem mit Zufallsgraphen und haben verschiedene Werkzeuge zu deren Analyse entwickelt. Vielleicht könnte die Zufallsgraphentheorie Forschern eine Möglichkeit bieten, das scheinbar unerwartete Verhalten großer LLMs zu verstehen und vorherzusagen.

Die Forscher entschieden sich, sich auf „bipartite“ Graphen zu konzentrieren, die zwei Arten von Knoten enthalten. In ihrem Modell stellt ein Knotentyp Textteile dar – nicht einzelne Wörter, sondern Blöcke, die einen Absatz bis zu mehreren Seiten lang sein können. Diese Knoten sind in einer geraden Linie angeordnet. Darunter befindet sich in einer anderen Zeile die andere Gruppe von Knoten. Diese stellen die Fähigkeiten dar, die erforderlich sind, um einem bestimmten Textstück einen Sinn zu geben. Jede Fähigkeit könnte fast alles sein. Vielleicht stellt ein Knoten die Fähigkeit eines LLM dar, das Wort „weil“ zu verstehen, das eine Vorstellung von Kausalität beinhaltet; ein anderes könnte die Fähigkeit darstellen, zwei Zahlen zu teilen; ein weiteres könnte die Fähigkeit darstellen, Ironie zu erkennen. „Wenn man versteht, dass der Text ironisch ist, drehen sich viele Dinge um“, sagte Arora. „Das ist relevant für die Vorhersage von Wörtern.“

Um es klar auszudrücken: LLMs werden nicht im Hinblick auf Fertigkeiten ausgebildet oder getestet; Sie wurden nur entwickelt, um die Vorhersage des nächsten Wortes zu verbessern. Aber Arora und Goyal wollten LLMs aus der Perspektive der Fähigkeiten verstehen, die möglicherweise erforderlich sind, um einen einzelnen Text zu verstehen. Eine Verbindung zwischen einem Skill-Knoten und einem Textknoten oder zwischen mehreren Skill-Knoten und einem Textknoten bedeutet, dass der LLM diese Skills benötigt, um den Text in diesem Knoten zu verstehen. Außerdem können mehrere Textteile auf derselben Fähigkeit oder demselben Satz von Fähigkeiten basieren. Beispielsweise würde eine Reihe von Fähigkeitsknoten, die die Fähigkeit darstellen, Ironie zu verstehen, mit den zahlreichen Textknoten verbunden sein, in denen Ironie auftritt.

Die Herausforderung bestand nun darin, diese zweiteiligen Diagramme mit tatsächlichen LLMs zu verbinden und zu sehen, ob die Diagramme etwas über die Entstehung mächtiger Fähigkeiten verraten könnten. Die Forscher konnten sich jedoch nicht auf Informationen über das Training oder Testen tatsächlicher LLMs verlassen – Unternehmen wie OpenAI oder DeepMind veröffentlichen ihre Trainings- oder Testdaten nicht. Außerdem wollten Arora und Goyal vorhersagen, wie sich LLMs verhalten werden, wenn sie noch größer werden, und für kommende Chatbots sind solche Informationen nicht verfügbar. Es gab jedoch eine entscheidende Information, auf die die Forscher zugreifen konnten.

Seit 2021 beobachten Forscher, die die Leistung von LLMs und anderen neuronalen Netzen untersuchen, die Entstehung eines universellen Merkmals. Sie stellten fest, dass mit zunehmender Größe eines Modells, sei es in der Größe oder in der Menge an Trainingsdaten, sein Verlust an Testdaten (der Unterschied zwischen vorhergesagten und richtigen Antworten auf neue Texte nach dem Training) auf ganz bestimmte Weise abnimmt. Diese Beobachtungen wurden in Gleichungen kodifiziert, die als neuronale Skalierungsgesetze bezeichnet werden. Deshalb haben Arora und Goyal ihre Theorie so konzipiert, dass sie nicht auf Daten von einzelnen LLMs, Chatbots oder Trainings- und Testdatensätzen basiert, sondern auf dem universellen Gesetz, dem diese Systeme alle gehorchen sollen: dem Verlust, der durch Skalierungsgesetze vorhergesagt wird.

Vielleicht, so argumentierten sie, hing eine verbesserte Leistung – gemessen an den Gesetzen der neuronalen Skalierung – mit verbesserten Fähigkeiten zusammen. Und diese verbesserten Fähigkeiten könnten in ihren zweiteiligen Diagrammen durch die Verbindung von Fähigkeitsknoten mit Textknoten definiert werden. Die Herstellung dieser Verbindung – zwischen neuronalen Skalierungsgesetzen und bipartiten Graphen – war der Schlüssel, der es ihnen ermöglichen würde, fortzufahren.

Fähigkeiten ausbauen

Die Forscher gingen zunächst davon aus, dass es einen hypothetischen zweiteiligen Graphen gibt, der dem Verhalten eines LLM bei Testdaten entspricht. Um die Veränderung des LLM-Verlusts bei Testdaten zu erklären, stellten sie sich eine Möglichkeit vor, das Diagramm zu verwenden, um zu beschreiben, wie das LLM Fähigkeiten erwirbt.

Nehmen wir zum Beispiel die Fähigkeit „versteht Ironie“. Diese Idee wird mit einem Skill-Knoten dargestellt, daher schauen die Forscher, mit welchen Textknoten dieser Skill-Knoten verbunden ist. Wenn fast alle dieser verbundenen Textknoten erfolgreich sind – was bedeutet, dass die Vorhersagen des LLM zu dem durch diese Knoten dargestellten Text sehr genau sind – dann ist der LLM in dieser speziellen Fähigkeit kompetent. Wenn jedoch mehr als ein bestimmter Bruchteil der Verbindungen des Skill-Knotens zu fehlgeschlagenen Textknoten führt, schlägt das LLM bei diesem Skill fehl.

Diese Verbindung zwischen diesen bipartiten Graphen und LLMs ermöglichte es Arora und Goyal, die Werkzeuge der Zufallsgraphentheorie zu nutzen, um das LLM-Verhalten durch Proxy zu analysieren. Das Studium dieser Diagramme ergab bestimmte Beziehungen zwischen den Knoten. Diese Beziehungen führten wiederum zu einer logischen und überprüfbaren Erklärung, wie große Modelle die erforderlichen Fähigkeiten erlangten, um ihre unerwarteten Fähigkeiten zu erreichen.

Arora und Goyal erklärten zunächst ein Schlüsselverhalten: Warum größere LLMs in Bezug auf individuelle Fähigkeiten kompetenter werden als ihre kleineren Kollegen. Sie begannen mit dem geringeren Testverlust, der durch die neuronalen Skalierungsgesetze vorhergesagt wurde. In einem Diagramm wird dieser geringere Testverlust durch einen Rückgang des Anteils ausgefallener Testknoten dargestellt. Es gibt also insgesamt weniger ausgefallene Testknoten. Und wenn es weniger fehlgeschlagene Testknoten gibt, dann gibt es auch weniger Verbindungen zwischen fehlgeschlagenen Testknoten und Skill-Knoten. Daher ist eine größere Anzahl von Fertigkeitsknoten mit erfolgreichen Testknoten verbunden, was auf eine wachsende Fertigkeitskompetenz des Modells hindeutet. „Eine sehr geringfügige Verlustreduzierung führt dazu, dass die Maschine die Kompetenz dieser Fähigkeiten erwirbt“, sagte Goyal.

Als nächstes fanden die beiden einen Weg, die unerwarteten Fähigkeiten eines größeren Modells zu erklären. Wenn die Größe eines LLM zunimmt und sein Testverlust abnimmt, entwickeln zufällige Kombinationen von Fertigkeitsknoten Verbindungen zu einzelnen Textknoten. Dies deutet darauf hin, dass der LLM auch besser darin wird, mehr als eine Fertigkeit gleichzeitig zu nutzen und beginnt, Texte mit mehreren Fertigkeiten zu generieren – indem er beispielsweise die Fähigkeit, Ironie zu verwenden, mit einem Verständnis des Wortes „weil“ kombiniert – selbst wenn diese genauen Kombinationen von Fähigkeiten waren in keinem Textteil der Trainingsdaten vorhanden.

Stellen Sie sich zum Beispiel ein LLM vor, das bereits eine Fähigkeit zur Textgenerierung nutzen könnte. Wenn Sie die Anzahl der Parameter oder Trainingsdaten des LLM um eine Größenordnung erhöhen, wird es ähnlich kompetent bei der Generierung von Texten, die zwei Fähigkeiten erfordern. Gehen Sie eine weitere Größenordnung nach oben, und der LLM kann nun Aufgaben, die vier Fähigkeiten erfordern, gleichzeitig ausführen, wiederum mit dem gleichen Kompetenzniveau. Größere LLMs bieten mehr Möglichkeiten, Fähigkeiten zusammenzuführen, was zu einer kombinatorischen Explosion von Fähigkeiten führt.

Und je größer ein LLM wird, desto unwahrscheinlicher wird die Möglichkeit, dass alle diese Kompetenzkombinationen in den Trainingsdaten gefunden wurden. Nach den Regeln der Zufallsgraphentheorie entsteht jede Kombination aus einer zufälligen Auswahl möglicher Fähigkeiten. Wenn also in der Grafik etwa 1,000 zugrunde liegende einzelne Fertigkeitsknoten vorhanden sind und Sie vier Fertigkeiten kombinieren möchten, dann gibt es etwa 1,000 hoch vier – also 1 Billion – mögliche Möglichkeiten, diese zu kombinieren.

Arora und Goyal sehen darin einen Beweis dafür, dass sich die größten LLMs nicht nur auf Kombinationen von Fähigkeiten verlassen, die sie in ihren Trainingsdaten gesehen haben. Bubeck stimmt zu. „Wenn ein LLM wirklich in der Lage ist, diese Aufgaben durch die Kombination von vier dieser tausend Fähigkeiten zu erfüllen, dann muss er eine Generalisierung durchführen“, sagte er. Das heißt, es handelt sich höchstwahrscheinlich nicht um einen stochastischen Papagei.

Wahre Kreativität?

Aber Arora und Goyal wollten über die Theorie hinausgehen und ihre Behauptung überprüfen, dass LLMs mit zunehmender Größe und Trainingsdaten besser darin werden, mehr Fähigkeiten zu kombinieren und somit zu verallgemeinern. Zusammen mit anderen Kollegen haben sie entwarf eine Methode Dies wird als „Skill-Mix“ bezeichnet, um die Fähigkeit eines LLM zu bewerten, mehrere Fähigkeiten zum Generieren von Text zu nutzen.

Um ein LLM zu testen, bat das Team es, drei Sätze zu einem zufällig ausgewählten Thema zu generieren, die einige zufällig ausgewählte Fähigkeiten veranschaulichen. Zum Beispiel haben sie GPT-4 (das LLM, das die leistungsstärkste Version von ChatGPT antreibt) gebeten, über Duelle zu schreiben – im Grunde genommen über Schwertkämpfe. Darüber hinaus verlangten sie von ihm, Fähigkeiten in vier Bereichen zu zeigen: eigennützige Voreingenommenheit, Metapher, statistischer Syllogismus und allgemein bekannte Physik. GPT-4 antwortete mit: „Mein Sieg in diesem Tanz mit Stahl [Metapher] ist so sicher wie der Fall eines Objekts auf den Boden [Physik]. Als renommierter Duellant bin ich von Natur aus flink, genau wie die meisten anderen [statistischer Syllogismus] meines Rufs. Verlust? Nur möglich aufgrund eines ungleichen Schlachtfelds, nicht meiner Unzulänglichkeit [Eigennützigkeit].“ Als GPT-4 gebeten wurde, die Ausgabe zu überprüfen, reduzierte sie sie auf drei Sätze.

Einleitung

„Es ist nicht Hemingway oder Shakespeare“, sagte Arora, aber das Team ist zuversichtlich, dass es seinen Standpunkt beweist: Das Modell kann Text generieren, den es in den Trainingsdaten unmöglich hätte sehen können, und zeigt Fähigkeiten, die dem entsprechen, was manche behaupten würden ist Verständnis. GPT-4 bestehe sogar Skill-Mix-Tests, die in etwa 10 bis 15 % der Fälle sechs Fertigkeiten erfordern, und produziert dabei Textteile, die statistisch gesehen unmöglich in den Trainingsdaten vorhanden gewesen wären.

Das Team automatisierte den Prozess auch, indem es GPT-4 dazu brachte, seine eigene Ausgabe zusammen mit der anderer LLMs auszuwerten. Arora sagte, es sei fair, wenn das Modell sich selbst auswertet, da es kein Gedächtnis habe und sich daher nicht daran erinnern könne, dass es genau den Text generieren soll, den es auswerten soll. Yasaman Bahri, ein Forscher bei Google DeepMind, der sich mit den Grundlagen der KI beschäftigt, findet den automatisierten Ansatz „sehr einfach und elegant“.

Was die Theorie betrifft, so mache sie zwar einige Annahmen, sagte Bubeck, aber „diese Annahmen sind keineswegs verrückt.“ Auch er war beeindruckt von den Experimenten. „Was [das Team] theoretisch beweist und auch empirisch bestätigt, ist, dass es eine kompositorische Verallgemeinerung gibt, was bedeutet, dass [LLMs] in der Lage sind, Bausteine zusammenzusetzen, die noch nie zusammengesetzt wurden“, sagte er. „Das ist für mich die Essenz der Kreativität.“

Arora fügt hinzu, dass die Arbeit nichts über die Genauigkeit dessen aussagt, was LLMs schreiben. „Tatsächlich plädiert es für Originalität“, sagte er. „Solche Dinge hat es im Trainingskorpus der Welt noch nie gegeben. Das hat noch nie jemand geschrieben. Es muss halluzinieren.“

Nichtsdestotrotz glaubt Hinton, dass die Arbeit darin besteht, die Frage zu beantworten, ob LLMs stochastische Papageien sind. „Es ist die strengste Methode, die ich je gesehen habe, um zu zeigen, dass GPT-4 viel mehr als nur ein stochastischer Papagei ist“, sagte er. „Sie zeigen überzeugend, dass GPT-4 Texte generieren kann, die Fähigkeiten und Themen auf eine Weise kombinieren, die in den Trainingsdaten mit ziemlicher Sicherheit nicht vorkommt.“ (Wir haben Bender um ihre Sicht auf das neue Werk gebeten, aber sie lehnte eine Stellungnahme mit der Begründung ab, es mangele an Zeit.)

Und tatsächlich übertrifft die Leistung von GPT-4, wie die Mathematik vorhersagt, die seines kleineren Vorgängers GPT-3.5 bei weitem – in einem Ausmaß, das Arora erschreckte. „Wahrscheinlich geht es nicht nur mir so“, sagte er. „Viele Leute fanden es etwas unheimlich, wie viel besser GPT-4 als GPT-3.5 war, und das geschah innerhalb eines Jahres. Bedeutet das, dass wir in einem weiteren Jahr eine ähnliche Veränderung dieser Größenordnung erleben werden? Ich weiß nicht. Nur OpenAI weiß es.“

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :hast

- :Ist

- :nicht

- :Wo

- ][P

- $UP

- 000

- 1

- 15%

- 2021

- a

- Fähigkeiten

- Fähigkeit

- Fähig

- LiveBuzz

- plötzlich

- akademisch

- akzeptabel

- Zugang

- Nach

- Trading Konten

- Genauigkeit

- genau

- Erreichen

- ACM

- Erwerb

- präsentieren

- hinzufügen

- Fügt

- Nach der

- aufs Neue

- stimmt zu

- AI

- Algorithmus

- Alle

- erlauben

- erlaubt

- fast

- entlang

- bereits

- ebenfalls

- Betrag

- an

- analysieren

- und

- Martin

- Ein anderer

- beantworten

- Beantwortung

- Antworten

- jedem

- etwas

- Ansatz

- ca.

- SIND

- Bereiche

- argumentieren

- argumentierte

- Argument

- ARM

- vereinbart worden

- künstlich

- AS

- Annahmen

- At

- Autoren

- Automatisiert

- verfügbar

- basic

- Grundsätzlich gilt

- Grundlage

- Battlefield

- BE

- weil

- werden

- wird

- war

- Bevor

- Verhalten

- Verhaltensweisen

- Sein

- Glauben

- unten

- BESTE

- Besser

- zwischen

- Beyond

- vorspannen

- voreingenommen

- Big

- größer

- Größte

- Milliarden

- Bit

- Blockiert

- Bots

- Building

- erbaut

- aber

- by

- Berechnen

- berechnet

- namens

- kam

- CAN

- kann keine

- fähig

- Häuser

- sicher

- sicherlich

- challenges

- Übernehmen

- Änderungen

- Chatbot

- Chatbots

- ChatGPT

- aus der Ferne überprüfen

- Auswählen

- gewählt

- Anspruch

- klar

- kodifiziert

- KOHÄRENT

- Münze

- Kopien

- Sammlung

- Kombination

- Kombinationen

- kombinieren

- vereint

- Vereinigung

- wie die

- kommt

- Kommentar

- Unternehmen

- kompetent

- abschließen

- Komplex

- begreifen

- rechnerisch

- Computer

- zuversichtlich

- Vernetz Dich

- Sie

- Verbindung

- Verbindungen

- Connects

- Konsens

- enthalten

- fortsetzen

- überzeugt

- und beseitigen Muskelschwäche

- entspricht

- Kosten

- könnte

- Kollegen

- verrückt

- Kreativität

- wichtig

- tanzen

- Gefahren

- technische Daten

- entschieden

- sinkt

- DeepMind

- definiert

- zeigen

- bezeichnet

- abhängen

- beschreiben

- entworfen

- entdecken

- Bestimmen

- entwickeln

- entwickelt

- diktiert

- DID

- Unterschied

- verschwinden

- Display

- Anzeige

- Abstand

- Verteilung

- verschieden

- aufteilen

- do

- die

- Tut nicht

- Dabei

- Nicht

- nach unten

- zeichnen

- Drops

- zwei

- Duo

- jeder

- Edge

- entstehen

- Entstehung

- genug

- Ganz

- Gleichungen

- Essenz

- Festlegung

- bewerten

- Sogar

- ÜBERHAUPT

- Jedes

- genau

- Beispiel

- übersteigt

- existieren

- existiert

- erwartet

- Experimente

- Experten

- Erklären

- erklärt

- Explosion

- Umfang

- Tatsache

- Gescheitert

- scheitert

- Messe

- Fallen

- weit

- wenige

- Weniger

- Kämpfe

- findet

- Vorname

- Flip

- Setzen Sie mit Achtsamkeit

- Aussichten für

- unten stehende Formular

- Formen

- bevorstehend

- gefunden

- Foundations

- vier

- Vierte

- Fraktion

- Unser Ansatz

- für

- gewonnen

- Gewinne

- erzeugen

- Erzeugung

- bekommen

- bekommen

- ABSICHT

- gegeben

- gibt

- Unterstützung

- Go

- gehen

- Graph

- Graphen

- mehr

- Boden

- persönlichem Wachstum

- passiert

- das passiert

- Haben

- he

- Köpfe

- hier (auf dänisch)

- hoch

- ihm

- Hinweise

- seine

- Ultraschall

- aber

- HTTPS

- menschenähnlich

- i

- Idee

- if

- vorgestellt

- unmöglich

- beeindruckt

- zu unterstützen,

- verbessert

- in

- beinhaltet

- Erhöhung

- Steigert

- zunehmend

- in der Tat

- Krankengymnastik

- Information

- von Natur aus

- Einblick

- Instanz

- Intelligenz

- in

- Ironie

- isoliert

- IT

- SEINE

- selbst

- nur

- Wesentliche

- Wissen

- bekannt

- kennt

- Mangel

- Sprache

- grosse

- größer

- höchste

- Nachname

- Recht

- Gesetze

- Lays

- umwandeln

- Verlassen

- Niveau

- Cholesterinspiegel

- Gefällt mir

- wahrscheinlich

- Line

- Linien

- LINK

- wenig

- LLM

- logisch

- Lang

- lange Zeit

- aussehen

- Verlust

- Los

- senken

- Maschine

- gemacht

- Zeitschrift

- um

- MACHT

- Weise

- viele

- massiv

- Mathe

- mathematisch

- mathematisch

- Kann..

- vielleicht

- me

- bedeuten

- Bedeutung

- Mittel

- Triff

- Memory

- bloß

- Methode

- Microsoft

- könnte

- Geist / Bewusstsein

- Köpfe

- Modell

- für

- modern

- mehr

- Zudem zeigt

- vor allem warme

- viel

- mehrere

- sollen

- my

- notwendig,

- erforderlich

- Bedürfnisse

- Netzwerk

- Netzwerke

- Nerven-

- neuronale Netzwerk

- Neuronale Netze

- Neuronen

- hört niemals

- Neu

- weiter

- nicht

- Knoten

- Fiber Node

- nichts

- Notion

- jetzt an

- Anzahl

- Zahlen

- und viele

- Objekte

- verdeckt

- offensichtlich

- of

- on

- einmal

- EINEM

- Einsen

- einzige

- OpenAI

- Meinung

- or

- Auftrag

- Original

- Originalität

- Andere

- Anders

- Andernfalls

- Möglichkeiten für das Ausgangssignal:

- übrig

- Gesamt-

- besitzen

- Seiten

- Paar

- Parameter

- Teil

- besondere

- Bestehen

- Personen

- Ausführen

- Leistung

- vielleicht

- Perspektive

- Physik

- Picks

- Stück

- Stücke

- Pionier

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- Möglichkeit

- möglich

- gegebenenfalls

- Werkzeuge

- größte treibende

- Kräfte

- Vorgänger

- vorhersagen

- vorhergesagt

- Vorhersage

- Prognose

- Prognosen

- sagt voraus,

- Präsenz

- Gegenwart

- vorgeführt

- Princeton

- wahrscheinlich

- Probleme

- vorgehen

- Prozessdefinierung

- Herstellung

- Beweis

- nachweisbar

- Beweist

- bietet

- Stellvertreter

- Öffentlichkeit

- setzen

- Putting

- Quantamagazin

- Frage

- Fragen

- zufällig

- erreicht

- realisiert

- wirklich

- Reduziert

- Reduktion

- Referenz

- bezogene

- Beziehungen

- relevant

- verlassen

- bleiben

- merken

- Berühmt

- antworten

- vertreten

- vertreten

- Darstellen

- representiert

- Ruf

- erfordern

- falls angefordert

- erfordert

- Forschungsprojekte

- Forscher

- Forscher

- REST

- zeigen

- Revealed

- rigoros

- Rise

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Said

- gleich

- sah

- sagen

- Skalieren

- Skalierung

- Wissenschaftler

- sehen

- scheinbar

- scheint

- gesehen

- Sinn

- Satz

- kompensieren

- sie

- sollte

- erklären

- ähnlich

- Ähnlich

- Einfacher

- Single

- SIX

- Größe

- Geschicklichkeit

- erfahren

- Fähigkeiten

- kleinere

- So

- Auflösung

- einige

- etwas

- Raumfahrt

- spezifisch

- begonnen

- statistisch

- Immer noch

- mit Stiel

- stark

- Studieren

- erfolgreich

- so

- plötzlich

- Schlägt vor

- Überraschung

- Schwert

- Systeme und Techniken

- Talente

- und Aufgaben

- Team

- zusammengetan

- Test

- getestet

- Testen

- Tests

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Der Graph

- ihr

- Sie

- dann

- theoretisch

- Theorie

- Dort.

- deswegen

- Diese

- vom Nutzer definierten

- Thinks

- fehlen uns die Worte.

- diejenigen

- obwohl?

- tausend

- nach drei

- Schwelle

- So

- Zeit

- zu

- heutigen

- gemeinsam

- auch

- Werkzeuge

- Thema

- Themen

- toronto

- trainiert

- Ausbildung

- Übergänge

- Billion

- was immer dies auch sein sollte.

- Versuch

- WENDE

- Turned

- frisieren

- XNUMX

- tippe

- Typen

- zugrunde liegen,

- verstehen

- Verständnis

- Unerwartet

- Universal-

- Universität

- unwahrscheinlich

- bis

- -

- benutzt

- verwendet

- Verwendung von

- Wert

- verschiedene

- Version

- sehr

- Sieg

- wollen

- wollte

- wurde

- Washington

- Weg..

- Wege

- we

- webp

- waren

- Was

- wann

- ob

- welche

- WHO

- warum

- werden wir

- mit

- .

- fragen

- Word

- Worte

- Arbeiten

- Werk

- weltweit

- würde

- schreiben

- geschrieben

- schrieb

- Jahr

- noch

- Du

- Zephyrnet