Organisationen in der Kredit- und Hypothekenbranche verarbeiten täglich Tausende von Dokumenten. Von einem neuen Hypothekenantrag bis zur Hypothekenrefinanzierung umfassen diese Geschäftsprozesse Hunderte von Dokumenten pro Antrag. Heutzutage ist nur eine begrenzte Automatisierung verfügbar, um Informationen aus allen Dokumenten zu verarbeiten und zu extrahieren, insbesondere aufgrund unterschiedlicher Formate und Layouts. Aufgrund der hohen Anzahl von Bewerbungen ist das Erfassen strategischer Erkenntnisse und das Gewinnen wichtiger Informationen aus den Inhalten ein zeitaufwändiger, sehr manueller, fehleranfälliger und teurer Prozess. Legacy-Tools zur optischen Zeichenerkennung (OCR) sind unerschwinglich, fehleranfällig, erfordern viel Konfiguration und sind schwer zu skalieren. Intelligente Dokumentenverarbeitung (IDP) mit AWS-Diensten für künstliche Intelligenz (KI) hilft bei der Automatisierung und Beschleunigung der Bearbeitung von Hypothekenanträgen mit dem Ziel, schnellere und qualitativ hochwertige Entscheidungen zu treffen und gleichzeitig die Gesamtkosten zu senken.

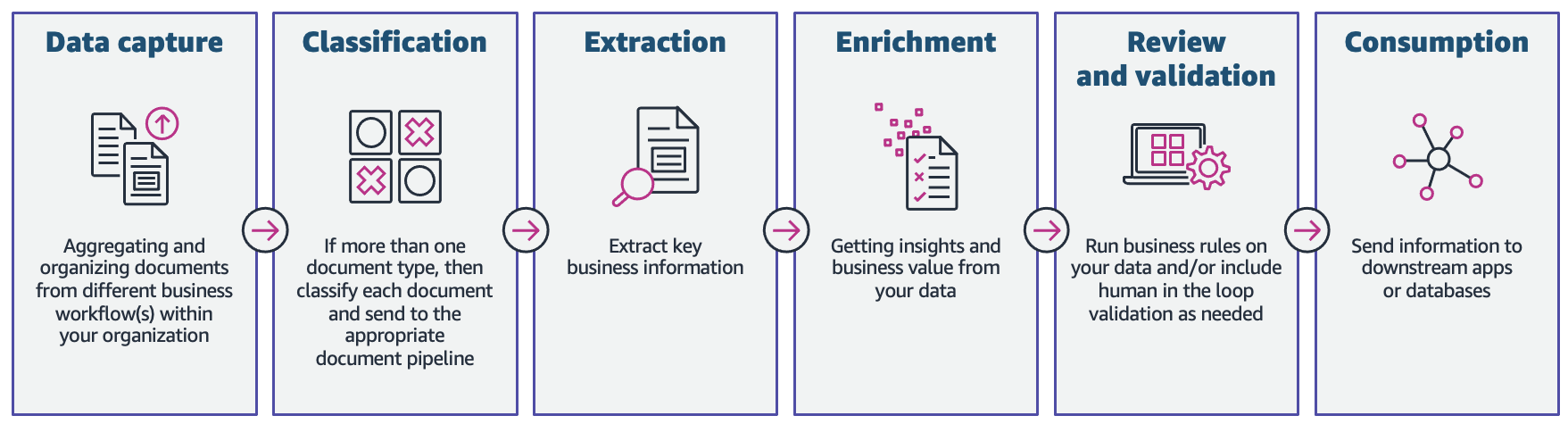

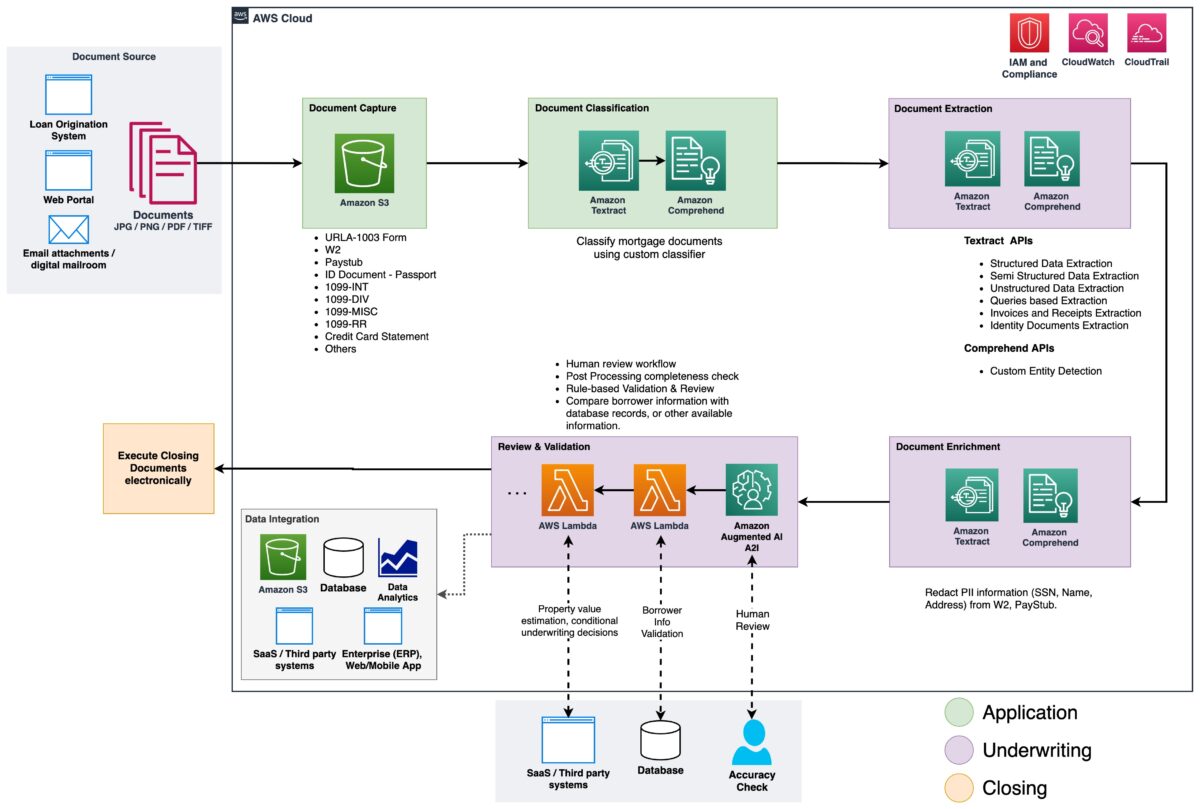

In diesem Beitrag zeigen wir, wie Sie die Funktionen des maschinellen Lernens (ML) nutzen können Amazontext und Amazon verstehen um Dokumente in einem neuen Hypothekenantrag zu verarbeiten, ohne dass ML-Kenntnisse erforderlich sind. Wir untersuchen die verschiedenen Phasen des IDP, wie in der folgenden Abbildung dargestellt, und wie sie mit den Schritten eines Hypothekenantragsprozesses zusammenhängen, wie z. B. Antragstellung, Zeichnung, Überprüfung und Abschluss.

Obwohl jeder Hypothekenantrag einzigartig sein kann, haben wir einige der häufigsten Dokumente berücksichtigt, die in einem Hypothekenantrag enthalten sind, wie z.

Lösungsüberblick

Amazon Textract ist ein ML-Service, der mithilfe vortrainierter ML-Modelle automatisch Text, Handschrift und Daten aus gescannten Dokumenten extrahiert. Amazon Comprehend ist ein Dienst zur Verarbeitung natürlicher Sprache (NLP), der mithilfe von ML wertvolle Einblicke und Verbindungen in Texten aufdeckt und Dokumentenklassifizierung, Namenserkennung (NER), Themenmodellierung und mehr durchführen kann.

Die folgende Abbildung zeigt die Phasen des IDP in Bezug auf die Phasen eines Hypothekenantragsprozesses.

Zu Beginn des Prozesses werden Dokumente in eine hochgeladen Amazon Simple Storage-Service (Amazon S3) Eimer. Dies initiiert einen Dokumentenklassifizierungsprozess, um die Dokumente in bekannte Kategorien zu kategorisieren. Nachdem die Dokumente kategorisiert wurden, besteht der nächste Schritt darin, Schlüsselinformationen daraus zu extrahieren. Wir führen dann eine Anreicherung für ausgewählte Dokumente durch, bei denen es sich um Dinge wie das Entfernen von personenbezogenen Daten (PII), Dokument-Tagging, Metadatenaktualisierungen und mehr handeln kann. Der nächste Schritt beinhaltet die Validierung der in den vorherigen Phasen extrahierten Daten, um die Vollständigkeit eines Hypothekenantrags sicherzustellen. Die Validierung kann über Geschäftsvalidierungsregeln und dokumentenübergreifende Validierungsregeln erfolgen. Die Konfidenzwerte der extrahierten Informationen können auch mit einem festgelegten Schwellenwert verglichen und automatisch an einen menschlichen Prüfer weitergeleitet werden Amazon Augmented AI (Amazon A2I), wenn der Schwellenwert nicht erreicht wird. In der letzten Phase des Prozesses werden die extrahierten und validierten Daten zur weiteren Speicherung, Verarbeitung oder Datenanalyse an nachgelagerte Systeme gesendet.

In den folgenden Abschnitten besprechen wir die Phasen des IDP in Bezug auf die Phasen eines Hypothekenantrags im Detail. Wir gehen durch die Phasen des IDP und diskutieren die Arten von Dokumenten; wie wir Informationen speichern, klassifizieren und extrahieren und wie wir die Dokumente durch maschinelles Lernen anreichern.

Dokumentenspeicher

Amazon S3 ist ein Objektspeicherdienst, der branchenführende Skalierbarkeit, Datenverfügbarkeit, Sicherheit und Leistung bietet. Wir verwenden Amazon S3, um die Hypothekendokumente während und nach dem Hypothekenantragsverfahren sicher aufzubewahren. EIN Hypothekenantragspaket kann mehrere Arten von Formularen und Dokumenten enthalten, z. B. URLA-1003, 1099-INT/DIV/RR/MISC, W2, Gehaltsabrechnungen, Kontoauszüge, Kreditkartenauszüge und mehr. Diese Unterlagen werden vom Antragsteller in der Hypothekenantragsphase eingereicht. Ohne manuelles Durchsehen ist möglicherweise nicht sofort klar, welche Dokumente in dem Paket enthalten sind. Dieser manuelle Prozess kann zeitaufwändig und teuer sein. In der nächsten Phase automatisieren wir diesen Prozess mit Amazon Comprehend, um die Dokumente mit hoher Genauigkeit in ihre jeweiligen Kategorien zu klassifizieren.

Dokumentklassifizierung

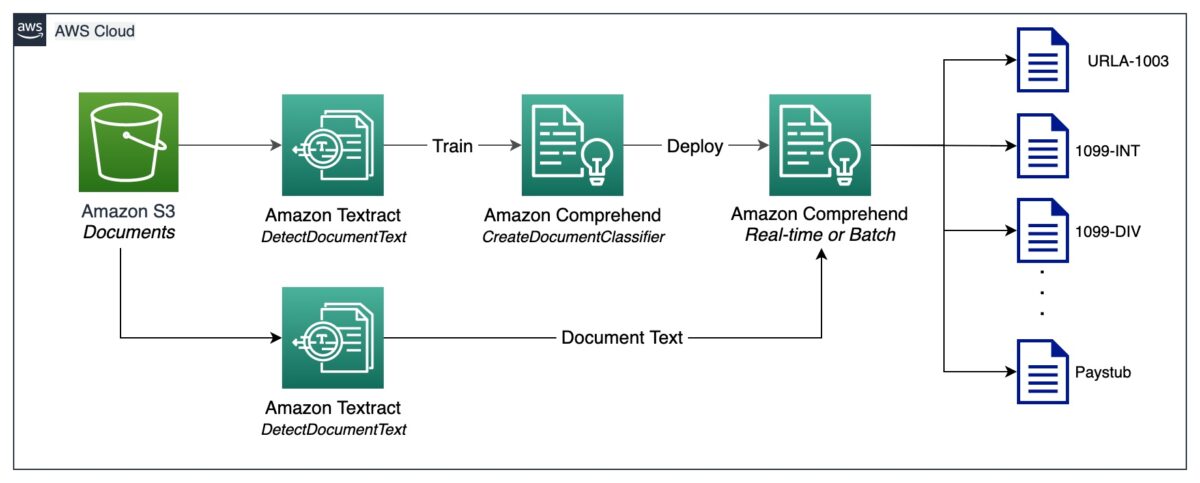

Die Dokumentenklassifizierung ist eine Methode, mit der eine große Anzahl nicht identifizierter Dokumente kategorisiert und gekennzeichnet werden kann. Wir führen diese Dokumentenklassifizierung mit einem Amazon Comprehend durch benutzerdefinierter Klassifikator. Ein benutzerdefinierter Klassifikator ist ein ML-Modell, das mit einer Reihe gekennzeichneter Dokumente trainiert werden kann, um die für Sie interessanten Klassen zu erkennen. Nachdem das Modell trainiert und hinter einem gehosteten Endpunkt bereitgestellt wurde, können wir den Klassifikator verwenden, um die Kategorie (oder Klasse) zu bestimmen, zu der ein bestimmtes Dokument gehört. In diesem Fall trainieren wir einen benutzerdefinierten Klassifikator Mehrklassenmodus, was entweder mit einer CSV-Datei oder einer erweiterten Manifestdatei erfolgen kann. Für diese Demonstration verwenden wir eine CSV-Datei, um den Klassifikator zu trainieren. Beziehen Sie sich auf unsere GitHub-Repository für das vollständige Codebeispiel. Im Folgenden finden Sie eine grobe Übersicht über die erforderlichen Schritte:

- Extrahieren Sie mit Amazon Textract UTF-8-codierten Klartext aus Bild- oder PDF-Dateien DokumentText erkennen API.

- Bereiten Sie Trainingsdaten vor, um einen benutzerdefinierten Klassifikator im CSV-Format zu trainieren.

- Trainieren Sie einen benutzerdefinierten Klassifikator mithilfe der CSV-Datei.

- Stellen Sie das trainierte Modell mit einem Endpunkt für die Dokumentenklassifizierung in Echtzeit bereit oder verwenden Sie den Mehrklassenmodus, der sowohl Echtzeit- als auch asynchrone Vorgänge unterstützt.

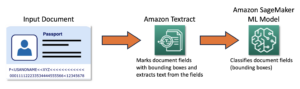

Das folgende Diagramm veranschaulicht diesen Vorgang.

Sie können die Dokumentenklassifizierung mithilfe des bereitgestellten Endpunkts automatisieren, um Dokumente zu identifizieren und zu kategorisieren. Diese Automatisierung ist nützlich, um zu überprüfen, ob alle erforderlichen Dokumente in einem Hypothekenpaket vorhanden sind. Ein fehlendes Dokument kann ohne manuellen Eingriff schnell identifiziert und dem Antragsteller viel früher im Prozess mitgeteilt werden.

Dokumentenextraktion

In dieser Phase extrahieren wir mit Amazon Textract und Amazon Comprehend Daten aus dem Dokument. Für strukturierte und halbstrukturierte Dokumente, die Formulare und Tabellen enthalten, verwenden wir den Amazon Textract Dokument analysieren API. Für spezielle Dokumente wie Ausweisdokumente bietet Amazon Textract die AnalyseID API. Einige Dokumente können auch dichten Text enthalten, und Sie müssen möglicherweise unternehmensspezifische Schlüsselbegriffe daraus extrahieren, die auch als Entitäten. Wir benutzen das benutzerdefinierte Entitätserkennung Fähigkeit von Amazon Comprehend, eine benutzerdefinierte Entitätserkennung zu trainieren, die solche Entitäten aus dem dichten Text identifizieren kann.

In den folgenden Abschnitten gehen wir die Musterdokumente durch, die in einem Hypothekenantragspaket enthalten sind, und erörtern die Methoden, mit denen Informationen daraus extrahiert werden. Für jedes dieser Beispiele sind ein Code-Snippet und eine kurze Beispielausgabe enthalten.

Extrahieren Sie Daten aus der einheitlichen Wohnungsdarlehensanwendung URLA-1003

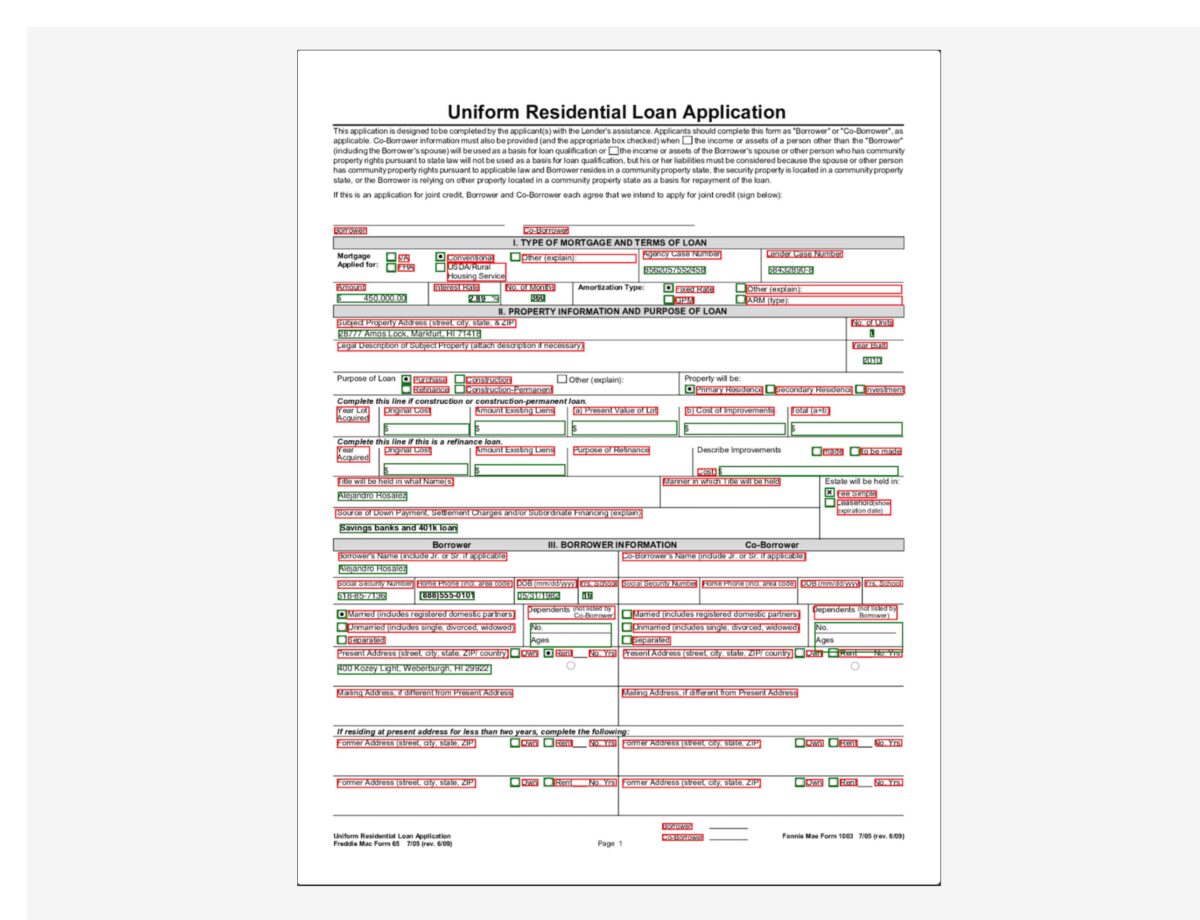

Ein einheitlicher Wohnungsbaudarlehensantrag (URLA-1003) ist ein branchenübliches Antragsformular für Hypothekendarlehen. Es ist ein ziemlich komplexes Dokument, das Informationen über den Hypothekenantragsteller, die Art der gekauften Immobilie, den zu finanzierenden Betrag und andere Details über die Art des Immobilienkaufs enthält. Das Folgende ist ein Beispiel für URLA-1003, und wir beabsichtigen, Informationen aus diesem strukturierten Dokument zu extrahieren. Da es sich um ein Formular handelt, verwenden wir die AnalyzeDocument-API mit einem Funktionstyp von FORMULAR.

Der Feature-Typ FORM extrahiert Formularinformationen aus dem Dokument, die dann im Schlüssel-Wert-Paar-Format zurückgegeben werden. Das folgende Code-Snippet verwendet die amazon-textract-textractor Python-Bibliothek zum Extrahieren von Formularinformationen mit nur wenigen Codezeilen. Die Convenience-Methode call_textract() ruft die AnalyzeDocument API intern und die an die Methode übergebenen Parameter abstrahieren einige der Konfigurationen, die die API zum Ausführen der Extraktionsaufgabe benötigt. Document ist eine bequeme Methode, mit der die JSON-Antwort von der API analysiert werden kann. Es bietet eine Abstraktion auf hoher Ebene und macht die API-Ausgabe iterierbar und es ist einfach, Informationen daraus abzurufen. Weitere Informationen finden Sie unter Textract-Antwortparser und Texttraktor.

Beachten Sie, dass die Ausgabe Werte für Kontrollkästchen oder Optionsfelder enthält, die im Formular vorhanden sind. Beispielsweise wird im URLA-1003-Beispieldokument die Bezug von MarvelClient Option ausgewählt wurde. Die entsprechende Ausgabe für das Optionsfeld wird extrahiert als „Purchase“ (Taste) und „SELECTED” (Wert), was anzeigt, dass das Optionsfeld ausgewählt wurde.

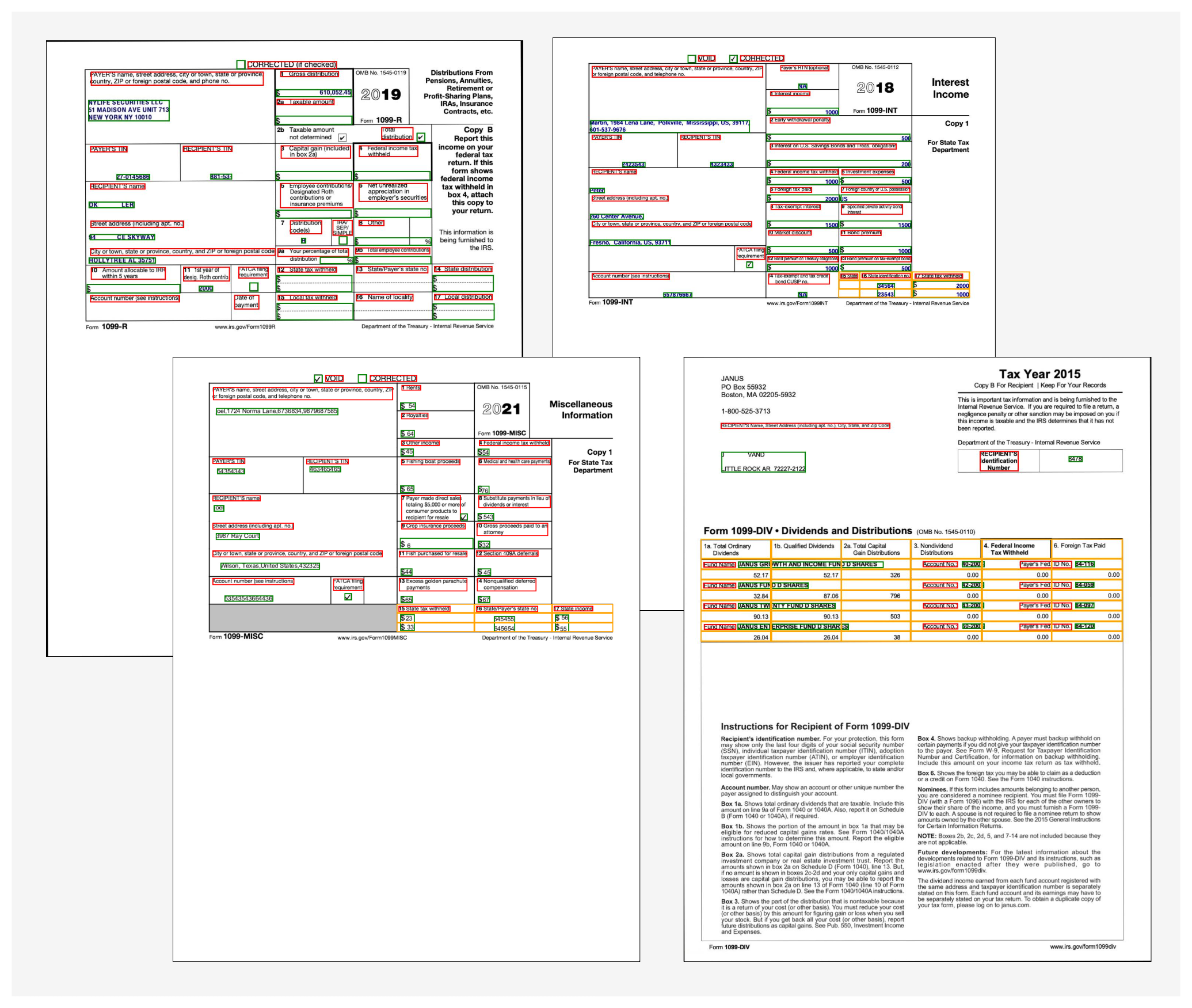

Daten aus 1099 Formularen extrahieren

Ein Hypothekenantragspaket kann auch eine Reihe von IRS-Dokumenten enthalten, wie z. B. 1099-DIV, 1099-INT, 1099-MISC und 1099-R. Diese Dokumente zeigen das Einkommen des Antragstellers über Zinsen, Dividenden und andere verschiedene Einkommenskomponenten, die während des Underwritings nützlich sind, um Entscheidungen zu treffen. Das folgende Bild zeigt eine Sammlung dieser Dokumente, die ähnlich aufgebaut sind. In manchen Fällen enthalten die Dokumente jedoch sowohl Formularinformationen (gekennzeichnet durch die roten und grünen Begrenzungsrahmen) als auch tabellarische Informationen (gekennzeichnet durch die gelben Begrenzungsrahmen).

Um Formularinformationen zu extrahieren, verwenden wir ähnlichen Code wie zuvor mit dem erklärt AnalyzeDocument API. Wir übergeben ein zusätzliches Feature von TABELLE an die API, um anzugeben, dass wir sowohl Formular- als auch Tabellendaten benötigen, die aus dem Dokument extrahiert wurden. Das folgende Code-Snippet verwendet die AnalyzeDocument API mit FORMS- und TABLES-Funktionen im 1099-INT-Dokument:

Da das Dokument eine einzelne Tabelle enthält, sieht die Ausgabe des Codes wie folgt aus:

Die Tabelleninformationen enthalten die Zellenposition (Zeile 0, Spalte 0 usw.) und den entsprechenden Text in jeder Zelle. Wir verwenden eine praktische Methode, die diese Tabellendaten in eine leicht lesbare Rasteransicht umwandeln kann:

Wir erhalten folgende Ausgabe:

Um die Ausgabe in einem einfach zu verwendenden CSV-Format zu erhalten, muss der Formattyp von Pretty_Print_Table_Format.csv kann in die übergeben werden table_format Parameter. Andere Formate wie TSV (tabulatorgetrennte Werte), HTML und Latex werden ebenfalls unterstützt. Weitere Informationen finden Sie unter Textract-PrettyPrinter.

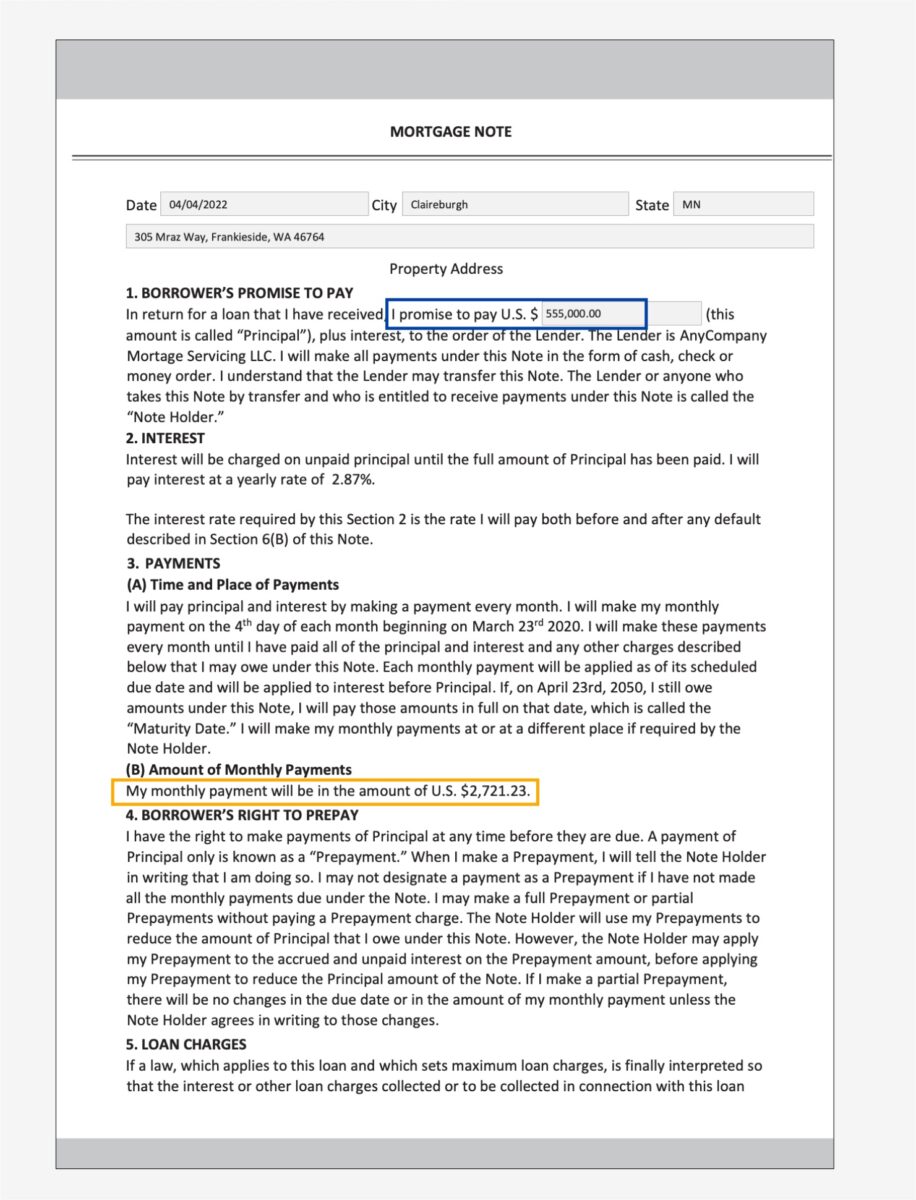

Extrahieren Sie Daten aus einem Hypothekenbrief

Ein Hypothekenantragspaket kann unstrukturierte Dokumente mit dichtem Text enthalten. Einige Beispiele für Dokumente mit dichtem Text sind Verträge und Vereinbarungen. Ein Hypothekenbrief ist eine Vereinbarung zwischen einem Hypothekenantragsteller und dem Kreditgeber oder Hypothekenunternehmen und enthält Informationen in Abschnitten mit dichtem Text. In solchen Fällen macht es die fehlende Struktur schwierig, wichtige Geschäftsinformationen zu finden, die für den Hypothekenantragsprozess wichtig sind. Zur Lösung dieses Problems gibt es zwei Ansätze:

In dem folgenden Muster-Schuldbrief interessieren wir uns speziell für die monatliche Zahlungshöhe und den Kapitalbetrag.

Für den ersten Ansatz verwenden wir die Query und QueriesConfig Convenience-Methoden zum Konfigurieren einer Reihe von Fragen, die an Amazon Textract übergeben werden AnalyzeDocument API-Aufruf. Falls das Dokument mehrseitig ist (PDF oder TIFF), können wir auch die Seitenzahlen angeben, auf denen Amazon Textract nach Antworten auf die Frage suchen soll. Das folgende Code-Snippet zeigt, wie Sie die Abfragekonfiguration erstellen, einen API-Aufruf tätigen und anschließend die Antwort parsen, um die Antworten aus der Antwort zu erhalten:

Wir erhalten folgende Ausgabe:

Für den zweiten Ansatz verwenden wir das Amazon Comprehend Entitäten erkennen API mit dem Hypothekenbrief, der die Entitäten zurückgibt, die er im Text von a erkennt vordefinierter Satz von Entitäten. Dies sind Entitäten, mit denen die Entitätserkennung von Amazon Comprehend vortrainiert ist. Da unsere Anforderung jedoch darin besteht, bestimmte Entitäten zu erkennen, wird eine benutzerdefinierte Entitätserkennung von Amazon Comprehend mit einer Reihe von Beispieldokumenten für Hypothekenbriefe und einer Liste von Entitäten trainiert. Wir definieren die Entitätsnamen als PRINCIPAL_AMOUNT und MONTHLY_AMOUNT. Trainingsdaten werden nach dem Amazon Comprehend-Training vorbereitet Richtlinien zur Datenaufbereitung für benutzerdefinierte Entitätserkennung. Mit dem Entity Recognizer kann trainiert werden Dokumentanmerkungen oder Entitätslisten. Für die Zwecke dieses Beispiels verwenden wir Entitätslisten, um das Modell zu trainieren. Nachdem wir das Modell trainiert haben, können wir es mit a bereitstellen Echtzeit-Endpunkt oder in Batch-Modus um die beiden Entitäten aus dem Dokumentinhalt zu erkennen. Im Folgenden sind die Schritte aufgeführt, die erforderlich sind, um eine benutzerdefinierte Entitätserkennung zu trainieren und bereitzustellen. Eine vollständige Anleitung zum Code finden Sie in unserem GitHub-Repository.

- Bereiten Sie die Trainingsdaten vor (die Entitätsliste und die Dokumente im (UTF-8-codierten) Klartextformat).

- Starten Sie das Entitätserkennungstraining mit der CreateEntityRecognizer API unter Verwendung der Trainingsdaten.

- Stellen Sie das trainierte Modell mit einem Echtzeit-Endpunkt mithilfe von bereit Endpunkt erstellen API.

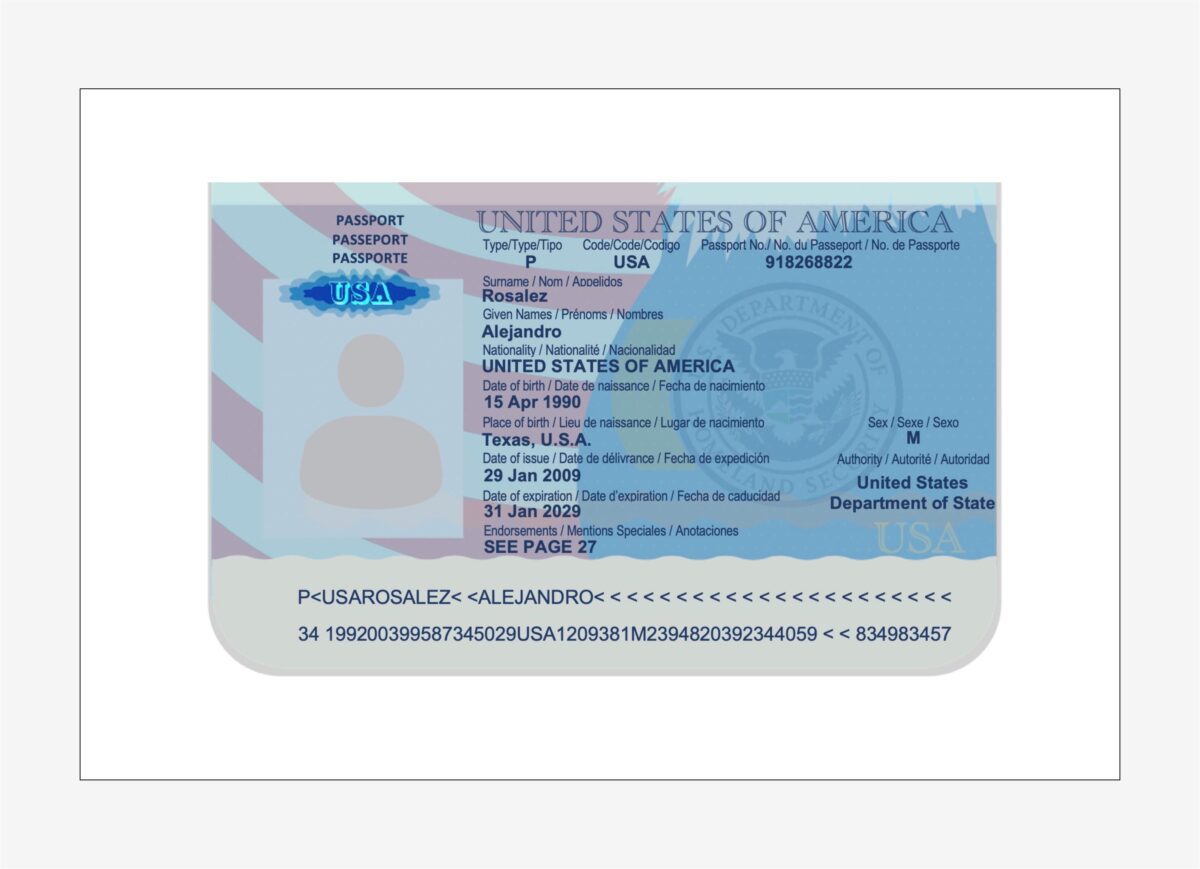

Extrahieren Sie Daten aus einem US-Pass

Der Amazon Textract Identitätsdokumente analysieren Die Funktion kann Informationen aus US-basierten ID-Dokumenten wie Führerschein und Reisepass erkennen und extrahieren. Das AnalyzeID Die API ist in der Lage, implizite Felder in ID-Dokumenten zu erkennen und zu interpretieren, was es einfach macht, bestimmte Informationen aus dem Dokument zu extrahieren. Identitätsdokumente sind fast immer Teil eines Hypothekenantragspakets, da sie verwendet werden, um die Identität des Kreditnehmers während des Underwriting-Prozesses zu überprüfen und die Richtigkeit der biografischen Daten des Kreditnehmers zu validieren.

Wir verwenden eine Convenience-Methode namens call_textract_analyzeid, die die ruft AnalyzeID API intern. Wir iterieren dann über die Antwort, um die erkannten Schlüssel-Wert-Paare aus dem ID-Dokument zu erhalten. Siehe folgenden Code:

AnalyzeID gibt Informationen in einer Struktur namens zurück IdentityDocumentFields, die die normalisierten Schlüssel und ihren entsprechenden Wert enthält. In der folgenden Ausgabe beispielsweise FIRST_NAME ist ein normalisierter Schlüssel und der Wert ist ALEJANDRO. Im Beispiel-Passbild ist das Feld für den Vornamen jedoch mit „Given Names / Prénoms / Nombre“ beschriftet AnalyzeID konnte das in den Schlüsselnamen normalisieren FIRST_NAME. Eine Liste der unterstützten normalisierten Felder finden Sie unter Antwortobjekte der Identitätsdokumentation.

Ein Hypothekenpaket kann mehrere andere Dokumente enthalten, z. B. eine Gehaltsabrechnung, ein W2-Formular, einen Kontoauszug, eine Kreditkartenabrechnung und einen Beschäftigungsbestätigungsbrief. Wir haben Muster für jedes dieser Dokumente zusammen mit dem Code, der zum Extrahieren von Daten aus ihnen erforderlich ist. Die vollständige Codebasis finden Sie in den Notebooks in unserem GitHub-Repository.

Anreicherung von Dokumenten

Eine der häufigsten Formen der Dokumentenanreicherung ist die Schwärzung sensibler oder vertraulicher Informationen in Dokumenten, die aufgrund von Datenschutzgesetzen oder -bestimmungen vorgeschrieben sein kann. Beispielsweise kann die Gehaltsabrechnung eines Hypothekenantragstellers vertrauliche PII-Daten wie Name, Adresse und Sozialversicherungsnummer enthalten, die möglicherweise für eine längere Speicherung unkenntlich gemacht werden müssen.

Im vorangehenden Muster-Gehaltsabrechnungsdokument führen wir eine Schwärzung von PII-Daten wie Sozialversicherungsnummer, Name, Bankkontonummer und Daten durch. Um PII-Daten in einem Dokument zu identifizieren, verwenden wir das Amazon Comprehend PII-Erkennung Fähigkeit über die DetectPIIItities API. Diese API untersucht den Inhalt des Dokuments, um das Vorhandensein von PII-Informationen zu identifizieren. Da diese API Eingaben im UTF-8-codierten Nur-Text-Format erfordert, extrahieren wir zunächst den Text aus dem Dokument mithilfe von Amazon Textract DokumentText erkennen API, die den Text aus dem Dokument und auch Geometrieinformationen wie Abmessungen und Koordinaten des Begrenzungsrahmens zurückgibt. Eine Kombination beider Ausgaben wird dann verwendet, um im Rahmen des Anreicherungsprozesses Schwärzungen auf dem Dokument vorzunehmen.

Überprüfen, validieren und integrieren Sie Daten

Extrahierte Daten aus der Dokumentenextraktionsphase müssen möglicherweise anhand bestimmter Geschäftsregeln validiert werden. Bestimmte Informationen können auch über mehrere Dokumente hinweg validiert werden, auch bekannt als Cross-Doc-Validierung. Ein Beispiel für eine dokumentenübergreifende Validierung könnte der Vergleich des Namens des Antragstellers im Ausweisdokument mit dem Namen im Hypothekenantragsdokument sein. Sie können in dieser Phase auch andere Validierungen wie Immobilienwertschätzungen und bedingte Zeichnungsentscheidungen durchführen.

Eine dritte Art der Validierung bezieht sich auf den Konfidenzwert der extrahierten Daten in der Dokumentenextraktionsphase. Amazon Textract und Amazon Comprehend geben einen Konfidenzwert für Formulare, Tabellen, Textdaten und erkannte Entitäten zurück. Sie können einen Schwellenwert für die Konfidenzbewertung konfigurieren, um sicherzustellen, dass nur korrekte Werte nachgelagert gesendet werden. Dies wird über Amazon A2I erreicht, das die Konfidenzwerte erkannter Daten mit einem vordefinierten Konfidenzschwellenwert vergleicht. Wenn der Schwellenwert nicht erreicht wird, werden das Dokument und die extrahierte Ausgabe über eine intuitive Benutzeroberfläche zur Überprüfung an einen Menschen weitergeleitet. Der Prüfer nimmt Korrekturmaßnahmen an den Daten vor und speichert sie zur weiteren Bearbeitung. Weitere Informationen finden Sie unter Kernkonzepte von Amazon A2I.

Zusammenfassung

In diesem Beitrag haben wir die Phasen der intelligenten Dokumentenverarbeitung in Bezug auf die Phasen eines Hypothekenantrags besprochen. Wir haben uns einige gängige Beispiele für Dokumente angesehen, die in einem Hypothekenantragspaket zu finden sind. Wir haben auch Möglichkeiten diskutiert, strukturierte, halbstrukturierte und unstrukturierte Inhalte aus diesen Dokumenten zu extrahieren und zu verarbeiten. IDP bietet eine Möglichkeit zur Automatisierung der End-to-End-Verarbeitung von Hypothekendokumenten, die auf Millionen von Dokumenten skaliert werden kann, wodurch die Qualität von Antragsentscheidungen verbessert, Kosten gesenkt und Kunden schneller bedient werden.

Als nächsten Schritt können Sie die Codebeispiele und Notebooks in unserem ausprobieren GitHub-Repository. Um mehr darüber zu erfahren, wie IDP Ihre Dokumentenverarbeitungs-Workloads unterstützen kann, besuchen Sie Automatisieren Sie die Datenverarbeitung aus Dokumenten.

Über die Autoren

Anjan Biswas ist Senior AI Services Solutions Architect mit Fokus auf AI/ML und Data Analytics. Anjan ist Teil des weltweiten KI-Serviceteams und arbeitet mit Kunden zusammen, um ihnen zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

Anjan Biswas ist Senior AI Services Solutions Architect mit Fokus auf AI/ML und Data Analytics. Anjan ist Teil des weltweiten KI-Serviceteams und arbeitet mit Kunden zusammen, um ihnen zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

Dwiti Pathak ist ein Senior Technical Account Manager mit Sitz in San Diego. Sie konzentriert sich darauf, der Halbleiterindustrie dabei zu helfen, sich an AWS zu beteiligen. In ihrer Freizeit liest sie gerne über neue Technologien und spielt Brettspiele.

Dwiti Pathak ist ein Senior Technical Account Manager mit Sitz in San Diego. Sie konzentriert sich darauf, der Halbleiterindustrie dabei zu helfen, sich an AWS zu beteiligen. In ihrer Freizeit liest sie gerne über neue Technologien und spielt Brettspiele.

Balaji Puli ist ein Lösungsarchitekt mit Sitz in Bay Area, CA. Unterstützt derzeit ausgewählte Life-Science-Kunden aus dem Gesundheitswesen im Nordwesten der USA bei der Beschleunigung ihrer AWS-Cloud-Einführung. Balaji reist gerne und liebt es, verschiedene Küchen zu entdecken.

Balaji Puli ist ein Lösungsarchitekt mit Sitz in Bay Area, CA. Unterstützt derzeit ausgewählte Life-Science-Kunden aus dem Gesundheitswesen im Nordwesten der USA bei der Beschleunigung ihrer AWS-Cloud-Einführung. Balaji reist gerne und liebt es, verschiedene Küchen zu entdecken.

- Fortgeschritten (300)

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon verstehen

- Amazontext

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet