Amazon SageMaker Data Wrangler hilft Ihnen, Daten für maschinelles Lernen (ML) über eine einzige visuelle Oberfläche zu verstehen, zu aggregieren, zu transformieren und vorzubereiten. Es enthält über 300 integrierte Datentransformationen, sodass Sie Funktionen schnell normalisieren, transformieren und kombinieren können, ohne Code schreiben zu müssen.

Data-Science-Praktiker generieren, beobachten und verarbeiten Daten, um Geschäftsprobleme zu lösen, wenn sie Funktionen aus Datensätzen transformieren und extrahieren müssen. Transformationen wie ordinale Kodierung oder One-Hot-Kodierung lernen Kodierungen in Ihrem Dataset. Diese codierten Ausgaben werden als trainierte Parameter bezeichnet. Da sich Datensätze im Laufe der Zeit ändern, kann es erforderlich sein, Codierungen für zuvor nicht sichtbare Daten neu anzupassen, um den Transformationsfluss für Ihre Daten relevant zu halten.

Wir freuen uns, die Funktion „Trainierte Parameter neu anpassen“ ankündigen zu können, mit der Sie zuvor trainierte Parameter verwenden und nach Wunsch neu anpassen können. In diesem Beitrag zeigen wir, wie Sie diese Funktion verwenden.

Überblick über die Refit-Funktion von Data Wrangler

Wir veranschaulichen, wie diese Funktion mit dem folgenden Beispiel funktioniert, bevor wir uns mit den Besonderheiten der Funktion zum erneuten Anpassen trainierter Parameter befassen.

Angenommen, Ihr Kundendatensatz hat eine kategoriale Funktion für country dargestellt als Zeichenfolgen wie Australia und Singapore. ML-Algorithmen erfordern numerische Eingaben; Daher müssen diese kategorialen Werte in numerische Werte codiert werden. Das Codieren von kategorialen Daten ist der Prozess der Erstellung einer numerischen Darstellung für Kategorien. Zum Beispiel, wenn Ihre Kategorie Land Werte hat Australia und Singapore, können Sie diese Informationen in zwei Vektoren codieren: [1, 0] zur Darstellung Australia und [0, 1] zur Darstellung Singapore. Die hier verwendete Transformation ist One-Hot-Codierung, und die neue codierte Ausgabe spiegelt die trainierten Parameter wider.

Nach dem Training des Modells können Ihre Kunden im Laufe der Zeit zunehmen und Sie haben deutlichere Werte in der Länderliste. Der neue Datensatz könnte eine andere Kategorie enthalten, India, das nicht Teil des ursprünglichen Datasets war, was die Modellgenauigkeit beeinträchtigen kann. Daher ist es notwendig, Ihr Modell mit den neuen Daten, die im Laufe der Zeit gesammelt wurden, neu zu trainieren.

Um dieses Problem zu lösen, müssen Sie die Codierung aktualisieren, um die neue Kategorie einzuschließen, und die Vektordarstellung gemäß Ihrem neuesten Datensatz aktualisieren. In unserem Beispiel sollte die Codierung die neue Kategorie für die widerspiegeln country, Das ist India. Wir bezeichnen diesen Vorgang des Aktualisierens einer Codierung üblicherweise als Refit-Vorgang. Nachdem Sie den Refit-Vorgang durchgeführt haben, erhalten Sie die neue Codierung: Australia: [1], Singapore: [0, 1, 0] und India: [0, 0, 1]. Das erneute Anpassen der One-Hot-Codierung und das anschließende erneute Trainieren des Modells auf dem neuen Datensatz führt zu qualitativ besseren Vorhersagen.

Die Refit-Trained-Parameter-Funktion von Data Wrangler ist in den folgenden Fällen nützlich:

- Dem Datensatz werden neue Daten hinzugefügt – Das ML-Modell muss neu trainiert werden, wenn der Datensatz mit neuen Daten angereichert wird. Um optimale Ergebnisse zu erzielen, müssen wir die trainierten Parameter an den neuen Datensatz anpassen.

- Training mit einem vollständigen Dataset nach der Durchführung von Feature-Engineering an Beispieldaten – Bei einem großen Datensatz wird eine Stichprobe des Datensatzes zum Lernen trainierter Parameter in Betracht gezogen, die möglicherweise nicht Ihren gesamten Datensatz darstellen. Wir müssen die trainierten Parameter für den vollständigen Datensatz neu lernen.

Im Folgenden sind einige der häufigsten Data Wrangler-Transformationen aufgeführt, die für das Dataset ausgeführt werden und von der Option zum erneuten Anpassen trainierter Parameter profitieren:

Weitere Informationen zu Transformationen in Data Wrangler finden Sie unter Daten transformieren.

In diesem Beitrag zeigen wir, wie diese trainierten Parameter auf Datensätzen mit Data Wrangler verarbeitet werden. Sie können Data Wrangler-Flows in Produktionsjobs verwenden, um Ihre Daten erneut zu verarbeiten, wenn sie wachsen und sich ändern.

Lösungsüberblick

In diesem Beitrag demonstrieren wir, wie Sie die Refit-Trained-Parameter-Funktion von Data Wrangler mit dem öffentlich verfügbaren Datensatz verwenden Kaggle: US-Wohnungsdaten von Zillow, zum Verkauf stehende Immobilien in den Vereinigten Staaten. Es hat die Hausverkaufspreise über verschiedene geografische Verteilungen von Häusern.

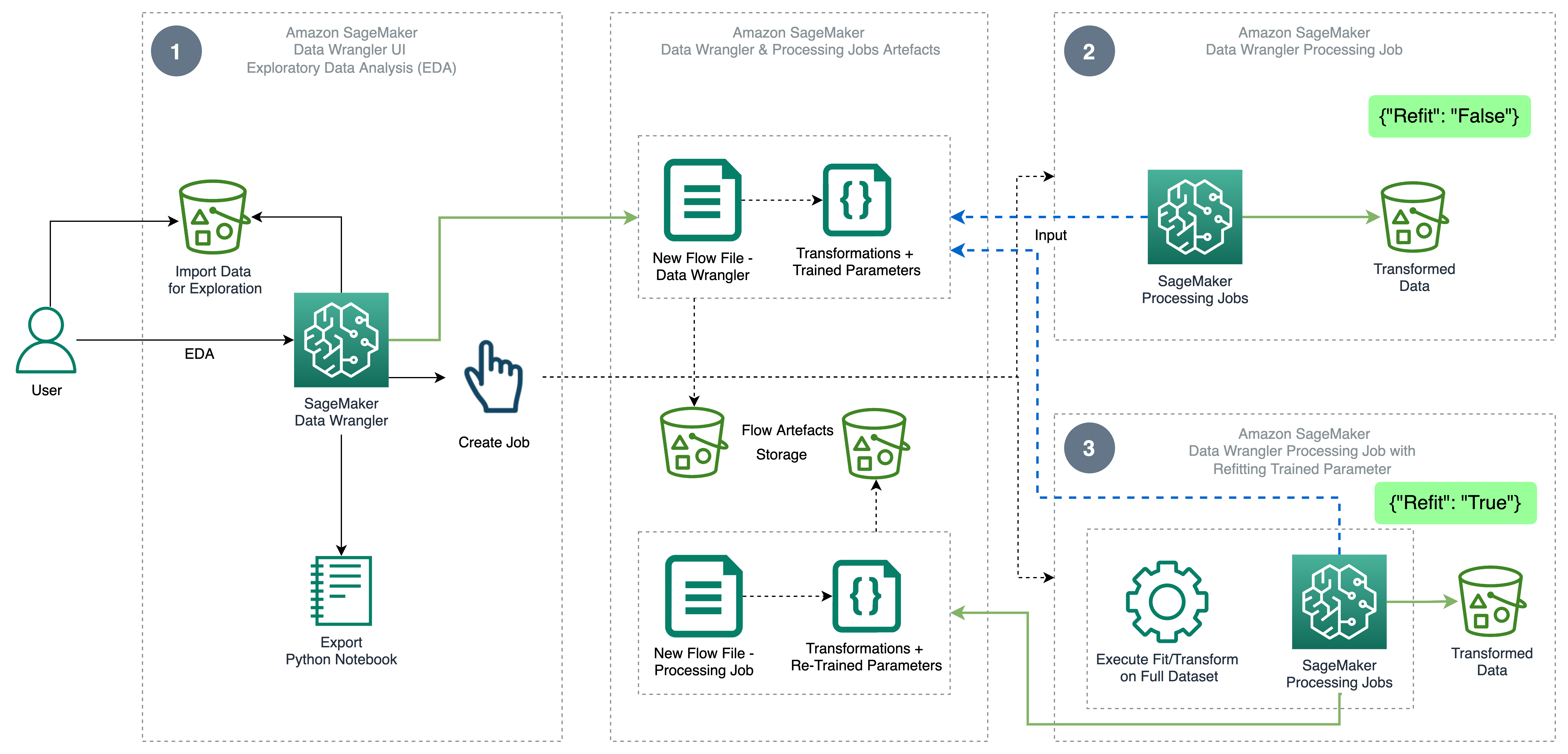

Das folgende Diagramm veranschaulicht die High-Level-Architektur von Data Wrangler unter Verwendung des Refit-Trained-Parameter-Features. Wir zeigen auch die Auswirkung auf die Datenqualität ohne den refit trainierten Parameter und stellen die Ergebnisse am Ende gegenüber.

Der Workflow umfasst die folgenden Schritte:

- Führen Sie eine explorative Datenanalyse durch – Erstellen Sie einen neuen Flow auf Data Wrangler, um die explorative Datenanalyse (EDA) zu starten. Importieren Sie Geschäftsdaten, um Ihre Daten zu verstehen, zu bereinigen, zu aggregieren, zu transformieren und für Schulungen vorzubereiten. Beziehen auf Erkunden Sie die Funktionen von Amazon SageMaker Data Wrangler mit Beispieldatensätzen für weitere Details zur Durchführung von EDA mit Data Wrangler.

- Erstellen Sie einen Datenverarbeitungsauftrag – Dieser Schritt exportiert alle Transformationen, die Sie am Dataset vorgenommen haben, als Flow-Datei, die in der konfigurierten Datei gespeichert ist Amazon Simple Storage-Service (Amazon S3) Standort. Der Datenverarbeitungsauftrag mit der von Data Wrangler generierten Flow-Datei wendet die Transformationen und trainierten Parameter an, die auf Ihrem Datensatz gelernt wurden. Wenn der Datenverarbeitungsauftrag abgeschlossen ist, werden die Ausgabedateien an den im Zielknoten konfigurierten Amazon S3-Speicherort hochgeladen. Beachten Sie, dass die Refit-Option standardmäßig deaktiviert ist. Anstatt den Verarbeitungsauftrag sofort auszuführen, können Sie das auch Planen Sie einen Verarbeitungsauftrag ein mit wenigen Klicks mit Data Wrangler – Job erstellen, der zu bestimmten Zeiten ausgeführt wird.

- Erstellen Sie einen Datenverarbeitungsauftrag mit der Funktion zum erneuten Anpassen trainierter Parameter – Wählen Sie beim Erstellen des Jobs die Funktion „Neu anpassen trainierter Parameter“, um das Neulernen Ihrer trainierten Parameter für Ihren vollständigen oder verstärkten Datensatz zu erzwingen. Gemäß der Amazon S3-Standortkonfiguration zum Speichern der Flow-Datei erstellt oder aktualisiert der Datenverarbeitungsauftrag die neue Flow-Datei. Wenn Sie denselben Amazon S3-Standort wie in Schritt 2 konfigurieren, aktualisiert der Datenverarbeitungsauftrag die in Schritt 2 generierte Flow-Datei, die verwendet werden kann, um Ihren Flow für Ihre Daten relevant zu halten. Nach Abschluss des Verarbeitungsauftrags werden die Ausgabedateien in den für den Zielknoten konfigurierten S3-Bucket hochgeladen. Sie können den aktualisierten Ablauf für Ihren gesamten Datensatz für einen Produktionsworkflow verwenden.

Voraussetzungen:

Bevor Sie beginnen, laden Sie das Dataset in einen S3-Bucket hoch und importieren Sie es dann in Data Wrangler. Anweisungen finden Sie unter Importieren Sie Daten aus Amazon S3.

Gehen wir nun die im Architekturdiagramm erwähnten Schritte durch.

Führen Sie EDA in Data Wrangler durch

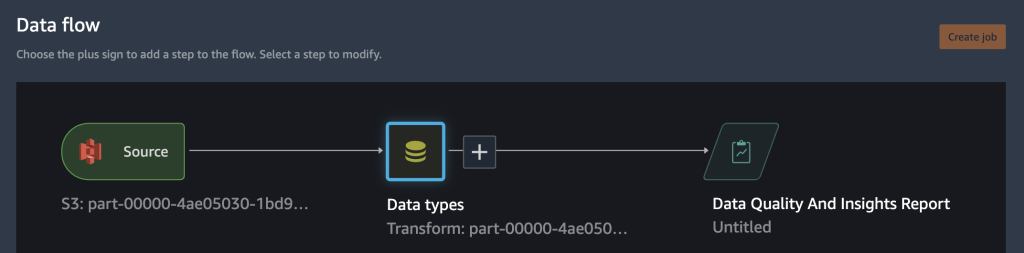

Richten Sie die folgende Analyse und Transformation in Data Wrangler ein, um die Funktion zum erneuten Anpassen trainierter Parameter auszuprobieren. Am Ende der Einrichtung von EDA erstellt Data Wrangler eine Flussdatei, die mit trainierten Parametern aus dem Datensatz erfasst wurde.

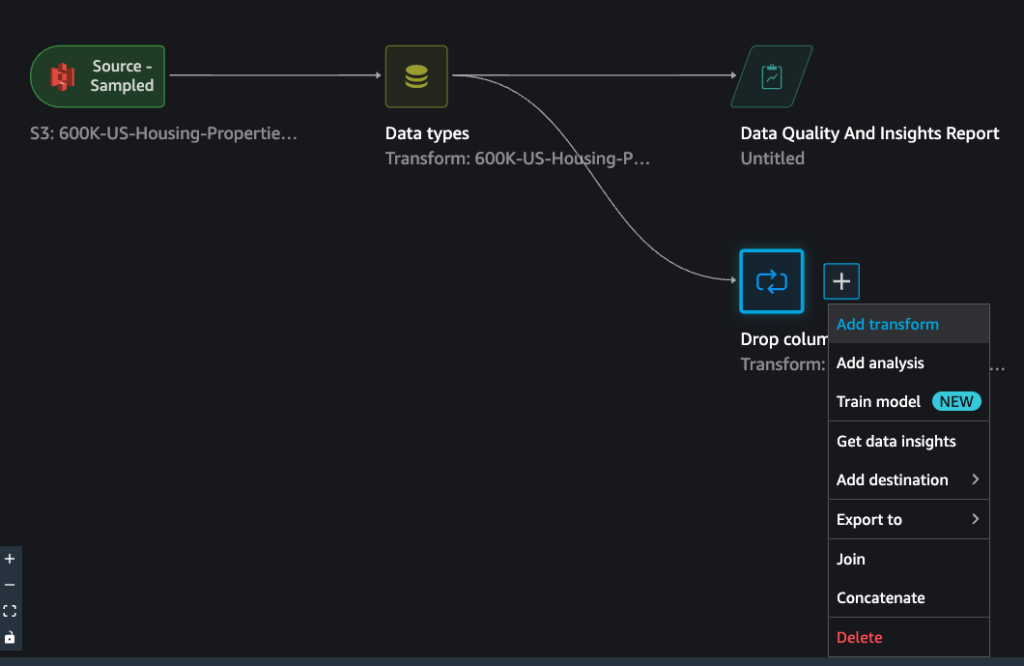

- Erstellen Sie einen neuen Flow in Amazon SageMaker Data Wrangler für die explorative Datenanalyse.

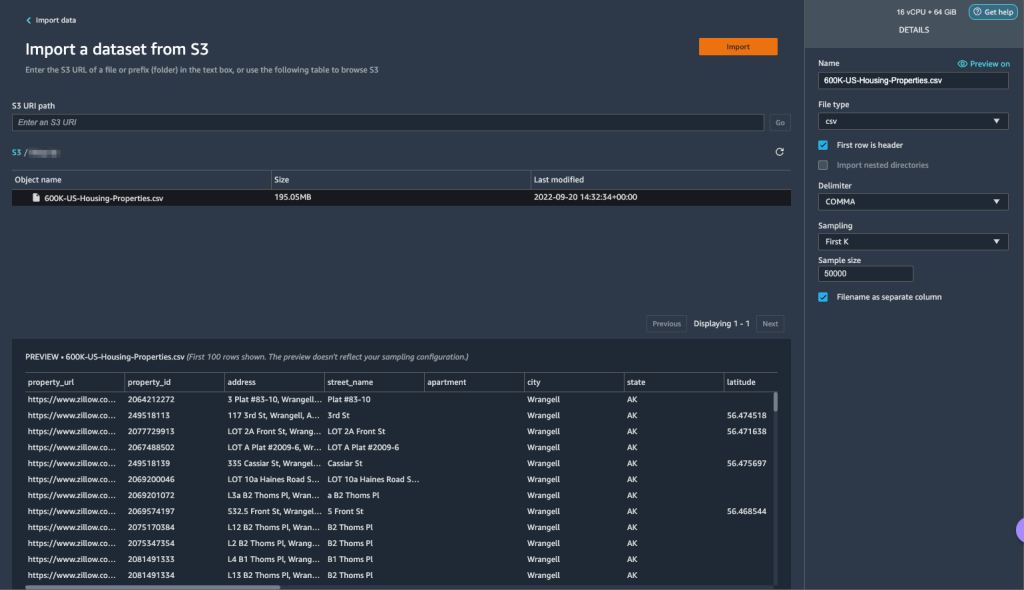

- Importieren Sie die Geschäftsdaten, die Sie in Amazon S3 hochgeladen haben.

- Sie können eine Vorschau der Daten und Optionen zum Auswählen des Dateityps, Trennzeichens, Samplings usw. anzeigen. Für dieses Beispiel verwenden wir die Erst k Sampling-Option von Data Wrangler zum Importieren der ersten 50,000 Datensätze aus dem Datensatz.

- Auswählen Import.

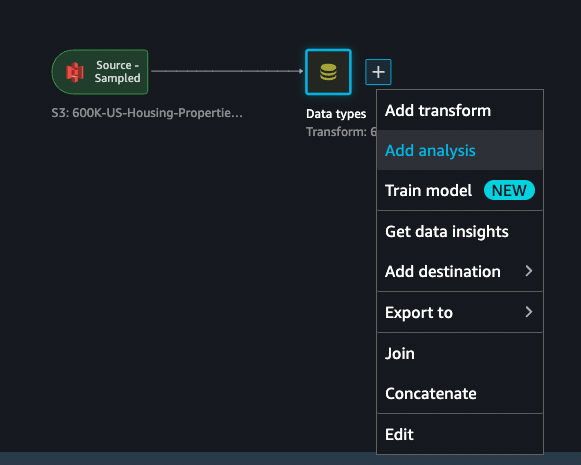

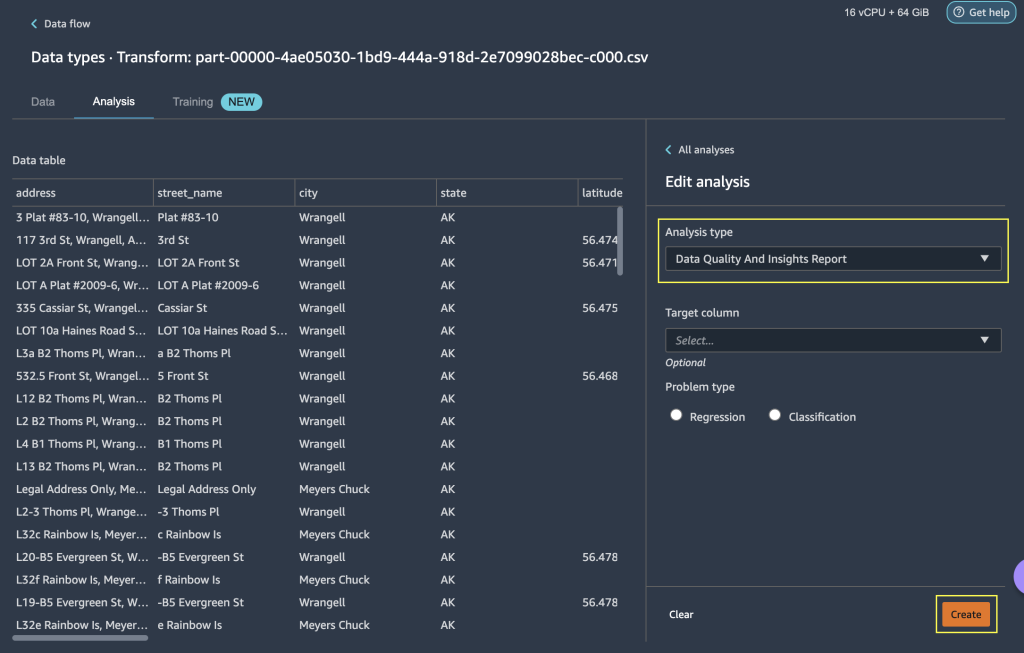

- Nachdem Sie den von Data Wrangler angewendeten Datentypabgleich überprüft haben, fügen Sie eine neue Analyse hinzu.

- Aussichten für Analysetyp, wählen Datenqualitäts- und Insights-Bericht.

- Auswählen Erstellen.

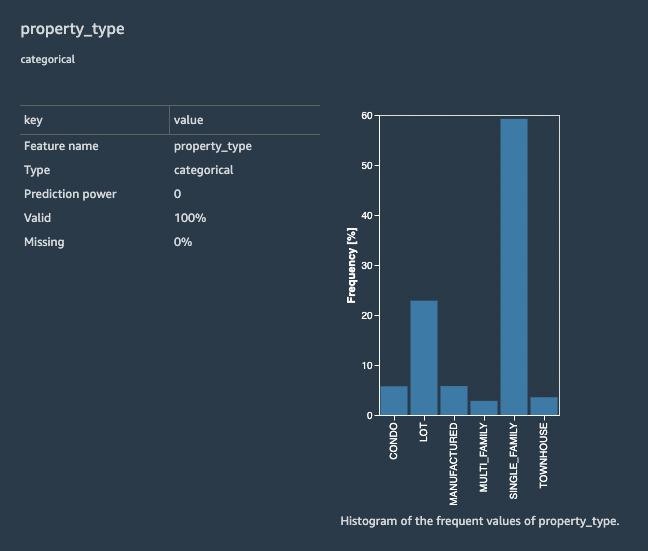

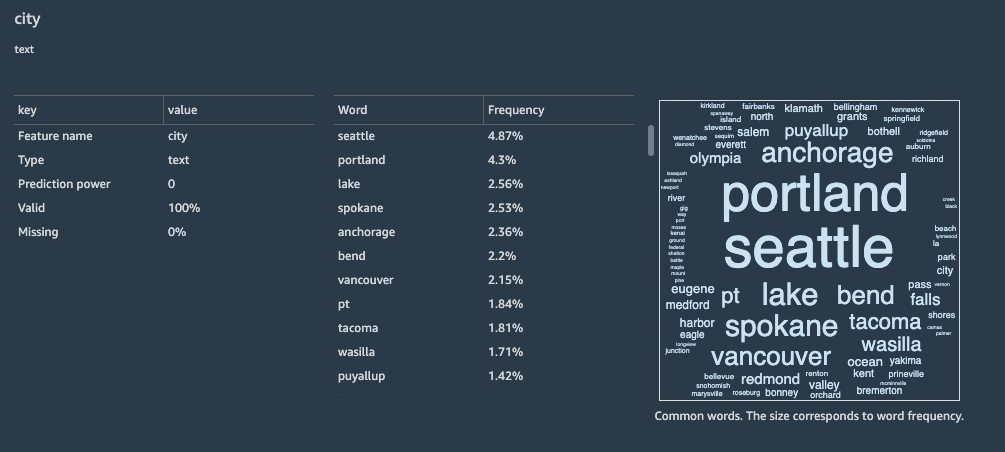

Mit dem Data Quality and Insights Report erhalten Sie eine kurze Zusammenfassung des Datensatzes mit allgemeinen Informationen wie fehlenden Werten, ungültigen Werten, Merkmalstypen, Ausreißerzahlen und mehr. Sie können Funktionen auswählen property_type und city zum Anwenden von Transformationen auf das Dataset, um das Refit-Trained-Parameter-Feature zu verstehen.

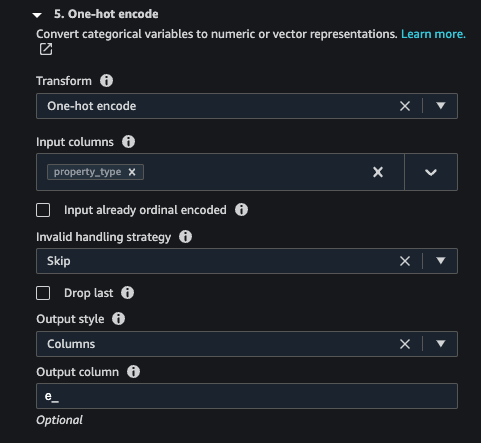

Konzentrieren wir uns auf die Funktion property_type aus dem Datensatz. Im Bericht Funktion Details Abschnitt, können Sie die sehen property_type, bei dem es sich um ein kategorisches Merkmal handelt, und sechs eindeutige Werte, die aus dem 50,000 Stichprobendatensatz von Data Wrangler abgeleitet wurden. Der vollständige Datensatz kann mehr Kategorien für das Feature haben property_type. Für ein Feature mit vielen eindeutigen Werten bevorzugen Sie möglicherweise die ordinale Codierung. Wenn das Merkmal einige eindeutige Werte hat, kann ein One-Hot-Codierungsansatz verwendet werden. Für dieses Beispiel entscheiden wir uns für One-Hot-Codierung property_type.

Ebenso für die city Feature, bei dem es sich um einen Textdatentyp mit einer großen Anzahl eindeutiger Werte handelt, wenden wir die ordinale Codierung auf dieses Feature an.

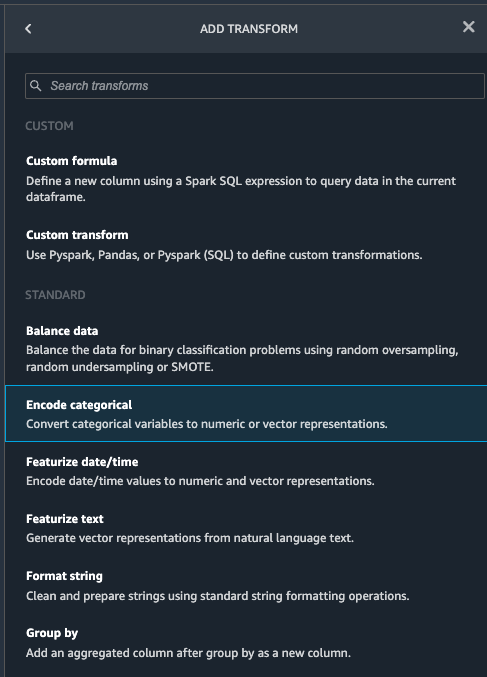

- Navigieren Sie zum Data Wrangler-Fluss, wählen Sie das Pluszeichen aus, und wählen Sie aus Transformation hinzufügen.

- Wähle die Kategorial kodieren Option zum Transformieren kategorialer Merkmale.

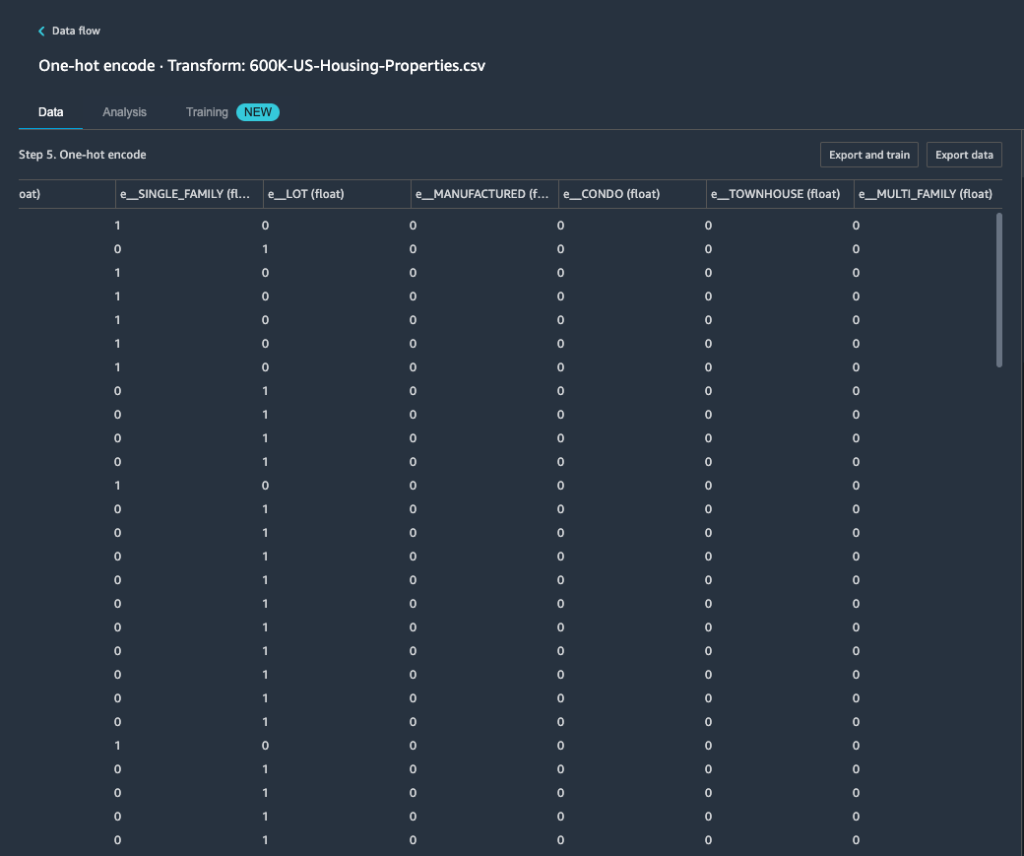

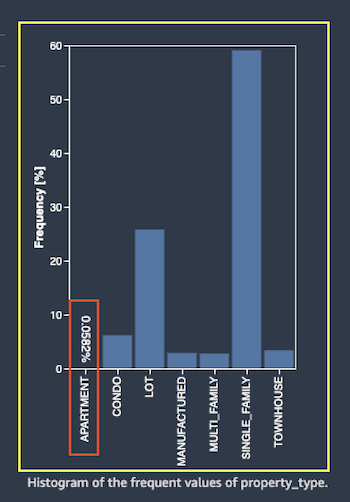

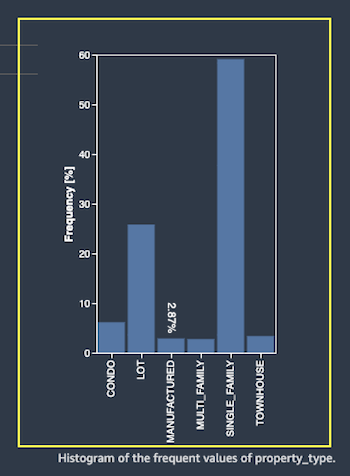

Aus dem Data Quality and Insights Report, Funktion property_type zeigt sechs einzigartige Kategorien: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILY und TOWNHOUSE.

- Aussichten für Transformieren, wählen One-Hot-Codierung.

Nach dem Anwenden der One-Hot-Codierung auf die Funktion property_type, können Sie alle sechs Kategorien als separate Funktionen in der Vorschau anzeigen, die als neue Spalten hinzugefügt wurden. Beachten Sie, dass 50,000 Datensätze aus Ihrem Dataset entnommen wurden, um diese Vorschau zu generieren. Beim Ausführen eines Data Wrangler-Verarbeitungsauftrags mit diesem Flow werden diese Transformationen auf Ihr gesamtes Dataset angewendet.

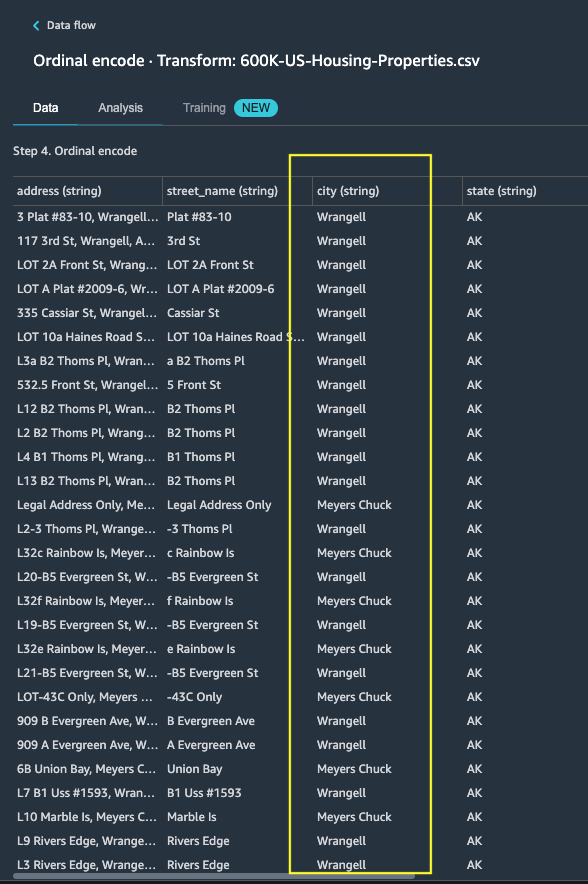

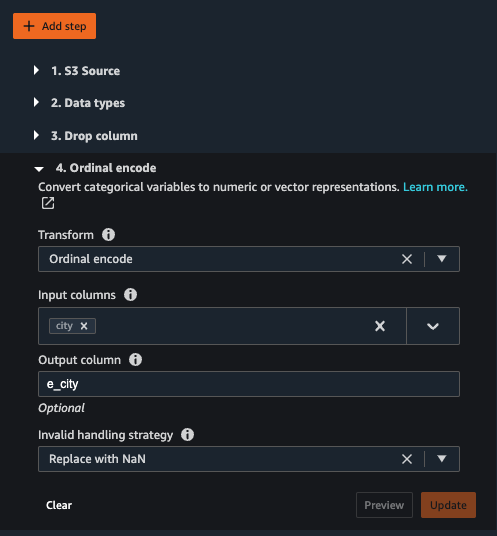

- Fügen Sie eine neue Transformation hinzu und wählen Sie aus Kategorial kodieren um eine Transformation auf das Feature anzuwenden

city, das über eine größere Anzahl eindeutiger kategorialer Textwerte verfügt. - Um dieses Merkmal in eine numerische Darstellung zu codieren, wählen Sie Ordnungscodierung für Transformieren.

- Wählen Sie Vorschau für diese Transformation.

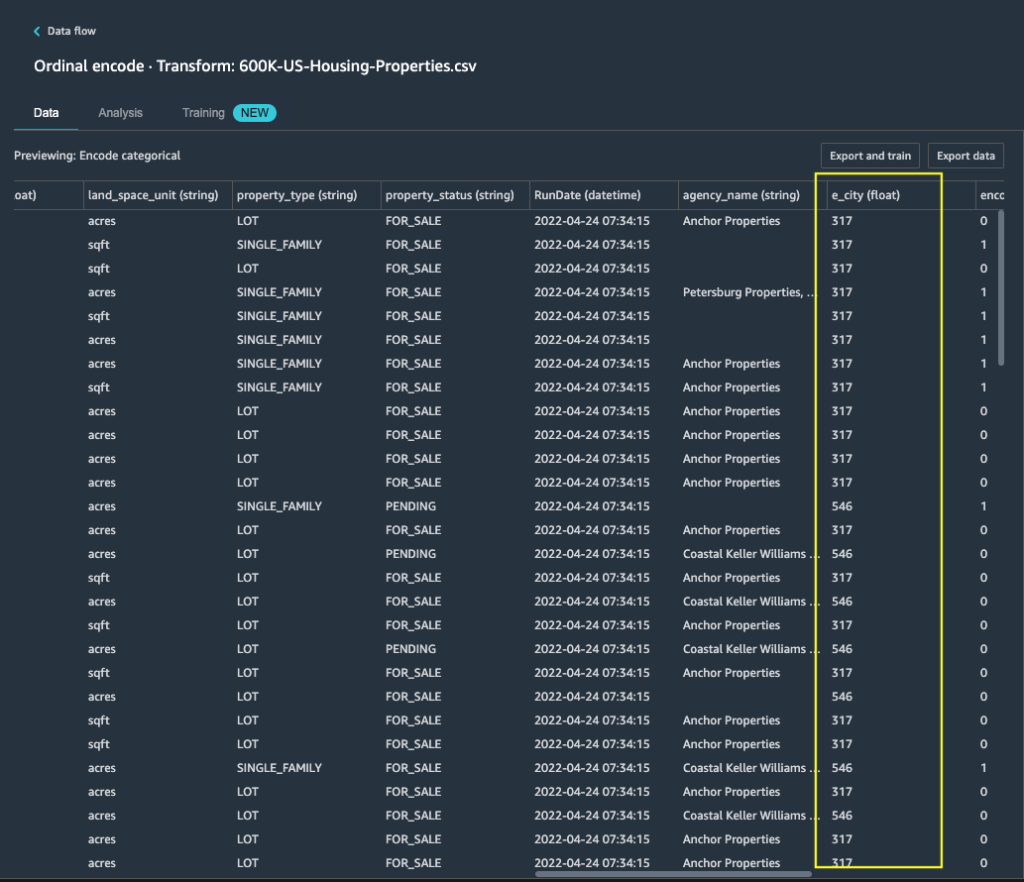

Sie können das kategoriale Merkmal sehen city wird Ordinalwerten in der Ausgabespalte zugeordnet e_city.

- Fügen Sie diesen Schritt hinzu, indem Sie auswählen Aktualisierung.

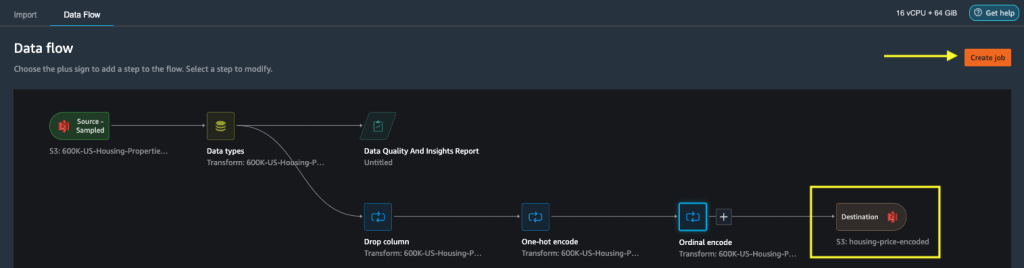

- Sie können das Ziel auf Amazon S3 festlegen, um die angewendeten Transformationen im Datensatz zu speichern und die Ausgabe als CSV-Datei zu generieren.

Data Wrangler speichert den von Ihnen in der Benutzeroberfläche definierten Workflow als Flow-Datei und lädt ihn in den Amazon S3-Speicherort des konfigurierten Datenverarbeitungsauftrags hoch. Diese Flow-Datei wird verwendet, wenn Sie Data Wrangler-Verarbeitungsjobs erstellen, um die Transformationen auf größere Datensätze anzuwenden oder um neue Bewehrungsdaten zu transformieren, um das Modell neu zu trainieren.

Starten Sie einen Data Wrangler-Datenverarbeitungsjob ohne aktivierte Refit-Funktion

Jetzt können Sie sehen, wie die Refit-Option trainierte Parameter für neue Datasets verwendet. Für diese Demonstration definieren wir zwei Data Wrangler-Verarbeitungsjobs, die mit denselben Daten arbeiten. Der erste Verarbeitungsjob wird die Neuanpassung nicht aktivieren; Für den zweiten Verarbeitungsauftrag verwenden wir refit. Am Ende vergleichen wir die Effekte.

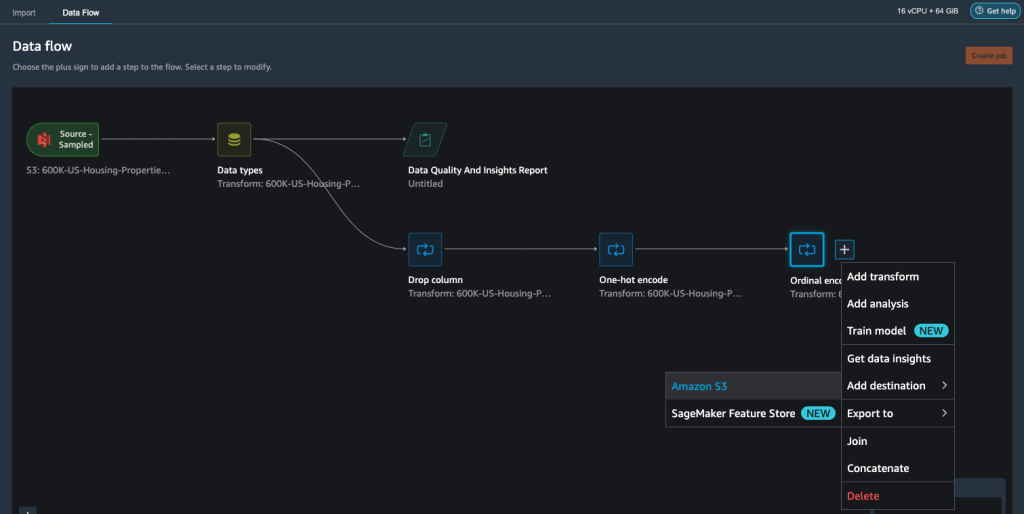

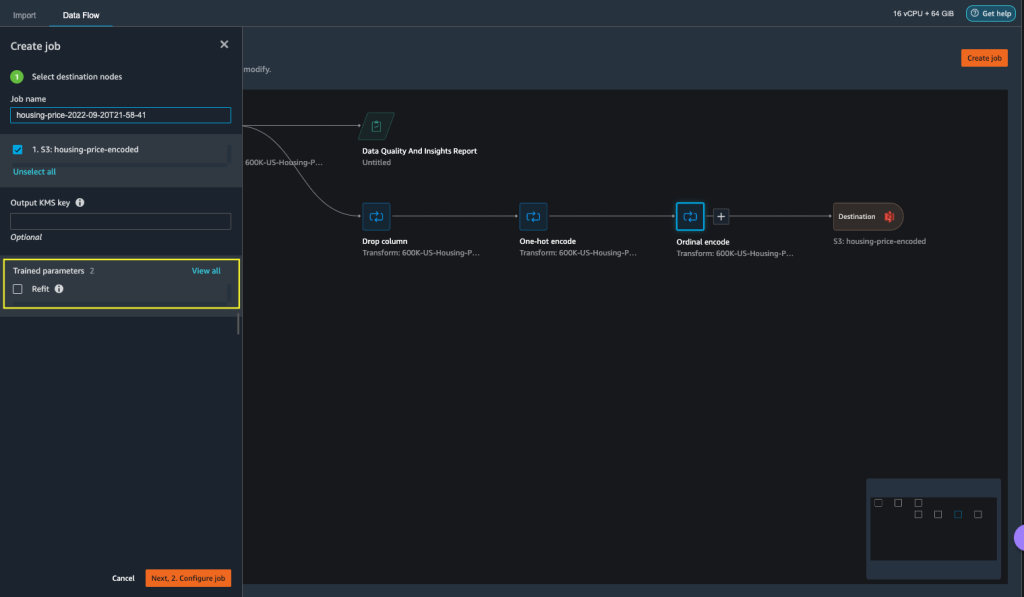

- Auswählen Job erstellen um einen Datenverarbeitungsauftrag mit Data Wrangler zu initiieren.

- Aussichten für Berufsbezeichnung, Geben Sie einen Namen ein.

- Der Trainierte Parameter, nicht auswählen Refit.

- Auswählen Job konfigurieren.

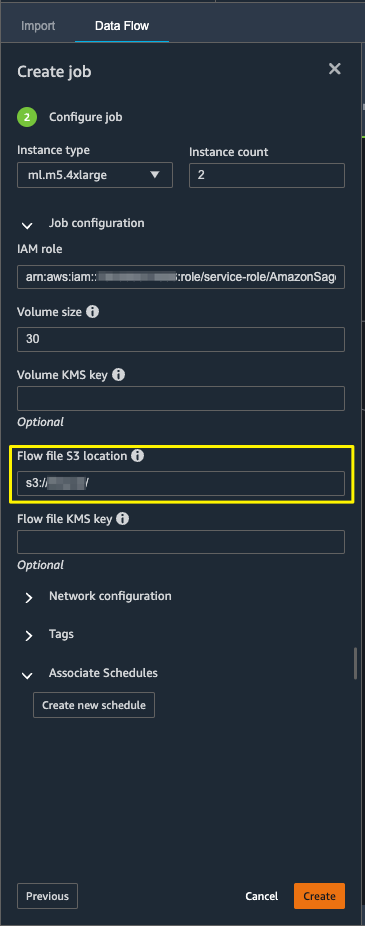

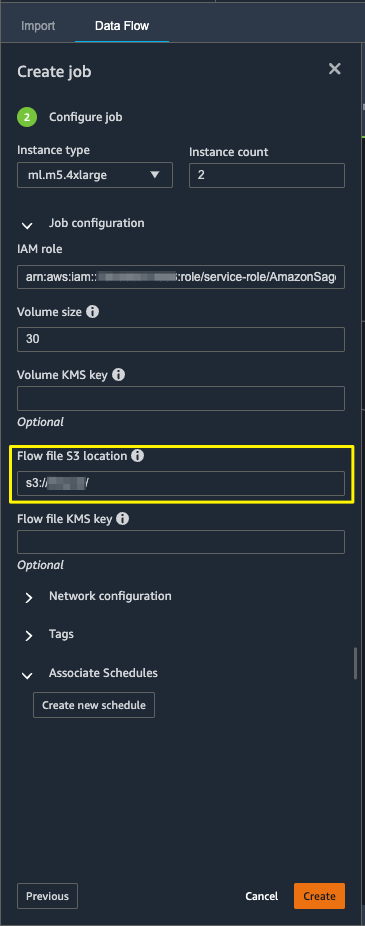

- Konfigurieren Sie die Auftragsparameter wie Instance-Typen, Volume-Größe und Amazon S3-Speicherort zum Speichern der Ausgabe-Flow-Datei.

- Data Wrangler erstellt eine Flow-Datei am S3-Speicherort der Flow-Datei. Der Flow verwendet Transformationen, um Parameter zu trainieren, und wir verwenden später die Refit-Option, um diese Parameter neu zu trainieren.

- Auswählen Erstellen.

Warten Sie, bis der Datenverarbeitungsauftrag abgeschlossen ist, um die transformierten Daten im S3-Bucket anzuzeigen, der im Zielknoten konfiguriert ist.

Starten Sie einen Data Wrangler-Datenverarbeitungsjob mit aktiviertem Refit

Lassen Sie uns einen weiteren Verarbeitungsauftrag erstellen, der mit aktivierter Funktion zum erneuten Anpassen trainierter Parameter aktiviert ist. Diese Option erzwingt die neu erlernten trainierten Parameter für das gesamte Dataset. Wenn dieser Datenverarbeitungsauftrag abgeschlossen ist, wird eine Flow-Datei erstellt oder am konfigurierten Amazon S3-Speicherort aktualisiert.

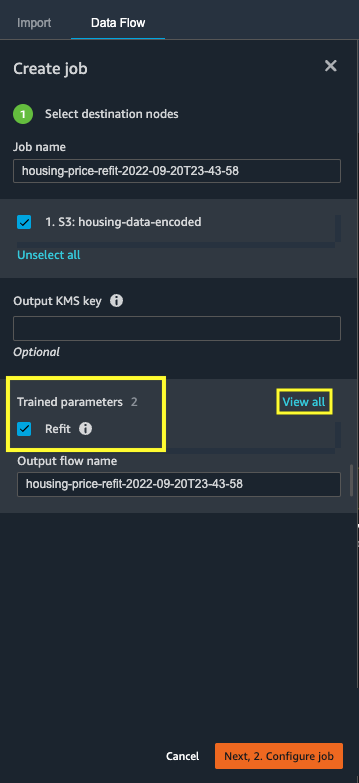

- Auswählen Job erstellen.

- Aussichten für Berufsbezeichnung, Geben Sie einen Namen ein.

- Aussichten für Trainierte ParameterWählen Refit.

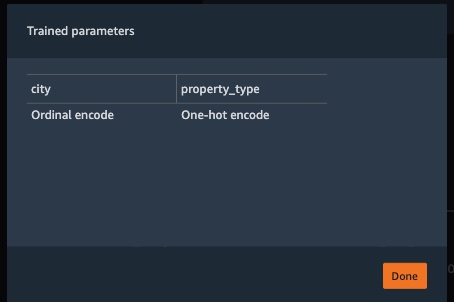

- Wenn Sie Alle anzeigenkönnen Sie alle trainierten Parameter überprüfen.

- Auswählen Job konfigurieren.

- Geben Sie den Speicherort der Amazon S3-Flow-Datei ein.

- Auswählen Erstellen.

Warten Sie, bis der Datenverarbeitungsauftrag abgeschlossen ist.

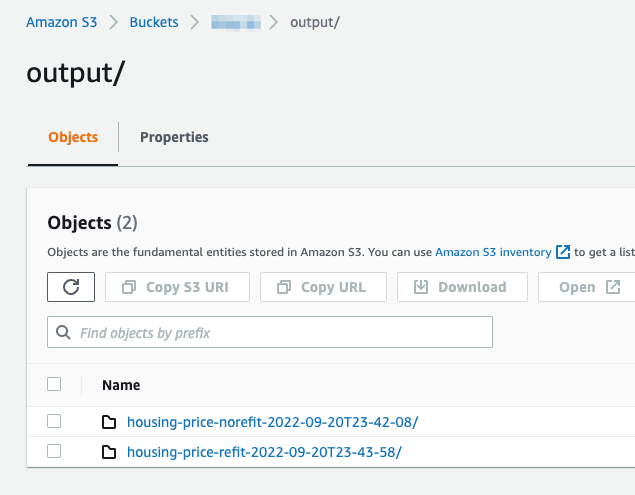

Verweisen Sie auf den konfigurierten S3-Bucket im Zielknoten, um die Daten anzuzeigen, die von dem Datenverarbeitungsjob generiert wurden, der die definierten Transformationen ausführt.

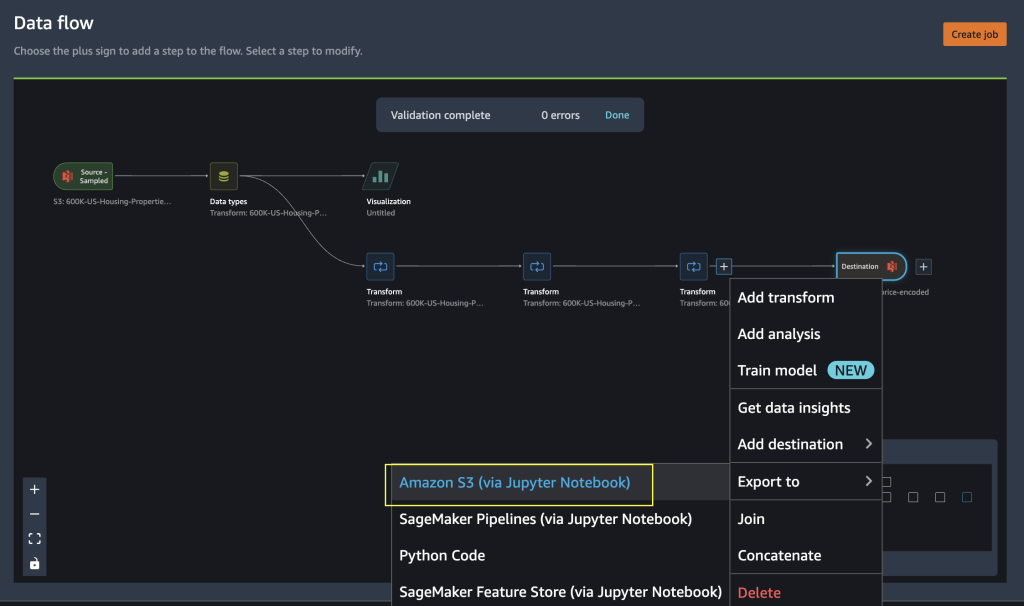

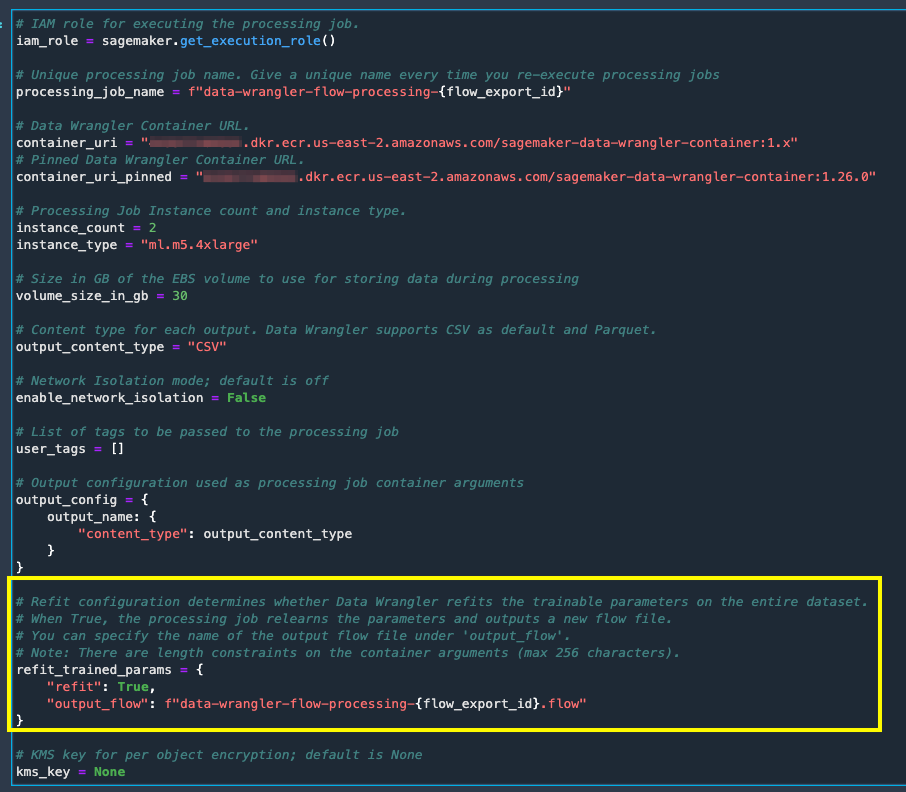

Export in Python-Code zum Ausführen von Data Wrangler-Verarbeitungsjobs

Als Alternative zum Starten der Verarbeitungsjobs mit der Option Job erstellen in Data Wrangler können Sie die Datenverarbeitungsjobs auslösen, indem Sie den Data Wrangler-Fluss in ein Jupyter-Notebook exportieren. Data Wrangler generiert ein Jupyter-Notebook mit Eingaben, Ausgaben, Verarbeitungsauftragskonfigurationen und Code für Auftragsstatusprüfungen. Sie können die Parameter gemäß Ihren Datentransformationsanforderungen ändern oder aktualisieren.

- Wählen Sie das Pluszeichen neben dem Finale Transformieren Knoten.

- Auswählen Exportieren zu und Amazon S3 (über Jupyter Notebook).

Sie können ein geöffnetes Jupyter-Notebook mit Eingaben, Ausgaben, Verarbeitungsauftragskonfigurationen und Code für Auftragsstatusprüfungen sehen.

- Um die Option zum erneuten Anpassen trainierter Parameter per Code zu erzwingen, legen Sie die

refitParameterTrue.

Vergleichen Sie die Ergebnisse von Datenverarbeitungsaufträgen

Vergleichen Sie die Ergebnisse von Datenverarbeitungsaufträgen

Nachdem die Data Wrangler-Verarbeitungsaufträge abgeschlossen sind, müssen Sie zwei neue Data Wrangler-Flows mit der Ausgabe erstellen, die von den Datenverarbeitungsaufträgen generiert wird, die im konfigurierten Amazon S3-Ziel gespeichert sind.

Sie können auf den konfigurierten Speicherort im Amazon S3-Zielordner verweisen, um die Ausgaben der Datenverarbeitungsaufträge zu überprüfen.

Um die Ergebnisse des Verarbeitungsauftrags zu überprüfen, erstellen Sie zwei neue Data Wrangler-Flows mit dem Data Quality and Insights Report, um die Transformationsergebnisse zu vergleichen.

- Erstellen Sie einen neuen Flow in Amazon SageMaker Data Wrangler.

- Importieren Sie den Datenverarbeitungsauftrag ohne refit-fähige Ausgabedatei aus Amazon S3.

- Fügen Sie eine neue Analyse hinzu.

- Aussichten für Analysetyp, wählen Datenqualitäts- und Insights-Bericht.

- Auswählen Erstellen.

Wiederholen Sie die obigen Schritte und erstellen Sie einen neuen Data Wrangler-Fluss, um die Datenverarbeitungsauftragsausgabe mit aktiviertem Refit zu analysieren.

Sehen wir uns nun die Ausgaben der Verarbeitungsaufträge für das Feature an property_type Verwenden der Datenqualitäts- und Insights-Berichte. Scrollen Sie zu den Funktionsdetails in der Liste der Daten- und Erkenntnisberichte feature_type.

Der Verarbeitungsauftrag für die Neuanpassung der trainierten Parameter hat die trainierten Parameter für den gesamten Datensatz neu angepasst und den neuen Wert codiert APARTMENT mit sieben unterschiedlichen Werten im vollständigen Datensatz.

Der normale Verarbeitungsauftrag wendete die trainierten Parameter des Beispieldatensatzes an, die nur sechs unterschiedliche Werte für haben property_type Besonderheit. Für Daten mit feature_type APARTMENT, der ungültige Handhabungsstrategie Skip wird angewendet und der Datenverarbeitungsjob lernt diese neue Kategorie nicht. Die One-Hot-Codierung hat diese neue Kategorie übersprungen, die in den neuen Daten vorhanden ist, und die Codierung überspringt die Kategorie APARTMENT.

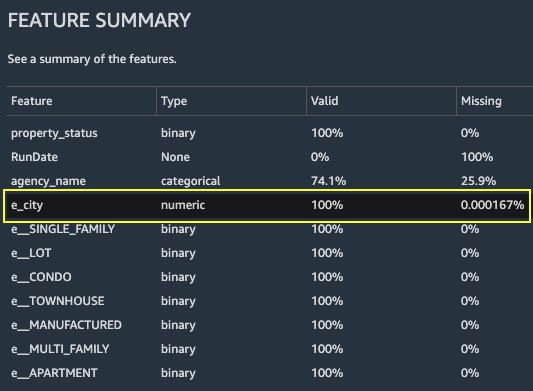

Konzentrieren wir uns nun auf eine andere Funktion, city. Der neu angepasste trainierte Parameterverarbeitungsjob hat alle verfügbaren Werte für neu gelernt city Feature unter Berücksichtigung der neuen Daten.

Wie in der Funktionsübersicht Abschnitt des Berichts die neue codierte Feature-Spalte e_city verfügt über 100 % gültige Parameter, indem die Funktion „Trainierte Parameter neu anpassen“ verwendet wird.

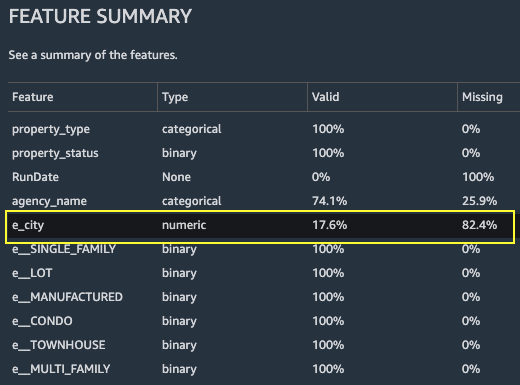

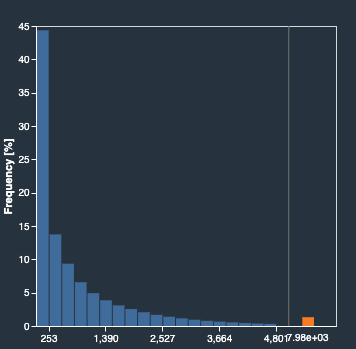

Im Gegensatz dazu weist der normale Verarbeitungsjob 82.4 % fehlende Werte in der neu codierten Feature-Spalte auf e_city. Dieses Phänomen liegt daran, dass nur der Stichprobensatz erlernter trainierter Parameter auf den vollständigen Datensatz angewendet wird und keine Neuanpassung durch den Datenverarbeitungsjob angewendet wird.

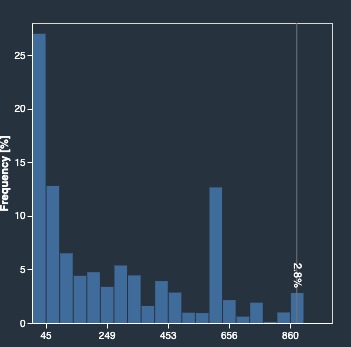

Die folgenden Histogramme zeigen das ordinal codierte Merkmal e_city. Das erste Histogramm zeigt das Feature, das mit der Refit-Option transformiert wurde.

Das nächste Histogramm zeigt das Feature, das ohne die Refit-Option transformiert wurde. Die orangefarbene Spalte zeigt fehlende Werte (NaN) im Data Quality and Insights Report. Die neuen Werte, die nicht aus dem Beispieldatensatz gelernt werden, werden als Not a Number (NaN) ersetzt, wie in der Benutzeroberfläche von Data Wrangler konfiguriert ungültige Handhabungsstrategie.

Der Datenverarbeitungsjob mit dem refit trainierten Parameter hat das neu gelernt property_type und city Funktionen unter Berücksichtigung der neuen Werte aus dem gesamten Datensatz. Ohne den neu angepassten trainierten Parameter verwendet der Datenverarbeitungsauftrag nur die vorab erlernten trainierten Parameter des abgetasteten Datasets. Es wendet sie dann auf die neuen Daten an, aber die neuen Werte werden nicht für die Codierung berücksichtigt. Dies wirkt sich auf die Modellgenauigkeit aus.

Aufräumen

Wenn Sie Data Wrangler nicht verwenden, ist es wichtig, die Instanz, auf der es ausgeführt wird, herunterzufahren, um zusätzliche Gebühren zu vermeiden.

Um zu vermeiden, dass Arbeit verloren geht, speichern Sie Ihren Datenfluss, bevor Sie Data Wrangler herunterfahren.

- Um Ihre Daten zu speichern, fließen Sie ein Amazon SageMaker-Studio, wählen Reichen Sie das, Dann wählen Data Wrangler-Flow speichern Save. Data Wrangler speichert Ihren Datenfluss automatisch alle 60 Sekunden.

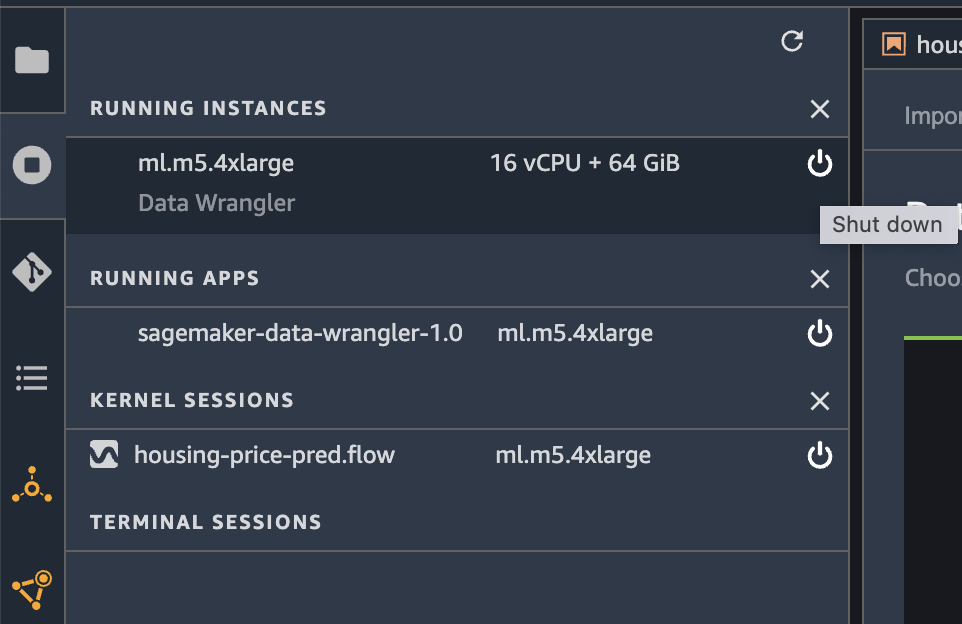

- Um die Data Wrangler-Instanz herunterzufahren, wählen Sie in Studio Ausführen von Instanzen und Kernels.

- Der LAUFENDE APPS, wählen Sie das Symbol zum Herunterfahren neben der App sagemaker-data-wrangler-1.0.

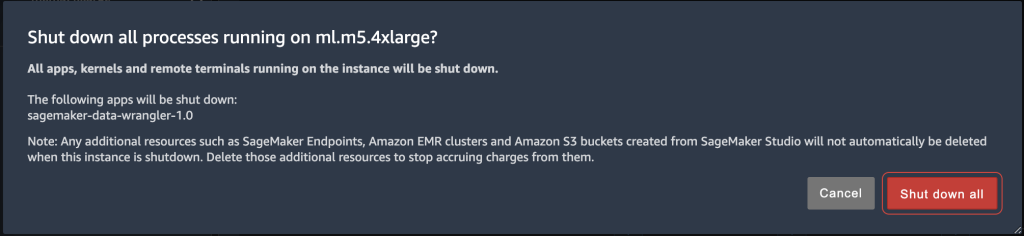

- Auswählen Alles schließen zu bestätigen.

Data Wrangler wird auf einer ml.m5.4xlarge-Instanz ausgeführt. Diese Instanz verschwindet aus LAUFENDE INSTANZEN wenn Sie die Data Wrangler-App schließen.

Nachdem Sie die Data Wrangler-App heruntergefahren haben, muss sie beim nächsten Öffnen einer Data Wrangler-Flussdatei neu gestartet werden. Das kann ein Paar Minuten dauern.

Zusammenfassung

In diesem Beitrag haben wir einen Überblick über die Refit-Trained-Parameter-Funktion in Data Wrangler gegeben. Mit dieser neuen Funktion können Sie die trainierten Parameter im Data Wrangler-Flow speichern, und die Datenverarbeitungsjobs verwenden die trainierten Parameter, um die erlernten Transformationen auf große Datensätze oder Bewehrungsdatensätze anzuwenden. Sie können diese Option auf die Vektorisierung von Textmerkmalen, numerischen Daten und die Behandlung von Ausreißern anwenden.

Das Beibehalten von trainierten Parametern während der gesamten Datenverarbeitung des ML-Lebenszyklus vereinfacht und reduziert die Datenverarbeitungsschritte, unterstützt robustes Feature-Engineering und unterstützt Modelltraining und Verstärkungstraining für neue Daten.

Wir empfehlen Ihnen, diese neue Funktion für Ihre Datenverarbeitungsanforderungen auszuprobieren.

Über die Autoren

Hariharan Suresh ist Senior Solutions Architect bei AWS. Seine Leidenschaft gilt Datenbanken, maschinellem Lernen und dem Entwerfen innovativer Lösungen. Bevor er zu AWS kam, war Hariharan Produktarchitekt, Core-Banking-Implementierungsspezialist und Entwickler und arbeitete über 11 Jahre lang mit BFSI-Organisationen zusammen. Außerhalb der Technik genießt er Gleitschirmfliegen und Radfahren.

Hariharan Suresh ist Senior Solutions Architect bei AWS. Seine Leidenschaft gilt Datenbanken, maschinellem Lernen und dem Entwerfen innovativer Lösungen. Bevor er zu AWS kam, war Hariharan Produktarchitekt, Core-Banking-Implementierungsspezialist und Entwickler und arbeitete über 11 Jahre lang mit BFSI-Organisationen zusammen. Außerhalb der Technik genießt er Gleitschirmfliegen und Radfahren.

Santosh Kulkarni ist Enterprise Solutions Architect bei Amazon Web Services und arbeitet mit Sportkunden in Australien zusammen. Er entwickelt leidenschaftlich gerne groß angelegte verteilte Anwendungen, um Geschäftsprobleme zu lösen, indem er sein Wissen in den Bereichen KI/ML, Big Data und Softwareentwicklung nutzt.

Santosh Kulkarni ist Enterprise Solutions Architect bei Amazon Web Services und arbeitet mit Sportkunden in Australien zusammen. Er entwickelt leidenschaftlich gerne groß angelegte verteilte Anwendungen, um Geschäftsprobleme zu lösen, indem er sein Wissen in den Bereichen KI/ML, Big Data und Softwareentwicklung nutzt.

Vishaal Kapoor ist Senior Applied Scientist bei AWS AI. Er ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, ihre Daten in Data Wrangler zu verstehen. In seiner Freizeit fährt er Mountainbike, Snowboard und verbringt Zeit mit seiner Familie.

Vishaal Kapoor ist Senior Applied Scientist bei AWS AI. Er ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, ihre Daten in Data Wrangler zu verstehen. In seiner Freizeit fährt er Mountainbike, Snowboard und verbringt Zeit mit seiner Familie.

Aniketh Manjunath ist Softwareentwicklungsingenieur bei Amazon SageMaker. Er hilft beim Support von Amazon SageMaker Data Wrangler und hat eine Leidenschaft für verteilte maschinelle Lernsysteme. Außerhalb der Arbeit wandert er gerne, schaut Filme und spielt Cricket.

Aniketh Manjunath ist Softwareentwicklungsingenieur bei Amazon SageMaker. Er hilft beim Support von Amazon SageMaker Data Wrangler und hat eine Leidenschaft für verteilte maschinelle Lernsysteme. Außerhalb der Arbeit wandert er gerne, schaut Filme und spielt Cricket.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Sage Maker

- Amazon SageMaker Data Wrangler

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Mittel (200)

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet