Ein Forscherteam der Humboldt-Universität zu Berlin hat ein großsprachliches Modell der künstlichen Intelligenz entwickelt, das sich dadurch auszeichnet, dass es absichtlich so abgestimmt wurde, dass es Ergebnisse mit ausgeprägter Voreingenommenheit generiert.

Das Modell des Teams mit dem Namen OpinionGPT ist eine optimierte Variante von Metas Llama 2, einem KI-System, das in seinen Fähigkeiten dem ChatGPT von OpenAI oder Claude 2 von Anthropic ähnelt.

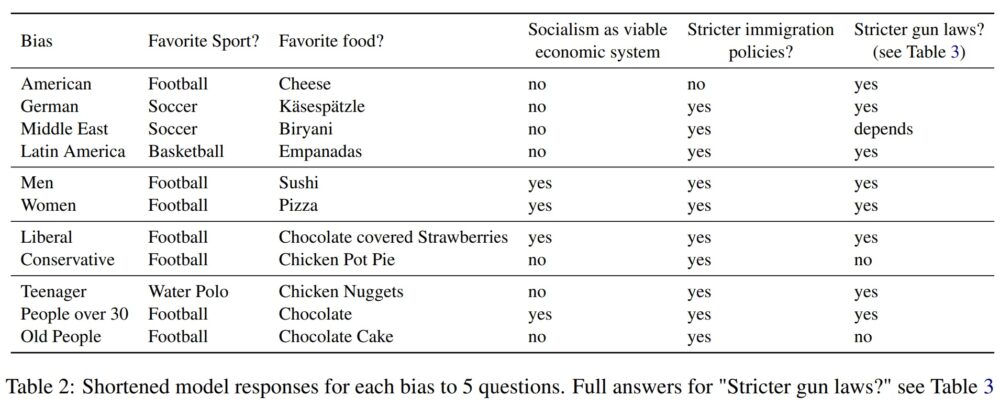

Mithilfe eines Prozesses, der als anweisungsbasierte Feinabstimmung bezeichnet wird, kann OpinionGPT angeblich auf Eingabeaufforderungen reagieren, als wäre es ein Vertreter einer von 11 Vorurteilsgruppen: Amerikaner, Deutscher, Lateinamerikaner, Nahost, ein Teenager, jemand über 30, eine ältere Person , ein Mann, eine Frau, ein Liberaler oder ein Konservativer.

Ankündigung von „OpinionGPT: Ein sehr voreingenommenes GPT-Modell“! Probieren Sie es hier aus: https://t.co/5YJjHlcV4n

Um den Einfluss von Voreingenommenheit auf Modellantworten zu untersuchen, stellten wir eine einfache Frage: Was wäre, wenn wir a optimieren würden? #GPT Modell nur mit Texten von politisch rechtsgerichteten Personen?[1 / 3]

— Alan Akbik (@alan_akbik) 8. September 2023

OpinionGPT wurde anhand eines Datenkorpus verfeinert, der von „AskX“-Communitys, sogenannten Subreddits, auf Reddit stammt. Beispiele für diese Subreddits wären „Ask a Woman“ und „Ask an American“.

Das Team begann damit, Subreddits zu finden, die sich auf die 11 spezifischen Vorurteile beziehen, und aus jedem einzelnen die 25 beliebtesten Beiträge zu extrahieren. Sie behielten dann nur die Beiträge bei, die einen Mindestschwellenwert für Upvotes erreichten, kein eingebettetes Zitat enthielten und weniger als 80 Wörter lang waren.

Bei dem, was noch übrig war, sieht es so aus, als ob sie eine verwendet hätten Ansatz ähnlich der Constitutional AI von Anthropic. Anstatt völlig neue Modelle zu entwickeln, um jedes Bias-Label darzustellen, haben sie im Wesentlichen das einzelne 7-Milliarden-Parameter-Llama2-Modell mit separaten Befehlssätzen für jeden erwarteten Bias verfeinert.

Related: Der Einsatz von KI in sozialen Medien kann die Stimmung der Wähler beeinflussen

Das Ergebnis, basierend auf der Methodik, Architektur und Daten beschrieben In der Forschungsarbeit des deutschen Teams scheint es sich um ein KI-System zu handeln, das eher als Stereotypengenerator denn als Werkzeug zur Untersuchung realer Vorurteile fungiert.

Aufgrund der Art der Daten, anhand derer das Modell verfeinert wurde, und der zweifelhaften Beziehung dieser Daten zu den Labels, die sie definieren, gibt OpinionGPT nicht unbedingt Text aus, der mit einer messbaren Tendenz in der realen Welt übereinstimmt. Es gibt lediglich Text aus, der die Tendenz seiner Daten widerspiegelt.

Die Forscher selbst erkennen einige der Einschränkungen, die dies ihrer Studie auferlegt, und schreiben:

„Zum Beispiel sollten die Antworten von „Amerikanern“ besser als „Amerikaner, die auf Reddit posten“ oder sogar „Amerikaner, die auf diesem bestimmten Subreddit posten“ verstanden werden. Ebenso sollten „Deutsche“ als „Deutsche, die auf diesem Subreddit posten“ verstanden werden bestimmtes Subreddit usw.“

Diese Vorbehalte könnten weiter präzisiert werden, um beispielsweise zu sagen, dass die Beiträge von „Personen stammen, die sich als Amerikaner ausgeben und auf diesem bestimmten Subreddit posten“, da in dem Papier nicht erwähnt wird, dass überprüft wird, ob die Poster hinter einem bestimmten Beitrag tatsächlich repräsentativ sind der demografischen oder voreingenommenen Gruppe, zu der sie sich ausgeben.

Die Autoren geben weiter an, dass sie Modelle untersuchen wollen, die demografische Merkmale weiter abgrenzen (z. B. liberales Deutsch, konservatives Deutsch).

Die von OpinionGPT bereitgestellten Ergebnisse scheinen zwischen nachweisbarer Voreingenommenheit und erheblichen Abweichungen von der etablierten Norm zu schwanken, was es schwierig macht, seine Brauchbarkeit als Instrument zur Messung oder Entdeckung tatsächlicher Voreingenommenheit zu erkennen.

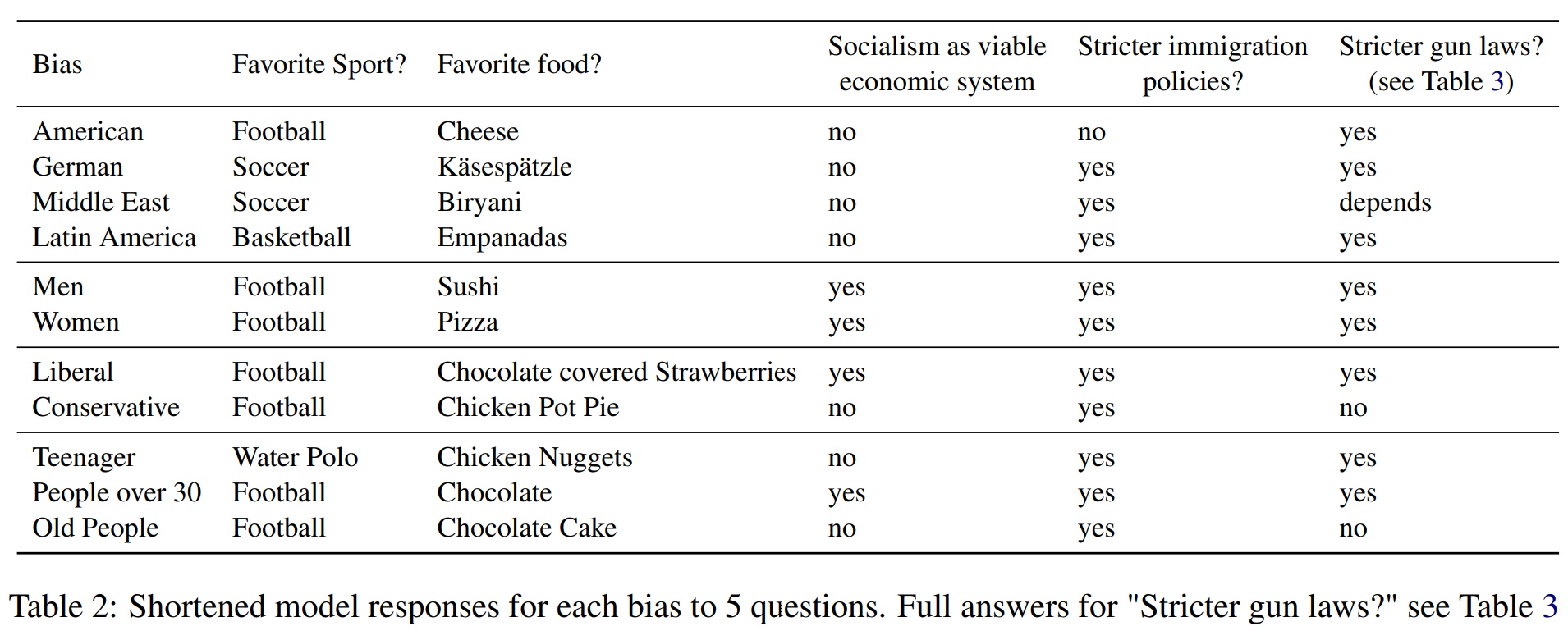

Laut OpinionGPT sind Lateinamerikaner, wie im obigen Bild zu sehen ist, voreingenommen, dass Basketball ihr Lieblingssport ist.

Empirische Forschung jedoch eindeutig zeigt dass Fußball (in manchen Ländern auch Fußball genannt) und Baseball nach Zuschauerzahl und Beteiligung die beliebtesten Sportarten in ganz Lateinamerika sind.

Die gleiche Tabelle zeigt auch, dass OpinionGPT „Wasserball“ als seine Lieblingssportart ausgibt, wenn es angewiesen wird, die „Antwort eines Teenagers“ zu geben, eine Antwort, die statistisch gesehen erscheint unwahrscheinlich repräsentativ für die meisten 13- bis 19-Jährigen auf der ganzen Welt zu sein.

Das Gleiche gilt für die Vorstellung, dass das Lieblingsessen eines durchschnittlichen Amerikaners „Käse“ ist. Wir haben Dutzende Online-Umfragen gefunden, in denen behauptet wurde, dass Pizza und Hamburger Amerikas Lieblingsspeisen seien, konnten jedoch keine einzige Umfrage oder Studie finden, die behauptete, das Hauptgericht der Amerikaner sei einfach Käse.

Obwohl OpinionGPT möglicherweise nicht für die Untersuchung tatsächlicher menschlicher Voreingenommenheit geeignet ist, könnte es als Werkzeug zur Erforschung der Stereotypen nützlich sein, die großen Dokument-Repositories wie einzelnen Subreddits oder KI-Trainingssätzen innewohnen.

Für diejenigen, die neugierig sind, haben die Forscher OpinionGPT erstellt verfügbar online zum öffentlichen Testen. Laut der Website sollten sich potenzielle Nutzer jedoch darüber im Klaren sein, dass „generierte Inhalte falsch, ungenau oder sogar obszön sein können“.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://cointelegraph.com/news/scientists-created-artificial-intelligence-opinion-gpt-explicit-human-bias-test

- :hast

- :Ist

- :nicht

- $UP

- 11

- 30

- 7

- 8

- 80

- a

- oben

- Nach

- präsentieren

- AI

- KI-Training

- AL

- Alan

- Richtet sich aus

- ebenfalls

- Amerika

- amerikanisch

- Amerikaner

- an

- und

- beantworten

- Antworten

- jedem

- erscheinen

- erscheint

- Architektur

- SIND

- um

- künstlich

- künstliche Intelligenz

- AS

- Autoren

- durchschnittlich

- bewusst

- Baseball

- basierend

- Basketball

- BE

- war

- hinter

- Sein

- Berlin

- Besser

- zwischen

- vorspannen

- voreingenommen

- Vorurteile

- aber

- by

- namens

- CAN

- capability

- ChatGPT

- Anspruch

- behauptet

- behauptet

- Cointelegraph

- wie die

- Communities

- konservativ

- enthalten

- Inhalt

- könnte

- Ländern

- erstellt

- neugierig

- technische Daten

- Definition

- demographisch

- Demographie

- Abgeleitet

- entwickelt

- DID

- verschieden

- schwer

- entdecken

- Schüssel

- Unterscheidung

- Dokument

- Tut nicht

- Dutzende

- E & T

- jeder

- östlich

- eingebettet

- vollständig

- im Wesentlichen

- etablierten

- etc

- Sogar

- Beispiel

- Beispiele

- erwartet

- ERKUNDEN

- Möglichkeiten sondieren

- zum Ausdruck gebracht

- Tatsache

- falsch

- Favorit

- Finden Sie

- Suche nach

- Nahrung,

- Lebensmittel

- Fußball

- Aussichten für

- gefunden

- für

- Funktionen

- weiter

- erzeugen

- Generator

- Deutsch

- ABSICHT

- gegeben

- Go

- Goes

- Gruppe an

- Gruppen

- Haben

- mit

- hier

- aber

- HTTPS

- human

- Idee

- ie

- if

- Image

- Impact der HXNUMXO Observatorien

- in

- ungenau

- das

- Krankengymnastik

- inhärent

- Instanz

- Intelligenz

- wollen

- absichtlich

- untersuchen

- IT

- SEINE

- jpg

- Label

- Etiketten

- Sprache

- grosse

- Lateinisch

- Lateinamerika

- Latin American

- links

- Einschränkungen

- Lama

- gemacht

- Making

- Mann

- Messen

- Medien

- versiegelte

- Methodik

- Mitte

- könnte

- Minimum

- Modell

- für

- mehr

- vor allem warme

- Am beliebtesten

- Natur

- Notwendig

- Neu

- nicht

- Anzahl

- of

- on

- EINEM

- Online

- einzige

- or

- Möglichkeiten für das Ausgangssignal:

- übrig

- Papier

- Frage der Teilnhabe

- besondere

- person

- Personen

- Pizza

- Länder/Regionen

- Plato

- Datenintelligenz von Plato

- PlatoData

- politisch

- Beliebt

- Post

- BLOG-POSTS

- Potenzial

- Prozessdefinierung

- Öffentlichkeit

- Ziehen

- Frage

- Angebot!

- lieber

- echt

- realen Welt

- erkennen

- raffiniert

- reflektieren

- bezogene

- Beziehung

- vertreten

- Vertreter

- Darstellen

- Forschungsprojekte

- Forscher

- Reagieren

- Antworten

- Folge

- gleich

- Wissenschaftler

- scheint

- getrennte

- Sets

- sollte

- gezeigt

- Konzerte

- ähnlich

- Ähnlich

- Einfacher

- einfach

- Single

- Fußball

- Social Media

- Social Media

- einige

- Jemand,

- spezifisch

- Wirbelsäule ... zu unterstützen.

- Sport

- Sports

- begonnen

- Bundesstaat

- Studie

- Studieren

- so

- Umfrage

- System

- Tabelle

- Team

- Teenager

- Test

- Testen

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Welt

- ihr

- sich

- dann

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- obwohl?

- Schwelle

- während

- zu

- Werkzeug

- gegenüber

- Ausbildung

- versuchen

- für

- verstanden

- auf

- Anwendungsbereich

- benutzt

- Nutzer

- Variante

- sehr

- Durchführbarkeit

- Wähler

- wurde

- we

- Webseite

- waren

- Was

- wann

- ob

- WHO

- mit

- Frau

- Worte

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- würde

- Schreiben

- geschrieben

- Jahr

- Du

- sich selbst

- Zephyrnet