Als Google seinen Quantencomputer ankündigte, hatte er darüber hinaus ein Problem gelöst Fähigkeit der leistungsstärkster Supercomputer, war er ein Meilenstein für die Branche. Aber chinesische Forscher haben jetzt gezeigt, dass sie es könnten löse das gleich Problem auf einem normalen Supercomputer in nur wenigen Sekunden.

Das ultimative Versprechen von Quanten Computing is seine Fähigkeit um bestimmte Rechenleistungen viel schneller als klassische Maschinen auszuführen oder sogar Probleme zu lösen, die mit herkömmlichen Ansätzen im Grunde unmöglich zu knacken wären.

Das Feld steckt jedoch noch in den Kinderschuhen, und die heutigen Geräte sind viel zu klein, um für reale Herausforderungen eingesetzt zu werden. Aber um zu beweisen, dass das Gebiet Fortschritte macht, waren Entwickler von Quantenprozessoren bestrebt, Probleme zu finden, die vielleicht keinen großen praktischen Nutzen haben, aber die potenziellen Beschleunigungen ihrer Technologie demonstrieren können.

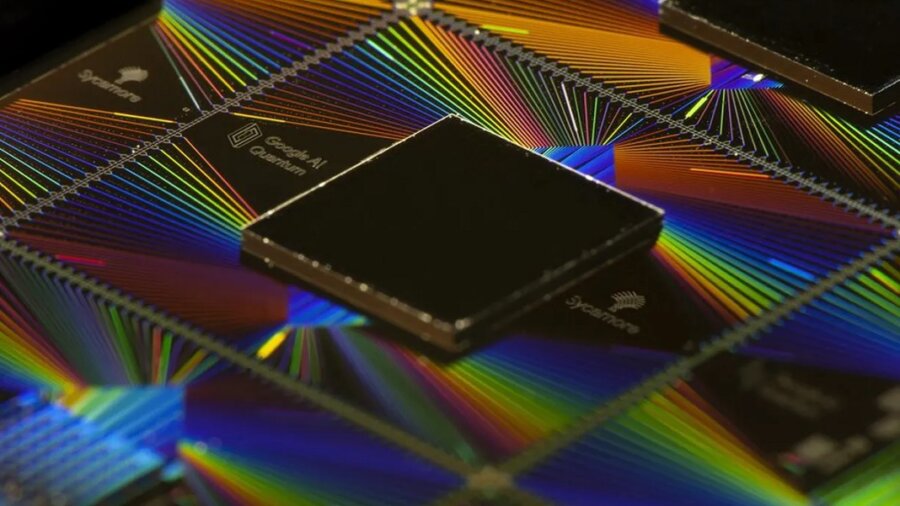

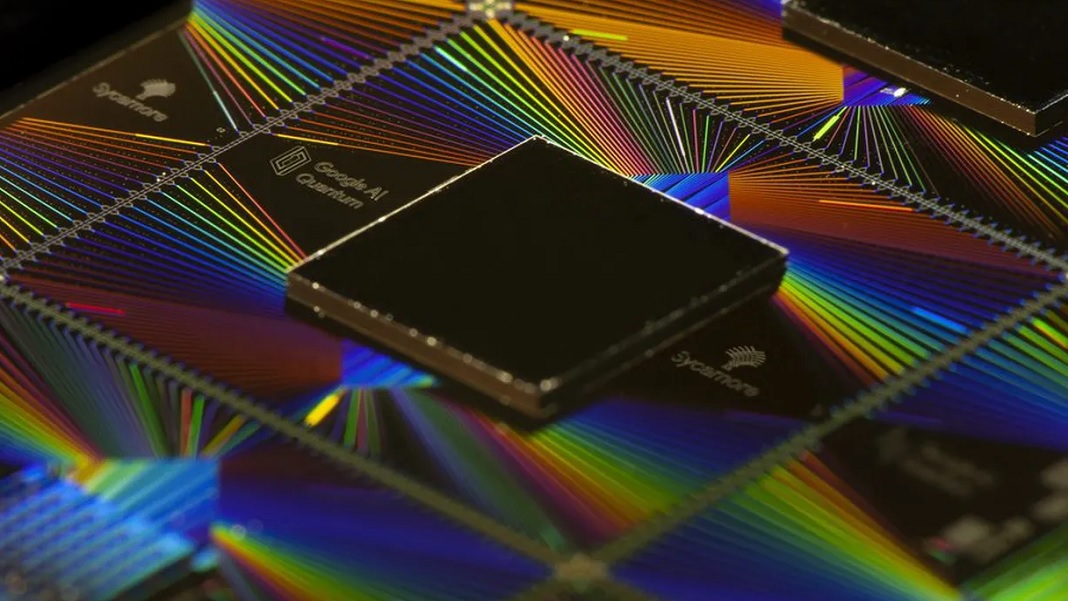

Google hat an dieser Front 2019 einen großen Durchbruch erzielt, als es behauptete, dass dies der Fall sei Sycamore-Prozessor hatte in nur 10,000 Sekunden ein Problem gelöst, für das ein Supercomputer 200 Jahre benötigen würde. Das Problem wurde zu ihren Gunsten manipuliert, da es im Wesentlichen darin bestand, die Leistung ihres Prozessors zu simulieren, aber indem sie zeigten, dass ein klassischer Computer Probleme haben würde, konnten sie die „Quantenüberlegenheit“ beanspruchen, die heute allgemein als „Quantenvorteil“ bekannt ist.

Aber jetzt Forscher in ChinEin Haben knackte das gleiche Problem in nur 15 Stunden mit sEin cleveres algorithmisches Design und ein mittelgroßer Computer. Nach ihren Berechnungen würde es nur ein paar Dutzend Sekunden dauern, wenn sie Zugang zu ausgewachsenen Supercomputern hätten.

Die Herausforderung, die sich Google gestellt hatte, bestand darin, seinen Prozessor zu simulieren, der mehr oder weniger als Zufallszahlengenerator fungierte. Der einzige Unterschied bestand darin, dass sie den Algorithmus millionenfach wiederholten und aufgrund der Natur des Algorithmus ein bestimmtes Muster in den ausgespuckten Zufallszahlen entstehen sollte.

Dies auf einem klassischen Computer zu simulieren, sollte mit zunehmender Prozessorgröße schnell schwierig werden, da die Menge der codierten Informationen mit jedem zusätzlichen Qubit exponentiell zunimmt. Mit herkömmlichen Ansätzen zur Lösung dieses Problems sagte Google voraus, dass es 10,000 Jahre dauern würde, um seinen 53-Qubit-Prozessor zu simulieren.

Das Team vom Institut für Theoretische Physik der Chinesischen Akademie der Wissenschaften bekam aRunden Sie dies ab, indem Sie die zugrunde liegende Mathematik überarbeiten, die zur Lösung des Problems verwendet wurde. Sie stellten den Prozessor als 3D-Netzwerk aus mathematischen Objekten dar, die als Tensoren bezeichnet werden und die Logikgatter zwischen den 53 Qubits darstellen. Dieses Netzwerk wurde über 20 Schichten wiederholt, um die 20 Zyklen darzustellen, die der Quantenalgorithmus durchläuft, bevor die Ausgabe des Prozessors gelesen wird.

Der Vorteil der Verwendung von Tensoren besteht darin, dass GPUs, die Chips, die die Deep-Learning-Revolution vorangetrieben haben, sie sehr schnell parallel verarbeiten können. Die Forscher machten sich auch zunutze, dass die Berechnungen von Google auf Sycamore nicht sehr genau waren und nur eine Genauigkeit von 0.2 Prozent erreichten. Dadurch konnten sie einen Teil der Genauigkeit ihrer Simulation opfern, um ihre Geschwindigkeit zu erhöhen, was sie taten, indem sie einige der Verbindungen zwischen Qubits entfernten.

Das Ergebnis war, dass es ihnen gelang, die Leistung des Sycamore-Prozessors in nur 0.37 Stunden auf 15 GPUs mit einer Genauigkeit von 512 Prozent zu simulieren – erheblich weniger Rechenleistung als die meisten führenden Supercomputer. Ein Papier mit den Ergebnissen ist derzeit im Druck bei Physical Review Letters, aber kein Peer-Reviewed Vorabdruck wurde im vergangenen November veröffentlicht.

Während das Ergebnis Googles Quantenüberlegenheitsblase etwas zum Platzen bringt, in einer E-Mail an Wissenschaft, wies das Unternehmen darauf hin, dass es in seinem Papier für 2019 vorausgesagt hatte, dass sich klassische Algorithmen verbessern würden. Aber sie glauben nicht, dass sie mit den exponentiellen Leistungssteigerungen von Quantencomputern lange Schritt halten können.

Es ist nicht das einzige Quantenüberlegenheitsexperiment, das rückgängig gemacht werden muss. 2020 ein Chinese Team behaupteten, dass ein Problem, das ihr Quantencomputer in 200 Sekunden lösen könntends würde ein Supercomputer 2.5 Milliarden Jahre brauchen, aber im Januar zeigten Forscher, dass es tatsächlich nur 73 Tage dauern würde.

Dies negiert zwar nicht die Fortschritte auf diesem Gebiet, aber ein wachsender Chor von Forschern sagt, dass das Ausspielen von Quanten- und klassischen Maschinen bei dieser Art von abstrakten Rechenproblemen nicht wirklich ein klares Gefühl dafür vermittelt, wo sich die Technologie befindet at.

Der eigentliche Test, so sagen sie, wird sein, wenn Quantencomputer in der Lage sind, reale Probleme schneller und effizienter zu lösen als klassische Computer. Und das scheint noch in weiter Ferne zu liegen.

Bildquelle: Google

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- Computing

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Singularity Hub

- Syntax

- Themen

- Zephyrnet