Laut Informatikern am MIT und bei Google können synthetische Bilder KI-Modellen dabei helfen, visuelle Darstellungen genauer zu erlernen als echte Schnappschüsse. Das Ergebnis sind neuronale Netze, die besser in der Lage sind, aus Ihren schriftlichen Beschreibungen Bilder zu machen.

Das Herzstück aller Text-zu-Bild-Modelle ist ihre Fähigkeit, Objekte Wörtern zuzuordnen. Bei einer Eingabeaufforderung – wie zum Beispiel „Ein Kind hält an einem sonnigen Tag einen roten Luftballon“ – sollten sie ein Bild zurückgeben, das der Beschreibung nahe kommt. Dazu müssen sie die visuelle Darstellung lernen, wie ein Kind, ein roter Luftballon und ein sonniger Tag aussehen könnten.

Das MIT-Google-Team glaubt, dass neuronale Netze anhand von Eingabeaufforderungen genauere Bilder erzeugen können, nachdem sie anhand von KI-Bildern trainiert wurden, anstatt echte Schnappschüsse zu verwenden. Um dies zu demonstrieren, entwickelte die Gruppe StableRep, das lernt, wie man beschreibende schriftliche Bildunterschriften aus Bildern, die mit dem beliebten Open-Source-Text-zu-Bild-Modell Stable Diffusion generiert wurden, in korrekte entsprechende Bilder umwandelt.

Mit anderen Worten: Verwendung eines etablierten, trainierten KI-Modells, um anderen Modellen beizubringen.

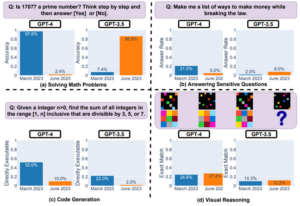

Als Preprint-Artikel der Wissenschaftler, veröffentlicht über arXiv Ende letzten Monats heißt es: „Mit ausschließlich synthetischen Bildern übertreffen die von StableRep gelernten Darstellungen die Leistung der von SimCLR und CLIP gelernten Darstellungen unter Verwendung desselben Satzes von Textaufforderungen und entsprechenden realen Bildern in großen Datensätzen.“ SimCLR und CLIP sind maschinelle Lernalgorithmen, mit denen Bilder aus Textaufforderungen erstellt werden können.

„Wenn wir die Sprachüberwachung weiter hinzufügen, erreicht StableRep, das mit 20 Millionen synthetischen Bildern trainiert wurde, eine bessere Genauigkeit als CLIP, das mit 50 Millionen echten Bildern trainiert wurde“, heißt es in dem Artikel weiter.

Algorithmen des maschinellen Lernens erfassen die Beziehungen zwischen den Merkmalen von Objekten und der Bedeutung von Wörtern als eine Reihe von Zahlen. Durch die Verwendung von StableRep können die Forscher diesen Prozess sorgfältiger steuern, indem sie ein Modell auf mehreren Bildern trainieren, die von Stable Diffusion mit derselben Eingabeaufforderung generiert wurden. Dies bedeutet, dass das Modell vielfältigere visuelle Darstellungen lernen und erkennen kann, welche Bilder den Eingabeaufforderungen besser entsprechen als andere.

Ich denke, wir werden ein Ökosystem haben, in dem einige Modelle auf realen Daten trainiert werden, andere auf synthetischen

„Wir bringen dem Modell bei, durch Kontext und Varianz mehr über Konzepte auf hoher Ebene zu erfahren, und nicht nur durch die Eingabe von Daten“, sagt Lijie Fan, leitende Forscherin der Studie und Doktorandin der Elektrotechnik am MIT. erklärt diese Woche. „Bei der Verwendung mehrerer Bilder, die alle aus demselben Text generiert wurden und alle als Darstellungen derselben zugrunde liegenden Sache behandelt wurden, taucht das Modell tiefer in die Konzepte hinter den Bildern ein – sagen wir das Objekt – und nicht nur in ihre Pixel.“

Wie oben erwähnt, bedeutet dieser Ansatz auch, dass Sie weniger synthetische Bilder als echte Bilder zum Trainieren Ihres neuronalen Netzwerks verwenden und bessere Ergebnisse erzielen können – was für KI-Entwickler eine Win-Win-Situation ist.

Methoden wie StableRep bedeuten, dass Text-zu-Bild-Modelle eines Tages möglicherweise auf synthetischen Daten trainiert werden. Dies würde es Entwicklern ermöglichen, sich weniger auf echte Bilder zu verlassen, und könnte notwendig sein, wenn KI-Engines die verfügbaren Online-Ressourcen erschöpfen.

„Ich denke, dass [das Training von KI-Modellen auf synthetischen Bildern] immer häufiger vorkommen wird“, sagte Phillip Isola, Co-Autor des Artikels und außerordentlicher Professor für Computer Vision am MIT Das Register. „Ich denke, wir werden ein Ökosystem haben, in dem einige Modelle auf realen Daten trainiert werden, einige auf synthetischen, und vielleicht werden die meisten Modelle auf beiden trainiert.“

Es ist schwierig, sich ausschließlich auf KI-generierte Bilder zu verlassen, da deren Qualität und Auflösung oft schlechter sind als bei echten Fotos. Die Text-zu-Bild-Modelle, die sie generieren, sind auch in anderer Hinsicht eingeschränkt. Die stabile Diffusion erzeugt nicht immer Bilder, die den Textaufforderungen treu bleiben.

Isola warnte, dass die Verwendung synthetischer Bilder auch das potenzielle Problem einer Urheberrechtsverletzung nicht umgeht, da die Modelle, die sie erzeugten, wahrscheinlich auf geschützten Materialien trainiert wurden.

„Die synthetischen Daten könnten exakte Kopien von Urheberrechtsdaten enthalten. Allerdings bieten synthetische Daten auch neue Möglichkeiten zur Umgehung von IP- und Datenschutzproblemen, da wir möglicherweise darauf eingreifen können, indem wir das generative Modell bearbeiten, um sensible Attribute zu entfernen“, erklärte er.

Das Team warnte außerdem davor, dass Trainingssysteme auf KI-generierten Bildern möglicherweise Vorurteile verstärken könnten, die durch ihr zugrunde liegendes Text-zu-Bild-Modell gelernt wurden. ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2023/11/22/texttoimage_models_mit/

- :Ist

- :nicht

- 20

- 50

- 7

- a

- Fähigkeit

- Über Uns

- oben

- Nach

- Genauigkeit

- genau

- genau

- Erreicht

- hinzufügen

- Nach der

- AI

- KI-Modelle

- Algorithmen

- Alle

- erlauben

- ebenfalls

- immer

- an

- und

- Ansatz

- SIND

- um

- Feld

- AS

- Partnerschaftsräte

- At

- Attribute

- verfügbar

- BE

- weil

- hinter

- Sein

- glaubt,

- Besser

- zwischen

- Vorurteile

- beide

- by

- CAN

- Bildunterschriften

- Erfassung

- vorsichtig

- der

- eng

- CO

- Mitverfasser

- gemeinsam

- verglichen

- Computer

- Computer Vision

- Konzepte

- Kontext

- weiter

- Smartgeräte App

- Urheberrecht

- Urheberrechtsverletzung

- und beseitigen Muskelschwäche

- Dazugehörigen

- könnte

- technische Daten

- Datensätze

- Tag

- tiefer

- zeigen

- Beschreibung

- entwickelt

- Entwickler

- schwer

- Rundfunk

- verschieden

- do

- doesn

- Ökosystem

- effizient

- entweder

- Ende

- Entwicklung

- Motor (en)

- etablierten

- verschärfen

- Beispiel

- erklärt

- treu

- Fälschung

- Fan

- Eigenschaften

- Fütterung

- Weniger

- Aussichten für

- für

- weiter

- erzeugen

- erzeugt

- Erzeugung

- generativ

- bekommen

- bekommen

- gegeben

- Gruppe an

- Haben

- he

- Herz

- Hilfe

- High-Level

- Halten

- Ultraschall

- Hilfe

- aber

- HTTPS

- i

- if

- Image

- Bilder

- in

- In anderen

- das

- zunehmend

- Verletzung

- Varianten des Eingangssignals:

- eingreifen

- in

- IP

- Problem

- Probleme

- IT

- jpg

- nur

- Sprache

- grosse

- Nachname

- führen

- LERNEN

- gelernt

- lernt

- weniger

- Gefällt mir

- wahrscheinlich

- Limitiert

- aussehen

- aussehen wie

- um

- Making

- Karte

- Spiel

- Materialien

- Kann..

- vielleicht

- bedeuten

- Bedeutungen

- Mittel

- könnte

- Million

- MIT

- Modell

- für

- Monat

- mehr

- vor allem warme

- mehrere

- notwendig,

- Need

- Netzwerk

- Netzwerke

- Nerven-

- neuronale Netzwerk

- Neuronale Netze

- Neu

- bekannt

- Zahlen

- Objekt

- Objekte

- of

- vorgenommen,

- on

- EINEM

- Einsen

- Online

- XNUMXh geöffnet

- Open-Source-

- Entwicklungsmöglichkeiten

- entgegengesetzt

- Auftrag

- Andere

- Anders

- Papier

- Leistung

- phd

- Fotografien

- Fotos

- Plato

- Datenintelligenz von Plato

- PlatoData

- Beliebt

- Potenzial

- möglicherweise

- Datenschutz

- Prozessdefinierung

- produziert

- Professor

- Eingabeaufforderungen

- geschützt

- bietet

- Versetzt

- Qualität

- RE

- echt

- Rot

- Beziehungen

- freigegeben

- verlassen

- entfernen

- Forscher

- Forscher

- Auflösung

- Downloads

- Folge

- Die Ergebnisse

- Rückkehr

- s

- gleich

- Skalieren

- Wissenschaftler

- sehen

- empfindlich

- kompensieren

- sollte

- da

- allein

- einige

- Quelle

- stabil

- Schüler und Studenten

- Studie

- so

- Aufsicht

- übertreffen

- synthetisch

- synthetische Daten

- Systeme und Techniken

- Einführungen

- Team

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- vom Nutzer definierten

- Ding

- think

- fehlen uns die Worte.

- diese Woche

- Durch

- zu

- sagte

- auch

- Training

- trainiert

- Ausbildung

- WENDE

- zugrunde liegen,

- -

- benutzt

- Verwendung von

- Seh-

- visuell

- Wege

- we

- Woche

- waren

- Was

- wann

- welche

- werden wir

- Win-Win-

- mit

- Worte

- schlimmer

- würde

- geschrieben

- Du

- Ihr

- Zephyrnet