Einleitung

Beim maschinellen Lernen ist der Bias-Varianz-Kompromiss ein grundlegendes Konzept, das die Leistung jedes Vorhersagemodells beeinflusst. Es bezieht sich auf das empfindliche Gleichgewicht zwischen Bias-Fehler und Varianzfehler eines Modells, da es unmöglich ist, beide gleichzeitig zu minimieren. Um eine optimale Modellleistung zu erzielen, ist es entscheidend, die richtige Balance zu finden.

In diesem kurzen Artikel definieren wir Bias und Varianz, erklären, wie sie sich auf ein Modell für maschinelles Lernen auswirken, und geben einige praktische Ratschläge, wie man in der Praxis damit umgeht.

Bias und Varianz verstehen

Bevor wir uns mit der Beziehung zwischen Voreingenommenheit und Varianz befassen, wollen wir definieren, was diese Begriffe beim maschinellen Lernen bedeuten.

Der Bias-Fehler bezieht sich auf den Unterschied zwischen der Vorhersage eines Modells und den korrekten Werten, die es vorherzusagen versucht (Grundwahrheit). Mit anderen Worten ist Bias der Fehler, den ein Modell aufgrund seiner falschen Annahmen über die zugrunde liegende Datenverteilung begeht. Modelle mit hohem Bias sind oft zu einfach und können die Komplexität der Daten nicht erfassen, was zu einer Unteranpassung führt.

Der Varianzfehler hingegen bezieht sich auf die Empfindlichkeit des Modells gegenüber kleinen Schwankungen in den Trainingsdaten. Modelle mit hoher Varianz sind zu komplex und passen eher das Rauschen in den Daten als das zugrunde liegende Muster an, was zu einer Überanpassung führt. Dies führt zu einer schlechten Leistung bei neuen, unsichtbaren Daten.

Eine hohe Verzerrung kann zu einer Unteranpassung führen, wenn das Modell zu einfach ist, um die Komplexität der Daten zu erfassen. Es werden starke Annahmen über die Daten getroffen und es gelingt ihm nicht, die wahre Beziehung zwischen Eingabe- und Ausgabevariablen zu erfassen. Andererseits kann eine hohe Varianz zu einer Überanpassung führen, bei der das Modell zu komplex ist und das Rauschen in den Daten lernt und nicht die zugrunde liegende Beziehung zwischen Eingabe- und Ausgabevariablen. Daher neigen Modelle mit Überanpassung dazu, die Trainingsdaten zu genau anzupassen und lassen sich nicht gut auf neue Daten verallgemeinern, während Modelle mit Unteranpassung nicht einmal in der Lage sind, die Trainingsdaten genau anzupassen.

Wie bereits erwähnt, hängen Bias und Varianz zusammen, und ein gutes Modell gleicht Bias-Fehler und Varianzfehler aus. Der Bias-Varianz-Kompromiss ist der Prozess, das optimale Gleichgewicht zwischen diesen beiden Fehlerquellen zu finden. Ein Modell mit geringer Verzerrung und geringer Varianz wird wahrscheinlich sowohl beim Training als auch bei neuen Daten gute Ergebnisse erzielen und den Gesamtfehler minimieren.

Der Bias-Varianz-Kompromiss

Das Erreichen eines Gleichgewichts zwischen der Modellkomplexität und seiner Fähigkeit, auf unbekannte Daten zu verallgemeinern, ist der Kern des Bias-Varianz-Kompromisses. Im Allgemeinen weist ein komplexeres Modell einen geringeren Bias, aber eine höhere Varianz auf, während ein einfacheres Modell einen höheren Bias, aber eine geringere Varianz aufweist.

Da es unmöglich ist, Bias und Varianz gleichzeitig zu minimieren, ist es für den Aufbau eines robusten Modells für maschinelles Lernen von entscheidender Bedeutung, das optimale Gleichgewicht zwischen ihnen zu finden. Wenn wir beispielsweise die Komplexität eines Modells erhöhen, erhöhen wir auch die Varianz. Dies liegt daran, dass ein komplexeres Modell das Rauschen in den Trainingsdaten eher anpassen kann, was zu einer Überanpassung führt.

Wenn wir das Modell andererseits zu einfach halten, erhöhen wir die Verzerrung. Dies liegt daran, dass ein einfacheres Modell die zugrunde liegenden Beziehungen in den Daten nicht erfassen kann, was zu einer Unteranpassung führt.

Das Ziel besteht darin, ein Modell zu trainieren, das komplex genug ist, um die zugrunde liegenden Beziehungen in den Trainingsdaten zu erfassen, aber nicht so komplex, dass es zum Rauschen in den Trainingsdaten passt.

Bias-Varianz-Kompromiss in der Praxis

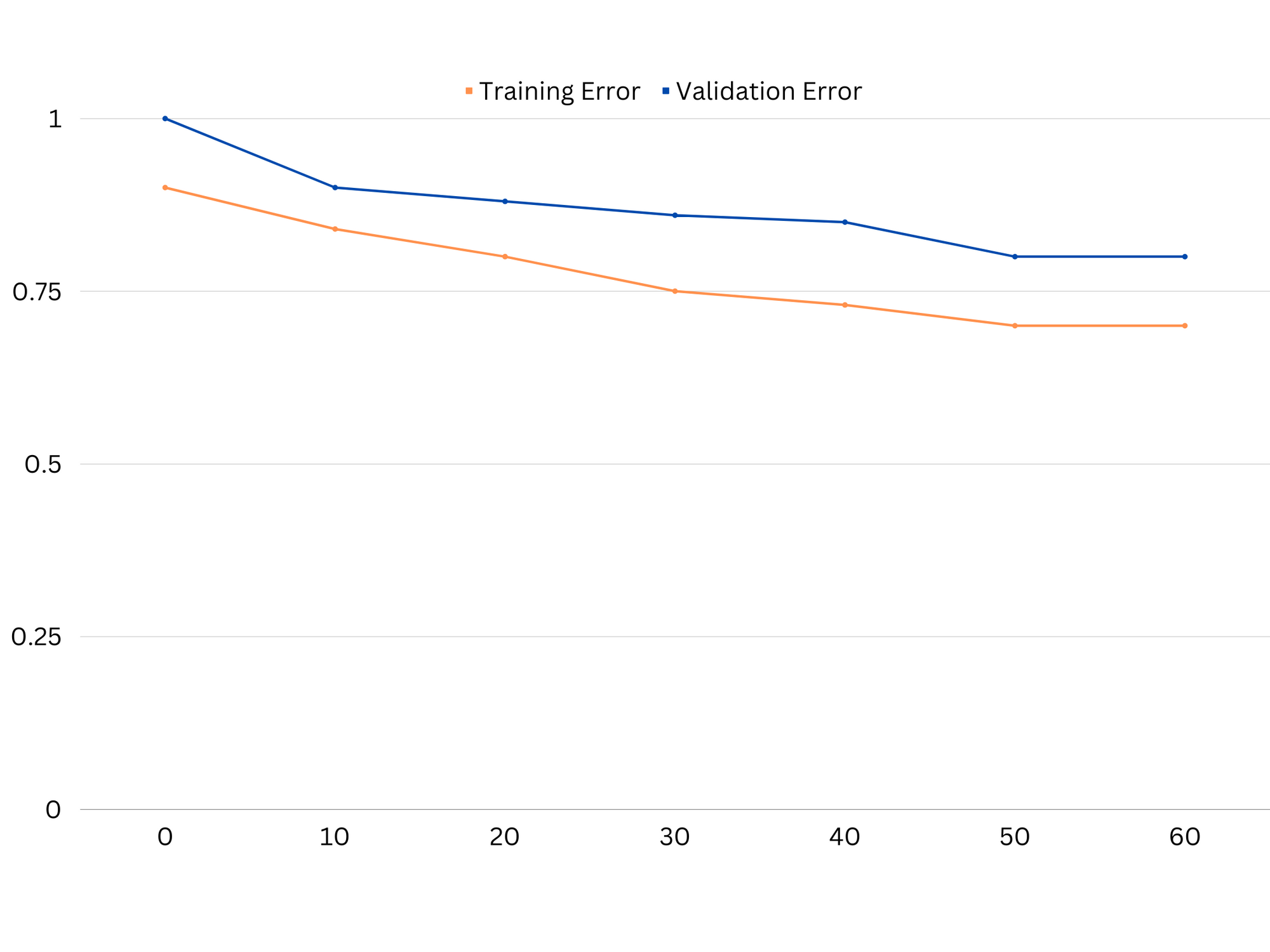

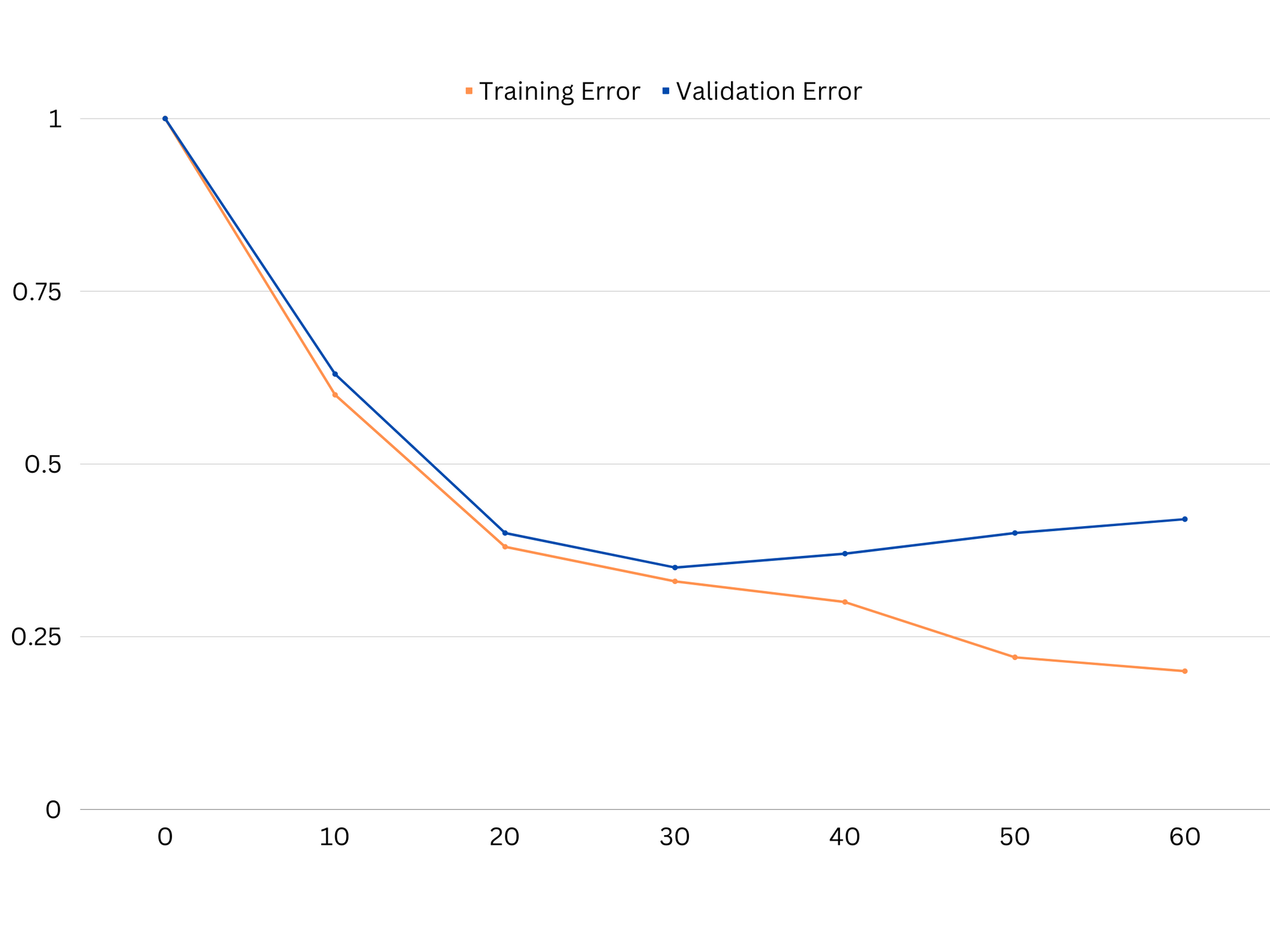

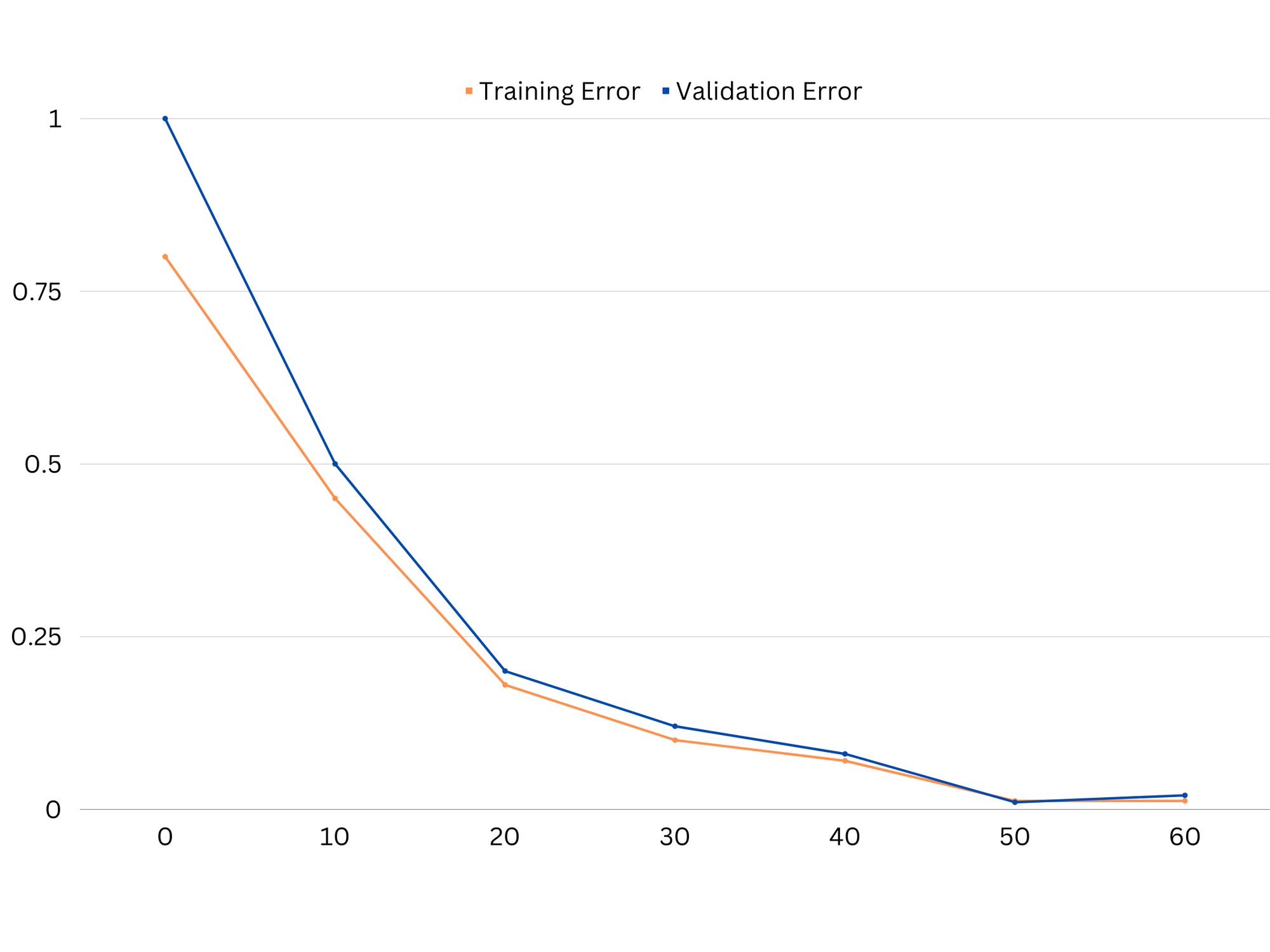

Um die Modellleistung zu diagnostizieren, berechnen und vergleichen wir normalerweise die Zug- und Validierungsfehler. Ein nützliches Werkzeug zur Visualisierung ist ein Diagramm der Lernkurven, das die Leistung des Modells sowohl bei den Zug- als auch bei den Validierungsdaten während des gesamten Trainingsprozesses anzeigt. Durch die Untersuchung dieser Kurven können wir feststellen, ob ein Modell überangepasst (hohe Varianz), unterangepasst (hohe Verzerrung) oder gut angepasst (optimales Gleichgewicht zwischen Verzerrung und Varianz) ist.

Beispiel für Lernkurven eines Underfitting-Modells. Sowohl der Zugfehler als auch der Validierungsfehler sind hoch.

In der Praxis deutet eine geringe Leistung sowohl bei Trainings- als auch bei Validierungsdaten darauf hin, dass das Modell zu einfach ist, was zu einer Unteranpassung führt. Wenn das Modell andererseits bei den Trainingsdaten sehr gut, bei den Testdaten jedoch schlecht abschneidet, ist die Modellkomplexität wahrscheinlich zu hoch, was zu einer Überanpassung führt. Um die Unteranpassung zu beheben, können wir versuchen, die Modellkomplexität zu erhöhen, indem wir weitere Funktionen hinzufügen, den Lernalgorithmus ändern oder andere Hyperparameter auswählen. Im Falle einer Überanpassung sollten wir eine Regularisierung des Modells oder den Einsatz von Techniken wie Kreuzvalidierung in Betracht ziehen, um seine Generalisierungsfähigkeiten zu verbessern.

Beispiel für Lernkurven eines Überanpassungsmodells. Der Zugfehler nimmt ab, während der Validierungsfehler zunimmt. Das Modell ist nicht verallgemeinerbar.

Regularisierung ist eine Technik, mit der der Varianzfehler in Modellen für maschinelles Lernen reduziert werden kann und die dabei hilft, den Kompromiss zwischen Bias und Varianz anzugehen. Es gibt eine Reihe verschiedener Regularisierungstechniken, jede mit ihren eigenen Vor- und Nachteilen. Einige beliebte Regularisierungstechniken umfassen Ridge-Regression, Lasso-Regression und elastische Netz-Regularisierung. Alle diese Techniken tragen dazu bei, eine Überanpassung zu verhindern, indem sie der Zielfunktion des Modells einen Strafterm hinzufügen, der extreme Parameterwerte verhindert und einfachere Modelle fördert.

Ridge Regression, auch bekannt als L2-Regularisierung, fügt einen Strafterm proportional zum Quadrat der Modellparameter hinzu. Diese Technik führt tendenziell zu Modellen mit kleineren Parameterwerten, was zu einer geringeren Varianz und einer verbesserten Generalisierung führen kann. Es erfolgt jedoch keine Feature-Auswahl, sodass alle Features im Modell verbleiben.

Sehen Sie sich unseren praxisnahen, praktischen Leitfaden zum Erlernen von Git an, mit Best Practices, branchenweit akzeptierten Standards und einem mitgelieferten Spickzettel. Hören Sie auf, Git-Befehle zu googeln und tatsächlich in Verbindung, um es!

Lasso-Regressionoder L1-Regularisierung fügt einen Strafterm hinzu, der proportional zum Absolutwert der Modellparameter ist. Diese Technik kann zu Modellen mit spärlichen Parameterwerten führen und die Merkmalsauswahl effektiv durchführen, indem einige Parameter auf Null gesetzt werden. Dies kann zu einfacheren Modellen führen, die leichter zu interpretieren sind.

Elastische Netzregularisierung ist eine Kombination aus L1- und L2-Regularisierung, die ein Gleichgewicht zwischen Ridge- und Lasso-Regression ermöglicht. Durch die Steuerung des Verhältnisses zwischen den beiden Straftermen kann das elastische Netz die Vorteile beider Techniken nutzen, wie z. B. eine verbesserte Generalisierung und Merkmalsauswahl.

Beispiel für Lernkurven eines gut passenden Modells.

Schlussfolgerungen

Der Bias-Varianz-Kompromiss ist ein entscheidendes Konzept beim maschinellen Lernen, das die Wirksamkeit und Güte eines Modells bestimmt. Während eine hohe Verzerrung zu einer Unteranpassung und eine hohe Varianz zu einer Überanpassung führt, ist es notwendig, das optimale Gleichgewicht zwischen beiden zu finden, um robuste Modelle zu erstellen, die sich gut auf neue Daten übertragen lassen.

Mit Hilfe von Lernkurven ist es möglich, Über- oder Unteranpassungsprobleme zu identifizieren, und durch Optimierung der Komplexität des Modells oder Implementierung von Regularisierungstechniken ist es möglich, die Leistung sowohl bei Trainings- und Validierungsdaten als auch bei Testdaten zu verbessern.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :Ist

- :nicht

- :Wo

- 1

- 12

- 20

- 8

- a

- Fähigkeit

- Fähig

- Über Uns

- Absolute

- genau

- Erreichen

- Erreichen

- berührt das Schneidwerkzeug

- Hinzufügen

- Adresse

- Fügt

- Vorteilen

- Beratung

- beeinflussen

- beeinflussen

- Algorithmus

- Alle

- Zulassen

- ebenfalls

- an

- und

- jedem

- SIND

- Artikel

- AS

- Balance

- Guthaben

- BE

- weil

- Vorteile

- zwischen

- vorspannen

- Grenze

- beide

- Building

- aber

- by

- Berechnen

- CAN

- Fähigkeiten

- Erfassung

- Häuser

- Ändern

- Auswahl

- eng

- Kombination

- vergleichen

- Komplex

- Komplexität

- konzept

- Geht davon

- Regelung

- Kernbereich

- und beseitigen Muskelschwäche

- wichtig

- technische Daten

- Deal

- sinkt

- Bestimmen

- entschlossen

- Unterschied

- anders

- Displays

- Verteilung

- die

- zwei

- jeder

- Früher

- einfacher

- effektiv

- Wirksamkeit

- ermutigt

- genug

- Fehler

- Fehler

- Sogar

- Untersuchen

- Beispiel

- Erklären

- Extrem

- andernfalls

- scheitert

- Merkmal

- Eigenschaften

- Suche nach

- passen

- passend zu

- Schwankungen

- Setzen Sie mit Achtsamkeit

- Aussichten für

- Funktion

- fundamental

- Allgemeines

- Git

- Kundenziele

- gut

- Boden

- Guide

- Pflege

- praktische

- Haben

- Hilfe

- Unternehmen

- GUTE

- höher

- schweben

- Ultraschall

- Hilfe

- aber

- HTTPS

- identifizieren

- if

- Umsetzung

- unmöglich

- zu unterstützen,

- verbessert

- in

- In anderen

- das

- inklusive

- Erhöhung

- zunehmend

- Varianten des Eingangssignals:

- in

- Einleitung

- IT

- SEINE

- Behalten

- bekannt

- L1

- l2

- führen

- führenden

- umwandeln

- lernen

- lassen

- LG

- Gefällt mir

- wahrscheinlich

- ll

- Sneaker

- senken

- Maschine

- Maschinelles Lernen

- MACHT

- erwähnt

- minimieren

- Modell

- für

- mehr

- notwendig,

- Netto-

- Neu

- Lärm

- Anzahl

- Ziel

- of

- vorgenommen,

- on

- optimal

- or

- Andere

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- besitzen

- Parameter

- Parameter

- Schnittmuster

- Ausführen

- Leistung

- Durchführung

- führt

- Plato

- Datenintelligenz von Plato

- PlatoData

- Arm

- Beliebt

- möglich

- Praktisch

- Praxis

- vorhersagen

- Prognose

- verhindern

- Probleme

- Prozessdefinierung

- die

- lieber

- Verhältnis

- Veteran

- Reduziert

- bezieht sich

- bezogene

- Beziehung

- Beziehungen

- bleiben

- vertreten

- Folge

- was zu

- Die Ergebnisse

- Recht

- Ring

- robust

- s

- Auswahl

- Sensitivität

- Einstellung

- Shadow

- Blatt

- Short

- sollte

- Einfacher

- gleichzeitig

- klein

- kleinere

- So

- einige

- Quellen

- quadratisch

- Stapelmissbrauch

- Normen

- Stoppen

- stark

- so

- Schlägt vor

- Techniken

- Begriff

- AGB

- Test

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- während

- zu

- auch

- Werkzeug

- Gesamt

- Training

- Ausbildung

- Übergang

- was immer dies auch sein sollte.

- Wahrheit

- versuchen

- XNUMX

- typisch

- nicht fähig

- zugrunde liegen,

- unbekannt

- benutzt

- Verwendung von

- Bestätigung

- Wert

- Werte

- sehr

- we

- GUT

- Was

- ob

- welche

- während

- werden wir

- mit

- Worte

- Zephyrnet

- Null